Замечания яндекса к сайту по перенаправлениям. Насколько критично?

При обращении к главной странице сайта www.obzoroff.info робот получает перенаправление на другой сайт, что делает невозможным её индексирование.

Это критично или нет, так как логично что сайт перенаправляет на без www на https и это прописано в роботс, что яшке не так?

Если перенесли недавно, то нужно бло сделать “переезд” сайта и ждать. А так вроде все правильно.

сделал в марте, иногда подобное сообщение появляется в вебмастере и на сайте без www и без https . Также появляются замечания об отсутствии файла robots.txt хотя он есть и сделан правильно 100%.

непонятка какая то выходит.

В вебмастере по сайтам без https загружено 0 страниц, в поиске ноль. с https все в порядке, все в поиске присутствуют

Так и должно быть. Можете не переживать. А сайт свой Вы тут не пропиарите.

Читайте внимательнее что они пишут. Редиректа на robots.txt быть не должно. Если это с www на без www – то пофиг. Если это с http на https, то robots.txt должен быть доступен на обоих вариантах без перенаправления. Там же host указан поэтому пойдет правильная индексация нужного варианте адреса.

Яндекс часто “путается в показаниях” 🙂 Я лично не обращаю внимания, привык к подобным “глюкам”. На каждый чих Яндекс – не накланяешься. Раньше писал Платонам, надоело получать отписки “ни о чем”, бросил.

Также появляются замечания об отсутствии файла robots.txt хотя он есть и сделан правильно 100%.

Вот правильный robots.txt

User-agent: *

Disallow: /wp-admin

Disallow: /wp-content/plugins

Host:

Sitemap:

еще заметил небольшой баг. При переходе на сайт появляется иногда “страница недоступна”, как будто бы нет интернета, и через полсекунды загружается нужная страница

Да и у меня тоже самое на Вашем сайте. А вобще всем, кто работает с ворпрессом, рекомендую этот плагин поставить. Он полностью удовлетворит все Ваши пожелания и наведет порядок. Это не реклама. Сам ставлю на все свои сайты. Стоит он недорого, но зато эффективно и просто. Вот ссылка https://wpshop.ru/plugins/clearfy

так стоит уже давно clearfy действительно классный и нужный плагин.

xShift , не понимаю Вас! Можно подробнее? что должно быть в роботс

Должно быть как обычно. Я вам просто напоминаю про старинную рекомендацию Яндекс оставлять robots.txt доступным без перенаправления. Если robots.txt нет, то индексация вообще не пойдет. Как это может отразиться в вашем случае я не уверен, но тем не менее такая рекомендация существует уже давно.

ну как роботс он один физически на хостинге, это же в реальности не три сайта с www, без него и с https

Тогда что нужно сделать, чтоб яндекс успокоился

Смотрите что происходит на самом деле: для Я http и https – это два совершенно разных сайта. Если у сайта не задан robots.txt то есть его тупо нет, то ни Я ни G такой сайт индексировать не будет вообще. Что может случиться? Провалится лиц накопленный одним из зеркал как вариант.

спасибо Сан Саныч, успокоил! Жаль что яндекс долго рассасывает, особенно купленные ссылки для сайта http. С марта по сентябрь гугл давно нашел и уже нормальный траф дает. А Яшка то 30 уников то 200 в день и так чередуется с каждым апом, а я сижу и думаю, чё просадка то резкий взлёт, а запросы по сути одни и те же

Ну… “штормит” Яшу, никакой валерианкой он не лечится, только Яндекс.Директ. Ориентируйтесь на google, единственный рецепт, имхо, для “спокойного сна” вебмастера 🙂 Россияне пока что продолжают юзать Яндекс, но, похоже, неадекватность выдачи уже многих… утомила. Минус аудитория – всего остального мира, минус Украина, минус – здравый смысл.

У меня есть аккаунтв на mail вебмастер, но на-фиг мне его просматривать? То же самое и с Яндекс Вебмастер. Аккаунт есть, но смотреть его – если только посмеяться.

вот такой вот роботс нашел в сети когда то. и мне он показался максимально адекватным. может пригодится кому-то:

User-agent: *

Disallow: /

Allow: /wp-content/uploads/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /template.html

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: */trackback

Disallow: */feed

Disallow: */comments

Disallow: */comment-page*

Disallow: */replytocom=

Disallow: /author*

Disallow: */?author=*

Disallow: */tag

Disallow: /?feed=

Disallow: /?s=

Disallow: /?se=

Host:

Sitemap:

В чем же адекватность, если толпу директив, типа:

Disallow: */?author=*

Disallow: /?feed=

Disallow: /?s=

Disallow: /?se=

Заменит одна:

Disallow: /*?

Это, товарыш, фигня, а не “эталон”.

странный Вы. А если у меня есть и другие параметры, которые мне закрывать ненужно?

это ведь wp стандартные директории закрыты. и никто не объявлял этот шаблон эталонным.

Просто он довольно полезный, особенно, когда человек совсем недавно занялся работой с wp

У вас нет ни одного url содержащий “?” – который вам нужен в индексе.

Если есть – пример. ОДИН.

По большому счету, роботс это: как у человека аллергия и не все лекарства подходят. Каждому свое. Для любого сайта нужно прописывать роботс в индивидуальном порядке и постепенно. А конкретно, смотреть именно что из мусора на начальных стадиях развития появляется в поиске. Искать болячки и тому подобное. При этом, желательно устранять при помощи сео плагинов, а не дериктивы писать портяночные.

Если сразу настроить к примеру YOAST, проблем не будет и в ворпрессе достаточно иметь тот роботс, который там уже стоит (стандартный). Ну правда дописать ХОСТ И КАРТУ САЙТА.

У меня к примеру на сайтах даже сео плагинов нет. А дубли закрываю тем самым clearfy

Зачем закрывать это?

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /template.html

Disallow: /wp-content/cache Это может пригодиться, так как в вебмастере google раздел заблокированные ресурсы некоторые страницы сайта требуют кэш и не могут без него нормально отображаться

Disallow: */comments комментарии это же дополнительный поисковый траффик, зачем их закрывать

Поясните пожалуйста, думаю многим будет полезно

Закрыли 90% картинок, css, js

Молодца! 🙂

Скучно. Есть же у всех доступ в Сеть, читайте, думайте. На-фиг банальщину тащить на полном серьезе.

“Эталон”… Нет их, никогда не было и не будет.

Сан Саныч, вот в продолжение темы, Яндекс вот так сегодня вечером выпендрился: копипаст ответа

На сайте www.obzoroff.info в директиве Host файла robots.txt указан домен, где аналогичные указания в файле robots.txt отсутствуют. Чтобы указания директивы Host были учтены, идентичные директивы должны присутствовать в файлах robots.txt всех зеркал сайта.

Что ему еще не так?

Изменение правил работы с контентными зеркалами

Выбор главного зеркала сайта — важный шаг для владельца сайта, позволяющий напрямую указать, какой из адресов сайта необходимо считать основным, и именно на него приводить пользователей из Поиска. Так, владелец сайта всегда мог сам указать главное зеркало через Вебмастер и настройку своего сайта: настроив 301-редирект с неглавной версий на главную и сообщив об этом через инструмент «Переезд сайта». Ранее мы также приводили к единому зеркалу и не указанные напрямую дубли основного сайта, если их контент совпадал с главным. Мы решили отказаться от этой практики, оставив указание контентных зеркал на усмотрение владельца сайта: через 301-й редирект.

В скором времени зеркала, склеенные по контенту, отклеятся в самостоятельные сайты. Если вам важно сохранить склейку, пожалуйста, проверьте, что все страницы неглавного зеркала имеют 301-й редирект на соответствующие страницы главного зеркала. Отклейка не коснется технических зеркал сайта, отличающихся от главного зеркала схемой (HTTP или HTTPS) или поддоменом www — они останутся склеенными по контенту в своей группе зеркал.

Проверить наличие редиректа можно в Яндекс.Вебмастере. Данная расклейка контентных зеркал не означает появления дубликатов в результатах поиска, она лишь позволит лучше контролировать указание неглавных зеркал сайта. Цель ранжирования, как и прежде — предоставить пользователям наилучший выбор сайтов, эффективно решающих их задачи.

Что касается логики изменения главного зеркала, то она не меняется: сделайте так, чтобы на ваш новый главный сайт вели 301-е редиректы с неглавных дублей сайта. После чего сообщите о необходимости изменения главного зеркала через инструмент «Переезд сайта» в Яндекс.Вебмастере.

Команда Поиска

P. S. Подписывайтесь на наши каналы

Блог Яндекса для Вебмастеров

Канал Яндекса о продвижении сайтов на YouTube

Канал для владельцев сайтов в Яндекс.Дзен

На сайте может быть установлен постоянный или временный редирект, который ведет пользователя из результатов поиска Яндекса не на ваш сайт, а на сторонний ресурс.

Если на сайте обнаружено такое нарушение, вероятно, сайт подвергся атаке, и в него был внедрен исполняющий перенаправление код.

-

Проверьте примеры страниц, которые представлены в описании нарушения в Вебмастере.

-

Воспользуйтесь рекомендациями в разделе Как защитить сайт от заражения.

Когда вы исправите нарушение, нажмите кнопку Я все исправил в Вебмастере на странице Безопасность и нарушения. Обычно ограничения при таком нарушении снимаются в течение месяца. Когда ограничения будут сняты, пометка о нарушении исчезнет.

Примечание.

Повторно нажать кнопку Я все исправил для одного сайта можно через месяц. Далее, во избежание злоупотребления кнопкой, этот период будет увеличиваться и может составить три месяца. Поэтому рекомендуем воспользоваться кнопкой только тогда, когда вы уверены, что нарушений на сайте больше нет.

Если в Вебмастере права на сайт подтверждены у нескольких пользователей, договоритесь, кто и когда отправит сайт на перепроверку. После нажатия кнопки ни один из пользователей не сможет нажать ее повторно в течение месяца.

Прошу вашей помощи.

При диагностике сайта в вебмастера идет проблема.

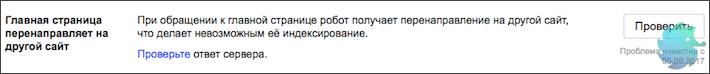

Главная страница перенаправляет на другой сайт. При обращении к главной странице робот получает перенаправление на другой сайт, что делает невозможным её индексирование.

robo74.ru – основной сайт, но с меню во всех разделах новостей редирект на news.robo74.ru,

И с меню news.robo74.ru редирект на robo74.ru кроме новостных разделов.

То есть news.robo74.ru – сайт с новостями. robo74.ru – все остальные разделы.

Мне нужно чтобы хлебные крошки и меню у robo74.ru и у news.robo74.ru работали одинаково, поэтому сделала взаимные редиректы.

И мне нужно чтобы в меню news.robo74.ru главная редиректила на robo74.ru.

Как мне тогда исправить ситуацию индексирования news.robo74.ru

Как настроить перенаправление?

чтобы главная страница https://news.robo74.ru/ присутствовала в поиске, а уведомление о редиректе на другую страницу пропало из Вебмастера и https://news.robo74.ru/ должна быть доступна для робота и отвечать на его запросы http-кодом 200ОК.

И чтобы с внутренних страниц домена https://news.robo74.ru/ пользователи попадали на нужные страницы https://robo74.ru/.

И с внутренних страниц домена https://robo74.ru/ пользователи попадали на нужные страницы https://news.robo74.ru/.

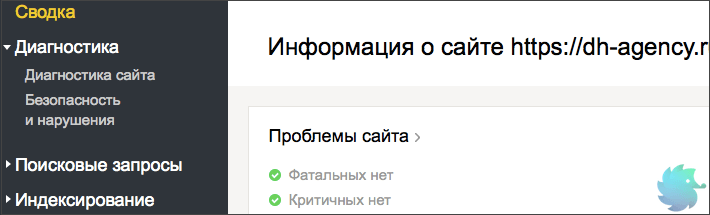

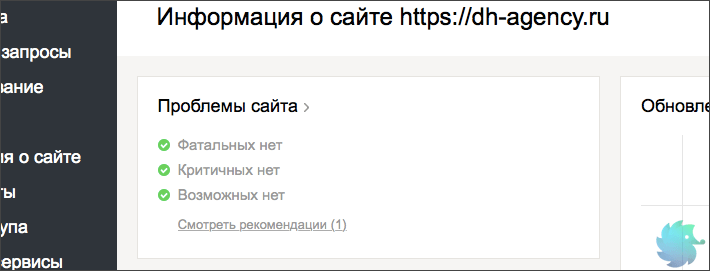

Вкратце о диагностике сайта

Фатальные

- Сайт закрыт к индексации в файле robots.txt

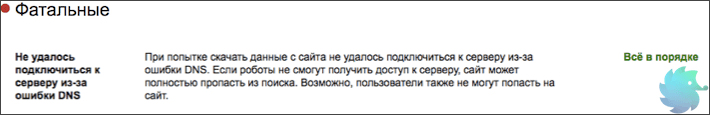

- Не удалось подключиться к серверу из-за ошибки DNS

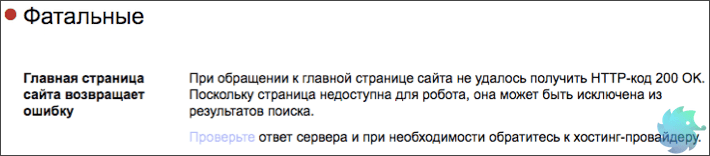

- Главная страница сайта возвращает ошибку

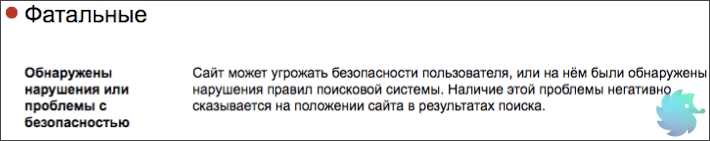

- Обнаружены нарушения или проблемы с безопасностью

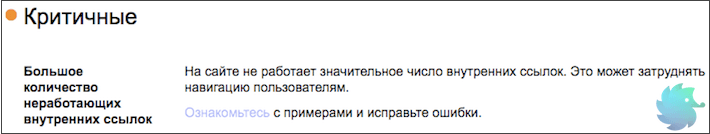

Критичные

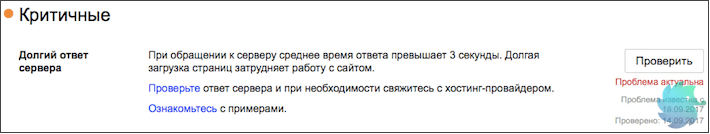

- Долгий ответ сервера

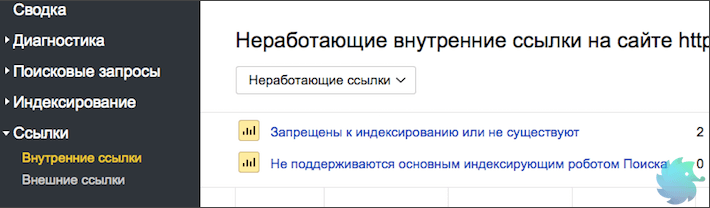

- Большое количество неработающих внутренних ссылок

Возможные проблемы

- Главная страница перенаправляет на другой сайт

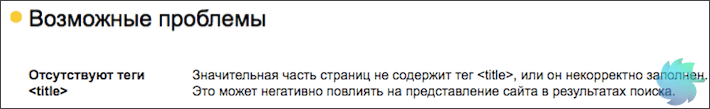

- Отсутствуют теги <title>

- Ошибки в файле robots.txt

- Не найден файл robots.txt

- Отсутствуют мета-теги <description>

- Некорректное отображение несуществующих файлов и страниц

- В файле robots.txt задана противоречивая директива Host

- В файле robots.txt не задана директива Host

- Большое количество страниц-дублей

- Нет используемых роботом файлов Sitemap

- Обнаружены ошибки в файлах Sitemap

- Файлы Sitemap давно не обновлялись

Рекомендации

- Не задана региональная принадлежность сайта

- Сайт не оптимизирован для мобильных устройств

- Ошибка счётчика Яндекс.Метрики

- Сайт не зарегистрирован в Яндекс.Справочнике

- Отсутствует файл favicon на сайте

- Отсутствуют быстрые ссылки

Вкратце о диагностике сайта

В этой статье мы подробно опишем большинство самых популярных проблем, которые выдает диагностика сайта от Яндекса. Напомним, что раздел диагностики находится в Yandex Webmaster на второй вкладке в левом меню.

Краткую информацию о наличии проблем возможно найти в левом верхнем блоке на главной странице Вебмастера.

Прежде, чем рассказывать о каждой проблеме отдельно, поясним общую информацию. Яндекс разделил все ошибки на 4 вида:

-

Фатальные — то есть, те, которые несовместимы с отображением сайта в поисковой выдаче. Наличие таких ошибок, скорее всего, приведет к полному исключению сайта из поиска. Среди них — запрет индексации, различного рода санкции со стороны поисковиков, серьезное нарушение безопасности или неработоспособность сайта;

-

Критичные — то есть, те, которые серьезно затрудняют удобство пользования сайтом, его корректную работу или индексацию. Наличие таких ошибок вряд ли приведет к исключению ресурса из поисковой выдачи, но может сильно снизить видимость;

-

Возможные — то есть, те, которые влияют на удобство пользователей, отображение и корректную индексацию. Подобные ошибки стоит устранить для улучшения сайта и повышения видимости в органической выдаче. В общем списке сайтов Вебмастера возможные проблемы обозначаются серым восклицательным знаком.

-

Рекомендации — носят исключительно рекомендательный характер. Обычно направлены на улучшение сайта или отображения.

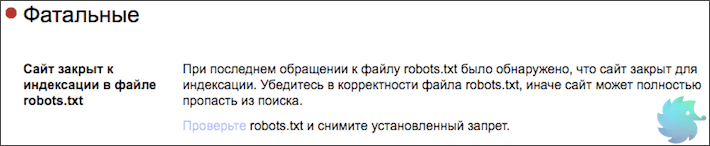

Фатальные проблемы

Решать фатальные проблемы нужно немедленно, иначе они приведут к исключению сайта из поисковой выдачи. Подобные ошибки справедливы не только для Яндекса, но и для всех остальных поисковых систем. Ниже мы опишем каждую из них в отдельности, а так же предложим варианты решения.

Сайт закрыт к индексации в файле robots.txt

«При последнем обращении к файлу robots.txt было обнаружено, что сайт закрыт для индексации. Убедитесь в корректности файла robots.txt, иначе сайт может полностью пропасть из поиска.» © Яндекс Вебмастер

Очень серьезная, но легко решаемая проблема. Причиной ее появления может стать банальная ошибка в синтаксисе файла robots.txt или ненамеренный запрет индексации. Зачастую такую ошибку можно увидеть у новых сайтов, так как разработчики обычно закрывают ресурс для индексации и не всега открывают обратно.

Поправить это очень просто. Открываем свой robots.txt по ссылке ваш_домен/robots.txt и проверяем содержимое. Если в нем расположен код следующего содержания:

User-agent: *

Disallow: /

или

User-agent: Yandex

Disallow: /

То, просто заменяем его на шаблонные инструкции для Вашей CMS или прописываем уникальные вручную.

Подробнее о настройке файла robots.txt

Не удалось подключиться к серверу из-за ошибки DNS

«При попытке скачать данные с сайта не удалось подключиться к серверу из-за ошибки DNS. Если роботы не смогут получить доступ к серверу, сайт может полностью пропасть из поиска. Возможно, пользователи также не могут попасть на сайт.» © Яндекс Вебмастер

Данная проблема решается уже не так быстро, как предыдущая. Суть ее проста. Индексирующий робот Яндекса попросту не смог получить доступ к сайту. То есть, корректная индексация уже невозможна. Если краулер, при повторных обращениях, будет продолжать получать ошибку, то сайт рано или поздно исключат из поиска.

В данном конкретном случае, лучше всего будет обратиться к разработчикам сайта или хост-провайдеру (регистратору доменного имени.) Если Вы не профессионал, то можете потерять много драгоценного времени в попытках разобраться в произошедшем. Помните, что фатальные ошибки нужно решать незамедлительно.

Главная страница сайта возвращает ошибку

«При обращении к главной странице сайта не удалось получить HTTP-код 200 OK. Поскольку страница недоступна для робота, она может быть исключена из результатов поиска.» © Яндекс Вебмастер

При обращении к главной странице сайта робот ожидает ответ 200 ОК. Только при его получении продолжается корректная индексация.

Если Вы столкнулись с вышеупомянутой проблемой, то вот несколько причин ее появления.

-

Неверно настроен ответ главной страницы. К примеру, главная может отдавать 404 Not Found или 403. Что для нее не корректно. Определить ответ можно в Яндекс Вебмастере, при помощи инструмента «проверка ответа сервера«;

-

Для главной страницы может быть настроен 301 редирект;

-

Главная страница сайта может технически отсутствовать, что редкость.

Решается проблема путем проверки наличия страницы и ее ответа. Для разработчиков сайта устранить данную ошибку не составит никакого труда.

Обнаружены нарушения или проблемы с безопасностью

«Сайт может угрожать безопасности пользователя, или на нём были обнаружены нарушения правил поисковой системы. Наличие этой проблемы негативно сказывается на положении сайта в результатах поиска.» © Яндекс Вебмастер

Одна из самых сложно решаемых проблем. Причин ее появления может быть множество. Вот основные из них:

-

Сайт был взломан и на нем находится вредоносный код. Это может быть вирусный рекламный баннер, вставки iframe, различного рода трояны, а так же множество другой гадости;

-

Сбор, обработка или передача данных пользователей сделана насколько некорректно, что индексирующий робот заподозрил в этом мошеннические намерения;

-

Сайт не соответствует правилам поисковой системы. То есть, имеет запрещенный контент, обманывает или вводит в заблуждение пользователей, подменяет материал и т.д.;

Стоит сказать, что данная проблема может появляться у очень молодых сайтов из-за темного прошлого доменного имени. Обязательно проверяйте домен перед покупкой.

Однако, не стоит беспокоиться и переделывать сайт, если Вы уверены в его корректной работе. Подобное сообщение может появляться по ошибке. Если это так, то оно автоматически пропадет через несколько обновлений.

Критичные проблемы

На критичные проблемы стоит сразу обратить внимание и начать искать решение. Их появление скорее всего не приведет к исключению из поиска, однако может серьезно повлиять на видимость сайта.

Долгий ответ сервера

«При обращении к серверу среднее время ответа превышает 3 секунды. Долгая загрузка страниц затрудняет работу с сайтом.» © Яндекс Вебмастер

Это одна из основных причин неполной (некорректной) индексации. Робот отводит на каждый сайт определенное количество секунд, после чего переходит к следующем ресурсу. Если ответ сервера слишком долгий, то времени на загрузку страниц может просто не остаться.

Что бы решить эту проблему, необходимо обратиться к администратору сервера или хост-провайдеру. Возможно, Вашему сайту просто не хватает выделенных для работы ресурсов.

Если данное сообщение появилось, а потом пропало без видимых причин, не стоит его игнорировать. Обязательно проверьте скорость ответа сервера, а так же параметры загрузки сайта. Наличие подобной проблемы влияет на индексацию вне зависимости от того, есть сообщение в Вебмастере или его нету.

Большое количество неработающих внутренних ссылок

«На сайте не работает значительное число внутренних ссылок. Это может затруднять навигацию пользователям.» © Яндекс Вебмастер

Причиной возникновения подобной проблемы может служить некорректный перенос разделов, страниц или сайта в целом. Так же, к этому может привести сбой в работе каталога, фильтра, пагинации или другого блока связанного со ссылками.

Определить точное количество неработающих ссылок и увидеть детали можно в разделе «Внутренние ссылки» Яндекс Вебмастера.

В этом блоке подробно описываются причины, поэтому Вам останется только устранить проблемы внутри сайта.

Возможные проблемы

Несмотря на название, возможные проблемы все же являются серьезными изъянами с точки зрения SEO. Они не приведут к исключению ресурса из поиска, а так же слабо повлияют на позиции и видимость. Однако их устранение может привести к подъему поискового трафика и более лояльному отношению поисковиков.

Главная страница перенаправляет на другой сайт

«При обращении к главной странице робот получает перенаправление на другой сайт, что делает невозможным её индексирование.» © Яндекс Вебмастер

Данную проблему Яндекс относит к разделу «Возможные», однако с нашей точки зрения это серьезная ошибка. Речь сейчас не идет о перенаправлении на зеркала или «склейку». Только редирект на сторонний сайт.

При корректном обращении к главной странице краулер должен получать ответ 200 ОК, что означает, что страница доступна пользователям и ее можно индексировать. В случае получения 301 Redirect, робот не только отправляется на сторонний ресурс, но и получает тревожный сигнал, что сайт мог быть взломан или вводит пользователей в заблуждение. То есть, Вы уже рискуете попасть под фильтры безопасности.

Сразу проверьте ответ сервера, если это будет не 200 ОК — ищите и устраняйте причину. В случае получения 301 Redirect рекомендуем заглянуть в файл .htaccess и проверить его на наличие редиректа.

Отсутствуют теги <title>

«Значительная часть страниц не содержит тег <title>, или он некорректно заполнен. Это может негативно повлиять на представление сайта в результатах поиска.» © Яндекс Вебмастер

Очень серьезное упущение с точки зрения поискового продвижения. Заголовки <title></title> являются одним из основных факторов внутренней оптимизации, которые влияют на ранжирование страницы.

Ранее этому заголовку мы посвятили полноценную статью. В ней разложено по полочкам все, что нужно знать о данном теге с точки зрения SEO.

Безусловно, Яндекс самостоятельно выберет текст для ссылки при построении поисковой выдачи и без сниппета Вы не останетесь, однако Ваша конкурентоспособность с точки зрения SEO сильно упадет.

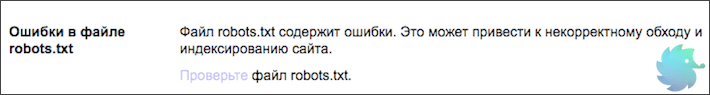

Ошибки в файле robots.txt

«Файл robots.txt содержит ошибки. Это может привести к некорректному обходу и индексированию сайта.» © Яндекс Вебмастер

Данный файл представляет из себя список инструкций для индексирующего робота. Именно в нем определяется, что нужно загружать в базу, а что игнорировать. Находится он в корневой папке сайта и доступен по адресу www.ваш_домен.ru/robots.txt.

Большинство ошибок в robots.txt, обычно, связаны с синтаксисом прописываемых в нем инструкций. Лишняя точка, слэш или пробел могут привести к некорректному распознанию команды.

Поэтому, при появлении данной проблемы сразу открывайте свой роботс и начинайте проверять синтаксис. В этом деле Вам может помочь сервис «Анализ robots.txt» находящийся во вкладке «Инструменты» Яндекс Вебмастера.

Подробнее об ошибках и настройке файла robots.txt

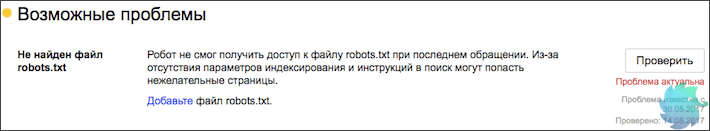

Не найден файл robots.txt

«Робот не смог получить доступ к файлу robots.txt при последнем обращении. Из-за отсутствия параметров индексирования и инструкций в поиск могут попасть нежелательные страницы.» © Яндекс Вебмастер

Суть проблемы понятна из названия. Что бы решить ее, необходимо просто добавить robots.txt в корневой каталог Вашего сайта. Сделать это можно через FTP или при помощи различного рода плагинов.

Если Вы используете популярную CMS, то мы готовы предложить шаблонные решения. Однако, обратите внимание, что шаблоны инструкций не гарантируют корректность индексации и отсутствие мусора. У каждого сайта будут свои особенности и подводные камни.

Подробнее о настройке файла robots.txt

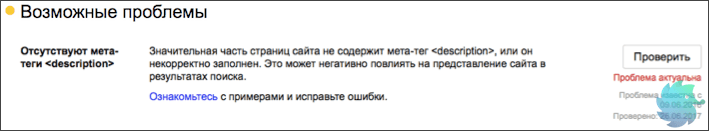

Отсутствуют мета-теги <description>

«Значительная часть страниц сайта не содержит мета-тег <description>, или он некорректно заполнен. Это может негативно повлиять на представление сайта в результатах поиска.» © Яндекс Вебмастер

Это одна из самых распространенных проблем, с которой сталкивается практически каждый SEO специалист. Для ее решения необходимо просто добавить недостающие <description>.

Узнать полный список страниц с отсутствующими тегами Вы можете перейдя по ссылке «Ознакомьтесь» в описании проблемы.

Отсутствие meta тега <description> сильно влияет на корректность отображения сниппетов. Поэтому тянуть с решением проблемы не стоит.

Если подобная ошибка появилась у Интернет-магазина, сайта-каталога или другого крупного ресурса, то для ее решения есть стандартные плагины, которые формируют meta description автоматически. Пользоваться такими плагинами мы советуем в крайнем случае, так как результат работы не всегда удовлетворителен.

Подробнее о description и правилах заполнения

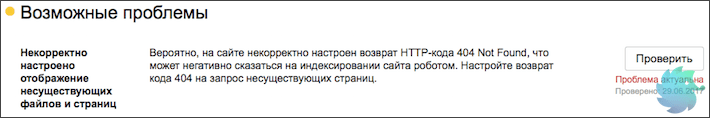

Некорректное отображение несуществующих файлов и страниц

«Вероятно, на сайте некорректно настроен возврат HTTP-кода 404 Not Found, что может негативно сказаться на индексировании сайта роботом. Настройте возврат кода 404 на запрос несуществующих страниц.» © Яндекс Вебмастер

Проще говоря, у Вас попросту отсутствует или некорректно работает страница 404. Что бы разобраться в этом, необходимо перейти на несуществующий раздел. Сделать это можно введя любой некорректный URL, к примеру «ваш_домен.ру/none12345».

Если Вы видите перед собой неизвестную ошибку, белый экран, сообщение хост-провайдера или другую информацию, которая к сайту не относится — у Вас просто нету данной страницы. Шаблон для нее необходимо сделать в CMS сайта. Это напрямую относится к разработке и дизайну сайта, поэтому работы стоит поручить верстальщику.

Если Вы видите оформленную страницу 404 своего сайта, тогда проблема в ответе сервера. Нужно понимать, что надпись «404 — страница не найдена» не означает, что сайт действительно отдает «404 Not Found», скорее всего, результатом будет 200 ОК.

Проверить ответ сервера Вы можете в разделе «Проверка ответов сервера» во вкладке «Инструменты» Яндекс Вебмастера.

Создание страницы 404 Not Found и настройка ответа сервера полностью зависят от конкретного сайта, поэтому сделать пошаговую инструкцию просто невозможно.

Подробнее о странице 404 с точки зрения SEO

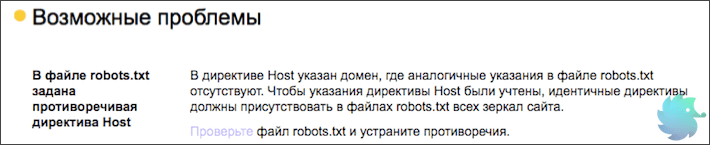

В файле robots.txt задана противоречивая директива Host

«В директиве Host указан домен, где аналогичные указания в файле robots.txt отсутствуют. Чтобы указания директивы Host были учтены, идентичные директивы должны присутствовать в файлах robots.txt всех зеркал сайта.» © Яндекс Вебмастер

Суть проблемы в следующем. Есть два зеркала. У обоих есть файл robots.txt, в котором указаны различные параметры инструкции HOST.

Решение очень простое. Необходимо указать во всех HOST одно главное зеркало. Это нужно, что бы у робота не оставалось сомнений, какое из зеркал основное.

Бывает так, что файл robots.txt один и инструкции попросту не могут различаться. В таком случае нужно подождать и сообщение пропадет.

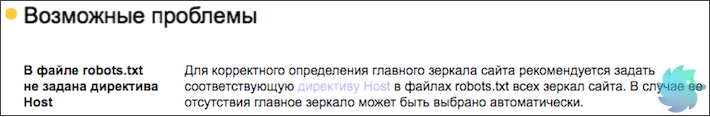

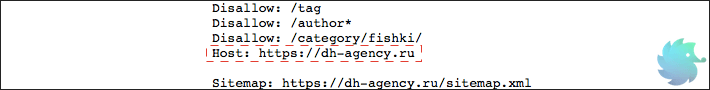

В файле robots.txt не задана директива Host

«Для корректного определения главного зеркала сайта рекомендуется задать соответствующую директиву Host в файлах robots.txt всех зеркал сайта. В случае ее отсутствия главное зеркало может быть выбрано автоматически.» © Яндекс Вебмастер

Помимо прочих инструкций в файле robots.txt для агента Яндекса необходимо указывать директиву host. Пример директивы приведен на рисунке ниже.

Синтаксис ее крайне прост. Сначала пишется служебное слово «Host:», далее через пробел вставляется главное зеркало сайта. При этом нужно учесть, что протокол http не пишется. Добавляется только https при его наличии. Убедитесь, что зеркало выставленное в Яндекс Вебмастере и других host (у сайтов-зеркал) соответствует указываемому в robots.txt. В противном случае Вы получите ошибку, о которой говорится выше.

Подробнее о директиве host

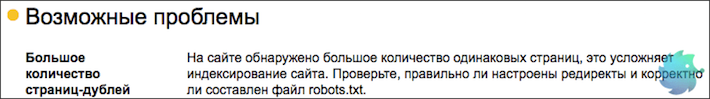

Большое количество страниц дублей

«На сайте обнаружено большое количество одинаковых страниц, это усложняет индексирование сайта. Проверьте, правильно ли настроены редиректы и корректно ли составлен файл robots.txt.» © Яндекс Вебмастер

Достаточно серьезная проблема, которая для решения, зачастую, требует квалифицированной помощи программиста. Страницы-дубли, по сути, представляют собой различные URL, которые ведут на одну и ту же страницу. (Реже, это несколько абсолютно одинаковых html файлов с разными URL)

Когда индексирующий робот попадает на сайт, он старается обойти все доступные URL адреса и загрузить по ним уникальный контент. Если робот переходит по адресу и «видит» уже загруженную ранее страницу, то он исключает ее из поиска как дубликат, при этом теряя драгоценное время обхода.

Определить наличие дублей возможно в Яндекс Вебмастере. Необходимо зайти в раздел «Индексирование» -> «Страницы в поиске» -> «Исключенные страницы». Тут будут представлены все исключенные из поиска разделы, в том числе и по причине дублирования. Для того, что бы долго не искать, можно настроить фильтр по статусу. (нажать на значок воронки рядом с заголовком)

После того, как все страницы будут отсортированы, Вы сможете увидеть имеющиеся дубликаты, о которых знает Яндекс.

Для решения данной проблемы необходимо, в первую очередь, определить причину появления дублей. Их может быть несколько.

-

При создании страницы, в CMS генерируется технический адрес, который обычно имеет вид «post=3333&action=edit» или любой другой не ЧПУ. Вы не хотите видеть подобный URL и создаете для страницы человекочитаемый адрес. Таким образом статья становится доступна по 2 адресам. В этом случае необходимо скрыть все технические адреса в robots.txt при помощи маски;

-

На сайте имеются динамические URL, которые дополняются различными префиксами в зависимости от выбранных параметров, поиска, сортировки и т.д. Их так же необходимо скрывать при помощи маски в robots или отказаться от динамических URL;

-

Во время настройки рекламы, для получения данных о клиенте и источнике, часто используются дублирующие ссылки с параметрами. Такие URL нужно сразу закрывать в robots.txt во избежание попадания в индекс;

-

Некоторые системы управления могут отображать страницу по нескольким человекочитаемым URL. К примеру, страница может быть доступна по всем 3-м адресам: «/page1/», «/page1.php», «/page1.html». Исключаются подобные дубли так же при помощи маски.

После того, как дубли будут закрыты для индексации, предупреждение пропадет автоматически. Но, не стоит думать, что это произойдет в первую неделю. Подобное сообщение может держаться месяцами.

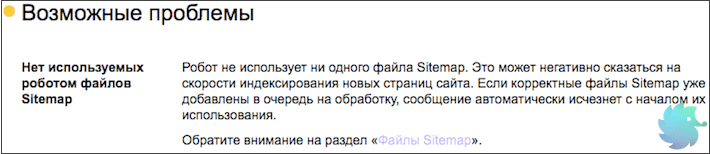

Нет используемых роботом файлов Sitemap

«Робот не использует ни одного файла Sitemap. Это может негативно сказаться на скорости индексирования новых страниц сайта. Если корректные файлы Sitemap уже добавлены в очередь на обработку, сообщение автоматически исчезнет с началом их использования.» © Яндекс Вебмастер

Это длинное сообщение описывает всего лишь отсутствие sitemap.xml. Что бы поправить ситуацию нужно просто создать данный файл и разместить его в корневом каталоге Вашего сайта. Ранее мы подробно рассказывали, как это сделать.

После создания необходимо зайти в Яндекс Вебмастер -> «Индексирование» — > «Файлы Sitemap» -> «Добавить карту». В этом же разделе возможно отследить корректность индексации и в случае необходимости обновить.

После того, как робот увидит sitemap сообщение о проблеме пропадет автоматически.

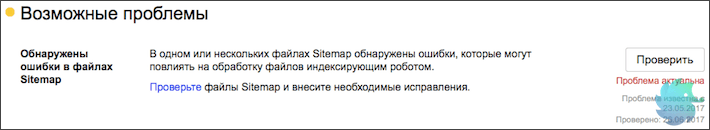

Обнаружены ошибки в файлах Sitemap

«В одном или нескольких файлах Sitemap обнаружены ошибки, которые могут повлиять на обработку файлов индексирующим роботом.» © Яндекс Вебмастер

В случае возникновения данной проблемы воспользуйтесь сервисом анализа sitemap.xml, который находится прямо в Яндекс Вебмастере. («Инструменты»-> «Анализ файлов Sitemap»).

Если ошибку не удается выявить, проще всего создать новую карту сайта. Как это сделать, подробно описывали ранее.

Если sitemap генерируется при помощи плагинов, обратите внимание на поля, которые находятся в итоговом файле. В отличии от Google, Яндекс не воспринимает инструкцию <image:image> и может сообщать об ошибке.

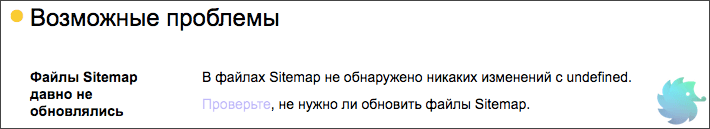

Файлы Sitemap давно не обновлялись

«В файлах Sitemap не обнаружено никаких изменений с undefined. Проверьте, не нужно ли обновить файлы Sitemap.»© Яндекс Вебмастер

Тут все просто. Необходимо обновить все имеющиеся на сайте файлы sitemap.xml. Причем сделать это нужно корректно. Вот лишь несколько ошибок, которые допускают при обновлении карты сайта.

-

Даты изменения страниц не соответствуют реальному обновлению страниц. Подобная ошибка происходит в тот момент, когда Вы используете online сервис. В таком случае все даты изменения могут быть одинаковыми и не соответствовать фактическим. Это заставляет поисковую систему повторно загружать один и тот же материал, что приводит к пустой трате времени;

-

Все страницы имеют один и тот же приоритет. В таком случае данный параметр sitemap.xml просто перестает иметь какой-либо смысл;

-

Вероятная частота изменения не соответствует действительной. Не стоит писать, что Ваши страницы обновляются каждый час. Обмануть поисковую систему не удастся и преимущества Вы не получите, но вот возможность корректного указания частоты обновления утратите.

Подробнее о создании sitemap.xml

Рекомендации

Этот раздел носит исключительно информационный характер, однако мы советуем соблюсти все его требования.

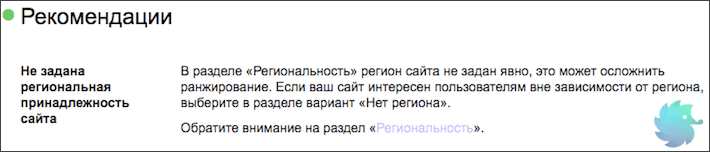

Не задана региональная принадлежность сайта

«В разделе «Региональность» регион сайта не задан явно, это может осложнить ранжирование. Если ваш сайт интересен пользователям вне зависимости от региона, выберите в разделе вариант «Нет региона».» © Яндекс Вебмастер

У данной проблемы есть две стороны медали. С одной — присвоение региона не является обязательной процедурой и Яндекс сам может определить его. С другой — если регион определен некорректно, то Вы можете получить нерелевантный трафик или же вообще лишиться его.

Поэтому мы настоятельно рекомендуем присваивать регион каждому сайту. Стоит отметить, что есть ряд ресурсов, которые не имеют региональной привязки. В таком случае необходимо сообщить Яндексу, что региона Вы не имеете.

Подробнее о том, как выбрать и присвоить регион.

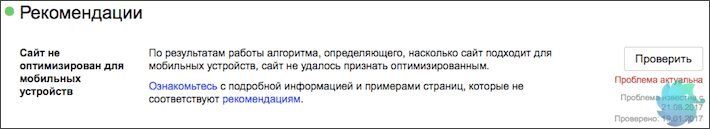

Сайт не оптимизирован для мобильных

«По результатам работы алгоритма, определяющего, насколько сайт подходит для мобильных устройств, сайт не удалось признать оптимизированным.» © Яндекс Вебмастер

Сегодня эта проблема должна находиться уже среди критичных. Поисковые системы не раз говорили о том, что будут занижать сайты не имеющие мобильной версии. С каждым годом процентное соотношение трафика с мобильных устройств растет, поэтому мобильная адаптация должна быть у всех.

Насколько корректно Ваш сайт адаптирован под мобильные телефоны и планшеты Вы можете определить с помощью официального сервиса Яндекса — «Проверка мобильных страниц» . Располагается он в разделе «Инструменты» Яндекс Вебмастера.

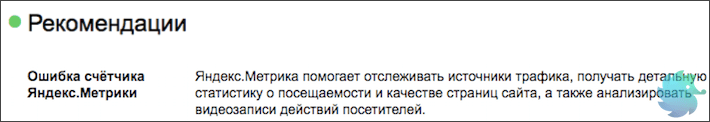

Ошибка счётчика Яндекс.Метрики

«Яндекс.Метрика помогает отслеживать источники трафика, получать детальную статистику о посещаемости и качестве страниц сайта, а также анализировать видеозаписи действий посетителей.» © Яндекс Вебмастер

Тут все просто. Скорее всего код Яндекс Метрики был установлен некорректно или не на все страницы.

Если Вы зайдете в счетчики и увидите красный значок слева от сайта — данные в Метрику не поступают. Нажмите на него.

Если он не станет зеленым, то просто переустановите счетчик. Для этого нужно:

-

Перейти в настройки нажав на значок шестеренки в правой части экрана;

-

Переходим на вкладку «Код счетчика» и копируем его;

-

Открываем шаблон, который формирует страницы сайта и вставляем в него код;

-

Переходим в метрику и нажимаем на красный кружок со стрелочкой. Он должен стать зеленым.

В случае, если Вы уверены, что код размещен правильно, но данные так и не поступают — обратитесь в службу поддержки или подробно ознакомьтесь с процессом установки счетчика.

Сайт не зарегистрирован в Яндекс.Справочнике

«Сайт не добавлен в Яндекс.Справочник. Если у вас есть офисы или филиалы, добавьте их в справочник, чтобы улучшить внешний вид сайта в поиске и региональное ранжирование. Если офисов и филиалов нет, явно укажите «Нет региона» в подразделе «Вебмастер» раздела настройки региональности.» © Яндекс Вебмастер

С точки зрения SEO, регистрация сайта в Яндекс Справочнике может дополнить сниппет такой полезной информацией, как телефон, адрес и режим работы. По брендовым запросам справа от сниппета начнет появляться карта с адресом и подробной информацией о фирме. Такие сниппеты любят пользователи, поэтому стоить уделить 15 минут на регистрацию.

Зарегистрироваться проще некуда. Это совершенно бесплатно.

-

Заходим в Яндекс Аккаунт и переходим по ссылке: https://yandex.ru/sprav/add/;

-

Вводим информацию о компании и нажимаем «Добавить организацию»;

-

Ожидаем одобрения модераторов. (Обычно проблем с этим не возникает)

После успешной модерации информация появится в выдаче через несколько обновлений.

Отсутствует файл favicon на сайте

«Не найден файл с изображением, которое должно отображаться во вкладке браузера и может быть показано возле названия сайта в поиске.» © Яндекс Вебмастер

Файл favicon.ico это небольшая картинка, которая отображается во вкладке браузера.

Favicon имеет расширение .ico и располагается в корневой папке сайта или шаблона.

Кроме отображения во вкладке, данное изображение присутствует в поисковой выдаче рядом со ссылкой на сайт. Именно поэтому о нем сообщает Яндекс.

Сделать favicon очень просто. Для этого нужно создать рисунок квадратной формы, после чего воспользоваться одним из множество online генераторов. Примеры таких сервисов:

-

http://pr-cy.ru/favicon/

-

http://www.favicon.ru

-

http://www.favicon.by

-

Множество других.

Скачайте получившийся файл, назовите его favicon.ico и разместите в корневой папке сайта. Несколько раз обновите браузер и Ваше изображение появится во вкладке рядом с доменом. В поисковой выдаче favicon обновится в течение 2-3 недель.

Отсутствуют быстрые ссылки

«В некоторых случаях в результатах поиска возможно отображение быстрых ссылок в сниппете сайта, что улучшает его видимость и количество переходов. Ссылки формируются полностью автоматически, роботы регулярно оценивают возможность показа быстрых ссылок.» © Яндекс Вебмастер

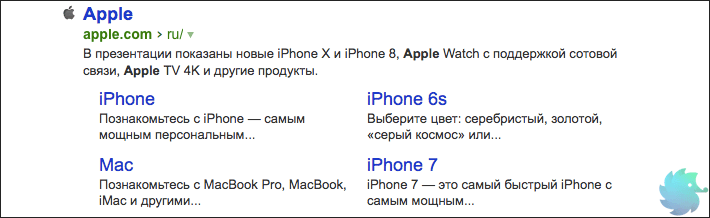

Это исключительно информационное сообщение, так как напрямую повлиять на вывод быстрых ссылок Вы не можете. Напомним, что последние располагаются под основным сниппетом сайта в органической выдаче. На рисунке ниже приведен пример быстрых ссылок для сайта компании Apple.

Но, несмотря на то, что напрямую влияния Вы не имеете, возможно «помочь» роботу определить быстрые ссылки. Делается это путем создания корректной древовидной структуры сайта. То есть, выделить основные разделы, сгруппировать в них подразделы и корректно связать все перелинковкой.

В этом случае Яндекс сможет с большей вероятностью определить основные разделы и сформировать блок быстрых ссылок.