Чтобы изменения вашего сайта быстрее отразились в результатах поиска Яндекса, сообщите об этом индексирующему роботу:

-

Перейдите в Вебмастер на страницу .

-

В поле укажите адрес обновленной страницы.

-

Нажмите кнопку Отправить.

Робот Яндекса посетит указанный вами адрес в приоритетном порядке при следующем обращении к сайту.

- Вы сообщили об участвующей в поиске странице

-

Изменения отобразятся в результатах поиска при очередном обновлении поисковой базы — в течение двух недель.

- Вы сообщили о новой странице

- Когда робот обойдет страницу, он загрузит ее в свою базу. Она сможет отображаться в результатах поиска, если будет отвечать на поисковый запрос пользователя. Подробнее см. в разделе Как работает поиск Яндекса.

Если через некоторое время на странице появился статус Ошибка, значит робот не смог проиндексировать страницу и обновить информацию о ней в поисковой базе. Проверьте, что страница доступна для робота и сервер возвращает ответ достаточно быстро. После этого отправьте страницу на переобход повторно.

Чтобы ваш вопрос быстрее попал к нужному специалисту, уточните тему:

Проверьте, что:

-

страницы доступны для робота с помощью инструмента Проверка ответа сервера;

-

информация о страницах есть в файле Sitemap;

-

в файле robots.txt запрещающие директивы Disallow, noindex и HTML-элемент noindex закрывают от индексирования только служебные и дублирующие страницы.

Если при удалении страниц сайта вы следовали инструкциям и после того, как сайт посетил робот Яндекса, прошло больше двух недель, заполните форму ниже:

Если вы использовали редирект, робот постепенно отследит перенаправление, и по мере обхода сайта старые страницы будут пропадать из результатов поиска. Чтобы робот быстрее узнал об изменениях, отправьте страницы на переобход.

Если адреса страниц меняются со сменой доменного имени сайта, то на обновление данных в поиске может потребоваться более месяца. Проверьте, правильно ли настроены зеркала.

Кратко самое важное об основах: как решить проблемы с индексацией и ускорить ее в Яндексе и Google.

В статье разберем типичные проблемы, а потом поговорим об ускорении. Постараемся лаконично)

Проблемы с индексацией:

❌ Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход.

Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию.

Также запрет может быть в HTTP-заголовке X-Robot-Tag, который находится в файле конфигурации сервера. Проверить запрет через X-Robots-Tag можно в инструменте бесплатно.

❌Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика.

Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Проверьте уведомления о Вебмастере и Консоли, часть санкций сопровождаются письмом от поисковика. Подробно в материалах о санкциях Яндекса и фильтрах Google.

❌ Страницы индексируются, но нужно долго ждать

Вариантов может быть много: вы редко обновляете контент, поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке… Проблема может быть в других ошибках на сайте, например, в куче ошибочных лишних страниц, сгенерированных движком, на которые тратится время.

Итак, если страницы не индексируются, то проверьте ограничения, если игнорирует поисковик, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить.

Как ускорить индексирование:

Лучший способ улучшить процесс индексирования — создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим

Джон Мюллер, представитель Google

Ага, классно. Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный… 😅

Что реально можно сделать, чтобы ускорить процесс.

1. Отправить страницу на переобход

Найдите переобход страниц в Google Search Console и Яндекс.Вебмастере и отправьте нужные URL на индексацию.

2. Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива “disallow”, “nofollow”, можно использовать мета-тег “noindex” или “none”. Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться.

А может и не прислушаться — это всего лишь рекомендации, а не прямое указание. 🤷♂

3. Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Сотрудник Google советовал добавлять на страницу видео с Youtube, если странице нечего добавить и содержание еще актуально. Поведенческие улучшатся за счет просмотра видео, на странице появится новый формат контента — это тоже хороший сигнал для поисковика.

4. Создать динамическую Sitemap

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться.

Для проектов на конструкторах сайтов, например, на Tilda, карта по умолчанию динамическая, для CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

5. Пометить обновления в Sitemap

Можно указать обновленные файлы в Sitemap вручную. Google рекомендует отметить страницы в Карте тегом < lastmod > и отправить страницу на переобход.

Но, опять же, ссылки в Карте сайта — это рекомендации.

6. Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования.

Такие страницы называют сиротами.

Нужно встроить их в структуру сайта.

В этой схеме каждая страница имеет ссылку с родительской категории, но они могут линковаться и между собой:

На поведение бота влияет количество кликов от главной до текущей страницы. Бот переходит на страницы по ссылкам с главной. Чем меньше кликов от главной до искомой страницы, тем она важнее, тем быстрее он до нее доберется и просканирует.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

7. Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, если в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Сомневаемся, что так уж много сайтов загружаются медленнее минуты, но всё возможно. На всякий случай проверьте скорость в сторонних инструментах.

Многое из перечисленного можно проверить автоматически в сервисе для анализа сайта. Ту же скорость — он быстро проанализирует этапы загрузки и отдельно найдет конкретные страницы, на которых есть проблема со скоростью.

Оцените пост, если было полезно 🙂 И напишите в комментариях, если вам есть что добавить к списку.

Актуальные способы ускорить индексирование страниц в обоих поисковиках. Обновленный материал.

В статье:

-

Проблемы с индексацией сайта в ПС

-

Как ускорить индексацию страниц

-

FAQ: что влияет на скорость индексации сайта

Чем быстрее страница займет место в выдаче поисковой системы, тем быстрее ее смогут увидеть пользователи, и тем больше вероятность, что она будет считаться первоисточником контента.

Нельзя точно сказать, когда боты поисковых систем просканируют страницу и она появится в выдаче. На частоту индексирования страниц ботами влияет:

- Частота обновления контента страниц. Боты составляют краулинговый бюджет сайта на основе данных об обновлении контента. Если страницы не меняются, нет смысла их часто сканировать.

- Поведенческие факторы, которые обрабатывают поисковые боты. Чем лучше ПФ, тем востребованнее сайт у аудитории, а это еще один сигнал к повышению внимания от робота.

- Хостинг. На загруженном хостинге снижается скорость обработки запросов от робота.

Разберем типичные проблемы, с которыми сталкиваются оптимизаторы.

Частые проблемы с индексацией сайта в ПС

Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход. Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию. Также запрет может быть в HTTP-заголовке X-Robot-Tag, который находится в файле конфигурации сервера. Проверить запрет через X-Robots-Tag можно в инструменте бесплатно.

Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика. Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Помогут материалы о санкциях Яндекса и фильтрах Google.

Страницы индексируются, но долго

Если приходится долго ждать индексации новых страниц, вариантов может быть много: контент редко обновляется и поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке или проблема в чем-то другом. Способы ускорить индексацию мы разберем дальше.

Посмотреть динамику индексации страниц и найти ошибки в SEO можно в сервисе для анализа сайта от PR-CY:

Итак, если страницы не индексируются, то проверьте ограничения, если игнорирует поисковик, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить.

Как ускорить индексацию страниц

Представитель Google Джон Мюллер на вопрос об индексировании ответил так:

«Лучший способ улучшить процесс индексирования — создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим. Нужно также понимать, что поисковые системы не индексируют абсолютно все, что выложено в сети».

Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный. 🙂 Это все, конечно, хорошо, но давайте посмотрим, что конкретно можно сделать, чтобы ускорить процесс.

Отправить страницу на переобход

Можно дополнительно обратить внимание поисковиков на конкретные URL. В Google Search Console и Яндекс.Вебмастере найдите переобход страниц и отправьте нужные URL на индексацию.

В Яндекс.Вебмастере это раздел Индексирование — Переобход страниц. В консоли Google это Инструмент проверки URL.

Массовая отправка страниц на переиндексацию в Google

Есть способ отправлять на повторное сканирование не по одной ссылке за раз, а по 200 URL в день. В этом мог бы помочь бесплатный скрипт, который сделал SEO-отдел компании Journey Further на базе Indexing API Google. Проблема в том, что для его работы понадобится аккаунт в Google Cloud Platform, но в марте Google перестал регистрировать пользователей из России в своем облачном сервисе.

Если вы не из РФ, можете настроить скрипт для массовой переиндексации URL. Для этого нужно:

-

Установить node.js.

-

Создать сервисный аккаунт в Google Cloud Platform.

-

Создать закрытый JSON-ключ.

-

Скачать скрипт и вставить ключ вместо содержимого service_account.

-

Связать скрипт с Google Search Console: назначить владельцем client_email. Нужен не полный доступ, а именно роль «Владелец».

-

Перейти по ссылке, выбрать сервисный аккаунт, который вы создали, и включить Index API.

-

В папке скрипта открыть файл urls и внести в него до 100 URL. Если нужно больше, можно отправить еще до 100 во втором заходе. В день можно отправлять не больше 200 ссылок.

-

Вызвать PowerShell, зажав Shift и правую кнопку мыши в окне.

-

Прописать node index.js.

-

Готово, через несколько секунд появится 200 ОК.

Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива “disallow”, “nofollow”, можно использовать мета-тег “noindex” или “none”. Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться. А может и не прислушаться.

Как говорит Ксения Пескова, SEO-TeamLead в Siteclinic:

«Если вы закроете сканирование в файле robots.txt — это всё равно может не уберечь от индексации страницы, так как в файле мы запрещаем сканирование, и это всего лишь рекомендации, а не прямое указание».

В любом случае, лучше проверить файл robots, вдруг там стоят запреты, к которым прислушались боты поисковых систем.

Создать Sitemap — Карту сайта

Карта сайта помогает поисковым ботам понять структуру ресурса и обнаруживать обновления контента.

Почитать по теме:

Как составить карту сайта (файл Sitemap)

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться. Для проектов на конструкторах сайтов, например, на Tilda, карта по умолчанию динамическая, для CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

Можно обновить файл Sitemap вручную. Обновленные страницы Google рекомендует отметить в Карте тегом < lastmod >. Обновленный файл отправьте с помощью специального отчета. Не стоит загружать один и тот же файл повторно: если вы ничего не поменяли в Карте сайта, никаких изменений не будет.

Но опять же, ссылки в Карте сайта — это рекомендации, важнее создать грамотную структуру сайта и организовать внутреннюю перелинковку.

Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования. Такие страницы называют сиротами.

Нужно встроить их в структуру сайта. К примеру, в этой схеме каждая страница имеет ссылку с родительской категории, но они вполне могут линковаться и между собой:

Еще один момент, который влияет на поведение бота — это Click Distance from Index (DFI), то есть количество кликов от главной до текущей страницы. Чем оно меньше, тем важнее считается страница, тем больший приоритет она получит с точки зрения бота. Приоритетные страницы он смотрит первее остальных.

DFI не определяется по числу директорий в URL, они могут не совпадать. Например, если на главной странице будет ссылка на хит продаж — конкретную модель холодильника Atlant, то DFI будет равен двум. Но при этом карточка модели может находиться в каталоге и подразделе каталога, тогда директорий будет больше — site.com/shop/refrigerator/one_chamber_refrigerators/atlant/h_1401_100.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

Александр Шестаков, руководитель продукта Links.Sape:

«Внутренняя перелинковка положительно влияет сразу на несколько параметров, например, увеличивает трафик и упрощает работу поисковых роботов. Также ускорению индексации способствуют внешние ссылки из качественных источников (сайтов с высоким трастом и уровнем трафика).

При этом любую внешнюю ссылку можно усилить, закупив дополнительные ссылки на страницу, с которой она исходит. Такая стратегия многоступенчатого усиления называется Tier 2.

Существуют и более сложные разветвленные стратегии, например Tier 3-5. Эти методы приводят к увеличению веса страницы, и не только качественно ускоряют индексацию сайта, но и влияют на рост позиций. При этом усиление ссылок не вызывает у поисковых систем подозрения в манипуляциях».

Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Сотрудник Google советовал добавлять на страницу видео с Youtube, если странице нечего добавить и содержание еще актуально. Поведенческие улучшатся за счет просмотра видео, на странице появится новый формат контента — это тоже хороший сигнал для поисковика.

Материал по теме:

Как переупаковать контент

Публиковать ссылки в соцсетях и на других площадках

Найдите сторонние сайты по вашей тематике, где можно оставлять ссылки или публиковать посты, и размещайте таким образом ссылки на новые материалы.

CTO компании Pear Advert Иван Самохин:

«Вопрос индексации остается актуальным не только для вашего сайта, но и для страниц с ссылками на ваш ресурс. Убедитесь в том, что страницы с внешними ссылками находятся в индексе поисковых систем, иначе оказать положительное влияние на продвижение сайта они не смогут».

Вы можете договориться о партнерстве с площадкой, близкой вам по тематике, и обмениваться ссылками. Главное, что размещения ссылок должны выглядеть естественными и подходить по теме. К примеру, ссылка на магазин рыболовных снастей будет уместно выглядеть на форуме рыболовов или туристическом портале. Ищите справочники, форумы, другие соцсети, отзовики, сервисы вопросов и ответов и другие площадки для размещения.

Материал по теме:

Как получить ссылки на сайт бесплатно

Если вы ведете страницы в социальных сетях, размещайте на них анонсы ваших новых материалов. С помощью разметки OpenGraph можно задать ссылке красивое превью с нужной картинкой и заголовком, и получить переходы пользователей на страницу.

Отследить популярные страницы поможет сервис сквозной аналитики и коллтрекинга Calltracking.ru. С его помощью вы сможете понять:

- с каких страниц поступают целевые и нецелевые обращения;

- есть ли проблемы с версткой на страницах сайта;

- на какие страницы увеличивать трафик и запускать рекламу.

Сервис помогает оптимизировать рекламу с учетом всех лидов и их стоимости.

Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, если в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Медленная загрузка страниц вредит им по всем параметрам: пользователи не ждут, а поисковые системы считают страницы некачественными и могут даже понизить сайт в выдаче, если проблема с загрузкой есть у всех страниц.

Материал по теме:

Полное руководство по ускорению сайта

Многое можно проверить на сайте автоматически. Поможет сервис для анализа сайта: он оценит загрузку сайта и отдельно найдет конкретные страницы, на которых есть проблема со скоростью.

Аудит сайта с проверкой внутренних страниц доступен на всех платных тарифах.

Вы можете попробовать неделю бесплатно и оценить все возможности сервиса.

FAQ: что еще влияет на скорость индексации сайта

Как страницы вне индекса могут повлиять на отношение поисковика к сайту?

Качество контента на сайте поисковики оценивают только по проиндексированным страницам.

Тег noindex может влиять на индексацию страницы после его снятия?

По словам Джона Мюллера из Google, у веб-мастера не будет проблем с реиндексацией URL, на которых когда-то был noindex.

Как редирект влияет на индексацию страниц?

Джон Мюллер утверждает, что поисковик скорее всего не проиндексирует конечный URL при использовании ссылок с 301 редиректом.

Как ускорить индексацию страниц, которые были 404?

Если адрес страницы отдавал 404 и не был индексирован, на индексирование может потребоваться некоторое время. Как советуют Seroundtable, можно создать новый URL для этого контента и настроить 301 редирект со старого адреса, либо запросить повторное сканирование URL.

Как поисковики относятся к URL c хэшами?

URL с хешами поисковик не проиндексирует. То есть ссылка https://site.ru/news/p/statya проиндексируется, а ссылка на конкретную часть статьи — https://site.ru/news/p/statya#step — нет.

Расскажите, какие способы ускорить попадание в индекс знаете вы? Добавьте в комментариях, если мы что-то упустили в материале.

Время прочтения: 9 минут

Тэги: SEO, Optimization, Google

О чем статья:

- Какие основные проблемы возникают при индексации страниц

- Какие ниши бизнеса больше всего страдают от проблем с индексацией

- Что мешает индексации сайта?

- Как узнать, есть ли проблемы с индексацией у вашего сайта?

- Как исправить проблему с индексацией

- Как настроить Google Indexing API

- Могут ли быть проблемы с индексацией в Яндексе

- Выводы

Для кого статья:

- Маркетологов;

- Специалистов по SEO;

- Агентств по продвижению сайтов.

Как решать проблемы с индексацией, какие ниши бизнеса они затрагивают и как получить максимум результата при минимуме ручного труда? Об этой и других проблемах с попаданием страниц в индекс поисковиков на конференции Optimization-2022 рассказал Захар Федоренко, SEO Team Lead в Rush Agency.

Какие основные проблемы возникают при индексации страниц

На момент написания статьи мы говорим о проблемах индексации применительно в основном к поисковой системе Google. Дело в том, что в другом популярном поисковике, Яндексе, такие проблемы на сегодня практически не возникают. А вот в Google очень многие сайты сталкиваются с тем, что:

-

Страницы не попадают в индекс;

-

Страницы очень долго попадают в индекс;

-

При изменении контента в индексе очень долго остается старая версия документа.

Чем это плохо для бизнеса:

-

Если страниц нет в индексе, то они не приносят поисковый трафик

-

Сайт получает низкий краулинговый бюджет, что, в свою очередь, снижает квоту на индексацию страниц.

Все это затрудняет поисковое продвижение сайта.

Мнение эксперта

Захар Федоренко, SEO Team Lead в Rush Agency:

«Многие говорят: SEO – это долго. На самом деле можно сделать так, чтобы в срок до четырех дней роботы узнали о ваших изменениях и ранжировали ваш сайт лучше».

Какие ниши бизнеса больше всего страдают от проблем с индексацией

В целом сложности индексации затрагивают все тематики. Приведем наиболее яркие примеры.

1. Онлайн-магазины. Например, ecom-проект внедряет теговые категории, которые потенциально являются довольно крупными точками роста. Если они не попадают в индекс, они не дают профита, и бизнес теряет деньги, а SEO-специалисты не видят результат своей работы.

2. Информационные сайты. Здесь ситуация аналогична: отсутствие индексации новых блоков не позволяет страницам получать органический трафик.

Мнение эксперта

Захар Федоренко, SEO Team Lead в Rush Agency:

«Приведу пример: мы на сайте создали блог, сделали новые категории, постепенно заполняли их контентом. Робот Google один раз зашел, увидел, что блог пустоват, запомнил это. И, сколько мы далее не публиковали статьи, они не индексировались, пока я не активировал бота. Как – расскажу ниже».

3. Сайты услуг. Например, в нише онлайн-образования страница может долго не попадать в индекс или даже выпадать из него – такое наблюдалось весной-летом 2022 года после обновления поисковых алгоритмов Google. При этом, когда документы индексируются, они начинают приносить много трафика.

4. Лендинги. Google вообще скептически относится к сайтам, у которых мало страниц, поэтому плохо индексирует лендинги. Тем не менее возможно даже новый небольшой сайт проиндексировать достаточно быстро, за несколько дней, не тратя при этом дополнительный бюджет.

Что мешает индексации сайта?

Для начала проанализируем, почему робот не хочет заходить на проект.

Техническая оптимизация сайта – банальное требование, про которое знают все, тем не менее зачастую оно является причиной отказа в индексации. Проверьте, что у вас есть правильно настроенный файл robots.txt, карта сайта sitemap.xml, отсутствуют нерабочие ссылки, дубли страниц и метатегов. Так же важно, что все страницы, которые потенциально могут приносить трафик, давали ответ сервера 200 ОК.

Также важна внутренняя перелинковка. Например, в онлайн-магазине желательны расширенные «хлебные крошки», сквозные ссылки, связывающие категории. В карточке товара нужен блок с похожими либо дополнительными товарами. На информационном сайте хорошо работают подборки «Похожие статьи», «Другие статьи автора» им подобные.

На индексацию в Goоgle очень сильно влияет скорость загрузки сайта. Вопреки распространенному мнению, что улучшение скорости загрузки дает выгоду в виде повышения позиций, на многих проектах на практике на ранжировании скорость загрузки не отражается. Зато она сильно улучшает индексацию. Если сайт долго грузится, робот может просто уйти вместо перехода по нужным вам ссылкам и добавления их в индекс.

Мнение эксперта

Мнение эксперта: Захар Федоренко, SEO Team Lead в Rush Agency:

«Что можно сделать со скоростью загрузки? Обычно оптимизатор ставит ТЗ разработчику на ускорение загрузки сайта. Выглядят эти ТЗ достаточно однотипно: скриншот теста сайта из PageSpeed Insights с указанием, что этот и тот параметры надо улучшить. Это не мотивирует программиста. Советую взять несколько основных конкурентов помимо вашего сайта и проверить в PageSpeed Insights главные страницы, страницы категория, несколько карточек товаров. После чего сделайте табличку, в которой наглядно отразите ваши данные и показатели конкурентов. На этом основании вы можете аргументированно требовать определенных значений скорости загрузки вашего сайте».

Алгоритмы поисковых систем охватывают весь мир. Google держит в индексе огромное количество адресов, и неудивительно, что случаются сбои. Например, у компании был не очень хороший сайт, поэтому были проведены работы по его улучшения, обновили качественным и полезным контентом. Но робот как запомнил один раз ресурс с низким качеством, так и перестал на него заходить. Ниже расскажем, как добиться, чтобы алгоритм совершил переобход страниц.

Низкое качество страниц означает несоответствие сайта критериям Google Page Quality. Мы подробно рассказывали о них в статье «Что такое алгоритм E-A-T и как делать контент, который полюбит Google?». Добиться релевантности этим метрикам можно разными путями. Например, использовать конкурентный анализ. Откройте топ-10 в вашей тематике и просмотрите сайты конкурентов, выявляя, какие элементы есть у них на страницах, которых нет у вас. Некоторые блоки могут реально сильно влиять на ранжирование, например, онлайн-калькулятор ОСАГО в тематике страховых услуг. Попытайтесь себя внедрить подобный функционал у себя на сайте.

Мнение эксперта

Захар Федоренко, SEO Team Lead в Rush Agency:

«Если вы действительно поработаете над сайтом, сделали аудит контента, подняли его качество, то, когда страница попадет в индекс, она может сразу получать поисковый трафик, соответственно, давать больше лидов и конверсий. При этом новые страницы, которые робот индексирует, могут положительно влиять на индексацию старых. Для этого не надо покупать ссылки, как советуют некоторые, они не способствуют ранжированию. Вам просто надо проинформировать Google о том, что надо проиндексировать или заново обойти такие-то страницы».

Как узнать, есть ли проблемы с индексацией у вашего сайта?

Существует множество инструментов, которые позволяют это сделать. Приведем несколько примеров.

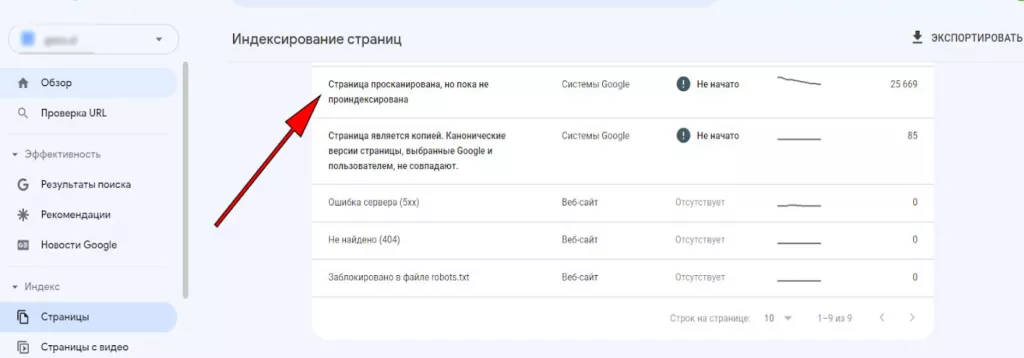

Google Search Console – бесплатный инструмент поисковика. Зайдите в настройки, раздел «Индексирование страниц» и увидите, сколько страниц просканировано роботом, но не проиндексировано.

Справа наверху указано общее количество таких документов. Если у вас довольно много адресов, которые не вошли в индекс, вам надо что-то предпринять по этому поводу. Google Search Console обновляет данные раз в четыре дня, поэтому, если вы хотите видеть результат раньше, вам понадобятся сторонние инструменты.

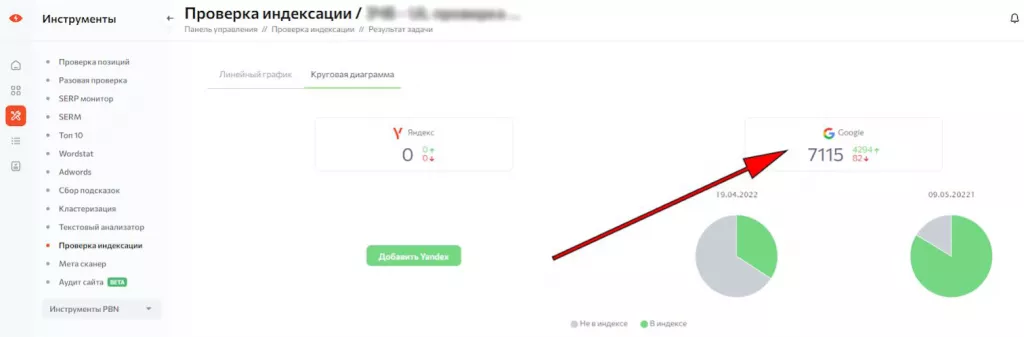

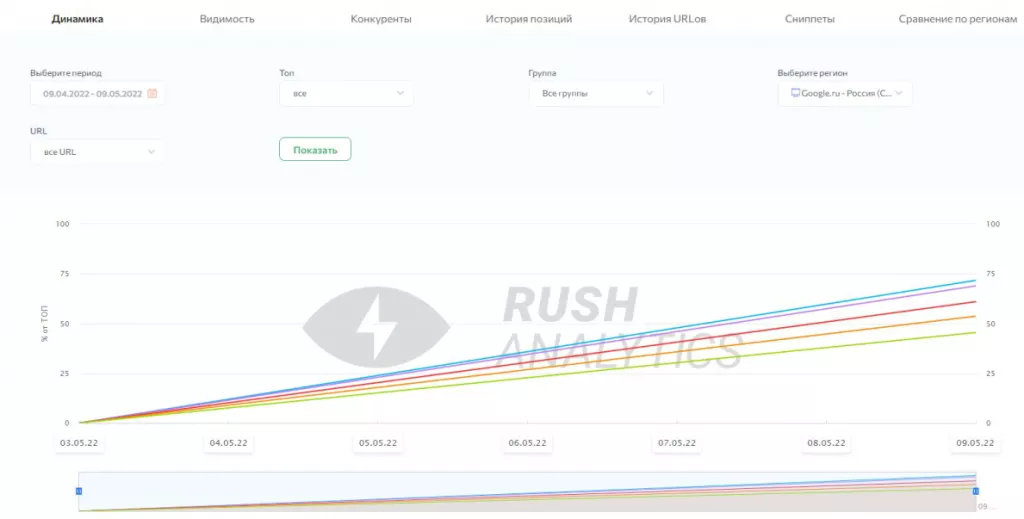

Rush Analytics – инструмент проверки индексации, куда можно загружать URL и смотреть динамику, графики, выгружать данные в формате для электронных таблиц, строить дашборды, отражающие различные сегменты. На скриншоте ниже можно видеть сравнение количества проиндексированных и не проиндексированных страниц в Google в виде круговой диаграммы.

Также специалисты используют такие сервисы как Screaming Frog SEO Spider, A-Parser, SiteAnalyzer, Key Collector для проверки индексации страниц.

Как исправить проблему с индексацией

Допустим, вы увидели, что большое количество страниц с сайта не проиндексировано. Что делать? Расскажем пошагово.

1. Проверьте, корректно ли Google отображает сайт. Этому может препятствовать использование JavaScript или то, что в robots.txt закрыты некоторые скрипты, стили, изображения. Тогда робот видит сайт недооформленным и считает его некачественным. Попробуйте выключить JavaScript в браузере и посмотреть, корректно отображаются основные элементы на странице либо нет. Затем в Google Search Console введите адрес страниц, которые вас интересуют, и в режиме реального времени увидите, как поисковик видит вашу страницу. Также в кеше выдачи можно посмотреть сохраненную копию страницы, как она выглядела до внесения вами изменений.

2. Проработайте контент на неиндексируемых страницах. Возможно, он реально плох и поисковая система считает, что не стоит такое содержание заносить в индекс. Сделайте аудит содержания, сравните с конкурентами.

3. Проработайте структуру сайта и его внутреннюю перелинковку. Чем перелинковка лучше, тем больше вероятность, что страница попадет в индекс. Вероятно, используется фактор внутреннего веса страницы, и если документ оказывается в тупиковой зоне, робот может решить, что он не столько важен, чтобы его индексировать.

4. Проверьте корректность файла robots.txt. Проверьте, что не запрещены для индексации элементы, влияющие на внешний вид сайта.

5. Проверьте наличие и корректность sitemap.xml, и обязательно сделайте его доступным в Google Search Console. Иногда после этого добавления Google Search Console все равно показывает, что в индексе ноль URL. Часто причиной является низкая скорость загрузки страниц, когда sitemap генерируется при запросе и это занимает более 5 секунд. Тогда нужно сделать sitemap статическим и обновлять его не при каждом запросе, а с установленной периодичностью. Также полезно добавить в robots.txt ссылку на sitemap. Иногда после этого робот Google начинает обходить ссылки из карты сайта.

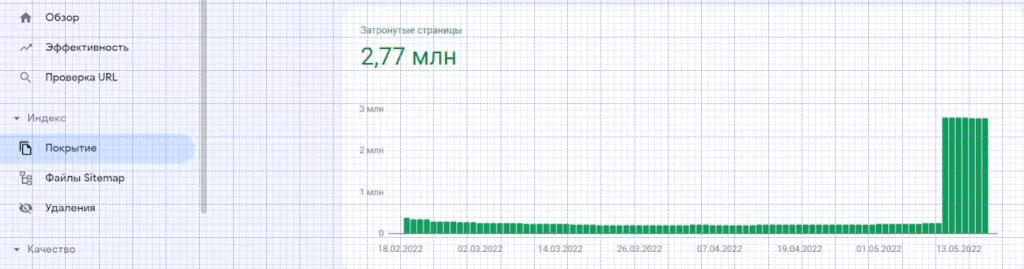

6. Отправьте адреса нужных страниц через Google Indexing API. Это инструмент поисковой системы, который позволяет, например, проиндексировать за 10 дней более 2,5 миллионов страниц – результат на скриншоте.

Многие думают, что через Google Indexing API можно проиндексировать небольшое количество страниц, так как слышали про лимит в 200 адресов в сутки. На самом деле можно сделать гораздо больше. При помощи этого инструмента многие вещи оптимизатор может делать сам, не делегируя программистам и не дожидаясь, пока у них будет время на задачи SEO.

Мнение эксперта

Захар Федоренко, SEO Team Lead в Rush Agency:

«Почему индексирование столь важно? Потому что после улучшения индексации можно наблюдать корреляцию с ростом органического трафика. Страницы, попадая в индекс, начинают ранжироваться по целевым запросам и улучшают видимость. У нас есть кейсы, где мы не делали ничего, кроме индексации, а документы сразу начинали приносить трафик, выросло число показов и кликов. Стоит отметить, что рост трафика помимо индексации зависит от SEO-оптимизации страниц, конкуренции и ниши, в которой находится ваш бизнес. Если с этим все в порядке, то, проиндексировав адреса, можно через день-два получить трафик».

Кейс 1

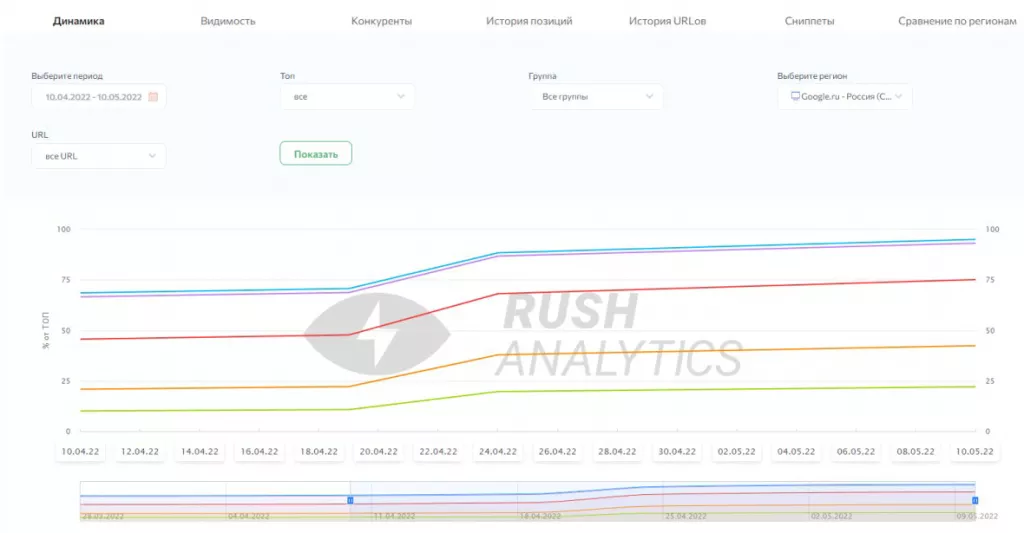

На скриншоте ниже показана динамика запросов, под которые были созданы страницы, не попавшие в индекс. После индексации виден резкий скачок, эти URL заняли топ-1, вошли в топ-10, топ-30.

Динамика запросов довольно резко возрастает после попадания в индекс.

Кейс 2

Был сделан срез запросов конкретно под те страницы проекта, которых не было в индексе Google, порядка 100 000 страниц, важных для сайта. Их отправили на индексацию через Google Indexing API, через неделю сняли позиции, чтобы проследить корреляции. Результат на графике ниже.

Почти по всем запросам страницы начали ранжироваться, приносить трафик, позиции, лиды.

Как настроить Google Indexing API

Для работы требуется подключиться к Google Indexing API и настроить Json-ключ. Для этого:

-

Создайте проект в Google Cloud Platform, а в нем – сервисный аккаунт, через который будут отправляться запросы по API.

-

В колонке «Действия» сервисного аккаунта сгенерируйте Json-ключ, который автоматически скачается на ваш компьютер.

-

В строке поиска Google Cloud Platform введите Indexing API, перейдите на результат и включите эту функцию.

-

Добавите созданный аккаунт (или аккаунты для крупных проектов) в Google Search Console как владельца домена в разделе «Пользователи и разрешения».

Чтобы не делать это вручную для каждого блока страниц, настройте скрипты для индексации в Google Indexing API. Более подробную инструкцию и ссылки на скрипты для небольших и крупных проектов, а также для удаления страниц из индекса можно посмотреть на Google Диске Захара Федоренко. Иногда необходимо удалять страницы, которые не должны быть в индексе, но попали в него. Также следует удалять документы низкого качества, чтобы не понижать общее качество сайта для Google.

Мнение эксперта

Мнение эксперта: Захар Федоренко, SEO Team Lead в Rush Agency:

«По умолчанию Google предоставляет 200 URL на один проект в день для работы через Google Indexing API. С большими сайтами этого явно недостаточно. Можно запросить увеличение квоты для проекта. Запрос отправляется через Google Search Console в разделе «Квоты» – «Изменить» – «Отправьте запрос на увеличение квоты». Важно: нельзя запрашивать увеличение лимита более чем в два раза за одно обращение. То есть в первое обращение нужно запросить увеличение лимита с 200 до 400 на проект. Через несколько дней после одобрения можно отправлять следующий запрос – с 400 до 800. И так далее».

Могут ли быть проблемы с индексацией в Яндексе

На сегодня сложностей с индексацией в Яндексе в отличие от Google нет. Если вдруг у вас возникли такие проблемы, нужно в Яндекс Вебмастере включить «Обход по счетчикам». Тогда при заходе пользователя на страницу Метрика будет генерировать запрос в Вебмастер, а тот добавлять адрес в индекс. Минус этого способа – могут генерироваться типа страниц, которых нет на сайте. Проверяйте Вебмастер регулярно и при необходимости склеивайте такие страницы в файла robots.txt директивами сlean-param. «Яндекса».

Выводы

-

Добавление страниц в индекс поисковых систем – часть работ по оптимизации. Если страницы не проиндексированы, они не приносят трафик, лиды и конверсии. Индексация новых страниц положительно сказывается на положении старых.

-

От проблем с индексацией в Google более всего страдают интернет-магазины, инфосайты, сайты услуг, лендинги. В целом это сложность может затронуть любой сайт, лишая его трафика и позиций.

-

Индексации сайта мешают технические ошибки на нем, некачественный контент и нюансы работы алгоритмов поиска.

-

Для определения количества проиндексированных и не включенных в индекс страниц сайта используйте Google Search Console и любой аналогичный инструмент.

-

Для исправления проблем с индексацией проверьте техническое и контентное качество ресурса, а также не стоит ли запрет на обход роботом элементов, необходимых для корректного отображения сайта. Затем используйте Google Indexing API, чтобы сообщить поисковику о наличии новых хороших страниц на сайте.

Даже начинающие интернет-бизнесмены в курсе, что «Переобход страниц» в Вебмастере Яндекса — нужная опция, позволяющая ускорять индексацию и переиндексацию страниц. Сегодня, опираясь на свой более чем 10-летний опыт сайтостроения, расскажу, в каких ситуациях этот инструмент особенно пригодится, и как им пользоваться правильно.

Содержание

- Переобход страниц в Вебмастере: что это такое?

- Зачем может понадобиться переиндексация

- Частые причины плохой индексации

- Инструкция: как использовать инструмент

- Отправка на переобход

- Отслеживание статусов

- Мониторинг страниц

- Что делать, если произошла ошибка?

- Полный переобход по Sitemap

- Обход по счетчикам Метрики

- IndexNow как альтернативный способ

- Советы по ускорению индексации

- Проверьте запреты

- Устраните ошибки

- Проанализируйте структуру

- Поработайте над внешним ссылочным

- Не забывайте про обновления

Переобход страниц в Вебмастере: что это такое?

Первый шаг на пути к получению трафика с новых страниц (неважно, будь это информационные статьи или карточки с товарами в интернет-магазине) — это их быстрая индексация поисковыми системами (ПС) с последующим ранжированием и попаданием в ТОП выдачи.

Быстроробот забирает информацию в поисковую базу между обновлениями основного индекса, поэтому все собранные им изменения будут учтены и проявлены не сразу, а только после очередного апдейта поисковика.

Зачем может понадобиться переиндексация

Рекомендую активно использовать данный инструментарий при внесении изменений на свои проекты. Причины, по которым может понадобиться переобход, многочисленны.

Вот самые распространенные случаи.

- На сайте появились обновления, о которых вы хотите быстро сообщить поисковику: свежая статья, новость, карточка товара (если это интернет-магазин), категория, страница меток и так далее.

- При обходе поисковым ботом возникли технические ошибки: робот не смог обойти страницу (посыпались ошибки в Вебмастере), либо она выпала из индекса (например, как малополезная), и вы желаете поскорее вернуть ее обратно.

- Вы только создали проект и хотите как можно быстрее сообщить о нем Яндексу. Молодые веб-ресурсы могут долго не индексироваться. Для них переобход особенно полезен и дает дополнительный сигнал ПС о том, что с проектом все в порядке.

- Ежедневно публикуете большое количество новых материалов. В этом случае переобходчику следует сообщить про наиболее важные и интересные из них (расставить приоритеты), чтобы они первыми попали в основной индекс.

- Вы внесли важные правки на каком-либо урле. Например, добавили или удалили лишние ключи из текста, поменяли title и description, чтобы сделать страницу более релевантной нужным запросам. Или, наоборот, почистили ее от переспама. Здесь также требуется ускоренно оповестить поисковик об изменениях.

- У вас молодой развивающийся ресурс, с которого регулярно воруют тексты. Учитывая, что инструмент «Оригинальные тексты» в Вебмастере был закрыт несколько лет назад, сейчас особенно важно своевременно сообщать Яндексу о новом контенте. Ваши странички должны индексироваться первыми, чтобы ПС понимала, кто создатель, а кто — вор, выкладывающий неоригинальные статьи.

- Если вы не успели закрыть от индексации все дубли, и некоторые из них попали в основную выдачу вместо продвигаемых страниц, нужно быстро внести правки и отправить на переобход.

Когда на проекте нет особых проблем с индексацией и корректно настроен Sitemap в формате xml, дополнительно использовать инструмент переобхода необязательно. Но это в идеале.

Частые причины плохой индексации

Самые популярные причины медленной или только частичной индексации интернет-ресурса:

- Сайт скрыт от поисковиков (как правило, сразу и от Яндекса, и от Google) и не индексируется вовсе.

- Санкции и фильтры ПС.

- Много технических недочетов.

- Сложная многоуровневая структура, при которой искомая страница может оказаться в 5–6 кликах от главной страницы.

- Длительное отсутствие обновлений.

- Отсутствие внешних и внутренних ссылок.

Инструкция: как использовать инструмент

Отправка на переобход

Запустить инструмент очень просто.

- Сайт уже должен быть добавлен в Панель Вебмастера. Зайдите в нее, нажав на соответствующий адрес в списке «Мои сайты».

- По умолчанию откроется раздел со сводной информацией. Но вам нужно в левой части экрана среди ссылок на разделы найти ссылку «Инструменты» и кликнуть по ней.

- После этого раскроется список подразделов, среди которых будет и «Переобход страниц». Кликните по нему.

- В верхней части открывшейся страницы появится большое пустое поле. Введите в него список URL-адресов, которые быстроробот должен обойти в первую очередь. Допустимо указывать вместо полного относительный путь без домена, например /pereobhod.html.

- Нажмите кнопку «Отправить».

Вот и все! Как только краулер обойдет страницы, в табличке ниже поменяется статус задачи.

Когда Яндекс только запустил этот инструмент, в сутки можно было отправить на индексацию всего 20 веб-адресов. Сейчас лимиты рассчитываются индивидуально и коррелируют с качеством сайта.

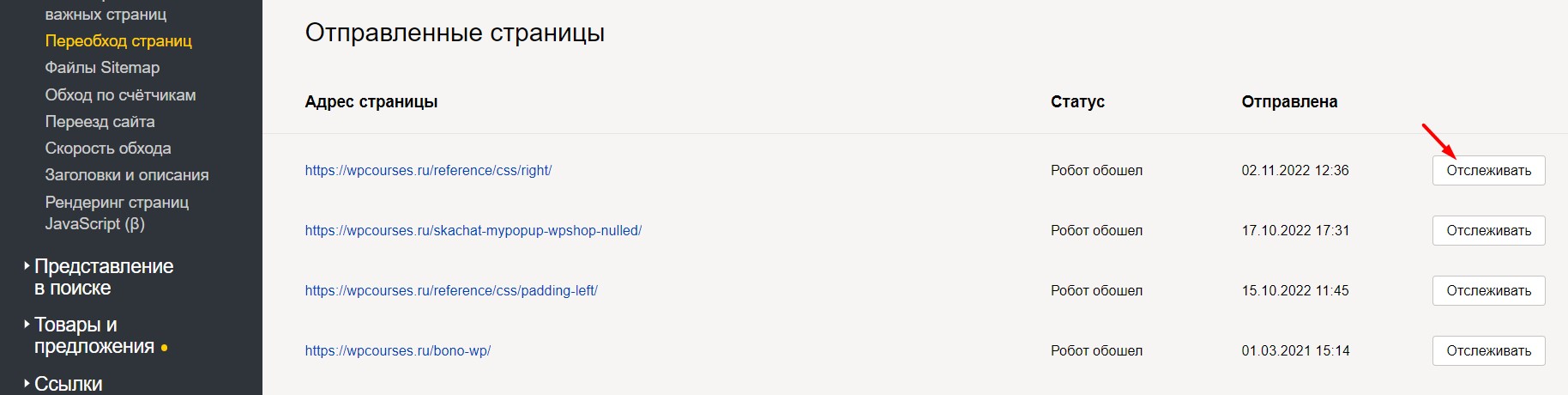

Отслеживание статусов

Как понять, что переобход сработал? На странице инструмента под полем для ввода адресов размещена таблица, где для каждого урла отображается статус и дата отправки.

Есть три типа статусов:

- «В очереди» — заявка на переобход нужной страницы принята и будет обработана в течение нескольких дней.

- «Робот обошёл» — то же самое, что «Успешно». Это значит, что робот посетил страницу и успешно забрал данные в базу. Теперь осталось дождаться ближайшего апдейта, чтобы обновления появились в поиске.

- «Ошибка» — краулер не смог получить доступ к странице, а значит, не переиндексировал ее.

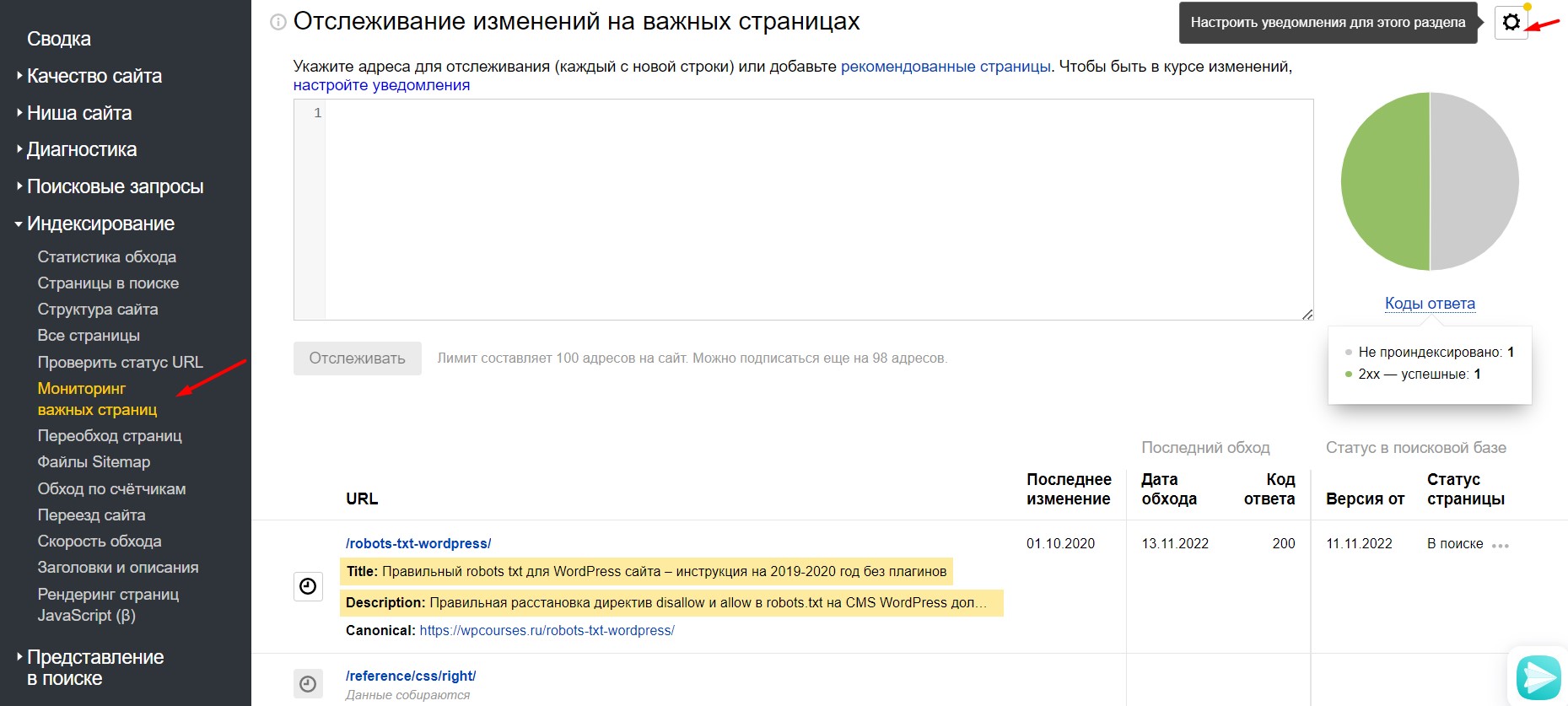

Мониторинг страниц

После запуска переобхода важно своевременно отслеживать все статусы.

Чтобы не пришлось каждый раз заходить в этот раздел и проверять руками, выполните следующие действия:

- Настройте отслеживание самых ценных URL, нажав напротив них кнопку «Отслеживать».

- После этого кнопка сменится ссылкой «Уже отслеживается». Нажав на нее, вы перейдете в раздел Я.Вебмастера «Мониторинг важных страниц».

- Здесь будет предоставлена более подробная информация по отслеживаемым страницам, включая title, description, canonical, дату последнего обхода, код ответа сервера, а также текущий статус страницы в поисковой базе.

- Настройте уведомления (например, на ваш e-mail или в специальный раздел), кликнув по значку шестеренки в правом верхнем углу, чтобы всегда быть в курсе.

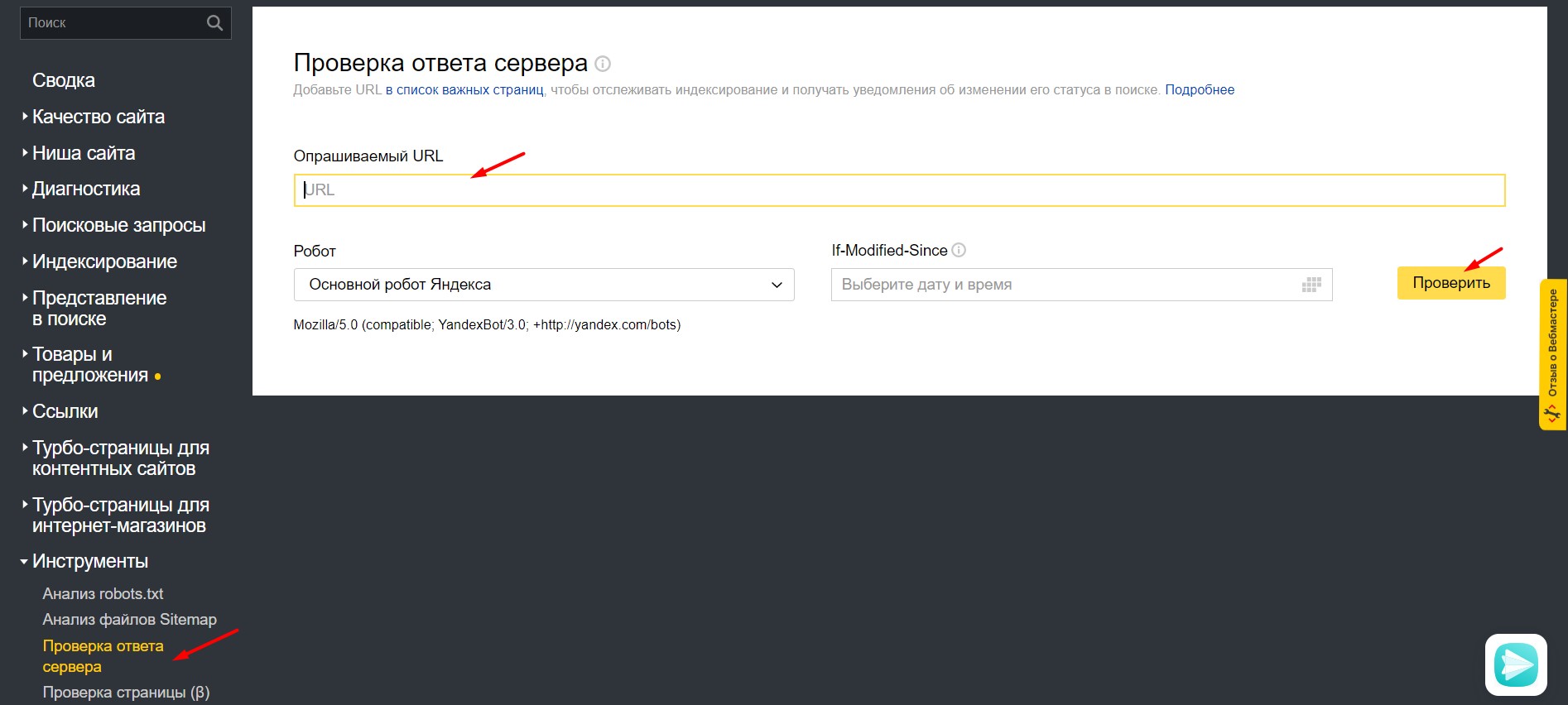

Что делать, если произошла ошибка?

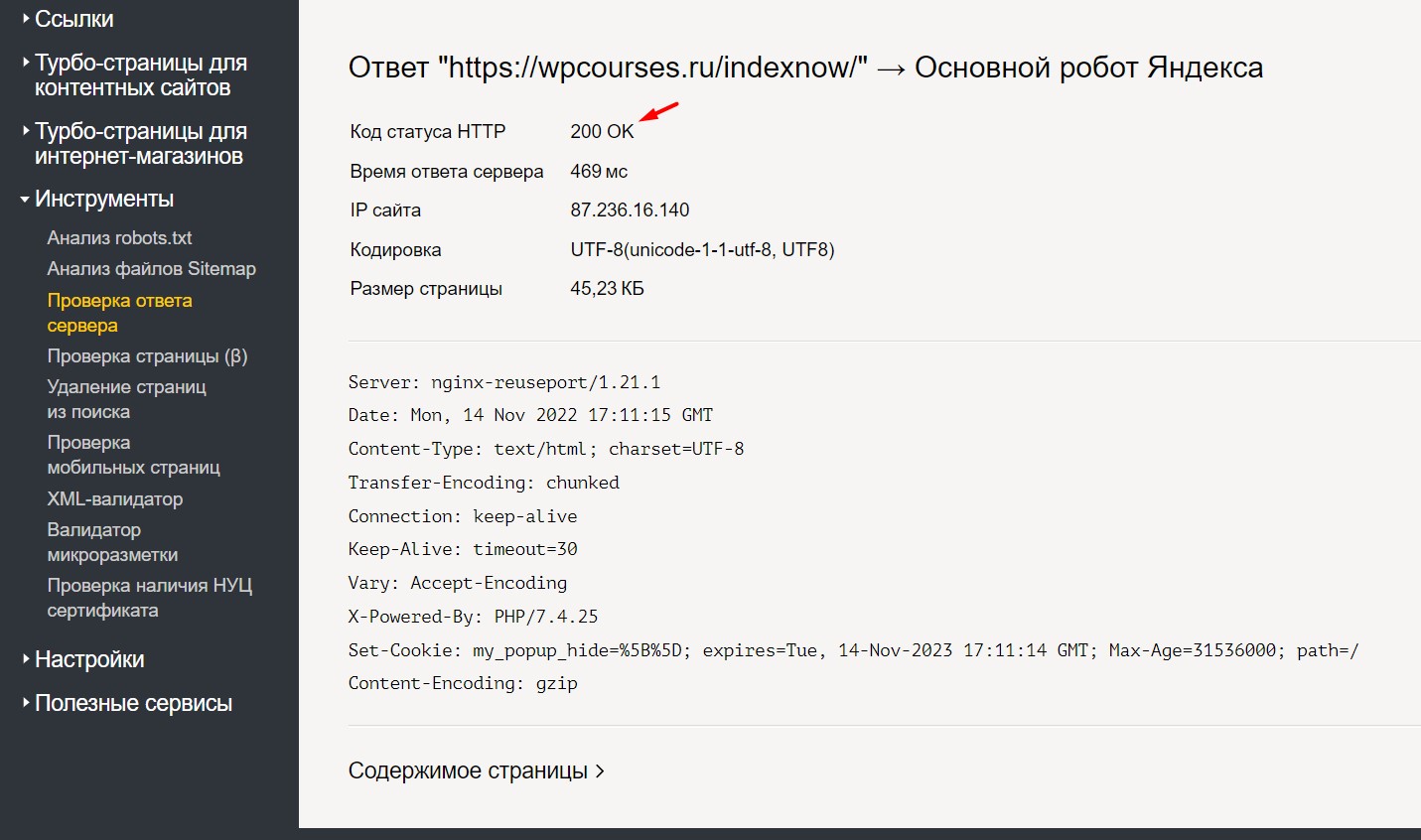

В таком случае вам нужно проверить, доступна ли она. Проще всего это сделать в том же Вебмастере, в разделе «Инструменты» – «Проверка ответа сервера».

Добавьте проблемный адрес в поле «Опрашиваемый URL», из выпадающего списка выберите «Основной робот Яндекса» (если проверяете обычную страницу, а не мультимедийные данные) и нажмите «Проверить».

Корректный ответ сервера — 200 OK. Если у вас такой же, отправьте страницу на переобход повторно. Такое случается, пусть и нечасто. В любом ином случае действуйте исходя из ошибки, на которую укажет инструмент.

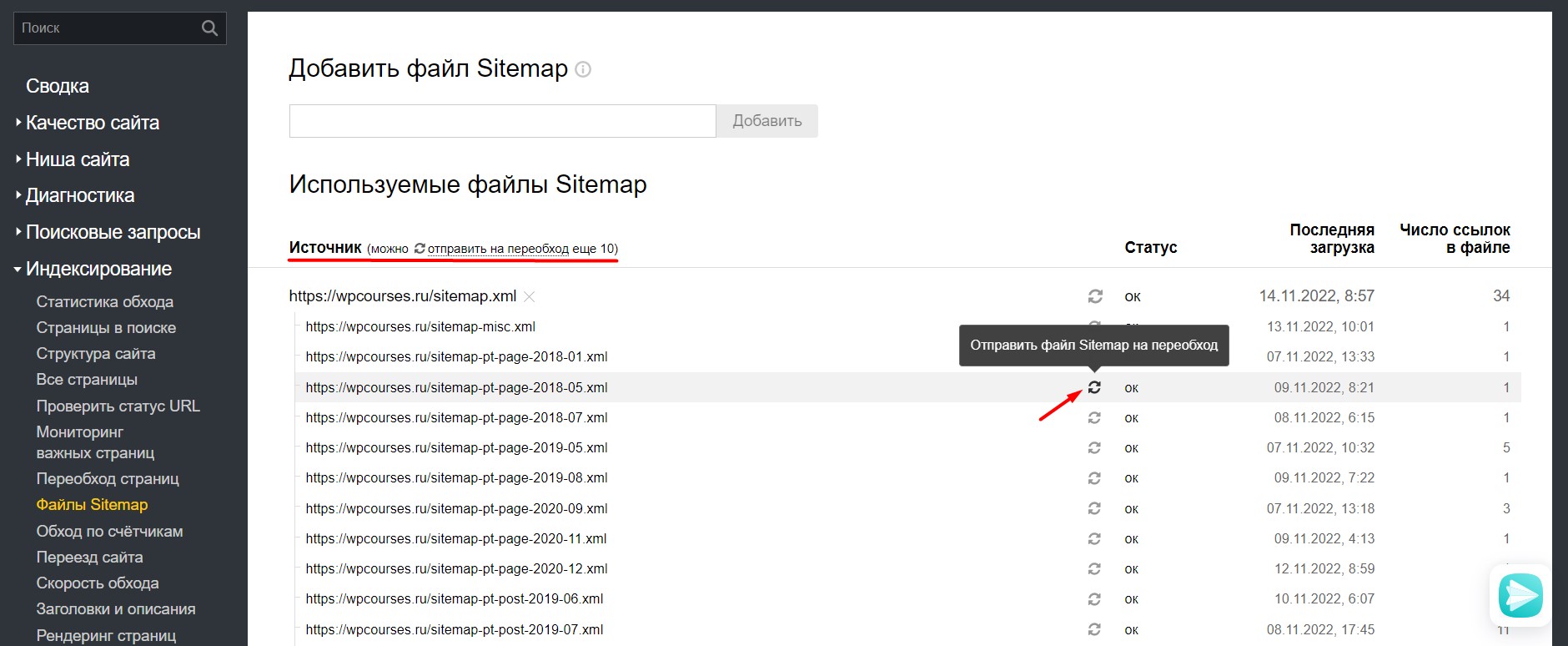

Полный переобход по Sitemap

Для больших сайтов неудобно вручную добавлять страницы на переобход. Гораздо проще массово запросить индексацию роботом всех страниц. Это тоже можно сделать прямо в Я.Вебмастере при условии, что у вас правильно настроена xml-карта.

- Найдите в разделе «Индексирование» пункт «Файлы Sitemap» и перейдите на эту страницу.

- У вас отобразятся все загруженные ранее файлы, относящиеся к карте сайта в виде небольшой таблички.

- Напротив нужного файлика между столбцами «Источник» и «Статус» нажмите на значок круговой ссылки. Это действие запустит полный обход по содержащимся в sitemap урлам.

Действующие ограничения:

- запуск массового обхода по карте возможен только единожды в месяц;

- единовременно можно отправить только 10 файлов-источников.

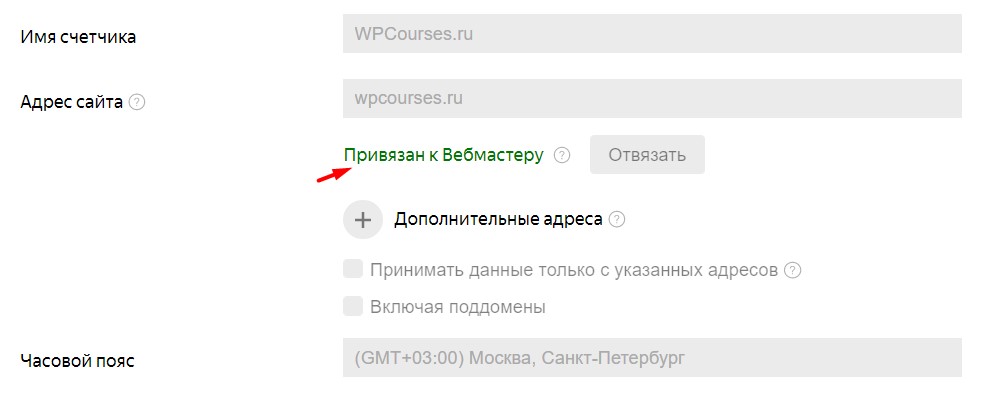

Обход по счетчикам Метрики

Еще один и далеко не последний по удобству способ сообщить Яндексу об обновлениях на своем веб-проекте — подключить обход по счетчику Метрики.

Пошаговый алгоритм действий:

- Добавьте код счетчика Метрики на свой интернет-проект (если еще этого не сделали).

- Нажмите напротив настраиваемого сайта справа на иконку с шестеренкой.

- Вы попадете на страницу, где осталось лишь нажать кнопку «Привязать», отправив запрос на привязку, и скопировать номер счетчика. Если и Панель Вебмастера, и Метрика для этого ресурса расположены на одном аккаунте, все произойдет автоматически.

- Следом перейдите в Я.Вебмастер в «Настройки» – «Привязка к Яндекс Метрике».

- Кликните мышкой «Подтвердить» в строке с ID вашего счетчика.

- В разделе «Индексирование» включите соответствующий тумблер в столбце «Обход». Этим действием вы запустите обход по счетчикам.

IndexNow как альтернативный способ

Не так давно Яндекс ввел поддержку протокола IndexNow, который позволяет практически мгновенно уведомлять ПС о последних изменениях, удалении или добавлении свежего контента.

И самый простой способ подключения для WP реализован в отдельной вкладке плагина Clearfy Pro.

Советы по ускорению индексации

Если на сайте замечены проблемы с индексацией: она отсутствует либо происходит слишком медленно, расскажу, что можно предпринять.

Проверьте запреты

Если стоит запрет на индексирование, боты не будут заходить на него в принципе. Решение проблемы зависит от того, каким способом была установлена блокировка обхода.

- В файле robots.txt. Проверьте, не закрыты ли важные разделы или сайт целиком с помощью директивы «Disallow».

- В настройках движка. Например, в админке WordPress в «Настройки» – «Чтение» достаточно поставить всего одну галочку «Попросить поисковые системы не индексировать сайт», чтобы роботы перестали заходить.

- В HTTP-заголовке X-Robot-Tag. Посмотрите, какие страницы закрыты с помощью этого заголовка и директив в нем «noindex, nofollow» в файле конфигурации .htaccess на вашем сервере.

Был случай, когда запрета на индексацию не стояло, но страницы начали массово выпадать из индекса. По совету техподдержки хостинга в файле .htaccess заблокировали отдельные IP-адреса. Оказалось, некоторые из них принадлежали краулерам самого Яндекса.

Устраните ошибки

Обязательно проанализируйте все ошибки, которые появились в Вебмастере. Для этого вам понадобятся два подраздела из группы «Индексирование»:

- «Статистика обхода»;

- «Страницы в поиске».

Здесь адреса можно просмотреть вручную, настроив фильтры по HTTP-коду и статусу. Если страничек слишком много, скачайте таблицы со всеми нужными параметрами данных в формате xls или csv, выгрузите в Excel, проанализируйте, исправьте ошибки, после чего отправьте на переобход.

Проанализируйте структуру

Сложная, плохо организованная структура — серьезная помеха для роботов ПС.

- Большой DFI (Distance from Index), или расстояние от главной. Сильно влияет на поведение роботов. На ресурсах, где много страниц, нужный url находится в 5, а то и в 6–7 кликах от главной, наблюдаются проблемы с индексацией. Чем меньше это значение, тем чаще на страницу заходит краулер как на приоритетную. Поэтому старайтесь уже на этапе создания сайта продумать структуру так, чтобы на любой урл можно было попасть не более чем за 3 клика.

- Сиротские, или зомби-страницы, как окрестил их Михаил Шакин, — те, на которые не ссылается ни один внутренний url: ни раздел, ни меню, ни другие странички, ничего. Их ПС индексируют со скрипом: сложно определить релевантность, да и попасть роботу по этому адресу, чтобы отсканировать, еще нужно суметь. Данная проблема решается внутренней перелинковкой. Если организовать ее правильно, можно бонусом подтянуть в ТОП многие запросы.

Поработайте над внешним ссылочным

Дополнительно улучшить индексацию можно за счет качественных внешних ссылок.

Это отдельная обширная тема, но если вкратце: ищите для размещения трастовые площадки с высоким ИКС (индексом качества) и хорошим трафиком. Важно, чтобы по ссылке переходили пользователи, иначе она не будет работать в полную силу.

Не забывайте про обновления

Долгое время нет обновлений? Это сигнал для ПС, что проект заброшен и им никто не занимается. Чем реже вы публикуете новые материалы, тем реже будет заходить бот, чтобы не тратить краулинговый бюджет напрасно.

Регулярные обновления контента и добавление новых страниц — залог успеха. Яндекс обращает на это особое внимание, дает приоритет в ранжировании и чаще отправляет бота на индексацию.

Как редирект влияет на индексацию?

Как ускорить индексацию страниц, которые отдавали 404 ответ?

Как поисковики относятся к URL c хэш-символами?

Как переобход страниц может повлиять на ранжирование?

Теперь вам известно не только как отправить странички на переобход в Панели Вебмастера, но и все остальные способы форсирования индексации в Яндексе.

Пожалуйста, оцените материал: