Какой алгоритм сайта использовать?

Какие технологии сайта наиболее эффективны?

Как узнать ценности клиентов – посетителей вашего сайта?

Как гибкие навыки помогают для достижения ситуации Win-Win?

Как с помощью Мини Задач и технологии АРИЗ оптимизировать сайт?

Какие бывают способы исследования тенденций?

Как достичь целей сайта?

Дата написание статьи: Октябрь 2017 Алгоритм Сайта.

Дата обновления статьи: Декабрь Январь 2018 2019

Алгоритм сайта:

Исследование тенденций

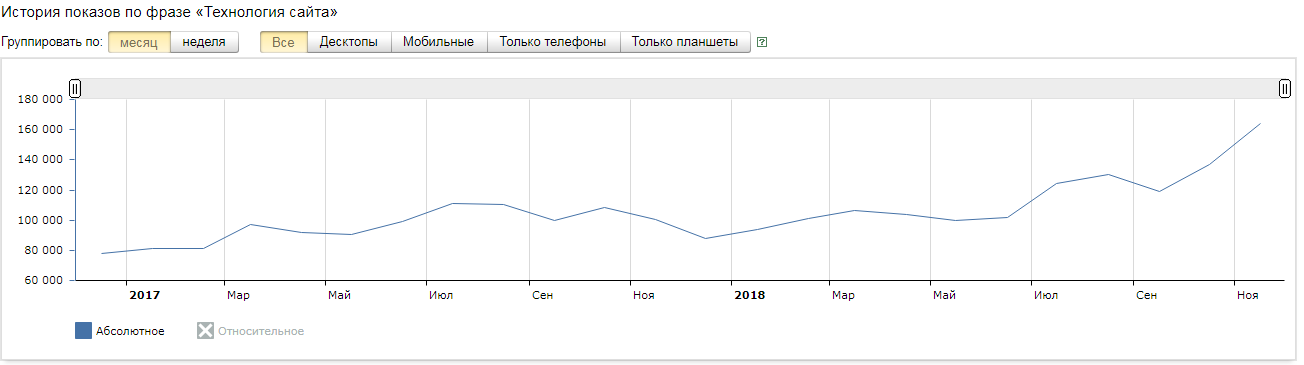

Для начала проведем сравнение таблица тенденций, для того чтобы понять в какой ситуации находится запрос Алгоритм Сайта, на основание этих тенденций и начинается построение Алгоритма сайта, мы изучаем тенденцию в которой придется находиться нашей статье для того чтобы понять стоит ли вступать в борьбу за посетителей на этом фронте (Для повышения конверсии сайта рекомендуем статью “Как продвижение являет на конверсию?” к прочтению). Итак, таблица по целевому запросу “алгоритм сайта” на октябрь 2017 года:

И такая же таблица но уже на декабрь 2018 года:

Что Вы видите? исследования тенденций год назад дали правильную оценку, тематика по “Алгоритму сайта” растёт и это означает что даный запрос может позволить достичь цели сайта в рамках этой темы. Но не будем торопиться с выводами, давайте про анализируем остальные тенденции по запросам чтобы отразить полноценную картину для построения технологии лидерства данной статьи.

Ранее мы исследовали запрос “ценности духа”, однако тематика не напрямую понятна обычному обывателю, но убирать то исследование не будем, мы чтим свои старые работы.

А сейчас давайте посмотрим на другой запрос, наиболее близкий по целям сайта, это запрос “Ценности клиента”:

И давайте рискнем возьмем такой конкурентный запрос как “Технология сайта”, о том для чего мы берем один высокочастотный запрос опишем дальше:

Далее мы действуем применяя платформу РААА и создавая гибкий процесс по созданию статей.

Ошибки при разработке Алгоритма сайта:

Первое, давайте точно определимся с терминами и этимологией:

Создание сайта – алгоритм разработки, алгоритм на английском это – algorithm произошедшей от латинского – algorizmus. Слово «алгоритм» получило распространение в русском языке в конце 20-х гг. XX в.

По всей видимости, данное слово заимствовано из английского языка и восходит к латинскому algorizmus, происходящему от имени турецкого математика Аль-Хорезми.

Абу́ Абдулла́х (или Абу Джафар) Муха́ммад ибн Муса́ аль-Хорезми́(перс. محمد بن موسی خوارزمی; араб.أبو عبد الله محمد بن موسی الخوارزمی; ок. 783, Хива, Хорезм (совр. Узбекистан) — ок. 850, Багдад (совр. Ирак)) — один из крупнейших средневековых учёных IX века хорезмийского[5] происхождения, математик, астроном, географ и историк.

Общепринятое значение слова «алгоритм» – «способ (программа) решения вычислительных и других задач, точно предписывающий, как и в какой последовательности получить результат, однозначно определяемый исходными данными». Сейчас слово наиболее популярно, поскольку является одним из основных понятий математики и кибернетики.

Алгоритм РААА предназначен для развития гибких навыков которые лучше всего формируются в измерительной процедуре поединка. Бой взвешивает физические и духовные силы противников. И уже сам факт измерения сил противников запускает древние механизмы инстинкта доминирования и мобилизации развития организма ради выживания. Именно поэтому алгоритм РААА способствует росту эффективности и результативности.

РААА в приложении к задаче создания сайта предполагает в основе информационный поединок. Особенностью алгоритма РААА концентрация и выход на модель ситуации «выиграл выиграл». Выиграл выиграл это самая сложная модель, когда побеждающий добивается выигрыша для обоих.

Для поединка необходим партнер оппонент, взаимодействуя с которым мы с читателем должны выиграть. Что укажет на то что мы выиграли? Только то что мы выйдем на первую позицию по запросу Алгоритм сайта, а читатель проголосует за это подняв стат вес статьи. (Как продвигать сайт без финансовых вложений? Как продавать через ТЕКСТ? читайте здесь)

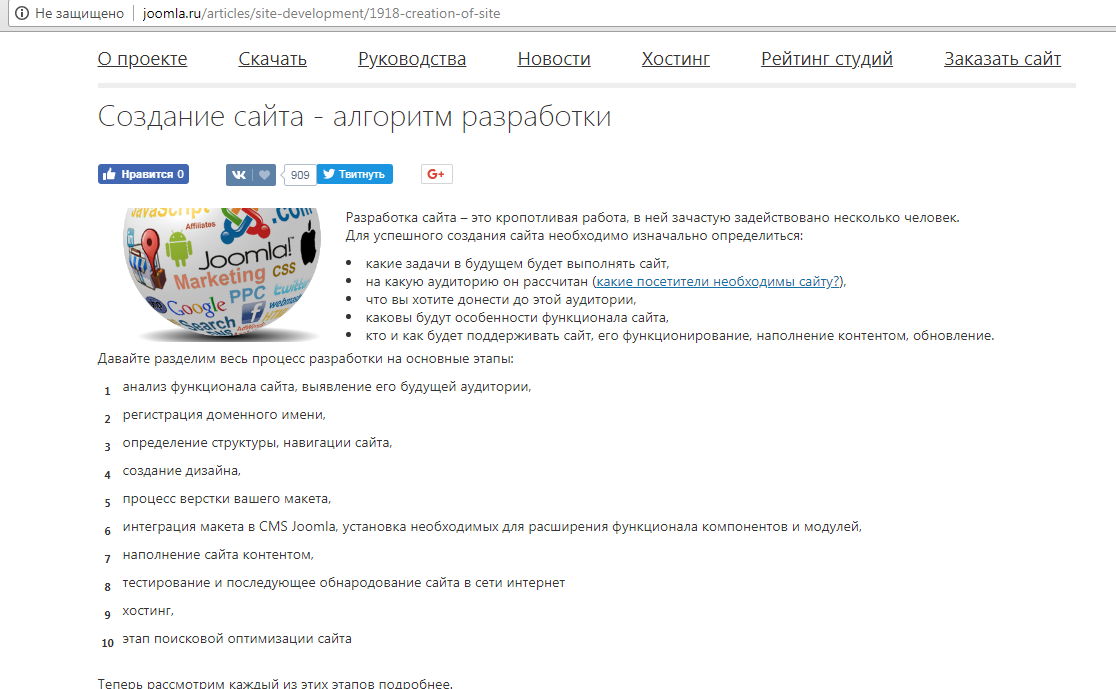

Мы выбираем в качестве противника и берем его статью:

напоминаем, что мы играем на выиграл выиграл, а не на выиграл проиграл. Что это значит? А это значит, что Автор статьи уважаемый человек который заложил основание для поединка, и аудитория вместе с ним сделали большую работу теперь мы должны продолжить его дело и обеспечить дальнейший рост интереса аудитории к запросу «алгоритм сайта». Мы должны помочь автору в раскрытии темы. Как? Мы должны выявить ошибки слабые места и противоречия и сформулировать мини задачи, которые позволят посетителям понять какой же алгоритм сайта позволяет не только вывести его в топ по запросам семантического ядра, но и главное получить максимальный выигрыш, как для владельца сайта, так и для аудитории. Каждое предложение автора, с которым мы ведем поединок мы оставляем написанным черным шрифтом наши комментарии мы выделяем красным цветом.

Начинаем создавать алгоритм сайта по алгоритму РААА!

С чего начинает наш оппонент?

Разработка сайта – это кропотливая работа, в ней зачастую задействовано несколько человек.

Для успешного создания сайта необходимо изначально определиться:

- какие задачи в будущем будет выполнять сайт,

- на какую аудиторию он рассчитан какие посетители необходимы сайту?,

Сайту -площадке никто не нужен. Поэтому не нужно придумывать какой нужен посетитель, а исследуем тенденции в запросах аудитории на сервисах где есть численные данные по интересным для посетителей запросам и по характеру изменения частоты хэтих запросов определяем фазу в которой находится интерес потенциального клиента. (О том, как не допустить спада продаж, читайте статью)

Для чего это нужно

Сайт — это инструмент привлечения посетителей и в конечном счете клиентов. Но посетители сайта — это не всегда его клиенты К примеру клиентами могут быть рекламодатели, а посетители — это клиенты рекламодателя. Что важно понимать при определении аудитории? Аудитория как любой предмет в нашей жизни имеет бесчисленное количество свойств и сторон. На какие следует обратить внимание по алгоритму сайта? Что определяет эти стороны?

Эти стороны определяют цели сайта. Если вы собираетесь делать коммерческий сайт, то вы обречены на конкуренцию за ресурсы время внимание деньги посетителя. Раз так то сайт это плащадка для битвы идей и смыслов в сознании клиента за его ценности и интересы в выборе лучшего смысла.

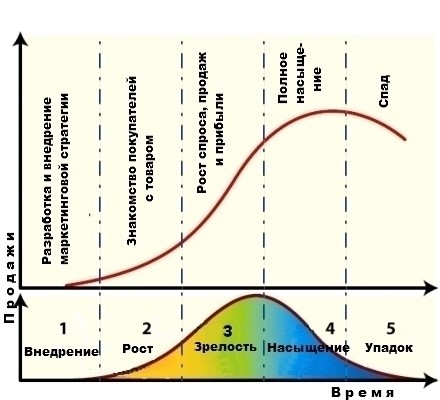

Важно понимать какие проблемы у потребителя разрешает ваш товар или образ товара насколько потребитель понимает свои проблемы в какой фазе жизненного цикла осознания своих проблем он находится. А какие фазы есть и какие важны для реализации алгоритма построения сайта?

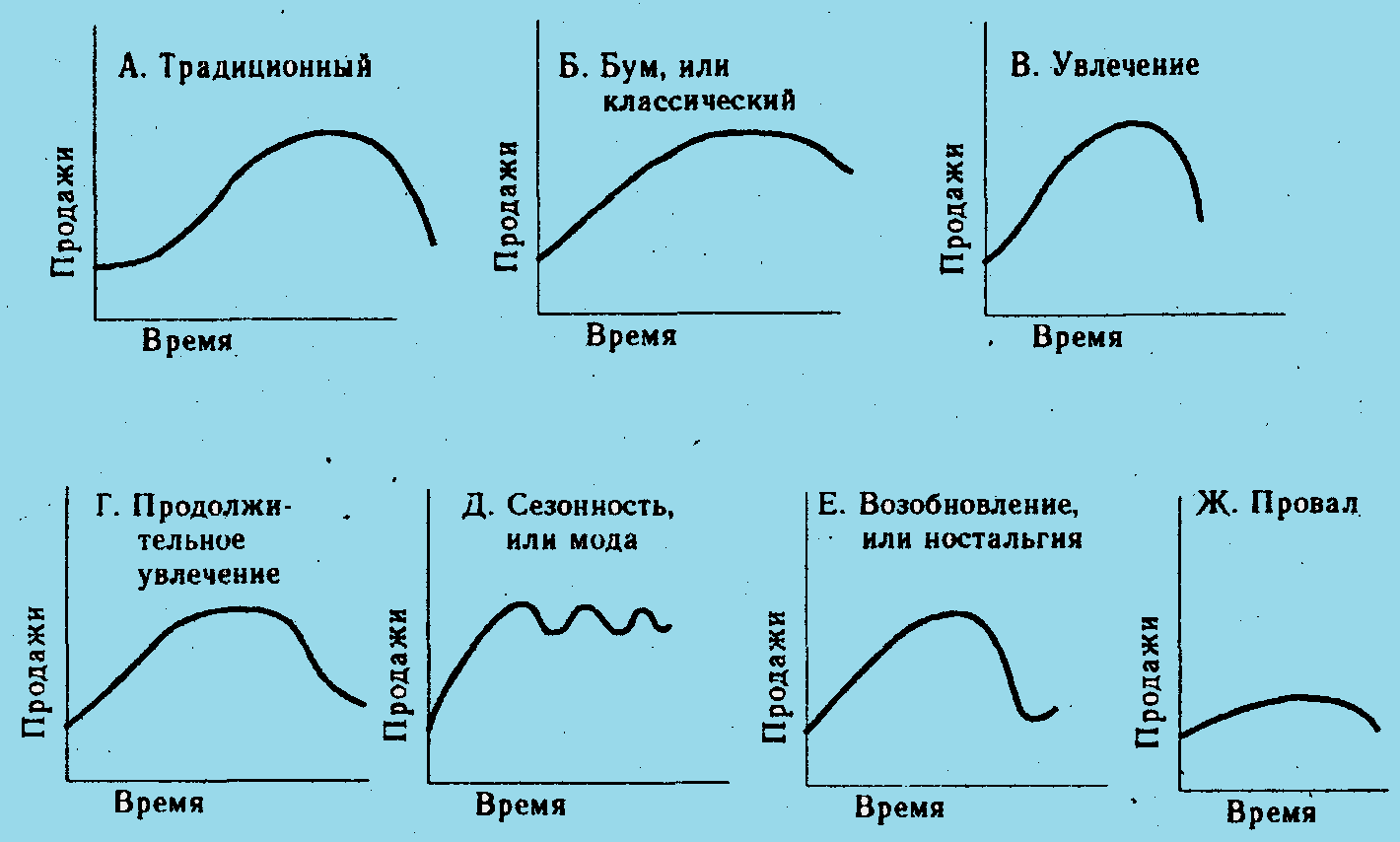

Частный случай одной гармоники жизни товара или гормоники потребности по факту форм кривой значительно больше, и они эти кривые циклично продолжаются так как на смену умершему товару и потребности приходит следующее поколение товаров или потребностей. ТОТ, КТО ПОНИМАЕТ ЭТО ОБРЕЧЕН НА ПОБЕДУ.

Где можно получить информацию о том какая фаза потребностей у вашего клиента? У нас для этого свяжитесь с нами, и мы вам ответим

Как использовать полученную информацию? Важно уточнять данные и управлять моделью спроса и получать желаемую и предсказуемою модель. Характер модели дает прогноз и возможность предсказать, а значит опередить конкурентов и иметь преимущество в осведомленности, а значит и выгодах. Вариантов в конкурентной борьбе действий и кривых может быть бесчисленное множество…

Переходим к следующей рекомендации

- что вы хотите донести до этой аудитории,

В этой рекомендации партнёра по поединку потерян правильный фокус. (Если вам интересно как повысить конверисю сайта БЕСПЛАТНО, рекомендуем эту статью к прочтению)

Важно не то что вы хотите донести и не важно определить хочет ли аудитория узнать это, а что важно? Важно понимать, что впереди и ради чего делается сайт. (Что делать, когда поступила заявка? КАК качественно ее обработать? Насколько эффективно обрабатывает заявки ваш сотрудник? Решение проблемы здесь)

Важна и информация о том где вы и аудитория будет с вами в гармонии. В какой гармонии? Признаком гармонии является соответствие потребности Аудитории получать от вас то что ей интересно то что вы ей даете, а Вам интересно давать то что интересно аудитории. Причем это важно только при том что то что вы хотите предложить существенно лучше, чем у ваших конкурентов. Вот тогда алгоритм создания сайта будет опираться на стратегию конкурентного преимущества! И тогда вы двигаетесь в нужном направлении алгоритма сайта.

Посмотрите, как соотносится продукт и потребность аудитории.

Насколько важна для нее информация которую вы хотите разместить на сайте? Почему это важно? Что бы не тратить время впустую если вы не будете обсуждать с аудиторией, то что для нее важно.

Как понять, что важно для аудитории? Насколько важно и как изменить эту важность? Для этого нужно делать замеры частотностей показов по тем запросам которые на ваш взгляд характеризуют ценности и интересы аудитории

Двигаемся дальше

Каковы будут особенности функционала сайта,

Как это делать? В рекомендации партнера не сказано. Разве это алгоритм? Указана ли здесь содержание и последовательность действий? Функционал сайта — это технология создания контента и управление действиями на сайте с его содержимым. Каким?

В функционале сайта состоят следующие процедуры с его содержимым

вывод товаров в интернет-магазине (Какие существуют причины спада продаж в интернете?);

добавление новых материалов на сайт; (о том, какие тексты являются наиболее эффективными и продающими читайте здесь)

управление через административную панель сайта материалами и элементами сайта;

вывод баннеров и модулей на определенные позиции;

смена слайдов в баннере, это увеличение картинок при клике во всплывающем окне, это создание и отправка по нужному адресу формы обратной связи и так далее.

Функционал сайта может быть ограничен возможностями системы управления сайтом (CMS), а может быть расширен за счет установки на сайт дополнительных компонентов, модулей, плагинов и виджетов. Любой функционал — и штатный, и дополнительный — нуждается в настройке. Так, например, после установки CMS Joomla нужно сразу же настроить встроенные плагины навигации сайта, создать и настроить меню, визуальный редактор для текстов, поставить плагины защиты от взлома сайта, и т.д. Таким образом определение функционала сайта это определение требований к технологии работы с сайтом всех заинтересованных лиц Владельца сайта исполнителей посетителей партнеров машин и т.п. как это сделать? Как угодно, История показывает, что обычно сайты создаются как угодно, но выдающиеся сайты делаются по специально созданному надежному как автомат Калашников алгоритму.

- кто и как будет поддерживать сайт, его функционирование, наполнение контентом, обновление.

Основных Вариантов поддержки сайта три

- Собственными силами

- Аутсорс – передача задачи поддержки профи

- Вовлечение посетителей к созданию содержания типа википедии

Оценим плюсы и минусы каждого из них

Вариант собственными силами

При принятие решений о формировании контента своими силами возникают в следующие проблемы.

1 собственные сотрудники компании не замотивированны на создание контента.

2 у сотрудников отсутствуют навыки написания оригинальных текстов.

3 в компании отсутствует специалист способный осуществлять сео оптимизацию.

4 в компании отсутствует Человек способный осуществлять редакцию созданных текстов.

5 в компании нет компетенции по управлению содержимым сайта.

Положительными моментами при принятии решений написание статей силами сотрудников собственной компании является:

1 в компании есть специалисты, которые разбираются в сути бизнеса.

2 при написании статей сотрудники развивают компетенции, связанные с коммуникациями

3 создание статей сотрудниками компании приводит к повышению их лояльности компании.

С какой скоростью можно создавать контент своими силами? По моим оценкам при использование речевых блокнотов можно добиваться скорости порядка 1000 знаков в минуту. К чему может привести такая скорость. 1000 знаков в минуту в принципе решает проблему продвижение сайта в интернете. Как? При обычный технологий создание текстов с помощью клавиатуры средняя скорость создания текста составляет в оптимуме 200 знаков в минуту. Понятно, что 1000 знаков превышает среднюю скорость работы с клавиатурой в пять раз. Таким образом получается, что использование речевого блокнота для создания текстового контента повышают производительность в 5 раз. Что такое превышение производительности в 5 раз? Это значит, что человек вооруженный речевым блокнотом способен генерировать текст в аудио режиме и способен заменить 5 копирайтеров. Ха-ха-ха.

Какие дополнительные бонусы может получить человек использующий речевой блокнот?

1 первым бонусом является развитие его речи. О чём идёт речь? Речь идёт о том, что человек неподготовленный не сможет с такой скоростью создавать текст. Только лишь специально тренированный человек сможет диктовать текст со скоростью порядка 1000 знаков в минуту. Следовательно, сам блокнот не является достаточным условием для того чтобы работать С такой скоростью. Что же ещё надо? Нужны компетенции. Какие? Компетенции по быстрому построению предложений. Что ещё нужно? Кроме того, что человек создающий контент должен обладать большой скоростью по созданию контента он должен уметь с такой же скоростью проверять создаваемые текста.

Вариант аутсорс – нанятая организация

При использовании нанимаемой компании резко возрастает стоимость контента. стоимость контента- содержание статей. При этом обязанность по приемке статьи от нанимаемых компании не снимается заказчика. А главное компания не использует возможности по развитию коммуникативных компетенций своего персонала.

Создание возможностей для посетителей

Стратегия привлечения посетителей сайта к созданию контента сайта является наиболее продуктивной. Почему? Потому что в этом случае участие посетителей в создании контента обеспечивает диалог между компанией потенциальными клиентами. Это с одной стороны резко удешевляет стоимость контента. С другой стороны, участие посетителей в создании контента это приводит к обмену информацией и в иврите ценностей и интересов аудитории сайта. Не забывайте, что после работы с вашим сайтом клиент отправит вам запрос на покупку/обсуждение деталей заказа/по какоим-то другим вопросам касаемых продаж. Что же тогда делать? ПОдходящий ответ может быть в этой статье.

Автор статьи: Тухватуллин Булат Рашитович – Телефон для консультаций +7 (937) 586-86-66

Как вычислить “корпоративного крота”? Как его распознать? Как с ним вести коммуникации? И самый главный вопрос: что сподвигло сотрудника на предательство?

Часто управленцы обходят эти вопросы стороной, убеждая себя тем, что их это не коснется.

На втором управленческом РУПОР-турнире “Расчеты войны” участникам была предоставлена возможность познакомиться с типичными стратегическими ошибками, приводящих к предательству ключевого персонала. Об этом читайте в статье “Второй управленческий РУПОР-турнир “Расчеты войны”“.

Последние новости:

Второй управленческий РУПОР-турнир “Расчтеты войны”. Отчет

Отчет о первом управленческом РУПОР-турнире “Преддверие войны”.

Читайте также:

Причины падения продаж в интернете

Как продвигать? Как выбрать способ продвижения?

Как повысить конверсию с помощью эффективного текста?

У меня падают продажи, в чем дело?

Отчет о первом управленческом РУПОР-турнире “Преддверие войны”.

Согласование целей как средство удержания персонала. Ч.1.

Согласование целей как средство удержания персонала. Ч.2.

Мы уже рассказывали о том, как работают фильтры «Яндекс» и фильтры Google. Но кроме фильтров, в ранжировании участвуют и алгоритмы поисковых систем. Сегодня рассмотрим основные алгоритмы, которые не дают сайтам подняться в выдаче: как они работают и что нужно сделать, чтобы улучшить позиции.

Как работают алгоритмы Google

В отличие от фильтров, алгоритмы не исключают страницы из выдачи, а снижают их позицию. Например, если сначала страница была на 5 месте, то с выходом нового алгоритма она попадает на 25-30 место и дальше. Поисковая система начала выпускать обновления алгоритмов ранжирования в 2003 году. Тогда вышел «Бостон» — первое официальное изменение ранжирования сайтов. Позже часть алгоритмов была отменена, а некоторые работают и до сих пор.

Принцип работы алгоритмов достаточно прост: сначала система сканирует и индексирует страницы, а затем отображает их в выдаче, учитывая персонализацию и релевантность. Поисковая система выделяет несколько ключевых факторов, от которых зависит результат поиска:

-

анализ слов и выражений, проверка орфографии, подбор синонимов;

-

подбор подходящих страниц с экспертным контентом;

-

ранжирование релевантных страниц — от более качественных к менее качественным;

-

показ наиболее подходящих результатов — формирование топа выдачи;

-

персонализация — анализ геолокации, социальных факторов, предыдущих запросов.

Интересный факт. Система Google хранит данные об интересах пользователей. Она формирует список тем на основании запросов и их контекста. Проверить свой портрет можно в сервисе «Настройка рекламных предпочтений».

Какие алгоритмы использует Google в ранжировании сайтов

Рассмотрим существующие алгоритмы ранжирования — все они влияют на выдачу, делая ее персонализированной и полностью отвечающей запросам пользователей.

Алгоритм Google YMYL (Your money — your life, E-A-T)

-

Год выпуска: 2018.

-

Что отслеживает: размещение экспертных материалов.

Этот алгоритм ориентирован на сайты с информацией, которая может повлиять на физическое или финансовое благополучие. Это следующие тематики:

-

медицина;

-

юридические услуги;

-

финансовые операции;

-

покупки;

-

официальные источники информации;

-

безопасность.

Контент, размещенный на таких сайтах, должен составляться на основании трех главных принципов: авторитетность, экспертность, добросовестность. Алгоритм направлен на устранение из выдачи тех сайтов, которые публикуют некачественную и недостоверную информацию, использование которой несет риски для жизни и благополучия. С его введением из индекса начали выпадать статьи с малополезными SEO-текстами, которые не проходят экспертизу перед публикацией.

За что можно получить ограничения:

-

отсутствие авторства статей;

-

нет экспертности в контенте;

-

неактуальное содержимое;

-

отсутствие документов, подтверждающих экспертность — дипломов, сертификатов, лицензий;

-

недостаточно качественные страницы.

Асессоры — специально обученные люди, которые помогают нейросети определять сайты с экспертным контентом. Стоит заранее позаботиться о том, чтобы заранее предоставить информацию о подтверждении экспертности.

Как привести сайт в соответствие алгоритму YMYL:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Отсутствие авторства |

Проверить все публикации на указание авторов статей, обозначить их экспертность, дать ссылки на их социальные сети |

Сразу формировать карточки экспертов и использовать их при публикации материала |

|

Неактуальное содержимое |

Регулярно обновлять и дополнять статьи, если появилась новая информация по теме публикации |

При создании контента проверять актуальность информации |

|

Отсутствие подтверждающих документов |

Пройти по карточкам экспертов, проверить блоки «О нас» на наличие сертификатов и разрешающих документов |

Добавлять документы и лицензии при создании сайта |

Hummingbird (Колибри)

-

Год выпуска: 2013.

-

Что отслеживает: соответствие ключевых фраз интенту пользователя.

«Колибри» — это часть алгоритма, которая помогает улучшить выдачу информативного контента. Она оценивает естественность вхождения ключевых фраз, находит перекосы по плотности текста, проверяет использование LSI (синонимов, подсветок и подсказок из выдачи). Если контент не соответствует теме, позиции сайта снизятся, а страницы могут получить пометку о малоценности.

Как привести сайт в соответствие алгоритму «Колибри»:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Неестественный текст, который трудно читается |

Проанализировать контент на естественность. При необходимости заменить на контент с естественностью более 80% |

Проверять весь размещаемый контент на естественность. При сборе семантики использовать не только ключи, но и синонимы, подсветки, слова из правой колонки. |

Pigeon (Голубь)

-

Год выпуска: 2014.

-

Что отслеживает: оптимизация местного поиска.

Этот алгоритм помогает региональным сайтам быть выше в выдаче, чем не имеющим географической привязки. Один из первых фильтров, который улучшил показатели ресурсов в выдаче, а не пессимизировал их. Изначально он использовался только в пределах США, затем начал применяться в отношении всех англоязычных ресурсов. Сейчас применяется в отношении всех сайтов, где есть региональность.

Как использовать:

-

заполнить карточку организации в Google Мой Бизнес;

-

сделать региональные контакты на сайте: городской номер, почтовый адрес;

-

использование локального контента — местное портфолио, отзывы;

-

использовать местные ссылки.

HTTPS

-

Год выпуска: 2014.

-

Что отслеживает: наличие SSL-сертификата на сайте.

В анонсе от 6 августа 2014 года представители Google официально объявили, что будут отдавать приоритет в выдаче тем сайтам, которые используют защищенное соединение. Это нужно не только ресурсам, которые собирают и передают личные данные — через формы обратной связи, телефоны и личный кабинет. Сайт, у которого нет SSL-сертификата, может получить отметку о том, что он может быть потенциально опасным, а это снизит количество переходов на ресурс.

Этот алгоритм не только искусственно снижает позиции сайта в выдаче — наличие окна из примера выше негативно влияет на поведенческие факторы. Пользователи просто закрывают вкладку и сразу возвращаются к поиску.

Как привести сайт в соответствие HTTPS:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Отсутствие SSL-сертификата |

Проверить наличие через SSL-чекер |

Подключать сертификат сразу, как только сайт выходит в индексацию |

Mobilegeddon (Mobile-Friendly)

-

Год выпуска: 2015.

-

Что отслеживает: адаптивность мобильной версии сайта.

С распространением мобильных устройств Google начал понижать в выдаче те сайты, у которых нет адаптированной мобильной версии. Здесь владельцы часто пытаются сэкономить на адаптивности, потому что нужно оптимизировать контент, а потому запускают отдельную мобильную версию сайта.

Такой подход не приветствуется ПС: придется делать дубли контента, а еще эти два сайта будут ранжироваться как отдельные. Поэтому сейчас лучше сразу адаптировать контент и проверять его отображение на мобильных устройствах.

Как привести сайт в соответствие алгоритма “Mobilegeddon”:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Отсутствие адаптивной версии |

Оценка отображения мобильной версии — либо через консоль браузера или через GSC |

Сразу давать задание программисту на верстку адаптивной версии сайта |

RankBrain

-

Год выпуска: 2015.

-

Что отслеживает: соответствие контента запросу пользователя.

Этот алгоритм направлен на определение того, что имел в виду пользователь, если по запросу это не очевидно. Он оценивает качество контента на сайте и его соответствие. Под действием алгоритма сайт тоже теряет позиции в выдаче, а страницы могут быть отмечены как малоценные.

Как привести сайт в соответствие алгоритму “RankBrain”:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Недостаточная глубина раскрытия тем на сайте |

Привлекать экспертов для проверки полноты и достоверности информации |

Привлекать экспертов к написанию статей до публикации. В текстах освещать темы наиболее полно и информативно |

BERT

-

Год выпуска: 2019.

-

Что отслеживает: естественный язык в контенте и работа с контекстом сайта.

Это усовершенствованный аналог Rank Brain. Алгоритм затронул порядка 10 % сайтов. Он учится понимать язык так, как его понимают люди.

Представители Google назвали это обновление одним из самых масштабных за 5 лет. С его помощью ПС учится более глубоко понимать контекст запроса и соответствие контента на сайте.

Possum/Hawk

-

Год выпуска: 2016/2017.

-

Что отслеживает: спам в локальной выдаче.

В 2016 году Google начал исключать спам в локальной выдаче: он убирал из выдачи клоны компаний, а также пессимизировал расположенные в одном месте идентичные бизнесы.

Но возникла проблема: из индекса начали вылетать сайты организаций, которые располагаются по одному адресу. Тогда представители ПС анонсировали дополнение — Hawk, оно смягчило действие «Опоссума». В выдачу вернулись сайты организаций, расположенных по одному адресу.

Как использовать:

-

Максимально полно заполнить карточку организации в Google Мой Бизнес: адрес, телефоны, сайт, фотографии.

Строго говоря, это не нарушение, а просто часть алгоритма, которая помогает лучше ранжироваться по заданному региону.

Fred (Maccabees)

-

Год выпуска: 2017.

-

Что отслеживает: обилие рекламы, некачественные ссылки, аффилиат-сайты.

«Фред» — масштабное обновление алгоритма Google, которое затронуло сайты с большим количеством рекламы, аффилиат-сайты, а также ресурсы с обилием некачественных ссылок. В результате наложения снижаются позиции сразу всего сайта.

Как привести сайт в соответствие алгоритму “Fred”:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Много рекламы |

Проверить наличие рекламных блоков |

Уменьшить объемы и агрессивность рекламных объявлений |

|

Аффилированность сайтов |

Провести проверку на аффилированность и попробовать продавать партнерские товары у себя, без перенаправления на другие сайты |

Заключить договор с партнерами и продавать их товары у себя |

|

Много некачественных ссылок с сайта |

Проверить ссылки через Screaming Frog и удалить ненужные |

Не использовать больше 5 ссылок на странице |

Speed Update (Время загрузки)

-

Год выпуска: 2018.

-

Что отслеживает: скорость загрузки страниц.

Оптимизированные страницы начинают получать более высокие позиции в выдаче, чем страницы с большим объемом контента на странице. Долгая скорость загрузки сказывается на поведенческих факторах, и сайт начинает проседать по качеству.

Как привести сайт в соответствие алгоритму “Speed Update”:

|

Нарушение |

Проверка и устранение |

Профилактика |

|

Долгая загрузка страниц |

С помощью инструмента Google Page Speed Insights проверить скорость загрузки и устранить основные причины: удалить неиспользуемые фрагменты кода, подключить использование кеша, оптимизировать изображения, etc. |

Проверять скорость загрузки сразу |

Sandbox и DomainAge

Ограничение индексации для молодых доменов. Официально этот алгоритм не подтвержден представителями Google, но все же многие SEO-специалисты отмечали, что в первые полгода домен получает меньше трафика, чем дальше.

Бороться с «Песочницей» не стоит — лучше потратить это время на совершенствование контента, чтобы в дальнейшем получить более высокие позиции в выдаче.

Что проверить, чтобы не попасть под алгоритмы Google

-

Экспертность контента: наличие авторства, ссылок на соцсети авторов.

-

Актуальность текущей семантики.

-

Наличие слов из правой колонки и синонимов в семантике.

-

Региональность сайта — если продвигаетесь не в рамках всей страны.

-

Наличие SSL-сертификата.

-

Адаптивность мобильной версии.

-

Полное заполнение карточки организации в Google Мой бизнес.

-

Наличие и объем рекламных блоков на сайте.

-

Аффилированность сайта.

-

Качество ссылок на внешние ресурсы.

-

Скорость загрузки страницы.

-

Возраст домена.

Чтобы продвигать сайт в Google и Яндекс, нужно ориентироваться, как работают алгоритмы поисковых систем. Мы расскажем, какие факторы учитываются при ранжировании веб-площадок в SERP, а также, что ожидать оптимизаторам в 2021 году и как строить стратегию продвижения.

Принцип работы поисковых систем Google и Яндекс

1. Поисковая система Google

Поисковик получает данные из станиц сайтов, мультимедиа, отсканированных и загруженных файлов, размещенного контента, который добавлен на сервисы Мой Бизнес и Карты, а также других источников.

Процесс выдачи информации можно условно поделить на три этапа:

- Сканирование содержимого страниц и файлов. Вначале поисковые роботы (Googlebot) собирают данные для анализа — ищут новые посадочные веб-страницы, чтобы добавить в базу. Одни боты сканируют текст на странице, другие индексируют изображения, третьи — контент под мобильную выдачу. Краулеры могут определять дубли, канонические URL и копии страниц.

- Индексирование. Боты обрабатывают контент, который содержится на странице — текст, изображения, видео, теги, включая и атрибуты для фото и картинок. Если содержимое может негативно повлиять на результаты ранжирования, то страницу закрывают в файле роботс.тхт , либо используют тег «nofollow».

- Выдача результатов в ответ на поисковые запросы пользователей. Алгоритмы, которые постоянно апгрейдятся поисковиками, помогают аудитории получать релевантные ответы на вопросы. Помимо соответствующего содержимого на сайте, на место сайта в SERP влияют и другие факторы:

- поведенческие;

- скорость загрузки;

- оптимизация под мобильную выдачу;

- полезность материалов;

- UX;

- авторитет домена.

Оптимально, если на сайте есть Sitemap — карта ресурса. Так бот быстрее сможет просканировать содержимое.

Алгоритмы Гугла отвечают за:

- Анализ отдельных слов и фраз, которые пользователи вводят в поисковик. Роботы определяют значение и после апгрейдов даже контекст. Учитывается и типы запросов. То есть, что конкретно ищет пользователь — новости, видеоролики, текстовые обзоры. Важна и дата публикации. В первую очередь поисковик выдает свежий контент.

- Подбор релевантных посадочных страниц. Когда бот «понимает» намерения пользователя, алгоритмы поисковика собирают страницы, которые содержат нужную аудитории информацию.

- Ранжирование страниц, которые подходят по запросу. Таких сайтов может быть тысячи. Задача алгоритмов Google — найти наиболее подходящие варианты и расположить линки на страницы в зависимости от оценки сайта.

- Подбор релевантных страниц под запросы пользователей. После отбора результатов, поисковик выводит из в SERP, распределяя по позициям.

- Учет сведений об аудитории. Поисковик собирает данные о предпочтениях и намерениях пользователей. Например, учитывается геолокация человека, предыдущие запросы, переходы по линкам, история просмотров сайтов и т.д.

Например: вводим в Гугл запрос — «Как сделать кукольный домик». Поисковик определяет, что пользователь хотел сделать поделку своими руками и подбирает страницы, где содержится релевантная информация. Но при этом может показываться и реклама компаний, где можно заказать товар.

Кроме того, когда человек начинает вводить запрос, поисковик автоматически определяет подходящие слова и предлагает варианты.

На этом этапе используется алгоритм PageRank — расчет авторитетности. Боты анализируют авторитетные сайты-домены, которые ссылаются на ресурс. Это показатель того, что страницы содержат полезный контент.

2. Поисковая система Яндекс

Принцип работы такой же, как и у Гугла — сканирование, индексация контента и выдача релевантных результатов. Но есть и различия, например, у Яндекса есть Вебмастер. Туда добавляют ресурсы для индексации.

Кроме того, поисковик умеет распознавать пользовательские запросы, учитывая морфологию русского языка. И помогает сузить поиск сайтов до конкретного региона — опция полезна для локального бизнеса, например, салона красоты или СТО.

Яндекс распознает изображения, PDF-формат файлов, RSS площадки, и другие форматы, например, xls, .ppt. и т.д.

Начиная с 2007 года, было создано и запущено 24 алгоритма ранжирования Яндекса. До 2016 не учитывался контекст материалов, а в основном боты выдавали информацию, соответствующую поисковым запросам. Яндекс учитывал также поведенческие факторы и объемы контента, которые генерируют сайты компаний. Так было до анонса алгоритма «Палех», который способен распознавать смысловое содержание контента. Через год был запущен «Королев», который стал улучшенной версией предыдущего варианта. И в 2017 году был анонсирован «Баден-Баден». Боты стали различать переоптимизированные статьи, что полностью изменило подход к созданию текстового контента.

В 2020 году вышел новый алгоритм YATI. Поисковик стал использовать нейросети для улучшения ранжирования и определения смысла поисковых фраз. То есть, это финальный вариант «Палеха».

Помимо алгоритмов ранжирования сайтов в SERP, Яндекс создал 25 фильтров, которые отвечали за «отлов» спама и накрутки. Поисковик распознает нечестные действия со стороны оптимизаторов, которые используют сторонний софт, чтобы улучшить показатели поведенческих факторов, и для кликджекинга (размещение невидимых элементов на странице, по которым пользователи кликают, не подозревая об этом). Фильтры поставлены и на рекламные баннеры, которые слишком часто показывают пользователю и раздражают аудиторию.

Материал по теме: СТРУКТУРА САЙТА — КАК СОЗДАТЬ ИДЕАЛЬНУЮ ИНФОРМАЦИОННУЮ АРХИТЕКТУРУ САЙТА: ИНСТРУКЦИЯ, ПРИМЕРЫ

Поисковые алгоритмы 2021: как работает поиск

Факторов ранжирования в поисковиках тысячи, но сосредоточимся на приоритетных в 2021 году.

1.Работа над уменьшением скорости загрузки до 2.5 секунд

В мае вышел новый алгоритм Гугла — Page Experience. Цель апдейта — вывести в ТОП сайты с хорошими показателями пользовательского опыта. В первую очередь обновление касается скорости загрузки страниц площадки. Разработчики считают, что если пользователь ждет дольше 2-3 секунд, то интерес к контенту падает, и он закрывает вкладку с сайтом.

В рамках нового алгоритма был введен набор технических показателей, с помощью которого оценивается UХ сайта — Core Web Vitals. В расчет берется скорость загрузки, визуальная стабильность элементов сайтов (блоков, баннеров и т.д) и интерактивность.

Алгоритм Google Core Web Vitals — главный фактор ранжирования сайтов в 2021

Рассмотрим подробнее составляющие Core Web Vitals:

- LCP — время до загрузки основных элементов контента (превью видеоролика, изображения, текстовые блоки). Показатель должен быть в пределах 2.5 секунд с момента открытия страницы.

- FID — скорость ответа сайта на целевое действие пользователя. То есть, как быстро произойдет отклик при нажатии на кнопку, клике по рекламному баннеру и т.д. Это должно быть в пределах 100 мс, иначе сайт будет хуже ранжироваться.

- CLS — коэффициент смещения визуальных блоков при загрузке. В идеале элементы должны быть стабильными, пока пользователь просматривает страницу. Резкое смещение кнопки или блока после полной загрузки страницы ухудшает пользовательский опыт. Человек может предпочесть конкурентов. Показатель необходимо свести к 0 или 0.1.

Чтобы проверить, насколько страница соответствует требованиям Гугла, установите расширение Google Chrome Lighthouse, либо используйте инструмент PageSpeed Insights.

2.Mobile-Friendly

В связи с ростом мобильного трафика адаптивность под смартфоны, планшеты и т.д. — не новый тренд. Но с 2021 года Google будет уделять этому фактору первостепенное значение. Вероятно, будут пропадать из индекса сайты, у которых только десктопная версия.

Поэтому проверьте, как отображается сайт на мобильных устройствах и ПК. Внесите правки, если элементы некорректно работают. Иначе рискуете ухудшить ранжирование ресурса.

Дедлайн полного перехода на Mobile-Friendly состоялся в марте 2021 года. И если вы заметили «просадку» по позициям в SERP, то проверьте, насколько сайт адаптивен.

3.Безопасность и отказ от назойливых рекламных объявлений

Безопасность данных пользователей должно стать прерогативой для владельцев сайтов. В особенности это касается интернет-магазинов и ресурсов, где нужно оставлять личную информацию, например, при записи к врачу онлайн.

Наличие вредоносных ПО станет серьезной проблемой для ресурсов. Поисковик может снизить позиции в выдаче. Кроме того, пользователи, заходя на страницу, могут увидеть сообщение, что площадка небезопасна. Это ухудшает пользовательский опыт и повышает количество отказов.

В 2021 году наличие сертификата HTTPS для сайтов — это must have. Поисковик ужесточает контроль безопасности в сети и борется с мошенниками и случаями утечки личных данных пользователей.

Агрессивная навязчивая реклама способна снизить рейтинг сайта из-за отказа пользователей. Каким бы не был контент, человеку надоедает отвлекаться на всплывающие окна или баннер. Поэтому проанализируйте, как размещенная реклама влияет на пользовательский опыт. Уберите некоторые баннеры, если они навязчивы или в них содержится неприемлемый контент.

Оставьте это профессионалам! Обращайтесь в Exiterra.com Digital Agency по услуге «SEO-продвижение» и находите свой сайт в ТОП-10 поисковой выдачи.

Яндекс

Поисковый алгоритм YATI Яндекса влияет на релевантность выдачи по поисковым запросам пользователей — результаты стали точнее. После нескольких апгрейдов, поисковик стал учитывать контекст фраз.

Новые алгоритмы Яндекс YATI и Google Bert: как они влияют на SEO-оптимизацию сайта

Оптимизаторам, которые продвигают сайты в Яндексе, необходимо улучшать контент. Это можно сделать, если:

- Изучить потребности и запросы целевой аудитории.

- Работать по широкой семантике, включая длиннохвостые запросы.

- Использовать в материалах ссылки на проверенные источники, чтобы повысить ценность материалу.

- Использовать информативные заголовки, создавать четкую структуру в тексте и оформлять при помощи html-тегов.

Дополнения к алгоритмам поисковиков в 2021

1. Обновление оценочных показателей в сниппете

После майского обновления Гугла появился новый символ, который пользователи видят в SERP — серый круг с белой звездой внутри. Таким знаком отмечены сайты, у которых, по оценке поисковика, положительный пользовательский опыт. За этот параметр отвечает алгоритм Page Experience.

Яндекс тоже ввел обновленный сниппет для онлайн-магазинов — рейтинг фирмы в Яндекс Маркете, изображение товара и цена. Это прямой намек, что сайтам необходимо подключиться к сервису, чтобы развивать бизнес.

2. Новые форматы микроразметки

В прошлом году Shema.org добавила разметку, которая используется для контента, связанного с пандемией. Микроразметку можно применять на сайтах, где нужно сообщить актуальную информацию, связанную с коронавирусом и бизнес-процессами. Например, как изменилась работа компании в связи с карантином.

Формат Special Announcements будет в ближайшее время поддерживаться и Гуглом. Также поисковик ужесточил требования к разметке FAQ и обновлению свойств в документах, которые связаны с мероприятиями Event.

3. E-A-T

Google еще раз подчеркнул, как важно создавать экспертный, достоверный контент, и подтверждать факты первоисточниками. В 2021 году поисковик хочет применять эту оценку материалов не только для сайтов, которые предоставляют медицинские услуги или продают медикаменты и БАДы, банков, интернет-магазинов, юридических площадок (YMYL-ресурсов), а и для других ниш.

Контент-маркетинг: ТОП 5 видов контента, которые вам нужно создавать уже сегодня, чтобы быть на коне завтра

Это говорит о необходимости работать с авторами-экспертами, которые смогут написать актуальный и экспертный контент. При этом важно учитывать SEO-требования к содержанию статей. Рекомендуем начать развивать блог на сайте, если это было не сделано раньше. Проверьте публикации, откорректируйте или удалите статьи, которые не соответствуют оценке E-A-T.

Если вам понравилась наша статья, предлагаем вам ознакомится с услугой «SEO-продвижение» или написать в чат менеджеру, если остались вопросы.

Автор: Exiterra.com Digital Agency

SEO-оптимиZация сайта – на 20% дешевле!

Ваш сайт должен быть выше конкурентов. Особенно в кризис. Zакажите в «ЭкZитерра» SEO Za рубли со скидкой 20%. Мы найдём для вас клиентов, невзирая на кризис! ДА Победе!

Лучшие статьи

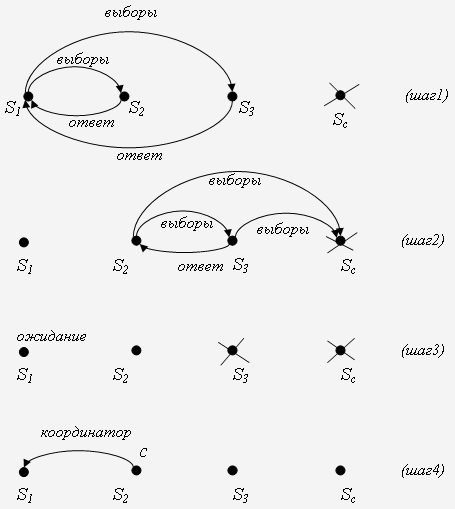

Аннотация: Определение алгоритма выбора. Алгоритм смещения и демонстрация его работы на примере. Выбор с помощью алгоритма для деревьев. Алгоритмы в компьютерных сетях с кольцевой топологией (алгоритм Ле Ланна, Чанга-Робертса)

Во многих распределенных системах один из сайтов играет роль координатора при выполнении распределенного алгоритма. Иногда координатором является сайт, который инициировал выполнение алгоритма. Но не всегда один и тот же сайт на протяжении всего вычисления может оставаться координатором. Можно привести следующие причины смены координатора.

- Выход из строя оборудования на сайте – координаторе, в связи с чем, этот сайт не может продолжать управлять процессами в распределенной системе.

- Метод координации, реализованный на сайте, оказался неэффективным.

- Изменения в интенсивности использования различных сайтов системы, приводящие к тому, что координация из прежнего места становится менее эффективной, чем координация с других сайтов.

В подобных случаях требуется выбор нового координатора. Выбор среди сайтов нужно проводить и тогда, когда должен быть выполнен централизованный алгоритм и не существует заранее известного кандидата на роль инициатора алгоритма. Например, в случае процедуры инициализации системы, которая должна быть выполнена в начале или после сбоя системы. Так как множество активных сайтов может быть неизвестно заранее, то невозможно назначить один сайт раз и навсегда на роль лидера.

Активные (функционирующие в данный момент) сайты должны самоорганизоваться и провести выборы координатора. Для выбора нужна какая-то информация о кандидатах. Для простоты будем считать, что с каждым сайтом связано некоторое число – оценка est (estimate). Выбран должен быть сайт с максимальным (или в отдельных задачах – минимальным) значением оценки.

Максимальное значение нетрудно найти, если все локальные оценки собрать в одном месте. Но сложность заключается в том, что неясно, кто бы мог взять на себя сбор информации, а также зависимость процедуры сбора от архитектуры системы.

Алгоритм смещения

Алгоритм предназначен для динамического выбора координатора на основе локальных оценок сайтов. Предполагается, что каналы связи надежны, а сайты иногда могут прерывать (например, из-за отказов) свое функционирование.

Сайты обмениваются сообщениями с тремя возможными значениями: “выборы”, “ответ”, “координатор“. Сообщение “выборы” посылается для объявления выборов. Сообщение “ответ” посылается в ответ на объявление выборов. Сообщение “координатор” посылается для объявления идентификатора нового координатора.

Алгоритм выборов может начать любой сайт Si, который определил, что текущий координатор SC не функционирует (например, если ему слишком долго приходится ожидать сообщения от координатора).

Алгоритм состоит из следующих шагов.

- Сайт S_i рассылает сообщение “выборы” всем другим сайтам, имеющим большую оценку est(S_j), чем у него. Он ожидает, что они отправят ему сообщения “ответ”.

- Ожидание сайтом Si ответов длится не более чем время T. Если за это время ответы не получены, то сайт Si объявляет себя координатором и уведомляет об этом сайты с меньшей оценкой, чем est(Si) путем отправки им сообщений “координатор“. Если же ответы получены, то сайт Si ожидает еще некоторое ограниченное время прихода сообщения “координатор” (возможно, кто-то из “старших” товарищей возьмет на себя функции координатора). Если он не дождался сообщения “координатор“, сайт Si начинает новые выборы.

- Если сайт Si получает сообщение “координатор“, то он записывает идентификатор сайта, с которого это сообщение было получено, и в дальнейшем общается с этим сайтом как с координатором.

- Если сайт Sj получает сообщение “выборы” и намерен участвовать в выборах, то он возвращает сообщение “ответ”, после чего начинает новые выборы (напомним, его оценка est(Sj) больше, чем оценка est(Si) сайта, проводящего сейчас выборы).

- Если происходит рестарт сайта SC, то он начинает выборы. В том случае, если его оценка est(SC) является наивысшей, он объявляет себя координатором и сообщает об этом другим сайтам. Это происходит, несмотря на то, что какой-то сайт в период неработоспособности SC выиграл выборы и функционирует сейчас как координатор. Происходит смещение “временщика”. Поэтому этот алгоритм выбора можно назвать алгоритмом смещения (английское название – the bully algorithm; слово bully имеет значения: задира, забияка, хвастун, хулиган, первоклассный, великолепный).

Рис.

18.1.

Пример выполнения алгоритма выбора “смещение”

На рис. 18.1 изображены четыре шага выполнения алгоритма. Алгоритм начинается с того, что сайт S1 обнаружил, что сайт SC не выполняет свои функции координатора. Тогда он объявляет выборы, посылая соответствующие сообщения на сайты S2 и S3. Те посылают сайту S1 “ответы” (шаг 1) и начинают собственные выборы (шаг 2). На рисунке предполагается, что оценки est сайтов увеличиваются слева направо.

Сайт S3 посылает “ответ” сайту S2, но сам дождаться ответа от SC не может, так как тот не функционирует. Поэтому S3 решает взять на себя функции координатора. Но ему не везет: он тоже выходит из строя (шаг 3), не успев послать сообщение “координатор“.

Тем временем истекает период ожидания сайтом S1 окончания выборов. Сообщения “ответ” он получил, а сообщение “координатор” – нет. Тогда он начинает новые выборы, по окончании которых координатором ( C ) становится сайт S2.

Во всех приведенных ниже алгоритмах процесс на сайте p имеет переменную state с возможными значениями coordinator (координатор) и lost (проигравший). Иногда мы будем предполагать, что state имеет значение sleep (спящий), когда p еще не выполнил ни одного шага алгоритма, и значение cand (кандидат), если p вступил в вычисление, но еще не знает, победил он или проиграл. Некоторые алгоритмы используют дополнительные состояния, такие как active, passive и др., которые будут указаны в самом алгоритме.

Важность уникальных идентификаторов в задаче выбора состоит в том, что они могут использоваться не только для адресации сообщений, но и для оценки сайтов. При разработке алгоритма выбора можно, например, потребовать, что сайт с наибольшей (или наоборот, с наименьшей) оценкой должен победить. Тогда задача состоит в поиске идентификатора с наибольшей оценкой с помощью децентрализованного алгоритма. В этом случае задачу выбора называют задачей поиска экстремума.

Выбор с помощью алгоритма для деревьев

Если топология распределенной системы – дерево или доступно остовное дерево системы, выбор можно провести с помощью алгоритма, приведенного в

“Волновые алгоритмы распространения информации”

. В этом алгоритме требуется, чтобы все концевые вершины были инициаторами алгоритма. Чтобы преобразовать алгоритм на случай, когда некоторые сайты также являются инициаторами, добавляется фаза wake-up. Сайты, которые хотят начать выборы, рассылают сообщение <wakeup> всем другим сайтам.

Когда сайт получит сообщение <wakeup> через каждый канал, он начинает выполнять алгоритм из

“Волновые алгоритмы распространения информации”

, который расширен таким образом, чтобы вычислять идентификатор сайта с наибольшей оценкой, и чтобы каждый сайт выполнял процедуру return(OK). Когда сайт выполняет эту процедуру, он знает идентификатор координатора; если этот идентификатор совпадает с идентификатором процесса, он становится координатором, а если нет – проигравшим.

В тексте алгоритма логическая переменная sent (“отправлено”) используется, чтобы каждый сайт послал сообщения <wakeup> не более одного раза, а переменная counter (счетчик) используется для подсчета количества сообщений <wakeup>, полученных сайтом.

var is_sent : boolean init false ;

counter: integer init 0 ;

recp[q] : boolean для всех q принадлежащих Out(this) init false ;

m : integer init this ;

state : (sleep, coordinator, lost) init sleep ;

begin if this - инициатор then

begin is_sent := true ;

forall q in Out(this) do send <wakeup> to q

end ;

while counter < card(Out(this)) do

begin receive <wakeup> ; counter := counter + 1 ;

if not is_sent then

begin is_sent := true ;

forall q in Out(this) do send <wakeup> to q

end

end ;

(* Начало алгоритма из лекции 12 *)

while card{q : not recp[q]} > 1 do

begin receive (token, r) from q ; recp[q] := true ;

if est(r) > est(m) then m := r

end;

send (token, m) to q0 with not recp[q0] ;

receive (token, r) from q0 ;

if est(r) > est(m) then m := r; (* return(OK) с ответом m *)

if m = this then state := coordinator else state := lost ;

forall q in Out(this), q not equils q0 do send (token, m) to q

end

Когда хотя бы один сайт инициирует выполнение алгоритма, все сайты посылают сообщения <wakeup> всем своим соседям, и каждый сайт начинает выполнение алгоритма для дерева после получения сообщения <wakeup> от каждого соседа. Все процессы завершают алгоритм для дерева с одним и тем же значением оценки, а именно, с наибольшей оценкой сайта. Единственный сайт с такой оценкой закончит выполнение в состоянии координатор, а все остальные сайты – в состоянии проигравший.

Через каждый канал пересылается по два сообщения <wakeup> и по два сообщения <tok,r>, откуда сложность сообщений равна 4N–4. В течение D единиц времени после того, как первый процесс начал алгоритм, каждый процесс послал сообщения <wakeup>, следовательно, в течение D+1 единиц времени каждый процесс начал волну. Легко заметить, что первое решение принимается не позднее, чем через D единиц времени после начала волны, а последнее решение принимается не позднее D единиц времени после первого, откуда полное время равно 3D+1.

Если порядок сообщений в канале может быть изменен (т.е. канал – не FIFO), процесс может получить сообщение (token, r) от соседа прежде чем он получил сообщение <wakeup> от этого соседа. В этом случае сообщение (token, r) может быть временно сохранено или обработано как сообщения (token, r), прибывающие позднее.

Интернет часто называет сетью, потому что он пронизан гиперссылками и все ресурсы (даже конкуренты) связаны между собой. Приток посещаемости сайтам обеспечивают переходы и конкуренция. Сейчас для того, чтобы найти нужную нам информацию, мы в большинстве случаев обращаемся к поиску.

Что такое поисковые алгоритмы?

Способы отсева сайтов, не отвечающих правилам сайтостроения. Были придуманы, чтобы сделать более здравой и честной конкуренцию и отбор лучших сайтов в поиске.

Ресурсы, у которых более понятный интерфейс, доступные и понятные тексты, разнообразные материалы, станут более успешными. И в итоге поднимутся выше в поиске. Иначе говоря будут лучше ранжироваться.

Как работают поисковые алгоритмы

В основе работы поисковых алгоритмов находится сложная математика и машинное обучение. Выдача любого поисковика просчитываются формулами, которые и составляют чарт популярности сайтов. Ключевые слова и результаты выдачи базируются на статистике посещений и тематических запросов.

Если максимально упростить для конечного пользователя, то «верхние» сайты в списке на странице Гугла получаются на основании ключевиков из тех слов, которые вводят пользователи сайтов. Потом собранная статистика обрабатывается алгоритмами поиска, создается ранжир сайтов.

Релевантность — соответствие результата запросу пользователя.

Как работают со ссылками поисковые алгоритмы Google

Google — пионер в вопросах «ценности» линков. Все произошло во время разработки собственного Индекса Цитирования. ИЦ — первый механизм, аккумулирующий и количество, и качество внешних ссылок. Гугл задал стандартизацию релевантности, тем самым обеспечив бум роста корпорации и веб-технологий одновременно.

Изначально «по версии Гугла» ранжир сайтов начинался от пиара и лишь затем учитывал контент. В дальнейшем были добавлены определенная региональная специфика и свежесть информации. Фактически, оперируя этими четырьмя критериями, и сегодня можно составить неплохой чарт веб-страниц из той или иной отрасли.

В 2000 была придумана форма подсчета пиара HillTop. Это была первая попытка оценить авторитет той или иной страницы. Google выделил некоммерческие проекты и доверенные сайты в особую категорию.

В 2003 впервые представлена система, нанесшая удар по SEO. Алгоритм Флорида попросту пропускал большой, как бы сейчас сказали, «заспам». Брать количеством анкоров уже бы не получилось. Через некоторое время были также введены оценки качества индексируемых страниц и само количество обрабатываемого материала.

2011 — год рождения «панда-копирайтинга». Алгоритм Панда впервые начал проверять качество выпущенных материалов на предмет литературной ценности, связности, легкости чтения материалов на сайтах.

В 2012 году был реализован алгоритм Пингвин, призванный анализировать и наказывать сайты с неестественно большим объёмом ссылок. Один из тех алгоритм, которые преобразили поиск и навсегда изменили и усложнили жизнь SEO-специалистам.

В том же году выпустили Антипиратский апдейт. Из названия ясно, что алгоритм борется с копированием контента.

Колибри — это алгоритм, внедряющий в поиск более гибкий анализ потребностей клиента в поиске. После его появления запросы стали анализироваться не по формальным ключевым словам, а по интентам. Появился в 2013 году.

Как работает Яндекс

Всерьез разработкой поисковых алгоритмов Яндекс занимается с 2007 года, когда компания решила составить конкуренцию Гуглу. Через год выходит поисковый алгоритм Магадан, обрабатывающий транслитерацию и аббревиатуры. Тогда же продолжается кампания по внедрению в выдачу электронных энциклопедий — абсолютная новинка для отечественных поисковиков.

Еще через два года, с релизом под кодовым наименованием «Конаково» Яндекс также начал проводить глубокую региональную ранжировку, а в 2010 практически параллельно с Гуглом была введена оценка качества текстов. Появилась возможность с высокой степенью надежности выявить и оценить авторский текст. С алгоритмом «Обнинск» копирайтинг на русском языке поднялся в качестве, а коммерческие тексты приняли современный вид.

В целом Яндекс считается скорее русскоязычным поисковиком, однако на практике искать им некоторые англоязычные сайты даже удобнее. Мастера СЕО умело играют на неполном соответствии авторского законодательства РФ и США. Потому часть сайтов, которые по американским законам имеют ограниченный или совсем закрытый доступ через Гугл, охотно вкладываются в продвижение по алгоритмам Яндекса. С 2011 года новый алгоритм Рейкьявик усовершенствовал и выдачу на латинице, в первую очередь — англоязычной. С выходом же на турецкий рынок Яндекс стал полноценным межрегиональным поисковым гигантом.

Результатом многих лет анализа и разработки механизмов ранжирования стал полный

Актуальным алгоритмом Яндекса с 2018 является Андромеда. Она сменила предыдущую версию «Королев», её функция — улучшенная интеграция сервисов Яндекса. Благодаря «Андромеде» рекомендации в Яндекс.Картах уже вполне могут составить конкуренцию картам от Гугл. Яндекс.Справочник тоже эволюционировал и пользуется заслуженно растущей популярностью.

Заключительная часть

Всю свою многолетнюю историю поисковые системы боролись с попытками веб-специалистов взломать логику выдачи. Долгое время SEO — специалисты пользовались несовершенством логики поисковиков и поднимали в поиске мало полезные сайты. Спустя чуть больше десятилетия поиск пришёл к тому, что для наиболее органичных результатов поиска нужно изучать паттерны поведения человека. Минимизировать математические способы нормирования количество ссылок, ключевых фраз, слов в заголовке. По сути алгоритмы изжили себя.

Все современные поисковики несомненно эволюционируют. Контент—мейкеры теперь зачастую заняты откровенным спамом, поскольку стиль написания меняется со значительной инерцией. Недобросовестные владельцы сайтов предпочитают просто начинить свои тексты «популярными» словами, тем самым выводя собственный ресурс повыше. Вдобавок, сильно изменили ситуацию возможности автоматизации. Спамные сайты сейчас практически не пишут «вручную», заполнение материалов происходит по шаблону и очень быстро.

В результате авторы уникального контента оказались в заведомо проигрышной позиции. Невозможно обогнать робота по чисто количественным показателям выдачи текста. Поэтому поисковики пошли навстречу обладателям сайтов с уникальным контентом. Методы SEO — продвижения не законсервированы, однако теперь гораздо труднее продвигать сайт исключительно спамом. Эволюция алгоритмов — прямая реакция на новые способы продвижения сайтов. Одним из наиболее эффективных критериев проверки оказался фильтр «Баден-Баден», исключающий избыточное количество повторов и приводящий к максимально естественному тексту. Проверять на «Баден-Баден» можно многими сервисами, один из удобнейших — сайт Ашманова.

Если после прочтения текста вам осталось что-то непонятно, вы можете посмотреть всю приведенную терминологию на странице «Терминология и определения».