У вас может быть очень крутой сайт. Качественный, с интересным контентом, с полезными товарами. Дизайном шикарным и удобным меню. Но если на нем есть битые ссылки (особенно если их много), это автоматически делает его подозрительным в глазах поисковых роботов и создает дурное впечатление о ресурсе со стороны посетителей. Такого допускать нельзя. Ваш прекрасный сайт должен быть прекрасным во всем. И мы этого добьемся.

Что такое битая ссылка?

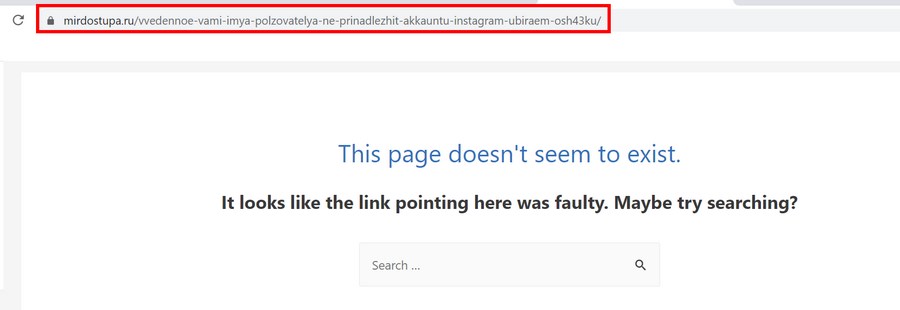

Битая ссылка — это страница на сайте, которую нельзя открыть. Ее не существует. Когда потенциальный посетитель пытается на нее попасть, то получает в ответ ошибку. Это может быть ошибка 404 Not Found или 400 Bad Request. Или без кода вовсе: Timeout, Empty, Reset. Зависит от настроек конкретного ресурса. Оболочка разная, а смысл один и тот же. Сервер говорит, что искомой страницы здесь нет.

Такие ссылки еще изредка называют «мертвыми». Они возникают по нескольким распространенным причинам:

- В адресе страницы допущена ошибка. Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы.

- Структуру сайта недавно кардинально поменяли, не настроив при этом перенаправление со старых ссылок.

- Ссылки на сторонний контент на странице удалили или каким-либо образом «сломали».

- В коде сайта затесались ошибки. В HTML или в JavaScript. Может быть, это сбой в CMS.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Подписаться

Чем опасны битые ссылки?

Есть две неподтвержденные теории и один солидный факт, подтверждающие серьезную угрозу со стороны битых ссылок.

Первая теория такая. Считается, что поисковые роботы Google и Яндекс не любят битые ссылки. Заприметив оные, поисковики решат, что сайт уже давно бросили или сделали так криво, что и стыдно его людям показывать. В связи с этим, позиции ресурса в Google и Яндекс заметно «просядут». Но никто еще не доказал, что это так.

Вторая теория. Якобы битые ссылки расходуют краулинговый бюджет — объем страниц, который поисковики сканируют за определенный период времени. Здесь вмешался представитель Google и сказал, что появление 404 ошибки никак не повлияет на краулинговый бюджет.

А вот что реально важно, так это отношение посетителей к сайту с битыми ссылками. На таких долго не задерживаются. Обычно 404 Not Found говорит о том, что надо бы перейти на главную страницу и воспользоваться поиском. Но всем плевать. Человек просто вернется в Google и будет искать ресурс с рабочими ссылками. Все. Вы потеряли своего посетителя.

Из-за этого вырастет доля отказов. А это не только упущенная аудитория, но и проблемы с ранжированием. Поисковик простит вам битую ссылку, но не простит визитер, который провел на сайте всего секунду и неожиданно убежал.

Читайте также

Как разыскать все битые ссылки на сайте?

Никто не будет сидеть и тыкать во все ссылки на сайте, чтобы найти битые. Тем более, если такие есть на чужих ресурсах. Поиском мертвых страниц занимаются специальные веб-сервисы и приложения. Кому что удобнее.

Я бы советовал не останавливать выбор на чем-то одном. Бывает так, что один сервис отображает неполную информацию. Это как с антивирусами. В тандеме находят больше угроз, чем по одиночке.

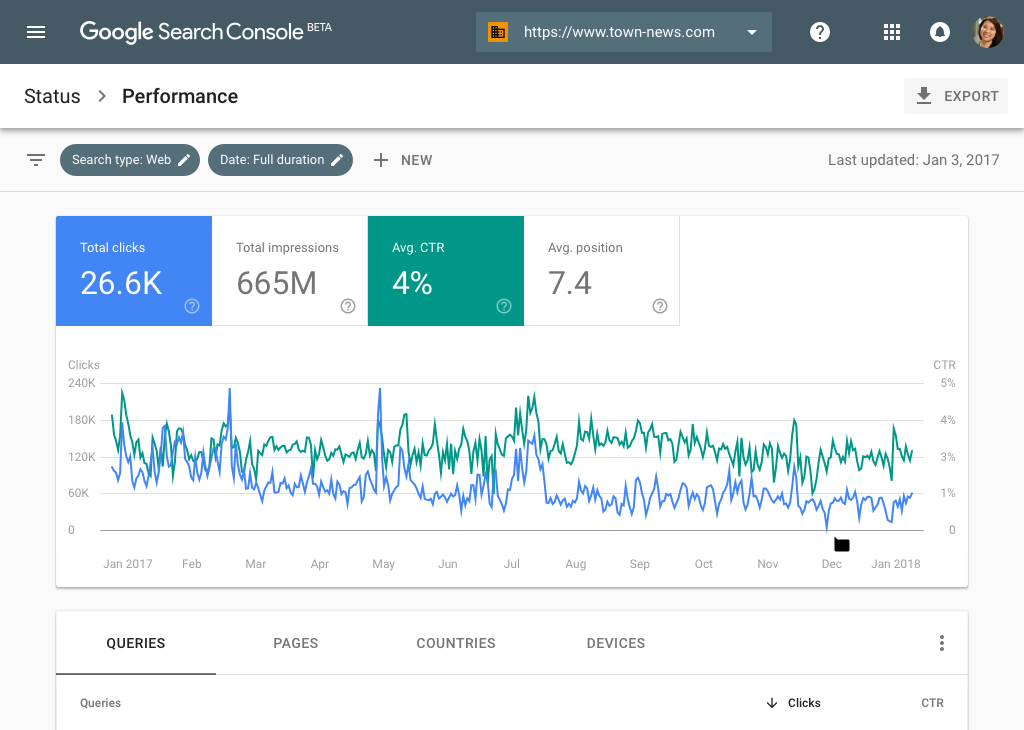

Google Search Console

Официальная панель управления Google отлично справляется с поиском битых ссылок. Так что можно отлавливать 404-е с помощью нее. Надо только подтвердить свои права на домен, а потом открыть пункт меню «Покрытие».

Яндекс.Вебмастер

Аналогичная функция есть в Яндексе. В их Вебмастере есть раздел «Ссылки», где можно взглянуть на все поломанные. Только вот здесь есть сложности с экспортом отчета. Раньше не было удобного способа вытащить все данные об ошибках, чтобы потом их устранить. Сейчас можно скачать TSV-файл с 10 000 битых ссылок. Кому-то даже этого будет мало.

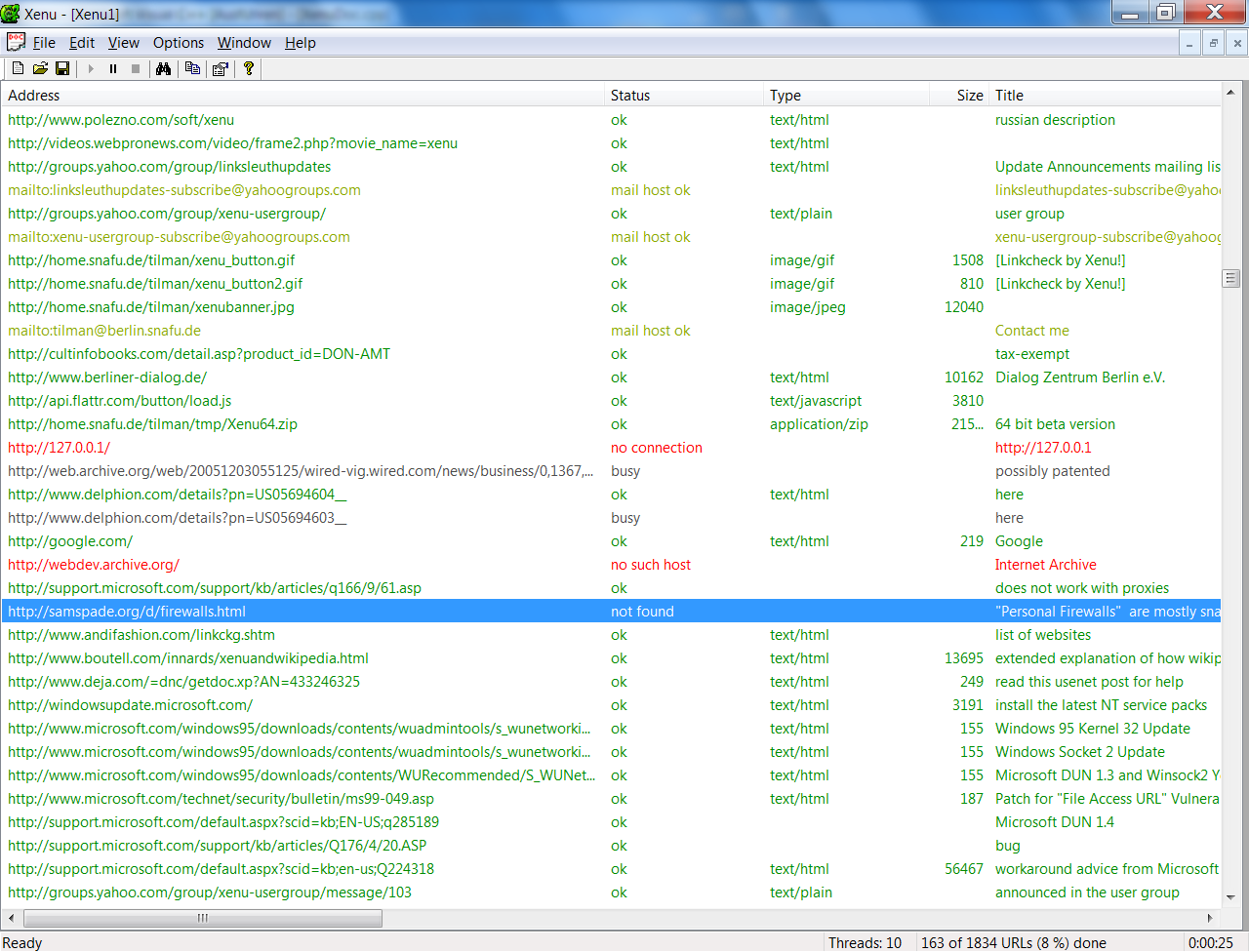

Xenu

Это старая программа, но отчеты из нее многие до сих пор считают эталонными. Xenu предоставляет информацию бесплатно, поэтому можно попробовать самостоятельно и без финансовых потерь.

- Поддерживает страницы с шифрованием.

- Работает быстрее большинства аналогов.

- Может обнаружить перенаправления.

- Позволяет делать повторные проверки.

Broken Link Checker

Это даже не отдельная программа, а плагин для WordPress. Дико популярный и полезный. Из плюсов можно выделить то, что он бесплатный и встраивается в WordPress. А из минусов — то, что он не всегда работает корректно и сложно настраивается. Часто приходится запускать модуль по несколько раз, чтобы был какой-то прок. Но другие дополнения к WordPress подобного рода оказываются еще хуже.

Netpeak Spider

Это дорогой и сложный инструмент для скрупулезного SEO-аудита. Он справляется с поиском сломанных страниц, но создавался для решения более широкого круга задач. Скорее всего, его покупка себя полностью не оправдает. Но функциональность хвалят, да.

Dead Link Checker

Платный онлайн-сервис для поиска ошибок 404 на ресурсе. Работает по подписке. То есть платите 10$ в месяц и получаете возможность отсканировать до 50 000 ссылок. Когда есть бесплатные альтернативы, кажется, что это не самый лучший выбор. Но я его не тестировал. Возможно, он творит какие-то чудеса и находит то, что не способны найти конкуренты.

Есть еще с десяток подобных приложений и сайтов, но они так себе. Либо работают чересчур медленно, либо стоят неадекватно дорого.

Нашел все битые ссылки, что дальше?

То, что нашли, уже хорошо. Только теперь надо их исправить. Будем действовать по следующей схеме действий:

- Разберем все ссылки.

- Категоризируем их.

- И исправим все ошибки.

Анализируем ссылки

Сначала надо организовать данные, полученные из сервисов по поиску битых ссылок. Надо понять, почему те или иные ссылки поломаны. Например, если дело в опечатке, то проще всего исправить эту самую опечатку в коде сайта. Если страницы больше не существует, то надо удалить ссылку и добавить заглушку с соответствующим сообщением. Мол, «410 Gone, ребята, странички не будет». А если вы недавно переехали на другой домен, то самым адекватным решением будет — настроить массовый редирект.

Поэтому для начала можно создать такую простенькую табличку:

| Мертвая ссылка | Количество посещений | Редирект сюда |

| kakaya-to-statya.net | 17 | kakaya-to-statya.blog.net |

| sayt-s-opechatkay.ru | 12 | – |

| sayt-s-opecahtloy-2.ru | 1 | – |

На ней сразу будет видно ссылки, которым нужен редирект, ссылки, для которых стоит заморочиться с исправлением опечаток, и те, о которых можно забыть.

Но это, конечно, исключительно пример. Вы можете организовать полученную информацию, как вздумается.

Исправляем опечатки

Опечатки бывают двух типов. Те, что допустили вы как владелец сайта. И те, что допускают посетители, надумавшие зайти к вам вручную, указав адрес страницы (страшные люди). Какие опечатки стоит исправлять и так понятно. Те, что допустили сами.

Но есть еще один момент. Если по ссылке с опечаткой пытаются пройти регулярно, то имеет смысл настроить перенаправление на правильную страницу. Или сделать вариант с опечаткой рабочей альтернативой для самых настойчивых.

Настраиваем редирект

Теперь займемся ссылками, которые по-вашему мнению нуждаются в перенаправлении.

Тут и пригодится таблица, которую я описал выше. Наглядно показано, что и куда должно переехать.

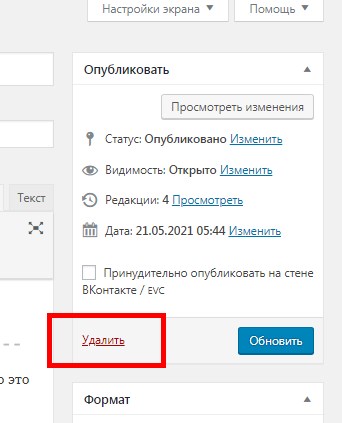

Расскажу, как можно сделать 301 редирект в CMS WordPress и с помощью файла .htaccess

WordPress

- Открываем вкладку «Инструменты»

- Переходим в подпункт «Плагины».

- Кликаем по поисковому полю.

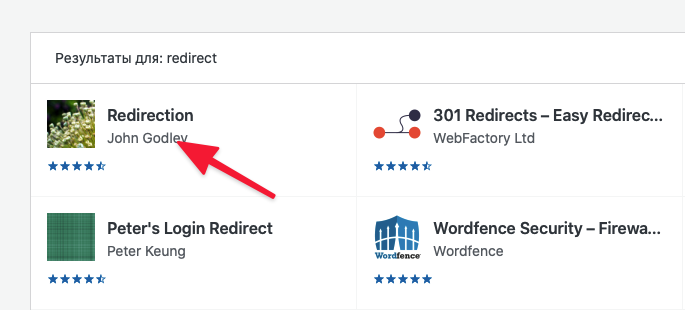

- Ищем плагин Redirection и устанавливаем его.

В поисковике будут и другие плагины, с помощью которых можно настроить редирект. Можете попробовать их. Это уже дело вкуса.

- Потом снова открываем вкладку «Инструменты».

- Переходим к настройкам плагина «Перенаправления».

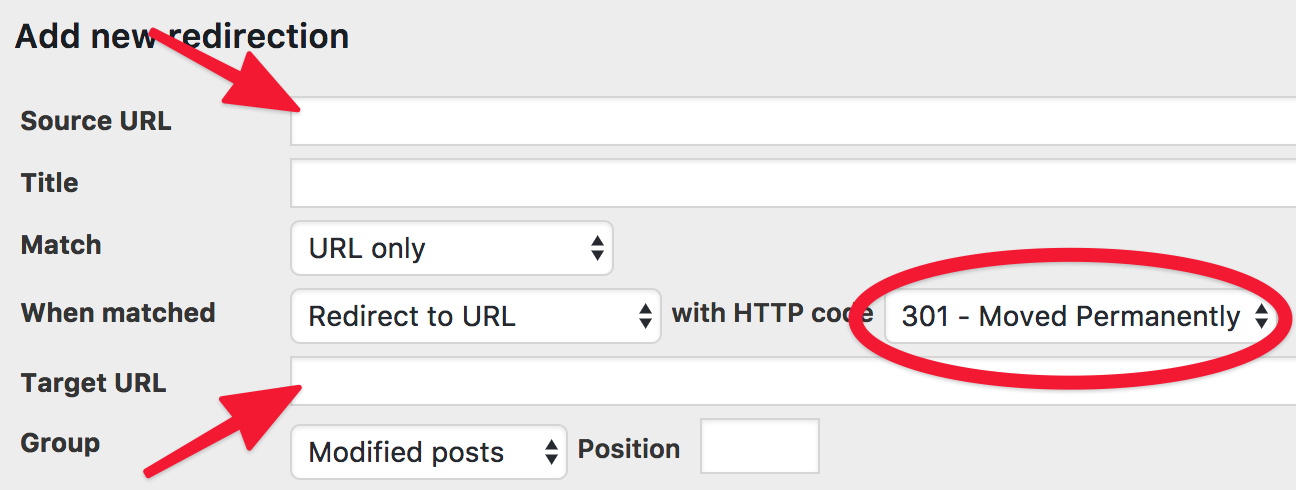

- Нажимаем на Add new redirection.

- Указываем Source URL (ссылку, с которой надо перенаправить).

- А потом Target URL (куда надо перенаправить).

- И сохраняем заданные параметры.

Ну и так придется повторять до тех пор, пока все ссылки, нуждающиеся в перенаправлении, не получат его. Эти задачи нередко достаются верстальщикам на аутсорсе или «разнорабочим» с UpWork и других бирж.

Как сделать массовый редирект

При переезде на новый домен вручную делать редирект всех битых ссылок — это нерациональный адский труд. Поэтому проще воспользоваться массовым редиректом. Делаем следующее:

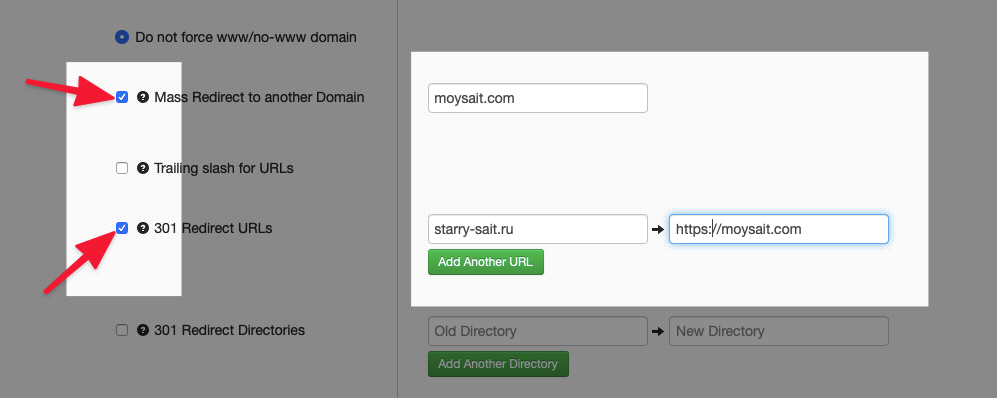

- Открываем сайт для генерации файла .htaccess с настроенным перенаправлением.

- Ставим галочки напротив пунктов Mass Redirect to another Domain и 301 Redirect URLs.

- Напротив первого вписываем название сайта.

- Напротив второго домен, с которого нужно перенаправить пользователей, и домен, на которой надо перенаправить.

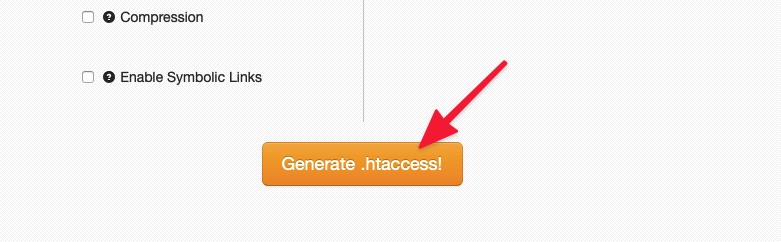

- Нажимаем на кнопку Generate .htaccess в нижней части страницы.

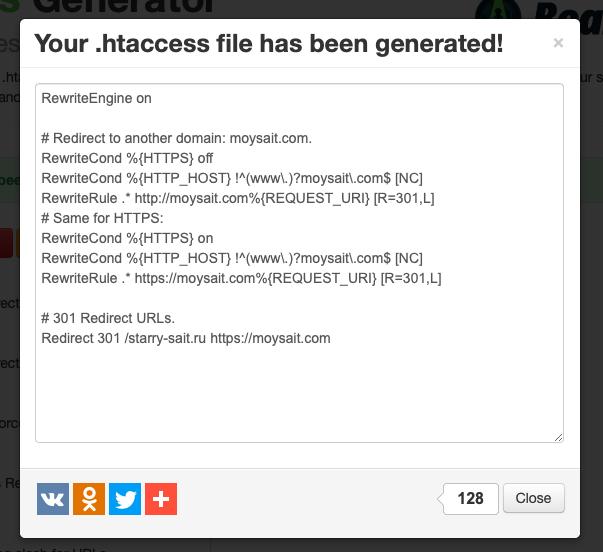

- Потом копируем сгенерированный код и вставляем его в файл .htaccess на сервере.

Впрочем, так можно сгенерировать код для любого типа перенаправлений.

Что делать с битыми ссылками на чужих сайтах?

Теперь вы знаете, что делать со страницами, которые убили сами и к которым у нас есть доступ. Проблематичнее дела обстоят с чужими сайтами, где есть ссылки на ваш ресурс. Они тоже подвержены опечаткам и переезду. Тоже будeт ошибка. Но дело поправимое.

Попросим владельца сайта поменять ссылку

Это, наверное, до боли очевидное решение. Просто постучите владельцам сайта, на котором лежит битая ссылка на ваш ресурс. Попросите их исправить опечатку или указать в материале обновленный адрес. Если удастся с ними связаться, то больше ничего делать и не придется. Все поправят за вас. Но шансы, что вас проигнорируют ощутимо выше.

Настроим редирект с битой ссылки на рабочую

Работает так же, как и в случае со своими ссылками. Просто настройте редирект, чтобы пользователь оказался в нужном месте. Для этого не надо ни с кем связываться и ждать ответа. Настраиваем перенаправление удобным способом и радуемся.

Заново создаем пропавшую страницу

Если уже успели удалить страницу, на которую ведет битая ссылка, то можно создать ее заново. Добавьте туда аналогичный контент. Или тот же, что был раньше. Это может пригодиться, если с чужой страницы приходит большое число посетителей.

Настроим редирект на похожую страницу

Может, контент на уже несуществующей странице устарел? Подумайте, возможно, у вас есть страничка с похожей информацией. Будет хорошей идеей настроить редирект на нее. Тогда и вы ничего не теряете, и посетитель получит то, чего ждет.

И бонусом делаем кастомную страничку 404

Тоже хороший вариант. Сделайте страницу с ошибкой 404 более привлекательной. Оригинальной, что ли. Добавьте картинку, анимацию. Не плоскую шутку. А самое главное, ссылку на главную страницу или на встроенный поисковик. Так вы в десятки раз повысите вероятность, что пользователь останется на вашем сайте, а не ретируется, заметив страшные черные буквы — Not Found.

Можно испробовать все описанные способы в том же порядке. Не ответил владелец чужого сайта? Пилите редирект. Не подходит вариант с редиректом? Так хотя бы сделайте нормальную страничку с ошибкой. Это уже что-то.

Выводы

Итак, еще раз:

- Битые ссылки — поломанные страницы, отзывающиеся ошибками 400 и 404.

- Они портят жизнь посетителям вашего сайта. Так что придется принимать какие-то меры.

- Их несложно найти с помощью бесконечного количества сайтов и программ, заточенных под эту задачу.

- И есть ворох путей исправления ситуации, независимо от того, почему появились проклятые битые ссылки.

Думаю, на этом и закончим. Спасибо.

Битые ссылки – это обычные, казалось бы, URL, но вот только одна проблема – они ведут в никуда.

Такие линки не только невероятно раздражают посетителей, но и негативно влияют на ранжирование домена. Рассказываем, как без помощи программистов быстро обнаружить на сайте и исправить неработающие URL.

Что считать битой ссылкой

Битыми ссылками можно назвать абсолютно любые линки, при открытии которых появляется 404-ая страница. В свою очередь, сами битые URL можно разделить на внутренние и внешние. Вас, как владельца сайта, должны волновать, в первую очередь, внутренние – это сломанные ссылки, которые ведут на разные страницы вашего сайта. Внешние же ссылки также представляют проблему, но решить ее в чем-то даже проще: достаточно заменить проблемную ссылку на рабочую, сославшись на другой домен.

Предлагаю разобраться в наиболее негативных последствиях большого количества битых URL.

Происхождение битых URL: что проверить в первую очередь

Битые ссылки могут возникать буквально на пустом месте. Все причины их появления можно свести к трем факторам:

- Ошибки в адресе ссылки при ручном или автоматическом указании URL. Самый частый подобный сценарий – проблемы со слешем. Многие недооценивают влияние простой черты в конце URL, и это большая ошибка. Обязательно учитывайте ее при указании ссылок и проверяйте, если неожиданно страница оказалась недоступной.

- Глобальные изменения на сайте – переход на новое доменное имя, изменения дизайна, установка плагинов. Любые действия, связанные с глобальными или частичными изменениями, способны привести к появлению битых ссылок. Даже если вносимые изменения в работу сайта, на ваш взгляд, не представляют опасности, всегда делайте бекап! Распространенный сценарий появления битых линков – установка SSL-сертификата и некорректный переезд на HTTPS-протокол, соответственно.

Если же на вашем сайте произошли структурные изменения, то обязательно нужно настроить 301-ое перенаправление со старых страниц.

- Частичное или массовое удаление уже существующих на сайте страниц. Это еще один частый случай появления битых URL. Особенно часто этим грешат магазины, которые, вместо того, чтобы настроить перенаправление на страницу с отсутствующим в наличии товаром, просто удаляют ее.

В чем опасность битых ссылок

Самая главная опасность битых линков – это пессимизация поведенческих факторов и раздражение аудитории.

Вспомните, что делаете вы сами, когда переходите по ссылке, но, вместо информации вам демонстрируется 404-ая страница. Скорее всего, просто закрываете сайт и начинаете искать другой источник информации. Таким образом, наличие большого количества битых ссылок, как минимум, негативно сказывается на метриках «Время на сайте» и «Отказы».

Следующая опасность – потеря трафика. Кроме этого, у каждой ссылки есть специальная «метрика» (в среде оптимизаторов она называется весом). Если речь идет о битой ссылке, то она тоже оказывается обнуленной. Другими словами, ссылочный вес просто не передается.

Еще одна негативная сторона битых URL – поисковики не любят домены с большим количеством таких ссылок. Такие сайты хуже ранжируется и медленнее индексируются. Почему?

Дело в том, что у каждого краулера (поискового робота) имеется собственный лимит по суммарному количеству запросов, который он может отправить в рамках одного домена (число запросов в секунду, например). Если битых URL очень много, то робот просто расходуют такой лимит на пустые страницы, а по-настоящему полезные страницы с контентом вовсе остаются без его внимания.

Как найти битые URL

Обнаружить битые URL можно при помощи нескольких инструментов. Проще всего это сделать в интерфейсе «Яндекс.Вебмастера» или Google Search Console, а также через расширения для браузеров и плагины CMS. Рассмотрим все варианты подробнее.

«Яндекс.Вебмастер»

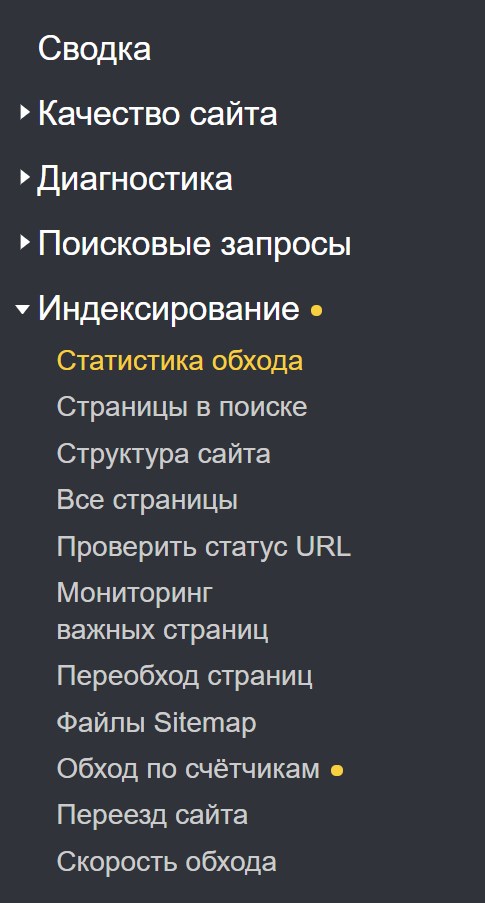

Открываем «Яндекс.Вебмастер» и выбираем «Индексирование», далее «Обход по счетчикам»:

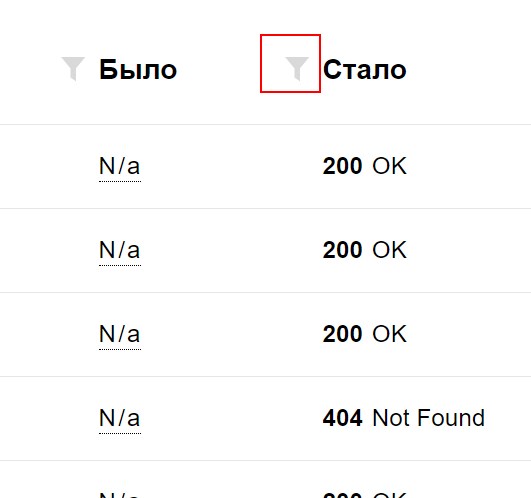

Теперь нам необходимо отфильтровать результаты таким образом, чтобы мы увидели только те страницы, которые отдают 404-ый код. Для этого кликаем по иконке с изображением воронки:

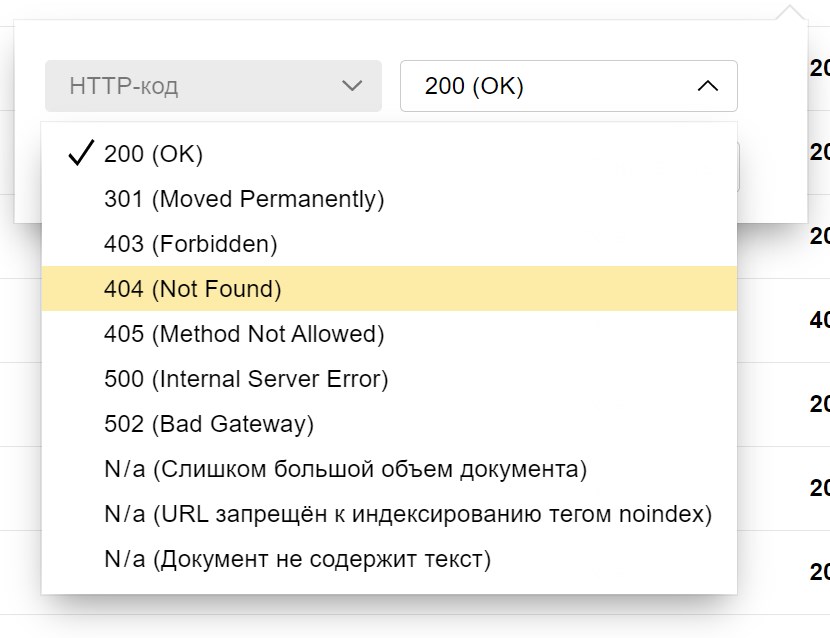

Выбираем 404-ый код:

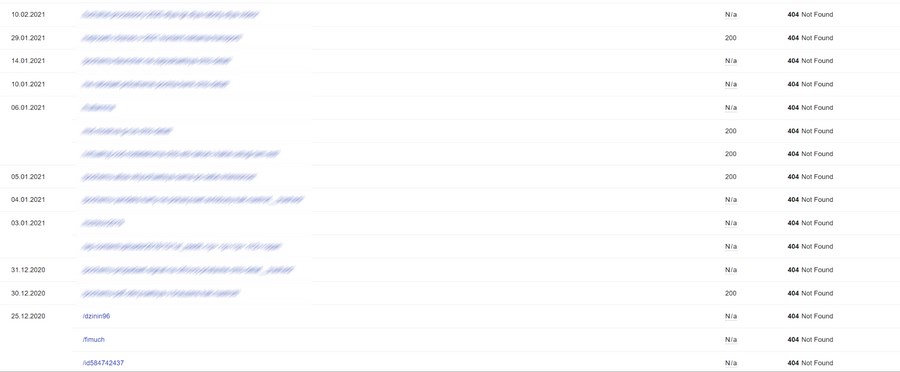

Получаем отчет со всеми удаленными страницами:

Google Search Console

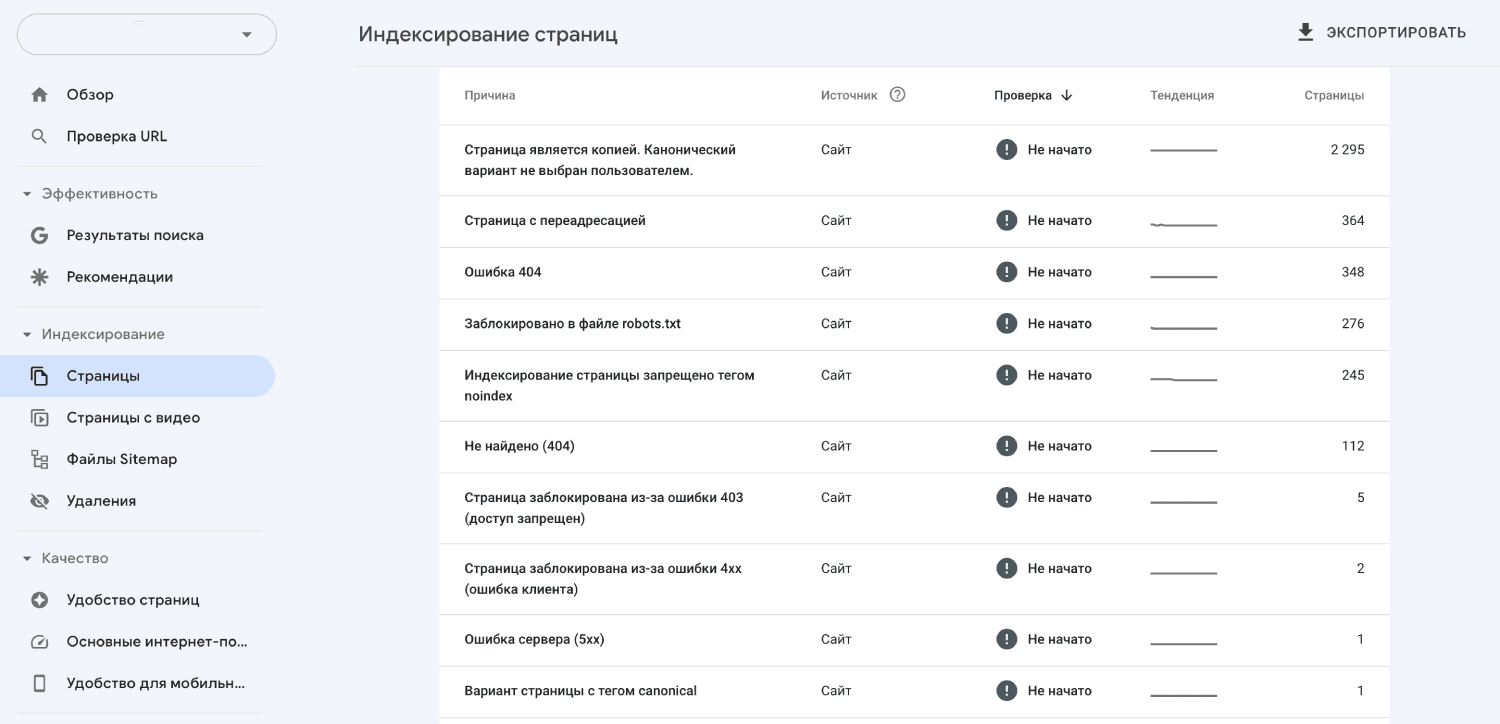

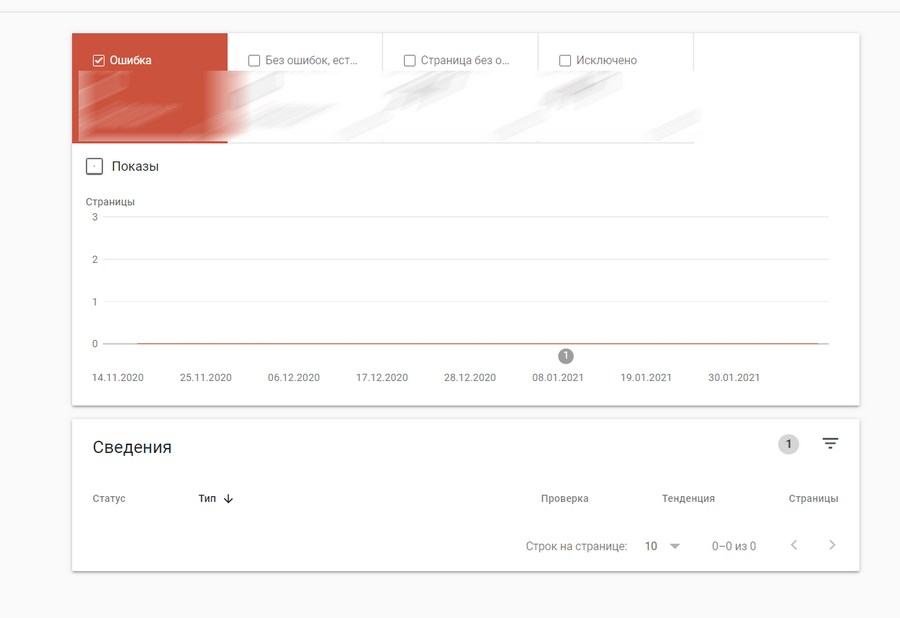

Чтобы увидеть битые ссылки в GSC, открываем раздел «Индекс» и выбираем пункт «Покрытие». Откроется анализ покрытия:

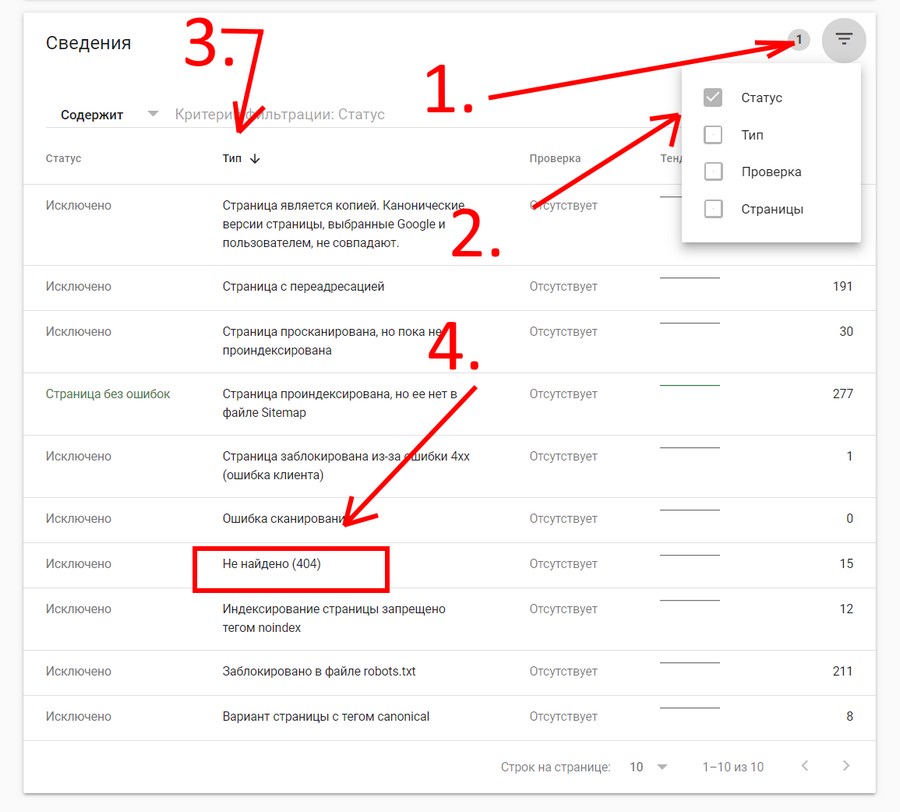

Выбираем пункт «Исключено». Теперь устанавливаем сортировку и выбираем 404-ые страницы.

Для этого действуем в следующей последовательности:

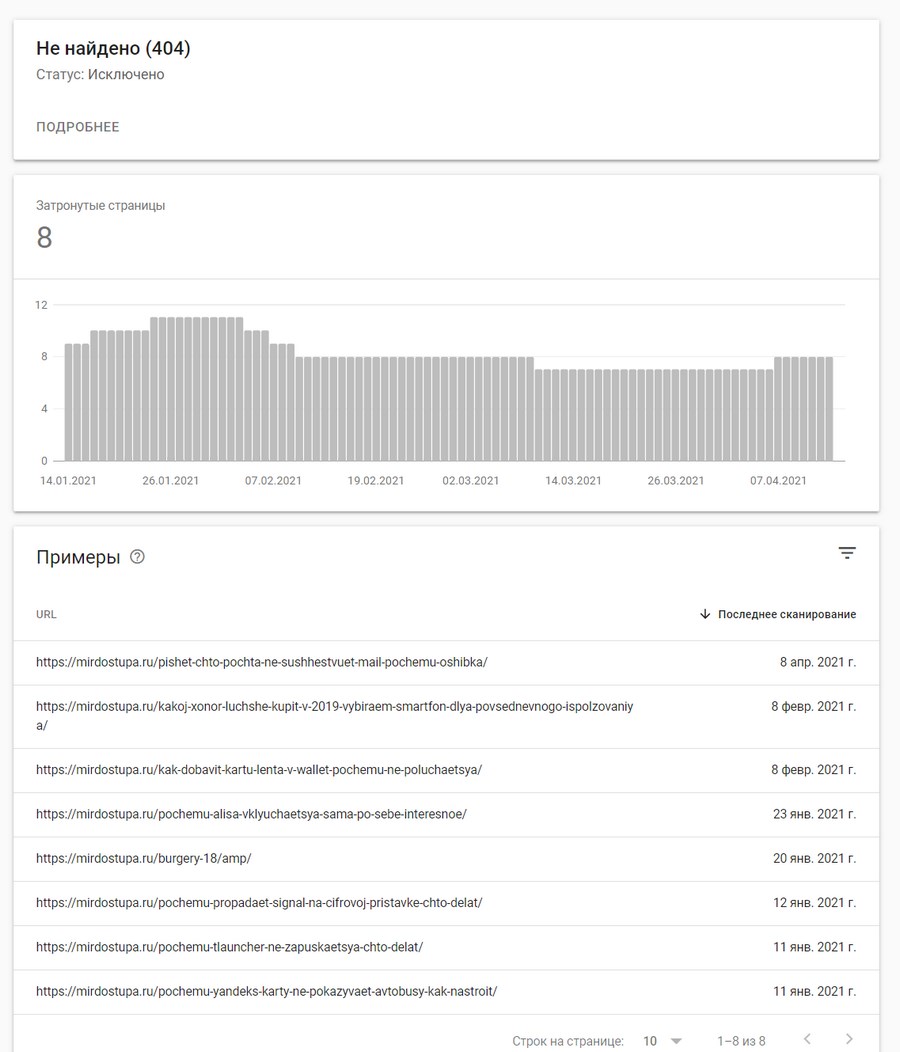

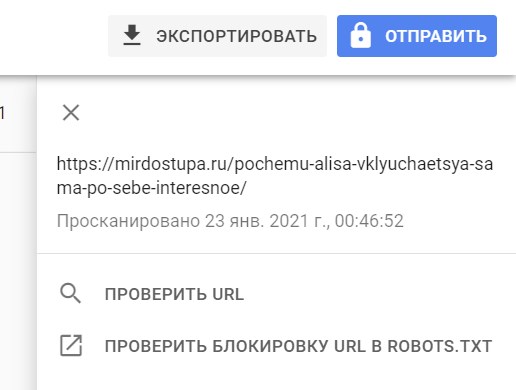

Далее кликаем на «Не найдено (404)» – здесь и будут все удаленные страницы:

Найти страницу, на которой обнаружен URL, вы можете вручную.

Google Analytics

К слову про инструменты Google: в Google Analytics также можно обнаружить все битые ссылки, которые есть на вашем сайте. Но в этом случае необходимо точно знать title вашей 404-ой. Обычно это «Страница не найдена» или вариации этого названия.

Для того чтобы найти битые ссылки при помощи GA, открываем «Контент сайта» и выбираем подраздел «Все страницы»:

Указываем название 404-ой страницы (напомню, что на каждом сайте оно разное, но обычно это «Страница не найдена» или «404»):

В некоторых случаях CMS, работающая на вашем сайте, не будет прописывать title 404-ой автоматически. Так что, если вам не удалось найти точное название, таким способом найти битые ссылки не удастся.

Но и здесь есть лайфхак: можно просто экспортировать все трафиковые страницы за интересующий вас период и проверить их код. Для проверки состояния можно использовать любой сервис, позволяющий получить код ответа сервера нескольких страниц сразу.

Ahrefs

Это удобный инструмент, который не только ищет битые бэклинки (внешние ссылки), но и пытается соотнести их с анкорами.

Все сломанные URL Ahrefs собирает в специальном отчете.

Если же вы пользуетесь интерфейсом на русском языке, то указанный отчет можно найти в разделе «Ссылочный профиль». Далее выбираем «Бэклинки» и пункт «Битые».

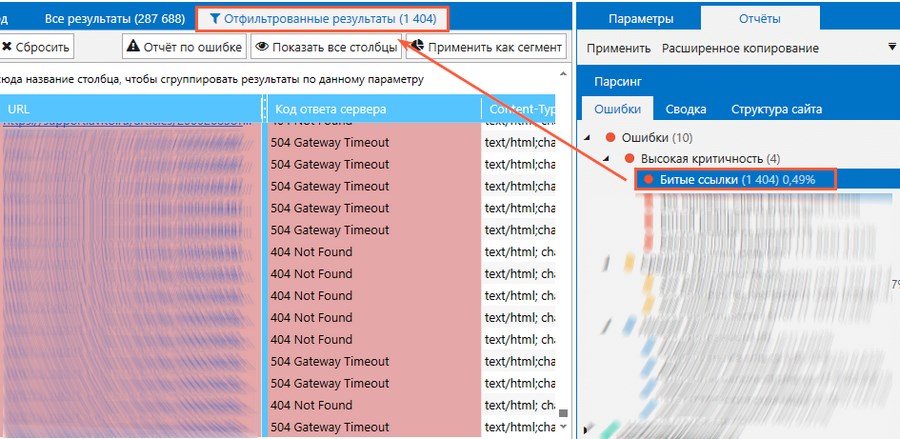

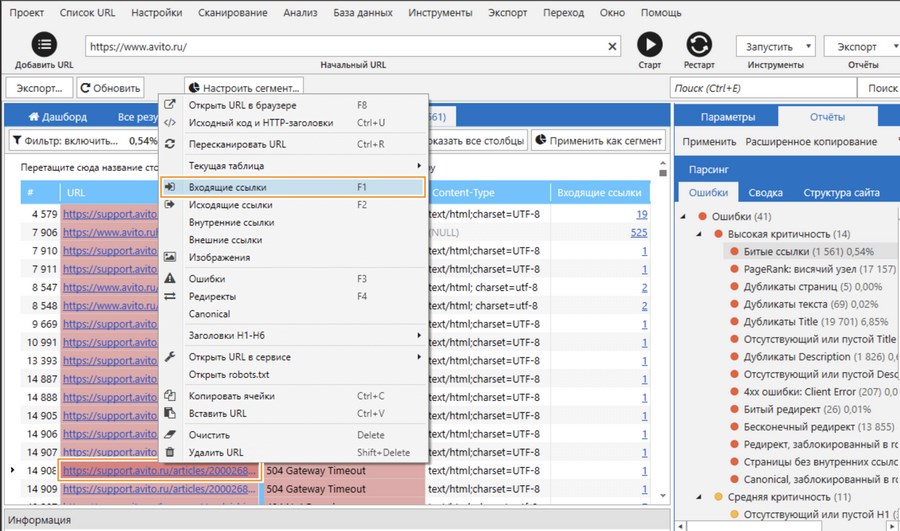

Netpeak Spider

Нетпиковский «паук» – мой фаворит. Сервис позволяет найти все сломанные URL на вашем сайте буквально в пару кликов. Что немаловажно, он умеет соотносить битые URL с целевым анкором и соответственно целевой страницей.

Чтобы найти битые линки, указываем доменное имя своего сайта в поисковой строке и ждем, пока сайт будет проверен.

Откроется общий отчет, содержащий ошибки, данные по структуре и общую сводку по домену.

Выбираем отчет «Ошибки», затем раздел «Высокая критичность». В нем и будут все интересующие нас данные по битым ссылкам.

Выбираем отчет по ошибке:

Для того чтобы узнать, какие именно URL ссылают на битую ссылку, кликаем по интересующему нас URL правой кнопкой мыши и в контекстном меню выбираем «Входящие ссылки»:

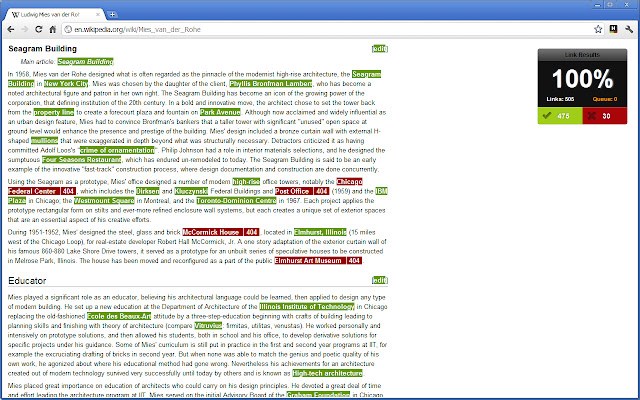

Check My Links

Check My Links – удобное расширение для Google Chrome, позволяющее проверить страницу на наличие битых ссылок.

Особенно удобно, если вы работаете сразу с большим количеством ссылок. Расширение подчеркивает работающие ссылки зеленым, а битые – красным.

Коды ответов HTTP и полные URL-адреса неработающих ссылок расширение отправляет в консоль Google Chrome.

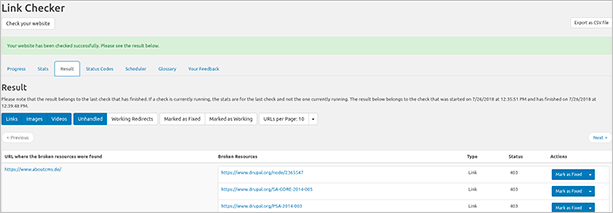

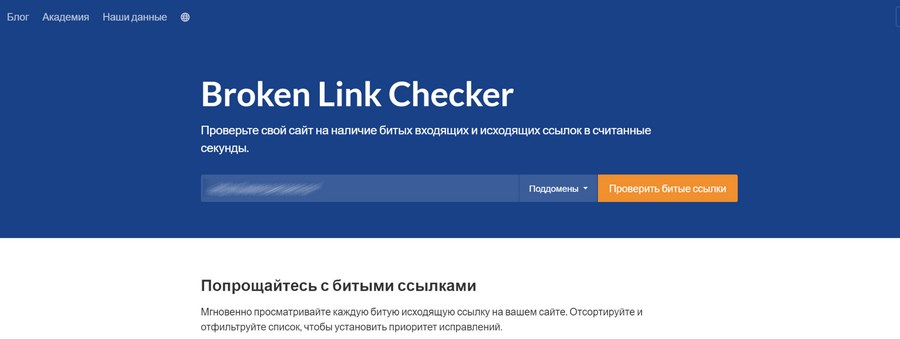

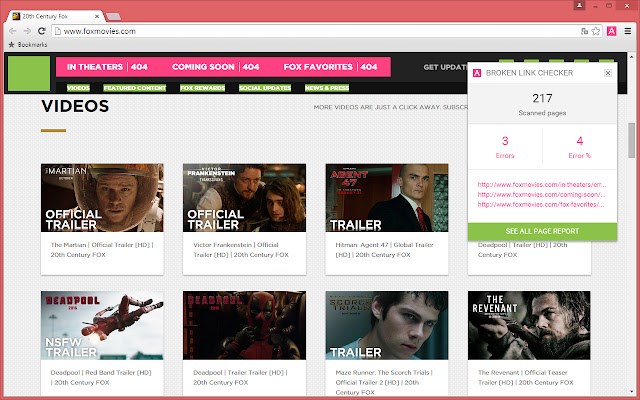

Broken Link Checker

Это функциональное расширение найдет все битые ссылки на странице или на всем сайте сразу.

Когда вы редактируете контент с большим количеством ссылок, такое расширение очень удобно. «Проверка неработающих ссылок» сканирует только выбранную страницу или весь сайт целиком.

Отчет по битым линкам будет готов в течение нескольких минут в зависимости от размеров сайта. Отчет создается напрямую, без установки и запуска каких-либо дополнительных файлов.

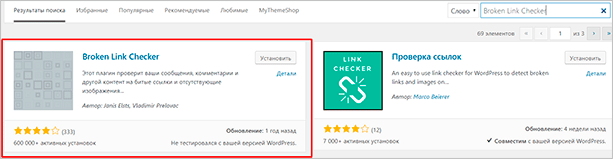

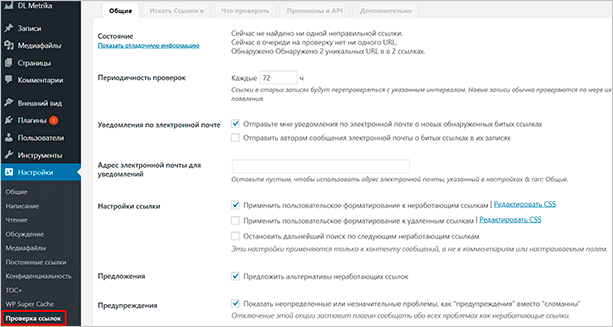

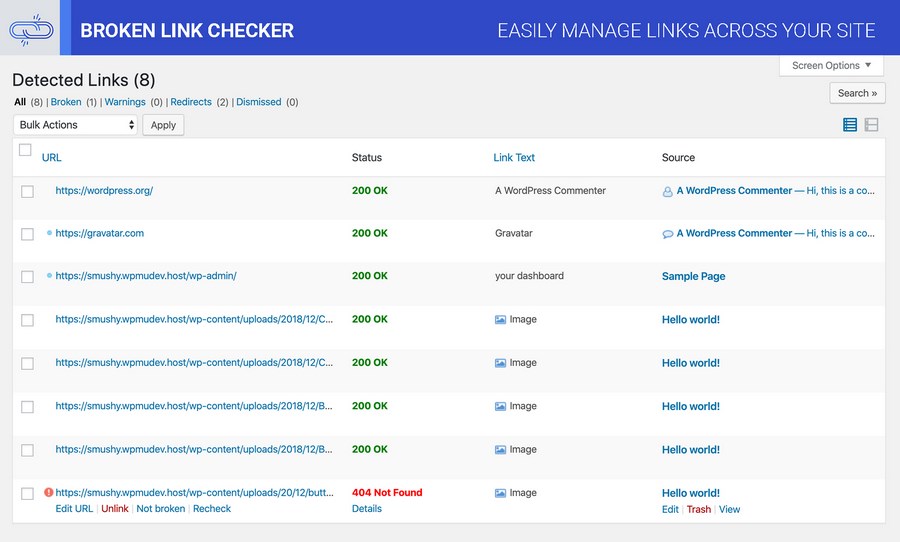

Broken Link Checker (плагин для WordPress)

Для вашей CMS можно подобрать подходящий плагин для поиска битых ссылок.

Например, для WordPress рекомендую плагин Broken Link Checker. Он постоянно обновляется, есть неплохая база знаний и довольно большое комьюнити.

Broken Link Checker отслеживает внутренние и внешние ссылки на всех страницах, включая посты, комментарии.

Он учитывает битые изображения и перенаправления. Есть уведомления по электронной почте. Также он предотвращает переход поисковых систем по неработающим ссылкам.

Можно искать «битышей» по прямому URL или анкорному. Редактировать ссылки можно прямо со страницы плагина, не обновляя вручную каждый пост.

Как исправить битые ссылки на сайте

После того, как все сломанные ссылки были собраны, пришло время разобраться с ними по-мужски.

Для начала я советую сделать один общий документ с постраничным перечислением всех сломанных линков. В нем нужно сделать три колонки: главная страница, битая ссылка, ссылка замены.

Такой подход значительно облегчит работу по исправлению сломанных линков на работающие и не даст запутаться.

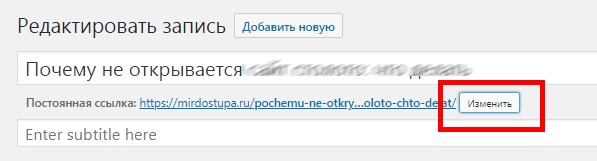

Заменить неработающую ссылку

Замысел простой – нужно заменить неработающую ссылку на актуальную на всех требующих этого страницах.

Для этого мы заходим на проблемную страницу, смотрим ее адрес и меняем путь ссылки на актуальный вариант:

Для этого логинимся в админке сайта (в используемой CMS) и открываем страницу редактирования записи. Затем меняем URL:

Если же страница вообще перестала быть актуальной, просто удаляем ее:

Если общее количество сломанных URL не превышает нескольких десятков, то справится с этой задачей можно и вручную. Если же битых ссылок очень много, то я советую использовать тот же Netpeak Spider или Ahrefs, так как они не показывают анкоры URL и догадаться об изначальном предназначении ссылки становится немного легче.

Указанный способ – самый эффективный, но он потребует значительных временных затрат.

Необязательно исправлять абсолютно все-все битые ссылки, которые есть на сайте. Достаточно обновить только те страницы, которые приносят самый большой трафик.

Для того чтобы узнать какие страницы самые посещаемые, воспользуйтесь тем же Google Analitics.

Перенаправить с проблемной страницы

Что можно сделать еще, если первый вариант решения проблемы не подходит? Например, сделать перенаправление с проблемной страницы на работающую.

Внимание! Не следует слишком увлекаться внутренней переадресацией, в рамках одного домена. В противном случае могут появиться неприятные последствия.

Например, в виде исключения страницы из индекса или понижения позиций домена в SERP.

Вариант c 301-ым перенаправлением может пригодиться в том случае, когда

- меняется уровень вложенности веб-страниц;

- переименовываются разделы сайта;

- вносятся какие-либо иные изменения в его структурный элемент.

Ваш сайт работает на CMS? Тогда ищите готовый плагин, который позволит настроить редирект страницы без изменений .htaccess.

Для сайта на WordPress рекомендую удобный плагин Redirection. В разделе Add new redirection указываем две ссылки и сохраняем. Все! Редирект настроен.

Удалить битую ссылку

Да, вот так просто. Удалять можно тогда, когда на вашем сайте отсутствуют достаточно релевантные страницы под замену URL. Собственно, здесь уже ничего не поделаешь и лучше удалить, чем плодить битые ссылки.

Восстановить удаленные страницы

Безусловно, битых ссылок может быть очень много, и восстановление каждой страницы может стать нереальной задачей.

В этом случае поступите следующим образом.

В GA посмотрите трафик всех удаленных страниц за последние полгода. Страницы с самой большой посещаемостью просто восстановите. Если контента для них нет, то создайте его заново.

Выводы

Теперь мы точно знаем, что битые URL – это отрицательное явление, способное навредить не только странице, но и всему домену в целом. Их не любят поисковики, они раздражают посетителей. Ухудшение пользовательского опыта – одна из главных проблем битых ссылок.

Решить ее можно, как минимум, при помощи четырех вариантов:

- удалить ссылку;

- сделать перенаправление;

- заменить битый линк на рабочий;

- вручную восстановить удаленную страницу.

Таким образом, всегда можно найти наиболее подходящее решение и сделать сайт удобнее для целевых посетителей.

Как найти битые ссылки на сайте бесплатно

Битые ссылки (broken links) — это ссылки на сайте, которые не работают: например, ведут на несуществующие страницы с кодом ошибки 404 (Page Not Found). Большое количество битых ссылок ухудшает позиции сайта в поисковых системах, а также негативно сказывается на удобстве для пользователей. В нашей статье мы расскажем, как проверить сайт на битые ссылки с помощью бесплатных онлайн-инструментов.

ТОП-5 бесплатных инструментов для поиска битых ссылок на сайте

- Яндекс.Вебмастер.

- Google Search Console.

- Screaming Frog Seo Spider.

- Xenu.

- Broken Link Checker.

Ниже мы подробнее расскажем о каждом сервисе и покажем, как с ним работать.

№1. Яндекс.Вебмастер

Яндекс.Вебмастер (Yandex.Webmaster) — это бесплатный инструмент для веб-мастеров и владельцев сайтов, позволяющий им контролировать индексацию сайта в поисковой системе Яндекс, а также отслеживать состояние сайта и предупреждать о возможных проблемах. С помощью Яндекс.Вебмастера вы можете проверять качество индексирования, искать и устранять ошибки, оптимизировать сайт для поисковых систем, а также получать информацию о запросах пользователей и посещаемости сайта.

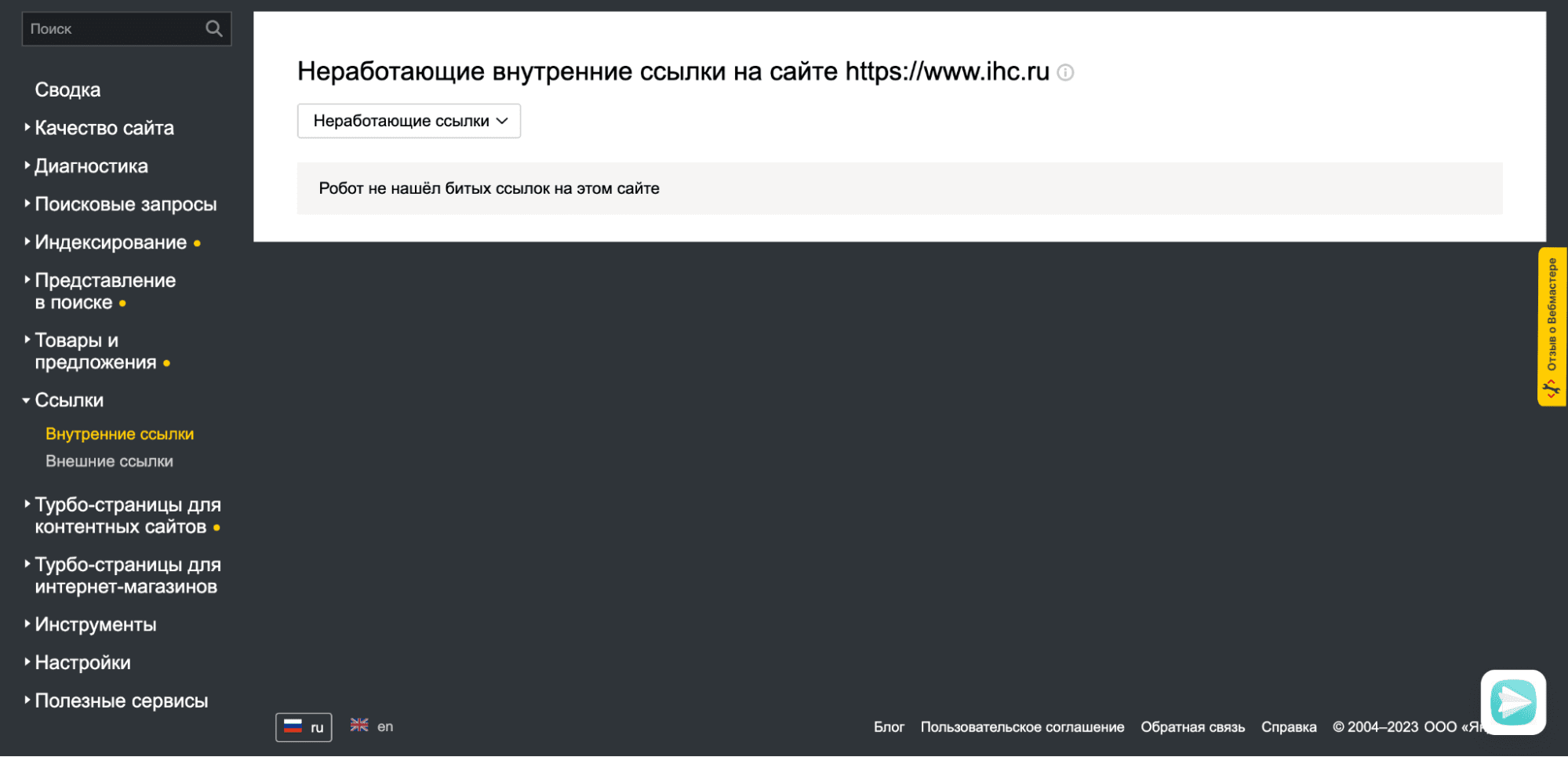

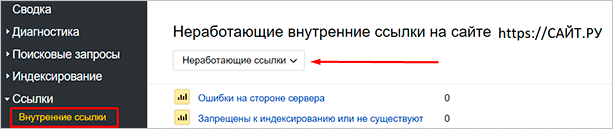

Чтобы найти битые ссылки в интерфейсе Яндекс.Вебмастера, необходимо перейти в раздел «Ссылки» → «Внутренние ссылки» и выбрать ответ по неработающим ссылкам. По данным Вебмастера на сайте «Интернет Хостинг Центр» таких линков нет.

№2. Google Search Console

Google Search Console (ранее известный как Google Webmaster Tools) — это бесплатный инструмент для владельцев веб-сайтов, который позволяет контролировать индексацию сайта в поисковой системе Google и получать отчеты о его производительности. С помощью Гугл.Вебмастера вы можете проверять исключения, ошибки индексации, анализировать выдачу поисковых запросов, мониторить состояние сайта и предотвращать возможные проблемы. Инструмент предоставляет важную информацию для оптимизации сайта и улучшения его выдачи в поисковых результатах.

Чтобы найти неработающие линки через Google Search Console, необходимо перейти в раздел «Страницы» и найти причины, по которым не проиндексированы некоторые страницы веб-сайта: здесь вы найдете адреса битых ссылок, например, с ошибками 404 и 5хх.

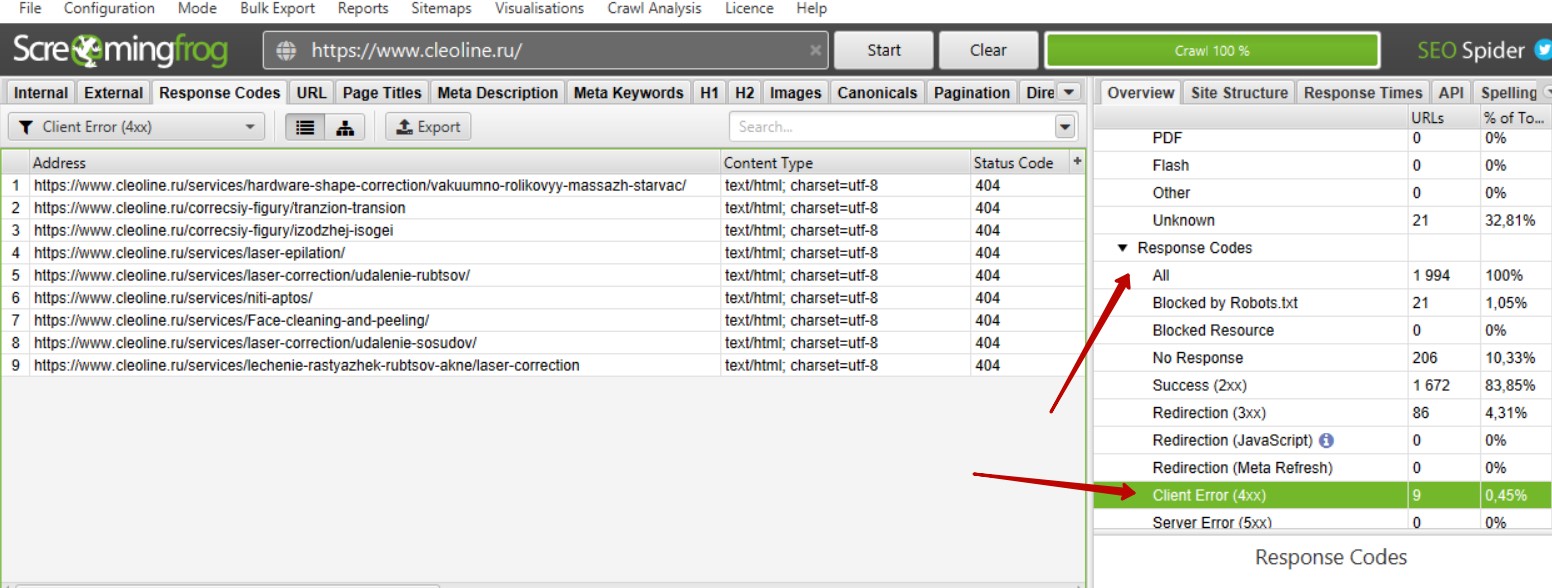

№3. Screaming Frog Seo Spider

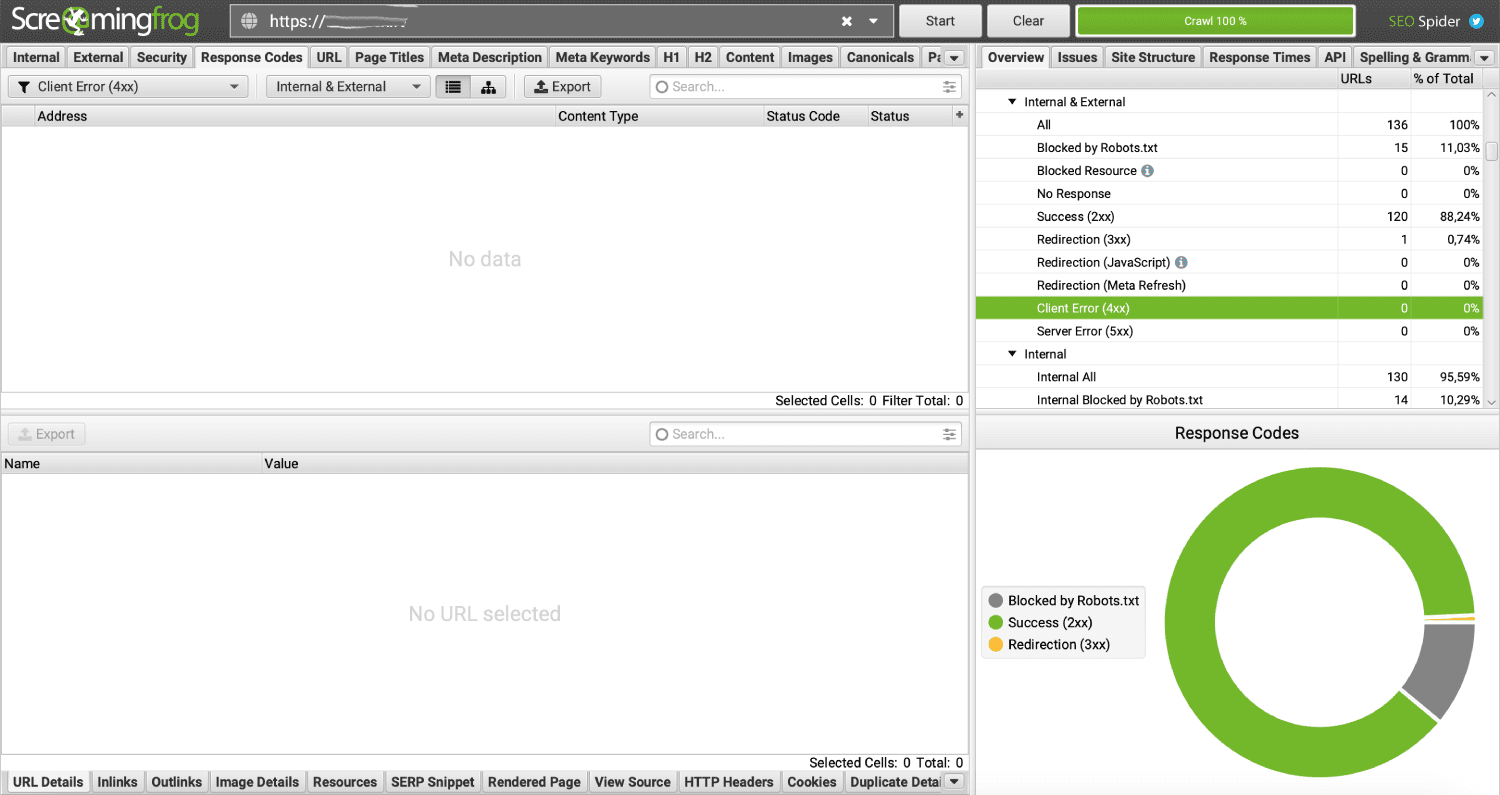

Screaming Frog SEO Spider — это программа для анализа веб-сайтов, которая позволяет сканировать сайты и анализировать их в поисках ошибок и проблем, связанных с поисковой оптимизацией. Screaming Frog SEO Spider (в народе ее называют «лягушка») может проверять мета-теги, заголовки, линки, изображения, структуру и другую важную информацию, необходимую для оптимизации SEO. Результаты анализа можно экспортировать в файлы Excel или CSV для дальнейшей обработки. Программа позволяет бесплатно проверять до 500 страниц сайта.

Алгоритм поиска битых ссылок в Screaming Frog:

- Скачайте программу с официального сайта и установите у себя на компьютере.

- Запустите «лягушку» и просканируйте сайт.

- В меню справа отобразятся все отчеты, по которым Скриминг Фрог проверяет веб-ресурс.

- Найдите отчеты с названиями Client Error (4xx) и Server Error (5xx) и убедитесь, что такие страницы не найдены. В противном случае на сайте обнаружились неработающие линки.

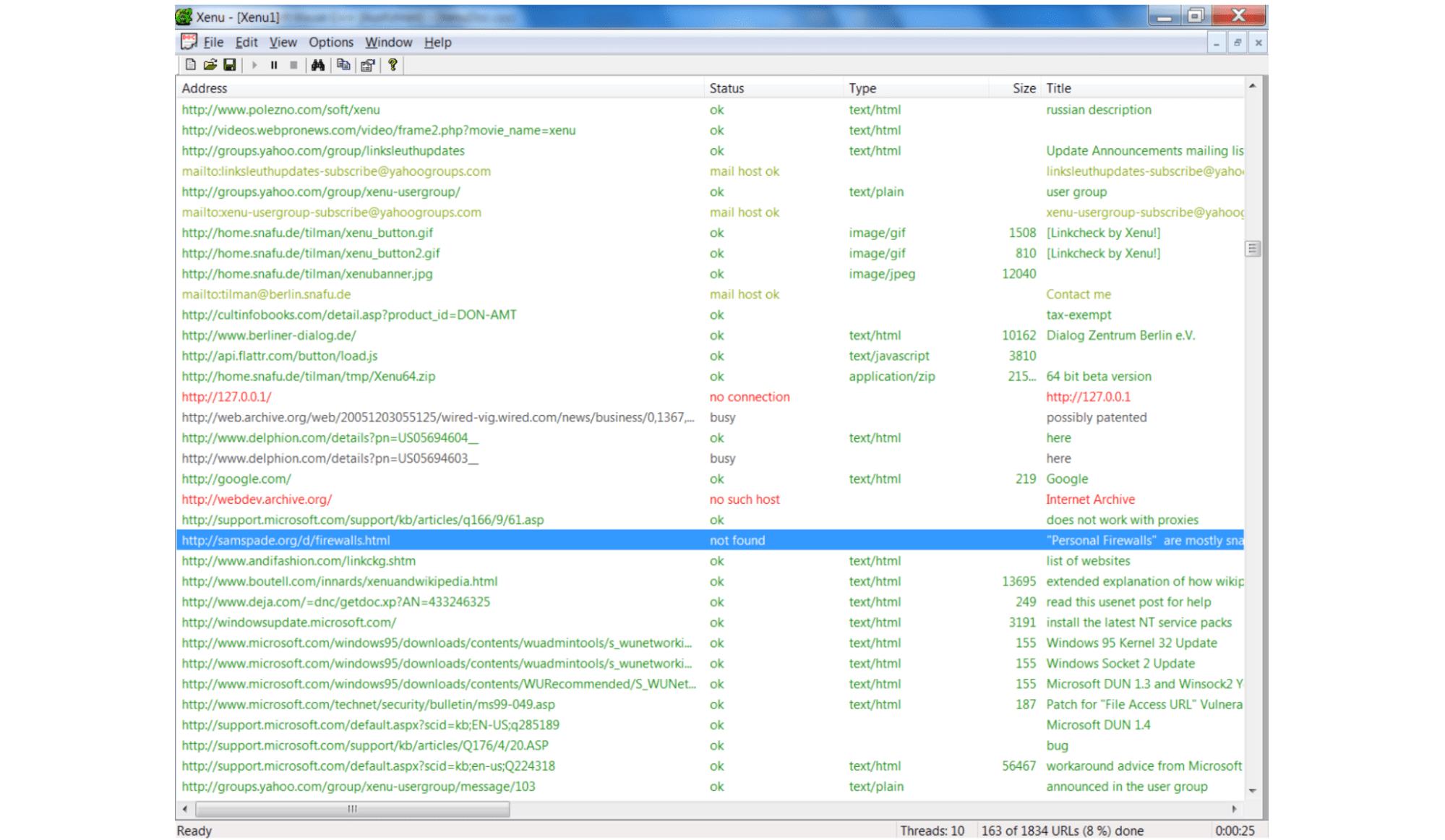

№4. Xenu

Xenu’s Link Sleuth — это бесплатный инструмент для анализа ссылок, разработанный для проверки сайтов на наличие битых ссылок. Он сканирует веб-ресурс и анализирует все линки на ошибки, например, на 404 (Page Not Found). Xenu помогает веб-мастерам идентифицировать проблемы со ссылками и улучшать поведенческие факторы и юзабилити. Просто просканируйте сайт через эту программу и получите список всех страниц сайта с соответствующим кодом ответа сервера.

№5. Broken Link Checker

Если ваш веб-ресурс работает на CMS WordPress, то найти битые ссылки на сайте можно с помощью плагина «Broken Link Checker». Broken Link Checker — это плагин для ВордПресс, который помогает обнаружить и исправить битые линки на вашем сайте. Он сканирует сайт и проверяет все гиперссылки в постах, страницах, комментариях и других местах. Если он находит неработающую ссылку, то отображает ее в панели администратора и предлагает варианты для ее исправления.

Как исправить битые ссылки на сайте

Если ссылка устарела и больше не работает, просто обновите ее (замените на существующий линк) или удалите. Чтобы исправить «broken links», вы можете:

- Найти альтернативную рабочую ссылку, которую можно использовать вместо битой.

- Настроить 301 редирект на существующую страницу, близкую по содержанию.

- Просто удалите ссылку.

Мы позаботились о своих клиентах и заранее составили цикл статей о различных ошибках на сайте. Специальная подборка:

Если вы столкнулись с одной из этих проблем, обязательно прочитайте наши инструкции.

Заключение

Своевременное обновление устаревших ссылок важно, чтобы улучшить пользовательский опыт и повысить репутацию сайта. Когда пользователь переходит на несуществующую страницу, он получает ошибку 404, что может привести к ухудшению впечатления о сайте. В статье мы рассказали о нескольких бесплатных сервисах, которые помогут избежать этих проблем. Являетесь нашим клиентом и остались вопросы? Задавайте их тикет-системе, наши специалисты обязательно помогут!

Похожие статьи

-

Капчей (captcha) называется автоматизированный тест для различения человека и робота, который используется в качестве защиты от спама на сайтах и в приложениях. За время своего развития этот инструмент претерпевал немало изменений. Если раньше капча представляла собой проверку в виде изображения с искаженными символами, которые требовалось ввести перед отправкой данных на сервер, то сейчас для ее прохождения пользователям даже не нужно предпринимать никаких дополнительных действий. Добавление капчи на веб-сайт поможет вам защититься от ботов. В статье мы расскажем об известных сервисах, позволяющих это сделать, и объясним, как установить капчу на сайт, используя самый популярный из них.

-

SSL-сертификат — это цифровой сертификат, удостоверяющий подлинность веб-сайта и позволяющий использовать зашифрованное соединение. Без защищенного соединения сайту будет проблематично продвинуться в поисковых системах и завоевать доверие клиентов. Для небольших веб-проектов, лендингов и блогов отлично подойдет бесплатный SSL-сертификат Let’s Encrypt. В нашей статье мы подробно расскажем, как получить его на виртуальном хостинге и VPS/VDS сервере.

-

Сегодня, чтобы создать полноценный работающий сайт, вовсе не обязательно владеть языками программирования и другими специальными знаниями. Для этого давно существуют программные продукты, которые делают всю техническую работу за вас. Конструкторы сайтов и системы управления контентом (CMS) являются простыми и удобными инструментами, позволяющими запустить собственный веб-проект. Их часто сравнивают, но на самом деле оба этих решения эффективны — в разных обстоятельствах. Мы расскажем, чем CMS отличаются от конструкторов сайтов, и перечислим особенности каждого метода.

Здравствуйте, уважаемые читатели!

Серия материалов про оптимизацию проектов на WordPress продолжается. На этот раз мы расскажем вам о том, как найти битые ссылки на сайте, почему их срочно нужно устранить и как это может повлиять на SEO-продвижение. Решить такую проблему можно несколькими способами: плагинами, вручную или же с помощью сторонних онлайн-сервисов. Обо всем этом и многом другом в сегодняшней статье.

Почему битые ссылки опасны для сайта

Во-первых, нужно понять, что такое битые ссылки вообще. Как правило, это те линки, которые ведут на страницу с 404-й ошибкой. Вы можете прямо сейчас зайти на свой ресурс, ввести после домена любую белиберду – и, вуаля, страничка с цифрой 404 тут как тут.

Страница кастомная. Каждый вебмастер пишет здесь то, что хочет. У кого-то нет упоминаний о номере ошибки. Зато есть линк на карту сайта и блок с популярными постами. Хорошее решение, которое может минимизировать негативную реакцию пользователя, попавшего на такую страницу.

Теперь представьте, что вы только что написали статью. ВордПресс автоматически поставил там линк по тайтлу, а вы забыли это изменить и опубликовали материал.

Вашим гостям очень понравилась статья, и они охотно разместили ее в своих соцсетях. Вы же, в свою очередь, заметили, что ссылка на материале не слишком красивая и изменили ее.

Решение здесь само напрашивается: нужно сделать редирект, т. е. перенаправление на верную статью. Пользователь будет заходить по старой ссылке, а его тотчас будет перекидывать на ту самую статью, даже если изменился адрес.

Сейчас WordPress умеет проделывать это автоматически. Но работает это далеко не во всех случаях, поэтому может понадобиться дополнительная диагностика. О ней мы и поговорим далее.

Количество битых ссылок учитывается поисковыми системами. Когда их слишком много, Яндекс или Гугл могут повесить на ресурс фильтр. То есть все ваши статьи будут опущены в самый конец поисковой выдачи или же вовсе удалены из нее.

С помощью онлайн-сервисов

- W3C Link Checker – очень популярный и функциональный сервис для проверки сайта на битые линки. Достаточно просто ввести адрес ресурса, после чего инструмент выдаст вам все необходимые результаты. Link Checker имеет несколько дополнительных опций. С помощью них вы сможете выявлять ошибки более точно.

- Free Link Checker – бесплатный инструмент для проверки ресурса на ошибки, который поможет легко и быстро выявить все адреса, ведущие на страницу с ошибкой 404. На сайте есть и другие инструменты для вебмастеров. Обязательно ознакомьтесь с ними.

- Link Tiger – еще один онлайн-сервис, который поможет узнать о битых ссылках на вашем проекте. От двух предыдущих “тигр” отличается более современным, удобным интерфейсом. Инструмент позволяет выслать все результаты проверки на email. Обязательно возьмите его на вооружение.

- Broken Link Checker – ресурс с классическим интерфейсом и стандартными функциями для проверки на битые ссылки. Просто вводите адрес, нажимаете кнопку и вам вылетают результаты.

- СайтРепорт – популярный онлайн-инструмент для проверки ресурса на ошибки. Работает, как и все остальные: адрес – кнопка – результат.

С помощью Yandex.Webmaster и Search Console

Если ваш ресурс добавлен в Яндекс Вебмастер и Консоль от Гугла (что нужно сделать обязательно), то вы можете без проблем найти все битые ссылки через них. Но не забывайте, что в отличие от онлайн-сервисов и плагинов, Yandex.Webmaster и Search Console умеют проверять только внутренние ссылки вашего сайта. То есть, если на странице будет битая внешняя ссылка, то эти инструменты ее проигнорируют.

Yandex.Webmaster

В Вебмастере от Яндекса вы должны перейти в раздел “Ссылки” – “Внутренние ссылки”. Там будут представлены все неработающие адреса, которые ведут на 404-ю ошибку.

Здесь будет представлена вся информация по битым адресам. Включая ошибки на стороне сервера, или те, которые вы создали самостоятельно. Например, при неправильной настройке robots.txt.

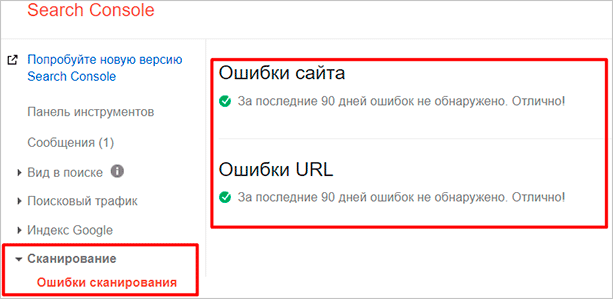

Search Console

В консоли от Гугла вы точно также сможете увидеть неработающие адреса. Для этого вы должны перейти в раздел “Сканирование” – “Ошибки сканирования”. Там вы сможете увидеть все ошибки сканирования вашего ресурса, включая 404-ю.

Учтите, что в этом разделе будут представлены не только ссылки внутри вашего проекта. Тут будут и адреса с других сайтов, которые могли ошибиться при размещении какого-то материала.

В любом случае, если большое количество трафика идет по какому-то неработающему адресу, то целесообразнее будет сделать редирект на верную статью. Так вы сделаете жизнь многих пользователей легче и в то же время не потеряете львиную долю трафика.

Поиск неработающих адресов через инструменты от поисковиков, по моему мнению, является наиболее приоритетным вариантом. Так вам не придется устанавливать дополнительные плагины или обращаться к сторонним онлайн-сервисам, не все из которых, кстати говоря, бесплатные.

Но вот что касается исправления ошибок, то тут уже придется поработать. Как мы и говорили в начале этой статьи, найти битые адреса не проблема. Проблема – грамотно исправить эту ошибку, сохраняя желание пользователей просматривать страницы вашего ресурса.

Вручную настроить переадресацию не всегда получится. Битых линков может быть за сотню, и если для каждого, подчеркиваю, отдельно делать редирект – можно с ума сойти.

Можно, конечно, заставить делать эту монотонную работу какого-нибудь фрилансера, но зачем переплачивать, когда есть более быстрый и, что самое главное, бесплатный способ?

С помощью плагинов для WordPress

Самая популярная блоговая CMS давно уже имеет инструменты для борьбы с битыми адресами. Обычно, если какой-то адрес схож с другим, то ВП может автоматически перекидывать с 404-й страницы на реальную статью. Но это возможно не всегда.

Однако у нас всегда есть плагины. Тысячи различных вариантов, с помощью которых мы можем исправить ошибку 404 раз и навсегда. Плагины могут решать проблему по-разному.

Можно пойти по более легкому и быстрому пути – сделать переадресацию со всех битых адресов на главную. В этом случае поисковые системы не будут считать неработающие адреса за таковые, потому что будет редирект. Многие сеошники так и поступают, потому как поисковые системы хорошо реагируют на такие решения.

Есть и другой способ. Он заключается в настройке редиректов на конкретные материалы или страницы. То есть если человек переходит по какой-то старой ссылке, желая найти определенный пост, то вебмастер специально учитывает это и перебрасывает его в нужное место.

Некоторые плагины значительно облегчают эту задачу. Их мы и рассмотрим далее.

Broken Link Checker

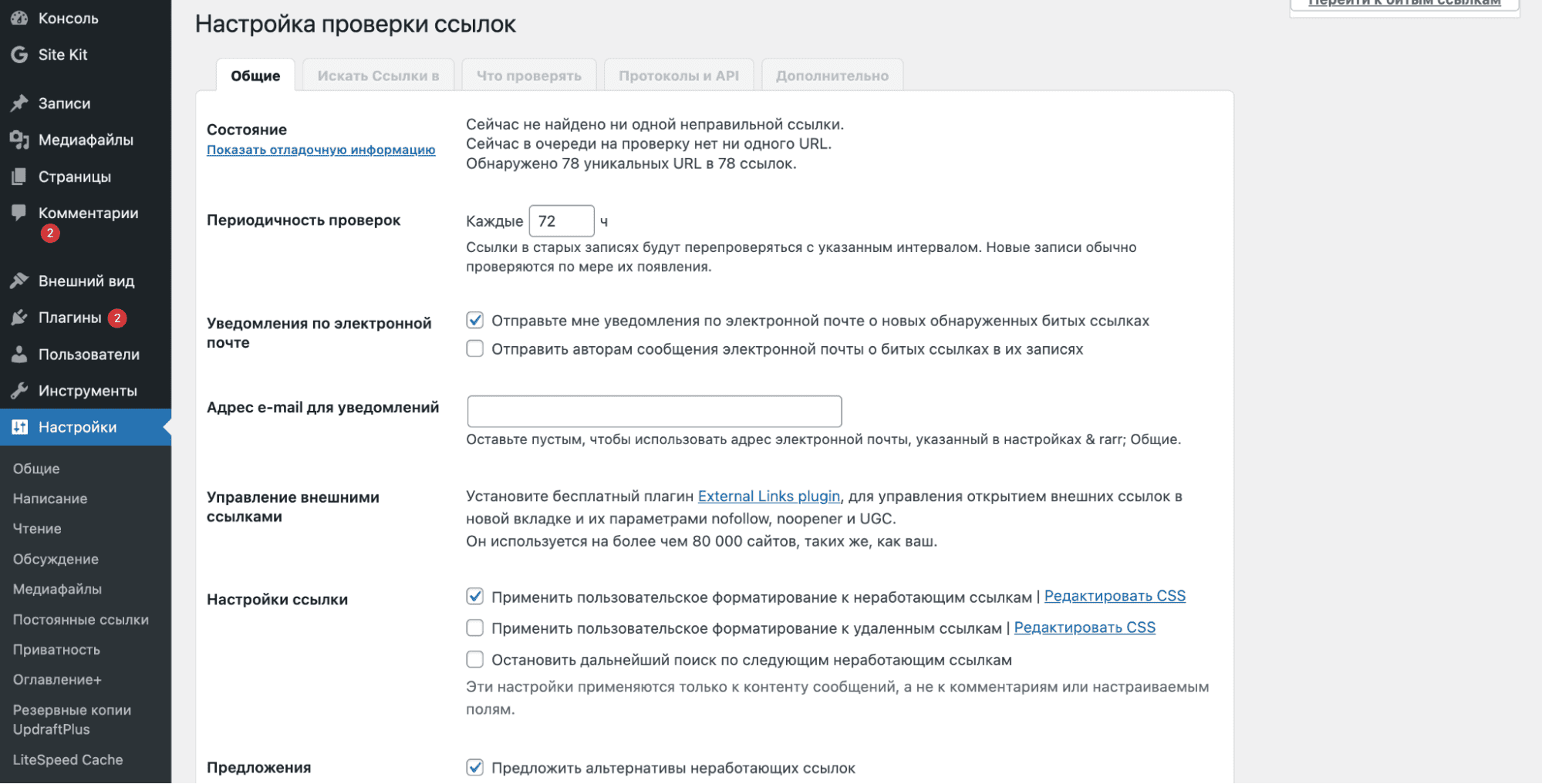

Достаточно популярное решение, которое, к сожалению, не обновлялось уже больше года. Тем не менее плагин все еще работает, причем отлично. Для его установки вы должны перейти в “Плагины” – “Добавить новый”, после чего ввести в поле поиска название – Broken Link Checker.

Для установки просто кликните на одноименную кнопку, после чего не забудьте активировать модуль.

После успешной активации вы должны перейти в настройки расширения. Они доступны по пути “Настройки” – “Проверка ссылок”. Broken Link Checker поддерживает русский язык, поэтому даже у новичков он не вызовет трудностей при использовании.

В плагине приличное количество возможностей. Адреса можно искать в постах, на страницах и даже в комментариях. Также он позволяет искать неработающие картинки, что будет полезно для любого информационного ресурса.

Настройка Broken Link Checker не вызовет у вас затруднений. Несколько параметров, в которых разберется даже ребенок.

Link Checker

Новый плагин, который также позволяет искать неработающие адреса. Он часто обновляется, да и интерфейс там достаточно удобный. Все ошибки представлены в виде удобной страницы. При желании их можно легко исправить в один клик, настроив переадресацию на главную или любую другую страницу.

Yoast SEO Premium

В премиум-версии самого популярного плагина для WordPress – Yoast SEO также есть инструменты для проверки ресурса на битые ссылки. Расширение, как вы могли догадаться, платное. Стоимость – около 79 евро.

Помимо простого поиска Yoast позволяет удалить или переадресовать неработающий адрес. Премиум-вариант подойдет далеко не всем, но если вы из тех вебмастеров, которые вкладываются по максимуму, то Yoast SEO Premium – хороший выбор.

Тем более что у плагина есть куча других полезных функций, которые помогут оптимизировать ваш сайт для поисковых систем.

WP Broken Link Status Checker

Завершает нашу подборку WP Broken Link Status Checker. Стоит сказать, что он не обновлялся на протяжении последних двух лет. Однако плагин до сих пор остается актуальным и рабочим. Многие вебмастера пользуются продуктом с большим удовольствием и даже покупают про-версию.

Как и в предыдущих случаях, WP Broken Link Status Checker может найти битые внутренние ссылки, неработающие картинки и прочие ошибки, которые могут быть связаны с этим. Здесь же вы сможете быстро исправить все это. Либо вручную, либо с помощью переадресации. Также можно просто удалять ненужные адреса в один клик, используя интерфейс плагина.

Не забывайте, что каждый плагин может дополнительно нагружать ваш ресурс на WordPress. Возможно, вам стоит обратить внимание на онлайн-сервисы, премиум-версию Yoast или любое другое комплексное решение.

С помощью софта

Наименее популярный вариант, который использовался еще в бородатых годах. И все же, мы думаем, что вам стоит о нем знать. В интернете можно найти много бесплатных программ, которые предоставляют точно такие же возможности, как и все предыдущие примеры.

Минусом этого варианта является необходимость в установке этих приложений на свой компьютер. С другой стороны, такой способ может показаться кому-то более удобным, нежели использование онлайн-сервисов или плагинов.

Самой известной программой для поиска битых ссылок является Xenu Link Sleuth. Работает точно так же: вводите адрес, приложение подключается к сети и ищет неработающие линки. В принципе, удобно. Но необходимость в установке не всем будет по душе.

Скачать программу можно из интернета. Какого-то официального источника Xenu Link Sleuth мы не нашли, зато есть куча перезаливов. Связано это, мы думаем, с частичной потерей актуальности. Зачем пользоваться софтом, когда есть куча более удобных аналогов? Тем не менее любители точно найдутся.

Заключение

Теперь вы знаете, как найти битые ссылки на своем проекте с помощью онлайн-сервисов, плагинов или приложений. Все это диагностируется и исправляется очень легко, поэтому вам непременно стоит обратить внимание на данный аспект.

Ведь все знают, что любая мелкая недоработка на сайте может послужить причиной возникновения более крупных проблем. Особенно на поприще поисковой оптимизации, где большое количество неработающих адресов негативно влияет на расположение проекта в выдаче.

Наличие технических ошибок на сайте может негативно сказаться на его ранжировании, что в свою очередь приведет к снижению поискового трафика и позиций в поисковых системах. Чтобы выявить технические ошибки, необходимо провести комплексный технический SEO-аудит сайта. Одним из основных помощников в этой сложной и трудозатратной задаче для нас выступает десктопная программа Screaming Frog.

О Screaming Frog

Screaming Frog – это софт для сканирования сайта, ключевыми функциями которого являются:

-

поиск битых ссылок;

-

поиск ссылок с редиректом;

-

поиск дублей страниц;

-

анализ изображений;

-

поиск страниц, где отсутствуют мета-теги или основной заголовок h1;

-

извлечение элементов со страниц сайта;

-

поиск пустых страниц или неинформативных страниц, где крайне мало контента.

С помощью данной программы можно проанализировать страницы, которые закрыты в файле robots.txt, проверить наличие и корректность заполнения тегов alt у изображений, а также наличие атрибута Canonical и многое другое.

Screaming Frog может просканировать весь сайт полностью, либо же определенный каталог, либо заданный вручную список страниц. Чтобы не создавать сильную нагрузку на сервер, можно в любой момент остановить сканирование.

Важным плюсом является то, что результат сканирования можно выгрузить в формате csv или xlsx. Но есть и некоторые минусы:

-

сложный и интуитивно непонятный интерфейс для новых пользователей;

-

данные хранятся в оперативной памяти вашего ПК, в связи чем довольно проблематично полностью сканировать объемный сайт. А также при работе с софтом работа ПК может замедлиться;

-

программа платная (но есть бесплатная версия с ограничениями).

А теперь подробнее.

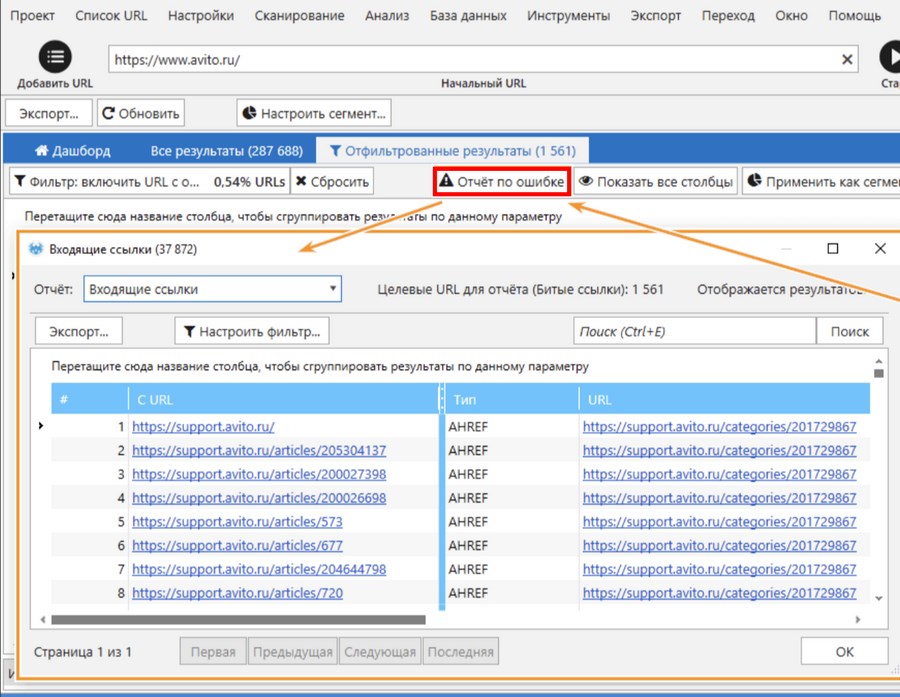

Поиск битых ссылок

Мы намеренно перескочили через тему «Настройка Screaming Frog», так как в сети присутствует большое количество мануалов по настройке программы, описаний интерфейса и вводной информации о том, как работать с программой и сканировать сайт. Переходим сразу к техническому анализу сайта.

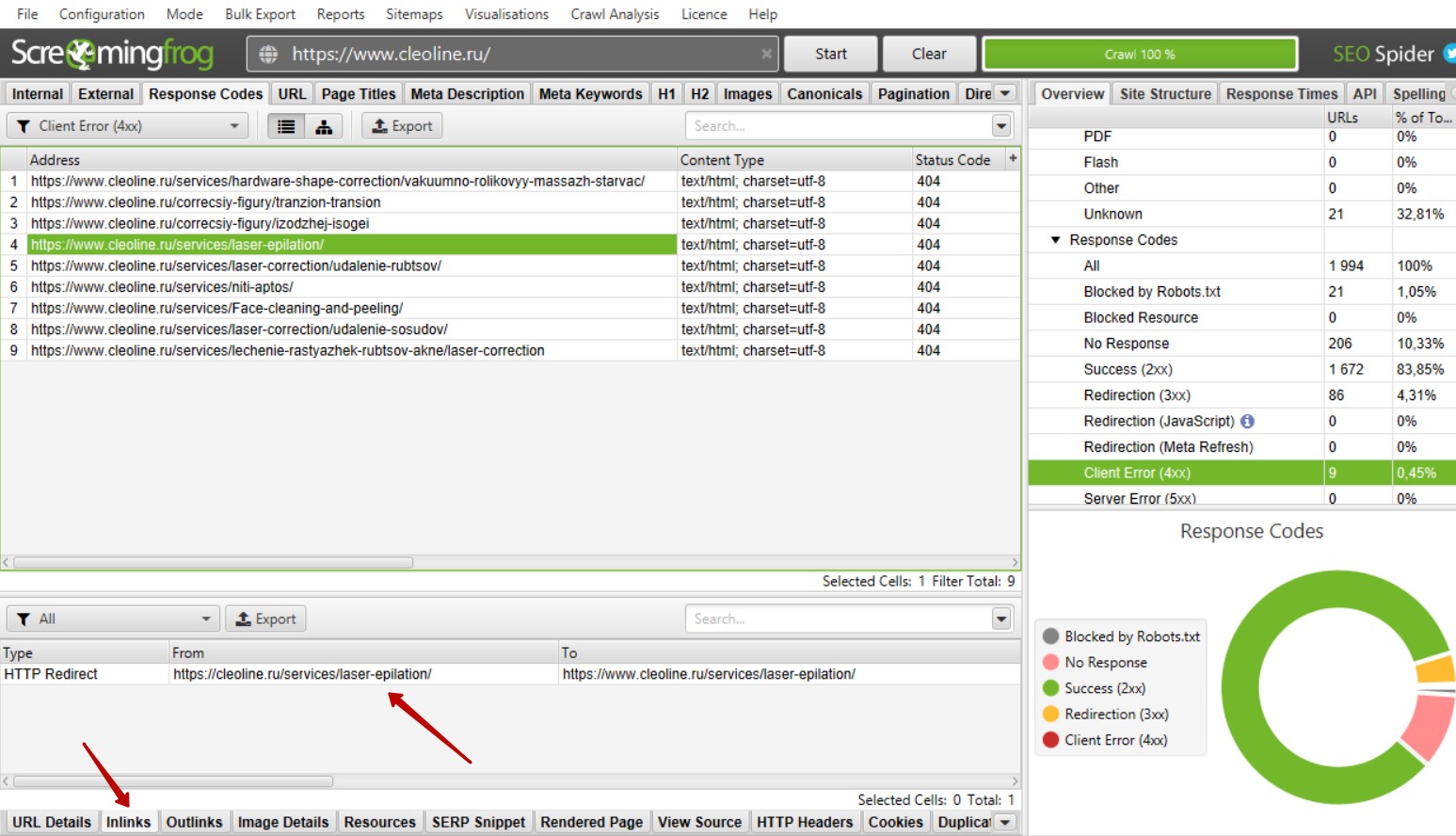

Итак, мы просканировали сайт. Для поиска битых ссылок необходимо справа найти вкладку «Response Code» — «Client Error (4xx)». Теперь мы видим список битых ссылок при их наличии на сайте.

Как определить на каких страницах находятся битые ссылки?

Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылка или список ссылок.

Такие ссылки рекомендуется убирать, так как большое количество битых ссылок может негативно сказаться на ранжировании сайта.

Как найти битые ссылки на странице сайта?

Если при осмотре страницы битая ссылка не бросается в глаза, необходимо открыть код сайта «ctrl + shift + i», далее открыть форму поиска в коде «ctrl + а» и вбить адрес битой ссылки.

Битые ссылки могут быть размещены в текстах страниц. В таком случае необходимо убирать ссылки вручную. В некоторых случаях ссылка может быть размещена сразу на нескольких страницах. Это говорит о том, что ссылка размещена в меню, в футере или в каком-либо другом сквозном блоке. В таком случае не нужно заходить на каждую страницу отдельно, а можно просто удалить или заменить ссылку.

Почему битые ссылки – это плохо?

Битые ссылки не оказывают прямого влияния на ранжирование сайта, и каких-либо санкций за битые ссылки со стороны поисковых систем нет. Однако они могут потратить часть краулингового бюджета поисковых роботов, понизить показатель качества сайта, увеличить количество отказов. Кроме того, битые ссылки не передают вес другим страницам, а если на неё стоят ссылки с внешних ресурсов, вес такой ссылки не учитывается. Поэтому битые ссылки необходимо удалять с сайта либо заменять их на действующие.

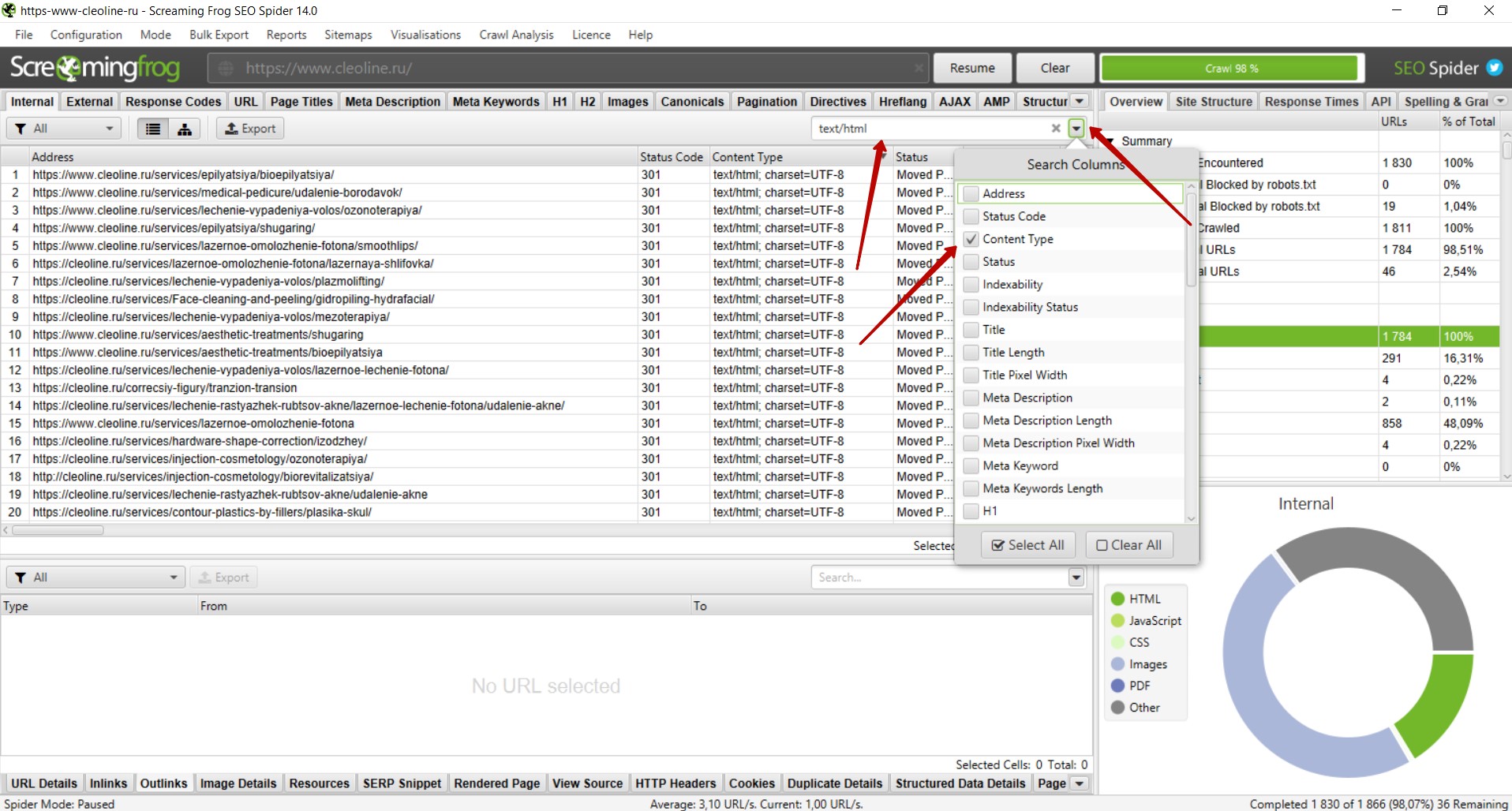

Поиск ссылок с 301 редиректом

301 редирект – перенаправление со старого адреса на новый, если изменился адрес страницы, а контент не менялся. Это делается как раз для того, чтобы не появлялись битые ссылки. Но лучше сразу ставить ссылку с 200 кодом ответа на существующую страницу. Если нет возможности менять ссылки, тогда настраивают 301 редирект. Обычно мы от таких ссылок избавляемся.

Поиск ссылок с 301 редиректом производится аналогичным поиску битых ссылок образом. Необходимо справа найти вкладку «Response Code» — «Redirection (3xx)». Теперь мы видим список ссылок с 301 редиректом и другими редиректами с 3xx кодом при их наличии на сайте.

Как определить на каких страницах находятся ссылки с 301 редиректом?

Поиск таких ссылок осуществляется так же, как и поиск битых ссылок. Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылки или список ссылок, как и в случае с битыми ссылками.

Рядом присутствует вкладка Outlinks, где указаны страницы, куда приходит редирект.

Почему желательно избавляться от таких ссылок?

Небольшое количество таких ссылок никак не отразится на ранжировании сайта. Однако, если ссылок с редиректами много или такие ссылки размещены на всех страницах в меню, футере или других сквозных блоках, рекомендуется заменить данные ссылки на существующие страницы, на которые настроен редирект. Такие ссылки не несут в себе информацию о том, почему происходит перенаправление на другой адрес, что усложняет поисковым системам обработку данного редиректа.

Поиск дублей страниц

Наличие дублей страниц негативно сказывается на ранжировании сайта, так как из двух страниц поисковые системы вероятнее всего будут индексировать только одну наиболее релевантную, на их взгляд, страницу. Дублями страниц могут восприниматься страницы с разным контентом, но одинаковыми тегами title. Бывает, что у страниц услуг и статей идентичные теги title, и такие страницы признаются дублями. При этом интент запросов совсем разный: у первой – информационный, у второй – коммерческий. Для избежания возникновения дублей следует в первую очередь проверять сайт на наличие дубликатов title и при наличии дублей корректировать мета-теги.

Как искать дубликаты title?

Выбираем справа вкладку «Page Titles» — «Duplicate» и получаем список страниц на которых дублируются мета-теги.

В случае, когда на страницах разный контент и одинаковые теги title, необходимо скорректировать мета-теги.

Если страницы идентичны и по тегами, и по контенту, следует удалить одну страницу и настроить 301 редирект с адреса удаленной страницы на существующую страницу. Это поможет, если ссылки на удаленные страницы размещены на других сайтах или находится в индексе. 301 редирект здесь нужен, чтобы пользователи попадали не на удаленную, а на нужную страницу.

Но на самом сайте такие ссылки нужно удалить. Поэтому рекомендуем сразу проверить, есть ли на сайте ссылки на удаленную страницу (см. инструкции выше) и заменить их на существующую страницу.

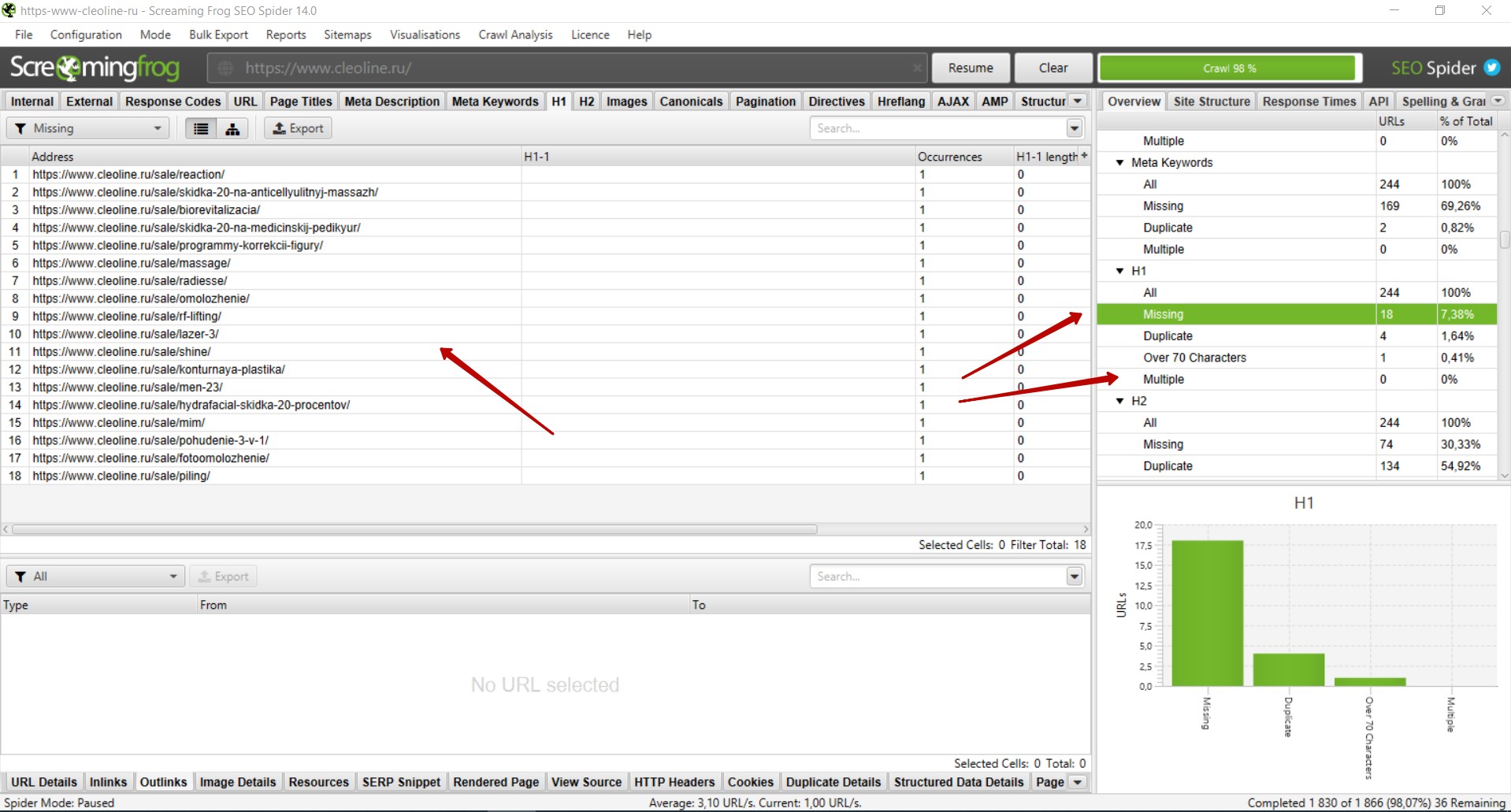

Анализ заголовков h1

На каждой странице должен присутствовать основной заголовок в тегах <h1>, который максимально подробно и при этом кратко отражает содержание страницы. Это позволяет поисковым система более точно определить, что за информация размещена на странице. При проведении SEO-аудита необходимо проверить наличие основного заголовка на всех страницах сайта. Кроме того, тегами <h1> должен быть размечен только один основной заголовок.

Как найти страницы, где отсутствует основной заголовок h1?

Необходимо справа выбрать вкладку «H1» — «Missing>. Вы увидите список страниц, где отсутствует заголовок h1. Следует добавить данный заголовок на все страницы сайта.

В том же блоке справа во вкладке «Multiple» будут страницы, где присутствует несколько заголовков h1. В таком случае необходимо удалить второй заголовок, если он дублирует первый либо в нём нет необходимости, или разметить заголовок тегами <h2> — <h6> в соответствии с его иерархией.

Рекомендуем также проверить вкладку «Duplicate» на наличие дублей заголовков h1. В целом, дубли h1 не являются проблемой. Однако при наличии большого количества дублей рекомендуем корректировать заголовки, в особенности на страницах товаров / услуг / статей и в случаях, когда на сайте настроена автоматическая генерация мета-тегов.

Проверка наличия и корректности Canonical

Для избежания возникновения дублей страниц рекомендуется на всех страницах размещать атрибут Canonical с указанием канонической (основной) страницы. Атрибут rel=canonical тега <link> указывает поисковым системам, что некоторые страницы могут быть одинаковыми, несмотря на разные URL-адреса (например, страницы пагинации).

Наличие данного атрибута не является фактором ранжирования, но в некоторых случаях может положительно сказаться на индексации сайта и избежать возникновения дублей страниц, например когда в URL добавляются GET-параметры (рекламные метки, сортировка и т.п.).

Для того, чтобы проверить на каких страницах размещен данный атрибут и корректно ли указаны ссылки, необходимо справа выбрать вкладку «Canonicals» — «All». Во вкладке «Missing» можно посмотреть список страниц, где данный атрибут отсутствует.

Поиск пустых или малоинформативных страниц

Наличие пустых или малоинформативных страниц может негативно сказаться на ранжировании сайта. Чаще всего такие страницы исключаются из индекса поисковых систем. Такие страницы рекомендуется удалять или дорабатывать таким образом, чтобы страница полностью отвечала на вопросы пользователя.

Для поиска пустых или малоинформативных страниц необходимо справа выбрать вкладку «Crawl Dara» — «Internal» — «All».

Через форму поиска следует отфильтровать страницы с контентом.

Далее необходимо в поле со списком страниц найти столбец «Word Count», отсортировать список страниц по убыванию количества слов и уже вручную проверить страницы с низким количеством слов в тексте страниц.

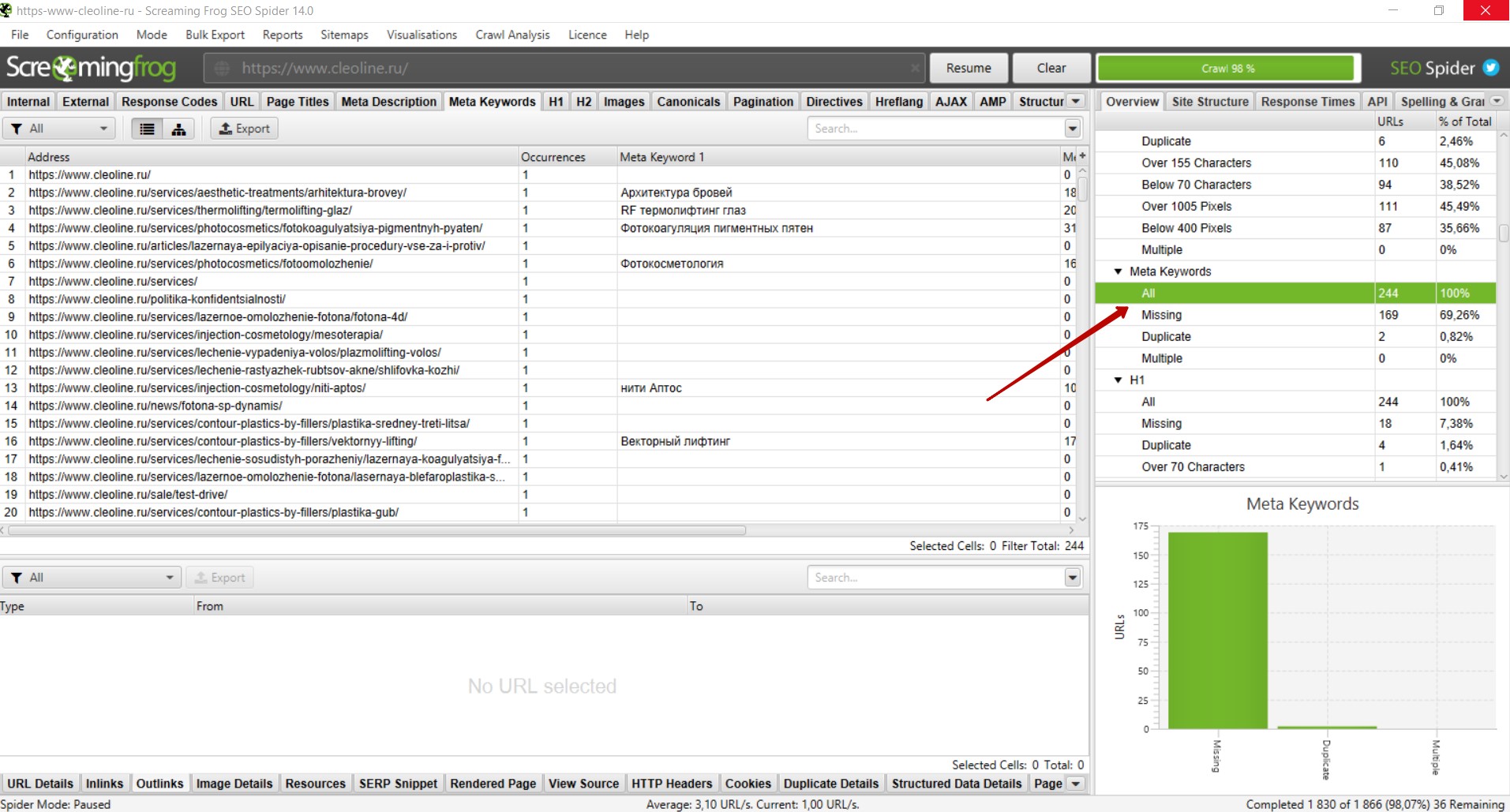

Спамный тег Keywords

Тег Keywords давно не учитывается поисковыми системами как фактор ранжирования и не оказывает положительного влияния. Однако при наличии на сайте спамных текстов и мета-тегов данный тег может стать одним из сигналов, что страница продвигается неестественными способами.

Для избежания таких ситуаций, мы рекомендуем удалять теги Keywords со всех страниц сайта.

Чтобы найти страницы, где размещен данный тег, необходимо справа выбрать вкладку «Meta Keywords» — «Missing», и вы увидите список страниц, где присутствует данный тег.

Анализ изображений

Изображения на сайте очень важны для продвижения и правильная оптимизация изображений может положительно сказаться на ранжировании сайтов и принести дополнительный трафик, например с поиска по картинкам.

Чтобы приступить к анализу изображений, следует перейти справа во вкладку «Crawl Data» — «Internal» — «Images». Вы увидите список ссылок на изображения. Необходимо проверить код ответа сервера в столбце «Status Code» — все ссылки должны отдавать 200 код ответа. Битые изображения следует удалить либо заменить на существующие. Если закрыты служебные папки, изображения рекомендуем открывать в файле robots.txt , чтобы они индексировались поисковыми системами.

Следует также проверить вес изображений в столбце «Size». Изображения с весом более 3 мб рекомендуем сжимать, чтобы они не замедляли скорость загрузки страниц.

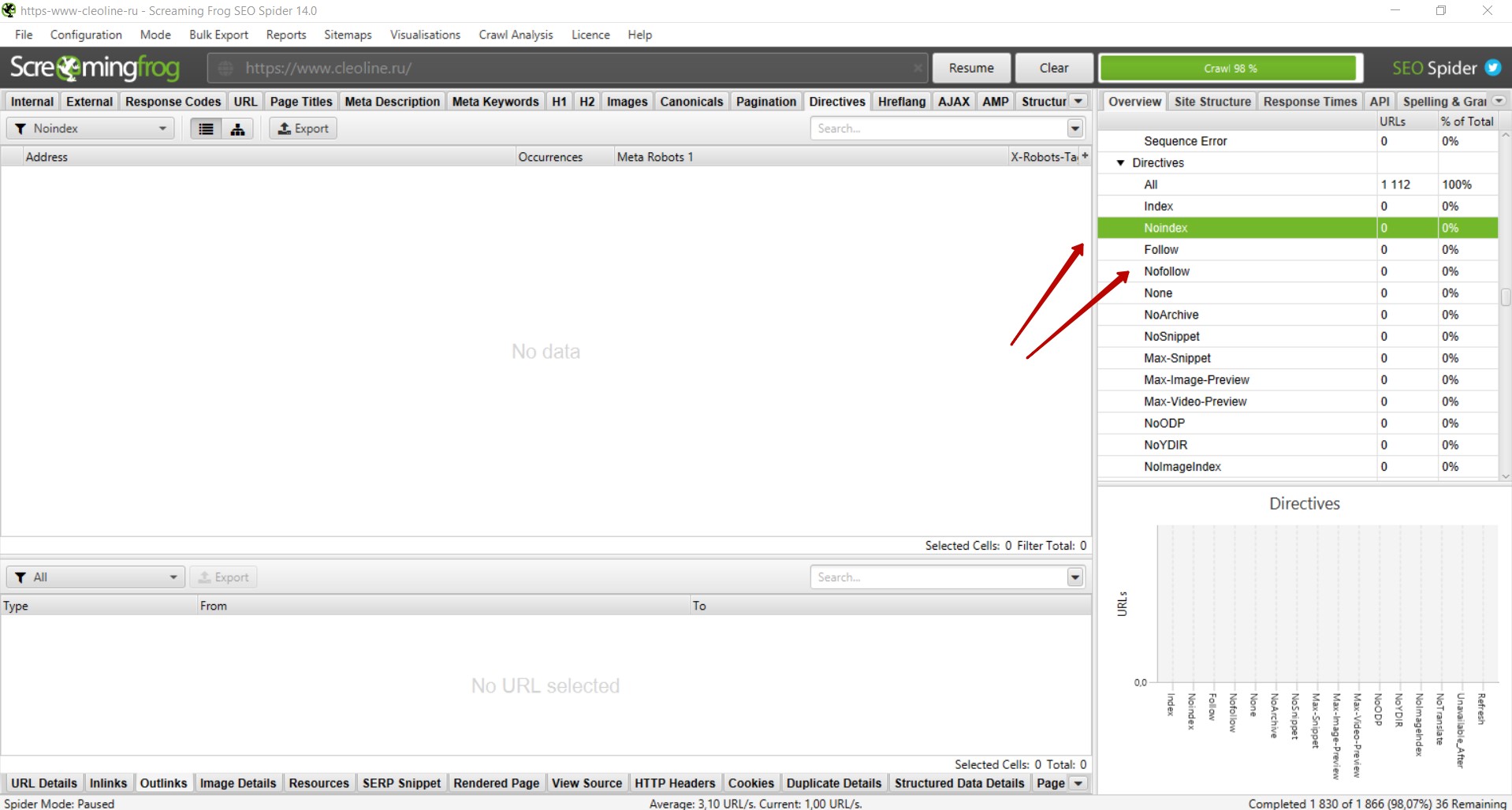

Анализ тегов Noindex и Nofollow

На некоторых страницах могут быть размещены теги «noindex», «nofollow». Чаще всего с помощью таких тегов намеренно закрывают страницы, которые не должны индексироваться. Однако некоторые теги могут быть размещены на страницах сайта ошибочно, в результате чего нужные страницы не попадут в индекс и не будут приносить трафик.

Поэтому рекомендуем проверять наличие данных тегов на страницах сайта. Для этого необходимо справа выбрать вкладку «Directives» — «noindex» и «nofollow» и проверить, не размещены ли данные теги на нужных для продвижения страницах. При наличии таких тегов на важных страницах рекомендуем убрать их из кода, чтобы страницы индексировались поисковыми системами.

Извлечение элементов со страниц сайта

Иногда возникает потребность извлечь какой либо элемент со страниц сайта. Например, подзаголовки, цены, названия каких-то определенных блоков и т.д.

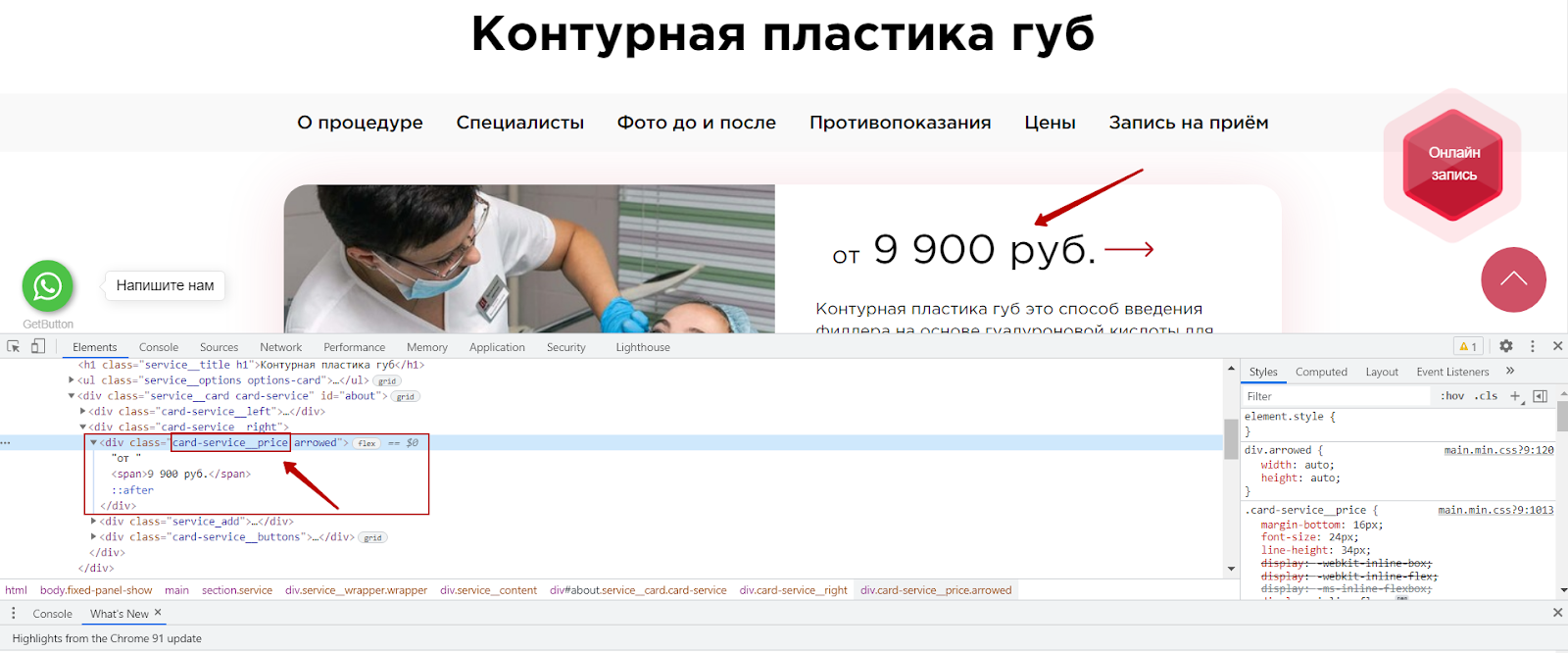

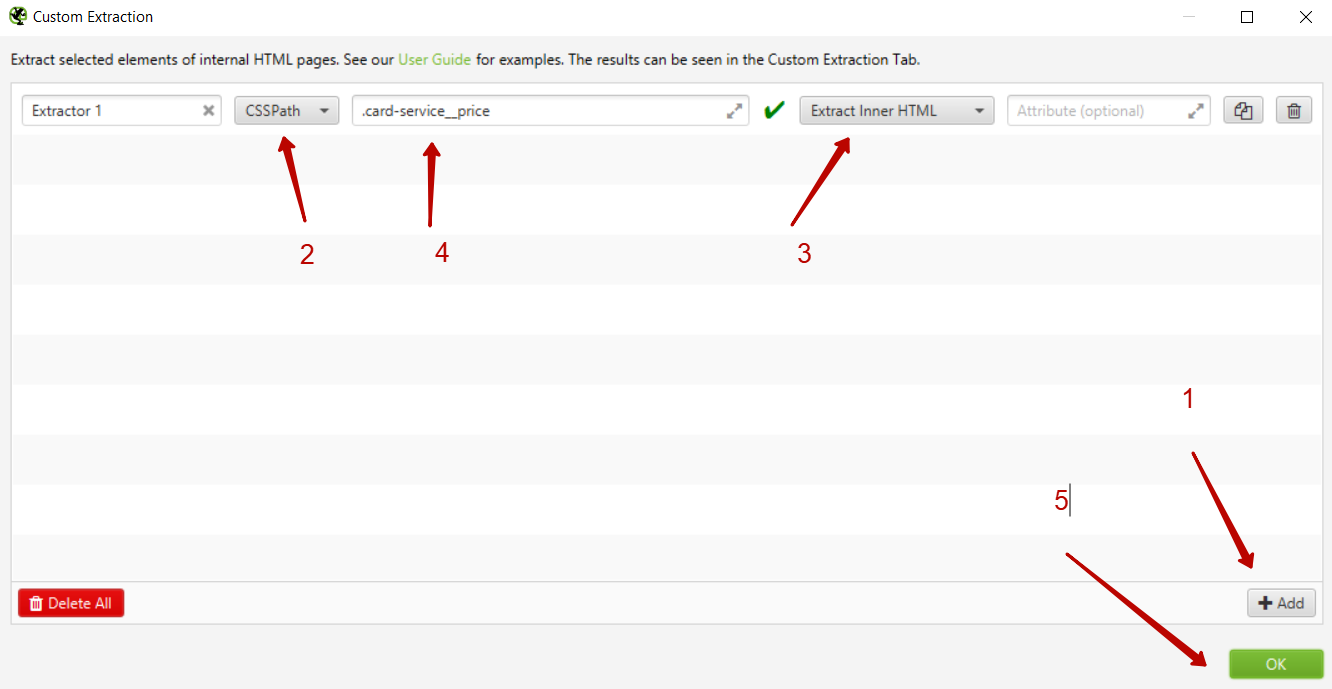

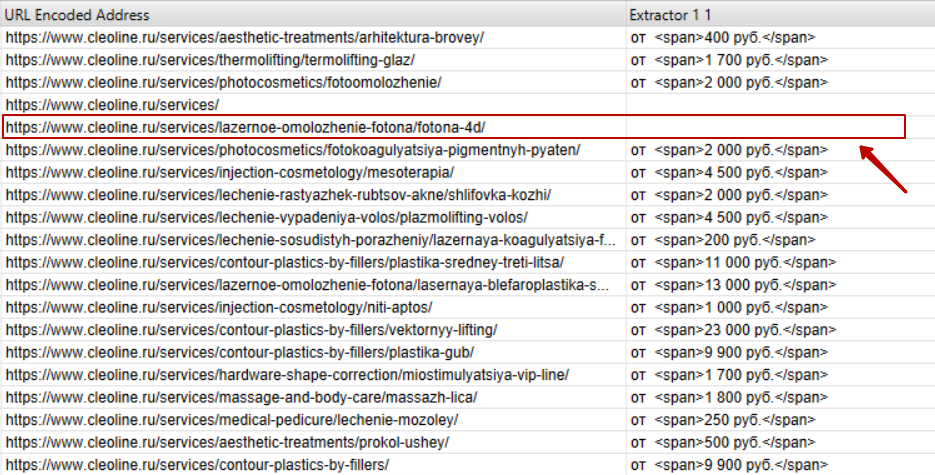

В случае с нашим клиентом мы обнаружили, что на некоторых страницах отсутствуют цены. Наличие цены на коммерческих страницах является одним из факторов ранжирования, в связи с чем мы подготовили рекомендацию о необходимости разместить цену на всех страницах сайта. Чтобы подготовить список страниц, где отсутствует цена, мы воспользовались функцией Custom Extraction.

Как это сделать?

Для начала необходимо определить, где находится нужный элемент на странице сайта, и скопировать стиль данного элемента.

В интерфейсе Screaming Frog необходимо выбрать вкладку Configuration — Custom — Extraction.

Далее необходимо добавить новый элемент, нажав на кнопку add, и выбрать способ извлечения — CSSPath и что извлекаем — Extract Inner HTML. Далее указываем CSS стиль элемента, который ранее мы скопировали из кода сайта и ставим перед названием стиля точку.

После этого запускаем парсинг.

Нас интересуют только страницы услуг, поэтому необходимо отфильтровать только страницы раздела /services/, где размещены ссылки на страницы услуг. И мы получаем список извлеченных страниц и элементов и можем найти страницы, где отсутствует цена.

Функционал Custom Extraction довольно сложен, мы привели лишь небольшой пример, как с его помощью можно извлечь элементы страницы. Если вам будет интересно, мы можем рассказать о возможностях этой функции более подробно в следующей статье.

Выводы

Мы рассмотрели основные моменты, которые необходимо всегда проверять при проведении технического SEO-аудита в программе Screaming Frog. Многие технические проблемы / недочеты могут не оказывать прямого влияния на ранжирование сайта, однако в совокупности большое количество технических ошибок может значительно затруднить поисковое продвижение.

Обращаем внимание, что технический анализ должен проводиться не только через Screaming Frog, но и с помощью других инструментов, например Яндекс.Вебмастер и Google Search Console.

Мы рекомендуем не останавливаться на одной технической проверке и проводить такой анализ раз в 1-3 месяца, в зависимости от обновления страниц сайта.

Стоит учитывать, что устранение технических недочетов не гарантирует улучшение позиций и рост поискового трафика. Для увеличения видимости сайта в поисковых системах необходима комплексная доработка технической составляющей сайта, коммерческих факторов, работа с текстами и мета-тегами, структурой сайта, ссылочным окружением и другими факторами.

Если у вас остались какие-либо вопросы, — готовы ответить на них в комментариях.

А если вопросов будет много, подробнее раскроем их уже в следующих статьях.