В прошлом месяце агентство Incapusla Security представило отчет о состоянии гуглботов и их вредоносных близнецов. И надо сказать, для тех, чей бизнес зависит от статистики сайта, новости не очень хорошие.

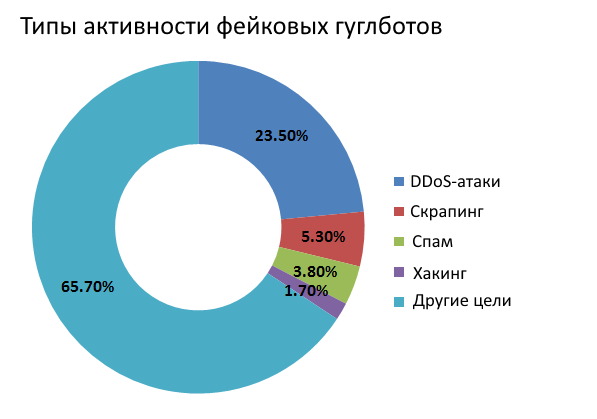

Из 24 посещений сайта гуглботами одно обязательно совершает фейк. При этом более 34% фейковых гуглботов используются для DDoS-атак, взломов, спама и других вредоносных действий.

Методология

Эксперты Incapusla проанализировали:

«… более 400 млн посещений роботами поисковых систем 10 тысяч сайтов, в результате которых было проиндексировано 2,19 млрд страниц в течение 30 дней.

Информация о гуглботах-самозванцах (фейковых гуглботах) получена вследствие проверки более 50 млн посещений гуглботов-самозванцев, а также из отчета DDoS Threat Landscape, опубликованного ранее в этом году».

Выводы Incapusla

Когда Incapusla обратили внимание на стандартного гуглбота, то заметили некоторые интересные моменты.

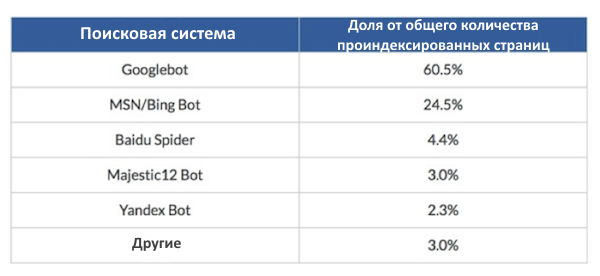

Для начала следует отметить, что гуглботы сканируют больше страниц, чем роботы всех других поисковых систем вместе взятые, — 60,5%.

То, что Incapusla обнаружили при анализе этих посещений, также было немного неожиданно:

- Yahoo выбыл из топ 5 поисковых роботов.

- Majestic 12 Bot, или бот WebCrawler Majestic SEO, занял четвертое место.

- Google не оказывает никому покровительства.

- Нет практически никакой разницы между размером площадки и:

- Частотой индексации,

- Показателем индексации,

- Глубиной индексации,

- SEO-продуктивностью.

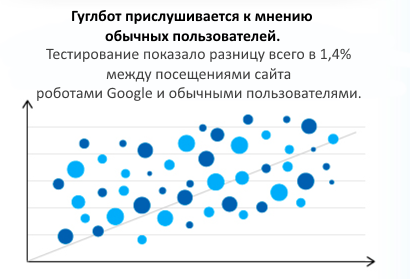

Известно, что Google — крупнейший генератор посещений ботов и что эти посещения инициируются чем-то иным, нежели активностью сайта или SEO, и что он прислушивается к мнению пользователей.

В целом, довольно неплохо. Но беспокойство вызывает не Google, а его «злые» близнецы, с которыми следует быть осторожнее (их очень много — и некоторые их них отлично сделаны).

Юзер-агенты

Чтобы узнать, какие боты посещают наш сайт необходимо посмотреть сведения о них в лог файлах . Когда мы видим соответствующий юзер-агентагент пользователя, мы знаем, из какой поисковой системы, с какого компьютера или браузера произошло посещение. Например, юзер-агент может выглядеть следующим образом:

Mozilla/5.0 (Macintosh; Intel Mac OS X 10.9; rv:30.0) Gecko/20100101 Firefox/30.0

Эта информация говорит, что кто-то использует Mozilla/Firefox 30 на MacIntoch с операционной системой Mavericks. Она также может рассказать о пауках, программах и ботах, то есть о тех, кто «бегает» по нашим сайтам.

Имитация Google — жизнь бота

В ходе исследования Incapusla обнаружили, что «более 4% ботов, представляющихся гуглботом, на самом деле им не являются». И здесь победителем становится Бразилия с долей фейковых гуглботов почти 14%.

Плохие боты

Зачем кому-то создавать фейковых гуглботов?

Это что-то вроде того, как иметь поддельные документы в 18 лет. Иногда вы просто хотите потусоваться, но чаще они нужны вам, потому что вы делаете что-то такое, о чем лучше не знать вашей маме.

Не все боты плохие

Примите во внимание, что не все боты плохие и созданы со злым умыслом. Иногда фейковых гуглботов используют только для того, что посмотреть на ваш сайт глазами Google.

Поэтому прежде чем блокировать бота, обратите внимание на его поведение. Может, он всего лишь просматривает сайт? Заходит ли он снова и снова, имеют ли его перемещения случайный характер?

И только после того как вы определите, что это плохой бот, можно закрыть ему доступ. Будьте осторожны, так как вы можете заблокировать доступ и для роботов Google.

Как узнать, что посещения фейковые?

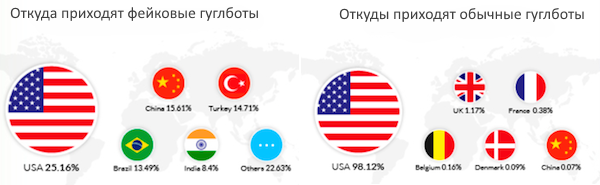

Одним из ключевых показателей, указывающих на то, что есть проблемы с фейковыми гуглботами, является страна происхождения бота.

На американские сайты чаще всего заходят боты из 6 стран, показанных на картинке справа. А вот боты, чья родина указана на изображении слева, должны заставить владельца ресурса насторожиться. Однако если вы работаете со странами из списка слева, то нет ничего странного в том, что ваш сайт будут посещать их гуглботы.

Если вы увидели что-то подозрительное, то не забудьте просмотреть логи сервера и юзер-агенты и проверить, совершаются ли на вас атаки. Если это так, и у вас нет доступа к серверам, свяжитесь с компанией, которая может заблокировать их за вас.

Определить плохого бота не слишком трудно

Хорошей новостью является то, что идентифицировать плохого бота не так уж сложно. И как только это будет сделано, вы можете заблокировать его и больше не пускать на свой сайт. Но это в том случае, если у вас есть такие возможности, права и доступы. У большинства владельцев сайтов всего этого нет, и им приходится полагаться на свою хостинговую компанию, поэтому очень важно выбрать надежного и осведомленного подрядчика.

Если у вас есть доступы, вы можете предпринять необходимые меры, чтобы убедиться, что боты действительно осуществляют какую-то деструктивную деятельность, а затем заблокировать их.

Как определить плохого бота?

Иногда выявить плохих ботов может быть достаточно проблематично: некоторые из них очень сложно устроены, особенно, те, которые имитируют Google. Вот некоторые шаги, которые помогут определить фейковых ботов.

Incapusla исходя из собственного опыта сформулировала 4 шага для выявления фейковых ботов:

Шаг 1. Посмотрите на данные в заголовке

Даже если боты использовали юзер-агент Google, остальные данные заголовка будут совсем «не как у Google». Этого достаточно, чтобы забить тревогу, но не торопитесь блокировать его, потому что зарегистрированы случаи, когда Google отклоняется от обычной структуры заголовка.

Шаг 2. Проверка IP и ASN

Далее проведите проверку IP и ASN. Здесь стоит обратить внимание на несколько моментов, в том числе на личности владельцев IP-адресов и ASN, которые производят подозрительный трафик.

В случае с фейковыми гуглботами ни IP, ни ASN не будут связаны с Google. Таким образом, с помощью параллельной проверки этой информации и сомнительных заголовков можно с высокой степенью уверенности сказать, что мы имеем дело с потенциально опасными двойниками.

Шаг 3. Контроль действий

Тем не менее «потенциально опасный» это не всегда «злой». Например, некоторые SEO-инструменты пытаются выдать себя за гуглботов, чтобы получить «гуглоподобное» видение контента сайта и ссылочного профиля.

Именно поэтому следующий пункт поиска — поведение посетителей. Оно поможет нам понять их намерения, ключ к которым часто лежит в самом запросе, так как они представлены в WAF (Web Application Firewall). В этом случае самого показателя посещений достаточно, чтобы завершить картину, сразу определив DDoS-атаки и повысив автоматизированную защиту от них.

Шаг 4. Репутация IP и новая низкоуровневая подпись

Хотя Incapusla регулярно сталкивается с гуглботами, вариант подписи, появившийся во время последней атаки, отраженной системой, не был частью существующей базы данных. После смягчения атаки собранные данные использовались, чтобы создать новую запись низкого уровня, которая затем будет добавлена к десятимиллионному пулу записей и разведена через сеть, чтобы защитить всех клиентов Incapusla.

В результате при следующем посещении этими ботами сайта они будут немедленно заблокированы. Более этого, репутация атакующих IP также будет записана и добавлена в другую базу данных, где хранятся потенциально опасные адреса.

Проще говоря, вы должны знать, что юзер-агенты могут быть фейками, IP-адреса могут быть подделаны, а заголовки реконструированы и т.д. И для обеспечения безопасности, нужно раскрыть «истинное лицо» и намерения посетителей.

Итоги

Следите за своим органическим трафиком, особенно за страной его происхождения. А когда кто-то или что-то путешествует по вашему сайту, узнайте, каковы его намерения, и не держите в страхе «хороших ребят».

Недавно для обеспечения удобства пользователей Google Analytics запустил фильтр ботов и пауков. Подробнее об этом можно прочитать здесь.

Приложения – это специальные аккаунты, которым вы можете отправлять сообщения и которые позволяют подключаться к сервисам в Google Chat, чтобы вы могли:

- получать информацию;

- планировать встречи;

- выполнять задачи.

Важно! Использовать приложения в Google Chat можно только в рабочих и учебных аккаунтах.

Пользователь с личным аккаунтом:

- может видеть в интерфейсе возможность добавить приложения, но не может их добавлять;

- может быть приглашен в чат-группу пользователем с рабочим или учебным аккаунтом, после чего сможет просматривать приложения в этой чат-группе.

О приложениях в Google Chat

Приложение, с которым вы взаимодействуете в Google Chat, имеет доступ к следующим сведениям о вас:

- адрес электронной почты;

- аватар;

- основная информация (например, ваше имя).

Приложению доступны основные сведения других участников чата, но адрес электронной почты и аватар – только в том случае, если участник напрямую взаимодействует с приложением.

Некоторые приложения, например Meet и Google Диск, созданы и обслуживаются Google.

За создание и работу других приложений отвечают сторонние разработчики. Если вы используете приложение стороннего разработчика, изучите его условия предоставления услуг и политику конфиденциальности, чтобы знать, как используются ваши данные.

Совет

- Узнайте, как создавать приложения для вашей организации.

- Чтобы получить рекомендации по созданию приложений для вашей организации, обратитесь к администратору Google Workspace.

Как найти и добавить приложение

Если приложение доступно в вашей организации, вы можете:

- вести с приложением прямую переписку;

- добавлять его в чаты и чат-группы.

Как добавить приложение в чат или чат-группу

Важно! Если вы используете рабочий или учебный аккаунт, администратор может устанавливать приложения от вашего имени, и в таком случае они смогут отправлять вам сообщения. Удалить такие приложения нельзя, но можно выключить уведомления для переписки.

Как удалить приложение из чата или чат-группы

- Откройте приложение Chat

или Gmail

.

- Выберите чат или чат-группу.

- В верхней части экрана нажмите на название чат-группы или на список участников чата

Управление приложениями

Ещё

.

- Чтобы удалить приложение из чата, нажмите Удалить из чата.

- Чтобы удалить приложение из чат-группы, нажмите Удалить из чат-группы.

Как использовать слеш-команды в сообщениях

Для быстрого взаимодействия с приложениями в Google Chat используйте слеш-команды. Это удобный и эффективный инструмент. Помнить команды не обязательно – если ввести косую черту (/), появится их список.

Введенные вами слеш-команды видны только вам. Ответы приложений видны всем участникам чата.

Как получить справку или оставить отзыв с помощью приложения в Chat и Gmail

Вы можете отправить в приложение сообщение, чтобы получить справочную информацию или оставить отзыв.

Эта информация оказалась полезной?

Как можно улучшить эту статью?

Пытаетесь преодолеть очередную планку роста органического трафика? Высококачественный контент и ссылки безусловно помогут вам в этом, но не стоит забывать о техническом SEO. Один из наиболее важных навыков в технической оптимизации сайтов, который вы можете приобрести в 2019-м – научиться думать, как Googlebot.

Прежде чем приступить к содержательной части, необходимо понять, что вообще из себя представляет этот Гугл-бот, как он работает и для чего нам всё это знать.

Googlebot – это веб-краулер (робот, паук), который собирает данные с веб-страниц. Всего лишь один из многих. У каждой поисковой системы есть свои фирменные пауки. В мире SEO их ещё называют «агентами пользователя». Вот наиболее известные:

- Yandex – Яндекс

- Googlebot – Google

- Bingbot – Bing

- Slurp Bot – Yahoo

- Alexa Crawler – Amazon Alexa

- DuckDuckBot – DuckDuckGo

Как работает Googlebot

Мы не можем начать оптимизировать сайты под Googlebot, пока не поймём, как он обнаруживает, читает и оценивает веб-страницы.

Как робот Google находит веб-страницы

Краткий ответ: ссылки, карты сайтов и запросы на обход.

Длинный ответ: самый быстрый способ заставить Google просканировать ваш сайт, это зайти в Search Console и добавить ссылку на карту вашего сайта. Однако это ещё не всё.

Несмотря на то, что карты сайта являются отличным способом заставить Google сканировать ваш сайт, этот метод не учитывает PageRank. Внутренние ссылки — это рекомендуемый способ сообщить Google, какие страницы связаны и имеют ценность. В Интернете опубликовано много замечательных статей о Google PageRank и внутренних ссылках, поэтому я не буду сейчас вдаваться в подробности.

Google также может обнаружить ваши веб-страницы, благодаря профилю «Google Мой бизнес», каталогам и ссылкам с других сайтов. Это упрощённая версия того, как работает робот Google. Чтобы узнать больше, вы можете прочитать официальную документацию Google по их пауку.

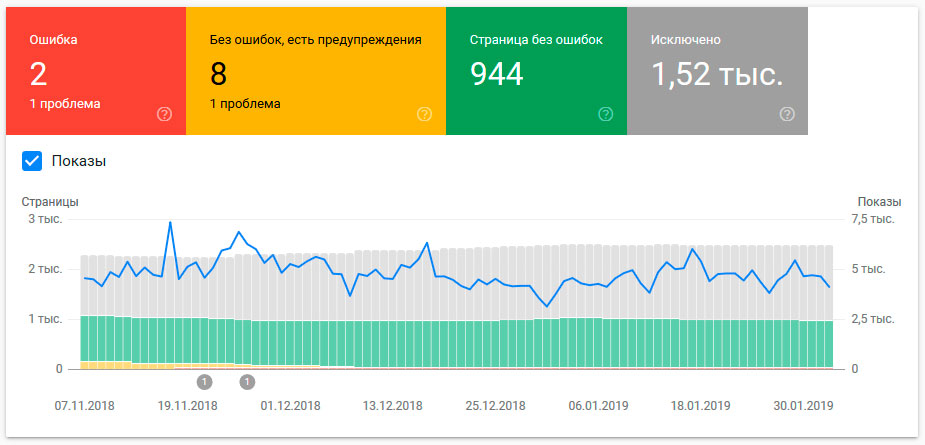

Как робот Google читает веб-страницы

Google прошёл долгий путь в рендеринге сайтов. Основная задача бота Гугла – прочитать страницу сайта так, как это сделал бы обычный пользователь. Чтобы проверить, как Google просматривает вашу страницу, воспользуйтесь инструментом проверки URL в Search Console. Так вы сможете сравнить страницу глазами посетителя и Googlebot.

Технические факторы ранжирования

Как и в традиционном SEO, в техническом SEO нет волшебной таблетки. Все 200+ факторов ранжирования важны!

Если вы являетесь техническим специалистом, думающим о будущем SEO, то самые значимые факторы ранжирования, на которые стоит обратить внимание, сосредоточены вокруг пользовательского опыта.

Зачем нам думать, как Googlebot

Когда представители поисковых систем говорят нам делать качественные сайты, они как раз вот это и имеют в виду. Все эти размытые формулировки являются в то же время очень точными.

Если вы можете удовлетворить пользователей интуитивным и полезным веб-сайтом, соответствующим требованиям Googlebot, то в итоге получите больше органического трафика.

Пользователи или роботы

На кого больше обращать внимание при создании сайта? На пользователей или на роботов?

Краткий ответ: на тех и на других.

Длинный ответ: это острый вопрос, который может вызвать напряжённость между дизайнерами интерфейсов, веб-разработчиками и SEO-специалистами. Тем не менее это даёт нам возможность поработать вместе и лучше понять баланс между поведением пользователей и ботов.

UX-дизайнеры отдают предпочтение в работе пользователям. SEO-специалисты – краулерам. Посередине находятся веб-разработчики, пытающиеся взять лучшее из обоих миров.

Опытный сеошник должен понимать важность пользовательского опыта. Поэтому необходимо оптимизировать сайты и под людей, и под роботов, одновременно. К счастью, Google изо всех сил старается ориентироваться на живых посетителей сайтов.

Следующие 10 советов по оптимизации под Гугл-бота позволят вам ублажить сразу обоих: дизайнера и разработчика.

1. Robots.txt

Robots.txt — это текстовый файл, который находится в корневом каталоге веб-сайта. Это одна из первых вещей, которую ищет робот Googlebot при сканировании сайта. Настоятельно рекомендуется добавить robots.txt на ваш сайт и включить в него ссылку на sitemap.xml.

Есть много способов оптимизировать файл robots.txt, но важно соблюдать осторожность. Разработчик может закрыть индексацию для всех роботов во время технических правок и забыть открыть её при внедрении на действующий сайт. В результате даже после устранения проблемы могут потребоваться недели на возврат органического трафика.

Существует множество советов и руководств по оптимизации файла robots.txt. Тщательно разберитесь в вопросе, прежде чем что-то внедрять на свой сайт. И не забывайте отслеживать результаты правок.

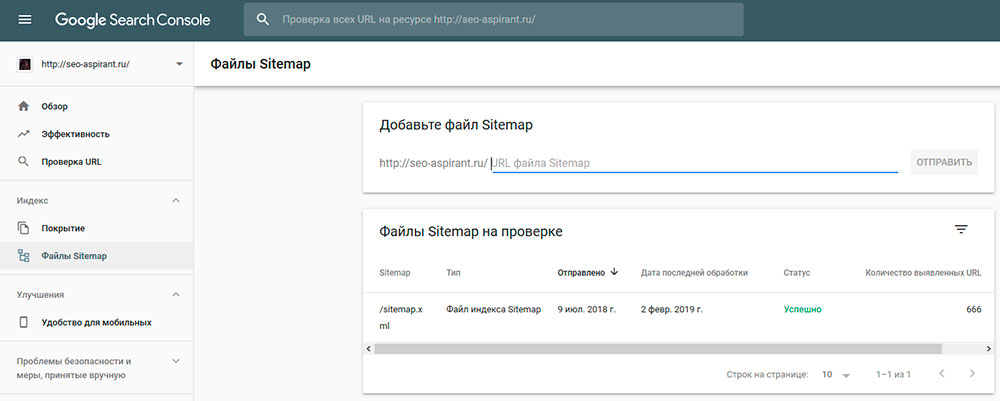

2. Sitemap.xml

Карты сайтов являются ключевым способом обнаружения новых страниц на ваших проектах ботом Гугла и считаются важным фактором ранжирования.

Вот несколько советов по оптимизации карты сайта:

- У вашего сайта должна быть только одна карта.

- Страницы блога и основные страницы сайта должны быть разделены на разные файлы, а затем объединены в общую карту.

- Не устанавливайте высокий приоритет для каждой отдельно взятой страницы.

- Удалите из карты сайта страницу для 404-ошибки и 301 редиректы.

- Отправьте файл sitemap.xml в Google Search Console и следите за обходом.

3. Скорость сайта

Быстрота загрузки стала одним из важнейших факторов ранжирования, особенно для мобильных устройств. Если скорость загрузки вашего сайта слишком низкая, робот Google может понизить ваш рейтинг.

Самый простой способ выяснить, считает ли робот Google, что ваш сайт загружается слишком медленно, — это проверить скорость с помощью любого из бесплатных инструментов. Многие из этих инструментов предоставляют рекомендации, которые вы можете отправить вашим разработчикам.

4. Микроразметка Schema

Добавление структурированных данных на ваш сайт поможет роботу Google лучше понять контекст отдельных веб-страниц и веб-сайта в целом. Однако важно, чтобы вы следовали рекомендациям Google.

Для наибольшей эффективности лучше использовать JSON-LD при реализации разметки структурированных данных. Сам Google отметил у себя в рекомендациях, что JSON-LD является предпочтительным языком разметки.

5. Канонизация

Большой проблемой для крупных сайтов, особенно в секторе электронной коммерции, является дублированный контент. Есть множество практических причин для дублирования контента, например, мультиязычность сайта.

Если вы используете сайт с дублированным контентом, крайне важно указывать основные страницы при помощи тега rel=canonical и атрибута hreflang.

6. Таксономия URL

Наличие чёткой и понятной структуры URL, как показывает практика, приводит к более высоким позициям в поисковой выдаче и помогает пользователям лучше ориентироваться на сайте. Настройка родительских страниц позволяет роботу Google понимать взаимосвязь каждой страницы.

Однако, если у вас есть старые страницы, которые имеют хорошие позиции, Джон Мюллер из Google не рекомендует менять их URL. Грамотная таксономия URL-адресов — это то, что нужно установить с самого начала разработки сайта.

Если вы абсолютно уверены, что оптимизация URL-адресов поможет сайту, убедитесь, что настроили правильные 301-редиректы и обновили свой sitemap.xml.

7. Загрузка JavaScript

Несмотря на то, что со статичными HTML-страницами проще работать в плане SEO, динамический контент, созданный с помощью JavaScript, позволяет сделать ваш веб-сайт интереснее для пользователей. В 2018 году Google потратил много ресурсов на улучшения взаимодействия с JavaScript.

Во время недавней сессии вопросов и ответов с Джоном Мюллером, последний заявил, что Google планирует продолжить фокусироваться на JavaScript в 2019 году. Если ваш сайт сильно зависит от динамического рендеринга с помощью JavaScript, убедитесь, что ваши разработчики следуют официальным рекомендациям Google.

8. Изображения

Google давно намекает на важность оптимизации изображений, но в последние месяцы особенно много говорит об этом. Оптимизация изображений поможет роботу Google контекстуализировать, как ваши картинки связаны и улучшить ваш контент.

Если вы хотите быстро оптимизировать изображения, я рекомендую:

- Имя файла изображения: опишите, что это за изображение, используя как можно меньше слов.

- ALT-текст: можно скопировать имя файла и использовать дополнительные слова для описания изображения.

- Структурированные данные: вы можете добавить schema-разметку для описания изображений на странице.

- Карта картинок сайта: Google рекомендует добавить отдельную карту для ваших изображений.

9. Неработающие ссылки и зацикленные редиректы

Все мы знаем, что битые ссылки — это плохо, некоторые оптимизаторы утверждают, что они могут потратить впустую бюджет на обход сайта. Однако Джон Мюллер заявил, что неработающие ссылки не уменьшают этот бюджет.

Я полагаю, что, учитывая неоднозначность имеющейся информации, мы должны быть осторожны и убирать все неработающие ссылки. Используйте Google Search Console или ваш любимый инструмент для сканирования, чтобы найти неработающие ссылки на сайте!

Зацикленные редиректы – ещё одна характерная черта старых проектов. Такое явление обычно возникает, когда в цепочке редиректов присутствует несколько этапов.

Пример выше: третий вариант первоначальной страницы перенаправляет пользователя на второй вариант, который, в свою очередь, перенаправляет опять на третий вариант. Получается замкнутый цикл.

Поисковые системы часто испытывают трудности при сканировании циклов перенаправления и потенциально могут завершить обход сайта. Лучшее решение здесь — заменить исходную ссылку на каждой странице финальной ссылкой.

10. Заголовки страниц и мета-описания

Для многих SEO-профессионалов подобная информация может показаться устаревшей, но на практике доказано, что хорошо оптимизированные заголовки страниц и мета-описания могут улучшить ранжирование и CTR в поисковой выдаче.

Да, это самые основы поисковой оптимизации, но Googlebot читает их (title, description), поэтому не стоит пренебрегать дополнительной возможностью. Есть много различных теорий по поводу правильных meta-тегов, но общие рекомендации довольно просты:

- Лучше использовать вертикальные чёрточки (|) вместо дефисов (-) в качестве разделителя, хотя боту Гугла без разницы.

- В заголовок главной, страницы контактов и «о компании» включите название вашего бренда. В большинстве случаев другие типы страниц не имеют большого значения.

- Не увлекайтесь длиной.

- Для вашего мета-описания скопируйте первый абзац текста и отредактируйте его так, чтобы он соответствовал диапазону, который в данное время Google рекомендует использовать для тега description. Если это в результате не совсем точно описывает вашу страницу, то вам следует подумать о том, чтобы поработать над содержанием.

- Проверьте! Использует ли Google ваши собственные заголовки и описания.

Подведём итог

Когда дело доходит до технического SEO и оптимизации под поисковых роботов, есть много вещей, на которые стоит обратить внимание. Многие из них требуют практических исследований, и я рекомендую попросить ваших коллег поделиться опытом, прежде чем вносить изменения в сайт.

Хотя новаторская тактика является захватывающей, она может привести к снижению органического трафика. Хорошее правило — проверить эту тактику, подождав несколько недель между изменениями. Это даст Googlebot определённое время, чтобы он смог разобраться с нововведениями на сайте и соответственно повысить вас в выдаче.

Источник

Пытаетесь преодолеть очередную планку роста органического

трафика? Высококачественный контент и ссылки безусловно помогут вам в этом, но

не стоит забывать о техническом SEO.

Один из наиболее важных навыков в технической оптимизации сайтов, который вы

можете приобрести в 2019-м – научиться думать, как Googlebot.

Прежде чем приступить к содержательной части, необходимо понять, что вообще из себя представляет этот Гугл-бот, как он работает и для чего нам всё это знать.

Что такое Googlebot

Googlebot – это веб-краулер (робот, паук), который собирает

данные с веб-страниц. Всего лишь один из многих. У каждой поисковой системы

есть свои фирменные пауки. В мире SEO их ещё называют «агентами

пользователя». Вот наиболее известные:

- Yandex – Яндекс

- Googlebot – Google

- Bingbot – Bing

- Slurp Bot – Yahoo

- Alexa Crawler – Amazon Alexa

- DuckDuckBot – DuckDuckGo

Как работает Googlebot

Мы не можем начать оптимизировать сайты под Googlebot, пока не поймём, как он обнаруживает, читает и оценивает веб-страницы.

Как робот Google находит веб-страницы

Краткий ответ:

ссылки, карты сайтов и запросы на обход.

Длинный ответ:

самый быстрый способ заставить Google просканировать ваш сайт, это зайти в Search

Console и добавить ссылку на карту вашего сайта. Однако это ещё не всё.

Несмотря на то, что карты сайта являются отличным способом заставить Google сканировать ваш сайт, этот метод не учитывает PageRank. Внутренние ссылки – это рекомендуемый способ сообщить Google, какие страницы связаны и имеют ценность. В Интернете опубликовано много замечательных статей о Google PageRank и внутренних ссылках, поэтому я не буду сейчас вдаваться в подробности.

Google также может обнаружить ваши веб-страницы, благодаря

профилю «Google Мой бизнес», каталогам и ссылкам с других сайтов. Это упрощённая

версия того, как работает робот Google. Чтобы узнать больше, вы можете

прочитать официальную документацию Google по их пауку.

Как робот Google читает веб-страницы

Google прошёл долгий путь в рендеринге сайтов. Основная

задача бота Гугла – прочитать страницу сайта так, как это сделал бы обычный

пользователь. Чтобы проверить, как Google просматривает вашу страницу,

воспользуйтесь инструментом проверки URL в Search Console. Так вы сможете сравнить страницу глазами посетителя

и Googlebot.

Технические факторы ранжирования

Как и в традиционном SEO, в техническом SEO нет волшебной

таблетки. Все 200+ факторов ранжирования важны!

Если вы являетесь техническим специалистом, думающим о

будущем SEO, то самые значимые факторы ранжирования, на которые стоит обратить

внимание, сосредоточены вокруг пользовательского опыта.

Зачем нам думать, как Googlebot

Когда представители поисковых систем говорят нам делать

качественные сайты, они как раз вот это и имеют в виду. Все эти размытые

формулировки являются в то же время очень точными.

Если вы можете удовлетворить пользователей интуитивным и

полезным веб-сайтом, соответствующим требованиям Googlebot, то в итоге получите

больше органического трафика.

Пользователи или роботы

На кого больше обращать внимание при создании сайта? На

пользователей или на роботов?

Краткий ответ: на

тех и на других.

Длинный ответ: это острый вопрос, который может вызвать напряжённость между дизайнерами интерфейсов, веб-разработчиками и SEO-специалистами. Тем не менее это даёт нам возможность поработать вместе и лучше понять баланс между поведением пользователей и ботов.

UX-дизайнеры отдают предпочтение в работе пользователям. SEO-специалисты – краулерам. Посередине находятся веб-разработчики, пытающиеся взять лучшее из обоих миров.

Опытный сеошник должен понимать важность пользовательского

опыта. Поэтому необходимо оптимизировать сайты и под людей, и под роботов,

одновременно. К счастью, Google изо всех сил старается ориентироваться на живых посетителей

сайтов.

Следующие 10 советов по оптимизации под Гугл-бота позволят

вам ублажить сразу обоих: дизайнера и разработчика.

1. Robots.txt

Robots.txt – это текстовый файл, который находится в корневом каталоге веб-сайта. Это одна из первых вещей, которую ищет робот Googlebot при сканировании сайта. Настоятельно рекомендуется добавить robots.txt на ваш сайт и включить в него ссылку на sitemap.xml.

Есть много способов оптимизировать файл robots.txt, но важно соблюдать осторожность. Разработчик может закрыть индексацию для всех роботов во время технических правок и забыть открыть её при внедрении на действующий сайт. В результате даже после устранения проблемы могут потребоваться недели на возврат органического трафика.

Существует множество советов и руководств по оптимизации

файла robots.txt. Тщательно разберитесь в вопросе, прежде чем что-то внедрять

на свой сайт. И не забывайте отслеживать результаты правок.

2. Sitemap.xml

Карты сайтов являются ключевым способом обнаружения новых страниц на ваших проектах ботом Гугла и считаются важным фактором ранжирования.

Вот несколько советов по оптимизации карты сайта:

- У вашего сайта должна быть только одна карта.

- Страницы блога и основные страницы сайта должны быть разделены на разные файлы, а затем объединены в общую карту.

- Не устанавливайте высокий приоритет для каждой отдельно взятой страницы.

- Удалите из карты сайта страницу для 404-ошибки и 301 редиректы.

- Отправьте файл sitemap.xml в Google Search Console и следите за обходом.

3. Скорость сайта

Быстрота загрузки стала одним из важнейших факторов ранжирования, особенно для мобильных устройств. Если скорость загрузки вашего сайта слишком низкая, робот Google может понизить ваш рейтинг.

Самый простой способ выяснить, считает ли робот Google, что

ваш сайт загружается слишком медленно, – это проверить скорость с помощью любого

из бесплатных инструментов. Многие из этих инструментов предоставляют

рекомендации, которые вы можете отправить вашим разработчикам.

4. Микроразметка Schema

Добавление структурированных данных на ваш сайт поможет роботу Google лучше понять контекст отдельных веб-страниц и веб-сайта в целом. Однако важно, чтобы вы следовали рекомендациям Google.

Для наибольшей эффективности лучше использовать JSON-LD при реализации разметки структурированных данных. Сам Google отметил у себя в рекомендациях, что JSON-LD является предпочтительным языком разметки.

5. Канонизация

Большой проблемой для крупных сайтов, особенно в секторе

электронной коммерции, является дублированный контент. Есть множество

практических причин для дублирования контента, например, мультиязычность сайта.

Если вы используете сайт с дублированным контентом, крайне важно указывать основные страницы при помощи тега rel=canonical и атрибута hreflang.

6. Таксономия URL

Наличие чёткой и понятной структуры URL, как показывает практика, приводит к более высоким позициям в поисковой выдаче и помогает пользователям лучше ориентироваться на сайте. Настройка родительских страниц позволяет роботу Google понимать взаимосвязь каждой страницы.

Однако, если у вас есть старые страницы, которые имеют

хорошие позиции, Джон Мюллер из Google не рекомендует менять их URL. Грамотная

таксономия URL-адресов – это то, что нужно установить с самого начала

разработки сайта.

Если вы абсолютно уверены, что оптимизация URL-адресов поможет сайту, убедитесь, что настроили правильные 301-редиректы и обновили свой sitemap.xml.

7. Загрузка JavaScript

Несмотря на то, что со статичными HTML-страницами проще работать в плане SEO, динамический контент, созданный с помощью JavaScript, позволяет сделать ваш веб-сайт интереснее для пользователей. В 2018 году Google потратил много ресурсов на улучшения взаимодействия с JavaScript.

Во время недавней сессии

вопросов и ответов с Джоном Мюллером, последний заявил, что Google планирует

продолжить фокусироваться на JavaScript в 2019 году. Если ваш сайт сильно

зависит от динамического рендеринга с помощью JavaScript, убедитесь, что ваши

разработчики следуют официальным рекомендациям Google.

8. Изображения

Google давно намекает на важность оптимизации изображений, но в последние месяцы особенно много говорит об этом. Оптимизация изображений поможет роботу Google контекстуализировать, как ваши картинки связаны и улучшить ваш контент.

Если вы хотите быстро оптимизировать изображения, я

рекомендую:

- Имя файла изображения: опишите, что это за изображение, используя как можно меньше слов.

- ALT-текст: можно скопировать имя файла и использовать дополнительные слова для описания изображения.

- Структурированные данные: вы можете добавить schema-разметку для описания изображений на странице.

- Карта картинок сайта: Google рекомендует добавить отдельную карту для ваших изображений.

9. Неработающие ссылки и зацикленные редиректы

Все мы знаем, что битые ссылки – это плохо, некоторые оптимизаторы утверждают, что они могут потратить впустую бюджет на обход сайта. Однако Джон Мюллер заявил, что неработающие ссылки не уменьшают этот бюджет.

Я полагаю, что, учитывая неоднозначность имеющейся информации, мы должны быть осторожны и убирать все неработающие ссылки. Используйте Google Search Console или ваш любимый инструмент для сканирования, чтобы найти неработающие ссылки на сайте!

Зацикленные редиректы – ещё одна характерная черта старых проектов. Такое явление обычно возникает, когда в цепочке редиректов присутствует несколько этапов.

Пример выше: третий вариант первоначальной страницы перенаправляет

пользователя на второй вариант, который, в свою очередь, перенаправляет опять

на третий вариант. Получается замкнутый цикл.

Поисковые системы часто испытывают трудности при

сканировании циклов перенаправления и потенциально могут завершить обход сайта.

Лучшее решение здесь – заменить исходную ссылку на каждой странице финальной

ссылкой.

10. Заголовки страниц и мета-описания

Для многих SEO-профессионалов подобная информация может показаться устаревшей, но на практике доказано, что хорошо оптимизированные заголовки страниц и мета-описания могут улучшить ранжирование и CTR в поисковой выдаче.

Да, это самые основы поисковой оптимизации, но Googlebot читает их (title, description), поэтому не стоит пренебрегать дополнительной возможностью. Есть много различных теорий по поводу правильных meta-тегов, но общие рекомендации довольно просты:

- Лучше использовать вертикальные чёрточки (|) вместо дефисов (-) в качестве разделителя, хотя боту Гугла без разницы.

- В заголовок главной, страницы контактов и «о компании» включите название вашего бренда. В большинстве случаев другие типы страниц не имеют большого значения.

- Не увлекайтесь длиной.

- Для вашего мета-описания скопируйте первый абзац текста и отредактируйте его так, чтобы он соответствовал диапазону, который в данное время Google рекомендует использовать для тега description. Если это в результате не совсем точно описывает вашу страницу, то вам следует подумать о том, чтобы поработать над содержанием.

- Проверьте! Использует ли Google ваши собственные заголовки и описания.

Подведём итог

Когда дело доходит до технического SEO и оптимизации под поисковых

роботов, есть много вещей, на которые стоит обратить внимание. Многие из них

требуют практических исследований, и я рекомендую попросить ваших коллег

поделиться опытом, прежде чем вносить изменения в сайт.

Хотя новаторская тактика является захватывающей, она может

привести к снижению органического трафика. Хорошее правило – проверить эту

тактику, подождав несколько недель между изменениями. Это даст Googlebot

определённое время, чтобы он смог разобраться с нововведениями на сайте и

соответственно повысить вас в выдаче.

Автор оригинала: Джон Макалпин – руководитель SEO-департамента в Cardinal DIgital Marketing. Джон разрабатывает общую SEO-стратегию для CDM – SEO-агентства из Атланты, которое специализируется на обслуживании компаний, работающих в сфере здравоохранения на всей территории США. В настоящее время он живёт в Далласе, активно участвует в местном и национальном SEO-сообществе, имеет большой опыт в области технического SEO, веб-разработки и стратегии цифрового маркетинга.

Источник: www.searchenginejournal.com.

- Об авторе

- Недавние публикации

Меня зовут Виктор, я – автор этого блога. Занимаюсь интернет-маркетингом (SEO, SMM, CPA) профессионально с 2008 года.

ПОНРАВИЛСЯ ПОСТ? ПОДЕЛИСЬ ССЫЛКОЙ С ДРУЗЬЯМИ!

Получать новые публикации по электронной почте:

СТАТЬИ ИЗ РУБРИКИ:

- Тренды партнёрского маркетинга, за которыми стоит следить в 2019: мнения CPA-экспертов

- VDSina – один из лучших доступных хостингов для начинающих вебмастеров

- Как Чарльз Нго потерял несколько сотен тысяч долларов на инвестициях в криптовалюту и какие уроки извлёк

- 8 трендов интернет-маркетинга 2019: блогеры, автоматизация и видео

- Как конвертировать Попандер-трафик – руководство от RedTrack и интервью с PropellerAds

- Твит на миллион долларов: 8 советов для создания успешного бизнеса от Нейтана Барри из ConvertKit

- Обзор SmmBox — инструмента для продвижения в социальных сетях

- Стоит ли вкладывать деньги в Биткоин, Эфириум, есть ли смысл инвестировать в другие криптовалюты, выгодно ли это

- Эльдар Гузаиров: как зарабатывать на YouTube в 2017-м

- Льём буржуйский поп-трафик на свипстейки: краткое руководство для начинающих от BizProfits

Тематика: Google, SEM, Переводы

Дата публикации: 05.02.2019

(некоторые ответы перед публикацией проверяются модератором)

Подключение телеграм бота к гугл таблицам

Время на прочтение

4 мин

Количество просмотров 54K

Всем привет, хабравчане!

Это мой первый пост на этой площадке, целью которого является погружение в коммьюнити для обратной связи и полезных ремарок относительно этой статьи. Также буду рада, если эта статья станет полезной для начинающих свой путь в написании ботов людей 🙂

За последний год я узнала об интересном способе автоматизации бизнес-процессов, которая достигается комбинацией гугл-таблиц и телеграма. Такие задачи как учет финансов, тайм-менеджмент, пересылка событий, сообщений, уведомлений и т.п. легко решаются с помощью бесплатного инструментария гугла и телеги.

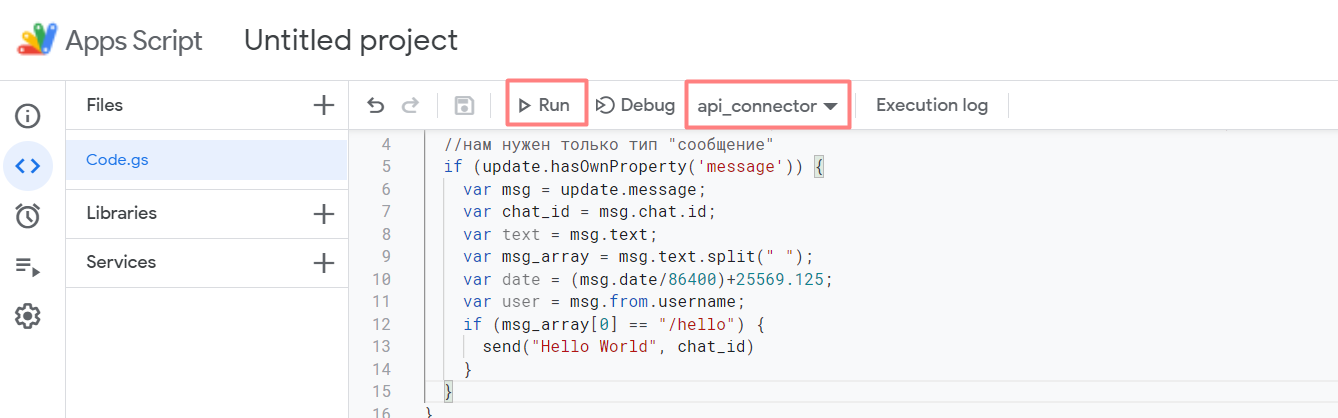

Далее речь пойдет о создании первого бота и написании скрипта в Apps Script. Поехали!

Создание телеграм-бота

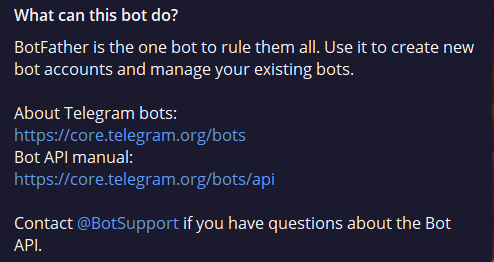

Откуда вообще берутся боты в телеграме? Опытному пользователю можно пропустить это пункт, ну а новичкам настало время познакомится с @BOTFATHER

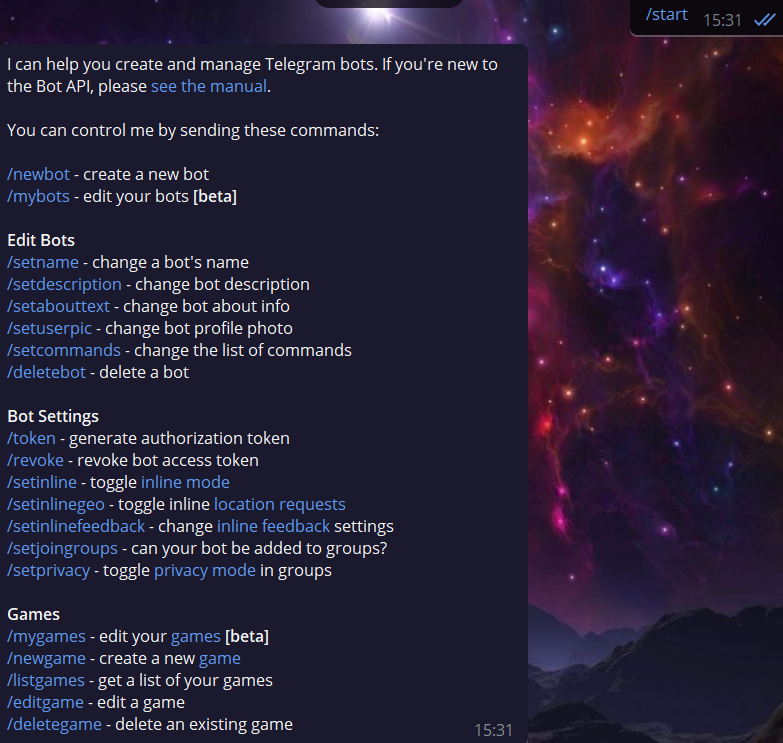

Находим отца всех ботов в поиске телеги и видим, что этот бот вообще из себя представляет.

После старта этого бота мы увидим список команд.

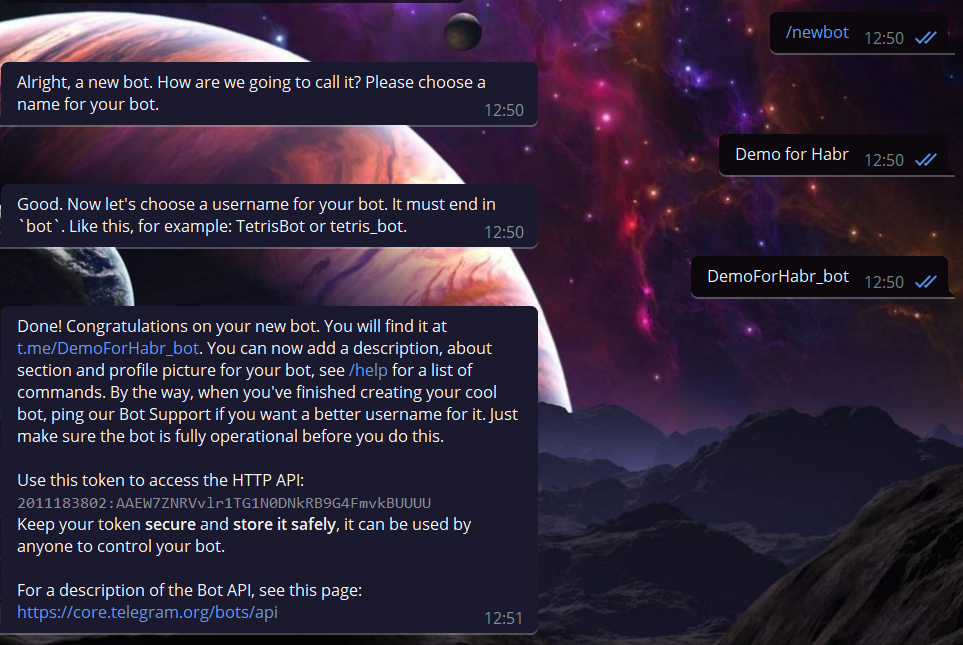

Здесь нам нужна команда /newbot, чтобы создать нашего первого бота.

Порядок действий незамысловатый: создаем бота помандой /newbot, даем ему вменяемое имя и задать ему username с обязательным окончанием bot. В результате получаем API токен нашего бота, который и будем дальше использовать.

Можете проверить работоспособность созданного бота перейдя по следующему URL:

https://api.telegram.org/bot2011183802:AAEW7ZNRVvlr1TG1N0DNkRB9G4FmvkBUUUU/getMe

выделенное жирным замените на апи своего бота

Запрос вернет примерно это:

{"ok":true,"result":{"id":2011183802,"is_bot":true,"first_name":"Demo for Habr","username":"DemoForHabr_bot","can_join_groups":true,"can_read_all_group_messages":false,"supports_inline_queries":false}}Подключение гугл-таблицы

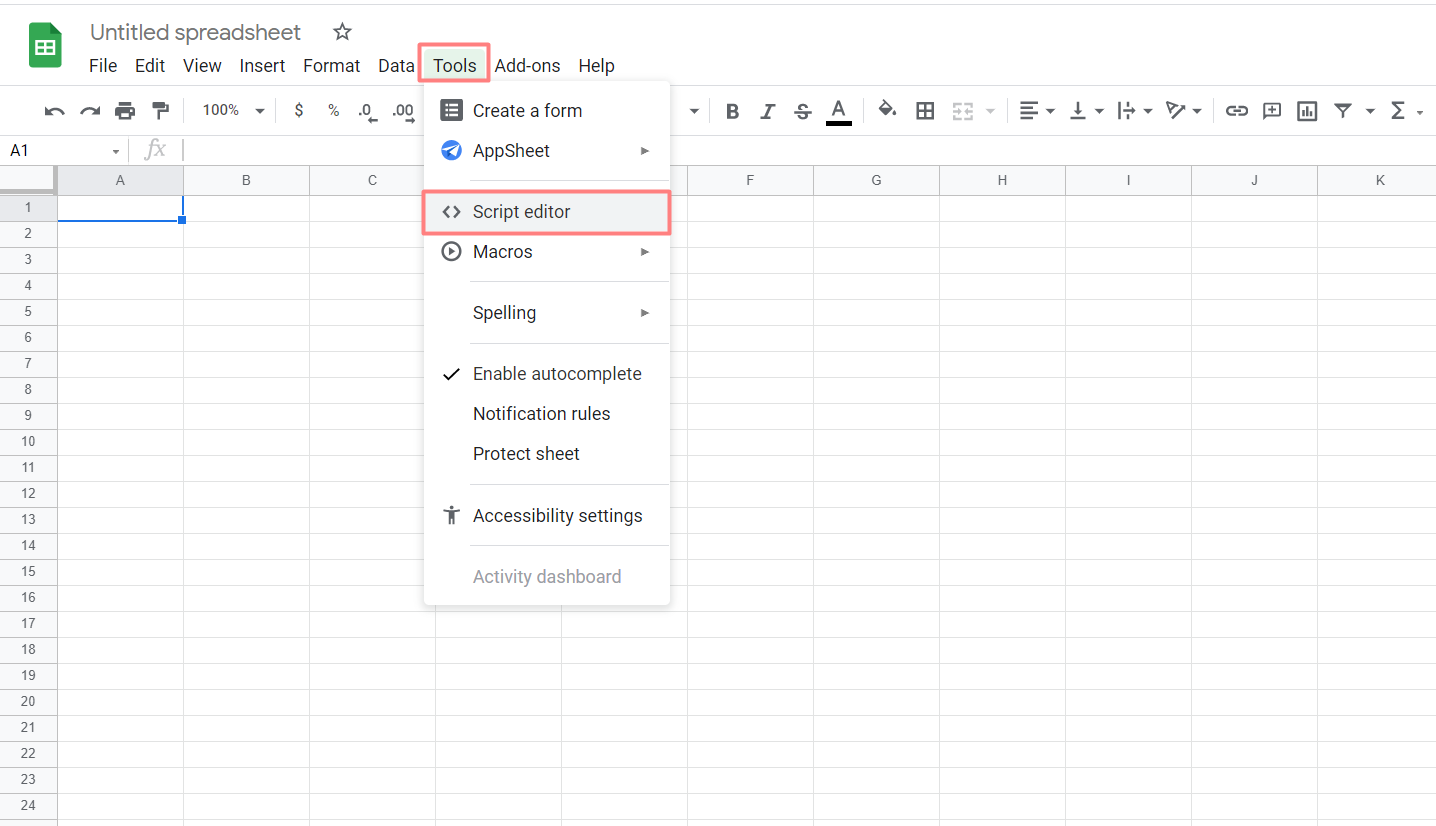

Переходим к гугл табличкам и создаем новый док.

Нам нужен пункт меню Инструменты/Tools -> Редактор скриптов/ Script editor.

Должно получиться вот это:

Затрем скрипт и напишем свой на языке JavaScript. Дополнительно в скрипте могут быть использованы инструменты гугла (классы, методы и т.п.), что мы далее и рассмотрим.

Начнем с объявления глобальных переменных. У нас их будет только две – API бота и App_link.

const API = "2011183802:AAEW7ZNRVvlr1TG1N0DNkRB9G4FmvkBUUUU";

//в кавычки впишите свой апи

const App_link = "";

//значение переменной пока оставляем пустымНапомню, что АПИ бота мы получили в диалоге с botfather.

Далее напишем функцию send, которая отправляет сообщение в чат с нашим ботом.

function send (msg, chat_id) {

let payload = {

'method': 'sendMessage',

'chat_id': String(chat_id),

'text': msg,

'parse_mode': 'HTML'

}

let data = {

'method': 'post',

'payload': payload

}

UrlFetchApp.fetch('https://api.telegram.org/bot' + API + '/', data);

}

Функция send() отправляет запрос для общения со строними приложениями, в нашем случае – с телегой. Подробнее в документации Class UrlFetchApp.

Аргументы функции – текст отправляемого сообщения и ид чата, в которое это сообщение отправляется.

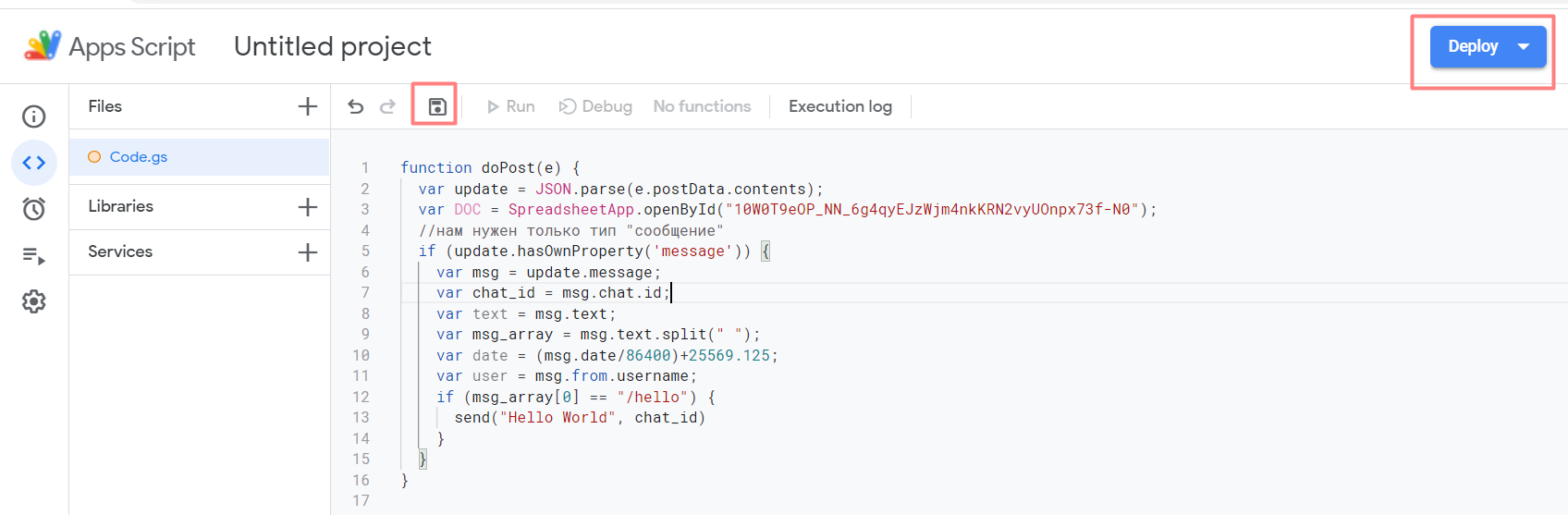

Далее нужно предусмотреть механизм запуска функции send(). Осуществим это из тела другой функции doPost():

function doPost(e) {

let update = JSON.parse(e.postData.contents);

//нам нужен только тип "сообщение"

if (update.hasOwnProperty('message')) {

let msg = update.message;

let chat_id = msg.chat.id;

let text = msg.text;

let user = msg.from.username;

if (text == "/hello") {

send("Hello World", chat_id)

}

}

}

Это стандартная функция при работе с телеграм ботами, в которую зашиваются ответные действия от бота при отправке сообщения в чат с ним.

Здесь мы сравниваем текст полученного ботом сообщения с текстом “/hello” и вызываем функцию send()при совпадении. Это все действия нашего бота.

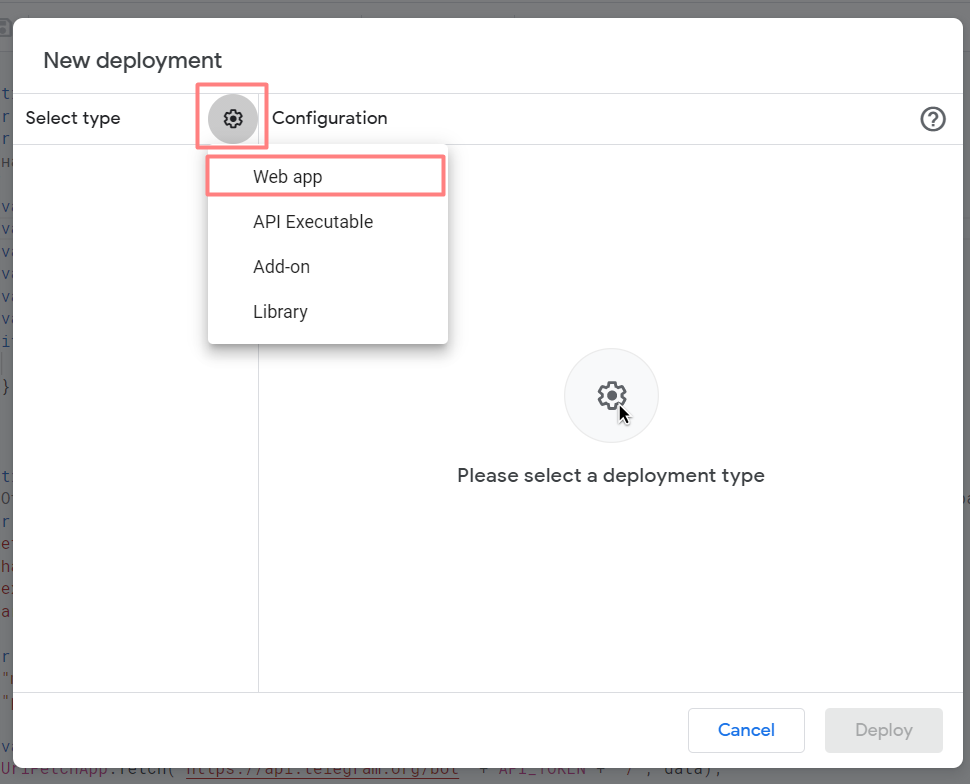

Сначала сохраним скрипт и задеплоим проект. Кликаем на кнопку Deploy -> New deployment.

В результате откроется окно New deployment, где нужно кликнуть по шестеренке и выбрать Web app.

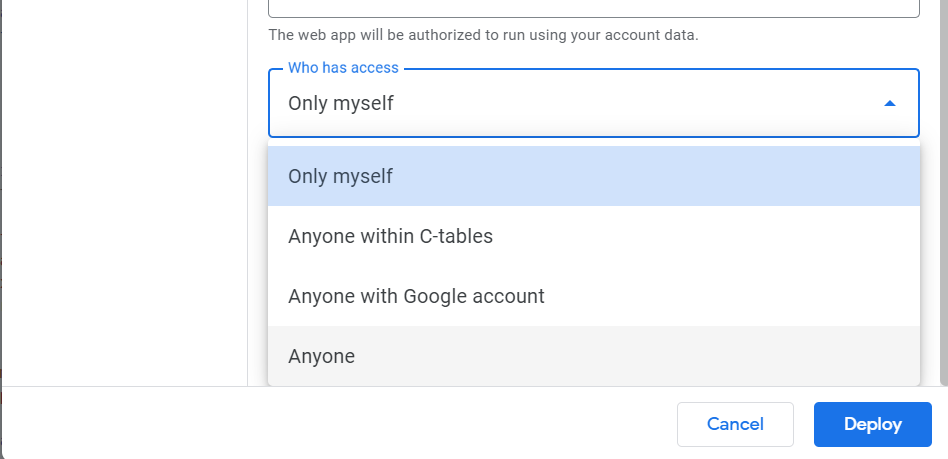

В поле Who has access выбираем Anyone, что позволит другим пользователям вносить правки в проект и деплоить без вашего участия.

И кликаем Deploy.

При первом запуске приложение попросит авторизации. Проделываем это упражнение.

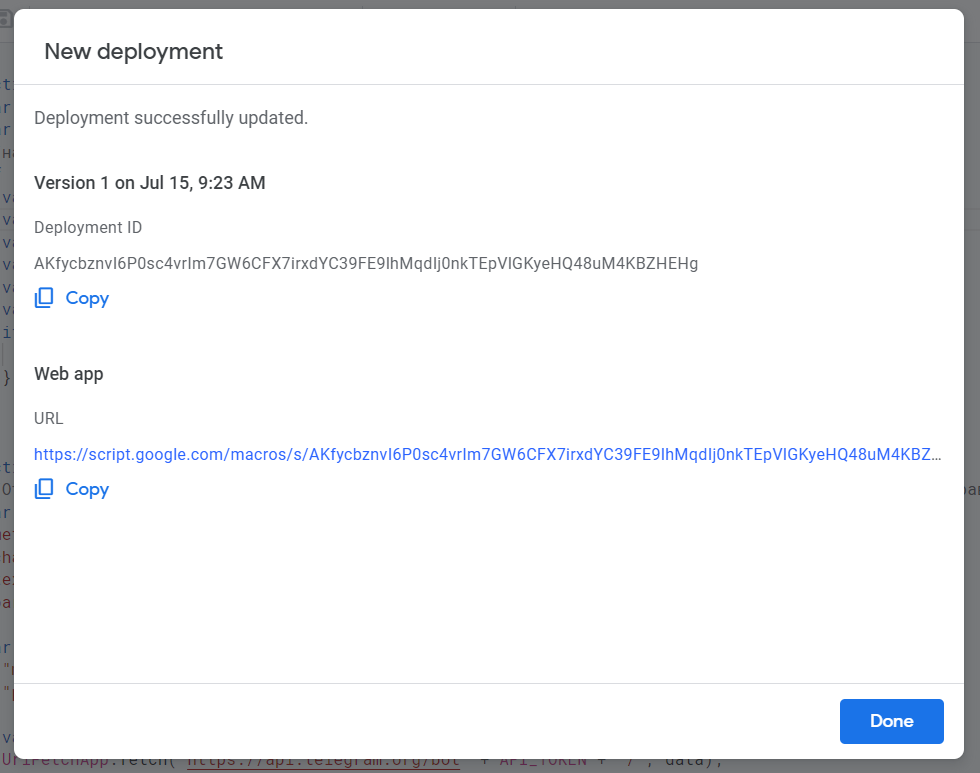

Получаем следующее:

Здесь нам нужен URL в самом конце. Копируем его по кнопке Copy и вставляем в качестве значения глобальной переменной App_link, значение для которой мы оставили изначально пустым.

Создадим функцию установки вебхука для получения обновлений от нашего бота.

Добавим следующий код к нашему скрипту:

function api_connector () {

UrlFetchApp.fetch("https://api.telegram.org/bot"+API+"/setWebHook?url="+App_link);

}

Функция принимает обе глобальные переменные API и App_link, так что убедитесь, что они у вас есть и их значения установлены корректно.

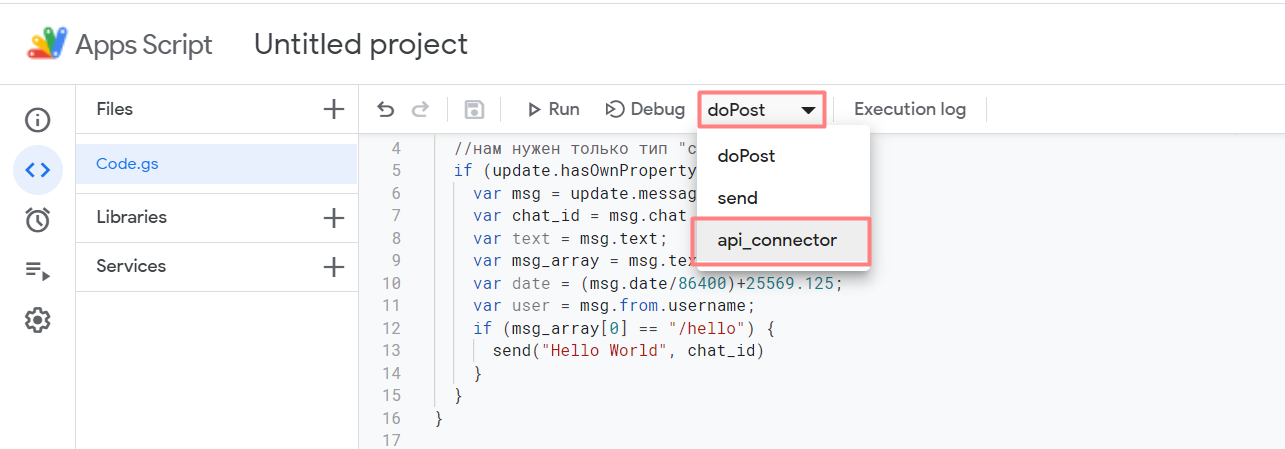

Снова сохраняем код и запускаем только функцию api_connector:

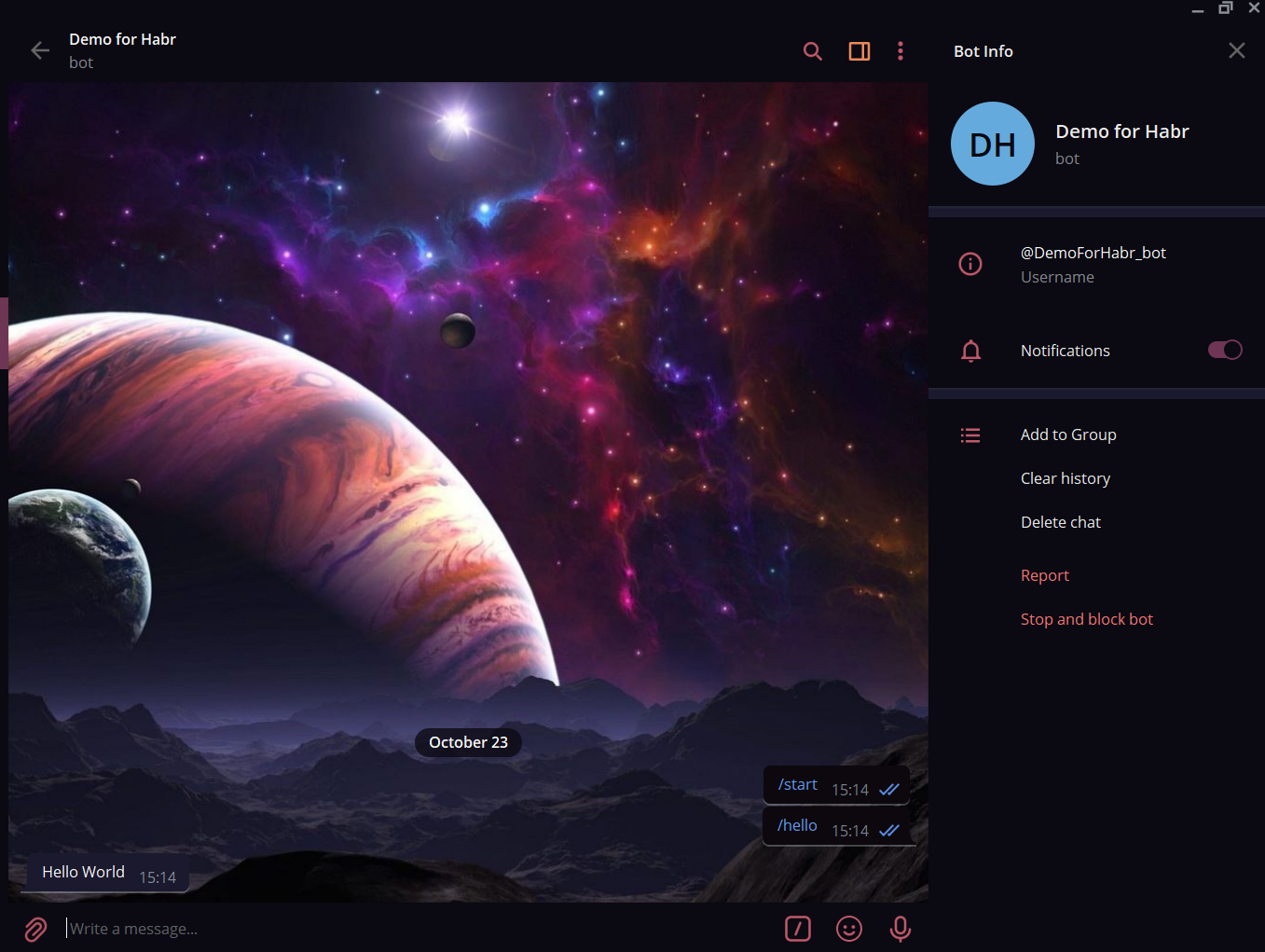

Если функция выполнилась без ошибок, идем проверять работу нашего бота непосредственно в телеге.

Сообщение “/hello” успешно распознано, на что наш бот ответил “Hello world”.

Скрипт целиком ниже:

const API = "2011183802:AAEW7ZNRVvlr1TG1N0DNkRB9G4FmvkBUUUU";

//в кавычки впишите свой апи

const App_link = "https://script.google.com/macros/s/AKfycbyS0k0r1VF0T1O1y8b_oElTXWzWNJKUiQDXS2HWdZT9q-ODieKgLoNXGQTtRoi6a8fo/exec";

//после каждого деплоя обновляем значение переменной

function send (msg, chat_id) {

let payload = {

'method': 'sendMessage',

'chat_id': String(chat_id),

'text': msg,

'parse_mode': 'HTML'

}

let data = {

"method": "post",

"payload": payload

}

UrlFetchApp.fetch('https://api.telegram.org/bot' + API + '/', data);

}

function doPost(e) {

let update = JSON.parse(e.postData.contents);

//нам нужен только тип "сообщение"

if (update.hasOwnProperty('message')) {

let msg = update.message;

let chat_id = msg.chat.id;

let text = msg.text;

let user = msg.from.username;

if (text == "/hello") {

send("Hello World", chat_id)

}

}

}

function api_connector () {

UrlFetchApp.fetch("https://api.telegram.org/bot"+API+"/setWebHook?url="+App_link);

}

Заключение

Мы создали простейшего бота для демонстрации работы гугл скриптов в связке с телеграмом.

Если тема интересна, с удовольствием подготовлю материал по написанию более сложных функций и/или более полезных с точки зрения бизнеса и автоматизации

Буду рада обратной связи.