Определение ботов на сайте с помощью нейронных сетей

Время на прочтение

4 мин

Количество просмотров 5.2K

Пару лет назад, как и многие другие владельцы сайтов в рунете, я столкнулся с резким ростом посетителей из социальных сетей. Поначалу это радовало, пока дело не дошло до детального изучения поведения таких “пользователей” – оказалось что это боты. Мало того, они еще и сильно портили поведенческие факторы, которые критически важны для хорошего ранжирования в Яндексе, да и в Гугле.

Изучая ТГ каналы, посвященным накрутке поведенческих факторов (а большинство ботов используется для этого), пришла в голову мысль, что наверняка же разработчики ботов где-то ошибаются, где-то упираются в невозможность реализовать полноценную эмуляцию параметров настоящих браузеров и поведение реальных посетителей. На основании двух этих гипотез и возникла идея создать 2 нейросети. Первая из них должна определять бота по многочисленным параметрам браузера. А вторая – по поведению на сайте – по тому, как пользователь скроллит, кликает и совершает другие действия.

Сбор базы

Первое, что нужно для обучения нейронной сети – достаточное количество обучающих примеров – визитов, о которых мы достоверно знаем, что это боты и визитов, о которых точно известно, что это реальные люди. Для такого отбора было использовано три параметра:

-

Скоринг Recapcha V3.

-

Залогинен ли посетитель в сервисах Google, Yandex, VK.

-

Уникальность Canvas Hash.

Суть последнего параметра в том, что на элементе HTML “холст” рисуется картинка, далее вычисляется md5 хэш этого изображения. В зависимости от операционной системы, ее версии, версии браузера, устройства, изображение чуть отличается и хэш получается разным. Боты, как правило, накладывают случайный шум на изображение, чтобы затруднить их детектирование, и в результате у них хэш получается уникальным. У реальных людей уникальных хэшей не бывает.

Итак, реальный посетитель, если:

-

Скоринг Recapcha V3 >=0.9.

-

Залогинен в Яндексе и в одном из: Google либо VK.

-

Canvas Hash неуникальный.

Бот, если:

-

Скоринг Recapcha V3<=0.3

-

Нигде не залогинен, либо залогинен только в Яндекс. Боты для накрутки поведенческих факторов очень часто ходят под профилем Яндекса.

-

Уникальный Canvas Hash.

Данные брались с трех информационных сайтов за период в 1 месяц. В базу попало чуть больше сорока тысяч визитов, 25% из которых это боты и 75% реальные люди. Что именно собиралось будет описано далее.

Определение бота по параметрам браузера

Хотя боты и работают на браузерных движках, но это далеко не полноценный Google Chrome, за который они себя хотят выдать. Многие параметры им приходится эмулировать, чтобы выглядеть как настоящий пользовательский браузер. Вот и попробуем обучить нейронную сеть находить несоответствия эмулированных параметров реальным. Для этого соберем максимальное количество информации о браузере, а именно:

-

ОС, версия ОС, название браузера, версия браузера, модель гаджета, если есть возможность ее получить.

-

Параметры соединения – тип сети, скорость.

-

Разрешение экрана, размер окна отображения, есть ли полоса прокрутки и другие параметры, связанные с отображением.

-

Параметры webGL (модель видеокарты, размер памяти и т.п.).

-

Виды медиа контента, который может воспроизвести браузер.

-

Какие шрифты поддерживает браузер (анализируются 300 самых распространенных шрифтов).

-

Параметры WebRTC.

Получилось несколько десятков параметров

Следующее, что нужно решить – какую архитектуру нейронной сети использовать. Поскольку база несколько не сбалансирована, первое, что пришло в голову – попробовать автокодировщик. Обучить его на реальных людях (их 75%), а выбросы трактовать как ботов. Была использована следующая архитектура:

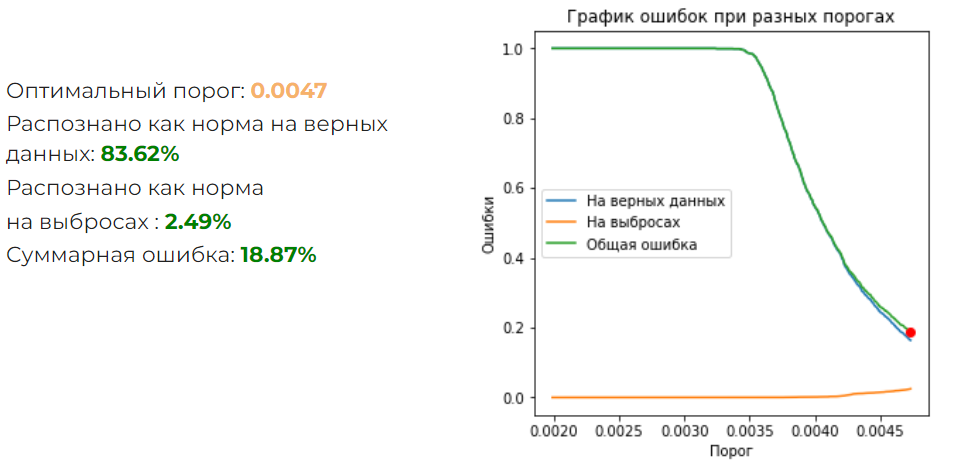

Результат получился такой:

Суммарная ошибка великовата. Надо попробовать обычный классификатор на полносвязанных слоях. Была подобрана следующая архитектура:

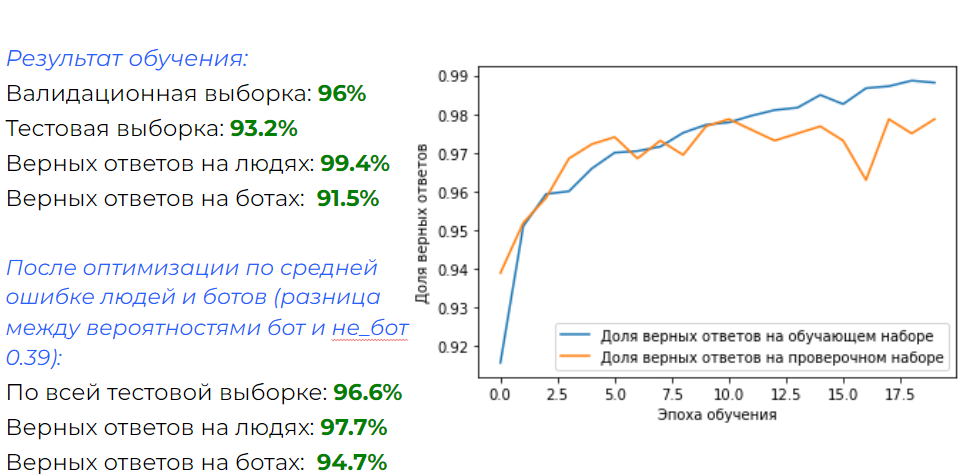

Что получилось:

Результат отличный! И для отсеивания большинства ботов, которые используются для накрутки ПФ, такая нейронка подходит.

Но что если бюджет позволяет использовать ботов не просто на браузерном движке, а на реальном Google Chrome? Это требует значительно больше ресурсов, но технически легко реализуемо. Для такого случая эта нейронная сеть не подойдет. Но можно попробовать проанализировать поведение бота и сравнить с поведением реальных людей.

Определение бота по поведению на сайте

Хорошие боты эмулируют поведение реального человека – они кликают, скроллят, двигают мышкой по траектории, похожей на человеческую и т.п. Но наверняка где-то ошибаются – может быть у них немного другое распределение событий, другие задержки, места клика и т.д. Попробуем собрать как можно больше данных о поведении посетителей. Для этого проанализируем следующие события:

-

Движение мыши.

-

Прокрутка колесика.

-

Нажатие на сенсорный экран.

-

Прокрутка на странице.

Для каждого события соберем следующие параметры:

-

Длительность.

-

Изменения по оси X и Y.

-

Скорость изменения по оси X и Y.

-

Число элементарных событий, которые получил браузер.

События укладываются во временной ряд, а значит имеет смысл использовать одномерные сверточные сети. Оптимальной получилась такая архитектура:

А результат следующий:

Результат тоже вполне хороший. К минусам можно отнести то, что требуется не меньше 20-ти секунд нахождения на странице, чтобы произошло достаточное количество действий. Поэтому нельзя применять для фильтрации траффика на этапе загрузки.

Вывод

Плюсы и минусы каждого метода приведены на картинке:

Что дальше

На данный момент функционал реализован в виде WordPress плагина и работает в тестовом режиме на одном из сайтов. Его код можно посмотреть здесь.

В дальнейшем планируется все довести до “ума” и запустить в виде сервиса.

Разбираемся, кто и зачем насылает ботов на сайт, как вовремя распознать нашествие, и рассказываем про 3 способа защиты, которыми пользовались.

Привет, с вами Сайткрафт — маркетинговое агентство для B2B. Специализируемся на работе с высококонкурентными нишами бизнеса: строительство, недвижимость, промышленность, заводы. Здесь конкуренты пытаются выделиться на фоне других всеми доступными способами, включая нашествие ботов на сайт.

Боты притворяются «живыми» пользователями, нагружают сервер и могут подпортить репутацию сайта в глазах поисковых систем. Наш SEO-специалист, Максим Зотьев, рассказал, кто и зачем насылает ботов, как заметить нашествие и, самое главное, как защитить свой сайт и сохранить его позиции в выдаче.

Зачем насылать ботов?

В Яндексе есть понятие «поведенческий фактор» — один из важнейших критериев, по которым сайт ранжируется в поисковой выдаче. По поведенческому фактору Яндекс оценивает, насколько сайт полезен пользователям, и решает, на какой странице и позиции результатов его показывать.

Например, пользователь загуглил «как защитить сайт от ботов» и наткнулся на эту статью. Ему понравился 1 из 3 способов, о которых мы рассказали, он его запомнил, закрыл статью и больше к Яндексу с этим запросом не обращался. Пользователь получил ответ на вопрос, а сайт получил плюсик к ранжированию.

Те, кто любыми способами пытается вывести сайты в ТОП, быстро поняли и оценили такую фишку Яндекса — появилась накрутка поведенческого фактора. На сайт целенаправленно нагоняют толпу ботов, которые пытаются имитировать действия обычных пользователей: скроллят страницы, переходят по разделам, вдумчиво «читают» статьи. Алгоритмы Яндекса оценивают это как интерес со стороны пользователей и поднимают сайт в поисковой выдаче.

Но в Яндексе быстро заметили, что их обманывают и используют лазейки в алгоритме, чтобы выводить сайты в ТОПы. В ответ на ботов Яндекс усовершенствовал алгоритмы так, чтобы они смогли вычислять искусственных пользователей.

Так началась настоящая битва, которая идёт до сих пор — ботов совершенствуют, делают умнее и ещё скрытнее, а Яндекс совершенствует алгоритмы, чтобы вычислять всё новых ботов. Теперь, когда Яндекс видит подозрительно высокую активность, он наоборот понижает позиции сайта и старается не показывать его пользователям.

Усовершенствованные алгоритмы Яндекса тоже начали использовать в своих целях — ботов нагоняют на сайты конкурентов, чтобы вывести их из игры. Это и называется «нашествием ботов». Но в отличие от «умных» ботов, эти специально нелепо копируют действия пользователей, чтобы Яндекс как можно быстрее применил санкции к сайту, например, отправил его вниз по поисковой выдаче или вовсе перестал показывать в результатах. Так конкуренты начали устранять друг друга.

Но не торопитесь сразу винить конкурентов и писать им на почту гневные письма — боты могут просто «нагуливать пузо», собирая полезную им информацию. Таких ботов просто «прокачивают», чтобы использовать в будущем для накрутки поведенческого фактора. Пока боты «качаются», они приходят на рандомные сайты, которые только попадаются на их пути.

Для владельца сайта это тоже может обернуться пессимизацией в Яндексе и падением позиций, потому что алгоритмов «прокачки» ботов тысячи. Если на одном и том же сайте боты слишком часто будут «нагуливать пузо», он тоже может отправиться на дальние страницы поисковой выдачи.

Давайте разбираться, как вовремя заметить нашествие ботов, которые «нагуливают пузо» или пришли от конкурентов, и какими способами защитить сайт.

Как заметить нашествие ботов до понижения в рейтинге

Когда сайт «упадёт» от мощной DDos-атаки или алгоритмы начнут показывать его только на пятой странице результатов поиска — нашествие ботов будет очевидным. Но заметить подозрительную активность можно и раньше:

-

Резко увеличивается трафик. Это кажется полезным только на первый взгляд. Если на сайте одномоментно поступают большие объёмы трафика, а вы не давали рекламу, — это может быть нашествием ботов.

- Показатели необъяснимо меняются. Если вы заметили нетипичные отказы, резкий упадок конверсий, уменьшение времени или глубины просмотра, причиной тоже могут быть боты.

- «Пользователи» ведут себя странно. Если поведение пользователей изменилось и стало нелогичным, например, посетители кликают по несуществующим ссылкам или хаотично переходят по страницам, то, скорее всего, это не «живые» пользователи, а роботы.

- В отчётах аналитики появились нетипичные показатели. Если данные веб-аналитики резко и беспричинно изменились — могли постараться боты. Сравните текущие отчёты метрики с показателями за прошлый период, чтобы оценить изменения.

3 способа защитить сайт от ботов

Реанимировать сайт после нашествия ботов намного сложнее, чем заранее защитить его от нежелательных «посетителей». 3 самых популярных способа защиты: блокировка IP-адресов, встроенная защита от хостинга и специальные сервисы защиты от ботов.

- Блокировка IP-адресов

Это самый распространённый, но, к сожалению, самый неэффективный способ защиты от ботов. В «Менеджере IP-адресов» потребуется вручную создать правило блокировки или блокировать отдельные адреса. Но сейчас многие боты используют мобильные прокси, который подменяет IP-адрес и в случае блокировки мгновенно меняет его на другой.

Можно заблокировать подсети в файле robots.txt или .htaccess, чтобы не пропускать ботов на сайт. Но такая блокировка может затронуть и «настоящих» пользователей, а не только ботов. В результате сайт окажется недоступным и для ботов, и для «живых» посетителей.

Блокировка IP-адресов сработает только как временное решение, но точно не будет эффективно работать в перспективе.

- Встроенные средства защиты от DDoS-атак и нашествий ботов

У многих хостинг-провайдеров есть встроенные средства защиты от DDoS-атак, которые можно использовать и против нашествия ботов. Инструменты фильтруют IP-адреса, блокируют повторяющиеся запросы, отличают «хороших» и «плохих» ботов, определяют, есть ли угроза уже на первом запросе и многое другое.

Средства защиты от DDoS-атак на популярных хостингах можно найти даже в базовых тарифах. Они выглядят как отдельный IP-адрес, который пропускает только допустимый трафик и блокирует любые подозрительные активности. Некоторые хостинги предлагают ещё и собственный дополнительный модуль, который устанавливается на сайт и настраивается по конкретным правилам.

Всего одно движение ползунка и ~300 рублей в месяц, чтобы забыть про проблемы с ботами и быть уверенными в безопасности сайта — встроенная защита справится с нашествием. Такой же способ защиты мы используем в агентстве.

Есть всего один нюанс, про который нельзя забывать: обязательно попросите техподдержку отключить встроенное кеширование. Иначе обновления на сайте будут появляться раз в сутки при каждом сбросе кеша со стороны хостинга. Поэтому убедитесь, что кеширование отключено сразу после подключения защиты от ботов.

- Сервисы защиты от DDoS-атак и ботов

Тех, кто обещает защитить сайт от ботов и DDoS-атак, тысячи, например, Amazon CloudFront, Incapsula, Akamai, Fastly, Cloudbric и другие. Они справляются с масштабным нападением, но неизвестно, как защищают именно от небольших атак ботов. Нашим фаворитом среди сервисов защиты от ботов стал CloudFlare, которым мы защищаемся и сами.

В первую очередь, CloudFlare — это сервис защиты от DDoS-атак. Но вместе с этим он отлично показал себя в борьбе с ботами — мы проверили.

На бесплатном тарифе сервиса предустановлен базовый уровень защиты от ботов, даже он справится с небольшим нашествием. Для усиленной защиты с дополнительным функционалом есть продвинутые платные тарифы: Pro (от $20 в месяц), Business (от $200 в месяц) и Enterprise (стоимость индивидуальна).

Чтобы настроить CloudFlare, потребуется время и базовые технические знания, но это того стоит — сервис зарекомендовал себя самым мощным и надёжным способом защиты от ботов. При подключении CloudFlare берёт текущие DNS-записи у домена и полностью копирует их к себе. Сервис автоматически кеширует данные, ведёт собственную статистику, мониторит посещения и имеет множество дополнительных приложений и бесплатный SSL-сертификат.

Но даже здесь не обошлось без нюанса, с которым придётся мириться. CloudFlare 5 секунд показывает каждому пользователю окно-предупреждение, а только после пропускает на сайт:

Регулярно следите за активностью на сайте, обращайте внимание на странное поведение пользователей и не спешите радоваться резкому беспричинному наплыву трафика. А если заметите, что что-то пошло не так, тут же активируйте все средства защиты против ботов и DDoS-атак, чтобы сайт не упал в рейтинге и стабильно работал.

За SEO-оптимизацией, разработкой сайта и продвижением — переходите на наш сайт и оставляйте заявку.

Расскажите, как защищаете сайт от ботов? Какие сервисы используете?

Статья подготовлена совместно с разработчиком Antibot.cloud.

Каким бывает ботовый трафик, и чем он опасен

Обращения к сайту можно разделить на три группы:

- Живые люди, зашедшие через браузер.

- Полезные боты (например, роботы поисковых систем «Яндекс» и Google).

- «Плохие» боты, которые могут нанести ущерб.

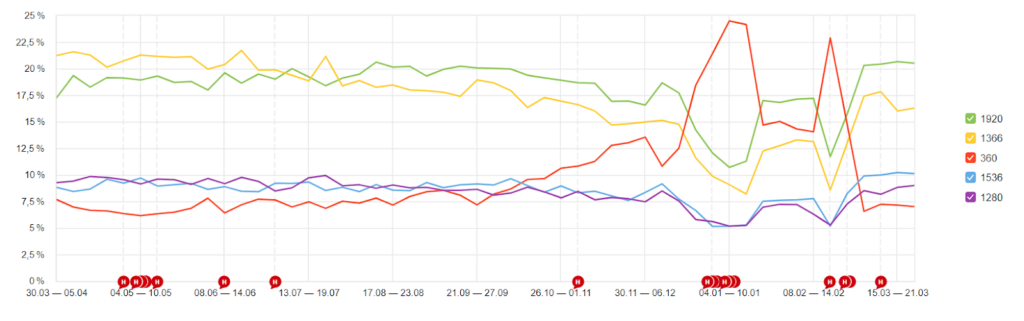

Многие даже не знают, сколько ботов бродит по страницам их ресурса. Наверняка вы наблюдали всплески посещений, заходы из необычных локаций или со странных устройств, изучая отчёты «Яндекс.Метрики» или Google Analytics. Скорее всего, за них были ответственны боты. Например, мы в 2021 году заметили рост трафика на блог Travelpayouts с устройств с низким разрешением экрана. А это одно из проявлений ботового трафика.

Ниже на картинке расположен пример статистики многостраничного сайта из кабинета сервиса Antibot.cloud. На ней видно, что процент живых людей («Уники» и «Хиты») составляет всего около 0,5% от количества всех ботов («Не прошли», «Хороших ботов» и «Заблокировано»).

«Хорошие боты» — это роботы поисковых систем, собственные автоматические обращения к API и подобное. «Фейк боты» — это парсеры, которые подставляли юзер-агенты GoogleBot или YandexBot. Те, которые отмечены как «Не прошли» и «Заблокировано», не приносят никакой пользы, а скорее вредят.

Также ботов можно разделить на две категории:

- совершают действия на сайте;

- переходят с одного сайта на другой. Например, кликают по партнёрской ссылке на сайте партнёра и переходят на ресурс бренда.

Цели таких ботов и проблемы, к которым может привести их активность, отличаются.

Ботовый трафик на сайте

Поисковые роботы (краулеры)

Поисковые роботы — это роботы поисковых систем «Яндекса», Google и других. Они ищут новые страницы в сети, сканируют их и помогают индексироваться в поиске.

Это полезные для SEO роботы, которые особых проблем не доставляют.

SEO-боты

SEO-боты принадлежат SEO-платформам (например, Ahrefs, Semrush, Serpstat и других), которые помогают своим пользователям проанализировать ресурсы конкурентов и узнать свой рейтинг. Такие данные помогают владельцам сайтов улучшить позиции в поиске.

Чем опасны:

Единственный урон от таких ботов — это нагрузка на сайт. Если вы не являетесь пользователем SEO-платформ, то можете заблокировать их.

Боты для накрутки поведенческих факторов

Боты для улучшения поведенческих факторов — это «серый» метод продвижения в поисковой выдаче. Их запускают на заказанный сайт, чтобы имитировать посещение реальных людей: просматривать разные страницы в течение длительного времени, чтобы уменьшить показатель отказов.

Чтобы вывести заказанный ресурс в топ, ботов отправляют ухудшать поведенческие факторы на сайтах, которые занимают первые строки поисковой выдачи. Здесь они, наоборот, проводят мало времени на страницах и увеличивают показатель отказов.

Чем опасны:

Ваш ресурс может стать одним из тех, который боты пытаются сместить с топовых позиций поиска.

Боты-парсеры

Парсеры (или скрейперы) собирают важные данные со страниц, такие как адреса или контактные данные. В некоторых случаях парсеры воруют контент.

Чем опасны:

Ваш контент может быть украден и опубликован на других ресурсах. Так, статьи и изображения становятся неуникальными, из-за чего падают позиции сайта в поисковиках.

Боты для поиска уязвимостей

Существуют боты, которые анализируют миллионы сайтов и ищут на них уязвимости. Только одни сообщают о проблемах владельцу, а другие — используют информацию в свою пользу.

Чем опасны:

Передают собранную информацию третьему лицу. Тот может продать данные или использовать их для взлома.

Боты загрузки

Боты загрузки предназначены для того, чтобы скачивать материалы с вашего сайта. Например, бесплатные путеводители или полезные чек-листы, которые владельцы сайтов используют в своей маркетинговой стратегии в качестве лид-магнитов.

Чем опасны:

Создают ложное впечатление об эффективности материалов. Предположим, если в вашем путеводителе есть партнёрские ссылки, вы заметите большое количество скачиваний гайда, но число переходов по ссылкам не будет соответствовать вашей средней конверсии. Тогда вы, скорее всего, захотите переработать материал или изменить маркетинговую воронку. Только если число скачиваний накрутили боты, ваша многодневная работа вряд ли улучшит конверсию.

Боты-спамеры

Боты-спамеры заполняют контактные формы, оставляют бессмысленные или рекламные комментарии на сайтах или в социальных сетях, отправляют фишинговые письма.

Чем опасны:

Спамеры быстро надоедают и негативно влияют на репутацию ресурса. Постоянно приходится читать от них письма, отправленные через форму, или модерировать комментарии.

Ботовый трафик с сайта

Клик-боты

Клик-боты имитируют поведение пользователя и, по сути, занимаются мошенничеством. Например, кликают по рекламе на сайте, партнёрским ссылкам и другим инструментам.

Чем опасны:

Если на сайте есть реклама с оплатой за клики, например, баннеры AdSense, РСЯ или партнёрские ссылки по CPC программам, можно получить бан и остаться без выплат за накрутку кликов. Гуляющие клик-боты сильно искажают статистику по партнёрским CPA программам: показов и кликов по инструментам много, а продаж нет.

Как проверить, есть ли на вашем сайте ботовый трафик

1. Изучайте данные систем аналитики

Проект может годами существовать с ботами, а негативный эффект может не проявиться или проявиться не столь заметно. Например, из-за ботового трафика будут постепенно снижаться позиции страниц сайта в выдаче, что приведёт к замедлению развития проекта.

Причём количество ненужных ботов возрастает вместе с ростом сайта. Ресурс становится более трастовым и раскрученным, растёт количество страниц и беклинков и вместе с тем и количество ботов. Поэтому первостепенная задача владельца — обнаружить вредоносный ботовый трафик.

Вычислить количество ботов, подсчитав все обращения без исключения, можно по логам сервера: access.log и так далее. Ботов, работающих на браузерных движках с поддержкой JS, можно увидеть в «Яндекс.Метрике». Елена Шикова, автор блога trip-together.ru рассказала, как она вычислила ботов с помощью «Метрики». Советы Елены подойдут и для анализа данных в Google Analytics. Читайте статью в нашем блоге.

2. Смотрите статистику по партнёрским программам без учёта ботов

Если вы занимаетесь партнёрским маркетингом, учитывайте, что визиты всех ботов попадают в статистику по партнёрским программам. Это искажает представление о конверсии: трудно оценить, сколько реальных людей интересуются контентом и кликают по партнёрским инструментам. Из-за неточной статистики вы можете принять неверное решение о работе с определёнными брендами: посчитаете, что приводите им большой трафик, но получаете недостаточно высокое вознаграждение за свою работу.

Чтобы статистика партнёров была более точной, мы в Travelpayouts сделали уникальный антибот фильтр. Он автоматически исключает ботовый трафик из всех отчётов и статистикам по партнёрским программам. Вы можете подробнее узнать, как работает антибот фича от Travelpayouts в нашей Базе знаний.

Как бороться с ботовым трафиком и когда начинать?

Стоит регулярно проверять трафик на наличие вредоносных ботов и быть готовым в любой момент выставить защиту. Даже если вы пока не замечаете негативного эффекта, вычислите количество ботового трафика. Если он составляет более 25% от всего трафика, то возникает риск получения проблем в «Яндексе» и Google. Это тот самый «порог», когда вам надо срочно позаботиться о защите.

Важно понимать, что избавиться от ботов на 100% не получится. Но существуют простые сервисы, которые помогут значительно сократить их количество: сохранить свой контент, позиции в выдаче, защитить рекламу и ссылки от скликивания.

BotFAQtor

Помогает анализировать посещения и блокировать трафик по источникам, типам визитов и другим критериям. Сервис предлагает защиту от скликивания баннеров, рекламы «Яндекс.Директ» и Google Ads, антибот для сайта и сервис сокращения ссылок.

Достоинства:

- Большой выбор сервисов и возможность покупать дополнительные проверки.

- Плагин для WordPress для быстрой установки BotFAQtor в пару кликов.

- Незаметный фильтр ботов (при входе пользователю не нужно доказывать, что он человек).

Недостатки:

- Падает скорость загрузки страниц.

- При включённой защите от скликивания рекламы замедляется скорость загрузки баннеров.

Сервис предлагает два тарифа: «Стандарт» стоимостью 7 500 рублей в год или VIP за 40 000 рублей в год. Если количества проверок в этих пакетах будет недостаточно, можно купить дополнительные в течение года.

CloudFlare

CloudFlare ориентировочно защищает 30% всех сайтов.

Достоинства:

- Кэширует статику (картинки) у себя, снижая нагрузку на сервер.

- Если настроить 3 простых правила, то получится отличная защита сразу от многих ботов, которые не поддерживают HTTP2. Это примитивные парсеры контента, чекеры уязвимостей, некоторые спамеры.

- При использовании CloudFlare у вас наготове будет защита от DDOS-атак.

- Всё это доступно на бесплатном тарифе. Даже платные сервисы защиты от DDOS-атак в целом не имеют преимуществ по сравнению с CloudFlare.

Недостатки:

- Исключительно из-за специфики российского законодательства: иногда IP от CloudFlare банит РКН.

- CloudFlare вообще не защищает от накрутки поведенческих факторов.

Сервис предлагает множество опций, в том числе бесплатных для личных сайтов и приложений до 50 пользователей. Если вам нужны более мощные функции безопасности, можно подключить платные опции, цены на которые начинаются от $5 в месяц.

AntiBot

«Антибот» помог решить проблему с ботами в блоге Travelpayouts: он установлен с февраля 2021 года и останавливает все виды ботов, включая тех, которые накручивают поведенческие факторы. Его можно использовать совместно с CloudFlare.

При антибот-проверке пользователь при заходе на сайт в течение 1-3 секунд видит страницу, похожую на страницу CloudFlare, затем автоматически проходит дальше. Если человек не прошёл автоматический тест, что случается примерно в 5% случаев, ему нужно просто нажать на кнопку.

Достоинства:

- Простая интеграция и настройка.

- Максимальная защита от ботов, маскирующихся людьми для улучшения поведенческих факторов.

- С «Антиботом» сайты не попадают в бан и не меняют позиции в поисковой выдаче.

- Заглушка переведена на самые популярные языки, а ещё её можно кастомизировать.

- «Антибот» защищает рекламу от скликивания ботами и не мешает её работе. Сайты с «Антиботом» успешно проходят модерацию в Adsense и РСЯ (при настройке: нужно добавить в белый список ботов «Яндекса» и Adsense).

- Если у вас нет опыта в установке скриптов, за дополнительную плату можно приобрести установку и настройку «под ключ».

Недостатки:

- Сайт, на котором стоит «Антибот», не получится рекламировать в Google Ads, так как он не пройдёт модерацию.

- Не обеспечивает защиту от DDOS-атак.

Стоимость «Антибота» зависит от количества доменов и варьируется от $25 до $99 в год. Читателям блога Travelpayouts сервис дарит промокод на +30 дней тестового периода на 1 домене и всех его поддоменах. Купон TP2022 будет работать при регистрации до 1 сентября 2023 года.

Сталкивались ли вы с ботами? Расскажите в комментариях, как они повлияли на ваш проект и как вы с ними боретесь.

Вы сделали лендинг с крутым продуктом. Запустили на него трафик и вот, первые результаты. Более 3 000 показов, но количество кликов по вашей СТА-кнопке стремится к уровню Марианской впадины.

Почему же так вышло?

Возможно, несколько людей по ошибке кликнули и перешли. Несколько, но откуда взялись остальные клики?

Скорее всего вы столкнулись с таким явлением, как бот-трафик. Ведь партнерский маркетинг — это постоянная конкуренция.

— Адверты хотят получить больше денег за счет источников платного трафика и паблишеров;

— Паблишеры занимаются тем же в отношении адвертов и источников трафика;

— Источники платного трафика заинтересованы в заработке на адвертах и паблишерах.

Часто в результате этого противостояния конкуренты используют нечестные методы. В этой статье мы разберем, как бороться с ботами и сохранить бюджет.

О паблишерах

Паблишер — это владелец веб-сайта. Естественно, он хочет получить как можно больше денежных средств с тех, кто покупает рекламу на его ресурсе. Для этого, помимо обычных путей, они прибегают к уловкам.

Веб-мастер пишет скрипт для специального бота, который автоматически будет посещать его сайт. В ходе этого путешествия он скликивает рекламные объявления на ресурсе. После этого, бот уходит со страницы. Источник трафика видит переход и берет оплату за показы рекламы. Далее, источник трафика отдает процент веб-мастеру, а остальное забирает себе. Адверт в проигрыше.

Существуют «хорошие» и «плохие» боты. Более подробно об этом мы расскажем в наших следующих статьях. А пока проверьте, есть ли у вас файл robots.txt. Он не допустит ботов на ваш лендинг.

Как обнаружить ботов и бороться с ними?

CTR

Проверьте свою статистику тщательно. Один из признаков бот-трафика это большое количество трафика при нулевом CTR. Перед этим необходимо изучить свою нишу и узнать оптимальные для нее показатели конверсии.

Также, можно поставить расширенную фильтрацию в Яндекс.Метрике. Это немного упростит задачу по борьбе с ботами.Сервисы

Существуют не просто сервисы, а целые компанию, которые помогают эффективно бороться с «мертвым» трафиком и результат не заставит себя долго ждать. Цены на их услуги варьируются от небольших до совсем не дешевых.

Пример такого сервиса — ClickFrog.

Этот сервис знает несколько сотен технических характеристик ботов. Именно по ним он вычисляет нарушителей трафика и автоматически заносит в блек-лист. При этом, он отправляет его в Яндекс и Google, тем самым исключая вашу рекламу для данного адреса.

Ловушки

Большинство ботов запрограммировано лишь кликать по ссылкам. Именно поэтому их можно легко поймать. Как это сделать?

— Ставим маленькую ссылку на изображении вашего лендинга. Такую, чтобы человек не заметил;

— Размещаем ее перед тегом </body> Сделать это нужно в самой нижней части лендинга;

— Всех кликнувших по этой ссылке заносим в блек-лист.

Важно

В блек-лист кидаем только ту, которая не приносит прибыли вообще. Если есть бот-трафик, но он не мешает добывать деньги, то смело оставляем и зарабатываем дальше.

Код для вставки перед тегом </body>:

<a href=”http://yourvoluumlink.com/click3/”>

<img src=”http://yourdomain.com/4×5-pixel.png”/>

</a>

Перенаправление

Вы можете отправлять ботов с вашего лендинга на другую пустую страницу. Этот метод позволяет с большой точностью разделить «живой» и «мертвый» трафик.

Большинство ботов читает лишь HTML, соответственно и переходить они будут по этим ссылкам. Делаем пустой лендинг. Вставляем на него сссылку. Именно она и приведет людей на вашу настоящую страницу, а боты ее не заметят.

На пустом лендинге внутри тегов <head> будет:

<script type=’text/javascript’>

function bottrap(){

window.location.replace(‘http://YourVoluumLink.com/click/1’);

}

</script>

Прописываем свою Voluum ccылку.

Меняем тэг <body> кодом:

<body onload = «setTimeout (bottrap, 200);»>

Это перенаправит на ваш лендинг через 200 миллисекунд реальных пользователей.

CSP модель

Это система, в которой вы платите не за показ рекламы на ресурсе, а за осуществленные продажи. Большим недостатком этой схемы является крайне высокая стоимость лидов. К тому же, потребуется очень глубокая интеграция.

Трафик для приманки

Некоторые мастера специально запускают рекламу и покупают для нее самый дешевый трафик. Это служит ловушкой для ботов. Попадаясь один раз, они навсегда оказываются в черном списке. Таким образом, арбитражники расчищают себе поле деятельности.

И напоследок

Не стоит забывать про самый простой метод. Если вы обнаружили факт бот-трафика, можете смело писать в Яндекс и Google. Эти компании активно борются с таким явлением и, наверняка, вам вернут потраченные впустую деньги.

Абсолютной защиты не существует

Но используя эти методы, есть шанс уменьшить «мертвый» трафик в разы. Иначе, львиную долю вашего бюджета заберут боты.

характеру их поведения на сайте. И хотя она все еще находится в разработке, но вы уже можете начать использовать ее. Код библиотеки доступен на Github по ссылке. В настоящее время я тестирую новую технику обнаружения, не стесняйтесь оспаривать ее эффективность и целесообразность работы над ней, а также писать мне.

Содержание

- Что представляет собой headless браузер?

- Зачем может понадобится определять загрузку страницы headless браузером?

- User agent

- Plugins

- Languages

- WebGL

- Browser features

- Отсутствующие изображения

Headless браузер – это браузер без графического интерфейса, который используется для загрузки и обработки содержимого веб-страниц. Им можно программно управлять для автоматизации выполнения различных задач, таких как выполнение тестов или создания скриншотов веб-страниц.

Зачем может понадобится определять загрузку страницы headless браузером?

Помимо этих двух вполне безобидных вариантов использования, упомянутых нами выше, headless браузер также может использоваться для вредоносных целей. Наиболее частым случаем его такого использования это парсинг веб-страниц, увеличение количества показов рекламы или поиск уязвимостей на веб-сайте.

До сих пор одним из самых популярных headless браузеров был PhantomJS. И поскольку он разработан основе платформы Qt, то это подразумевает наличия большого числа отличий от популярных браузеров. Как будет показано в этом посте ниже, его можно обнаружить с помощью некоторых достаточно простых методов.

Начиная с версии 59, Google выпустила headless версию своего браузера Chrome. В отличие от PhantomJS, он основан на обычном Chrome, а не другой платформе, что затрудняет обнаружение его присутствия на сайте.

User agent

Начнем с пользовательского агента, который является атрибутом, значение которого обычно используется для определения ОС, а также браузера пользователя. И может принимать следующее значения: Mozilla/5.0 (X11; Linux x86_64), AppleWebKit/537.36 (KHTML, like Gecko), HeadlessChrome/59.0.3071.115, Safari/537.36.

Следующий фрагмент кода, позволяет определить присутствие headless Chrome:

if (/HeadlessChrome/.test(window.navigator.userAgent)) {

console.log("Chrome headless detected");

}

Тип пользовательского агента можно также определить из содержимого HTTP заголовков. Однако подменить его наименование злоумышленнику для обоих случаев простая тривиальная задача.

Plugins

Обращение к свойству navigator.plugins возвращает массив подключаемых в браузере плагинов. Обычно в Chrome мы находим плагины в любом случае подключаемые по умолчанию, например, такие как Chrome PDF viewer или Google Native Client. И напротив, в headlessрежиме, возвращаемый массив не содержит ни одного плагина.

if(navigator.plugins.length == 0) {

console.log("It may be Chrome headless");

}

Languages

В Chrome средства Javascript позволяют получить значение двух атрибутов, содержащих значения, определяющие языки, используемые пользователем браузера: navigator.languageи navigator.languages. Первый атрибут содержит значение, определяющее язык пользовательского интерфейса браузера, а второй — это массив строк, представляющих предпочтительные для пользователя языки. Однако в headless режиме свойство navigator.languages возвращает пустую строку.

if(navigator.languages == "") {

console.log("Chrome headless detected");

}

WebGL

WebGL, предоставляет API для отображения результатов 3D-рендеринга на холсте HTML canvas. С помощью этого API можно запросить возможности графического процессора, а также его средств визуализации.

В Linux с обычным Chrome я получаю следующие значения для средства визуализации и рендера: Google SwiftShader и Google Inc.. В headless режиме используется Mesa OffScreen, технология, применяющаяся для рендеринга без использования какой-либо window system, и Brian Paul, программа с открытым исходным кодом, которая запускает графическую библиотеки Mesa.

var canvas = document.createElement('canvas');

var gl = canvas.getContext('webgl');

var debugInfo = gl.getExtension('WEBGL_debug_renderer_info');

var vendor = gl.getParameter(debugInfo.UNMASKED_VENDOR_WEBGL);

var renderer = gl.getParameter(debugInfo.UNMASKED_RENDERER_WEBGL);

if(vendor == "Brian Paul" && renderer == "Mesa OffScreen") {

console.log("Chrome headless detected");

}

Тем не менее не все Chrome headless будут иметь одинаковые значения для рендера и средства визуализации. Другие сохраняют значения, которые также можно найти в headless версии браузера. Тем не менее, наличие значений Mesa Offscreen и Brian Paul явно указывают на использвание headless версии.

Browser features

Библиотека Modernizr позволяет проверить, присутствует ли в браузере широкий спектр новых возможностей HTML5 и CSS3. Единственная разница, которую мы можем обнаружить между Chrome и headless Chrome, заключается в том, что последний не имеет hairline функциональности, которая определяет поддержку hidpi для retina экранов устройств.

if(!Modernizr["hairline"]) {

console.log("It may be Chrome headless");

}

Отсутствующие изображения

И наконец, рассмотрим последний метод для обнаружения ботов, который является, с моей точки зрения, наиболее надежным. Он основан на вычислении браузером Chrome размера изображения, используемого в случае если изображение не может быть загружено.

В случае простого браузера Chrome изображение будет иметь ширину и высоту, которые зависят от масштаба окна браузера, но отличны от нуля. В headless Chrome изображение будет иметь ширину и высоту равную нулю.

var body = document.getElementsByTagName("body")[0];

var image = document.createElement("img");

image.src = "http://iloveponeydotcom32188.jg";

image.setAttribute("id", "fakeimage");

body.appendChild(image);

image.onerror = function(){

if(image.width == 0 && image.height == 0) {

console.log("Chrome headless detected");

}

}