Сегодня каждый из нас не представляет жизнь без компьютера. Компьютер — это устройство, которое может работать с разными видами данных (текстовыми, графическими, звуковыми). Чтобы эти данные компьютер мог сохранить, обработать, передать, они должны быть представлены в цифровом виде. Данные в компьютере хранятся, обрабатываются, передаются в двоичном коде.

Двоичный код — это строка символов, состоящих из (0) и (1).

Как и каждый язык (формальный или естественный), двоичный код имеет свой алфавит и мощность алфавита.

Алфавит, который состоит из двух символов, называется двоичным алфавитом.

Мощность алфавита — это количество символов, которые в него входят.

Запись информации с помощью двоичного алфавита называют двоичным кодированием.

Почему именно (0) и (1)? Потому что в технике проще всего реализовать такие наборы цифр: если есть сигнал, то это (1), если нет — это (0).

Двоичная система кодирования появилась не с созданием компьютера, ещё задолго до этого математик Г. В. Лейбниц использовал двоичные числа.

Рис. (1). Портрет Г. В. Лейбница

В своей бинарной (двоичной) арифметике Лейбниц видел прообраз творения. Ему представлялось, что единица представляет божественное начало, а нуль — небытие, и что Высшее Существо создаёт все сущее из небытия точно таким же образом, как единица и нуль в его системе выражают все числа.

Существуют ряд устройств, работающих по принципу двоичного кодирования. Например, обычный выключатель, где свет горит/не горит.

Всем известная азбука Морзе тоже состоит из двух знаков: точки и тире.

Рис. (2). Алфавит азбуки Морзе

Память компьютера можно представить в виде листочка в клетку, и в каждой клетке хранится либо (1), либо (0).

Рис. (3). Представление битов памяти

Что же происходит, когда мы нажимаем на клавиатуре цифру, например (5)?

Каждая клавиша имеет свой порядковый номер (по кодировочной таблице), и именно он переводится в двоичный код.

Рис. (4). Схема двоичного кодирования

Как узнать, сколько бит (клеточек) в памяти компьютера необходимо для кодирования различных знаков?

Как кодируются числа при помощи двоичного кодирования?

Пусть нам нужно закодировать две цифры — (0) и (1). Для кодирования этих цифр нужно (2) ячейки памяти, в одну напишем (0), а в другую — (1).

А если цифр больше? Сколько битов нужно для кодирования каждой цифры? Рассмотрим, как закодировать (4) цифры.

Если будем использовать однозначные числа, то хватит только для кодирования (2) цифр, а нам нужно больше. Попробуем сделать коды двузначными:

(0) — (00),

(1) — (01),

(2) — (10),

(3) — (11).

Цепочка из двух символов достаточна для кодирования (4) знаков, а если нужно закодировать (8) знаков? Попробуем увеличить длину цепочки:

(0) — (000),

(1) — (001),

(2) — (010),

(3) — (011),

(4) — (100),

(5) — (101),

(6) — (110),

(7) — (111).

Получается, если цифр будет (16), то длина цепочки будет (4)?

Длина цепочки знаков в двоичном коде называется разрядностью двоичного кода.

Рассмотри таблицу.

| Разрядность двоичного кода |

(1) |

(2) |

(3) |

(4) |

(5) |

(6) |

(7) |

(8) |

(9) |

(10) |

|

Количество цифр (комбинаций), которые можно закодировать |

(2) |

(4) |

(8) |

(16) |

(32) |

(64) |

(128) |

(256) |

(512) |

(1024) |

Проанализировав таблицу, можно увидеть зависимость между разрядностью и количеством цифр.

Чтобы получить коды для (2) цифр, нужно взять цепочку из (1) знака, чтобы получить (4) цифры, нужно взять цепочку из (2) знаков, чтобы получить (8) цифр, нужно взять цепочку из (3) знаков и т. д.

(2 = 2);

(4 = 2·2);

(8 = 2·2·2);

(16 = 2·2·2·2);

(32 = 2·2·2·2·2).

Из математики ты знаешь, что степень показывает количество множителей числа на само себя.

Если обозначить количество цифр (комбинаций) через (N), а степень — через (i), получим формулу:

N=2i

.

Задача (1). Определи, сколько нужно знаков для кодирования (11) цифр?

Решение: посмотри в таблицу.

Число (8<11<16), значит, цепочка из (3) символов нам не подходит, а вот цепочки из (4) символов нам достаточно.

Проверим:

(0) — (0000), (1) — (0001), (2) — (0010), (3) — (0011), (4) — (0100), (5) — (0101), (6) — (0110), (7) — (0111), (8) — (1000), (9) — (1001), (10) — (1010), (11) — (1011).

Задача (2). Определи, сколько можно составить различных последовательностей, если длина цепочки (6) символов?

Решение: для решения воспользуемся таблицей.

Если длина цепочки (разрядность двоичного кода) равна (6), следовательно, можно закодировать (64) различные последовательности.

Источники:

Цитата с сайта https://www.livelib.ru/quote/1343718-chto-takoe-matematika-kurant-r-robbins-g (Дата обращения: 14.11.2021.)

Рис. 1. Портрет Г. В.Лейбница By Christoph Bernhard Francke – Herzog Anton Ulrich-Museum Braunschweig, Public Domain, https://commons.wikimedia.org/w/index.php?curid=57268659 (Дата обращения: 14.11.2021.)

Рис. 2. Алфавит азбуки Морзе. © ЯКласс.

Рис. 3. Представление битов памяти. © ЯКласс.

Рис. 4. Схема двоичного кодирования. © ЯКласс.

Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 17 февраля 2023 года; проверки требуют 4 правки.

Слово «Wikipedia», закодированное двоичным ASCII-кодом.

Двои́чный код — это способ представления данных в виде кода, в котором каждый разряд принимает одно из двух возможных значений, обычно обозначаемых цифрами 0 и 1. Разряд в этом случае называется двоичным разрядом.

В случае обозначения цифрами «0» и «1», возможные состояния двоичного разряда наделяются качественным соотношением «1» > «0» и количественными значениями чисел «0» и «1».

Двоичный код может быть непозиционным и позиционным. Позиционный двоичный код лежит в основе двоичной системы счисления, широко распространенной в современной цифровой технике.

Описание[править | править код]

Из комбинаторики известно, что, в случае непозиционного кода, количество комбинаций (кодов) n-разрядного кода является числом сочетаний с повторениями, равно биномиальному коэффициенту:

, [возможных состояний (кодов)], где:

В двоичной системе кодирования (n=2) количество возможных состояний (кодов) равно :

, [возможных состояний (кодов)], то есть

описывается линейной функцией:

, [возможных состояний (кодов)], где

Например, в одном 8-битном байте (k=8) количество возможных состояний (кодов) равно:

, [возможных состояний (кодов)].

В случае позиционного кода, число комбинаций (кодов) k-разрядного двоичного кода равно числу размещений с повторениями:

, где

Используя два двоичных разряда можно закодировать четыре различные комбинации: 00 01 10 11, три двоичных разряда — восемь: 000 001 010 011 100 101 110 111, и так далее.

При увеличении разрядности позиционного двоичного кода на 1, количество различных комбинаций в позиционном двоичном коде удваивается.

Двоичные коды являются комбинациями двух элементов и не являются двоичной системой счисления, но используются в ней как основа. Двоичный код также может использоваться для кодирования чисел в системах счисления с любым другим основанием. Пример: в двоично-десятичном кодировании (BCD) используется двоичный код для кодирования чисел в десятичной системе счисления.

При кодировании алфавитноцифровых символов (знаков) двоичному коду не приписываются весовые коэффициенты, как это делается в системах счисления, в которых двоичный код используется для представления чисел, а используется только порядковый номер кода из множества размещений с повторениями.

В системах счисления k-разрядный двоичный код, (k-1)-разрядный двоичный код, (k-2)-разрядный двоичный код и т. д. могут отображать одно и то же число. Например, 0001, 001, 01, 1 — одно и то же число — «1» в двоичных кодах с разным числом разрядов — k.

Примеры двоичных чисел[править | править код]

В таблице показаны первые 16 двоичных чисел и их соответствие десятичным и шестнадцатиричным числам.

| Десятичное число | Шестнадцатеричное число | Двоичное число |

|---|---|---|

| 0 | 0 | 0000 |

| 1 | 1 | 0001 |

| 2 | 2 | 0010 |

| 3 | 3 | 0011 |

| 4 | 4 | 0100 |

| 5 | 5 | 0101 |

| 6 | 6 | 0110 |

| 7 | 7 | 0111 |

| 8 | 8 | 1000 |

| 9 | 9 | 1001 |

| 10 | A | 1010 |

| 11 | B | 1011 |

| 12 | C | 1100 |

| 13 | D | 1101 |

| 14 | E | 1110 |

| 15 | F | 1111 |

Примеры «доисторического» использования кодов[править | править код]

- Инки имели свою счётную систему кипу, известную с III тысячелетия до н. э, которая физически представляла собой верёвочные сплетения и узелки. В 2006 году американский исследователь Гэри Уртон[en] обнаружил, что в узелках заложен некий код, более всего похожий на двоичную систему счисления[1]. Их код допускает 27=128 вариаций.

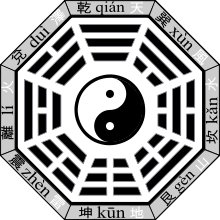

- Древнекитайская система гадания основанная на гексаграммах была описана в Книге Перемен датируемый ок. 700 г. до. н. э.. Их код допускает 26=64 вариации.

См. также[править | править код]

- Троичный код

- Двоичная система счисления

- Унитарный код

Примечания[править | править код]

- ↑ Инки изобрели двоичный код за 500 лет до компьютера. Дата обращения: 1 мая 2020. Архивировано 10 марта 2016 года.

From Wikipedia, the free encyclopedia

For the binary form of computer software, see Machine code.

The word ‘Wikipedia’ represented in ASCII binary code, made up of 9 bytes (72 bits).

A binary code represents text, computer processor instructions, or any other data using a two-symbol system. The two-symbol system used is often “0” and “1” from the binary number system. The binary code assigns a pattern of binary digits, also known as bits, to each character, instruction, etc. For example, a binary string of eight bits (which is also called a byte) can represent any of 256 possible values and can, therefore, represent a wide variety of different items.

In computing and telecommunications, binary codes are used for various methods of encoding data, such as character strings, into bit strings. Those methods may use fixed-width or variable-width strings. In a fixed-width binary code, each letter, digit, or other character is represented by a bit string of the same length; that bit string, interpreted as a binary number, is usually displayed in code tables in octal, decimal or hexadecimal notation. There are many character sets and many character encodings for them.

A bit string, interpreted as a binary number, can be translated into a decimal number. For example, the lower case a, if represented by the bit string 01100001 (as it is in the standard ASCII code), can also be represented as the decimal number “97”.

History of binary codes[edit]

The modern binary number system, the basis for binary code, was invented by Gottfried Leibniz in 1689 and appears in his article Explication de l’Arithmétique Binaire. The full title is translated into English as the “Explanation of the binary arithmetic”, which uses only the characters 1 and 0, with some remarks on its usefulness, and on the light it throws on the ancient Chinese figures of Fu Xi.[1] Leibniz’s system uses 0 and 1, like the modern binary numeral system. Leibniz encountered the I Ching through French Jesuit Joachim Bouvet and noted with fascination how its hexagrams correspond to the binary numbers from 0 to 111111, and concluded that this mapping was evidence of major Chinese accomplishments in the sort of philosophical visual binary mathematics he admired.[2][3] Leibniz saw the hexagrams as an affirmation of the universality of his own religious belief.[3]

Binary numerals were central to Leibniz’s theology. He believed that binary numbers were symbolic of the Christian idea of creatio ex nihilo or creation out of nothing.[4] Leibniz was trying to find a system that converts logic verbal statements into a pure mathematical one[citation needed]. After his ideas were ignored, he came across a classic Chinese text called I Ching or ‘Book of Changes’, which used 64 hexagrams of six-bit visual binary code. The book had confirmed his theory that life could be simplified or reduced down to a series of straightforward propositions. He created a system consisting of rows of zeros and ones. During this time period, Leibniz had not yet found a use for this system.[5]

Binary systems predating Leibniz also existed in the ancient world. The aforementioned I Ching that Leibniz encountered dates from the 9th century BC in China.[6] The binary system of the I Ching, a text for divination, is based on the duality of yin and yang.[7] Slit drums with binary tones are used to encode messages across Africa and Asia.[7] The Indian scholar Pingala (around 5th–2nd centuries BC) developed a binary system for describing prosody in his Chandashutram.[8][9]

The residents of the island of Mangareva in French Polynesia were using a hybrid binary-decimal system before 1450.[10] In the 11th century, scholar and philosopher Shao Yong developed a method for arranging the hexagrams which corresponds, albeit unintentionally, to the sequence 0 to 63, as represented in binary, with yin as 0, yang as 1 and the least significant bit on top. The ordering is also the lexicographical order on sextuples of elements chosen from a two-element set.[11]

In 1605 Francis Bacon discussed a system whereby letters of the alphabet could be reduced to sequences of binary digits, which could then be encoded as scarcely visible variations in the font in any random text.[12] Importantly for the general theory of binary encoding, he added that this method could be used with any objects at all: “provided those objects be capable of a twofold difference only; as by Bells, by Trumpets, by Lights and Torches, by the report of Muskets, and any instruments of like nature”.[12]

George Boole published a paper in 1847 called ‘The Mathematical Analysis of Logic’ that describes an algebraic system of logic, now known as Boolean algebra. Boole’s system was based on binary, a yes-no, on-off approach that consisted of the three most basic operations: AND, OR, and NOT.[13] This system was not put into use until a graduate student from Massachusetts Institute of Technology, Claude Shannon, noticed that the Boolean algebra he learned was similar to an electric circuit. In 1937, Shannon wrote his master’s thesis, A Symbolic Analysis of Relay and Switching Circuits, which implemented his findings. Shannon’s thesis became a starting point for the use of the binary code in practical applications such as computers, electric circuits, and more.[14]

Other forms of binary code[edit]

The bit string is not the only type of binary code: in fact, a binary system in general, is any system that allows only two choices such as a switch in an electronic system or a simple true or false test.

Braille[edit]

Braille is a type of binary code that is widely used by the blind to read and write by touch, named for its creator, Louis Braille. This system consists of grids of six dots each, three per column, in which each dot has two states: raised or not raised. The different combinations of raised and flattened dots are capable of representing all letters, numbers, and punctuation signs.

Bagua [edit]

The bagua are diagrams used in feng shui, Taoist cosmology and I Ching studies. The ba gua consists of 8 trigrams; bā meaning 8 and guà meaning divination figure. The same word is used for the 64 guà (hexagrams). Each figure combines three lines (yáo) that are either broken (yin) or unbroken (yang). The relationships between the trigrams are represented in two arrangements, the primordial, “Earlier Heaven” or “Fuxi” bagua, and the manifested, “Later Heaven,”or “King Wen” bagua.[15] (See also, the King Wen sequence of the 64 hexagrams).

Ifá, Ilm Al-Raml and Geomancy[edit]

The Ifá/Ifé system of divination in African religions, such as of Yoruba, Igbo, and Ewe, consists of an elaborate traditional ceremony producing 256 oracles made up by 16 symbols with 256 = 16 x 16. An initiated priest, or Babalawo, who had memorized oracles, would request sacrifice from consulting clients and make prayers. Then, divination nuts or a pair of chains are used to produce random binary numbers,[16] which are drawn with sandy material on an “Opun” figured wooden tray representing the totality of fate.

Through the spread of Islamic culture, Ifé/Ifá was assimilated as the “Science of Sand” (ilm al-raml), which then spread further and became “Science of Reading the Signs on the Ground” (Geomancy) in Europe.

This was thought to be another possible route from which computer science was inspired,[17] as Geomancy arrived at Europe at an earlier stage (about 12th Century, described by Hugh of Santalla) than I Ching (17th Century, described by Gottfried Wilhelm Leibniz).

Coding systems[edit]

ASCII code[edit]

The American Standard Code for Information Interchange (ASCII), uses a 7-bit binary code to represent text and other characters within computers, communications equipment, and other devices. Each letter or symbol is assigned a number from 0 to 127. For example, lowercase “a” is represented by 1100001 as a bit string (which is “97” in decimal).

Binary-coded decimal[edit]

Binary-coded decimal (BCD) is a binary encoded representation of integer values that uses a 4-bit nibble to encode decimal digits. Four binary bits can encode up to 16 distinct values; but, in BCD-encoded numbers, only ten values in each nibble are legal, and encode the decimal digits zero, through nine. The remaining six values are illegal and may cause either a machine exception or unspecified behavior, depending on the computer implementation of BCD arithmetic.

BCD arithmetic is sometimes preferred to floating-point numeric formats in commercial and financial applications where the complex rounding behaviors of floating-point numbers is inappropriate.[18]

Early uses of binary codes[edit]

- 1875: Émile Baudot “Addition of binary strings in his ciphering system,” which, eventually, led to the ASCII of today.

- 1884: The Linotype machine where the matrices are sorted to their corresponding channels after use by a binary-coded slide rail.

- 1932: C. E. Wynn-Williams “Scale of Two” counter[19]

- 1937: Alan Turing electro-mechanical binary multiplier

- 1937: George Stibitz “excess three” code in the Complex Computer[19]

- 1937: Atanasoff–Berry Computer[19]

- 1938: Konrad Zuse Z1

Current uses of binary[edit]

Most modern computers use binary encoding for instructions and data. CDs, DVDs, and Blu-ray Discs represent sound and video digitally in binary form. Telephone calls are carried digitally on long-distance and mobile phone networks using pulse-code modulation, and on voice over IP networks.

Weight of binary codes[edit]

The weight of a binary code, as defined in the table of constant-weight codes,[20] is the Hamming weight of the binary words coding for the represented words or sequences.

See also[edit]

- Binary number

- List of binary codes

- Binary file

- Unicode

- Gray code

References[edit]

- ^ Leibniz G., Explication de l’Arithmétique Binaire, Die Mathematische Schriften, ed. C. Gerhardt, Berlin 1879, vol.7, p.223; Engl. transl.[1]

- ^ Aiton, Eric J. (1985). Leibniz: A Biography. Taylor & Francis. pp. 245–8. ISBN 978-0-85274-470-3.

- ^ a b J.E.H. Smith (2008). Leibniz: What Kind of Rationalist?: What Kind of Rationalist?. Springer. p. 415. ISBN 978-1-4020-8668-7.

- ^ Yuen-Ting Lai (1998). Leibniz, Mysticism and Religion. Springer. pp. 149–150. ISBN 978-0-7923-5223-5.

- ^ “Gottfried Wilhelm Leibniz (1646 – 1716)”. www.kerryr.net.

- ^ Edward Hacker; Steve Moore; Lorraine Patsco (2002). I Ching: An Annotated Bibliography. Routledge. p. 13. ISBN 978-0-415-93969-0.

- ^ a b Jonathan Shectman (2003). Groundbreaking Scientific Experiments, Inventions, and Discoveries of the 18th Century. Greenwood Publishing. p. 29. ISBN 978-0-313-32015-6.

- ^ Sanchez, Julio; Canton, Maria P. (2007). Microcontroller programming: the microchip PIC. Boca Raton, Florida: CRC Press. p. 37. ISBN 978-0-8493-7189-9.

- ^ W. S. Anglin and J. Lambek, The Heritage of Thales, Springer, 1995, ISBN 0-387-94544-X

- ^ Bender, Andrea; Beller, Sieghard (16 December 2013). “Mangarevan invention of binary steps for easier calculation”. Proceedings of the National Academy of Sciences. 111 (4): 1322–1327. doi:10.1073/pnas.1309160110. PMC 3910603. PMID 24344278.

- ^ Ryan, James A. (January 1996). “Leibniz’ Binary System and Shao Yong’s “Yijing”“. Philosophy East and West. 46 (1): 59–90. doi:10.2307/1399337. JSTOR 1399337.

- ^ a b Bacon, Francis (1605). “The Advancement of Learning”. London. pp. Chapter 1.

- ^ “What’s So Logical About Boolean Algebra?”. www.kerryr.net.

- ^ “Claude Shannon (1916 – 2001)”. www.kerryr.net.

- ^ Wilhelm, Richard (1950). The I Ching or Book of Changes. trans. by Cary F. Baynes, foreword by C. G. Jung, preface to 3rd ed. by Hellmut Wilhelm (1967). Princeton, NJ: Princeton University Press. pp. 266, 269. ISBN 978-0-691-09750-3.

- ^ Olupona, Jacob K. (2014). African Religions: A Very Short Introduction. Oxford: Oxford University Press. p. 45. ISBN 978-0-19-979058-6. OCLC 839396781.

- ^ Eglash, Ron (June 2007). “The fractals at the heart of African designs”. www.ted.com. Archived from the original on 2021-07-27. Retrieved 2021-04-15.

- ^ Cowlishaw, Mike F. (2015) [1981,2008]. “General Decimal Arithmetic”. IBM. Retrieved 2016-01-02.

- ^ a b c Glaser 1971

- ^ Table of Constant Weight Binary Codes

External links[edit]

- Sir Francis Bacon’s BiLiteral Cypher system, predates binary number system.

- Weisstein, Eric W. “Error-Correcting Code”. MathWorld.

- Table of general binary codes. An updated version of the tables of bounds for small general binary codes given in M.R. Best; A.E. Brouwer; F.J. MacWilliams; A.M. Odlyzko; N.J.A. Sloane (1978), “Bounds for Binary Codes of Length Less than 25”, IEEE Trans. Inf. Theory, 24: 81–93, CiteSeerX 10.1.1.391.9930, doi:10.1109/tit.1978.1055827.

- Table of Nonlinear Binary Codes. Maintained by Simon Litsyn, E. M. Rains, and N. J. A. Sloane. Updated until 1999.

- Glaser, Anton (1971). “Chapter VII Applications to Computers”. History of Binary and other Nondecimal Numeration. Tomash. ISBN 978-0-938228-00-4. cites some pre-ENIAC milestones.

Информатика

7 класс

Урок № 5

Кодирование информации. Двоичный код

Перечень вопросов, рассматриваемых в теме:

- Понятие код.

- Понятие кодирования информации.

- Двоичный код.

Тезаурус:

Дискретизация информации – процесс преобразования информации из непрерывной формы представления в дискретную. Чтобы представить информацию в дискретной форме, её следует выразить с помощью символов какого-нибудь естественного или формального языка.

Алфавит языка – конечный набор отличных друг от друга символов, используемых для представления информации. Мощность алфавита – это количество входящих в него символов.

Алфавит, содержащий два символа, называется двоичным алфавитом. Представление информации с помощью двоичного алфавита называют двоичным кодированием. Двоичное кодирование универсально, так как с его помощью может быть представлена любая информация.

Основная литература:

1. Босова Л. Л. Информатика: 7 класс. // Босова Л. Л., Босова А. Ю. – М.: БИНОМ, 2017. – 226 с.

Дополнительная литература:

- Босова Л. Л. Информатика: 7–9 классы. Методическое пособие. // Босова Л. Л., Босова А. Ю., Анатольев А. В., Аквилянов Н.А. – М.: БИНОМ, 2019. – 512 с.

- Босова Л. Л. Информатика. Рабочая тетрадь для 7 класса. Ч 1. // Босова Л. Л., Босова А. Ю. – М.: БИНОМ, 2019. – 160 с.

- Босова Л. Л. Информатика. Рабочая тетрадь для 7 класса. Ч 2. // Босова Л. Л., Босова А. Ю. – М.: БИНОМ, 2019. – 160 с.

- Гейн А. Г. Информатика: 7 класс. // Гейн А. Г., Юнерман Н. А., Гейн А.А. – М.: Просвещение, 2012. – 198 с.

Теоретический материал для самостоятельного изучения

Кодирование информации

Для решения своих задач человеку часто приходится преобразовывать имеющуюся информацию из одной формы представления в другую. Например, при чтении вслух происходит преобразование информации из дискретной (текстовой) формы в непрерывную (звук). Во время диктанта на уроке русского языка, наоборот, происходит преобразование информации из непрерывной формы (голос учителя) в дискретную (записи учеников).

Информация, представленная в дискретной форме, значительно проще для передачи, хранения или автоматической обработки. Поэтому в компьютерной технике большое внимание уделяется методам преобразования информации из непрерывной формы в дискретную.

Дискретизация информации – процесс преобразования информации из непрерывной формы представления в дискретную.

Рассмотрим суть процесса дискретизации информации на примере.

На метеорологических станциях имеются самопишущие приборы для непрерывной записи атмосферного давления. Результатом их работы являются барограммы – кривые, показывающие, как изменялось давление в течение длительных промежутков времени. Одна из таких кривых, вычерченная прибором в течение семи часов проведения наблюдений, показана на рисунке 1.

На основании полученной информации можно построить таблицу, содержащую показания прибора в начале измерений и на конец каждого часа наблюдений.

Полученная таблица даёт не совсем полную картину того, как изменялось давление за время наблюдений: например, не указано самое большое значение давления, имевшее место в течение четвёртого часа наблюдений. Но если занести в таблицу значения давления, наблюдаемые каждые полчаса или 15 минут, то новая таблица будет давать более полное представление о том, как изменялось давление.

Таким образом, информацию, представленную в непрерывной форме (барограмму, кривую), мы с некоторой потерей точности преобразовали в дискретную форму (таблицу).

В дальнейшем вы познакомитесь со способами дискретного представления звуковой и графической информации.

Двоичное кодирование

В общем случае, чтобы представить информацию в дискретной форме, её следует выразить с помощью символов какого-нибудь естественного или формального языка. Таких языков тысячи. Каждый язык имеет свой алфавит.

Алфавит – конечный набор отличных друг от друга символов (знаков), используемых для представления информации. Мощность алфавита – это количество входящих в него символов (знаков).

Алфавит, содержащий два символа, называется двоичным алфавитом (рис. 3). Представление информации с помощью двоичного алфавита называют двоичным кодированием. Закодировав таким способом информацию, мы получим её двоичный код.

Рассмотрим в качестве символов двоичного алфавита цифры 0 и 1. Покажем, что любой алфавит можно заменить двоичным алфавитом. Прежде всего, присвоим каждому символу рассматриваемого алфавита порядковый номер. Номер представим с помощью двоичного алфавита. Полученный двоичный код будем считать кодом исходного символа.

Если мощность исходного алфавита больше двух, то для кодирования символа этого алфавита потребуется не один, а несколько двоичных символов. Другими словами, порядковому номеру каждого символа исходного алфавита будет поставлена в соответствие цепочка (последовательность) из нескольких двоичных символов. Правило получения двоичных кодов для символов алфавита мощностью больше двух можно представить схемой на рисунке.

Двоичные символы (0,1) здесь берутся в заданном алфавитном порядке и размещаются слева направо. Двоичные коды (цепочки символов) читаются сверху вниз. Все цепочки (кодовые комбинации) из двух двоичных символов позволяют представить четыре различных символа произвольного алфавита:

Цепочки из трёх двоичных символов получаются дополнением двухразрядных двоичных кодов справа символом 0 или 1. В итоге кодовых комбинаций из трёх двоичных символов получается 8 – вдвое больше, чем из двух двоичных символов:

Соответственно, четырёхразрядный двоичный код позволяет получить 16 кодовых комбинаций, пятиразрядный – 32, шестиразрядный – 64 и т. д.

Длину двоичной цепочки – количество символов в двоичном коде – называют разрядностью двоичного кода.

Обратите внимание, что:

4 = 2 ∙ 2,

8 = 2 ∙ 2 ∙ 2,

16 = 2 ∙ 2 ∙ 2 ∙ 2,

32 = 2 ∙ 2 ∙ 2 ∙ 2 ∙ 2 и т. д.

Здесь количество кодовых комбинаций представляет собой произведение некоторого количества одинаковых множителей, равного разрядности двоичного кода.

Если количество кодовых комбинаций обозначить буквой N, а разрядность двоичного кода – буквой i, то выявленная закономерность в общем виде будет записана так:

В математике такие произведения записывают в виде:

N = 2i.

Запись 2i читают так: «2 в i-й степени».

Задача. Вождь племени Мульти поручил своему министру разработать двоичный код и перевести в него всю важную информацию. Двоичный код какой разрядности потребуется, если алфавит, используемый племенем Мульти, содержит 16 символов? Выпишите все кодовые комбинации.

Решение. Так как алфавит племени Мульти состоит из 16 символов, то и кодовых комбинаций им нужно 16. В этом случае длина (разрядность) двоичного кода определяется из соотношения: 16 = 2i. Отсюда i = 4.

Чтобы выписать все кодовые комбинации из четырёх 0 и 1, воспользуемся схемой на рис. 1.13: 0000, 0001, 0010, 0011, 0100, 0101, 0110, 0111, 1000, 1001, 1010, 1011, 1100, 1101, 1110, 1111.

Универсальность двоичного кодирования

В начале нашей беседы вы узнали, что информация, представленная в непрерывной форме, может быть выражена с помощью символов некоторого естественного или формального языка. В свою очередь, символы произвольного алфавита могут быть преобразованы в двоичный код. Таким образом, с помощью двоичного кода может быть представлена любая информация на естественных и формальных языках, а также изображения и звуки (рис. 6). Это и означает универсальность двоичного кодирования.

Двоичные коды широко используются в компьютерной технике, требуя только двух состояний электронной схемы – «включено» (это соответствует цифре 1) и «выключено» (это соответствует цифре 0).

Простота технической реализации – главное достоинство двоичного кодирования. Недостаток двоичного кодирования – большая длина получаемого кода.

Равномерные и неравномерные коды

Различают равномерные и неравномерные коды. Равномерные коды в кодовых комбинациях содержат одинаковое число символов, неравномерные – разное.

Выше мы рассмотрели равномерные двоичные коды.

Примером неравномерного кода может служить азбука Морзе, в которой для каждой буквы и цифры определена последовательность коротких и длинных сигналов. Так, букве Е соответствует короткий сигнал («точка»), а букве Ш – четыре длинных сигнала (четыре «тире»). Неравномерное кодирование позволяет повысить скорость передачи сообщений за счёт того, что наиболее часто встречающиеся в передаваемой информации символы имеют самые короткие кодовые комбинации.

Разбор решения заданий тренировочного модуля

№1.Тип задания: ввод с клавиатуры пропущенных элементов в тексте

Переведите десятичное число 273 в двоичную систему счисления.

27310=_____

Решение.

Воспользуемся алгоритмом перевода целых чисел из системы с основанием p в систему с основанием q:

1. Основание новой системы счисления выразить цифрами исходной системы счисления и все последующие действия производить в исходной системе счисления.

2. Последовательно выполнять деление данного числа и получаемых целых частных на основание новой системы счисления до тех пор, пока не получим частное, меньшее делителя.

3. Полученные остатки, являющиеся цифрами числа в новой системе счисления, привести в соответствие с алфавитом новой системы счисления.

4. Составить число в новой системе счисления, записывая его, начиная с последнего остатка.

27310= 100010001.

Ответ: 27310= 100010001.

№2. Тип задания: единичный / множественный выбор.

Четыре буквы латинского алфавита закодированы кодами различной длины:

Определите, какой набор букв закодирован двоичной строкой 0100000100010.

Варианты ответов:

- BACAD

- ACAD

- ABBAD

- CADDA

Решение. Рассмотрим код: 0100000100010.

Выделим закодированные буквы:

01 000 001 000 10

В A C A D

Ответ: 1. BACAD.

Перевод текста в двоичный код

На чтение 3 мин Опубликовано 02.03.2021

Обновлено 23.10.2022

Всем привет, сегодня поговорим про то, как осуществляется перевод текста в двоичный код. Благодаря этому вы узнаете, как в памяти компьютере записываются различные знаки и символы. Также на этой странице вы сможете осуществить перевод ваших слов в язык юникода.

Содержание статьи

- Конвертер для перевода в Unicode

- Основные определения

- ASCII

- Unicode

- Заключение

Конвертер для перевода в Unicode

Получить текст в Юникод

Введите ваш текст

Конвертация

Основные определения

В начале изучим основы, чтобы в дальнейшем всё было понятно. Здесь не будет ничего сложного, чтобы полностью разобраться в теме, надо знать всего два определения и иметь представление о том, как работать с числами в двоичной системе счисления. Итак, приступим.

Код (в информатике) – это взаимно однозначное отображение символов одного алфавита (цифр) с помощью другого, который удобен для хранения, отображения и передачи данных.

На первый взгляд понятие может показаться непонятным, однако, оно совсем простое. Так, например, буквы русского алфавита мы можем представить с помощью десятичных, двоичных или любых других чисел в различных системах исчисления. Также буквы или слова можно закодировать любыми знаками. Однако тут есть одно условие – должны существовать правила, чтобы переводить значения назад. Исходя из этого положения возникает другое:

Кодирование(в информатике) – это процесс преобразования информации в код.

Для отображения текста разработчиками были придуманы так называемые кодировки – таблицы, где символам одного алфавита сопоставляются определенные числовые или текстовые значения. На данный момент относительно широкую популярность имеют две из них – ASCII и Unicode (Юникод). Ниже предложена информация, для ознакомления.

ASCII

Таблица была разработана в Соединенных Штатах Америки в одна тысяча девятьсот шестьдесят третьем году. Изначально предназначалась для использования в телетайпах. Эти устройства представляли собой печатные машинки, с помощью которых передавались сообщения по электрическому каналу. Физическая модель канала была простейшей – если по нему шел ток, то это трактовали как 1, если тока не было, то 0.

Такой системой пользовались высокопоставленные политические деятели. Например, так передавались слова между руководствами двух сверхдержав – США и СССР. Изначально в этой кодировке использовалось 7 бит информации (можно было переводить 128 символов), однако потом их значение увеличили до 256 (8 бит – 1 байт). Небольшая табличка значений двоичных величин, которые помогут с переводом в АСКИ, представлена ниже.

Unicode

Более современная кодировка. Данный стандарт был предложен в Соединенных штатах в 1991 году. Стоит отметить, что его разработала некоммерческая фирма, которая называлась “Консорциум Юникода”. Популярность свою стандарт получил из-за его большого символьного охвата – на данный момент с помощью него можно отобразить почти все знаки и буквы, которые используются на планете. Начиная от символов Римской нотации и заканчивая китайскими иероглифами. Символ в этой кодировке использует 1-4 байта машинной памяти. Числовые значения для перевода различных знаков в двузначный формат можно посмотреть здесь.

Заключение

Вот и все, теперь вы знаете про перевод текста в двоичный код в информатике, а также имеете представление о двух самых популярных кодировках, которые используются на данный момент. При возникновении вопросов можете написать их в комментариях.

Python программист. Увлекаюсь с детства компьютерами и созданием сайтов. Закончил НГТУ (Новосибирский Государственный Технический Университет ) по специальности «Инфокоммуникационные технологии и системы связи».