Обновлено: 24.05.2023

Давайте разберемся с этим, ведь нам придется измерять объем памяти и быстродействие компьютера.

Единицей измерения количества информации является бит – это наименьшая (элементарная) единица.

Байт – основная единица измерения количества информации.

Байт – довольно мелкая единица измерения информации. Например, 1 символ – это 1 байт.

Производные единицы измерения количества информации

1 килобайт (Кб)=1024 байта =2 10 байтов

1 мегабайт (Мб)=1024 килобайта =2 10 килобайтов=2 20 байтов

1 гигабайт (Гб)=1024 мегабайта =2 10 мегабайтов=2 30 байтов

1 терабайт (Гб)=1024 гигабайта =2 10 гигабайтов=2 40 байтов

Запомните, приставка КИЛО в информатике – это не 1000, а 1024, то есть 2 10 .

Методы измерения количества информации

Итак, количество информации в 1 бит вдвое уменьшает неопределенность знаний. Связь же между количеством возможных событий N и количеством информации I определяется формулой Хартли:

Алфавитный подход к измерению количества информации

Вероятностный подход к измерению количества информации

Этот подход применяют, когда возможные события имеют различные вероятности реализации. В этом случае количество информации определяют по формуле Шеннона:

I – количество информации,

N – количество возможных событий,

Pi – вероятность i-го события.

Задача 1.

Имеется 4 равновероятных события (N=4).

Задача 2.

Чему равен информационный объем одного символа русского языка?

В русском языке 32 буквы (буква ё обычно не используется), то есть количество событий будет равно 32. Найдем информационный объем одного символа. I=log2 N=log2 32=5 битов (2 5 =32).

Примечание. Если невозможно найти целую степень числа, то округление производится в большую сторону.

Задача 3.

Чему равен информационный объем одного символа английского языка?

Задача 4.

Световое табло состоит из лампочек, каждая из которых может находиться в одном из двух состояний (“включено” или “выключено”). Какое наименьшее количество лампочек должно находиться на табло, чтобы с его помощью можно было передать 50 различных сигналов?

С помощью N лампочек, каждая из которых может находиться в одном из двух состояний, можно закодировать 2 N сигналов.

2 5 6 , поэтому пяти лампочек недостаточно, а шести хватит. Значит, нужно 6 лампочек.

Задача 5.

Метеостанция ведет наблюдения за влажностью воздуха. Результатом одного измерения является целое число от 0 до 100, которое записывается при помощи минимально возможного количества битов. Станция сделала 80 измерений. Определите информационный объем результатов наблюдений.

В данном случае алфавитом является множество чисел от 0 до 100, всего 101 значение. Поэтому информационный объем результатов одного измерения I=log2101. Но это значение не будет целочисленным, поэтому заменим число 101 ближайшей к нему степенью двойки, большей, чем 101. это число 128=2 7 . Принимаем для одного измерения I=log2128=7 битов. Для 80 измерений общий информационный объем равен 80*7 = 560 битов = 70 байтов.

Задача 6.

Определите количество информации, которое будет получено после подбрасывания несимметричной 4-гранной пирамидки, если делают один бросок.

Пусть при бросании 4-гранной несимметричной пирамидки вероятности отдельных событий будут равны: p1=1/2, p2=1/4, p3=1/8, p4=1/8.

Тогда количество информации, которое будет получено после реализации одного из них, можно вычислить по формуле Шеннона:

I = -[1/2 * log2(1/2) + 1/4 * log2(1/4) + 1/8 * log(1/8) + 1/8 * log(1/8)] = 14/8 битов = 1,75 бита.

Задача 7.

В книге 100 страниц; на каждой странице – 20 строк, в каждой строке – 50 символов. Определите объем информации, содержащийся в книге.

Задача 8.

Оцените информационный объем следующего предложения:

Тяжело в ученье – легко в бою!

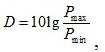

(2.10)

где P – максимальное и минимальное значения мгновенной мощности. Пик-фактором сигнала называют отношение максимальной мощности к средней

Р

ширина спектра сигнала –

отношение сигнал/шум или превышение сигнала над помехой –

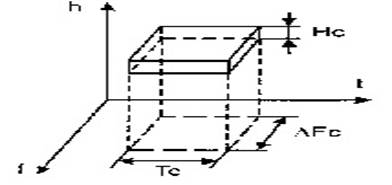

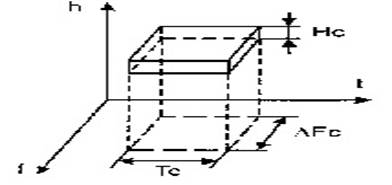

Таким образом, можно принять некоторое геометрическое представление сигнала как некоторого объема в трехмерном пространстве (рис.2.6).

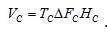

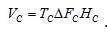

Рис. 2.6 Геометрическое представление сигнала Объемом сигнала принято называть произведение трех параметров

Введя понятие объема сигнала можно сравнительно просто представить соотношения между свойствами сигнала и свойствами системы связи.

Система связи может быть охарактеризована:

ü временем в течении которого канал связи предоставлен для передачи;

ü полосой частот, которую канал способен пропустить;

ü полосой уровней к зависящей от допустимой нагрузки на аппаратуру канала.

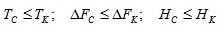

Очевидно, что передача сигнала с характеристиками с” с’ с по системе связи с каналом, имеющим параметры к’ к’ к возможна, лишь при условиях

Динамический диапазон и пик-фактор сигналов

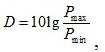

Чтобы охарактеризовать изменения мгновенной мощности сигналов вводятся понятия динамического диапазона и пик-фактора. Динамический диапазон сигнала. дБ. определяется выражением

(2.10)

где P – максимальное и минимальное значения мгновенной мощности. Пик-фактором сигнала называют отношение максимальной мощности к средней

Р

ширина спектра сигнала –

отношение сигнал/шум или превышение сигнала над помехой –

Таким образом, можно принять некоторое геометрическое представление сигнала как некоторого объема в трехмерном пространстве (рис.2.6).

Рис. 2.6 Геометрическое представление сигнала Объемом сигнала принято называть произведение трех параметров

Введя понятие объема сигнала можно сравнительно просто представить соотношения между свойствами сигнала и свойствами системы связи.

Система связи может быть охарактеризована:

ü временем в течении которого канал связи предоставлен для передачи;

ü полосой частот, которую канал способен пропустить;

ü полосой уровней к зависящей от допустимой нагрузки на аппаратуру канала.

Очевидно, что передача сигнала с характеристиками с” с’ с по системе связи с каналом, имеющим параметры к’ к’ к возможна, лишь при условиях

Информационная емкость сигналов

Информационная емкость сигналов существенно зависит от типа сигналов и определяет требования к каналам передачи данных (каналам связи), равно как и технические характеристики каналов связи определяют требования к информационной емкости сигналов, передаваемых по этим каналам.

Для каналов передачи дискретных сигналов (дискретные канала связи) используют понятия технической и информационной скорости передачи данных.

Под технической скоростью передачи подразумевают число элементарных сигналов (символов), передаваемых по каналу в единицу времени. Простейший элементарный символ – однополярный электрический импульс длительностью t на тактовом интервале T. В дискретных каналах используют, как правило, двуполярные импульсы, положительные на первой половине интервала Т и отрицательные на второй половине. Это позволяет поддерживать нулевой потенциал кабеля и выполнять тактовую синхронизацию приемо-передачи сигналов. Единицей измерения технической скорости V t = 1/T служит БОД – один символ в секунду. Полоса пропускания канала связи обычно ограничивается определенной предельной частотой F пред по уровню затухания сигнала до уровня статистических помех, при этом значение технической скорости передачи данных, естественно, не может быть выше F пред без каких-либо специальных устройств выделения информационных сигналов.

При известной технической скорости V T скорость передачи информации измеряется в битах в секунду, и при уровне помех меньше амплитудных значений символьных импульсов задается соотношением:

где H(s) – энтропия символа. Для двоичных дискретных символов с возможными состояниями [0, 1] (однополярные – есть/нет импульс на такте, для двуполярных – порядок полярности импульсов на такте, например, 0: плюс/минус, 1: минус/плюс) при постоянной амплитуде импульсов значение H(s) равно 1. При числе L возможных равновероятных уровней амплитуды импульсов (уровень помех меньше разности уровней амплитуд импульсов) значение H(s) равно log L.

I t (S) = N log L = (t/T) log L. (1.4.7)

Увеличение числа уровней L увеличивает пропускную способность каналов связи, но усложняет аппаратуру кодирования данных и снижает помехоустойчивость связи.

Для непрерывных сигналов передача по каналам связи возможна только при условии, что максимальная информационная частота в сигнале F max не превышает предельной частоты F пред передачи сигналов каналом связи. Для оценки информационной емкости непрерывного сигнала выполним его дискретизацию с интервалом D t = 1/2F max . Как установлено Котельниковым в 1933 году, по мгновенным отсчетам непрерывного сигнала с таким интервалом дискретизации аналоговый сигнал может быть восстановлен без потери информации. При полной длительности сигнала T s число отсчетов:

N = T s / D t = 2F max T s .

Определим максимально возможное число выборок в каждом отсчете при наличии шума в канале со средней мощностью Р ш = d 2 . При средней мощности сигнала P s = s 2 :

Информационная емкость сигнала:

I(S) = 2F max T s log L. (1.4.8)

Информационные возможности сигнала возрастают с расширением его спектра и превышением его уровня над уровнем помех.

Знаете ли Вы, почему “черные дыры” – фикция?

Согласно релятивистской мифологии, “чёрная дыра – это область в пространстве-времени, гравитационное притяжение которой настолько велико, что покинуть её не могут даже объекты, движущиеся со скоростью света (в том числе и кванты самого света). Граница этой области называется горизонтом событий, а её характерный размер – гравитационным радиусом. В простейшем случае сферически симметричной чёрной дыры он равен радиусу Шварцшильда”.

На самом деле миф о черных дырах есть порождение мифа о фотоне – пушечном ядре. Этот миф родился еще в античные времена. Математическое развитие он получил в трудах Исаака Ньютона в виде корпускулярной теории света. Корпускуле света приписывалась масса. Из этого следовало, что при высоких ускорениях свободного падения возможен поворот траектории луча света вспять, по параболе, как это происходит с пушечным ядром в гравитационном поле Земли.

Отсюда родились сказки о “радиусе Шварцшильда”, “черных дырах Хокинга” и прочих безудержных фантазиях пропагандистов релятивизма.

Впрочем, эти сказки несколько древнее. В 1795 году математик Пьер Симон Лаплас писал:

“Если бы диаметр светящейся звезды с той же плотностью, что и Земля, в 250 раз превосходил бы диаметр Солнца, то вследствие притяжения звезды ни один из испущенных ею лучей не смог бы дойти до нас; следовательно, не исключено, что самые большие из светящихся тел по этой причине являются невидимыми.” [цитата по Брагинский В.Б., Полнарёв А. Г. Удивительная гравитация. – М., Наука, 1985]

Однако, как выяснилось в 20-м веке, фотон не обладает массой и не может взаимодействовать с гравитационным полем как весомое вещество. Фотон – это квантованная электромагнитная волна, то есть даже не объект, а процесс. А процессы не могут иметь веса, так как они не являются вещественными объектами. Это всего-лишь движение некоторой среды. (сравните с аналогами: движение воды, движение воздуха, колебания почвы). Подробнее читайте в FAQ по эфирной физике.

Единицу количественной меры информации – БИТ (сокращение binary digit – двоичная цифра), впервые предложил Р. Хартли в 1928 году. 1 бит – это информация о двух возможных равновероятных состояниях объекта, неопределенность выбора из двух равновероятных событий. Математически это отображается состоянием 1 или 0 одного разряда двоичной системы счисления. Количество информации Н (в битах), необходимое и достаточное для полного снятия неопределенности состояния объекта, который имеет N равновозможных состояний, измеряется как логарифм по основанию 2 из числа возможных состояний:

H = log 2 N. (10)

Соответственно, двоичный числовой информационный код одного из N возможных состояний объекта занимает Н двоичных разрядов.

Требование аддитивности: неопределенность объединенного источника равна сумме неопределенностей исходных источников, что соответствует интуитивному требованию к информации: она должна быть однозначной, а ее количество должно быть одним и тем же независимо от способа задания.

Основание логарифма не имеет принципиального значения и определяет только масштаб или единицу неопределенности. Так, если за единицу неопределенности принять три равновероятных состояния, то для определения, например, одной фальшивой золотой монеты (более легкой) из 27 внешне неотличимых монет потребуется только H = log 327 = 3, т.е. три взвешивания на равноплечных весах.

Двоичная мера информации получила общее признание в связи с простотой реализации информационной техники на элементах с двумя устойчивыми состояниями.В десятичном исчислении единицей информации является один десятичный разряд – ДИТ.

Энтропия источника информации. Степень неопределенности состояния объекта (или так называемого источника информации) зависит не только от числа его возможных состояний, но и от вероятности этих состояний. При неравновероятных состояниях свобода выбора для источника ограничивается. Так, если из двух возможных состояний вероятность одного из них равна 0.999, то вероятность другого состояния соответственно равна 1-0.999 = 0.001, и при взаимодействии с таким источником результат практически предрешен.

В общем случае, в соответствии с теорией вероятностей, источник информации однозначно и полно характеризуется ансамблем состояний U = 1, u2. uN> с вероятностями состояний соответственно <р(u1), р(u2). р(uN)> при условии, что сумма вероятностей всех состояний равна 1. Мера количества информации, как неопределенности выбора дискретным источником состояния из ансамбля U, предложена К. Шенноном в 1946 году и получила названиеэнтропии дискретного источника информацииили энтропии конечного ансамбля:

H(U) = -pnlog2pn. (11)

Выражение Шеннона совпадает с выражением Больцмана для энтропии физических систем при оценке степени разнообразия их состояний. Мера энтропии Шеннона является обобщением меры Хартли на случай ансамблей с неравновероятными состояниями, в чем нетрудно убедиться, если в выражении (11) значение pnзаменить значением p=1/N для ансамбля равновероятных состояний.Энтропия конечного ансамбля H(U) характеризует неопределенность, приходящуюся в среднем на одно состояние ансамбля.

Учитывая, что в дальнейшем во всех математических выражениях, касающихся энтропии, мы будем использовать только двоичное основание логарифма, индекс 2 основания логарифма в формулах будем подразумевать по умолчанию.

Основные свойства энтропии:

1. Энтропия является величиной вещественной и неотрицательной, т.к. значения вероятностей pnнаходятся в интервале 0-1, значения log pnвсегда отрицательны, а значения -pnlog pnв (1.4.2) соответственно положительны.

2. Энтропия – величина ограниченная, т.к. при pn0 значение -pnlog pnтакже стремится к нулю, а при 0

Рисунок 20 – график изменения энтропии источника с двумя состояниями

5. Энтропия источника с двумя состояниями u1и u2при изменении соотношения их вероятностей p(u1)=p и p(u2)=1-p определяется выражением:

H(U) = -[p log p + (1-p) log (1-p)],

и изменяется от 0 до 1, достигая максимума при равенстве вероятностей. График изменения энтропии приведен на рис. 20.

6. Энтропия объединенных статистически независимых источников информации равна сумме их энтропий.

Рассмотрим это свойство на двух источниках информации u и v. При объединении источников получаем обобщенный источник информации (u,v), который описывается вероятностями p(unvm) всех возможных комбинаций состояний unисточника u и vmисточника v. Энтропия объединенного источника при N возможных состояниях источника u и М возможных состояниях источника v:

H(UV) = -p(unvm) log p(unvm),

Источники статистически независимы друг от друга, если выполняется условие:

С использованием этого условия соответственно имеем:

H(UV) = -p(un)p(vm) log [p(un)p(vm)] =

= -p(un) log p(un)p(vm) -p(vm) log p(vm)p(um).

С учетом того, чтоp(un) = 1 иp(vm) = 1, получаем:

7. Энтропия характеризует среднюю неопределенность выбора одного состояния из ансамбля, игнорируя содержательную сторону ансамбля. Это расширяет возможности использования энтропии при анализе самых различных явлений, но требует определенной дополнительной оценки возникающих ситуаций, т.к. из рисунка 20 следует, что энтропия состояний может быть неоднозначной.

Энтропия непрерывного источника информации должна быть бесконечна, т. к. неопределенность выбора из бесконечно большого числа возможных состояний бесконечно велика.

Разобьем диапазон изменения непрерывной случайной величины U на конечное число n малых интервалов u. При реализации значений u в интервале (un, un+u) будем считать, что реализовалось значение un дискретной случайной величины U’, вероятность реализации которой:

p(un 2 . При средней мощности сигнала Ps = s 2 :

L = =.

Информационная емкость сигнала:

I(S) = 2Fmax Ts log L. (17)

Информационные возможности сигнала возрастают с расширением его спектра и превышением его уровня над уровнем помех.

Пространство сигналов

Множества сигналов.Сигналы обычно рассматриваются в составе определенных множеств L, объединенных каким-либо свойством Р, характерным для всех и каждого из сигналов данного множества. Условное отображение множества: L = – множество всех s, для которых справедливо свойство Р. Определив свойство Р, мы тем самым можем ограничивать сигналы, действующие в каких-либо системах, определенными типами, условиями, границами по параметрам и т.п.

Множества сигналов могут образовываться из других, ранее определенных множеств, логическими операциями объединения (индекс – ) и пересечения (индекс -):

Возможно разбиение множества сигналов на непересекающиеся подмножества, более удобные для обработки, при этом для множества S, разбитого на совокупность подмножеств 1, S2, S3, …, SN>, должны выполняться условия:

Запись S1Sозначает, что множествоS1входит в состав множества S, т.е. является подмножеством в составе S.

Преобразование элементов vi множества V в элементы gi множества G называется отображением (трансформацией, преобразованием) V в G. Символьные записи преобразования: g = T[v] или v → g, при этом элементы v называют прообразом множества g, а элементы g – образом множества v.

Если преобразование выполняется над числами одного множества R (например, x = T[y]), то такое преобразование порождает функциональную зависимость x = f(y).

Если преобразование выполняется над функциями одного и того же множества L (например, f(t) = T[g(t)], f(t) L и g(t) L), то алгоритм преобразования T[..] называют оператором преобразования f(t) в g(t).

Преобразование g = T[f(t)] функций f(t) множества F называют функционалом, если результатом преобразования являются числовые значения g множества G. Примерами функционалов являются интегралы функций в определенных пределах.

Преобразование может выполняться функциональными операторами с переводом функций одной переменной, например t, в функции по другой переменной, например ω, Типичным примером функционального оператора является преобразование Фурье. В комплексной форме:

S(ω) = s(t) exp(-jωt) dt.

Пространство сигналов.Для анализа и обработки информации, которая может быть заключена в сигналах, требуется выделять из множества сигналов сигналы с определенными параметрами, сравнивать сигналы друг с другом, оценивать изменение сигналов при их прохождении через системы обработки данных, и т.п. Это может выполняться только при “помещении” множества сигналов в определенные метрические пространства с заранее оговоренными свойствами и единицами измерений.Положение на поверхности Земли любого объекта однозначно определяется по “координатному сигналу” в заранее сформированных метрических координатных пространствах с нулевыми точками и принятыми единицами измерений. Для практического использования сформированы также различные пространства картографических проекций с определенными структурными ограничениями, жестко установленная метрология которых позволяет трансформировать информацию из одного пространства в другое, более удобное для отображения или обработки определенными программами.

Главным условием превращения множество сигналов L1(t), s2(t), …>, которые имеют какие-то общие свойства, в функциональное пространство сигналов является выполнение условия однозначной реализации. Если пространство значений независимой переменной t задано выражением R:=(-,+), то пространство сигналов L P [R] определяет множество сигналов в этом пространстве, для которых условие однозначной реализации записывается в следующей форме:

|s(t)| p dt 2 dt 2 [0, 2π] одного периода:

|s(t)| 2 dt 3 можно только абстрактно, но с математических позиций такое пространство вполне реально и N-мерный сигнал s отображается вполне определенной точкой в этом пространстве с координатами snпо осям пространства. При уменьшении интервала дискретизации сигнала до бесконечно малой величины значение N стремится к бесконечности, и пространство сигналов превращается в бесконечномерное пространство аналоговых сигналов. Следовательно, и аналоговые сигналы могут рассматриваться как предельный случай бесконечномерных векторов.

Рисунок 21 – Пространства сигналов и функций.

С учетом вышеизложенного, для математического анализа систем и сигналов в линейном пространстве может использоваться математика векторов.

В линейном пространстве Ln; n=0,1,2,…,N> всегда можно выделить множество векторов n; n=0,1,2,…,N>, для которых выполняется равенство нулю их линейной комбинации

n xn = 0 (18)

только при условии равенства нулю всех значений k. Такое множество векторов называется линейно независимым. Ни один вектор линейно независимого множества не может быть выражен в виде какой-либо линейной комбинации других векторов этого пространства. Такое множество векторов называется базисом N-мерного пространства Ln; N>. Линейная комбинация таких линейно независимых векторов образует векторное пространство где каждый вектор U может быть выражен единственной линейной комбинацией векторовxn:

U =n xn

Совокупность чисел n> называется спектром вектора U в этом базисе. Спектр вектора в общем случае может быть комплексным.

Линейные пространства сигналов имеют, как правило, не единственный базис. Выбор базиса определяется простотой и удобством его использования при обработке сигналов.

Основными метрическими параметрами линейного пространства являются норма, метрика и скалярное произведение сигналов.

Норма сигналов в линейном пространстве является аналогом длины векторов, и обозначается индексом ||s(t)|| – норма. В математике существуют различные формы норм. При анализе сигналов обычно используются квадратичные нормы

||s(t)|| =. (19)

Для дискретных сигналов:

||s(n)|| =. (19′)

Для комплексных сигналов

||s(t)|| =, (19”)

где s*(t) – величины, комплексно сопряженные с s(t).

Линейное пространство сигналов L является нормированным, если каждому сигналу пространства s(t) однозначно сопоставлена его числовая норма ||s(t)||, и выполняются следующие аксиомы:

Норма неотрицательна (||s(t)|| ≥ 0) и равна нулю тогда и только тогда, когда сигнал равен нулю (||s(t)|| = , при s(t) =).

Для любого числа b должно быть справедливо равенство||bs(t)|| = |b|||s(t)||.

Если v(t) и u(t) – сигналы из пространства L, то должно выполняться неравенство треугольника||v(t)+u(t)||||v(t)|| + ||u(t)||.

Пример нормы для двумерных цифровых сигналов приведен на рисунке 22.

Рисунок 22 – Норма и метрика сигналов.

Метрика сигналов.Линейное пространство сигналов L является метрическим, если каждой паре сигналов s(t) L и v(t) L однозначно сопоставляется неотрицательное число (s,v) – метрика или расстояние между векторами. Пример метрики для двух векторов в двумерном пространстве приведен на рисунке 22.

Для метрик сигналов в метрическом пространстве любой размерности должны выполняться аксиомы:

(s,v) = (v,s) – рефлексивность метрики.

(s,s) = 0 для любых s(t) L.

(s,v) (s,a) + (a,v) для любых a L.

Метрика определяется нормой разности двух сигналов (рисунок 22)

В свою очередь норму можно отождествлять с расстоянием от выбранного элемента пространства до нулевого||s(t)|| =(s(t),).

По метрике сигналов можно судить, например, о том, насколько точно один сигнал может быть аппроксимирован другим сигналом, или насколько изменяется выходной сигнал относительно входного при прохождении через какое-либо устройство. Пространство сигналов может иметь несколько метрик.

Тут вы можете оставить комментарий к выбранному абзацу или сообщить об ошибке.

ИНФОРМАЦИОННАЯ ЕМКОСТЬ средства отображения информации— максимальное количество информации, которое может быть отображено на СОИ. Значение И. е. зависит от структуры информационного поля, количества позиций в нем и числа символов в алфавите, закрепленном за позицией. И. е. определяет максимальные информационные возможности СОИ. Реальное же количество отображаемой информации обычно меньше И. е. Равенство возможно лишь в том случае ( если для каждой позиции информационного поля равновероятно появление любого из символов алфавита, относящегося к ней. Воспринимая И. м.г оператор производит анализ и оценку сложившейся ситуации, планирует управляющие воздействия, наблюдает и оценивает результаты их реализации. Технической основой для формирования И. м. являются системы и средства отображения информации. И. м. должна удовлетворять трем важнейшим требованиям: 1) по содержанию она должна адекватно отражать объект управления, рабочие процессы, окружающую среду и состояние самой системы управления; 2) по количеству информации И. м. должна обеспечивать оптимальный информационный баланс и не приводить к таким нежелательным явлениям, как дефицит или избыток информации; она должна отображать лишь те свойства, отношения и связи управляемых объектов, которые имеют существенное значение; 3) по форме и композиции И. м. должна соответствовать задачам трудового процесса и возможностям человека по приему и переработке поступающей информации и осуществлению управляющих воздействий. И. м., как правило, воспроизводит действительность в упрощенной форме и всегда является некоторой идеализацией действительности. Степень и характер упрощения и идеализации могут быть определены на основе анализа задач СЧМ в целом и анализа задач оператора. Однако при этом желательно, чтобы И. м. была наглядной, т. е. оператор должен иметь возможность быстрого понимания ситуации. Важным свойством И. м. является ее читаемость, что обеспечивается структурой И. м.: в нее не просто должны входить упорядоченные сведения, а должна быть представлена их взаимосвязь. И. м. различаются по модальности выдаваемых сигналов (визуальные, акустические, полимодальные), по характеру используемых элементов индикации, по степени детализации информации (детальные, интегральные, смешанные). Основными классами И. м. являются: наглядные (картинные) модели-изображения (фото-, кино-, телеизображение), абстрактные знаковые модели (печатный текст, табло, формуляр и т .п.), графические модели (график, диаграмма, чертеж, блок-схема) и комбинированные (мнемосхема, карта и др.).

Энциклопедический словарь по психологии и педагогике . 2013 .

Полезное

Смотреть что такое “ИНФОРМАЦИОННАЯ ЕМКОСТЬ” в других словарях:

Информационная емкость — Количество охраняемых объектов (для систем передачи извещений), контролируемых шлейфов сигнализации (для приемно контрольных приборов), охраняемых зон, о состоянии которых может оповестить оповещатель (для оповещателей), или защищаемых зон (для… … Словарь-справочник терминов нормативно-технической документации

информационная емкость — Общее число битов в информации в канале пользователя, поддерживаеиле одной ячейкой (или точечным лучом), которая является частью бесконечного набора идентичных ячеек (или большого числа точечных спутниковых лучей) в единообразном двумерном (или… … Справочник технического переводчика

информационная емкость кадра средства отображения информации — информационная емкость кадра Максимальное количество различимых элементов отображения информации в кадре средства отображения информации. [ГОСТ 27833 88] Тематики средства отображения информации Синонимы информационная емкость кадра … Справочник технического переводчика

информационная емкость устройства записи [воспроизведения, записи-воспроизведения] — Характеристика устройства записи [воспроизведения, записи воспроизведения], определяющая количество информации, которое может быть записано [воспроизведено] с помощью этого устройства без смены носителя записи [сигналограммы] или комплекта… … Справочник технического переводчика

информационная емкость устройства телемеханики — информационная емкость Число объектов измерения, сигнализации, управления и регулирования, от (для) которых может передавать информацию устройство телемеханики. [ГОСТ 26.005 82] Тематики телемеханика, телеметрия Синонимы информационная емкость EN … Справочник технического переводчика

информационная емкость носителя записи [сигналограммы] — Характеристика единицы носителя записи (сигналограммы), определяющая количество записываемой или записанной информации. Примечание Количественно информационная емкость может выражаться в битах или иных единицах, прямо или косвенно характеризующих … Справочник технического переводчика

информационная емкость запоминающего устройства — емкость Наибольшее количество единиц данных, которое одновременно может храниться в запоминающем устройстве. [ГОСТ 25492 82] Тематики устройства цифр. выч. машин запоминающие Синонимы емкость EN capacity … Справочник технического переводчика

информационная емкость (абонентского оборудования) — — [Е.С.Алексеев, А.А.Мячев. Англо русский толковый словарь по системотехнике ЭВМ. Москва 1993] Тематики информационные технологии в целом EN user data capacity … Справочник технического переводчика

информационная емкость дискретного сигнала — Максимум энтропии дискретного сигнала, равный логарифму числа возможных дискретных сигналов за единицу времени. [Сборник рекомендуемых терминов. Выпуск 94. Теория передачи информации. Академия наук СССР. Комитет технической терминологии. 1979 г.] … Справочник технического переводчика

Читайте также:

- Выбор жизненного пути обществознание 6 класс кратко

- Политические партии и движения их классификация кратко

- Меры центральной тенденции кратко

- Мусульманские кратко метражный видеоролики

- Применение каменного угля кратко

!!! Информационная емкость сигналов

Количественная

мера информации. При

неопределенности самого понятия

информации можно достаточно обоснованно

считать, чтоинформация проявляется,

хранится и передается от одного объекта

к другому в материально-энергетической

форме в виде сигналов.Сигналом как

материальным носителем информации

может быть любой физический процесс

(электрический, магнитный, оптический,

акустический и пр.), определенные

параметры которого (амплитуда, частота,

энергия, интенсивность и др.)однозначно

отображают информационные данные

(сообщения).

Единицу

количественной меры информации – БИТ

(сокращение binary

digit – двоичная

цифра), впервые предложил Р. Хартли в

1928 году. 1 бит – это информация о двух

возможных равновероятных состояниях

объекта, неопределенность выбора из

двух равновероятных событий. Математически

это отображается состоянием 1 или 0

одного разряда двоичной системы

счисления. Количество информации Н (в

битах), необходимое и достаточное для

полного снятия неопределенности

состояния объекта, который имеет N

равновозможных состояний, измеряется

как логарифм по основанию 2 из числа

возможных состояний:

H = log 2

N. (10)

Соответственно,

двоичный числовой информационный код

одного из N возможных состояний объекта

занимает Н двоичных разрядов.

Требование

аддитивности: неопределенность

объединенного источника равна сумме

неопределенностей исходных источников,

что соответствует интуитивному требованию

к информации: она должна быть однозначной,

а ее количество должно быть одним и тем

же независимо от способа задания.

Основание логарифма

не имеет принципиального значения и

определяет только масштаб или единицу

неопределенности. Так, если за единицу

неопределенности принять три равновероятных

состояния, то для определения, например,

одной фальшивой золотой монеты (более

легкой) из 27 внешне неотличимых монет

потребуется только H = log 327 = 3, т.е.

три взвешивания на равноплечных весах.

Двоичная мера

информации получила общее признание в

связи с простотой реализации информационной

техники на элементах с двумя устойчивыми

состояниями.В десятичном исчислении

единицей информации является один

десятичный разряд – ДИТ.

Энтропия

источника информации. Степень

неопределенности состояния объекта

(или так называемого источника информации)

зависит не только от числа его возможных

состояний, но и от вероятности этих

состояний. При неравновероятных

состояниях свобода выбора для источника

ограничивается. Так, если из двух

возможных состояний вероятность одного

из них равна 0.999, то вероятность другого

состояния соответственно равна 1-0.999 =

0.001, и при взаимодействии с таким

источником результат практически

предрешен.

В общем случае, в

соответствии с теорией вероятностей,

источник информации однозначно и полно

характеризуется ансамблем состояний

U = {u1, u2,…, uN} с

вероятностями состояний соответственно

{р(u1), р(u2),…, р(uN)} при

условии, что сумма вероятностей всех

состояний равна 1. Мера количества

информации, как неопределенности выбора

дискретным источником состояния из

ансамбля U, предложена К. Шенноном в 1946

году и получила названиеэнтропии

дискретного источника информацииили энтропии конечного ансамбля:

H(U) = –![]() pnlog2pn.

pnlog2pn.

(11)

Выражение Шеннона

совпадает с выражением Больцмана для

энтропии физических систем при оценке

степени разнообразия их состояний. Мера

энтропии Шеннона является обобщением

меры Хартли на случай ансамблей с

неравновероятными состояниями, в чем

нетрудно убедиться, если в выражении

(11) значение pnзаменить значением p=1/N для ансамбля

равновероятных состояний.Энтропия

конечного ансамбля H(U) характеризует

неопределенность, приходящуюся в среднем

на одно состояние ансамбля.

Учитывая, что в

дальнейшем во всех математических

выражениях, касающихся энтропии, мы

будем использовать только двоичное

основание логарифма, индекс 2 основания

логарифма в формулах будем подразумевать

по умолчанию.

Основные

свойства энтропии:

1. Энтропия является

величиной вещественной и неотрицательной,

т.к. значения вероятностей pnнаходятся в интервале 0-1, значения log pnвсегда отрицательны, а значения -pnlog pnв

(1.4.2) соответственно положительны.

2. Энтропия – величина

ограниченная, т.к. при pn0 значение -pnlog pnтакже стремится к нулю, а при 0 < pn1 ограниченность

суммы всех слагаемых очевидна.

3. Энтропия равна

0, если вероятность одного из состояний

источника информации равна 1, и тем самым

состояние источника полностью определено

(вероятности остальных состояний

источника равны нулю, т.к. сумма

вероятностей должна быть равна 1).

4. Энтропия

максимальна при равной вероятности

всех состояний источника информации:

Hmax(U)

= –![]() (1/N)

(1/N)

log (1/N) = log N.

Рисунок 20 – график

изменения энтропии источника с двумя

состояниями

5. Энтропия источника с двумя

состояниями u1и u2при

изменении соотношения их вероятностей

p(u1)=p и p(u2)=1-p определяется

выражением:

H(U) = -[p

log p + (1-p) log (1-p)],

и изменяется от 0

до 1, достигая максимума при равенстве

вероятностей. График изменения энтропии

приведен на рис. 20.

6. Энтропия

объединенных статистически независимых

источников информации равна сумме их

энтропий.

Рассмотрим это

свойство на двух источниках информации

u и v. При объединении источников получаем

обобщенный источник информации (u,v),

который описывается вероятностями

p(unvm)

всех возможных комбинаций состояний

unисточника u и vmисточника v. Энтропия объединенного

источника при N возможных состояниях

источника u и М возможных состояниях

источника v:

H(UV) =

–![]()

![]() p(unvm)

p(unvm)

log p(unvm),

Источники

статистически независимы друг от друга,

если выполняется условие:

p(unvm)

= p(un)p(vm).

С

использованием этого условия соответственно

имеем:

H(UV) =

–![]()

![]() p(un)p(vm)

p(un)p(vm)

log [p(un)p(vm)]

=

= –![]() p(un)

p(un)

log p(un)![]() p(vm)

p(vm)

–![]() p(vm)

p(vm)

log p(vm)![]() p(um).

p(um).

С

учетом того, что![]() p(un)

p(un)

= 1 и![]() p(vm)

p(vm)

= 1, получаем:

H(UV) = H(U) + H(V).

(12)

7. Энтропия

характеризует среднюю неопределенность

выбора одного состояния из ансамбля,

игнорируя содержательную сторону

ансамбля. Это расширяет возможности

использования энтропии при анализе

самых различных явлений, но требует

определенной дополнительной оценки

возникающих ситуаций, т.к. из рисунка

20 следует, что энтропия состояний может

быть неоднозначной.

Энтропия

непрерывного источника информации

должна быть бесконечна, т. к. неопределенность

выбора из бесконечно большого числа

возможных состояний бесконечно велика.

Разобьем

диапазон изменения непрерывной случайной

величины U

на конечное число n

малых интервалов u.

При реализации значений u

в интервале (un,

un+u)

будем считать, что реализовалось значение

un

дискретной случайной величины U’,

вероятность реализации которой:

p(un<u<un+u)

=![]() p(u)

p(u)

du

p(un)

u.

Энтропия

дискретной

величины

U’:

H(U’)

= –![]() p(un)

p(un)

u

log (p(un)

u).

Заменяем

log

(p(un)

u)

= log

p(un)+log

u,

принимаем во внимание, что сумма p(un)

u

по всем возможным значениям un

равна 1, и получаем:

H(U’)

= –![]() p(un)

p(un)

u

log p(un)

– log u.

(13)

В пределе, при u

0, получаем выражение энтропии для

непрерывного источника:

H(U)

= –![]() p(u)

p(u)

log p(u) du –![]() .(14)

.(14)

Значение энтропии

в (1.4.5), как и ожидалось, стремится к

бесконечности за счет второго члена

выражения. Для получения конечной

характеристики информационных свойств

непрерывных сигналов используют только

первый член выражения (14), получивший

название дифференциальной энтропии.

Ее можно трактовать, как среднюю

неопределенность выбора произвольной

случайной величины по сравнению со

средней неопределенностью выбора

случайной величины U’,

имеющей равномерное распределение в

диапазоне (0-1). Действительно, для такого

распределения p(un)

= 1/N,

u

= 1/N,

и при N

из (13) следует:

H(U’)

= – (log N)/N – log u

–![]() .

.

Соответственно,

разность энтропий дает дифференциальную

энтропию:

h(U) = H(U)

– H(U’) = –![]() p(u)

p(u)

log p(u) du.(15)

Дифференциальная

энтропия не зависит от конкретных

значений величины U:

h(U+a) =

h(U), a = const,

но зависит от

масштаба ее представления:

h(kU)

= h(U)

+ log

k.

Практика анализа

и обработки сигналов обычно имеет дело

с сигналами в определенном интервале

[a,

b]

их значений, при этом максимальной

дифференциальной энтропией обладает

равномерное распределение значений

сигналов:

h(U) =

–![]() p(u)

p(u)

log p(u) du = log (b-a).

По

мере сужения плотности распределения

значение h(U)

уменьшается, и в пределе при p(u)

(u-c),

a<c<b

стремится к нулю.

!!! Информационная

емкость сигналов

существенно

зависит от типа сигналов и определяет

требования к каналам передачи данных.

Для

каналов передачи дискретных сигналов

(дискретные каналы связи) используют

понятия технической и информационной

скорости передачи данных.

Под

технической скоростью передачи

подразумевают число элементарных

сигналов (символов), передаваемых по

каналу в единицу времени. Простейший

элементарный символ – однополярный

импульс длительностью

на тактовом интервале T.

В дискретных каналах используют, как

правило, двуполярные импульсы,

положительные на первой половине

интервала Т и отрицательные на второй

половине. Это позволяет поддерживать

нулевой потенциал в кабеле и выполнять

тактовую синхронизацию приемо-передачи

сигналов. Единицей измерения технической

скорости Vt

= 1/T

служит БОД – один символ в секунду.

Полоса пропускания канала связи

ограничивается предельной частотой

Fпред

по уровню затухания сигнала до уровня

помех, при этом значение технической

скорости передачи данных не может быть

выше Fпред.

При известной

технической скорости Vt

скорость передачи информации измеряется

в битах в секунду и задается соотношением:

Vh

= Vt

H(s),

где H(s)

– энтропия символа. Для двоичных

дискретных символов [0, 1] при постоянной

амплитуде импульсов значение H(s)

равно 1. При числе L

возможных равновероятных уровней

амплитуды импульсов (уровень помех

меньше разности уровней амплитуд

импульсов) значение H(s)

равно log

L.

Информационная

емкость сигнала или полное количество

информации в сигнале S

(сообщении, кодовой последовательности/слове)

определяется полным количеством N

= t/T

энтропии символов в битах на интервале

задания сигнала t:

It(S)

= N log L = (t/T) log L.

(16)

Увеличение числа

уровней L

увеличивает пропускную способность

каналов связи, но усложняет аппаратуру

кодирования данных и снижает

помехоустойчивость связи.

Для

непрерывных сигналов передача по каналам

связи возможна только при условии, что

максимальная информационная частота

в сигнале Fmax

не превышает предельной частоты Fпред

передачи сигналов каналом связи. Для

оценки информационной емкости непрерывного

сигнала выполним его дискретизацию с

интервалом t

= 1/2Fmax.

Как установлено Котельниковым и Шенноном,

по мгновенным отсчетам непрерывного

сигнала с таким интервалом дискретизации

аналоговый сигнал может быть восстановлен

без потери информации. При полной

длительности сигнала Ts

число отсчетов:

N

= Ts/t

= 2Fmax

Ts.

Определим

максимально возможное число выборок в

каждом отсчете при наличии шума в канале

со средней мощностью Рш

= 2.

При средней мощности сигнала Ps

= s2:

L

= ![]() =

=![]() .

.

Информационная

емкость сигнала:

I(S) =

2Fmax

Ts

log L. (17)

Информационные

возможности сигнала возрастают с

расширением его спектра и превышением

его уровня над уровнем помех.

Пространство

сигналов

Важнейшее свойство

аналоговых и дискретных сигналов

заключается в том, что их линейные

комбинации также являются аналоговыми

или дискретными сигналами.Линейные

комбинации цифровых сигналов, в силу

их ограничения по разрядности, в принципе

относятся к разряду нелинейных операций,

однако последним фактором можно

пренебречь, если ошибки, которые вносятся

в результаты наблюдений при квантовании

отсчетов, достаточно малы по сравнению

с шумами зарегистрированной информации.

При дискретизации и квантовании данных

непосредственно на входах в ЭВМ это

условие выполняется практически всегда,

поскольку ошибки определяются разрядностью

ЭВМ и программными системами обработки

данных, которые обычно не ниже 6-12

десятичных разрядов.

Множества

сигналов.Сигналы обычно

рассматриваются в составе определенных

множеств L, объединенных каким-либо

свойством Р, характерным для всех и

каждого из сигналов данного множества.

Условное отображение множества: L = {s;

P} – множество всех s, для которых

справедливо свойство Р. Определив

свойство Р, мы тем самым можем ограничивать

сигналы, действующие в каких-либо

системах, определенными типами, условиями,

границами по параметрам и т.п.

Множества сигналов

могут образовываться из других, ранее

определенных множеств, логическими

операциями объединения (индекс – )

и пересечения (индекс -):

L = S1

S2

= {s; s

S1 или

s

S2},

L = S1S2= {s; sS1и sS2}.

Возможно разбиение

множества сигналов на непересекающиеся

подмножества, более удобные для обработки,

при этом для множества S, разбитого на

совокупность подмножеств {S1, S2,

S3, …, SN}, должны выполняться

условия:

S=S1S2 S3…SN,

SnSm=дляn≠m.

Запись S1Sозначает, что множествоS1входит в состав

множества S, т.е. является подмножеством

в составе S.

Преобразование

элементов vi

множества V в элементы gi

множества G называется отображением

(трансформацией, преобразованием) V в

G. Символьные записи преобразования: g

= T[v] или v → g,

при этом элементы v

называют прообразом множества g,

а элементы g – образом множества v.

Если преобразование

выполняется над числами одного множества

R (например, x = T[y]), то такое преобразование

порождает функциональную зависимость

x = f(y).

Если преобразование

выполняется над функциями одного и того

же множества L (например, f(t) = T[g(t)], f(t)

L и g(t)

L),

то алгоритм преобразования T[..] называют

оператором преобразования f(t) в g(t).

Преобразование

g = T[f(t)] функций f(t) множества F называют

функционалом, если результатом

преобразования являются числовые

значения g множества G. Примерами

функционалов являются интегралы функций

в определенных пределах.

Преобразование

может выполняться функциональными

операторами с переводом функций одной

переменной, например t, в функции по

другой переменной, например ω, Типичным

примером функционального оператора

является преобразование Фурье. В

комплексной форме:

S(ω)

= ![]() s(t)

s(t)

exp(-jωt) dt.

Пространство

сигналов.Для анализа и обработки

информации, которая может быть заключена

в сигналах, требуется выделять из

множества сигналов сигналы с определенными

параметрами, сравнивать сигналы друг

с другом, оценивать изменение сигналов

при их прохождении через системы

обработки данных, и т.п. Это может

выполняться только при “помещении”

множества сигналов в определенные

метрические пространства с заранее

оговоренными свойствами и единицами

измерений.Положение на поверхности

Земли любого объекта однозначно

определяется по “координатному

сигналу” в заранее сформированных

метрических координатных пространствах

с нулевыми точками и принятыми единицами

измерений. Для практического использования

сформированы также различные пространства

картографических проекций с определенными

структурными ограничениями, жестко

установленная метрология которых

позволяет трансформировать информацию

из одного пространства в другое, более

удобное для отображения или обработки

определенными программами.

Главным условием

превращения множество сигналов L{s1(t),

s2(t), …}, которые имеют

какие-то общие свойства, в функциональное

пространство сигналов является выполнение

условия однозначной реализации. Если

пространство значений независимой

переменной t задано выражением

R:=(-,+),

то пространство сигналов LP[R]

определяет множество сигналов в этом

пространстве, для которых условие

однозначной реализации записывается

в следующей форме:

![]() |s(t)|p

|s(t)|p

dt < .

Для анализа

сигналов наиболее часто используется

гильбертово пространство, сигналы в

котором должны удовлетворять условию

интегрирования с квадратом:

![]() |s(t)|2

|s(t)|2

dt < .

Периодические

сигналы обычно рассматриваются в

пространстве L2 [0,

2π] одного периода:

![]() |s(t)|2

|s(t)|2

dt < .

Метрические

пространства должны иметь определенную

систему координат, что позволяет

рассматривать любые произвольные

сигналы х и у, принадлежащие пространству,

в виде векторов, соединяющих начало

координат с определенными точками этого

пространства и определять расстояние

(x,y) между

этими точками (метрика). Так как расстояние

между точками должно быть числовым, а

сигналы х и у представляют собой функции,

то (x,y)

представляет собой функционал, для

которого в метрическом пространстве

должны быть справедливы следующие

аксиомы:

-

(x,y)

≥ 0; (x,y)

= 0 при х = у, -

(x,y)

=

(y,x), -

(x,z)

≤ (x,y)

+ (y,z)

– неравенство треугольника.

Каждый элемент

векторного пространства может отображаться

проекциями на координатные оси, а для

обработки и преобразований сигналов

могут использоваться операции векторной

алгебры. Достаточно простые алгебраические

взаимосвязи между сигналами характерны

для линейных пространств.

Линейное

пространство сигналов.Метрическое

пространство является линейным,

если в нём определены операции сложения

векторов и умножения вектора на скаляр,

в результате которых образуется новый

вектор в том же пространстве.Множество

сигналов L образует линейное пространство

сигналов, если для него справедливы

следующие аксиомы

-

Множество

содержит такой нулевой элемент ,

что для всех сигналов u(t)

L выполняется равенство u(t) +

= u(t). -

Для любых

сигналов u(t)

L и v(t) L

существует их сумма s(t) = u(t)+v(t), которая

также содержится в L. При этом операция

суммирования должна быть

– коммутативна:

u(t)+v(t) = v(t)+u(t),

– ассоциативна:

u(t)+(v(t)+x(t)) = (u(t)+v(t))+x(t),

– однородна: u(t)

+ (-u(t)) = .

-

Существует

множество скалярных элементов ,

на которые может выполняться умножение

любого сигнала s(t)

L, при этом результат умножения является

новым сигналом y(t) = s(t)

в том же пространстве, у(t)

L. Операция умножения должна быть

–

ассоциативна:

(·s(t))

= ·s(t),

–

дистрибутивна:

(u(t)+s(t))

= u(t)+s(t),

(+)s(t)

= s(t)+s(t),

–

пропорциональна:

1·s(t) = s(t), 0·s(t) = 0.

Сигналы могут

описываться как вещественными, так и

комплексными функциями, и линейные

пространства также могут быть вещественными

или комплексными. Скалярные множества

обычно отождествляются с множествами

действительных или комплексных чисел,

но на них также могут накладываться

определенные ограничения. Так, например,

в теории связи широко применяется

бинарное скалярное множество{0, 1}.

Множество L, для

которого выполняются приведенные выше

аксиомы, при анализе сигналов и систем

может рассматриваться как специальным

образом сконструированное многомерное

(в пределе – бесконечномерное)

геометрическое пространство. Рассмотрим

это на конкретном примере.

Имеем произвольный

сигнал s(t), заданный на интервале [a, b].

Дискретизируем сигнал с равномерным

шагом дискретизации и переведем в

цифровую форму (представим сигнал N

последовательными выборками):

s = (s1, s2,

… , sN).

В таком отображении

величина s может рассматриваться в виде

N-мерного вектора в N-мерном пространстве,

в котором значения snпредставляют

собой проекции s-вектора на координатные

оси данного пространства. Двумерный

вектор в двумерном пространстве – это

точка с координатами s1и s2на рис. 21. Соответственно, в трехмерном

пространстве сигнал s представлен точкой

в трехмерном пространстве. Представить

себе N-мерное пространство при N>3 можно

только абстрактно, но с математических

позиций такое пространство вполне

реально и N-мерный сигнал s отображается

вполне определенной точкой в этом

пространстве с координатами snпо

осям пространства. При уменьшении

интервала дискретизации сигнала до

бесконечно малой величины значение N

стремится к бесконечности, и пространство

сигналов превращается в бесконечномерное

пространство аналоговых сигналов.

Следовательно, и аналоговые сигналы

могут рассматриваться как предельный

случай бесконечномерных векторов.

Рисунок 21 –

Пространства сигналов и функций.

С учетом

вышеизложенного, для математического

анализа систем и сигналов в линейном

пространстве может использоваться

математика векторов.

В линейном

пространстве L{un;

n=0,1,2,…,N}

всегда можно выделить множество векторов

{xn; n=0,1,2,…,N},

для которых выполняется равенство нулю

их линейной комбинации

![]() n

n

xn = 0

(18)

только при условии

равенства нулю всех значений k.

Такое множество векторов называется

линейно независимым. Ни один

вектор линейно независимого множества

не может быть выражен в виде какой-либо

линейной комбинации других векторов

этого пространства. Такое множество

векторов называется базисом

N-мерного пространства

L{un; N}.

Линейная комбинация таких ![]() линейно независимых векторов образует

линейно независимых векторов образует

векторное пространство где каждый

вектор U может быть выражен единственной

линейной комбинацией векторовxn:

U = n

n

xn

Совокупность

![]() чисел {n}

чисел {n}

называется спектром вектора

U в этом базисе.

Спектр вектора в общем случае может

быть комплексным.

Линейные

пространства сигналов имеют, как правило,

не единственный базис. Выбор базиса

определяется простотой и удобством его

использования при обработке сигналов.

Основными

метрическими параметрами линейного

пространства являются норма, метрика

и скалярное произведение сигналов.

Норма сигналов

в линейном

пространстве является аналогом длины

векторов, и обозначается индексом

||s(t)|| – норма.

В математике существуют различные формы

норм. При анализе сигналов обычно

используются квадратичные нормы

||s(t)|| = .

.

(19)

Для дискретных

сигналов:

||s(n)|| =![]() .

.

(19′)

Для комплексных

сигналов

||s(t)|| = ,

,

(19”)

где s*(t) – величины,

комплексно сопряженные с s(t).

Линейное пространство

сигналов L является нормированным, если

каждому сигналу пространства s(t)

однозначно сопоставлена его числовая

норма ||s(t)||, и выполняются следующие

аксиомы:

-

Норма неотрицательна

(||s(t)|| ≥ 0) и равна нулю тогда и только

тогда, когда сигнал равен нулю (||s(t)|| =

, при s(t) =). -

Для любого числа

b должно быть справедливо равенство||bs(t)|| = |b|||s(t)||. -

Если v(t) и u(t) –

сигналы из пространства L, то должно

выполняться неравенство треугольника||v(t)+u(t)||||v(t)|| +

||u(t)||.

Пример нормы для

двумерных цифровых сигналов приведен

на рисунке 22.

Рисунок 22 – Норма

и метрика сигналов.

Метрика

сигналов.Линейное пространство

сигналов L является метрическим, если

каждой паре сигналов s(t)

L и v(t) L

однозначно сопоставляется неотрицательное

число (s,v) –

метрика или расстояние

между векторами. Пример метрики для

двух векторов в двумерном пространстве

приведен на рисунке 22.

Для метрик сигналов

в метрическом пространстве любой

размерности должны выполняться аксиомы:

-

(s,v) = (v,s)

– рефлексивность метрики. -

(s,s) =

0 для любых

s(t)

L. -

(s,v)

(s,a)

+ (a,v)

для любых

a

L.

Метрика определяется

нормой разности двух сигналов (рисунок

22)

(s,v) = || s(t) – v(t)

||. (20)

В свою очередь

норму можно отождествлять с расстоянием

от выбранного элемента пространства

до нулевого||s(t)||

=(s(t),).

По метрике

сигналов можно судить, например, о том,

насколько точно один сигнал может быть

аппроксимирован другим сигналом, или

насколько изменяется выходной сигнал

относительно входного при прохождении

через какое-либо устройство. Пространство

сигналов может иметь несколько метрик.

Соседние файлы в папке Лекции

- #

- #

- #

- #

- #

- #

- #

- #

- #

Автор материалов – Лада Борисовна Есакова.

При оцифровке звука в памяти запоминаются только отдельные значения сигнала. Чем чаще записывается сигнал, тем лучше качество записи.

Частота дискретизации f – это количество раз в секунду, которое происходит преобразование аналогового звукового сигнала в цифровой. Измеряется в Герцах (Гц).

Глубина кодирования (а также, разрешение) – это количество бит, выделяемое на одно преобразование сигнала. Измеряется в битах (Бит).

Возможна запись нескольких каналов: одного (моно), двух (стерео), четырех (квадро).

Обозначим частоту дискретизации – f (Гц), глубину кодирования – B(бит), количество каналов – k, время записи – t(Сек).

Количество уровней дискретизации d можно рассчитать по формуле: d = 2B.

Тогда объем записанного файла V(бит) = f * B * k * t.

Или, если нам дано количество уровней дискретизации,

V(бит) = f * log2d * k * t.

Единицы измерения объемов информации:

1 б (байт) = 8 бит

1 Кб (килобайт) = 210 б

1 Мб (мегабайт) = 220 б

1 Гб (гигабайт) = 230 б

1 Тб (терабайт) = 240 б

1 Пб (петабайт) = 250 б

При оцифровке графического изображения качество картинки зависит от количества точек и количества цветов, в которые можно раскрасить точку.

Если X – количество точек по горизонтали,

Y – количество точек по вертикали,

I – глубина цвета (количество бит, отводимых для кодирования одной точки), то количество различных цветов в палитре N = 2I. Соответственно, I = log2N.

Тогда объем файла, содержащего изображение, V(бит) = X * Y * I

Или, если нам дано количество цветов в палитре, V(бит) = X * Y * log2N.

Скорость передачи информации по каналу связи (пропускная способность канала) вычисляется как количество информации в битах, переданное за 1 секунду (бит/с).

Объем переданной информации вычисляется по формуле V = q * t, где q – пропускная способность канала, а t – время передачи.

Кодирование звука

Пример 1.

Производится двухканальная (стерео) звукозапись с частотой дискретизации 16 кГц и глубиной кодирования 32 бит. Запись длится 12 минут, ее результаты записываются в файл, сжатие данных не производится. Какое из приведенных ниже чисел наиболее близко к размеру полученного файла, выраженному в мегабайтах?

1) 30 2) 45 3) 75 4) 90

Решение:

V(бит) = f(Гц)* B(бит) * k * t(Сек),

где V – размер файла, f – частота дискретизации, B – глубина кодирования, k – количество каналов, t – время.

Значит, V(Мб) = (f * B * k * t ) / 223

Переведем все величины в требуемые единицы измерения:

V(Мб) = (16*1000 * 32 * 2 * 12 * 60 ) / 223

Представим все возможные числа, как степени двойки:

V(Мб) = (24 * 23 * 125 * 25 * 2 * 22 * 3 * 15 * 22) / 223 = (5625 * 217) / 223 = 5625 / 26 =

5625 / 64 ≈ 90.

Ответ: 4

!!! Без представления чисел через степени двойки вычисления становятся намного сложнее.

!!! Частота – это физическая величина, а потому 16 кГц = 16 * 1000 Гц, а не 16 * 210. Иногда этой разницей можно пренебречь, но на последних диагностических работах она влияла на правильность ответа.

Пример 2.

В течение трех минут производилась четырёхканальная (квадро) звукозапись с частотой дискретизации 16 КГц и 24-битным разрешением. Сжатие данных не производилось. Какая из приведенных ниже величин наиболее близка к размеру полученного файла?

1) 25 Мбайт

2) 35 Мбайт

3) 45 Мбайт

4) 55 Мбайт

Решение:

V(бит) = f(Гц)* B(бит) * k * t(Сек),

где V – размер файла, f – частота дискретизации, B – глубина кодирования (или разрешение), k – количество каналов, t – время.

Значит, V(Мб) = (f * B * k * t ) / 223 = (16 * 1000 * 24 * 4 * 3 * 60) / 223 = (24 * 23 * 125 * 3 * 23 * 22 * 3 * 15 * 22) / 223 = (125 * 9 * 15 * 214) / 223 = 16875 / 29 = 32, 96 ≈ 35

Ответ: 2

Пример 3.

Аналоговый звуковой сигнал был записан сначала с использованием 64 уровней дискретизации сигнала, а затем с использованием 4096 уровней дискретизации сигнала. Во сколько раз увеличился информационный объем оцифрованного звука?

1) 64

2) 8

3) 2

4) 12

Решение:

V(бит) = f * log2d * k * t, где V – размер файла, f – частота дискретизации, d – количество уровней дискретизации, k – количество каналов, t – время.

V1 = f * log264 * k * t = f * 6 * k * t

V2 = f * log24096 * k * t = f * 12 * k * t

V2 / V1 = 2

Правильный ответ указан под номером 3.

Ответ: 3

Кодирование изображения

Пример 4.

Какой минимальный объём памяти (в Кбайт) нужно зарезервировать, чтобы можно было сохранить любое растровое изображение размером 64×64 пикселей при условии, что в изображении могут использоваться 256 различных цветов? В ответе запишите только целое число, единицу измерения писать не нужно.

Решение:

V(бит) = X * Y * log2N, где V – объем памяти, X,Y – количество пикселей по горизонтали и вертикали, N – количество цветов.

V (Кб) = (64 * 64 * log2256) / 213 = 212 * 8 / 213 = 4

Ответ: 4

Пример 5.

Для хранения растрового изображения размером 64×32 пикселя отвели

1 килобайт памяти. Каково максимально возможное число цветов в палитре изображения?

Решение:

V(бит) = X * Y * log2N, где V – объем памяти, X,Y – количество пикселей по горизонтали и вертикали, N – количество цветов.

log2N = V /( X*Y) = 213 / (26 * 25) = 4

N = 16

Ответ:16

Сравнение двух способов передачи данных

Пример 6.

Документ объемом 5 Мбайт можно передать с одного компьютера на другой двумя способами:

А) Сжать архиватором, передать архив по каналу связи, распаковать.

Б) Передать по каналу связи без использования архиватора.

Какой способ быстрее и насколько, если

– средняя скорость передачи данных по каналу связи составляет 218 бит в секунду,

– объем сжатого архиватором документа равен 80% от исходного,

– время, требуемое на сжатие документа – 35 секунд, на распаковку – 3 секунды?

В ответе напишите букву А, если способ А быстрее или Б, если быстрее способ Б. Сразу после буквы напишите количество секунд, насколько один способ быстрее другого. Так, например, если способ Б быстрее способа А на 23 секунды, в ответе нужно написать Б23. Слов «секунд», «сек.», «с.» к ответу добавлять не нужно.

Решение:

Способ А. Общее время складывается из времени сжатия, распаковки и передачи. Время передачи t рассчитывается по формуле t = V / q, где V — объём информации, q — скорость передачи данных.

Объем сжатого документа: 5 * 0,8 = 4 Мб =4 * 223 бит.

Найдём общее время: t = 35 с + 3 с + 4 * 223 бит / 218 бит/с = 38 + 27 с = 166 с.

Способ Б. Общее время совпадает с временем передачи: t = 5 * 223 бит / 218 бит/с = 5 * 25 с = 160 с.

Способ Б быстрее на 166 – 160 = 6 с.

Ответ: Б6

Определение времени передачи данных

Пример 7.

Скорость передачи данных через ADSL─соединение равна 128000 бит/c. Через данное соединение передают файл размером 625 Кбайт. Определите время передачи файла в секундах.

Решение:

Время t = V / q, где V — объем файла, q — скорость передачи данных.

t = 625 * 210 байт / (2 7 * 1000) бит/c = 625 * 213 бит / (125 * 210) бит/c = 5 * 23 с = 40 с.

Ответ: 40

Пример 8.

У Васи есть доступ к Интернет по высокоскоростному одностороннему радиоканалу, обеспечивающему скорость получения им информации 217 бит в секунду. У Пети нет скоростного доступа в Интернет, но есть возможность получать информацию от Васи по низкоскоростному телефонному каналу со средней скоростью 215 бит в секунду. Петя договорился с Васей, что тот будет скачивать для него данные объемом 4 Мбайта по высокоскоростному каналу и ретранслировать их Пете по низкоскоростному каналу. Компьютер Васи может начать ретрансляцию данных не раньше, чем им будут получены первые 512 Кбайт этих данных. Каков минимально возможный промежуток времени (в секундах), с момента начала скачивания Васей данных, до полного их получения Петей? В ответе укажите только число, слово «секунд» или букву «с» добавлять не нужно.

Решение:

Нужно определить, сколько времени будет передаваться файл объемом 4 Мбайта по каналу со скоростью передачи данных 215 бит/с; к этому времени нужно добавить задержку файла у Васи (пока он не получит 512 Кбайт данных по каналу со скоростью 217 бит/с).

Время скачивания данных Петей: t1= 4*223 бит / 215 бит/с = 210 c.

Время задержки: t2 = 512 кб / 217 бит/с = 2(9 + 10 + 3) – 17 c = 25 c.

Полное время: t1 + t2 = 210 c + 25 c = (1024 + 32) c = 1056 c.

Ответ: 1056

Пример 9.

Данные объемом 60 Мбайт передаются из пункта А в пункт Б по каналу связи, обеспечивающему скорость передачи данных 219 бит в секунду, а затем из пункта Б в пункт В по каналу связи, обеспечивающему скорость передачи данных 220 бит в секунду. Задержка в пункте Б (время между окончанием приема данных из пункта А и началом передачи в пункт В) составляет 25 секунд. Сколько времени (в секундах) прошло с момента начала передачи данных из пункта А до их полного получения в пункте В? В ответе укажите только число, слово «секунд» или букву «с» добавлять не нужно.

Решение:

Полное время складывается из времени передачи из пункта А в пункт Б (t1), задержки в пункте Б (t2) и времени передачи из пункта Б в пункт В (t3).

t1 = (60 * 223) / 219 =60 * 16 = 960 c

t2 = 25 c

t3 = (60 * 223) / 220 =60 * 8 = 480 c

Полное время t1 + t2 +t3 = 960 + 25 + 480 = 1465 c

Ответ: 1465

Спасибо за то, что пользуйтесь нашими материалами.

Информация на странице «Задача №9. Кодирование звуковой и графической информации. Передача информации, Время записи звукового файла, время передачи данных, определение объема информации.» подготовлена нашими авторами специально, чтобы помочь вам в освоении предмета и подготовке к ЕГЭ и ОГЭ.

Чтобы успешно сдать нужные и поступить в ВУЗ или техникум нужно использовать все инструменты: учеба, контрольные, олимпиады, онлайн-лекции, видеоуроки, сборники заданий.

Также вы можете воспользоваться другими материалами из разделов нашего сайта.

Публикация обновлена:

07.05.2023

1. Найди информационный объём следующего сообщения, если известно, что один символ кодируется одним байтом.

Кто владеет информацией, тот владеет миром.

Решение: посчитаем количество символов в сообщении, будем учитывать буквы, знаки препинания и пробелы.

Всего (43) символа. Каждый символ кодируется (1) байтом.

(I = К · i), (43 · 1) байт (= 43) байта.

Ответ: (43) байта.

2. Найди информационный объём слова из (12) символов в кодировке Unicode (каждый символ кодируется двумя байтами). Ответ дайте в битах.

Решение.

Мы знаем из условия задачи, что каждый символ кодируется двумя байтами. Найдём сколько это бит.

(2) байта (· 8 = 16) бит;

Слово состоит из (12) символов, поэтому

(16) бит (· 12) символов (= 192) бита.

Ответ: (192) бита.

3. Найди информационный вес книги, которая состоит из (700) страниц, на каждой странице (70) строк и в каждой строке (95) символов . Мощность алфавита — (256) символов. Ответ дать в Мб.

Решение: если мощность алфавита (256) символов, то информационный объём одного символа (8) бит.

Найдём количество символов в книге: (700·70·95 = 4655000) символов.

Информационный вес сообщения: (4655000·8=37240000) бит.

Ответ нужно дать в Мб, поэтому переведём биты в Мб

(37240000:8:1024:1024 = 4,44) Мб

Ответ: (4,44) Мб.

Определение информационного объема сообщения. Информатика в 7 классе.

Тема: «Измерение информации»

Формулы

Для определения информационного объема сообщения потребуются две формулы:

1. ( N= 2^i )

N — мощность алфавита

i — информационный объём одного символа в алфавите

2. ( I = k * i )

I — информационный объём сообщения

k — количество символов в сообщении

i — информационный объём одного символа в алфавите

Формула нахождения k:

( k = frac{mathrm I}{mathrm i} )

Формула нахождения i:

( i = frac{mathrm I}{mathrm k} )

Задачи

Задача №1. Сообщение, записанное буквами из 128-символьного алфавита, содержит 30 символов. Найти информационный объем всего сообщения?

Решение. Запишем, что дано по условию задачи и что необходимо найти:

N = 128

k = 30

( I = ? )

( i = ? )

Сначала найдем вес одного символа по формуле:

( N= 2^i ) = ( 128= 2^7 )

( i = 7 ) бит. Какая степень двойки, такой вес одного символа в алфавите. Далее определяем информационный объем сообщения по формуле:

( I = k * i ) = 30 * 7 = 210 бит

Ответ: 210 бит

Задача №2. Информационное сообщение объемом 4 Кбайта содержит 4096 символов. Сколько символов содержит алфавит, при помощи которого было записано это сообщение?

Решение. Запишем, что дано по условию задачи и что необходимо найти:

( I = 4 ) Кб

k = 4096

( N = ? )

( i = ? )

Очень важно перевести все числа в степени двойки:

1 Кб = ( 2^{13} ) бит

( I = 4 ) Кб = ( 2^2 ) * ( 2^{13} ) = ( 2^{15} ) бит

k = 4096 = ( 2^{12} )

Сначала найдем вес одного символа по формуле:

( i = frac{mathrm I}{mathrm k} ) = ( 2^{15} ) : ( 2^{12} ) = ( 2^3 ) = 8 бит

Далее находим мощность алфавита по формуле:

( N= 2^i ) ( 2^8 =256)

Ответ: 256 символов в алфавите.

Задача №3. Сколько символов содержит сообщение, записанное с помощью 16-символьного алфавита, если его объем составляет 1/16 Мб?

Решение. Запишем, что дано по условию задачи и что необходимо найти:

N = 16

( I = frac{mathrm 1}{mathrm 16} ) Мб

( k = ? )

( i = ? )

Представим ( I = frac{mathrm 1}{mathrm 16} ) Мб в степень двойки:

1 Мб = ( 2^{23} ) бит

( I = frac{mathrm 1}{mathrm 16} ) Мб = ( 2^{23} ) : ( 2^4 ) = ( 2^{19} ) бит.

Сначала найдем вес одного символа по формуле:

( N= 2^i ) = ( 2^4 = 16 )

( i = 4 ) бит = ( 2^2 )

Теперь найдём количество символов в сообщении k:

( k = frac{mathrm I}{mathrm i} ) = ( 2^{19} ) : ( 2^2 ) = ( 2^{17} ) = 131072

Ответ: 131072 символов в сообщении.