Игровой потенциал компьютера определяется в первую очередь установленной в него видеокартой. А следовательно — к ее выбору нужно подходить не менее ответственно, чем к покупке центрального процессора или материнской платы.

В этом гайде мы в очередной раз постараемся рассказать о том, на что действительно стоит обратить внимание при выборе видеокарты, а какие распространенные убеждения на деле являются бесполезными и даже вредными мифами.

Что выбрать — Nvidia или AMD

Nvidia и AMD — это не видеокарты. Это, внезапно, — названия компаний.

Если же вы выбираете видеокарту — то выбирать нужно конкретный продукт за конкретную цену. Ориентироваться следует на его реальные характеристики: стоимость, количество FPS в играх, возможности разгона и получаемый от него прирост производительности.

Для наглядности — рассмотрим конкретный пример:

Radeon RX 5500 XT в версии с 4 гигабайтами набортной памяти стоит столько же, сколько GeForce GTX 1650 Super. Их энергопотребление одинаково, производительность — тоже.

Очевидно, что в данном случае можно выбирать и ту, и другую карту. И, что бы вы ни предпочли, вы абсолютно ничего не потеряете.

А вот — Radeon RX 5500 XT в версии c 8 гигабайтами, который стоит столько же, сколько и GeForce GTX 1660:

При одинаковой цене карта от AMD оказывается уже немного медленнее. Да, разницу трудно назвать существенной, и уж абсолютно точно она не позволит играть с более высокими настройками или в большем разрешении.

Но какой смысл отдавать те же деньги за продукт, который, пусть и очень условно, но слабее? Вот если разница в цене составит 2–3 тысячи рублей, которые можно «вложить» в другие комплектующие — тогда другое дело.

Оперирование мифическими параметрами вроде «репутации бренда», «стабильности софта» или «особо яркой, сочной картинки» в итоге приведет вас к покупке видеокарты, которая либо не будет справляться с вашими задачами, либо покажет себя хуже, чем решение от конкурентов.

От какой компании купить карту — Gigabyte, Asus или MSI

У каждого вендора есть несколько линеек продуктов, нацеленных на бюджетный, средний и высший ценовые сегменты. Причем касается это в том числе и карт, основанных на одном и том же графическом чипе.

Есть карты, отличающиеся от референсного дизайна только наклейкой и комплектом поставки, есть продукты, ориентированные на упрощение и удешевление оригинальной конструкции, но есть и глубоко переработанные устройства, рассчитанные на энтузиастов и оверклокеров.

Соответственно, видеокарты каждого из трех типов будут отличаться разными характеристиками. К примеру, условная видеокарта Inno3D из линейки iChill, с массивным кулером, разработанным компанией Arctic по спецзаказу, всегда будет холоднее, тише и возьмет бо́льшие частоты, нежели условная видеокарта Asus TURBO, использующая для охлаждения референсную турбину. И никакая «репутация бренда» этого никогда не изменит.

Впрочем, не думайте, что это не работает в обратном направлении: видеокарта Asus ROG STRIX всегда будет тише, холоднее и более приспособлена к разгону, чем, к примеру, Palit StormX на том же графическом чипе. А Palit Jetstream или Super Jetstream, в свою очередь, могут ничем не уступать Asus ROG STRIX, но побеждать их ценой…

Нужна игровая видеокарта. Карта с 4 гигабайтами памяти подойдет?

Вопрос можно переиначить следующим образом: «Я хочу купить машину, разгоняющуюся до 100 км/ч за 7 секунд. Хватит для этого машины с багажником объемом в 520 литров?». Что, согласитесь, полный абсурд — объем багажника очевидно не является фактором, влияющим на динамику разгона автомобиля.

Одно из распространенных заблуждений, касающихся видеокарт — то, что их производительность напрямую зависит от объема установленной памяти.

Отчасти это верно, но лишь отчасти. Память, установленная на видеокарте — это и есть своего рода «багажник», в котором хранится весь объем данных, генерируемых и используемых графическим процессором: игровые текстуры, геометрические вершины и буферы. Если этого объема достаточно для конкретной игры — отлично, все будет работать в штатном режиме.

Если же объем памяти мал — могут возникнуть проблемы. На современных платформах под нужды графики начнет выделяться часть оперативной памяти — однако DRR4 медленнее GDDR5 и уж тем более GDDR6, и переход к ее ресурсам может привести к временному падению производительности, что не очень комфортно.

Опять же, конкретный пример:

Horizon Zero Dawn, разрешение экрана — FullHD, настройки графики — высокие:

Как можно видеть, Radeon RX 5500 XT в версии с 8 гигабайтами на борту использует собственную память, в то время как RX 5500 XT 4gb и GTX 1650 Super вынуждены использовать часть оперативки.

К чему это приводит можно заметить по счетчику FPS, и в особенности — по показателю 1% событий. Обе карты с 4 гигабайтами памяти на борту резко проседают, что делает игровой процесс далеким от понятия комфорта. С другой стороны, в этом примере речь идет об одном разрешении экрана и одном наборе настроек, при котором ни одна из трех карт не обеспечивает постоянных и стабильных 60 кадров в секунду по показателю среднего FPS. Следовательно, настройки так или иначе придется снижать.

А что будет на средних и низких настройках графики в той же сцене?

Как можно видеть, со снижением настроек графики потребление видеопамяти снижается. А следовательно — даже в этой требовательной игре можно найти компромиссные параметры.

Так сколько же в итоге должно быть набортной памяти? Ее не должно быть много или мало: памяти должно быть достаточно для игры на тех настройках, на которых графический процессор способен выдавать комфортный уровень FPS.

Рассмотрим это на конкретном примере: сцена из встроенного бенчмарка игры Assassin’s Creed: Valhalla, запущенного на Radeon RX 6500 XT с 4 гигабайтами памяти на борту:

В примере слева используется штатный профиль «Высокие настройки». Хотя показатель среднего фпс держится на отметке в 34 кадра, постоянные просадки по 1% и 0,1% редких событий и нестабильный график времени кадра делают игровой процесс на этих настройках графики попросту невозможным. И дело не только в нехватке объема памяти, но и в том, что видеокарта начального уровня не рассчитана на игру на этих настройках графики.

Справа — та же игра и та же видеокарта, однако настройки графики понижены до средних. В этом случае потребление видеопамяти ниже буквально на один гигабайт, но кроме этого существенно снижается и нагрузка на ГПУ. 37 и 49 кадров по редким событиям, 54 и 63 кадра — по показателям минимального и среднего фпс. И абсолютно комфортный геймплей.

Объем памяти — важная характеристика видеокарты, но его нельзя рассматривать в отрыве от производительности ГПУ, игр и настроек графики, которые предполагается получить.

И уж совершенно точно не стоит думать, будто GeForce GT 730 и GeForce GTX 1650 Super при одинаковом объеме памяти в 4 гигабайта позволят выставить одинаковые настройки и получить одинаковую производительность.

Так сколько видеопамяти вообще нужно?

Если мы говорим о современных игровых видеокартах, которые РЕАЛЬНО способны тянуть игровые новинки на высоких и максимальных настройках как минимум в FullHD — 6 или 8 гигабайт памяти на борту будут обязательны. А для QuadHD и 4К — это и вовсе необходимый минимум, если не понижать настройки до средних. Но если вы не гонитесь за максимальными настройками, или вовсе предпочитаете новинкам старые добрые игры из эпохи до середины 2010-ых годов — и 4 гигабайт вам будет достаточно.

Для примера, вот столько видеопамяти потребляет Ведьмак 3 (игра 2015 года выпуска) на максимальных настройках графики в FullHD и QuadHD:

Что же касается видеокарт начального уровня — объем памяти выше 2 гигабайт для них скорее избыточен: для воспроизведения медиаконтента, аппаратного ускорения браузера и эффектов интерфейса ОС хватит и этого, а на игры AAA-класса их ГПУ уже не рассчитан.

Стоит ли выбирать карты с шиной в 256 бит вместо 128 бит

Сравнение видеокарт по «ширине» шины памяти — это всего лишь еще одна попытка выбрать из непонятного и обширного комплекса параметров одно простое число. Да, шина «толщиной» в 256 бит может обеспечить большую пропускную способность, чем шина в 128 бит, но сравнивать их можно только если все прочие параметры одинаковы. Разные типы памяти — к примеру, GDDR5 и GDDR6 — обладают совершенно разными скоростями чтения и записи и даже разными диапазонами рабочих частот, что уже делает прямое сравнение бессмысленным.

Но ведь и тут все не так просто! Дело не только в самой памяти, но и в характеристиках ГПУ: каким объемом данных он реально оперирует, и самое главное — насколько эффективно эти данные сжимает.

Metro: Exodus, разрешение экрана — FullHD, настройки графики — высокие, тесселяция включена, эффекты PhysX и Hairworks отключены:

Слева — Radeon RX 6500 XT с шиной всего лишь в 64 бита. Справа — GeForce GTX 1650 со 128-битной шиной. Обе карты используют память стандарта gddr6.

Как можно видеть по счетчику фпс и показателям редких событий — в реальной игре быстрее оказывается совсем не та карта, которая была «лучше» по цифрам в характеристиках.

Но рассмотрим еще один пример:

Star Wars Jedi Fallen Order, разрешение экрана — FullHD, настройки графики — максимальные:

Слева — Radeon RX 580 c 4 гигабайтами памяти gddr5 и 256-битной шиной. Справа — Radeon RX 5500 XT с теми же 4 гигабайтами, но — уже gddr6 на 128-битной шине.

В этом случае все наоборот: разница в кадрах невелика, несмотря на то, что карты относятся к двум разным поколениям и используют разную память. Да, быстрее оказывается более современная модель, но выигрывает она всего 2–3 кадра.

Соблазн свести все к простому объяснению «здесь цифры выше — эта карта лучше» понятен. Но на практике пользы от такого объяснения не будет: скорее наоборот, в результате вы купите видеокарту, которая в реальности окажется хуже той, которую можно было бы приобрести за тот же бюджет.

Если вам так уж хочется все упростить, и сравнивать видеокарты только по одному простому параметру — пусть этим параметром будет количество кадров в играх.

Нужно выбирать видеокарты обязательно с памятью GDDR6?

И снова — нет.

Сама по себе память стандарта gddr6 обеспечивает большую скорость обмена данными при меньшем энергопотреблении по сравнению с gddr5 — это абсолютный факт. Но, как уже говорилось выше, один параметр не может определять все характеристики видеокарты.

Опять же конкретный пример — Red Dead Redemption II, встроенный бенчмарк. Разрешение экрана — FullHD, настройки графики — средние:

Слева — GeForce GTX 1660, с 6 гигабайтами памяти стандарта gddr5. Справа — GeForce GTX 1650 Super с 4 гигабайтами памяти стандарта gddr6.

Быстрее оказывается первая карта: на ее стороне и более мощный ГПУ, и больший объем набортной памяти. Хотя последнее именно здесь не столь важно: бенчмарк задействует лишь чуть более 3.5 гигабайт. Тип набортной памяти может иметь определяющее значение только в том случае, если все прочие параметры видеокарты одинаковы. А такое случается крайне редко.

Пожалуй, единственный наглядный пример — GeForce GTX 1650, которая существует сразу в двух версиях: с памятью стандарта gddr5, и, соответственно, с gddr6:

В этом случае — разумеется, вторая версия заметно быстрее в играх. Но кроме памяти эти карты абсолютно ничем не отличаются, а потому такой результат закономерен.

Если же сравнивать карты разных моделей, а тем более — разных поколений, то тип набортной памяти снова превращается в вырванное из контекста единичное значение, по которому нельзя делать никакие выводы.

Стоит ли менять материнскую плату, если на ней PCI-e 3.0, а у карты PCI-e 4.0

Различные версии интерфейса PCI-e совместимы между собой: видеокарту, разработанную во времена PCI-e 2.0, можно без всяких проблем установить в плату с интерфейсами 3.0 и 4.0. Также и видеокарте с интерфейсом версии 4.0 ничто не запрещает работать в плате со «старой» версией интерфейса.

В качестве наглядного примера можно привести подробные материалы с разбором работы в различных режимах видеокарты Radeon RX 5700 XT и GeForce RTX 2080 Ti.

Оказывать влияние на производительность видеокарты версия интерфейса PCI-e напрямую также не может, даже если рассматривать высокопроизводительные модели, вроде GeForce RTX 3080:

Однако слово «напрямую» в абзаце выше выделено отнюдь неспроста, и косвенное влияние все же имеет место. Скоростной интерфейс важен в том случае, когда потребление видеопамяти превышает объем собственного буфера карты, и она вынуждена использовать часть оперативной памяти в качестве резерва.

Red Dead Redemption II, FullHD и высокие настройки графики:

На этих настройках бенчмарк задействует до 6 гигабайт видеопамяти, и Radeon RX 5500 XT с 8 гигабайтами на борту абсолютно все равно, на какой версии интерфейса ему работать. Кстати, PCI-e 4.0 в этом примере — слева, а PCI-e 3.0 — справа.

А вот младшая версия с 4 гигабайтами на борту – закономерно теряет в производительности, но если сравнивать её результаты с примером RX 5500 XT 8gb, то потери наблюдаются в ОБОИХ случаях. PCI-e 4.0 лишь позволяет немного сгладить этот процесс.

Причем именно сгладить, а не исправить или компенсировать потери. Так как вначале бенчмарка PCI-e 4.0 вроде бы позволяет получить более высокий фпс, но уже к середине тестовой сцены результаты на PCI-e 3.0 и PCI-e 4.0 уравниваются.

Впрочем, есть и редкие исключения, когда влияние оказывает именно пропускная способность интерфейса PCI-e:

Radeon RX 6500XT — единственная пока что видеокарта игрового класса (пусть и начального уровня), использующая всего 4 сигнальных линии PCI-e. В такой конфигурации, как показали исследования, разница в пропускной способности между PCI-e 4.0 и PCI-e 3.0 уже имеет реальное значение.

Правда, разница в реальных сценариях составляет далеко не 50, и даже не 20 процентов. В отдельных случаях она и вовсе равняется 2-3 кадрам в секунду.

Таким образом, если вы вдруг услышите советы о том, что при покупке видеокарты процессор с материнской платой тоже нужно обязательно сменить, иначе ничего работать не будет или старый интерфейс «отрежет» до 15% (20, 25, 30 и так далее) производительности видеокарты, знайте: задача этого «советчика» — именно убедить вас сделать еще одну дорогостоящую покупку.

А что тогда с PCI-e 5.0?

Интерфейс пятой версии реализован на платформе Intel LGA 1700 с процессорами Core 12-ой серии и материнскими платами на чипсетах 600-ой серии.

Несмотря на иные спецификации, внешне разъемы PCI-e x16 никак не изменились. И более того абсолютно никто и ничто не запрещает устанавливать в них актуальные видеокарты, использующие разъём PCI-e 4.0! Ну а раз так – вопрос обратной совместимости разъёмов PCI-e 5.0 c видеокартами под ранние версии интерфейса в принципе не должен подниматься.

А вот видеокарт, рассчитанных именно на интерфейс версии 5.0, в продаже (по состоянию на начало 2022 года) пока что нет, так что говорить об их реальных характеристиках не приходится. Всё пока лишь на этапе слухов и домыслов.

Естественно, PCI-e 5.0 обеспечивает огромный прирост в пропускной способности, но насколько он будет использоваться в реальности — пока загадка. Сейчас даже флагманские видеокарты в лице Radeon RX 6900 XT и GeForce RTX 3090 не упираются в пропускную способность 16 линий PCI-e версии 4.0. Будет ли следующее поколение оперировать на порядок большими объемами данных? Не имея доступа к картам следующего поколения — сказать сложно.

Более-менее реальным поводом для беспокойства может служить переход видеокарт под PCI-e 5.0 на новый разъем дополнительного питания:

Новый стандарт предполагает возможность передачи мощности до 600 ватт. Но, опять же, не зная реального энергопотребления видеокарт следующих поколений, трудно сказать, насколько такая мощность будет востребована. Не исключено, что подобными разъемами будут оснащаться лишь флагманские модели, а младшие решения продолжат использовать привычные 8- и 6-контактные колодки.

Так или иначе, беспокоиться о видеокартах следующего поколения стоит начинать только тогда, когда они будут представлены на рынке в виде реальных продуктов.

Трассировка лучей: важна или нет?

Тренд последнего времени — внедрение в игры обработки освещения в реальном времени, позволяющей отказаться от предварительной расстановки множества «искусственных» источников света по игровому уровню в пользу глобального освещения. А кроме того — внедряющей более реалистичные эффекты отражения и преломления света от различных типов поверхностей.

В самой технологии как таковой нет ничего плохого. Более того, трудно ожидать революции в графике за счет простого наращивания количества пикселей на экране и мегабайт в текстурах: необходимы именно качественные изменения, и трассировка лучей под это определение вполне подходит.

Проблема заключается несколько в ином.

Трассировка лучей хороша только в том случае, если выбранная вами видеокарта РЕАЛЬНО способна обеспечивать комфортный фпс в играх со включенными лучами.

Если мы говорим о моделях видеокарт из семейства Radeon RX 6000 и GeForce RTX 3000, то тут, разумеется, оговоркам не место: вы получите выше 60 FPS со включенными лучами в любой актуальной игре при разрешении FullHD и QuadHD. В 4К — уже не всегда, но даже там можно будет подобрать компромиссные настройки графики.

Что будет, если задействовать трассировку лучей на более бюджетных моделях карт предыдущего поколения?

Буквально:

Control, высокие настройки графики, разрешение экрана — FullHD.

Включение трассировки лучей в «полном» разрешении экрана просаживает производительность ниже 60 кадров на всех видеокартах — только RTX 2080 подбирается к заветной отметке (а точнее — выдает 59 кадров по показателю среднего ФПС).

Задействование технологии апскейла DLSS поправляет ситуацию, но изображение в данном случае генерируется в меньшем разрешении, а затем растягивается до FullHD, так что итоговое качество картинки может оказаться хуже «полного кадра». Плюс, Control — пример наиболее полной реализации DLSS по сравнению с другими играми, поддерживающими трассировку лучей.

Так стоит ли выбирать видеокарты с поддержкой трассировки лучей?

Если речь об актуальном поколении — вопрос лишен смысла, так как и Radeon RX 6000, и GeForce RTX 3000 ее в любом случае поддерживают. Не факт, что выбранная вами видеокарта обеспечит комфортный фпс со включенными лучами на тех же настройках графики, что и без них — но принципиальная возможность все равно останется.

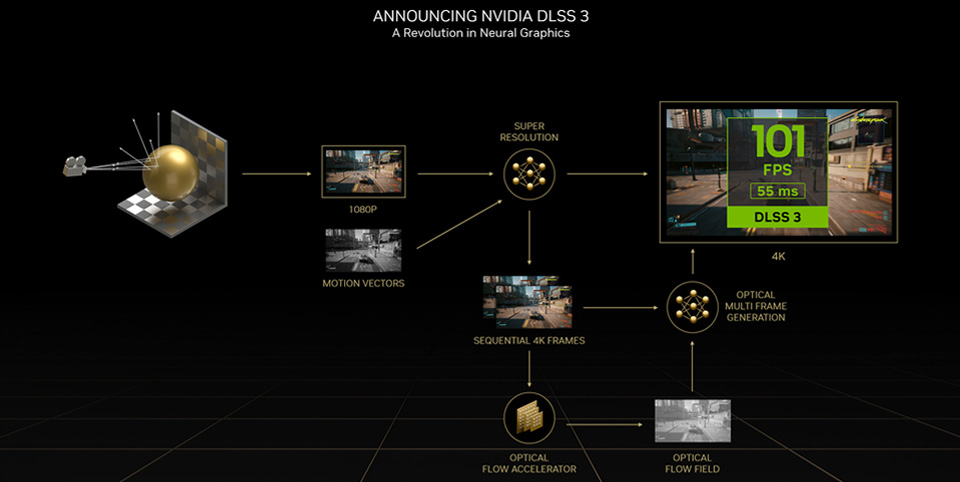

А что это за DLSS, которая фпс повышает?

Алгоритм улучшения качества изображения, поддерживаемый картами GeForce с суффиксом RTX. То есть — для серий 2000 и 3000. Для работы алгоритма требуется наличие у видеокарты тензорных ядер, так что GTX 16** и более ранние поколения, увы, проходят мимо.

Суть алгоритма в получении более качественной картинки из изображения низкого разрешения. Проще говоря — в апскейле.

Да, по факту все гораздо сложнее, и алгоритм имеет самое прямое отношение к ИИ и нейросетям, однако со стороны пользователя работа DLSS выглядит именно так: производительность будет примерно соответствовать разрешению 720p, а качество картинки — примерно соответствовать FullHD. Ну, или оригинальное разрешение FullHD может превратиться в подобие 4К.

Разумеется, основная цель достигается, и количество кадров в секунду примерно соответствует исходному разрешению:

А вот с качеством — не все так очевидно, итоговый результат варьируется от игры к игре и от объекта к объекту. К примеру, мелкие контрастные объекты могут изобиловать артефактами:

С другой стороны, лица и волосы персонажей, особенно если они находятся в статичном положении и на них не накладывается эффект размытия в движении — с DLSS могут выглядеть даже лучше, чем в нативном разрешении со сглаживанием TAA:

К слову о сглаживании — DLSS в некоторых случаях может заменять и его, например — дорисовывая грани у объектов, которые в оригинальном качестве выглядят сильно пикселизированными, а то и вовсе теряются:

С другой стороны, хотя пропадающие в оригинальном разрешении и рассыпающиеся на квадраты щели между досками DLSS действительно дорисовывает, текстуры в этом примере — наоборот становятся менее четкими, а деревянный настил местами начинает походить на рисунок на плоской поверхности.

Пример, кстати, не единственный:

Если обратить внимание на ветку в центре, то можно заметить, что ее края в варианте с DLSS не такие резкие, и на них отсутствуют характерные «лесенки». Но вместе с тем — текстуры цветков заметно теряют в детализации по сравнению с нативным 4К.

Безусловно, это не значит, что технология сама по себе плоха: нельзя создать универсальный инструмент, который будет одинаково хорош во всех задачах. Напротив, появление такой технологии стоит приветствовать: массовый переход к геймингу в нативном разрешении 4К, судя по всему, откладывается как минимум до выхода видеокарт следующего поколения. А если вас интересует не просто высокое разрешение, а еще и реалистичное освещение — то и того дольше. Да и возможность поднять производительность в новых играх при отсутствии более производительных видеокарт и денег на них — это просто отлично!

Минус у DLSS ровно один: это жесткая привязка к технологиям Nvidia и необходимость наличия аппаратных ядер у ГПУ. То есть, если у вас установлена как минимум RTX 2060, а еще лучше — RTX 3060, вы сами сможете включить DLSS и проверить качество картинки в поддерживающих эту технологию играх. А вот с GTX 1650 или GTX 1050, увы, ничего не выйдет.

Ну, если только не…

Альтернатива DLSS

Технология AMD FidelityFX Super Resolution не задействует ИИ для дорисовки недостающих частей изображения, но зато не требует специализированных аппаратных решений, и работает на гораздо большем количестве видеокарт, причем даже на продуктах Nvidia.

Как и DLSS, FSR разрабатывалась для повышения производительности в высоких разрешениях за счет апскейла менее насыщенной пикселями картинки.

Со своей прямой задачей эта технология справляется, и справляется не хуже, чем DLSS:

А вот с качеством картинки по вышеназванным причинам не все так однозначно. Если DLSS может буквально достраивать кадр, пусть и не всегда успешно, то FSR — это набор эффектов постобработки, накладываемых на оригинальное изображение.

Да — более эффективный по сравнению с другими методами апскейла:

Да — позволяющий приблизить качество картинки к нативному разрешению. Но — не достраивающий того, чего в оригинальном кадре нет. Что, в итоге, может приводить к подобным результатам:

В примере выше и без комментариев видно, как FSR и DLSS работают с объектами на заднем плане. Если FSR буквально повторяет изображение, полученное в нативном разрешении FullHD, то DLSS, как уже говорилось в предыдущем абзаце, сглаживает края тросов и дорисовывает теряющиеся элементы. С другой стороны, где слабее DLSS — там сильнее FSR…

God of War, апскейл до QuadHD, DLSS в режиме Quality, FSR — в Ultra Quality. Иначе говоря — обе технологии в режиме максимального качества. И обе работают на RTX 3080.

DLSS в очередной раз лучше работает с дальней перспективой — просто обратите внимание на лапы у елок в средней части экрана, да и в целом на дальность прорисовки.

А теперь посмотрите на текстуры камней в правой нижней части, детализацию коры у дерева в правом углу, а в особенности — на меховые и кожаные части одежды Кратоса. Все эти объекты выглядят четче как раз за счет FSR.

Также четче и намного контрастнее выглядит хвоя у маленькой ели в центре — здесь тоже вопрос к алгоритмам сглаживания у DLSS. Но, пожалуй, основное преимущество FSR — это именно большая степень свободы для технологии. Причем это касается как официальных спецификаций: в списке совместимых видеокарт куда больше моделей, чем у DLSS:

Так и неофициальных экспериментов: как это часто бывает с продуктами AMD, энтузиасты быстро добрались до недокументированных возможностей, и нашли способ задействовать технологию даже в тех приложениях, где она использоваться не должна:

Таким образом, FSR буквально не оставляет вам выбора. Не нужно искать карты с поддержкой этой технологии — не исключено, что они у вас уже есть.

Стоит ли выбирать видеокарту под процессор

Нет, видеокарта выбирается под игры — либо под рабочие задачи, которые предполагается решать с ее помощью.

Зависимость же игр от процессора, во-первых, в большинстве случаев, преувеличена, а во-вторых — абсолютно никогда не бывает линейной и не сводится к простой формуле «дороже процессор — больше FPS», которую предлагают вам «раскрывашки».

Total War: Three Kingdoms. Игра, довольно требовательная к ресурсам центрального процессора и к тому же использующая преимущества многопотока:

Слева — Intel Core i9-9900KF. Справа — Intel Core i7-9700KF. Оба процессора разогнаны до 5000 МГц, частота кольцевой шины поднята до 4700 МГц, видеокарта RTX 2080 Ti работает в штатном для нее режиме, все прочие условия идентичны. При этом, в случае с Core i7-9700KF FPS в бенчмарке оказывается… выше!

Да, это исключительно частный случай, связанный с тем, что технология Hyper Threading, отличающая Core i9 от Core i7, в играх далеко не всегда работает корректно, и производительность старшей (!!!) модели ЦПУ при прочих одинаковых условиях оказывается ниже, чем у младшей.

WarThunder, являющийся уже диаметрально противоположным примером, так как движок игры по сей день активно использует не более 2-х ядер процессора:

Слева — снова Core i9-9900KF, но на сей раз — в номинальном для него режиме. 4700 МГц по всем ядрам за счет технологии MCE, 4300 МГц на кольцевой шине.

Справа — уже Core i5-9600KF, разогнанный ровно до тех же параметров. Все прочие характеристики системы идентичны, в качестве видеокарты опять используется RTX 2080 Ti.

Разница в FPS очевидна. В данном случае Core i9 в принципе не может иметь никаких преимуществ над Core i5 — игра попросту не использует «лишние» ядра. А технология Hyper Threading здесь опять ведет себя не лучшим образом, что и позволяет Core i5-9600KF выдавать немного больше кадров в секунду.

Те же условия, те же Core i9 и Core i5, но Assassin’s Creed: Odyssey, использующий преимущества многопотока:

Производительность с Core i5-9600KF здесь уже ниже на 10–15 кадров, то есть ни о каком превращении RTX 2080 Ti в RTX 2060 речи тут не идет, да и идти не может. Кстати, вот это — RTX 2060 в том же тесте и при тех же настройках. Сравните показатели счетчика FPS:

У каждой игры свои требования к характеристикам центрального процессора. Так, где-то используется максимально доступное количество ядер и, например, старые процессоры под ту же платформу LGA 2011 могут не только эффективно справляться с игрой, выпущенной на 7 лет позже них самих, но и обеспечивать более комфортный геймплей, чем современные бюджетные модели под LGA 1200.

Где-то наоборот — количество ядер не имеет значения, важна только тактовая частота и производительность в однопоточной нагрузке. Какие-то игры в силу особенностей движка в принципе мало зависимы от процессора и более требовательны к видеокарте. Да и сама «зависимость» от характеристик процессора в одной и той же игре может меняться со сменой разрешения экрана и настроек графики: чем они выше — тем выше влияние видеокарты, и менее заметна разница между более и менее быстрыми ЦПУ.

Раскрывашки же эти факты игнорируют и сводят все к одному простому тезису: «более дорогой и новый процессор — лучше». Но для кого именно лучше — обычно умалчивают. Поэтому, если вы решились на апгрейд видеокарты, не стоит задаться вопросом «а раскроИт ли?» — им и без вас много кто задается.

Ваш вопрос — насколько производительности текущего процессора достаточно для игр, в которые вы планируете играть. Если ответ на него положительный — берите новую видеокарту. Если отрицательный — рассматривайте возможные варианты апгрейда, пусть даже и в рамках нынешней платформы.

Так на что тогда нужно обращать внимание при выборе видеокарты?

1) На ее цену.

Парадоксально, но это одновременно самый очевидный и самый… неоднозначный параметр. С одной стороны, задумав покупку, вы уже знаете, какую сумму теоретически готовы потратить, и в каких лимитах эта сумма может изменяться, если это необходимо.

С другой стороны, цена не всегда отражает реальную производительность видеокарты. Возможны казусы, когда карта старой и менее производительной модели стоит столько же, сколько более быстрый современный аналог.

Возможны и более любопытные варианты, когда карта, основанная на менее производительном ГПУ, но оснащенная топовым охлаждением и переработанной платой стоит столько же или буквально чуть дешевле, чем более производительные карты с «меньшим уровнем пафоса»:

Именно поэтому никогда не стоит упираться в единственный вариант — всегда могут быть более выгодные альтернативы.

Даже если вам кажется, что выбранный вами вариант оптимален по всем параметрам, даже если его наперебой советуют «интернет-знатоки», даже если вы пересмотрели кучу обзоров именно на эту модель — в реалиях рынка соотношение цены и характеристик может оказаться не самым выгодным.

Поэтому — всегда выбирайте несколько вариантов, попадающих в ваш исходный бюджет, но также оставляйте небольшой запас для «маневров». Уж поверьте, но 25 тысяч рублей за карту, способную тянуть игры в FullHD на высоких настройках графики, и 27 тысяч рублей за карту, способную тянуть те же игры на максимальных настройках, или с комфортом играть в QuadHD — это очень сомнительная разница в цене.

Обязательно следите за скидками и акциями магазина, а также интересуйтесь сроками выхода новинок — с появлением даже просто новых моделей на чипах текущего поколения ценовая политика вендора может заметно измениться, а на действия одного производителя обязательно отреагируют конкуренты.

Кроме того, не постесняйтесь узнать, сколько стоит на рынке б/у комплектующих ваша нынешняя видеокарта. Не исключено, что ее продажа позволит добавить значительную сумму к бюджету на покупку новой.

2) Производительность.

Этот аспект вполне очевиден, и более того — именно он определяет итоговый выбор. За какую бы цену вы ни выбирали видеокарту — она должна с лихвой отрабатывать каждый вложенный рубль.

Но не стоит оценивать производительность по отзывам и комментариям в стиле «<название_игры> литаит на ультрах!». Их можно написать про какое угодно устройство. Да и как правило, единственное, с чем пользователи могут сравнить свою покупку — это их старая видеокарта, которая может быть старше сразу на несколько поколений. Естественно, это не даст понять, как видеокарта выглядит на фоне прямых конкурентов.

Ваш вариант — прямые сравнительные тестирования, проводимые авторитетными изданиями при участии если не всех, то большинства конкурирующих решений. Ознакомившись с ними, вы будете представлять, насколько выбранная видеокарта быстрее или медленнее ближайших аналогов, а следовательно — сделаете аргументированный выбор.

3) Энергопотребление видеокарты

Безусловно, идеальный сценарий — это если при покупке видеокарты и внезапной нехватке мощности вашего нынешнего блока питания вы просто идете в магазин и приобретаете новый блок.

Но, во-первых, давайте называть вещи своими именами: далеко не у всех из нас бюджеты позволяют купить одновременно два не самых дешевых девайса.

А во-вторых, энергопотребление видеокарт некоторые люди понимают настолько по-своему, что советы приобретать блоки мощностью в 750 ватт под GeForce GTX 1650 Super и Radeon RX 5500 XT в современных интернетах — ни разу не редкость.

В этих условиях задача — купить видеокарту, с которой справится ваш нынешний блок, и с другой стороны — не потратить деньги на новый блок, мощность которого заведомо избыточна для конфигурации с новой видеокартой.

Как это сделать? Довольно просто, и есть два возможных способа.

Первый из них — прочесть обзор на видеокарту от авторитетного источника. Да, нередко в обзорах указывается энергопотребление всей системы, а не отдельно видеокарты — но так получается даже более наглядно. Ведь, если тестовая система на условном Core i9-9900K в разгоне показывает пиковое энергопотребление на уровне 580 ватт, а в игровом режиме ест 300–350 ватт, то ваш компьютер с опять же, условным Core i5-9400F потреблять будет очевидно меньше.

Второй способ — подробно ознакомиться с характеристиками интересующей вас карты. Только не с теми, что напечатаны в таблице со спецификациями, а с теми, что хранятся в самой карте. А точнее — в ее BIOS.

Одна из ключевых характеристик современных видеокарт — лимит энергопотребления. Программное ограничение, обойти которое карта сама по себе не может. Так, если карте назначен лимит в 130 ватт — необходимость блока на 750–800 ватт для нее несколько… сомнительна.

Тут, кстати, следует сделать одну очень важную оговорку. Видеокарта — это лишь одна из частей системы, в которой живут процессор, материнская плата, оперативная память, SSD, жесткие диски и даже корпусные вентиляторы. Все эти «соседи» тоже питаются электричеством, и при работе тоже хотят есть. Поэтому рассчитывать мощность блока питания необходимо исходя из требований не видеокарты, а всей системы в целом.

4) Разъемы дополнительного питания

Этот пункт также касается БП, однако его стоит вынести отдельно.

Современные видеокарты игрового класса в большинстве случаев потребляют больше электричества, чем способен обеспечить слот PCI-e x16, а потому оснащаются разъемами дополнительного питания, соединяющими карту напрямую с БП.

Разъемы эти стандартизированы и могут насчитывать 6 либо 8 контактов.

Но дело в том, что разные версии карт даже одной модели могут использовать разные сочетания этих разъемов:

- два 6-контактных;

- один 6- и один 8-контактный;

- один 8-контактный разъем;

- два 8-контактных разъема;

- два 8-контактных и один 6-контактный разъем;

- три 8-контактных разъема.

Прежде чем выбирать конкретную модель карты, нужно удостовериться, что ваш блок обладает нужным количеством разъемов дополнительного питания для устройств PCI-e. Если их нет, или количество недостаточно — можно воспользоваться переходниками 4-контактных разъемов Molex, но в таком случае их стоит приобрести либо заранее, либо одновременно с покупкой карты.

И да — в последнее время парадоксальная путаница возникает вокруг разъемов 6+2-pin PCI-e на блоках питания. В комментариях можно прочесть много странных и неописуемо диких вещей, но в реальности этот разъем делается разборным как раз для того, чтобы им можно было подключать карты и с 8-, и с 6-контактными колодками.

5) Физические размеры карты

Разные версии карт на одном и том же графическом чипе могут оснащаться разными системами охлаждения, а, следовательно, обладать разной длиной и толщиной.

В то же время, компьютерные корпуса могут допускать установку видеокарт строго определенной длины, а разъемы PCI-e на материнских платах располагаться так, что карты расширения можно расположить только в строго определенной последовательности. Это, конечно, не катастрофа, но вы лично готовы менять ради видеокарты еще и корпус компьютера, или отказываться от привычной и подходящей вам звуковой карты? Если нет, то перед покупкой обязательно изучите, сколько места интересная вам карта занимает в длину, и сколько слотов расширения на материнской плате перекрывает ее система охлаждения:

Возможно, чтобы сохранить нынешний корпус и карты расширения, вам придется выбрать другую, более компактную модель карты. Возможно, она даже будет отличаться более высокими температурами и/или повышенным уровнем шума по сравнению с более массивной моделью, но тут уже вам решать, что более приоритетно. И решать следует заранее, а не после покупки карты.

6) Разъемы для вывода сигнала на монитор

С одной стороны, сильной путаницы разъемы для подключения к монитору не вызывают. С другой — далеко не все карты обладают теми разъемами, которые есть именно на вашем мониторе. И в особенности это касается как раз современных моделей.

Так, разъем VGA канул в неизвестность вместе с видеокартами GeForce серии 900 и Radeon серии 300. Современные видеокарты не поддерживают вывод аналогового сигнала вовсе: ни через нативный разъем VGA, ни через комбинированный DVI-I их на картах текущих поколений просто нет.

Если вы используете монитор, подключаемый исключительно через аналоговый интерфейс, можно воспользоваться конвертерами (например, HDMI-VGA), преобразующими цифровой сигнал в аналоговый. Однако, если быть честным, такое решение — полумера. Гарантировать качество картинки на мониторе ни один подобный переходник не может, так что польза от них сомнительна. Да и стоят они немало, и гораздо выгоднее будет взять эти деньги, продать ваш старый монитор на вторичном рынке, добавить полученную сумму и купить уже другой монитор, поддерживающий цифровые интерфейсы.

К слову, цифровой разъем DVI-D тоже становится исчезающим видом: последние модели видеокарт от него отказываются в пользу HDMI и DisplayPort.

Впрочем, получить «цифру» из «цифры» не в пример проще, и переходники HDMI-DVI стоят гораздо дешевле активных конвертеров. Но, если выбранная вами карта нуждается в переходниках, лучше узнать об этом заранее и купить их одновременно с самой картой, а не ездить в магазин дважды.

7) Эффективность системы охлаждения и акустический комфорт

Этот пункт стоит последним в списке — однако не потому, что он не важен, а потому, что им возможно пожертвовать ради приобретения более производительной видеокарты, либо карты, совместимой по габаритам и разъемам с другим вашим оборудованием.

Но, разумеется, о температурах видеокарты под нагрузкой и уровне издаваемого ей шума забывать не стоит.

Видеокарты референсного дизайна с кулером типа «турбина» покупать не рекомендуется — пусть современные ГПУ и не столь горячи, конструктивным недостатком таких кулеров остается малая площадь поверхности радиатора. И чтобы эффективно снять с него тепло — турбине придется раскручиваться до достаточно высоких скоростей. А выше скорость — больше шума. Тихоходные кулеры вендорского дизайна в этом плане куда предпочтительнее.

Впрочем, и гоняться за самыми топовыми версиями видеокарт сегодня тоже не имеет смысла. Даже если рассматривать карты уровня того же Radeon RX 5700 XT — реальная разница в температурах может оказаться несколько ниже разницы в цене. А разброс по частотам в данном случае легко компенсируется ручной настройкой.

Перед покупкой видеокарты следует внимательно изучить обзоры, в которых показана конструкция установленной системы охлаждения и протестирована ее эффективность. Здесь также желательно сравнение с конкурентами, однако выводы можно сделать и по графикам температур и шума одиночной карты.

Также следует помнить, что восприятие шума у каждого человека индивидуально, и к тому же, сильно зависит от естественного шумового фона в помещении. Ориентируйтесь на следующие цифры:

- 25–30 децибел — естественный шумовой фон глухой ночью в квартире с закрытыми окнами при отсутствии других источников шума.

- 40 децибел — тихий разговор.

- 55–60 децибел — средний уровень шума днем в офисе.

Критерии и варианты выбора

Видеокарты начального уровня подойдут для офисных задач, воспроизведения мультимедийного контента и достаточно старых и нетребовательных игр. Если рассматривать видеокарты для мультимедийного ПК, собранного в компактном корпусе, отдельного внимания заслуживают низкопрофильные карты.

Однако, выбирать их следует с оглядкой на остальные комплектующие. Если у вас относительно старое железо, или же процессор не оснащен встроенной графикой — покупка, безусловно, будет иметь смысл.

Если же ПК только планируется собирать — стоит обратить внимание на центральные процессоры со сравнительно мощной встроенной графикой.

Также, если у вас старый монитор с интерфейсом VGA, и менять его по той или иной причине вы не хотите — безусловно, имеет смысл посмотреть видеокарты с нативным разъемом VGA или DVI-I. Подключить к ним такой монитор гораздо проще, чем к современным аналогам.

Однако имейте ввиду, что это в большинстве случаев будут старые и далеко не самые производительные модели. Поэтому, если замена монитора — не ваш путь, стоит купить конвертер сигнала в помощь более современной видеокарте.

Если необходимо больше производительности, но из игр интересуют в первую очередь различные сетевые проекты — можно ограничиться игровыми видеокартами начального уровня. На практике они способны и на большее, чем DOTA и Танки — правда, в более серьезных проектах придется ограничиться средними настройками графики.

Средние настройки и FPS, лишь немного превышающий границу комфорта — не ваш вариант? Обратите внимание на карты, составляющие основную долю среднего ценового сегмента. На практике они способны и на большее, чем дота и танки — правда, в более серьёзных проектах придется ограничиться средними настройками графики.

На верхней границе среднего ценового сегмента расположились карты, способные поднять настройки в FullHD ближе к максимальным. С ними тоже не имеет смысла замахиваться на более высокие разрешения, но актуальность они сохранят несколько дольше предыдущих вариантов.

Не слишком придирчивы к графике, но берете карту с расчетом не апгрейдить ее в течение нескольких лет? Стоит обратить внимание на карты из нижней границы топового сегмента. Обойдутся они уже дороже предыдущих вариантов, но далеко не в разы. А актуальность сохранят куда на дольше — не исключено, что траты окажутся гораздо меньше, чем в случае покупки среднебюджетной карты сегодня и ее замены на аналог из следующего поколения.

Хотите попробовать новые технологии, играть в разрешениях 2К и 4К с высокими настройками и комфортным FPS, или же вам нужна карта для онлайн-трансляций? Тут уже в дело вступают флагманы с бескомпромиссной ценой и столь же бескомпромиссной производительностью.

Обновлено автором.

Видеокарта (графический адаптер) — важный элемент любого компьютера. Именно она отвечает за формирование изображения, которое появляется на экране компьютера.

Видеокарты бывают интегрированными и дискретными. Интегрированные уже встроены в центральный процессор или материнскую плату. Они решают самые простые задачи: игры на телефоне, просмотр видео. Не подходят для требовательных игр и работы с графикой — для таких задач понадобятся дискретные видеокарты, которые отдельно подключают к компьютеру.

Игровые

Для игр уровня Dota, Counter-Strike или Minecraft достаточно видеокарты в пределах 15 тысяч рублей. Для игр AAA-класса уже стоит обратить внимание на частоту памяти и количество ядер — чем они выше, тем быстрее и качественнее будут рассчитываться эффекты в игре.

Перейти в каталог

Профессиональные

Предназначены для работы с графикой. Для них важен объем памяти и пропускная способность шины. Они часто дороже игровых, но в играх могут быть хуже, так как заточены под другие задачи: качество изображения, рендер, работу с ArchiCAD, AutoCAD, 3ds Max. Для машинного обучения иногда эффективнее купить несколько игровых видеокарт по цене одной профессиональной.

Перейти в каталог

nVidia или AMD?

В продаже сегодня можно встретить видеокарты, выпущенные различными компаниями, среди которых Asus, Gigabyte, MSI и многие другие. Но эти фирмы закупают графические процессоры (GPU), то есть тот компонент, который можно назвать «сердцем» видеокарты, у двух производителей: AMD и nVidia. Каждый из них предлагает решения, имеющие свои достоинства, которые определяются их конструктивными особенностями.

Размеры видеокарты

Прежде чем покупать графический ускоритель, необходимо понять, сможете ли вы его установить на своей материнской плате, не перекроет ли он доступ к какому-либо слоту и поместится ли она по длине в корпус вашего ПК. Обязательно обратите внимание на параметр «Максимальная длина видеокарты», который указывается в характеристиках практически всех компьютерных корпусов.

Производительность

На производительность видеокарты влияет множество параметров, поэтому при выборе проще ориентироваться на то, к какой серии компания-производитель относит тот или иной графический адаптер.

nVidia сейчас выпускает бюджетную серию GTX и «продвинутую» линейку RTX.

Внутри каждой из линеек можно смотреть на цифровые индексы: чем индекс больше, тем видеокарта мощнее.

У AMD все несколько сложнее. Она сейчас выпускает несколько серий графических процессоров, которые не выстраиваются в какую-либо четкую иерархию.

Самая последняя обновленная линейка от этого производителя — RX c «пятитысячными» индексами, например, AMD Radeon 5500 и AMD Radeon 5700

Бюджетные

Ее возможностей достаточно, чтобы воспроизводить графикку с разрешением Full HD (1920×1080 пикселей) со средними и в некоторых случаях высокими настройками.

Перейти в каталог

Средние

Решения среднего класса, справляющиеся с обработкой графики с разрешением Full HD или 2K, — это, в частности.

Продвинутые

Для топового геймерского компьютера, который должен воспроизводить графику с максимальными настройками в разрешении 4K, подойдут.

Видеопамять

Видеопамять графического ускорителя — это внутренняя оперативная память, которая отводится для хранения данных, использующихся для формирования изображения на экране компьютера. В принципе, чем больше ее объем, тем лучше, но производительность во многом зависит и от других критериев. Поэтому рассматривать характеристики нужно в комплексе, не ограничиваясь только объемом видеопамяти.

Чтобы найти компромисс между объемом видеопамяти и ценой, можно ориентироваться на следующие параметры:

2 Гб

Видеокарта начального уровня, многие игры на компьютере, в котором она установлена, вообще не запустятся или «пойдут» с низкими настройками графики

Перейти в каталог

4 Гб

Решение для компьютера среднего уровня мощности, подходит для работы с профессиональными графическими редакторами и запуска игр в жанре «стратегия»

Перейти в каталог

6 Гб

Для топового геймерского компьютера, который должен воспроизводить графикус максимальными настройками в разрешении 4K, подойдут

Перейти в каталог

8 Гб и выше

Для наиболее требовательных игр с картинкой, которая воспроизводится с разрешением 4K (3840 х 2160 пикселей), для игр с использованием устройств виртуальной реальности, а также для решения профессиональных задач, связанных с дизайном и видеомонтажом

Перейти в каталог

Разрядность шины памяти

Это настолько важный параметр, что о нем следует сказать отдельно. Шина памяти представляет собой канал между графическим процессором и памятью, и чем он шире (чем больше разрядность), тем больше информации способна видеокарта обработать за единицу времени. Но, так как видеокарта состоит из нескольких компонентов, низкую разрядность можно компенсировать, например, за счет более быстрой и современной видеопамяти.

Принято считать, что игровому компьютеру необходима разрядностьне менее 128 бит. Лучше, если этот показатель будет выше.

Выберите в каталоге

Питание

Разъёмы

6 pin, 8 pin, 6+8 pin

Бюджетные видеокарты и решения низшего среднего класса обходятся без дополнительного питания. Однако многие графические адаптеры со средней и высокой производительностью потребляют так много энергии, что без дополнительного питания им не обойтись. Для этого они комплектуются разъемами различных типов.

Высокое энергопотребление видеокарты означает, что к блоку питания компьютера тоже предъявляются особые требования. Обычно в технических характеристиках графического адаптера указываются рекомендации относительно мощности БП. Ориентируйтесь на эти показатели.

Рекомендуем брать блок питания мощностью не ниже 700 ватт.

Выберите в каталоге

Охлаждение

Видеокарта при работе под интенсивной нагрузкой не только потребляет много энергии, но и серьезно нагревается. Перегрев может привести к снижению производительности, а в худшем случае к выходу графического адаптера из строя. Чтобы этого избежать, производители используют системы охлаждения. Конечно, в мощном игровом компьютере или ПК, предназначенном для профессиональной работы с графикой и видео, обычно есть кулеры или система водяного охлаждения. Однако видеокарте требуется и собственная система защиты от перегрева. Охлаждение бывает:

Пассивное

Пассивная система охлаждения представляет собой радиатор, работающий по принципу естественного тепловыделения. Проще говоря, металлическая пластина отводит тепло, нагревая окружающий воздух.

Ее основное преимущество — бесшумность, однако эффективность таких систем оставляет желать лучшего.

Перейти в каталог

Активное

Активная система охлаждения обычно является гибридной: она состоит из радиатора, тепловых трубок и одного или нескольких вентиляторов.

КПД такой системы значительно выше по сравнению с пассивными, однако она потребляет довольно много энергии и при работе под большой нагрузкой может шуметь.

Перейти в каталог

Жидкостное (водяное) активное охлаждение

В некоторых видеокартах используется не воздушное, а жидкостное (водяное) активное охлаждение. Такие системы обладают высокой эффективностью, но стоят довольно дорого и используются обычно в топовых игровых системах. Они тоже могут шуметь, только звук работающего вентилятора заменяется на звук работающей водяной помпы.

Вывод изображения на экран

Для вывода изображения на экран видеокарте нужен разъем, посредством которого она подключается к монитору.

Основные типы видеовыходов

D-Sub (VGA)

На современных видеокартах среднегои высшего классов встречаются сравнительно редко

DVI

Позволяет подключать многие старые и современные мониторы

Display Port, Mini Display Port

Обеспечивают совместимость со многими моделями современных мониторов

HDMI

позволяет не только транслировать видео с разрешением 4K, но и по одному кабелю передавать видео- и аудиосигнал, что крайне важно для тех, кто обходится без внешней аудиосистемы и пользуется встроенными в монитор динамиками

Также вам понадобится возможность подключения по HDMI, если вы собираетесь использовать шлем виртуальной реальности

Выберите в каталоге

На рынке сегодня представлено множество видеокарт, различающихся такими характеристиками, как объем и тип видеопамяти, размеры, тип системы охлаждения и так далее. При этом компании-производители постоянно предлагают новое решение, и то, что вчера казалось наиболее современным, сегодня становится стандартным, а завтра его уже вытесняют более «продвинутые» модели.

Однако, если вдумчиво подойти к процессу выбора, учесть информацию, которую мы привели в этой статье, и советы, которые мы дали, можно выбрать видеокарту, которая не только оптимально подойдет для решения стоящих перед вами задач, но и не устареет в течение нескольких лет.

На сайте интернет-магазина СИТИЛИНК предусмотрена система фильтров, позволяющая быстро провести поискв режиме онлайн и найти видеокарту, которая оптимально соответствует вашим потребностям.

Перейти в каталог

В начало страницы

Видеокарта, иначе графический ускоритель или видеочип, отвечает за вывод графической информации на экран компьютера. Чтобы ориентироваться в многообразии моделей и не переплачивать за бренд, давайте разберемся, какие характеристики важны для производительности, что означают параметры видеокарты, какая модель подойдет для игр, а какая идеальна для рендеринга.

Два вида карт: дискретная и встроенная

Начнем с того, что есть видеокарта встроенная, а есть дискретная.

Встроенная или интегрированная видеокарта — это графический ускоритель, который встроен напрямую в процессор. У него нет собственной памяти, поэтому, когда вы запускаете игры, чип использует ресурсы оперативной памяти. Это значительно тормозит работу браузера и системные процессы.

Интегрированный ускоритель используется в большинстве ноутбуков из-за небольшого размера и в бюджетных ПК из-за дешевизны. Его нельзя купить или заменить отдельно от центрального процессора.

Интегрированный видеочип подойдет тем, кто использует офисные приложения, простые графические редакторы, браузерные игры и серфит в сети.

Плюсы и минусы встроенной видеокарты

+ небольшой размер;

+ не нужно подбирать отдельно, идет с процессором;

+ цена на процессор с видеокартой почти не отличается от цен на процессоры без нее.

– низкая производительность, не подходит для игровых ПК;

– нельзя заменить или улучшить.

Есть вариант комфортно работать на встроенной видеокарте с «тяжелыми» графическими приложениями типа Photoshop, но для этого обзаведитесь оперативной памятью не менее 8 Гб, а лучше все 16.

Дискретная видеокарта — графический ускоритель на отдельной плате, который имеет собственную память. Он выделяет много тепла и поэтому поставляется со встроенной системой охлаждения. Из-за этого в собранном виде корпус видеокарты имеет большие габариты и комплектуется только в персональные компьютеры.

Есть вариант упрощенной дискретной видеокарты, которая создана специально для ноутбуков и бюджетных ПК. У нее нет собственного корпуса и вентилятора и она распаяна на материнской плате рядом с процессором. От встроенной отличается тем, что имеет собственный набор памяти и не тратит оперативную.

My Gadget в Telegram!

Дискретная видеокарта нужна для геймера, веб-дизайнера, проектировщика, ретушера, мастера видеомонтажа и 3D-рендеринга. Вся память видеокарты будет задействована в графических задачах, а оперативная память будет работать с браузером и системными файлами.

Цена современного графического ускорителя заходит за 100 000 рублей, но для игр подойдут карты от 20 000 р. Перед покупкой решите, для каких задач он вам нужен, чтобы не переплачивать за лишнюю мощность или наоборот — не взять слишком слабую. Если производительности видеокарты не хватит для текущей задачи, то снизится частота кадров и плавность картинки.

Плюсы и минусы дискретной видеокарты

+ высокая производительность для игр и графического дизайна;

+ собственная видеопамять;

+ можно заменить или улучшить.

– высокая цена;

– большие габариты;

– высокое энергопотребление.

Дальше мы будем рассматривать только дискретные видеокарты, потому что интегрированную вы не можете выбрать сами. Это полностью зависит от вашего процессора.

Габариты

Разбираясь в сложных настройках, пользователи забывают о том, что дискретная видеокарта с системой охлаждения имеет большие габариты и может банально не влезть в системный блок. Поэтому посмотрите сколько места есть над материнской платой и перед покупкой удостоверьтесь, что места для выбранной карты хватит.

Какого производителя выбрать

Сейчас на рынке дискретных видеокарт конкурируют две корпорации AMD и NVIDIA. В 2020 году компания Intel анонсировала первый игровой ускоритель, но точной информации о нем еще не представлено.

Рассмотрим подробно качества видеокарт на примере похожих AMD Radeon RX 5600 XT и NVIDIA GeForce RTX 2060 из среднебюджетного сегмента:

Мощность. В бюджетном сегменте лидирует Radeon, который захватил рынок средних по производительности моделей, но среди топовых видеокарт по мощности выигрывает GeForce.

Софт — это специальная программа, с помощью которой вы можете настраивать видеокарту и обновлять драйвера. У NVIDIA она называется GeForce Experience, у AMD – Radeon Software. Обе компании стараются расширять функциональность программ, но у AMD более понятный интерфейс и удобная настройка графики.

Особенности. В плане внедрения новых технологий обе компании идут вровень, но у среднебюджетных NVIDIA есть:

- Трассировка лучей – более реалистичное освещение, отражение и построение теней в играх;

- DLSS – технология сглаживания острых краев в играх без дополнительных затрат мощности.

У AMD эти технологии есть только в топовых моделях.

Цена. Средняя цена на Radeon RX 5600 XT – 18 000 рублей, а на GeForce RTX 2060 – 26 500 рублей. Сейчас большинство среднебюджетных карт от NVIDIA стоят на 3-6 тысяч дороже, чем аналогичные от AMD.

Важный момент, о котором надо знать перед покупкой: NVIDIA и AMD чаще всего выпускают только чипы под видеокарту. Корпус и внутренние комплектующие с разными конфигурациями выпускают компании-поставщики. Их называют вендоры. Как правило, цена на «железо» от вендоров ниже, чем у первоисточника. Так что не пугайтесь, если на видеокарте GeForce увидите вместо NVIDIA логотип MSI, ASUS или Palit. Все они выпускают сертифицированные видеокарты от одного производителя, только в разном стиле и с различным ценовым уровнем.

Видеокарты NVIDIA

Видеокарты AMD

Совместимость с блоком питания

Большинство статей расписывают совместимость видеокарты с процессором, оперативной памятью и материнской платой. Для неискушенного пользователя эти параметры не критичны, потому что видеокарта будет работать практически с любым «железом». Но есть важный нюанс.

Если вы поставите топовую MSI GeForce RTX 2080 Ti 2018 года на устаревший процессор Intel Core 2 Duo E8400 2008 года, то процессор не будет успевать нагружать видеокарту, и она будет использовать примерно 10% от возможной мощности.

Важный параметр, без которого видеокарта может не запуститься —– это блок питания. К нему подключается видеокарта с помощью коннекторов. Перед покупкой посмотрите на панели с разъемами, какие коннекторы нужно подключить к блоку питания или найдите в инструкции графу «Требование к БП (Вт)».

- 6 pin – коннектор, популярный у бюджетных видеокарт;

- 8 pin – коннектор с более высокой мощностью.

Видеокарты с небольшим энергопотреблением могут обходиться без коннекторов и питаться напрямую от материнской платы. А мощным видеочипам нужно много питания, поэтому часто они используют два разъема сразу: 6+6 pin или 6+8 pin.

Видеоразъемы

В наше время есть переходники для любых разъемов, но, чтобы не покупать дополнительные «приблуды» заранее проверьте, какие разъемы вам необходимы:

VGA (D-Sub) — устаревший аналоговый разъем для бюджетных мониторов, проекторов и игровых консолей.

DVI — более современный разъем для мониторов в нескольких вариантах: DVI-I, DVI-A и DVI-D. Маркировка на обратной стороне монитора подскажет, какой тип разъема вам необходим.

HDMI — распространенный цифровой выход от монитора, способный передавать многоканальный аудиосигнал. HDMI 2.0 есть на большинстве современных видеокарт.

DisplayPort — самый популярный выход, который имеет переходники для всех видеоразъемов. Обычно на видеокарте установлено несколько DisplayPort для разных мониторов или устройств.

Объем и тип видеопамяти

С объемом все просто: чем больше его, тем легче будет прогружаться графика в играх и приложениях. Чтобы беспрепятственно серфить по сети и редактировать картинки в Paint достаточно 1 Гб видеопамяти.

Для современных игр на высоких настройках в разрешении FullHD хватит 4-6 Гб памяти. А вот маньякам видеоигр в разрешении 4K c настройками Ultra лучше озаботиться 8-16 Гб видеопамяти и двумя плашками по 4 Гб оперативной памяти дополнительно.

У видеокарты есть тип памяти. Чем выше поколение памяти, тем больше объем данных, который обрабатывает карта, скорость загрузки и ниже энергопотребление.

Чтобы купить современную видеокарту нужно знать только два типа памяти:

GDDR — наиболее распространенный тип, который использует несколько поколений:

- GDDR3 — бюджетный, подойдет для офисных задач и домашнего использования;

- GDDR5 — наиболее распространенный тип с высокой скоростью передачи данных, подходит для большинства современных игр;

- GDDR6 — максимально возможный стандарт для современных видеокарт со скоростью передачи в 1,5 раза больше предыдущего.

HBM — редкий тип памяти со значительно повышенной пропускной способностью. Новое поколение HBM2 используют в топовых видеокартах для игр в виртуальной реальности, поддержки 4K-изображения, серверов и рабочих станций.

Важно! Оперативная память компьютера имеет похожую маркировку. Например, DDR2 или DDR4. Но тип видеопамяти никак не зависит от типа оперативной памяти, они могут отличаться и никаких проблем из-за этого не будет.

Разрядность (битность) шины памяти

Параметр отвечает за то, сколько информации обработает видеокарта за секунду. Чем больше показатель, тем больше пропускная способность памяти и выше производительность. Измеряется в битах. Информацию о битности видеокарты легко найти в инструкции в графе «Разрядность шины памяти (bit)».

Для офисного компьютера подойдет небольшая разрядность 64-128 bit.

Для игр на средних настройках лучше выбрать видеокарту 128-192 bit.

Для видеомонтажа, 3D-моделирования, рендеринга и требовательных игр подойдут видеокарты разрядностью от 256 bit.

Тактовая (штатная) частота видеочипа

Чем выше частота, тем больше задач выполняет графический ускоритель за единицу времени. Информацию о тактовой частоте можно узнать в графе инструкции «Частота GPU базовая (MHz)».

Для нетребовательных систем подойдет штатная частота до 950 МГц.

Наиболее популярный средний сегмент 950-1350 МГц.

У высокопроизводительных чипов показатель обычно не превышает 1800 МГц, потому что высокая частота потребляет больше энергии и требует серьезной системы охлаждения.

Система охлаждения

Как и процессор, видеокарта нагревается во время работы, и требует принудительного охлаждения. Некоторые устаревшие и неигровые ускорители охлаждаются пассивно, но такая система практически не встречается. Обычно над рабочей платой установлено от одного до трех вентиляторов, которые отводят лишнее тепло. В режиме бездействия кулеры отключаются.

Популярность набирает водяное охлаждение. Но даже бюджетные системы стоят от 5-7 тысяч рублей.

Чтобы охлаждение работало эффективно, перед вентиляторами должно быть свободное пространство в 5-10 см.

Выберите видеокарту

Дополнительные параметры

Второстепенные характеристики видеокарты. Будут важны тем, кто выбирает чип для игр и работы с графикой.

Количество мониторов. Посмотрите в инструкции параметр «Количество подключаемых мониторов», которые может поддержать видеокарта. С помощью этой функции можно растянуть картинку на два рабочих стола или запускать разные программы на нескольких мониторах.

Разрешение. В инструкции к видеокарте указано, какое максимальное разрешение картинки она способна сформировать и вывести на экран. Обратите внимание, что максимальное разрешение для разных видеовходов может различаться.

Чтобы узнать разрешение видеокарты, которая установлена на вашем ПК: кликните правой кнопкой мыши по рабочему столу, выберите вкладку «Параметры графики» → «Разрешение» и посмотрите максимальное значение.

Поддержка стандартов (API). Разработчики игр пишут их на определенном интерфейсе. Чтобы эти игры запустились на вашем компьютере, видеокарта должна поддерживать актуальные стандарты. Самые распространенные это:

- DirectX — программный комплекс, соединяющий приложения в среде Windows и все внутренние устройства компьютера. Актуальная версия на 2020 год — DirectX 12.

- OpenGL — профессиональный стандарт для создания графического программного обеспечения. Актуальная версия на 2020 год — OpenGL 4.6.

- Vulkan — низкоуровневый интерфейс для графического программирования. Актуальная версия на 2020 год — Vulkan 1.2.

SLI/Crossfire. Эта технология позволяет установить несколько одинаковых видеопроцессоров на один ПК. Параметр важен для тех, кто хочет постепенно расширять потенциал компьютера. Чтобы реализовать систему, нужно иметь материнскую плату с несколькими слотами для каждой карты.

Помните, что производительность достигается комплексом параметров. Не нужно брать карту с высокой разрядностью шины и низкой тактовой частотой, лучше подбирать параметры примерно на одном уровне: низком, среднем или высоком.

Чтобы выбрать подходящую видеокарту:

- Проверьте, хватит ли в системном блоке места для видеокарты.

- Выберите производителя — AMD или NVIDIA и вендора.

- Посмотрите, есть ли в вашем блоке питания нужные разъемы: 6 pin или 8 pin.

- Посмотрите, есть ли на вашей материнской плате разъем PC-E.

- Проверьте, какие разъемы нужны для подключения вашего монитора к видеокарте.

- Подберите нужный объем и тип видеопамяти. Чем серьезнее задачи будет решать видеокарта, тем больше памяти нужно.

- Чем выше разрядность и тактовая частота видеочипа, тем больше его производительность. Если выбираете карту для игр или работы с графикой, то разрядность будет от 128 bit, тактовая частота от 950 МГц.

- Видеокарта для игр должна поддерживать DirectX и OpenGL.

- Если планируете добавить в систему еще одну видеокарту, проверьте, чтобы на материнской плате был дополнительный слот, а карта поддерживала технологию SLI или Crossfire.

Надеемся, что инструкция ответила на все ваши вопросы. Пишите в комментариях, помогла ли вам статья и с какими трудностями вы столкнулись, когда покупали «железо» для ПК. Ставьте лайки и подписывайтесь на новые статьи в MyGadget!

Смотрите также:

👉 Рейтинг лучших ноутбуков до 40000 рублей

👉 Лучший игровой процессор 2020 года. Рейтинг игровых процессоров

👉 Как выбрать ноутбук? Рейтинг лучших ноутбуков по соотношению цены и качества

Современный гейминг, обработка фотографий, 3D-моделирование, архитектурное проектирование, анимирование, видеомонтаж – для этого всего требуется видеокарта. Она не только выводит изображение на монитор, но и занимается всеми графическими вычислениями на компьютере. Далее мы разберемся, как выбрать видеокарту для ПК и что о ней следует знать пользователю.

На что нужно обращать внимание при выборе видеокарты?

Название – это то, на что необходимо обращать внимание в первую очередь. Именно в нем содержится основная информация о видеокарте. Назначение, мощность, поддерживаемые технологии – все это раскрывается в наименовании.

Производитель графического процессора

С него начинается название всех видеокарт. Их главным компонентом выступает графический процессор (ГПУ). Его разрабатывают компании NVIDIA и AMD. Также графические процессоры выпускает компания Intel. Но она специализируется на производстве серверных решений. Да, в 2022 году они выпустили свои карты для десктопного сегмента под брендом «ARC». Но эти устройства оказались не конкурентны на фоне ускорителей от NVIDIA и AMD.

Семейство

Это второе слово в названии карты. Оно сообщает назначение устройства. Например, карты NVIDIA серии «TITAN» применяются для разработки нейронных сетей. А продукция AMD семейства «Radeon PRO» используется профессионалами для создания анимаций, монтажа видео в 8K разрешении и т.п.

Геймерам, а также ПК пользователям, не заинтересованным в работе со сложными графическими задачами, подойдут карты семейства «GeForce» от NVIDIA и «Radeon» от AMD. Далее мы будем рассматривать именно их.

Буквенный индекс

Он следует сразу за семейством и сообщает о приблизительной мощности и поддержке современных технологий. Продукция NVIDIA обозначается тремя буквенными индексами:

- GT – устройство имеет низкую производительность и не обладает последними технологиями. Используется только для вывода изображения на монитор.

- GTX – обладает производительностью для старых игр и несложных графических задач (обработка фото, монтаж видео в Full HD, базовое 2D-моделирование).

- RTX – адаптер имеет поддержку всех функций, увеличенное число CUDA-ядер, трассировку лучей и DLSS-сглаживание. Используется для современного гейминга, а также для профессиональной работы с компьютерной графикой.

Продукция AMD маркируется двумя буквенными индексами:

- R – карта имеет низкий уровень производительности и подходит исключительно для вывода картинки на монитор.

- RX – игровая серия ускорителей. Обладает всеми последними технологиями и подходит как для современных игр, так и для работы с графикой.

Номер поколения

Примерно каждые 2 года выходят новые поколения видеокарт. Чем они актуальнее, тем выше их производительность. Например, NVIDIA GeForce RTX 4080, вышедшая в 2022 году, на 51% мощнее GeForce RTX 3080 – своего аналога, выпущенного в 2020 году.

У видеокарт NVIDIA номер поколения обозначается первыми двумя цифрами в названии. Если вернуться к предыдущему примеру, то числа 40 и 30 – как раз обозначают поколение. У продукции AMD принцип аналогичный. Только у «красных» поколение сообщается первой цифрой в наименовании. К примеру, в названии AMD Radeon RX 6700XT номер поколения – это число 6.

Серия и буквенный индекс в конце наименования

Именно они раскрывают конкретную производительность видеокарты. У продукции NVIDIA серия обозначается последними двумя цифрами в наименовании, а у AMD последними тремя. К примеру, в названии AMD Radeon RX 6600XT число 600 – это и есть серия. Чем она больше, тем выше производительность карты. Например, GeForce RTX 4090 на 30% мощнее GeForce RTX 4080.

Буквенный индекс в конце названия сообщает об «улучшенной версии» устройства. Карты NVIDIA маркируются приставкой «Ti», а карты AMD «XT». Так, AMD Radeon RX 6800XT на 10% мощнее обычной Radeon RX 6800.

Разбор наименования на практике

Подытожим все вышесказанное на примере NVIDIA GeForce RTX 4090. Ее название говорит нам о том, что:

- NVIDIA – графический процессор от компании «зеленых»;

- GeForce – устройство предназначено для игр и работы с графикой;

- RTX – карта имеет поддержку всех последних функций;

- 40 – устройство последнего поколения, выпущенное в 2022 году;

- 90 – адаптер является самым мощным в текущем поколении.

У компании NVIDIA серия «90» является максимальной. У продукции AMD ситуация похожая. Их самые производительные карты имеют серию «950», например, как у Radeon RX 6950XT.

Что выбрать – NVIDIA или AMD

Определитесь, зачем вам нужна видеокарта. Если требуется комплектующая для работы с графикой (видеомонтаж, проектирование, обработка фото, 3D-моделирование и т.п.), то ответ однозначный – берите карту NVIDIA. Почему устройство от «зеленых»? Потому что их продукция отличается стабильной работой и наличием CUDA-ядер.

- Под стабильной работой понимают отсутствие ошибок. Лаги, зависания, фризы, вылеты программ – все это отсутствует у графических ускорителей NVIDIA. А вот карты AMD, наоборот, по сообщениям пользователей, перечисленными проблемами не обделены. Однако с выходом каждого нового драйвера ситуация становится лучше.

- Ядра CUDA представляют собой технологию параллельного вычисления. Эта разработка увеличивает производительность ГПУ как в играх, так и в профессиональных задачах. Причем многие программы имеют тесную интеграцию с технологией CUDA. Например, в видеомонтажной утилите Adobe Premiere Pro есть пункт «Ускорение GPU с помощью механизма Adobe Mercury Playback (CUDA)».

Если вас интересует гейминг, а не профессиональная работа с графикой, то определитесь, хотите ли вы играть с трассировкой лучей (DXR). В случае отрицательного ответа берите карты от AMD. Зачастую они стоят дешевле аналогов от NVIDIA и обладают лучшей производительностью. Например, во многих играх Radeon RX 6600XT мощнее GeForce RTX 3060 на 10%. Однако это касается бюджетных и среднебюджетных карт. В случае с «топовыми» устройствами лидерство занимает NVIDIA. Их карты 80 и 90 серии производительнее аналогов 800, 900 и 950 серии у AMD.

Но если вы планируете играть с трассировкой лучей, то выбирайте устройства «зеленых». Они имеют более производительные RT-ядра, которые отвечают за ускорение технологии DXR. Если включить трассировку лучей в Cyberpunk 2077 на GeForce RTX 3060, то FPS упадет на 40%, а у Radeon RX 6600XT он снизится на 110%.

От какой компании купить карту

Когда вы зайдете в магазин и задумаетесь, какую видеокарту выбрать для игр, то обнаружите, что в названии не только их буквенно-цифровые индексы. Также вам встретятся следующие надписи: Asus, Gigabyte, Palit, MSI, Zotac, Sapphire и т.п. Все это названия компаний производителей.

Кто на самом деле производит видеокарты?

NVIDIA и AMD не выпускают видеокарты. Более того, они даже не производят графические процессоры. ГПУ изготавливают компании Samsung (Южная Корея) и TSMC (Тайвань). Тогда чем занимаются NVIDIA и AMD? На самом деле они разрабатывают графические процессоры, а готовые чертежи отправляют партнерам из Samsung и TSMC.

Но почему GPU выпускает кто-то другой? Причина одна – деньги. Построить завод по производству микрочипов стоит миллиарды долларов. Кроме того, поиск персонала и процесс строительства занимает несколько лет. Гораздо проще и дешевле обратиться к организации, которая уже специализируется на выпуске микрочипов. Достаточно передать ей чертежи и получить готовую продукцию.

Хорошо, графические процессоры разрабатывают NVIDIA и AMD. Выпускают их Samsung и TSMC. Но кто делает сами видеокарты? Вот именно здесь на сцену выходят вендоры – компании-производители графических карт. Как и в случае с ГПУ у «зеленых» и «красных» нет заводов по выпуску своей продукции. Поэтому за данной услугой они обращаются к партнерам. Самые известные из них: Gigabyte, Asus, MSI и Palit. Менее популярные: Zotac, Sapphire, Colorful, Inno 3D, EVGA и KFA2.

Все эти компании называют себя производителями, но по факту они сборщики. Графические процессоры закупают у NVIDIA и AMD. Видеопамять заказывают у Samsung, Micron и Hynix. Конденсаторы, дроссели, радиаторы, вентиляторы – приобретаются у других фирм. Так называемые «производители» только собирают купленное на своем оборудовании и наносят логотип на готовую продукцию.

Чем отличаются карты у разных производителей?

Современные видеокарты почти не отличаются друг от друга компонентной базой. Контроллеры, конденсаторы, драйверы, мосфеты, дроссели, топология печатной платы – все это практически одинаковое. Исключение составляют:

- KFA2 линейки HOF;

- MSI линейки SUPRIM;

- ASUS линейки ROG Strix;

- ColorFul линейки iGame Vulcan.

В этих премиальных моделях используется не только другая компонентная база, но и частично перерабатывается топология платы. Это повышает надежность карт и увеличивает их ресурс. Например, в продукции MSI SUPRIM используются DrMOS-микросхемы не AOZ, а NCP. Согласно отзывам пользователей они надежнее и реже выходят из строя. Но улучшенная компонентная база встречается только в премиальных линейках. У той же MSI есть бюджетная серия под названием «Ventus». В ней используются упрощенные компоненты.

Помимо основы производители используют разную систему охлаждения. Она состоит из металлического радиатора и вентиляторов. Горячие компоненты через термоинтерфейс отдают тепло на радиатор. Кулеры обдувают его и охлаждают компоненты. Чем ниже их рабочие температуры, тем дольше они проработают.

Система охлаждения проектируется исходя из тепловыделения карты. На эту характеристику влияет производительность элементов, а также их количество. Например, NVIDIA GeForce RTX 3090 имеет массивную систему охлаждения. У нее 21 фаза питания, 24 чипа видеопамяти и графический процессор с TDP 350 Ватт. В сравнении, GeForce RTX 3060 Ti имеет: 10 фаз питания, 8 чипов видеопамяти и ГПУ с TDP 200 Ватт. По этой причине видеокарта младшей серии не обладает габаритной системой охлаждения. Ее радиатор тоньше, а количество вентиляторов у некоторых моделей составляет не 3, а 2 штуки.

У каких производителей карты лучше?

Данный вопрос некорректный. Почему? Потому что у производителей есть как премиальные, так и бюджетные линейки видеокарт. Графические ускорители выбираются не только исходя из производителя, но и из его модельного ряда. А о том, какую видеокарту выбрать, мы поговорим в разделе «критерии и варианты выбора».

Объем видеопамяти

Для эффективной работы графическому процессору нужно хранить данные в «быстром доступе». Закачивать их напрямую с накопителя долго. Даже современные высокоскоростные SSD не обладают достаточной скоростью для ГПУ. Чтобы решить эту проблему была разработана видеопамять (VRAM). Ее принцип работы такой же как у оперативной памяти для центрального процессора. Разница лишь в том, что в ней хранятся графические данные, из которых формируется картинка на мониторе.

Главные характеристики видеопамяти:

- тип;

- объем.

Сегодня актуальны GDDR6 и GDDR6X типы видеопамяти. Дополнительная приставка «X» говорит об улучшенной версии. GDDR6X отличается увеличенной рабочей частотой и пропускной способностью, повышающими производительность карты в среднем на 15%. Однако тип GDDR6X встречается только в старших сериях продуктов NVIDIA. Компания AMD использует во всех своих устройствах стандартную GDDR6.

От объема памяти напрямую зависят мощность и возможности карты. Даже флагманские ГПУ не смогут проводить графические расчеты при малом объеме VRAM.

Трассировка лучей

Эту технологию разработали еще в 80-х годах прошлого века. С ее помощью освещение в компьютерной графике рассчитывается по законам физики. Источники света в реальной жизни испускают миллионы лучей. Они преломляются, отражаются, поглощаются и только после этого попадают на сетчатку человеческого глаза.

Системы 80-х годов не имели ресурсов для работы с такими сложными вычислениями. Поэтому освещение в компьютерной графике создавалось не по законам физики. Разработчики делали множество алгоритмов, которые имитировали поведение света из реальной жизни. Но сколько бы ни старались программисты, их технологии имели много недостатков. Например, алгоритм SSR, который используется для отрисовки отражений в играх и кинематографе, не работает в крайних областях экрана. А стоит наклонить камеру вверх или вниз, как отражения исчезают вовсе.

Поддержка трассировки лучей в современных картах

С каждым годом производительность центральных и графических процессоров росла. И вскоре их мощности стало достаточно для расчета света по законам физики. В 2018 году NVIDIA представила новое поколение видеокарт, главная особенность которых – поддержка DXR. Для этого «зеленые» полностью переработали архитектуру своих устройств. Они даже сменили название с «GTX» на «RTX», где буква «R» это сокращение от «Ray tracing».

Главное архитектурное нововведение – это добавление RT и тензорных ядер. RT-ядра ускоряют работу видеокарты при включении трассировки лучей. А тензорные используются для работы DLSS-сглаживания. В 2020 году компания AMD также добавила поддержку технологии DXR, и в 6000 серии карты Radeon обзавелись RT-ядрами. Эти блоки также были добавлены в консоли нового поколения. PlayStation 5 и Xbox Series получили поддержку DXR наравне с персональными компьютерами.

Трассировка лучей в играх и программах

Добавить поддержку технологии DXR в видеокарты недостаточно. Чтобы насладиться реалистичным освещением, рейтрейсинг должен быть реализован в играх и программах. В 2018 году разработчики только начали добавлять технологию в свои продукты. Однако сегодня поддержку DXR имеют многие игры и графические утилиты.

Технология DLSS и ее альтернативы