Роботы — это программы, которые обходят сайт с определенной целью. Например, для индексирования сайта или проверки его работы. Какие-то роботы представляются сами, другие — наоборот, стараются маскироваться под реального пользователя, чтобы аналитические системы их не вычислили. Метрика определяет роботов по поведенческим факторам и другим техническим сигналам.

Также к визитам роботов Метрика может относить посещения сайта с адресов, которые не указаны в настройках счетчика (поля Адрес и Дополнительный адрес).

Фильтрация роботного трафика в отчетах Метрики помогает получать точные значения метрик. Например, показателя отказов, времени на сайте и глубины просмотра.

- Как понять, какие роботы посещают сайт

- Как сравнить статистику с роботными данными и без них

Примечание. Если в настройках счетчика включен фильтр фильтровать роботов по поведению, дополнительная настройка фильтрации роботов недоступна.

Вы можете использовать фильтрацию роботов по поведению, если вы пользуетесь Logs API Метрики и вам нужны неагрегированные данные без роботов. В других случаях меняйте режим отображения данных в отчетах, как описано ниже.

Роботы, которые представились (их User-agent известен), сразу исключаются из статистических данных. Их можно посмотреть в отчете Роботы. Он поможет определить, например, приходят ли на сайт поисковые роботы, чтобы проиндексировать страницы. Посмотрите, как представляются роботы Яндекса.

Отображение визитов роботов, которые определены по поведению, можно настроить. По умолчанию статистика отображается без учета таких визитов.

Отслеживать долю отфильтрованных по поведению роботов можно:

- В отчетах

-

Используйте метрику Роботность. Чтобы ее добавить, в отчете в настройке Данные выберите с роботами. После этого включится опция Метрика Роботность в отчетах — метрика появится в таблице данных.

Вы можете добавить метрику Роботность даже при выключенной опции. Для этого в отчете нажмите кнопку Метрики и выберите .

- На странице Сводка

-

Используйте настройку Данные:

-

без роботов — значение задано по умолчанию;

-

с роботами — выберите его, чтобы данные пересчитались с учетом посещений роботов.

Также можно использовать виджет:

-

;

-

.

-

- На странице со списком счетчиков

-

Используйте настройку Данные:

-

без роботов — значение задано по умолчанию;

-

с роботами — выберите его, чтобы данные пересчитались с учетом посещений роботов.

-

Как отфильтровать визиты роботов с помощью API Метрики

Чтобы сравнить статистику, в отчете в настройке Данные: без роботов выберите Сравнить с данными с роботами. Так вы сможете увидеть, как роботы влияют на ваш сайт. Например, роботы могут стать причиной снижения глубины просмотров и увеличения отказов.

Написать в чат

Обратите внимание: служба поддержки не обзванивает пользователей. Не следуйте указаниям людей, которые вам звонят и представляются службой поддержки Яндекс Метрики.

От автора: хотите составить для своего проекта файл с указаниями для робота, но не знаете как? Сегодня разберемся, как посмотреть robots.txt сайта и изменить его под свои нужды.

В интернете каждый день появляются готовые решения по той или иной проблеме. Нет денег на дизайнера? Используйте один из тысяч бесплатных шаблонов. Не хотите нанимать сео-специалиста? Воспользуйтесь услугами какого-нибудь известного бесплатного сервиса, почитайте сами пару статей.

Уже давно нет необходимости самому с нуля писать тот же самый robots.txt. К слову, это специальный файл, который есть практически на любом сайте, и в нем содержатся указания для поисковых роботов. Синтаксис команд очень простой, но все равно на составление собственного файла уйдет время. Лучше посмотреть у другого сайта. Тут есть несколько оговорок:

Сайт должен быть на том же движке, что и ваш. В принципе, сегодня в интернете куча сервисов, где можно узнать название cms практически любого веб-ресурса.

Это должен быть более менее успешный сайт, у которого все в порядке с поисковым трафиком. Это говорит о том, что robots.txt составлен нормально.

Итак, чтобы посмотреть этот файл нужно в адресной строке набрать: доменное-имя.зона/robots.txt

Все неверятно просто, правда? Если адрес не будет найден, значит такого файла на сайте нет, либо к нему закрыт доступ. Но в большинстве случаев вы увидите перед собой содержимое файла:

В принципе, даже человек не особо разбирающийся в коде быстро поймет, что тут написать. Команда allow разрешает что-либо индексировать, а disallow – запрещает. User-agent – это указание поисковых роботов, к которым обращены инструкции. Это необходимо в том случае, когда нужно указать команды для отдельного поисковика.

Что делать дальше?

Скопировать все и изменить под свой сайт. Как изменять? Я уже говорил, что движки сайтов должны совпадать, иначе изменять что-либо бессмысленно – нужно переписывать абсолютно все.

Итак, вам необходимо будет пройтись по строкам и определить, какие разделы из указанных присутствуют на вашем сайте, а какие – нет. На скриншоте выше вы видите пример robots.txt для wordpress сайта, причем в отдельном каталоге есть форум. Вывод? Если у вас нет форума, все эти строки нужно удалить, так как подобных разделов и страниц у вас просто не существует, зачем тогда их закрывать?

Самый простой robots.txt может выглядеть так:

|

User–agent: * Disallow: /wp–admin Disallow: /wp–includes Disallow: /wp–content Allow: /wp–content/uploads/ |

Все вы наверняка знаете стандартную структуру папок в wordpress, если хотя бы 1 раз устанавливали этот движок. Это папки wp-admin, wp-content и wp-includes. Обычно все 3 закрывают от индексации, потому что они содержат чисто технические файлы, необходимые для работы движка, плагинов и шаблонов.

Каталог uploads открывают, потому что в нем содержаться картинки, а их обыно индексируют.

В общем, вам нужно пройтись по скопированному robots.txt и просмотреть, что из написанного действительно есть на вашем сайте, а чего нет. Конечно, самому определить будет трудно. Я могу лишь сказать, что если вы что-то не удалите, то ничего страшного, просто лишняя строчка будет, которая никак не вредит (потому что раздела нет).

Так ли важна настройка robots.txt?

Конечно, необходимо иметь этот файл и хотя бы основные каталоги через него закрыть. Но критично ли важно его составление? Как показывает практика, нет. Я лично вижу сайты на одних движках с абсолютно разным robots.txt, которые одинаково успешно продвигаются в поисковых системах.

Я не спорю, что можно совершить какую-то ошибку. Например, закрыть изображения или оставить открытым ненужный каталог, но чего-то супер страшного не произойдет. Во-первых, потому что поисковые системы сегодня умнее и могут игнорировать какие-то указание из файла. Во-вторых, написаны сотни статей о настройке robots.txt и уж что-то можно понять из них.

Я видел файлы, в которых было 6-7 строчек, запрещающих индексировать пару каталогов. Также я видел файлы с сотней-другой строк кода, где было закрыто все, что только можно. Оба сайта при этом нормально продвигались.

В wordpress есть так называемые дубли. Это плохо. Многие борятся с этим с помощью закрытия подобных дублей так:

|

Disallow: /wp–feed Disallow: */trackback Disallow: */feed Disallow: /tag/ Disallow: /archive/ |

Это лишь некоторые из дублей, создаваемых wordpress. Могу сказать, что так можно делать, но защиты на 100% ожидать не стоит. Я бы даже сказал, что вообще не нужно ее ожидать и проблема как раз в том, о чем я уже говорил ранее:

Поисковые системы все равно могут забрать в индекс такие вещи.

Тут уже нужно бороться по-другому. Например, с помощью редиректов или плагинов, которые будут уничтожать дубли. Впрочем, это уже тема для отдельной статьи.

Где находится robots.txt?

Этот файл всегда находится в корне сайта, поэтому мы и можем обратиться к нему, прописав адрес сайта и название файла через слэш. По-моему, тут все максимально просто.

В общем, сегодня мы рассмотрели вопрос, как посмотреть содержимое файла robots.txt, скопировать его и изменить под свои нужды. О настройке я также напишу еще 1-2 статьи в ближайшее время, потому что в этой статье мы рассмотрели не все. Кстати, также много информации по продвижению сайтов-блогов вы можете найти в нашем курсе. А я на этом пока прощаюсь с вами.

Определение ботов на сайте с помощью нейронных сетей

Время на прочтение

4 мин

Количество просмотров 5.2K

Пару лет назад, как и многие другие владельцы сайтов в рунете, я столкнулся с резким ростом посетителей из социальных сетей. Поначалу это радовало, пока дело не дошло до детального изучения поведения таких “пользователей” – оказалось что это боты. Мало того, они еще и сильно портили поведенческие факторы, которые критически важны для хорошего ранжирования в Яндексе, да и в Гугле.

Изучая ТГ каналы, посвященным накрутке поведенческих факторов (а большинство ботов используется для этого), пришла в голову мысль, что наверняка же разработчики ботов где-то ошибаются, где-то упираются в невозможность реализовать полноценную эмуляцию параметров настоящих браузеров и поведение реальных посетителей. На основании двух этих гипотез и возникла идея создать 2 нейросети. Первая из них должна определять бота по многочисленным параметрам браузера. А вторая – по поведению на сайте – по тому, как пользователь скроллит, кликает и совершает другие действия.

Сбор базы

Первое, что нужно для обучения нейронной сети – достаточное количество обучающих примеров – визитов, о которых мы достоверно знаем, что это боты и визитов, о которых точно известно, что это реальные люди. Для такого отбора было использовано три параметра:

-

Скоринг Recapcha V3.

-

Залогинен ли посетитель в сервисах Google, Yandex, VK.

-

Уникальность Canvas Hash.

Суть последнего параметра в том, что на элементе HTML “холст” рисуется картинка, далее вычисляется md5 хэш этого изображения. В зависимости от операционной системы, ее версии, версии браузера, устройства, изображение чуть отличается и хэш получается разным. Боты, как правило, накладывают случайный шум на изображение, чтобы затруднить их детектирование, и в результате у них хэш получается уникальным. У реальных людей уникальных хэшей не бывает.

Итак, реальный посетитель, если:

-

Скоринг Recapcha V3 >=0.9.

-

Залогинен в Яндексе и в одном из: Google либо VK.

-

Canvas Hash неуникальный.

Бот, если:

-

Скоринг Recapcha V3<=0.3

-

Нигде не залогинен, либо залогинен только в Яндекс. Боты для накрутки поведенческих факторов очень часто ходят под профилем Яндекса.

-

Уникальный Canvas Hash.

Данные брались с трех информационных сайтов за период в 1 месяц. В базу попало чуть больше сорока тысяч визитов, 25% из которых это боты и 75% реальные люди. Что именно собиралось будет описано далее.

Определение бота по параметрам браузера

Хотя боты и работают на браузерных движках, но это далеко не полноценный Google Chrome, за который они себя хотят выдать. Многие параметры им приходится эмулировать, чтобы выглядеть как настоящий пользовательский браузер. Вот и попробуем обучить нейронную сеть находить несоответствия эмулированных параметров реальным. Для этого соберем максимальное количество информации о браузере, а именно:

-

ОС, версия ОС, название браузера, версия браузера, модель гаджета, если есть возможность ее получить.

-

Параметры соединения – тип сети, скорость.

-

Разрешение экрана, размер окна отображения, есть ли полоса прокрутки и другие параметры, связанные с отображением.

-

Параметры webGL (модель видеокарты, размер памяти и т.п.).

-

Виды медиа контента, который может воспроизвести браузер.

-

Какие шрифты поддерживает браузер (анализируются 300 самых распространенных шрифтов).

-

Параметры WebRTC.

Получилось несколько десятков параметров

Следующее, что нужно решить – какую архитектуру нейронной сети использовать. Поскольку база несколько не сбалансирована, первое, что пришло в голову – попробовать автокодировщик. Обучить его на реальных людях (их 75%), а выбросы трактовать как ботов. Была использована следующая архитектура:

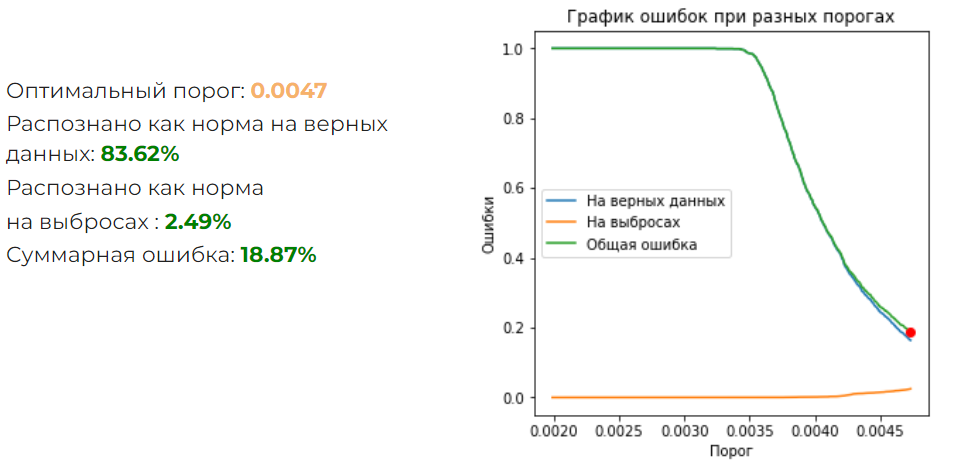

Результат получился такой:

Суммарная ошибка великовата. Надо попробовать обычный классификатор на полносвязанных слоях. Была подобрана следующая архитектура:

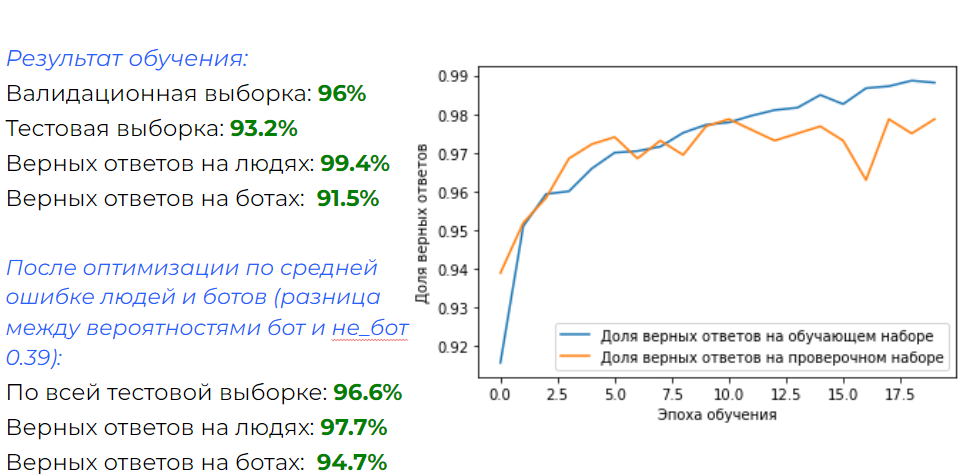

Что получилось:

Результат отличный! И для отсеивания большинства ботов, которые используются для накрутки ПФ, такая нейронка подходит.

Но что если бюджет позволяет использовать ботов не просто на браузерном движке, а на реальном Google Chrome? Это требует значительно больше ресурсов, но технически легко реализуемо. Для такого случая эта нейронная сеть не подойдет. Но можно попробовать проанализировать поведение бота и сравнить с поведением реальных людей.

Определение бота по поведению на сайте

Хорошие боты эмулируют поведение реального человека – они кликают, скроллят, двигают мышкой по траектории, похожей на человеческую и т.п. Но наверняка где-то ошибаются – может быть у них немного другое распределение событий, другие задержки, места клика и т.д. Попробуем собрать как можно больше данных о поведении посетителей. Для этого проанализируем следующие события:

-

Движение мыши.

-

Прокрутка колесика.

-

Нажатие на сенсорный экран.

-

Прокрутка на странице.

Для каждого события соберем следующие параметры:

-

Длительность.

-

Изменения по оси X и Y.

-

Скорость изменения по оси X и Y.

-

Число элементарных событий, которые получил браузер.

События укладываются во временной ряд, а значит имеет смысл использовать одномерные сверточные сети. Оптимальной получилась такая архитектура:

А результат следующий:

Результат тоже вполне хороший. К минусам можно отнести то, что требуется не меньше 20-ти секунд нахождения на странице, чтобы произошло достаточное количество действий. Поэтому нельзя применять для фильтрации траффика на этапе загрузки.

Вывод

Плюсы и минусы каждого метода приведены на картинке:

Что дальше

На данный момент функционал реализован в виде WordPress плагина и работает в тестовом режиме на одном из сайтов. Его код можно посмотреть здесь.

В дальнейшем планируется все довести до “ума” и запустить в виде сервиса.

Статья подготовлена совместно с разработчиком Antibot.cloud.

Каким бывает ботовый трафик, и чем он опасен

Обращения к сайту можно разделить на три группы:

- Живые люди, зашедшие через браузер.

- Полезные боты (например, роботы поисковых систем «Яндекс» и Google).

- «Плохие» боты, которые могут нанести ущерб.

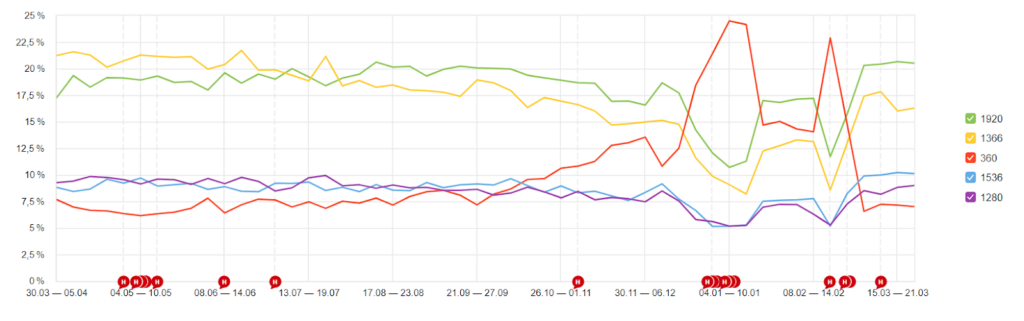

Многие даже не знают, сколько ботов бродит по страницам их ресурса. Наверняка вы наблюдали всплески посещений, заходы из необычных локаций или со странных устройств, изучая отчёты «Яндекс.Метрики» или Google Analytics. Скорее всего, за них были ответственны боты. Например, мы в 2021 году заметили рост трафика на блог Travelpayouts с устройств с низким разрешением экрана. А это одно из проявлений ботового трафика.

Ниже на картинке расположен пример статистики многостраничного сайта из кабинета сервиса Antibot.cloud. На ней видно, что процент живых людей («Уники» и «Хиты») составляет всего около 0,5% от количества всех ботов («Не прошли», «Хороших ботов» и «Заблокировано»).

«Хорошие боты» — это роботы поисковых систем, собственные автоматические обращения к API и подобное. «Фейк боты» — это парсеры, которые подставляли юзер-агенты GoogleBot или YandexBot. Те, которые отмечены как «Не прошли» и «Заблокировано», не приносят никакой пользы, а скорее вредят.

Также ботов можно разделить на две категории:

- совершают действия на сайте;

- переходят с одного сайта на другой. Например, кликают по партнёрской ссылке на сайте партнёра и переходят на ресурс бренда.

Цели таких ботов и проблемы, к которым может привести их активность, отличаются.

Ботовый трафик на сайте

Поисковые роботы (краулеры)

Поисковые роботы — это роботы поисковых систем «Яндекса», Google и других. Они ищут новые страницы в сети, сканируют их и помогают индексироваться в поиске.

Это полезные для SEO роботы, которые особых проблем не доставляют.

SEO-боты

SEO-боты принадлежат SEO-платформам (например, Ahrefs, Semrush, Serpstat и других), которые помогают своим пользователям проанализировать ресурсы конкурентов и узнать свой рейтинг. Такие данные помогают владельцам сайтов улучшить позиции в поиске.

Чем опасны:

Единственный урон от таких ботов — это нагрузка на сайт. Если вы не являетесь пользователем SEO-платформ, то можете заблокировать их.

Боты для накрутки поведенческих факторов

Боты для улучшения поведенческих факторов — это «серый» метод продвижения в поисковой выдаче. Их запускают на заказанный сайт, чтобы имитировать посещение реальных людей: просматривать разные страницы в течение длительного времени, чтобы уменьшить показатель отказов.

Чтобы вывести заказанный ресурс в топ, ботов отправляют ухудшать поведенческие факторы на сайтах, которые занимают первые строки поисковой выдачи. Здесь они, наоборот, проводят мало времени на страницах и увеличивают показатель отказов.

Чем опасны:

Ваш ресурс может стать одним из тех, который боты пытаются сместить с топовых позиций поиска.

Боты-парсеры

Парсеры (или скрейперы) собирают важные данные со страниц, такие как адреса или контактные данные. В некоторых случаях парсеры воруют контент.

Чем опасны:

Ваш контент может быть украден и опубликован на других ресурсах. Так, статьи и изображения становятся неуникальными, из-за чего падают позиции сайта в поисковиках.

Боты для поиска уязвимостей

Существуют боты, которые анализируют миллионы сайтов и ищут на них уязвимости. Только одни сообщают о проблемах владельцу, а другие — используют информацию в свою пользу.

Чем опасны:

Передают собранную информацию третьему лицу. Тот может продать данные или использовать их для взлома.

Боты загрузки

Боты загрузки предназначены для того, чтобы скачивать материалы с вашего сайта. Например, бесплатные путеводители или полезные чек-листы, которые владельцы сайтов используют в своей маркетинговой стратегии в качестве лид-магнитов.

Чем опасны:

Создают ложное впечатление об эффективности материалов. Предположим, если в вашем путеводителе есть партнёрские ссылки, вы заметите большое количество скачиваний гайда, но число переходов по ссылкам не будет соответствовать вашей средней конверсии. Тогда вы, скорее всего, захотите переработать материал или изменить маркетинговую воронку. Только если число скачиваний накрутили боты, ваша многодневная работа вряд ли улучшит конверсию.

Боты-спамеры

Боты-спамеры заполняют контактные формы, оставляют бессмысленные или рекламные комментарии на сайтах или в социальных сетях, отправляют фишинговые письма.

Чем опасны:

Спамеры быстро надоедают и негативно влияют на репутацию ресурса. Постоянно приходится читать от них письма, отправленные через форму, или модерировать комментарии.

Ботовый трафик с сайта

Клик-боты

Клик-боты имитируют поведение пользователя и, по сути, занимаются мошенничеством. Например, кликают по рекламе на сайте, партнёрским ссылкам и другим инструментам.

Чем опасны:

Если на сайте есть реклама с оплатой за клики, например, баннеры AdSense, РСЯ или партнёрские ссылки по CPC программам, можно получить бан и остаться без выплат за накрутку кликов. Гуляющие клик-боты сильно искажают статистику по партнёрским CPA программам: показов и кликов по инструментам много, а продаж нет.

Как проверить, есть ли на вашем сайте ботовый трафик

1. Изучайте данные систем аналитики

Проект может годами существовать с ботами, а негативный эффект может не проявиться или проявиться не столь заметно. Например, из-за ботового трафика будут постепенно снижаться позиции страниц сайта в выдаче, что приведёт к замедлению развития проекта.

Причём количество ненужных ботов возрастает вместе с ростом сайта. Ресурс становится более трастовым и раскрученным, растёт количество страниц и беклинков и вместе с тем и количество ботов. Поэтому первостепенная задача владельца — обнаружить вредоносный ботовый трафик.

Вычислить количество ботов, подсчитав все обращения без исключения, можно по логам сервера: access.log и так далее. Ботов, работающих на браузерных движках с поддержкой JS, можно увидеть в «Яндекс.Метрике». Елена Шикова, автор блога trip-together.ru рассказала, как она вычислила ботов с помощью «Метрики». Советы Елены подойдут и для анализа данных в Google Analytics. Читайте статью в нашем блоге.

2. Смотрите статистику по партнёрским программам без учёта ботов

Если вы занимаетесь партнёрским маркетингом, учитывайте, что визиты всех ботов попадают в статистику по партнёрским программам. Это искажает представление о конверсии: трудно оценить, сколько реальных людей интересуются контентом и кликают по партнёрским инструментам. Из-за неточной статистики вы можете принять неверное решение о работе с определёнными брендами: посчитаете, что приводите им большой трафик, но получаете недостаточно высокое вознаграждение за свою работу.

Чтобы статистика партнёров была более точной, мы в Travelpayouts сделали уникальный антибот фильтр. Он автоматически исключает ботовый трафик из всех отчётов и статистикам по партнёрским программам. Вы можете подробнее узнать, как работает антибот фича от Travelpayouts в нашей Базе знаний.

Как бороться с ботовым трафиком и когда начинать?

Стоит регулярно проверять трафик на наличие вредоносных ботов и быть готовым в любой момент выставить защиту. Даже если вы пока не замечаете негативного эффекта, вычислите количество ботового трафика. Если он составляет более 25% от всего трафика, то возникает риск получения проблем в «Яндексе» и Google. Это тот самый «порог», когда вам надо срочно позаботиться о защите.

Важно понимать, что избавиться от ботов на 100% не получится. Но существуют простые сервисы, которые помогут значительно сократить их количество: сохранить свой контент, позиции в выдаче, защитить рекламу и ссылки от скликивания.

BotFAQtor

Помогает анализировать посещения и блокировать трафик по источникам, типам визитов и другим критериям. Сервис предлагает защиту от скликивания баннеров, рекламы «Яндекс.Директ» и Google Ads, антибот для сайта и сервис сокращения ссылок.

Достоинства:

- Большой выбор сервисов и возможность покупать дополнительные проверки.

- Плагин для WordPress для быстрой установки BotFAQtor в пару кликов.

- Незаметный фильтр ботов (при входе пользователю не нужно доказывать, что он человек).

Недостатки:

- Падает скорость загрузки страниц.

- При включённой защите от скликивания рекламы замедляется скорость загрузки баннеров.

Сервис предлагает два тарифа: «Стандарт» стоимостью 7 500 рублей в год или VIP за 40 000 рублей в год. Если количества проверок в этих пакетах будет недостаточно, можно купить дополнительные в течение года.

CloudFlare

CloudFlare ориентировочно защищает 30% всех сайтов.

Достоинства:

- Кэширует статику (картинки) у себя, снижая нагрузку на сервер.

- Если настроить 3 простых правила, то получится отличная защита сразу от многих ботов, которые не поддерживают HTTP2. Это примитивные парсеры контента, чекеры уязвимостей, некоторые спамеры.

- При использовании CloudFlare у вас наготове будет защита от DDOS-атак.

- Всё это доступно на бесплатном тарифе. Даже платные сервисы защиты от DDOS-атак в целом не имеют преимуществ по сравнению с CloudFlare.

Недостатки:

- Исключительно из-за специфики российского законодательства: иногда IP от CloudFlare банит РКН.

- CloudFlare вообще не защищает от накрутки поведенческих факторов.

Сервис предлагает множество опций, в том числе бесплатных для личных сайтов и приложений до 50 пользователей. Если вам нужны более мощные функции безопасности, можно подключить платные опции, цены на которые начинаются от $5 в месяц.

AntiBot

«Антибот» помог решить проблему с ботами в блоге Travelpayouts: он установлен с февраля 2021 года и останавливает все виды ботов, включая тех, которые накручивают поведенческие факторы. Его можно использовать совместно с CloudFlare.

При антибот-проверке пользователь при заходе на сайт в течение 1-3 секунд видит страницу, похожую на страницу CloudFlare, затем автоматически проходит дальше. Если человек не прошёл автоматический тест, что случается примерно в 5% случаев, ему нужно просто нажать на кнопку.

Достоинства:

- Простая интеграция и настройка.

- Максимальная защита от ботов, маскирующихся людьми для улучшения поведенческих факторов.

- С «Антиботом» сайты не попадают в бан и не меняют позиции в поисковой выдаче.

- Заглушка переведена на самые популярные языки, а ещё её можно кастомизировать.

- «Антибот» защищает рекламу от скликивания ботами и не мешает её работе. Сайты с «Антиботом» успешно проходят модерацию в Adsense и РСЯ (при настройке: нужно добавить в белый список ботов «Яндекса» и Adsense).

- Если у вас нет опыта в установке скриптов, за дополнительную плату можно приобрести установку и настройку «под ключ».

Недостатки:

- Сайт, на котором стоит «Антибот», не получится рекламировать в Google Ads, так как он не пройдёт модерацию.

- Не обеспечивает защиту от DDOS-атак.

Стоимость «Антибота» зависит от количества доменов и варьируется от $25 до $99 в год. Читателям блога Travelpayouts сервис дарит промокод на +30 дней тестового периода на 1 домене и всех его поддоменах. Купон TP2022 будет работать при регистрации до 1 сентября 2023 года.

Сталкивались ли вы с ботами? Расскажите в комментариях, как они повлияли на ваш проект и как вы с ними боретесь.

Искусственный трафик, вызванный обращениями к сайту роботами и «пауками», может сильно искажать данные о трафике. Для получения более точной информации следует исключить их из статистических данных. В системах аналитики существуют встроенные функции, позволяющие осуществить фильтрацию роботов, о которых мы и расскажем.

Фильтрация посещений роботов в Яндекс.Метрике

Для того чтобы отфильтровать визиты роботов в Метрике, необходимо в настройках счетчика перейти на вкладку «Фильтры» и указать необходимый способ.

Вы увидите следующее окно:

Обратив внимание на параметр «Фильтрация роботов», вы заметите, что возможно три варианта:

- Учитывать визиты всех роботов. Данная настройка отключает фильтрацию визитов роботов.

- Фильтровать роботов только по строгим правилам. В данном случае фильтрация осуществляется на основании шаблонов IP-адресов и User-Agent. Среди преимуществ — отсутствие ложных срабатываний, однако по таким правилам фильтруется лишь небольшая доля искусственного трафика.

- Фильтровать роботов по строгим правилам и по поведению — позволяет более точно определить робота, но не исключены и ложные срабатывания, что может немного исказить картину естественного трафика.

Отфильтровать роботов в представляемых данных можно с помощью характеристики «Роботность» в инструментах сегментации:

Кроме того, в Метрике также возможно посмотреть отчёт о том, когда роботы посещали сайт. Для этого необходимо перейти в «Отчеты» — «Стандартные отчеты» — «Мониторинг» — «Роботы».

Фильтрация посещений роботов в Google Analytics

Чтобы включить фильтрацию, перейдите во вкладку «Администратор» — «Настройки представления».

Поставив флажок «Исключить обращения роботов и ”пауков”», вы исключите весь искусственный трафик и он не будет учитываться при составлении отчётов и представлении данных.