Цепи Маркова. Переходные вероятности

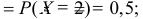

Лучшее спасибо – порекомендовать эту страницу

Примеры решений

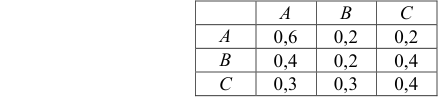

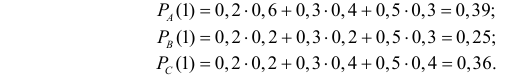

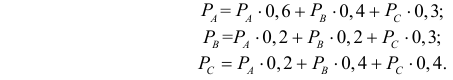

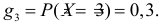

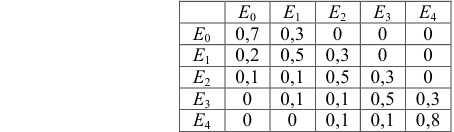

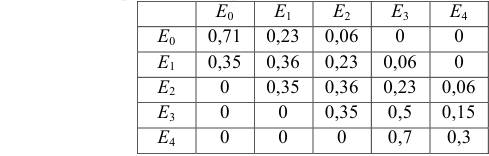

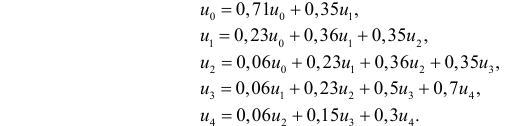

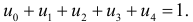

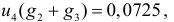

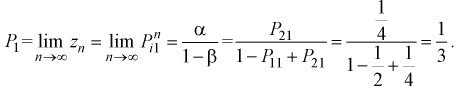

Задача 1. Для заданной матрицы переходных вероятностей Р найти вероятности перехода за 2 шага и стационарные вероятности, если они существуют.

Задача 2. Задана матрица $P_1$ вероятностей перехода дискретной цепи Маркова из состояния $i (i=1,2)$ в состояние $j (j=1,2)$ за один шаг. Распределение вероятностей по состояниям в момент $t=0$ определяется вектором $bar{q}$. Найти:

1) матрицу $P_2$ перехода из состояния $i$ в состояние $j$ за два шага;

2) распределение вероятностей по состояниям в момент $t=2$;

3) вероятность того, что в момент $t=1$ состоянием цепи будет $i=2$;

4) стационарное распределение.

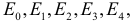

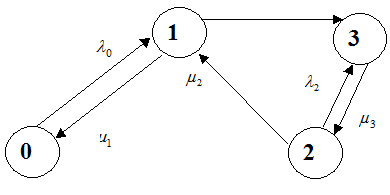

Задача 3. В заданной матрице $L$ элемент $lambda_{ij}$ есть интенсивность случайного пуассоновского процесса переходов из состояния $i$ в состояние $j$ (размерность кол-во переходов в единицу времени).

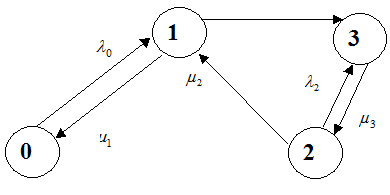

А) построить граф переходов между состояниями, ребра которого помечены соответствующими интенсивностями переходов.

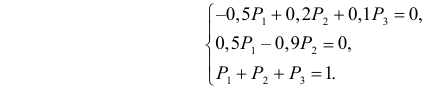

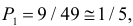

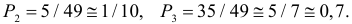

Б) написать систему уравнений для определения предельных вероятностей различных состояний.

В) решить эту систему уравнений, найти предельную вероятность каждого состояния.

Задача 4. Найти стационарные вероятности и математическое ожидание для марковского процесса N, заданного графом переходов состояний.

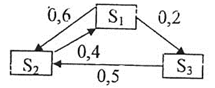

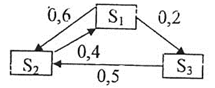

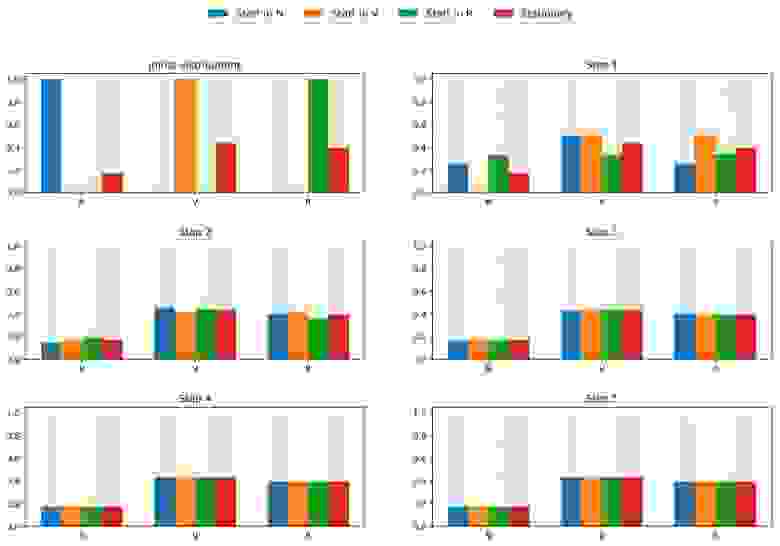

Задача 5. Дан размеченный граф состояний системы.

Найти:

А) матрицы перехода за один и два шага,

Б) вероятности состояний системы после первого, второго, третьего шага, если в начальный момент система находилась в состоянии $S_1$,

В) финальные вероятности.

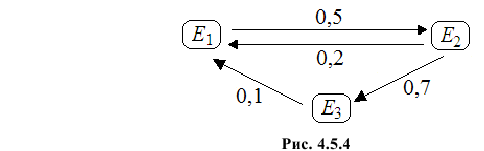

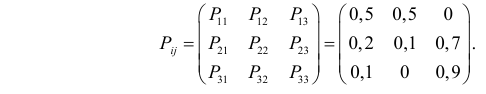

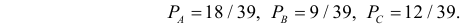

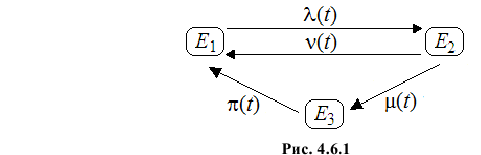

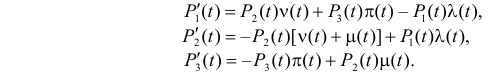

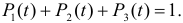

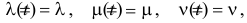

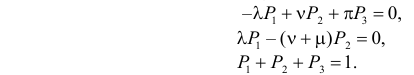

Задача 6. Система имеет три состояния. Построить граф состояний системы, написать уравнения Колмогорова и найти стационарное распределение.

Мы отлично умеем решать задачи по теории вероятностей

Содержание:

Случайные процессы:

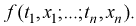

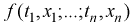

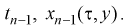

Пусть T – некоторое множество действительных чисел. Случайной функцией называется совокупность случайных величин

Что такое случайный процесс

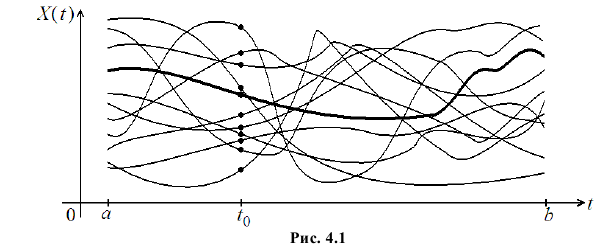

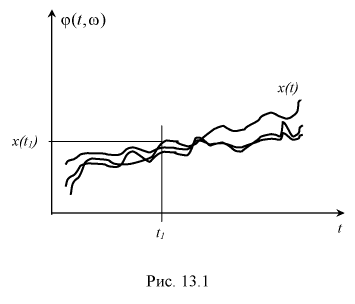

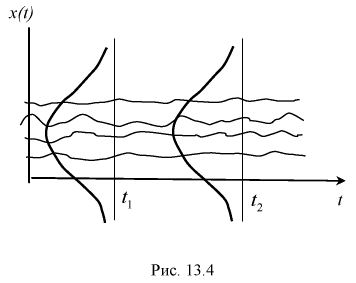

При наблюдении случайной функции мы получаем одну из возможных ее реализаций – неслучайную функцию. Поэтому случайную функцию можно рассматривать как совокупность всех ее возможных реализаций (см. рис. 4.1, на котором жирной линией выделена одна из возможных реализаций, а точками отмечены возможные значения случайной величины

Если роль параметра t играет время, то случайную функцию называют случайным процессом. Если параметр дискретный, то соответствующие ему случайные величины образуют случайную последовательность.

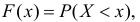

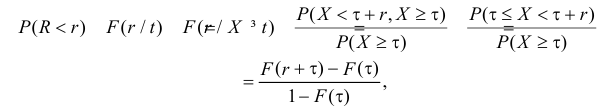

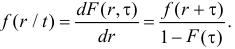

С изменением параметра t изменяется и закон распределения случайной величины  Этот закон распределения можно задать в виде функции распределения

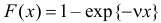

Этот закон распределения можно задать в виде функции распределения

Если функция распределения  дифференцируема, то

дифференцируема, то

называется функцией плотности вероятности.

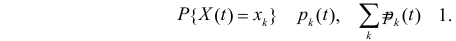

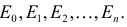

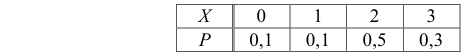

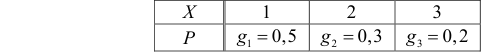

Для дискретной случайной величины одномерный закон распределения задается перечислением возможных значений и соответствующих им вероятностей

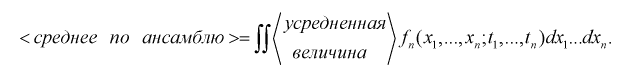

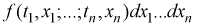

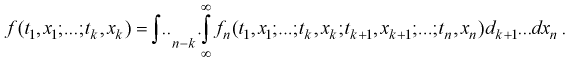

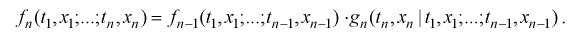

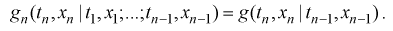

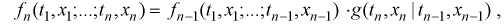

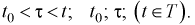

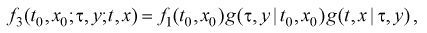

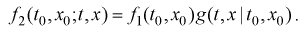

Конечномерным законом распределения случайной функции  называется закон распределения n сечений случайной функции

называется закон распределения n сечений случайной функции

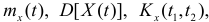

Проследить за изменениями всех возможных значений случайной величины и соответствующих им вероятностей, как правило, практически невозможно. Поэтому обычно ограничиваются анализом числовых характеристик случайной величины  . В первую очередь интересуются математическим ожиданием (начальным моментом первого порядка), дисперсией (центральным моментом второго порядка) и для анализа взаимосвязи между значениями процесса при разных значениях параметра t рассматривают коэффициент ковариации (ковариационный момент).

. В первую очередь интересуются математическим ожиданием (начальным моментом первого порядка), дисперсией (центральным моментом второго порядка) и для анализа взаимосвязи между значениями процесса при разных значениях параметра t рассматривают коэффициент ковариации (ковариационный момент).

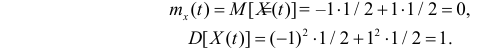

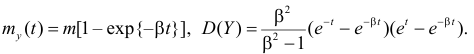

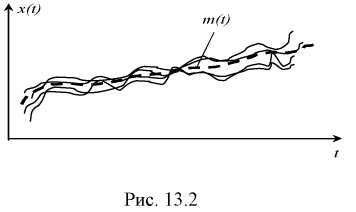

Математическим ожиданием случайного процесса  называют неслучайную функцию

называют неслучайную функцию  значение которой при каждом фиксированном значении параметра t равно математическому ожиданию сечения процесса при этом значении параметра, т.е

значение которой при каждом фиксированном значении параметра t равно математическому ожиданию сечения процесса при этом значении параметра, т.е

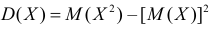

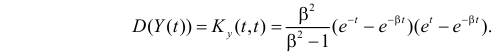

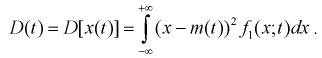

Дисперсией случайного процесса  называют неслучайную функцию

называют неслучайную функцию  значение которой при каждом фиксированном значении параметра t равно дисперсии сечения процесса при этом значении параметра, т.е.

значение которой при каждом фиксированном значении параметра t равно дисперсии сечения процесса при этом значении параметра, т.е.

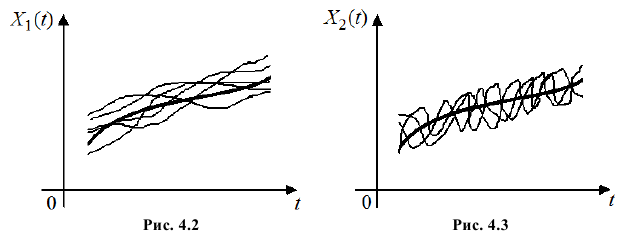

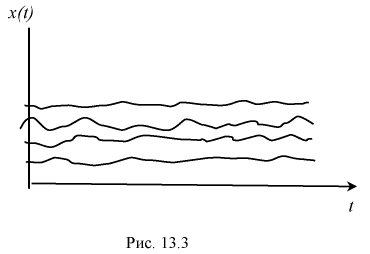

На рис. 4.2 и рис. 4.3 изображены несколько реализаций соответственно случайных процессов  и

и  , которые имеют одинаковые математические ожидания и дисперсии. Однако характер протекания этих процессов существенно различен. У процесса

, которые имеют одинаковые математические ожидания и дисперсии. Однако характер протекания этих процессов существенно различен. У процесса  реализации плавные. Это свидетельствует о зависимости значений процесса, отделенных небольшими промежутками времени. Процесс же

реализации плавные. Это свидетельствует о зависимости значений процесса, отделенных небольшими промежутками времени. Процесс же  меняется быстро и влияние предыдущих значений процесса быстро иссякает.

меняется быстро и влияние предыдущих значений процесса быстро иссякает.

Для описания этих особенностей процесса существует специальная характеристика, которая называется корреляционной функцией (иногда говорят об автокорреляционной функции).

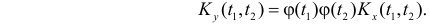

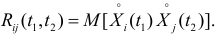

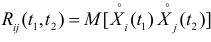

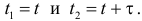

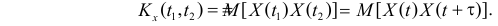

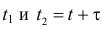

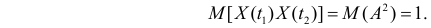

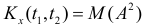

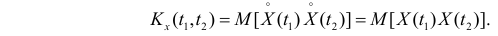

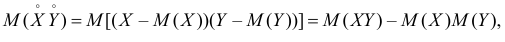

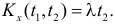

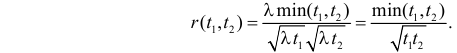

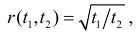

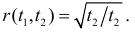

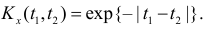

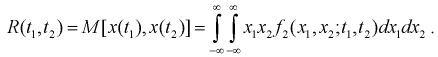

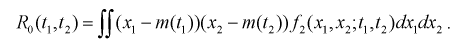

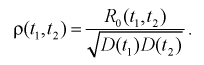

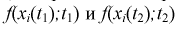

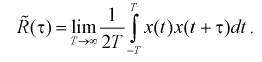

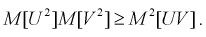

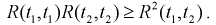

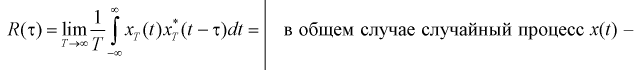

Корреляционной функцией случайного процесса  называют неслучайную функцию

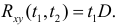

называют неслучайную функцию  значение которой при каждых фиксированных значениях параметра t1 и t2 равно коэффициенту ковариации величин

значение которой при каждых фиксированных значениях параметра t1 и t2 равно коэффициенту ковариации величин  и

и  , т.е.

, т.е.

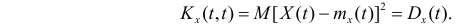

При равных между собой аргументах  корреляционная функция равна дисперсии случайного процесса:

корреляционная функция равна дисперсии случайного процесса:

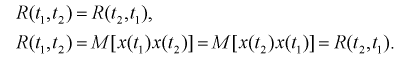

Свойства корреляционной функции

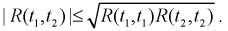

Отметим некоторые свойства корреляционной функции:

1. При перестановке аргументов корреляционная функция не меняется:

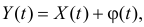

2. Прибавление к случайной функции  неслучайной функции

неслучайной функции не меняет ее корреляционной функции. Если

не меняет ее корреляционной функции. Если  то

то

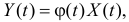

3. При умножении случайной функции  на неслучайную функцию

на неслучайную функцию  корреляционная функция умножается на произведение

корреляционная функция умножается на произведение  Если

Если  то

то

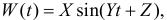

При решении некоторых научно-технических задач приходится иметь дело со случайными процессами, которые удается описать комбинацией простых (элементарных) функций, в которые в качестве параметров входят случайные величины. Такие случайные функции называют элементарными случайными функциями.

Например,  где случайными величинами являются амплитуда X, частота Y и фаза Z гармонических колебаний.

где случайными величинами являются амплитуда X, частота Y и фаза Z гармонических колебаний.

Пример №1

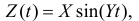

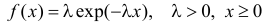

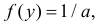

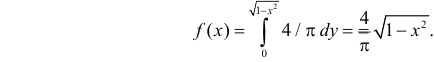

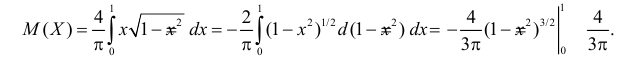

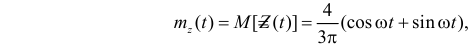

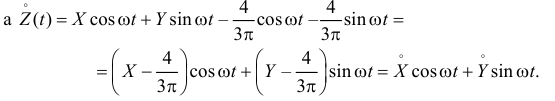

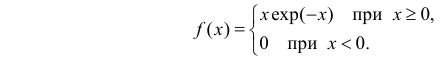

Элементарная случайная функция имеет вид  где X и Y независимы, причем X имеет плотность вероятности

где X и Y независимы, причем X имеет плотность вероятности  (показательный закон распределения с параметром

(показательный закон распределения с параметром  ), а случайная величина Y равномерно распределена в отрезке

), а случайная величина Y равномерно распределена в отрезке  Требуется найти для

Требуется найти для  математическое ожидание, дисперсию и автокорреляционную функцию.

математическое ожидание, дисперсию и автокорреляционную функцию.

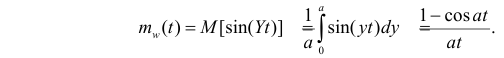

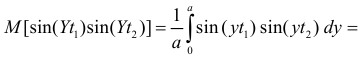

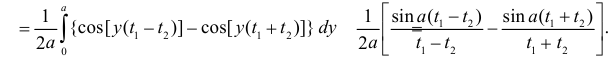

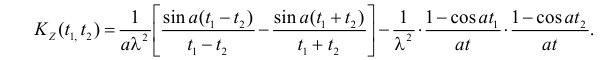

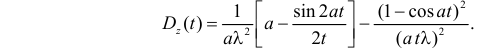

Решение. Обозначим  через

через  Учитывая, что случайная величина Y равномерно распределена на

Учитывая, что случайная величина Y равномерно распределена на  с постоянной плотностью

с постоянной плотностью  имеем

имеем

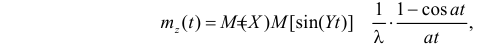

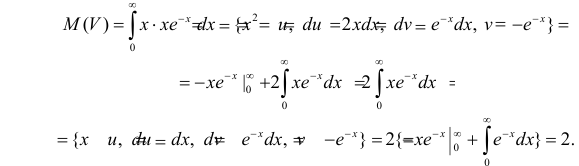

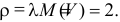

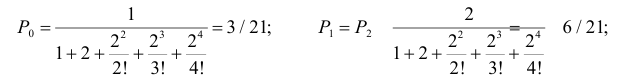

Поэтому

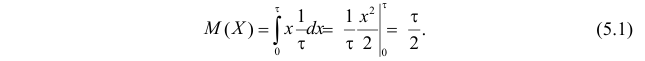

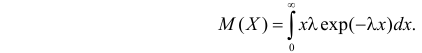

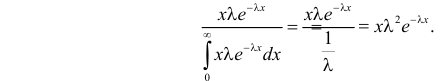

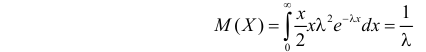

так как для показательного закона распределения  Вычислим

Вычислим

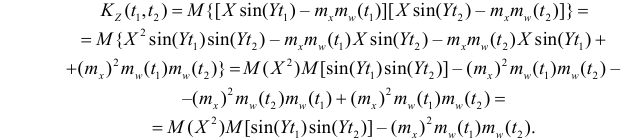

Для показательного закона распределения двукратное интегрирование по частям дает

а

Поэтому и при  и при

и при

Для вычисления дисперсии возьмем в полученном выражении

Ответ.

Пример №2

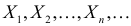

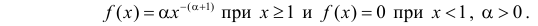

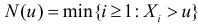

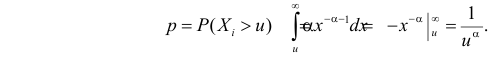

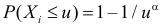

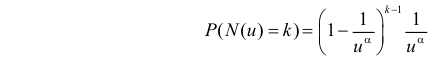

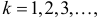

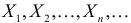

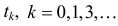

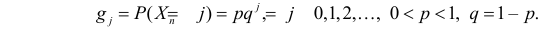

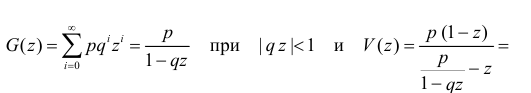

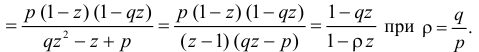

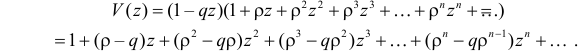

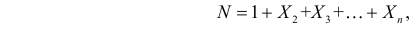

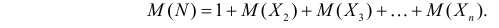

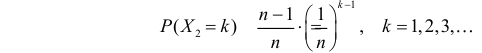

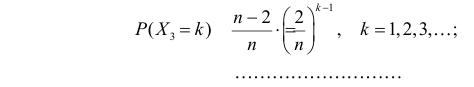

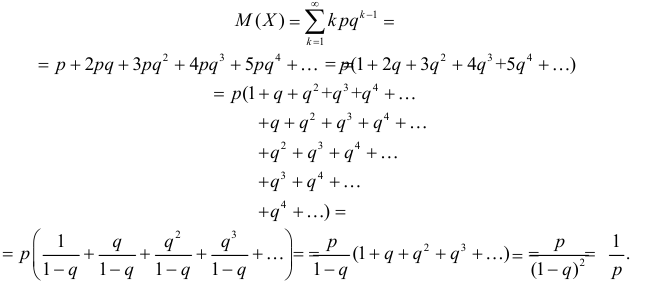

Пусть  – последовательность независимых случайных величин с функцией плотности вероятности

– последовательность независимых случайных величин с функцией плотности вероятности

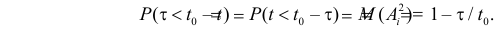

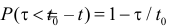

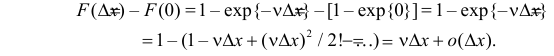

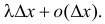

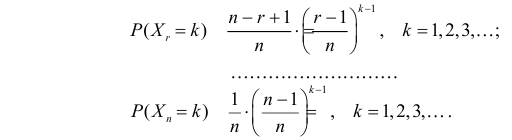

Говорят, что последовательность  превышает уровень

превышает уровень  (выходит за уровень

(выходит за уровень  ) в момент

) в момент  если

если  Рассмотрим

Рассмотрим  – момент первого выхода последовательности (случайного процесса с дискретным временем) за уровень

– момент первого выхода последовательности (случайного процесса с дискретным временем) за уровень  . Требуется найти распределение случайной величины

. Требуется найти распределение случайной величины  и ее математическое ожидание.

и ее математическое ожидание.

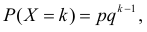

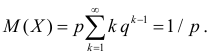

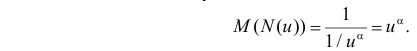

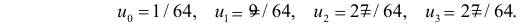

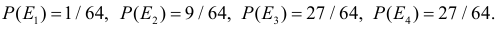

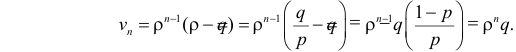

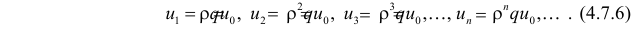

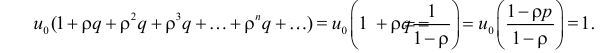

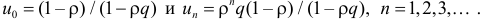

Решение. Вычислим

Тогда  и

и

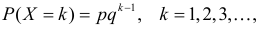

– это геометрический закон распределения.

Но для геометрического закона распределения

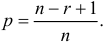

В нашем случае роль p играет величина

В нашем случае роль p играет величина  Поэтому

Поэтому

Ответ.

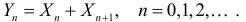

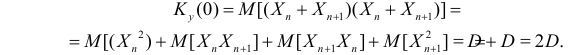

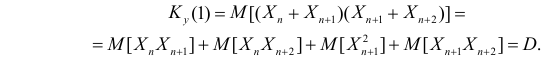

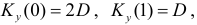

Пример №3

Пусть  – последовательность независимых случайных величин с нулевыми математическими ожиданиями и равными дисперсиями

– последовательность независимых случайных величин с нулевыми математическими ожиданиями и равными дисперсиями  Требуется найти корреляционную функцию для случайной последовательности

Требуется найти корреляционную функцию для случайной последовательности

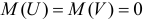

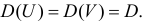

Решение. Так как математические ожидания случайных величин равны нулю, то  Поэтому

Поэтому

При

При

При остальных s = 2,3,… величина

Ответ.  при остальных s = 2,3,… величина

при остальных s = 2,3,… величина

Пример №4

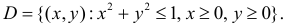

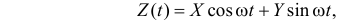

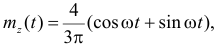

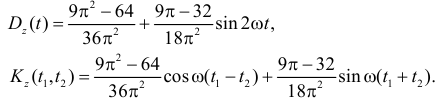

Все положения случайной точки (X,Y) равновозможны в области  Для случайного процесса

Для случайного процесса  постоянная w > 0, требуется найти математическое ожидание

постоянная w > 0, требуется найти математическое ожидание  дисперсию

дисперсию  и корреляционную функцию

и корреляционную функцию

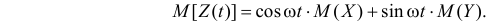

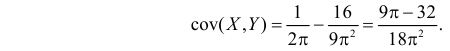

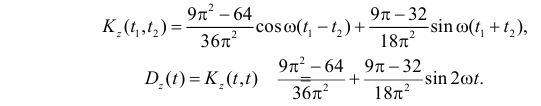

Решение. По свойствам математического ожидания

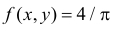

Так как площадь области D равна  , а все положения случайной точки (X,Y) в этой области равновозможны, то плотность вероятности случайной точки

, а все положения случайной точки (X,Y) в этой области равновозможны, то плотность вероятности случайной точки  при

при  и

и  при остальных

при остальных

Маргинальная плотность вероятности случайной величины X равна

Поэтому

Аналогично,  Поэтому

Поэтому

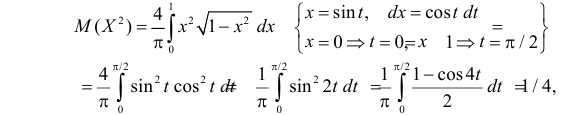

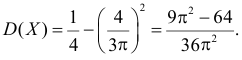

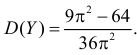

Вычислим дисперсию X. Так как

то  Аналогично находим, что

Аналогично находим, что

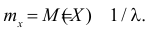

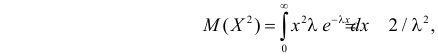

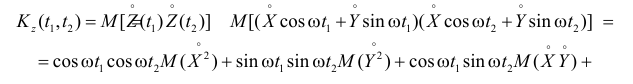

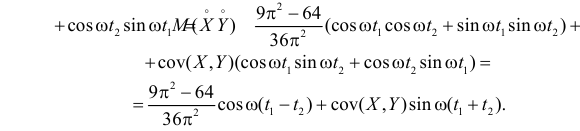

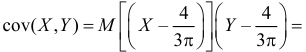

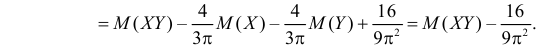

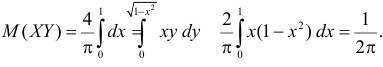

Вычислим теперь корреляционную функцию процесса:

Вычислим

Но  Поэтому

Поэтому

С учетом этого получаем

Ответ.

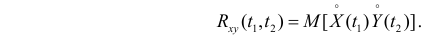

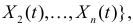

Взаимной корреляционной функцией двух случайных функций X(t) и Y(t) называют неслучайную функцию  двух независимых аргументов t1 и t2, значения которой равны корреляционному моменту случайных величин X(t1) и Y(t2):

двух независимых аргументов t1 и t2, значения которой равны корреляционному моменту случайных величин X(t1) и Y(t2):

Коррелированными называют две случайные функции, если их взаимная корреляционная функция не равна тождественно нулю. В противном случае говорят о некоррелированных случайных функциях.

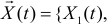

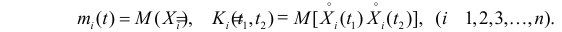

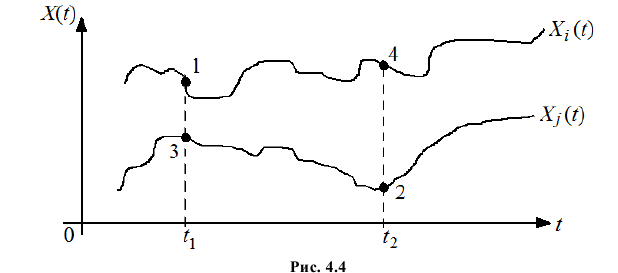

Если рассматривать многомерный случайный процесс

то он имеет характеристики

то он имеет характеристики

Эти характеристики описывают поведение отдельно взятых координат случайного процесса, но не учитывают взаимодействие между ними. В качестве характеристики взаимозависимости координат случайного процесса используют взаимную корреляционную функцию  В общем случае взаимная корреляционная функция

В общем случае взаимная корреляционная функция  не равна

не равна  так как ковариация между сечениями

так как ковариация между сечениями  (на рис. 4.4 точки 3 и 4).

(на рис. 4.4 точки 3 и 4).

В терминах характеристик второго порядка, например, двумерный случайный процесс  описывают вектором средних значений

описывают вектором средних значений  и матрицей корреляционных функций

и матрицей корреляционных функций

Наглядным примером двумерного случайного процесса (или случайного поля) может служить поверхность моря.

Пример №5

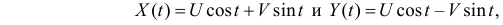

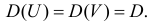

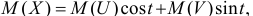

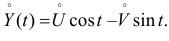

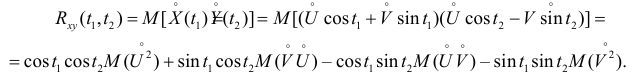

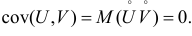

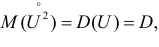

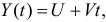

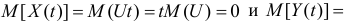

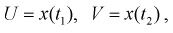

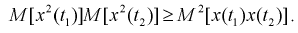

Даны два случайных процесса

где случайные величины U и V независимы и имеют равные дисперсии  Требуется найти взаимную корреляционную функцию этих процессов.

Требуется найти взаимную корреляционную функцию этих процессов.

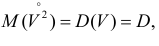

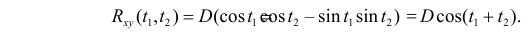

Решение. Так как  то

то

Аналогично,  Тогда

Тогда

Величины U и V независимы, а значит и некоррелированы. Поэтому  С учетом того, что

С учетом того, что  а

а  получаем

получаем

Ответ.

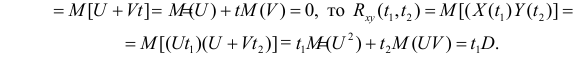

Пример №6

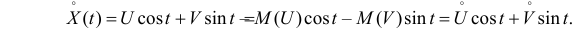

Даны два случайных процесса  и

и  где U и V независимы, имеют

где U и V независимы, имеют  и

и  Требуется найти взаимную корреляционную функцию этих процессов.

Требуется найти взаимную корреляционную функцию этих процессов.

Решение. Так как

Ответ.

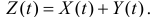

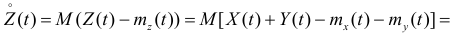

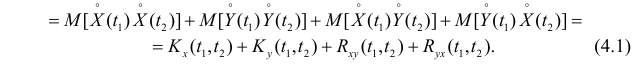

Пусть X(t) и Y(t) – две случайные функции, а случайная функция Z(t) равна  Выразим характеристики Z(t) через характеристики X(t) и Y(t).

Выразим характеристики Z(t) через характеристики X(t) и Y(t).

Математическое ожидание суммы двух случайных функций равно сумме математических ожиданий этих функций:

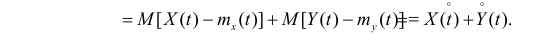

Заметим, что

Поэтому

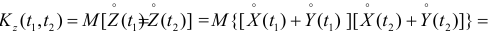

Легко видеть, что для процесса  корреляционная функция имеет вид:

корреляционная функция имеет вид:

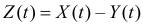

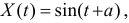

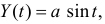

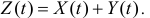

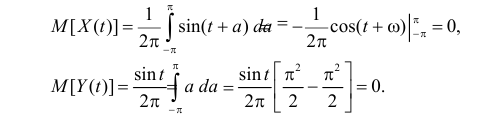

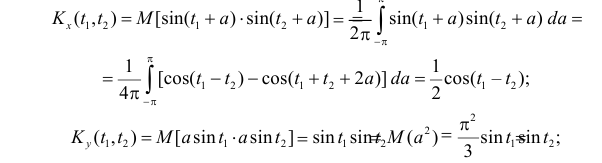

Пример №7

Случайный процесс  а

а  где

где  – случайная величина с равномерным законом распределения на

– случайная величина с равномерным законом распределения на  Необходимо найти корреляционную функцию случайного процесса

Необходимо найти корреляционную функцию случайного процесса

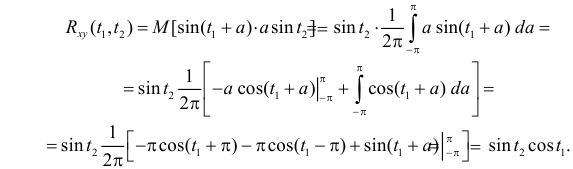

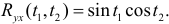

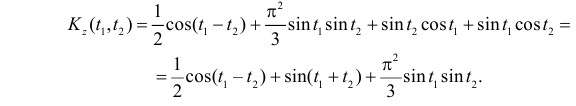

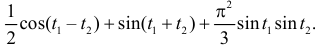

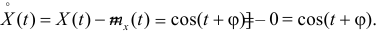

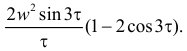

Решение. Прежде всего вычислим математические ожидания случайных процессов. Случайная величина  равномерно распределена на

равномерно распределена на  с плотностью вероятности равной

с плотностью вероятности равной  Поэтому

Поэтому

Вычислим величины необходимые для использования формулы (4.1):

Аналогично,  По формуле (4.1)

По формуле (4.1)

Ответ.

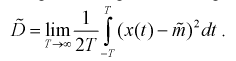

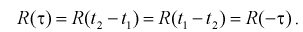

Стационарные случайные процессы

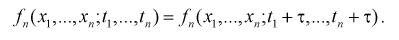

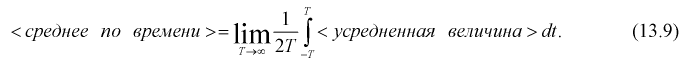

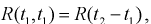

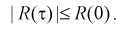

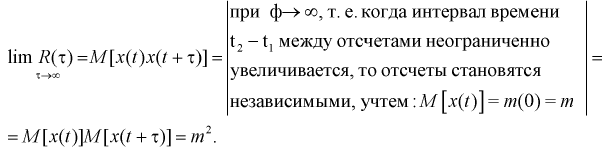

Случайный процесс называется стационарным, если все его характеристики не зависят от времени.

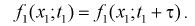

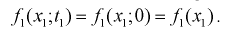

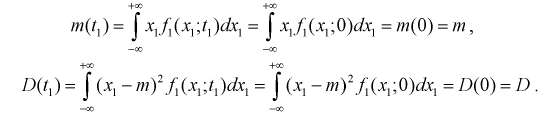

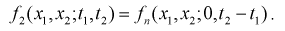

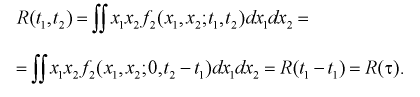

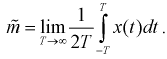

Определение. Случайная функция X(t) называется строго стационарной (стационарной в узком смысле), если все ее конечномерные законы распределения не изменяются от сдвига параметра (времени) на произвольную величину t0. Это в частности означает, что ее математическое ожидание и дисперсия постоянны, а корреляционная функции зависит только от разности аргументов.

Определение. Случайная функция X(t) называется стационарной в широком смысле, если ее математическое ожидание постоянно, а корреляционная функции зависит только от разности аргументов т.е.

Так как  то условие (4.1.1) означает и постоянство дисперсии.

то условие (4.1.1) означает и постоянство дисперсии.

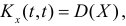

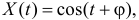

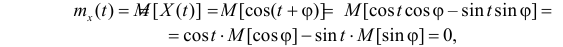

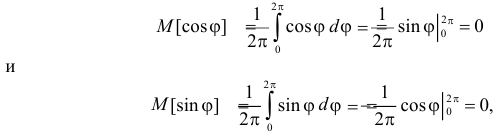

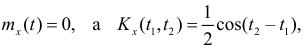

Пример 4.8.

Дан случайный процесс  где

где  – случайная величина, равномерно распределенная в отрезке

– случайная величина, равномерно распределенная в отрезке  Требуется доказать, что этот случайный процесс стационарен в широком смысле.

Требуется доказать, что этот случайный процесс стационарен в широком смысле.

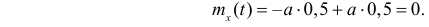

Решение. Для доказательства необходимо проверить выполнение условий (4.1.1). Найдем математическое ожидание

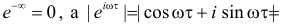

так как

где  – плотность вероятности случайной величины

– плотность вероятности случайной величины  . Заметим, что

. Заметим, что  Поэтому

Поэтому

так как

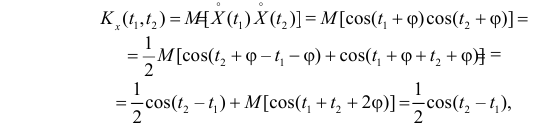

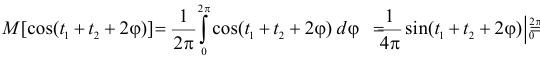

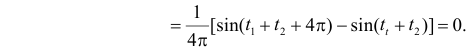

Итак,  т.е. зависит только от разности

т.е. зависит только от разности  Корреляционная функция оказалась независящей от величины

Корреляционная функция оказалась независящей от величины  , которую в приложениях обычно трактуют как «фазу».

, которую в приложениях обычно трактуют как «фазу».

Ответ. Процесс стационарен в широком смысле.

Пример 4.9.

Значения случайного процесса X(t) изменяются скачками в случайные моменты времени  . Моменты скачков образуют простейший (пуассоновский) поток событий интенсивности

. Моменты скачков образуют простейший (пуассоновский) поток событий интенсивности  т.е. вероятность того, что за время t произойдет k скачков равна

т.е. вероятность того, что за время t произойдет k скачков равна

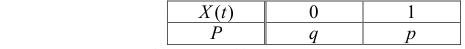

В интервале ,  между двумя скачками X(t) может принимать лишь два значения 0 или 1 с вероятностями соответственно

между двумя скачками X(t) может принимать лишь два значения 0 или 1 с вероятностями соответственно  Значения X(t) в различных интервалах независимы. (Такой процесс называют фототелеграфным сигналом.)

Значения X(t) в различных интервалах независимы. (Такой процесс называют фототелеграфным сигналом.)

Необходимо найти  и выяснить, является ли этот процесс X(t) стационарным в широком смысле.

и выяснить, является ли этот процесс X(t) стационарным в широком смысле.

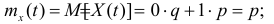

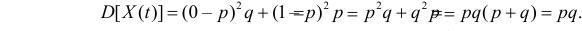

Решение. В произвольный момент времени t значения процесса имеют распределение

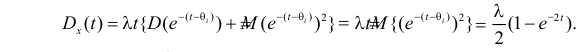

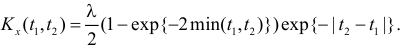

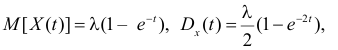

Поэтому

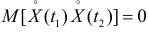

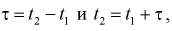

Заметим, что если между моментами t1 и t2 не было скачков процесса (вероятность чего по формуле (4.1.2) равна  где

где  то значения процесса X(t1) и X(t2) совпадают и

то значения процесса X(t1) и X(t2) совпадают и

Если же между моментами t1 и t2 скачки были, то величины X(t1) и X(t2) независимы и  . Поэтому

. Поэтому

Итак, математическое ожидание и дисперсия процесса постоянны, а корреляционная функция зависит только от разности значений аргументов. Это означает, что процесс стационарен в широком смысле.

Ответ.  Процесс стационарен в широком смысле.

Процесс стационарен в широком смысле.

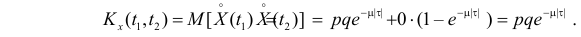

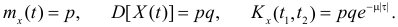

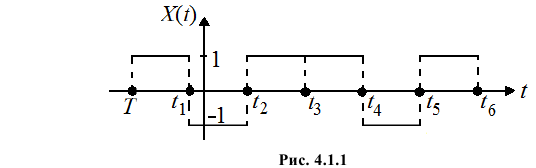

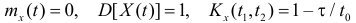

Пример 4.10.

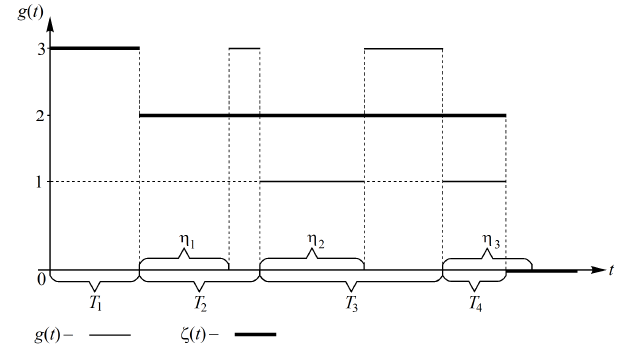

Случайный процесс X(t) строится следующим образом. В некоторый случайный момент времени T появляется прямоугольный импульс длительности t0 и случайной амплитудой A1. В момент времени  этот импульс сменяется новым импульсом той же длительности и случайной амплитуды A2, и т. д. Величины A1, A2,… независимы, и каждая с равными вероятностями принимает одно из двух значений «+1» или «–1». Одна из возможных реализаций процесса X(t) показана на рис. 4.1.1.

этот импульс сменяется новым импульсом той же длительности и случайной амплитуды A2, и т. д. Величины A1, A2,… независимы, и каждая с равными вероятностями принимает одно из двух значений «+1» или «–1». Одна из возможных реализаций процесса X(t) показана на рис. 4.1.1.

Требуется найти  и выяснить, является ли этот процесс X(t) стационарным в широком смысле.

и выяснить, является ли этот процесс X(t) стационарным в широком смысле.

Решение. Для любого момента времени t:

Обозначим  Так как равновозможны все положения точки t в

Так как равновозможны все положения точки t в  то t имеет равномерное распределение в

то t имеет равномерное распределение в  с функцией плотности вероятности

с функцией плотности вероятности

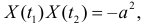

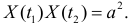

Случайный процесс центрирован  поэтому

поэтому

Если вместе  принадлежит промежутку

принадлежит промежутку  то

то

Вероятность этого

Если же  вероятность чего равна

вероятность чего равна  то

то

в силу независимости случайных величин  Поэтому

Поэтому

при

при  и

и  при

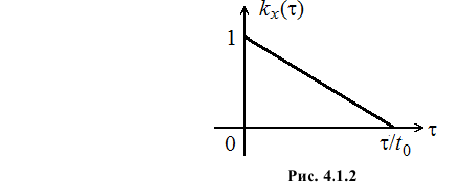

при  (см. рис. 4.1.2).

(см. рис. 4.1.2).

Постоянное значение математического ожидания процесса и зависимость корреляционной функции  только от разности аргументов

только от разности аргументов  свидетельствуют о том, что процесс стационарен в широком смысле.

свидетельствуют о том, что процесс стационарен в широком смысле.

Ответ.  при

при  и

и  при

при  Процесс стационарен в широком смысле.

Процесс стационарен в широком смысле.

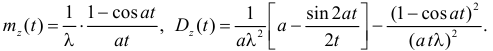

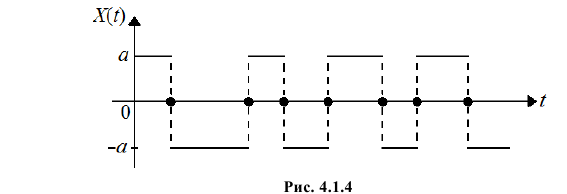

Пример 4.11.

Случайный процесс X(t) строится следующим образом. На числовой оси  реализуется простейший поток событий интенсивности

реализуется простейший поток событий интенсивности  Случайный процесс X(t) принимает попеременно случайные значения

Случайный процесс X(t) принимает попеременно случайные значения  и –

и – . При наступлении события простейшего потока X(t) скачком меняет свое значение с

. При наступлении события простейшего потока X(t) скачком меняет свое значение с  на –

на – или наоборот. Одна из реализаций процесса показана на рис. 4.1.4, где точками на оси отмечены события простейшего потока.

или наоборот. Одна из реализаций процесса показана на рис. 4.1.4, где точками на оси отмечены события простейшего потока.

Требуется найти математическое ожидание, дисперсию и ковариационную функцию этого случайного процесса.

Решение. Так как моменты изменения знака никак не связаны со значениями процесса X(t), нет оснований считать, что какое либо из значений ( или –

или – ) более вероятно, чем другое. Следовательно,

) более вероятно, чем другое. Следовательно,

Рассмотрим значения процесса в произвольные моменты времени t1 и t2. Так как  то

то

Произведение  если в интервале

если в интервале  происходит нечетное число событий (тогда значения процесса X(t1) и X(t2) будут разных знаков). Если же в интервале

происходит нечетное число событий (тогда значения процесса X(t1) и X(t2) будут разных знаков). Если же в интервале  происходит четное число событий, то

происходит четное число событий, то

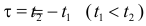

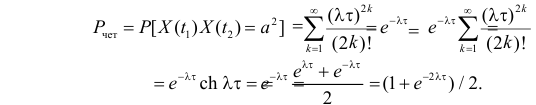

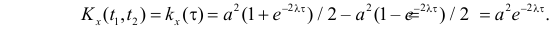

Вероятность появления за время  четного числа событий простейшего потока равна

четного числа событий простейшего потока равна

Тогда

Следовательно,

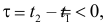

Аналогично, при  т.е. при

т.е. при

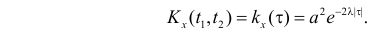

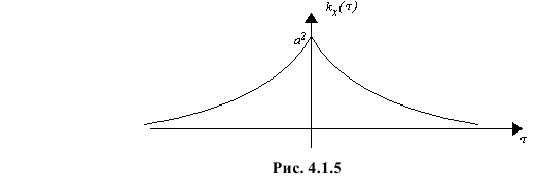

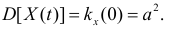

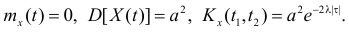

Полученные выражения для  можно объединить в одну запись:

можно объединить в одну запись:

График этой функции изображен на рис. 4.1.5.

Дисперсия процесса равна

Ответ.  Процесс стационарен в широком смысле.

Процесс стационарен в широком смысле.

Пример 4.12.

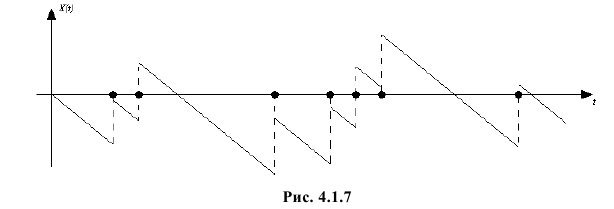

Случайный процесс X(t) устроен следующим образом. На оси времени реализуется простейший поток событий интенсивности  При появлении события этого потока процесс X(t) скачком возрастает на единицу. Между скачками он убывает линейно под углом минус 45°. Одна из реализаций процесса приведена на рис. 4.1.7, где точками на оси отмечены моменты появления событий простейшего потока.

При появлении события этого потока процесс X(t) скачком возрастает на единицу. Между скачками он убывает линейно под углом минус 45°. Одна из реализаций процесса приведена на рис. 4.1.7, где точками на оси отмечены моменты появления событий простейшего потока.

Требуется найти математическое ожидание  дисперсию

дисперсию  и корреляционную функцию

и корреляционную функцию  этого случайного процесса и его нормированную корреляционную функцию.

этого случайного процесса и его нормированную корреляционную функцию.

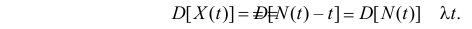

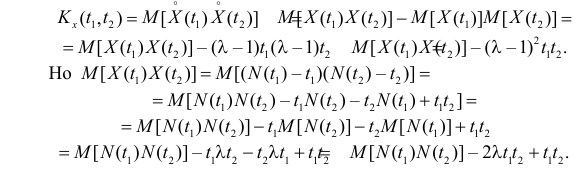

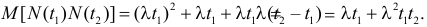

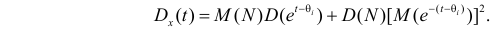

Решение. Каждый скачок процесса равен единице. Поэтому значение процесса в момент времени t можно записать в виде

где N(t) – число скачков за время t.

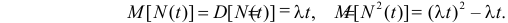

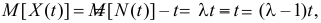

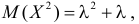

Случайная величина N(t) имеет пуассоновский закон распределения, причем

Поэтому

Так как  то при

то при

В свою очередь

Так как случайные величины  и

и  независимы, а для распределения Пуассона

независимы, а для распределения Пуассона  если параметр распределения равен

если параметр распределения равен то

то

В итоге имеем

Аналогично, при  получаем

получаем  Поэтому

Поэтому

Нормированная корреляционная функция:

Если  то

то  если же

если же  то

то  Величины X(t1) и X(t2) коррелированы положительно.

Величины X(t1) и X(t2) коррелированы положительно.

Ответ.

Пример 4.13.

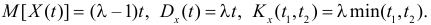

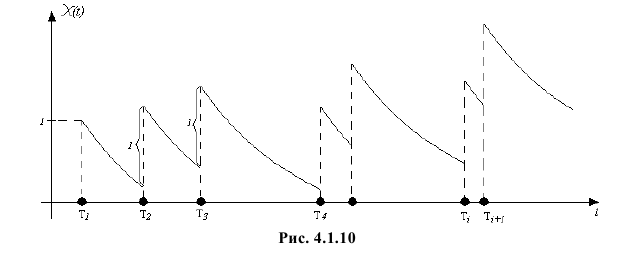

Случайный процесс X(t) изменяет свое состояние в моменты времени, которые образуют простейший поток интенсивности  В каждой точке скачка процесс X(t) возрастает на единицу, а затем убывает по экспоненте с показателем –1 до точки следующего скачка. Одна из реализаций такого процесса приведена на рис. 4.1.10. Требуется найти математическое ожидание, дисперсию и ковариационную функцию этого случайного процесса.

В каждой точке скачка процесс X(t) возрастает на единицу, а затем убывает по экспоненте с показателем –1 до точки следующего скачка. Одна из реализаций такого процесса приведена на рис. 4.1.10. Требуется найти математическое ожидание, дисперсию и ковариационную функцию этого случайного процесса.

Замечание. Описанный процесс может служить простейшей математической моделью воздействия потока электронов на анод. Поток электронов от катода к аноду близок к простейшему потоку некоторой интенсивности  При попадании электрона на анод напряжение на нем X(t) возрастает на некоторую единицу, а затем убывает по экспоненте, показатель которой зависит от характеристик электронной схемы.

При попадании электрона на анод напряжение на нем X(t) возрастает на некоторую единицу, а затем убывает по экспоненте, показатель которой зависит от характеристик электронной схемы.

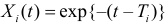

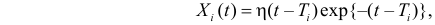

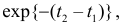

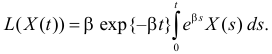

Решение. Результат воздействия  -го скачка, происшедшего в момент времени

-го скачка, происшедшего в момент времени  имеет вид:

имеет вид:  при

при  и

и  при

при  или

или

где  при

при  и

и  при

при

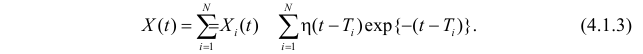

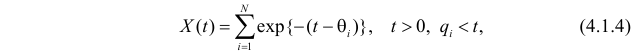

Так как поток скачков простейший, то за время t произойдет случайное число скачков N, распределенных по закону Пуассона с параметром  Поэтому X(t) является суммой случайного числа N случайных слагаемых

Поэтому X(t) является суммой случайного числа N случайных слагаемых

Воспользуемся следующим фактом: Простейший поток событий на (0, )t можно представить как совокупность случайного числа точек, каждая из которых равномерно распределена на  независимо от других точек. Поэтому (4.1.3) можно переписать в виде

независимо от других точек. Поэтому (4.1.3) можно переписать в виде

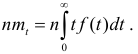

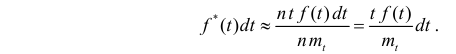

где все  равномерно распределены на

равномерно распределены на  а N не зависит от

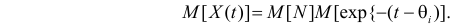

а N не зависит от  . Из (4.1.4) следует, что

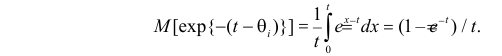

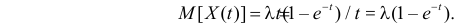

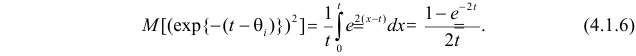

. Из (4.1.4) следует, что

(Здесь мы воспользовались тем, что математическое ожидание суммы случайного числа одинаково распределенных случайных величин равно произведению математического ожидания числа этих величин на математическое ожидание одной из них.)

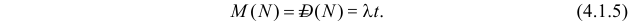

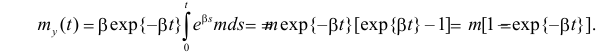

Так как число слагаемых N распределено по закону Пуассона, то

Каждая из величин равномерно распределена в  . Поэтому

. Поэтому

В итоге

Кроме того,

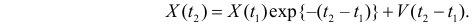

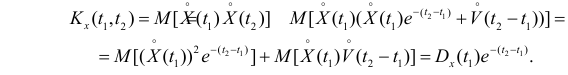

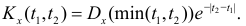

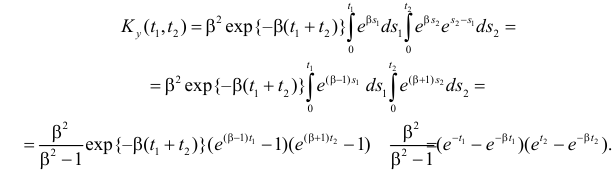

Рассмотрим два момента времени t1 и t2  Значение X(t2) равно значению 1 X(t1), умноженному на

Значение X(t2) равно значению 1 X(t1), умноженному на  , плюс вклад

, плюс вклад  от скачков процесса на интервале

от скачков процесса на интервале

Величины X(t1), и  независимы, так как они связаны со скачками процесса в непересекающихся интервалах времени

независимы, так как они связаны со скачками процесса в непересекающихся интервалах времени  и

и  . Поэтому при

. Поэтому при

Аналогично, при  получим

получим

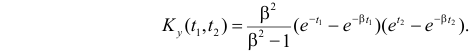

Поэтому  Остается вычислить:

Остается вычислить:

С учетом (4.1.5), (4.1.6) и того, что  получаем

получаем

В итоге,

Ответ.

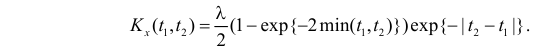

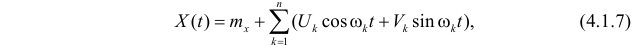

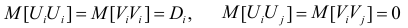

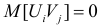

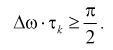

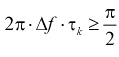

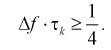

Стационарная в широком смысле функция X(t), представимая во всей области определения в виде

где Uk и Vk – центрированные случайные величины, удовлетворяющие условиям  при

при  ,

,  при всех i и j, называется случайной функцией с дискретным спектром.

при всех i и j, называется случайной функцией с дискретным спектром.

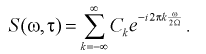

Такая случайная функция имеет автокорреляционную функцию

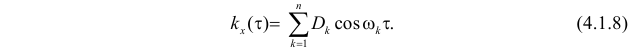

Равенство (4.1.7) называют спектральным разложением случайного процесса, а равенство (4.1.8) спектральным разложением корреляционной функции. Представление (4.1.8) показывает, что дисперсия процесса является суммой дисперсий отдельных гармоник на частотах

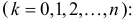

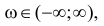

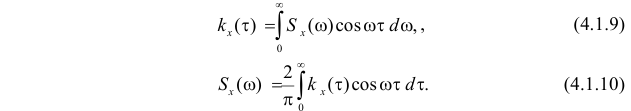

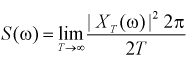

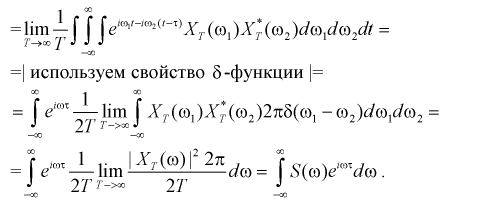

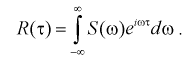

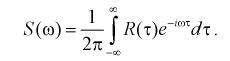

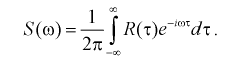

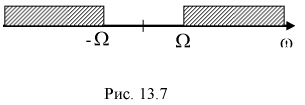

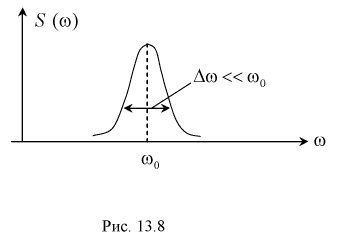

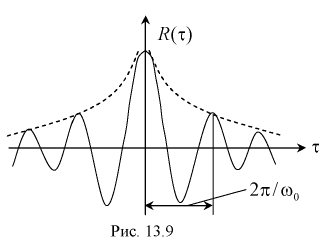

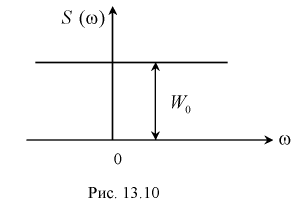

Говорят, что стационарная случайная функция X(t) является случайной функцией с непрерывным спектром, если существует такая действительная неотрицательная функция  определенная при всех

определенная при всех  что

что

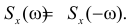

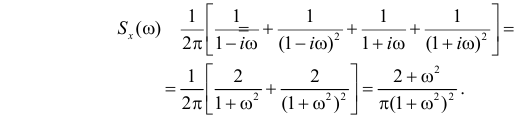

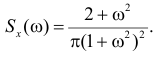

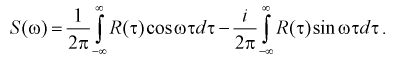

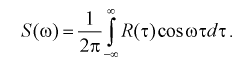

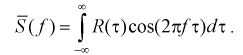

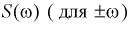

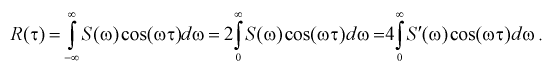

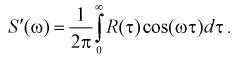

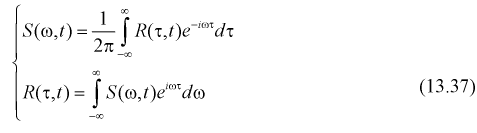

Функцию  называют спектральной плотностью, а формулы (4.1.9) и (4.1.10) называют формулами Винера–Хинчина. Из этих формул и свойств корреляционной функции следует, что

называют спектральной плотностью, а формулы (4.1.9) и (4.1.10) называют формулами Винера–Хинчина. Из этих формул и свойств корреляционной функции следует, что  – функция четная, т.е.

– функция четная, т.е.  Поэтому

Поэтому  изображают обычно только для неотрицательных

изображают обычно только для неотрицательных  . Случайные функции, обладающие конечной дисперсией, имеют спектральные плотности, которые стремятся к нулю на бесконечности быстрее, чем

. Случайные функции, обладающие конечной дисперсией, имеют спектральные плотности, которые стремятся к нулю на бесконечности быстрее, чем

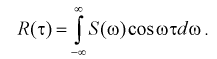

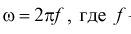

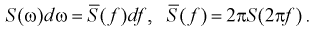

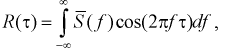

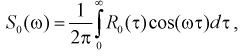

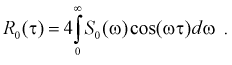

В силу четности корреляционной функции стационарного процесса и

его спектральной плотности формулы (4.1.9) и (4.1.10) можно записать в

виде:

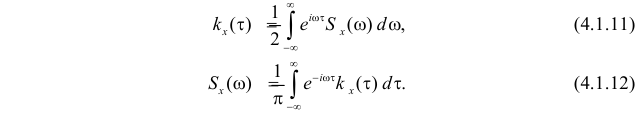

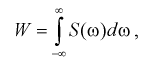

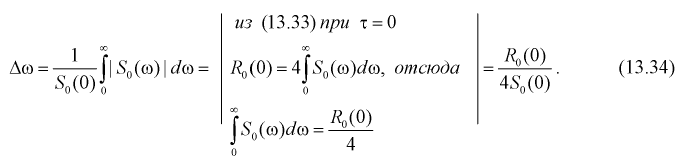

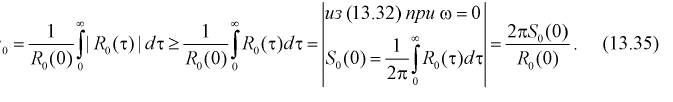

Формулы (4.1.11) и (4.1.12) означают, что корреляционная функция и спектральная плотность связаны взаимно обратными преобразованиями Фурье. Выражения вида (4.1.11) называют интегралом Фурье. Интеграл Фурье является обобщением разложения в ряд Фурье для случая непериодической функции на бесконечном интервале. Это разложение функции на сумму простых гармонических колебаний с непрерывным спектром.

Заметим, что дисперсию стационарного случайного процесса с непрерывным спектром можно выразить в виде интеграла от спектральной плотности:

Пример 4.14.

Корреляционная функция стационарного случайного процесса X(t) имеет вид

Требуется найти спектральную плотность процесса.

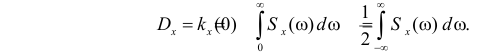

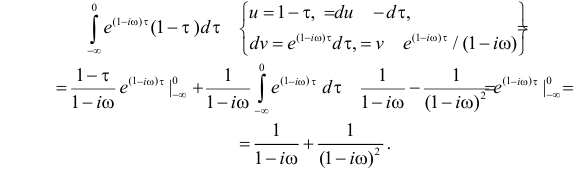

Решение. В соответствии с формулой (4.1.12)

Вычислим сначала первый интеграл

Аналогично

Поэтому

Ответ.

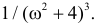

Спектральная плотность производной от случайной функции X(t) связана со спектральной плотностью этой функции  соотношением

соотношением

Пример 4.15.

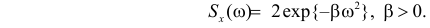

Спектральная плотность случайной функции X(t) имеет вид  Требуется найти дисперсию производной этой случайной функции.

Требуется найти дисперсию производной этой случайной функции.

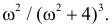

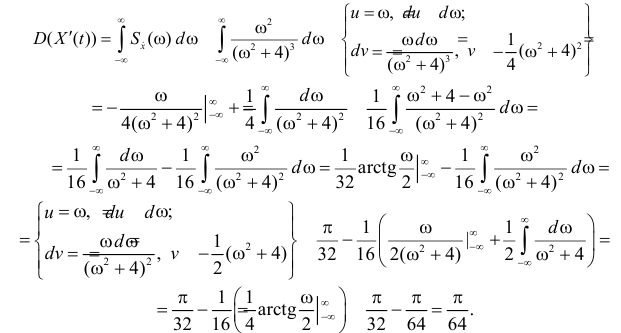

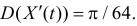

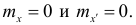

Решение. Согласно (4.1.13) спектральная плотность производной X'(t) имеет вид  Тогда

Тогда

Ответ.

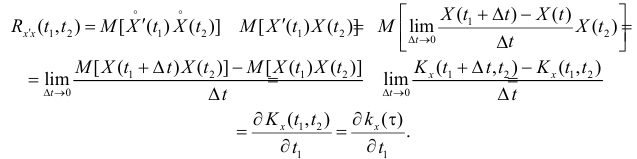

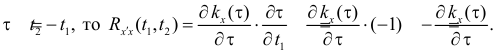

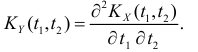

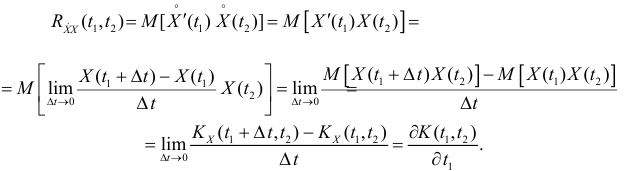

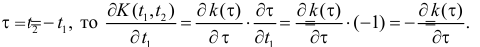

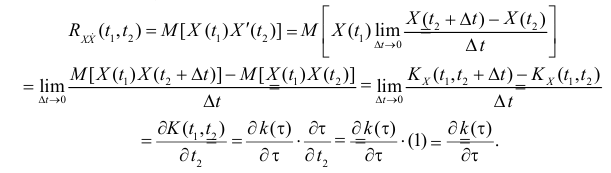

Пусть – автокорреляционная функция стационарного случайного процесса X(t). Найдем взаимную корреляционную функцию процессов X'(t) и X(t). Так как процесс X(t) стационарен, то

– автокорреляционная функция стационарного случайного процесса X(t). Найдем взаимную корреляционную функцию процессов X'(t) и X(t). Так как процесс X(t) стационарен, то  Поэтому

Поэтому

Так как

Аналогично

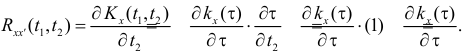

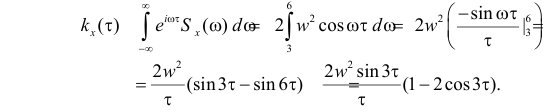

Пример 4.16.

Спектральная плотность случайного стационарного процесса X(t) имеет вид:  если

если  и

и  при остальных х. Требуется найти автокорреляционную функцию этого процесса.

при остальных х. Требуется найти автокорреляционную функцию этого процесса.

Решение. Так как функция  четная, то по формуле (4.1.11) получаем

четная, то по формуле (4.1.11) получаем

Ответ.

Пример 4.17.

Задана спектральная плотность стационарного случайного процесса

Требуется найти корреляционную функцию этого процесса.

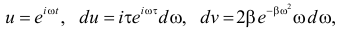

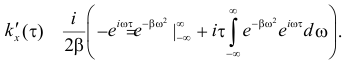

Решение. По формуле (4.1.11) получим:

Непосредственно вычислять такой интеграл трудно. Поэтому воспользуемся следующим приемом. Продифференцируем обе части равенства:

Проинтегрируем по частям:

Тогда  Первое слагаемое в скобке равно нулю, так как

Первое слагаемое в скобке равно нулю, так как

Интеграл во втором слагаемом совпадает с

Интеграл во втором слагаемом совпадает с  .

.

В итоге обнаружилась возможность найти  , как решение дифференциального уравнения

, как решение дифференциального уравнения

Это уравнение с разделяющимися переменными. Его общее решение:

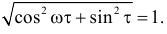

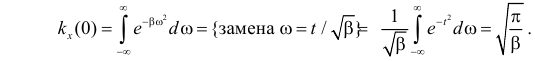

Для определения произвольной постоянной зададим начальное условие

(Напомним, что интеграл Пуассона  )

)

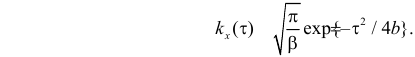

При таком начальном условии  Искомая корреляционная функция имеет вид:

Искомая корреляционная функция имеет вид:

Заметим, что и спектральная плотность, и корреляционная функция этого процесса относятся к типу гауссовских кривых.

Ответ.

Преобразование случайных процессов динамическими системами

Для случайных процессов оказалось целесообразным расширить трактовку некоторых понятий математического анализа.

Говорят, что случайная последовательность  сходится к числу b в среднеквадратическом смысле, если

сходится к числу b в среднеквадратическом смысле, если

(этот факт записывают кратко  ).

).

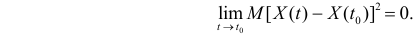

Случайный процесс X(t) называется стохастически непрерывным в точке  если

если

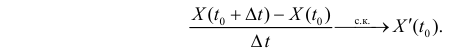

Случайная величина X'(t) называется среднеквадратической производной случайной функции X(t) в точке  если

если

Пусть имеется некоторая динамическая система. Под динамической системой понимается любое радиотехническое устройство, прибор, прицел, система автоматического управления, автопилот, вычислительное устройство и т.д.

На вход системы непрерывно подаются некоторые данные, система их перерабатывает и выдает результат этой переработки. Иногда входящие в систему данные называют «воздействием» или «сигналом», данные на выходе называют «реакцией» или «откликом» на воздействие. Обычно вместе с полезным сигналом поступают и случайные помехи, которые тоже перерабатываются динамической системой и влияют на отклик. Поэтому в общем виде ставится формальная задача о переработке динамической системой некоторого случайного процесса X(t). На выходе тоже получается случайный процесс Y(t). Схема описанной системы приведена на рисунке 4.2.1.

Естественно возникает вопрос: как по характеристикам X(t), с учетом особенностей динамической системы, найти характеристики сигнала на выходе?

С формальной точки зрения, каждая динамическая система задает некоторое соответствие между сигналами на входе и откликами на выходе.

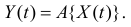

Правило, по которому функция X(t) на входе преобразуется в функцию Y(t) на выходе, называется оператором. Символически это записывают в виде:

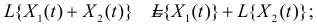

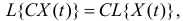

Оператор L называется линейным однородным оператором, если он обладает следующими свойствами:

1.

2.  где C – постоянная величина.

где C – постоянная величина.

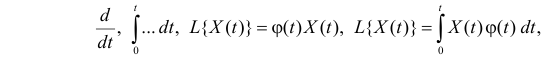

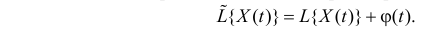

Примерами линейных операторов могут служить операторы

где  – некоторая функция.

– некоторая функция.

Оператор называют линейным неоднородным, если он состоит из линейной части с прибавлением некоторой определенной функции:

Если случайная функция X(t) с математическим ожиданием  и корреляционной функцией

и корреляционной функцией  преобразуется линейным однородным оператором L в случайную функцию

преобразуется линейным однородным оператором L в случайную функцию

то для нахождения математического ожидания  нужно применить этот оператор к

нужно применить этот оператор к  т.е.

т.е.

А для нахождения корреляционной функции  необходимо применить этот оператор к корреляционной функции

необходимо применить этот оператор к корреляционной функции  сначала по одному аргументу, а затем по другому:

сначала по одному аргументу, а затем по другому:

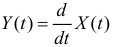

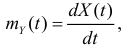

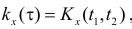

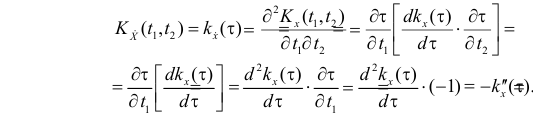

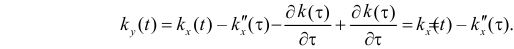

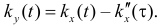

Например, если линейный оператор дифференцирования  применяется к случайному процессу X(t) с математическим ожиданием

применяется к случайному процессу X(t) с математическим ожиданием  и корреляционной функцией

и корреляционной функцией  , то для

, то для  математическое ожидание

математическое ожидание  а корреляционная функция

а корреляционная функция

Пример 4.18.

Задана  – корреляционная функция стационарного случайного процесса X(t). Требуется найти корреляционную функцию процесса

– корреляционная функция стационарного случайного процесса X(t). Требуется найти корреляционную функцию процесса

Решение. Воспользуемся формулой (4.1) для корреляционной функции суммы случайных процессов. Вычислим необходимые для этого величины.

Так как процесс X(t) стационарен, то его математическое ожидание и математическое ожидание его производной равны нулю. Поэтому

Но так как

Аналогично,

Так как  где

где  то

то  а

а  Поэтому по формуле (4.2.1)

Поэтому по формуле (4.2.1)

В итоге по формуле (4.2)

Ответ.

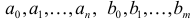

Стационарной линейной динамической системой называется устройство, которое можно описать линейным дифференциальным уравнением с постоянными коэффициентами:

где  – постоянные коэффициенты, X(t) – входящий стационарный процесс (воздействие), а Y(t) – случайный процесс на выходе из системы (отклик). Если динамическая система устойчива, то по окончании переходного периода процесс Y(t) тоже стационарен.

– постоянные коэффициенты, X(t) – входящий стационарный процесс (воздействие), а Y(t) – случайный процесс на выходе из системы (отклик). Если динамическая система устойчива, то по окончании переходного периода процесс Y(t) тоже стационарен.

Найдем характеристики Y(t) по характеристикам X(t). Возьмем математическое ожидание от правой и левой частей равенства (4.2.3).Так как X(t) и Y(t) стационарные процессы, то их математические ожидания mx и my постоянны, а производные математических ожиданий равны нулю. Поэтому

Обозначим оператор дифференцирования  через p, оператор

через p, оператор  через p2 и т.д. Тогда уравнение (4.2.3) можно записать в виде

через p2 и т.д. Тогда уравнение (4.2.3) можно записать в виде

или

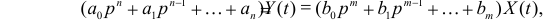

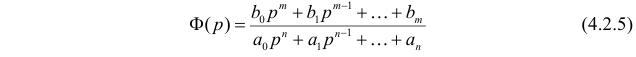

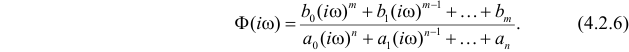

Выражение

называют передаточной функцией.

Уравнение (4.2.3) в операторной форме кратко записывается в виде

Частотной характеристикой линейной динамической системы называют функцию, которая получается заменой p на  в передаточной функции:

в передаточной функции:

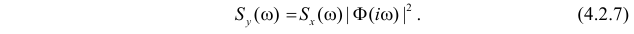

Доказано, что спектральные плотности процессов X(t) и Y(t) связаны соотношением

Это означает, что для получения спектральной плотности выходного случайного процесса необходимо умножить спектральную плотность входного процесса на квадрат модуля частотной характеристики динамической системы.

Пример 4.19.

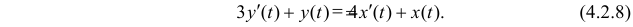

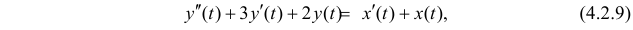

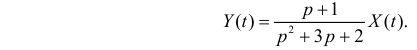

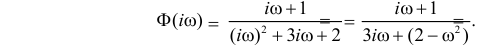

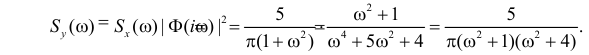

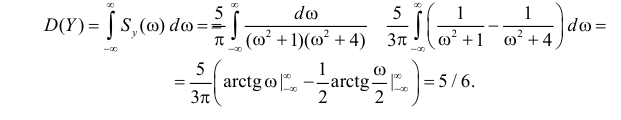

Динамическая система задана уравнением

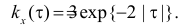

На вход системы подается стационарный случайный процесс X(t) с корреляционной функцией  Требуется найти дисперсию процесса на выходе в установившемся режиме.

Требуется найти дисперсию процесса на выходе в установившемся режиме.

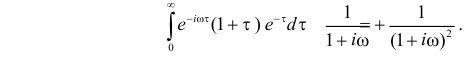

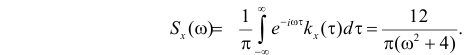

Решение. Вычислим спектральную плотность случайного процесса X(t) по формуле (4.1.12)

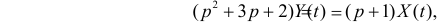

В операторной форме уравнение (4.2.8) имеет вид

Поэтому частотная характеристика  По формуле

По формуле

Поэтому

Ответ.

Пример 4.20.

На вход линейной динамической системы, описываемой уравнением

подается стационарный случайный процесс X(t) с математическим ожиданием  и корреляционной функцией

и корреляционной функцией  Требуется найти математическое ожидание и дисперсию процесса на выходе.

Требуется найти математическое ожидание и дисперсию процесса на выходе.

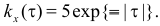

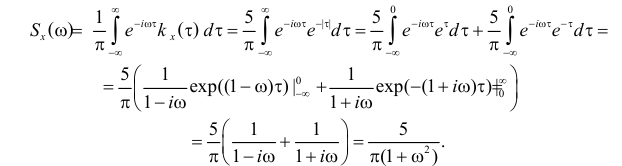

Решение. Вычислим спектральную плотность случайного процесса X(t). По формуле (4.1.12)

Обозначим оператор дифференцирования  через p, а оператор

через p, а оператор  через p2 . Тогда уравнение (4.2.9) можно записать в виде

через p2 . Тогда уравнение (4.2.9) можно записать в виде

или

Передаточная функция динамической системы имеет вид

а ее частотная характеристика

Спектральная плотность процесса на выходе системы равна, согласно (4.2.7),

Дисперсия процесса на выходе равна

Если динамическая система устойчива, то при достаточно больших значениях t (после переходного периода) функцию Y(t) можно считать стационарной. Так как X(t) и Y(t) стационарны, то математические ожидания их производных равны нулю. Поэтому переход к математическим ожиданиям в равенстве (4.2.9) дает

Ответ.

Пример 4.21.

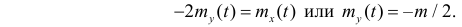

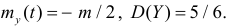

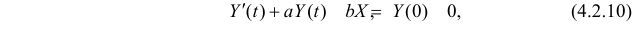

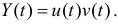

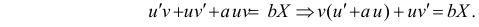

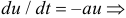

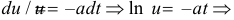

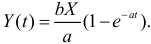

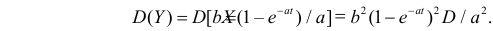

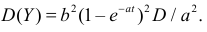

Пусть X – случайная величина с  Случайный процесс Y(t) определяется уравнением

Случайный процесс Y(t) определяется уравнением

где  – постоянные коэффициенты. Требуется найти дисперсию процесса Y(t).

– постоянные коэффициенты. Требуется найти дисперсию процесса Y(t).

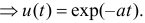

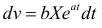

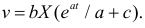

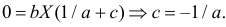

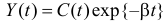

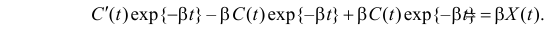

Решение. Решим линейное дифференциальное уравнение (4.2.10) методом Бернулли. Будем искать решение в виде  Тогда уравнение (4.2.10) можно переписать:

Тогда уравнение (4.2.10) можно переписать:

Подберем u(t) так, чтобы  т. е.

т. е.

При таком u(t) получаем уравнение

При таком u(t) получаем уравнение  Откуда

Откуда  или

или  В итоге получаем общее решение уравнения (4.3.2):

В итоге получаем общее решение уравнения (4.3.2):

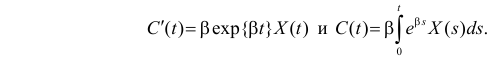

При начальных условиях  имеем

имеем  Частное решение уравнения (4.2.10) имеет вид

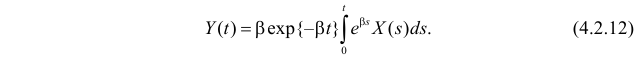

Частное решение уравнения (4.2.10) имеет вид  Поэтому

Поэтому

Ответ.

Пример 4.22.

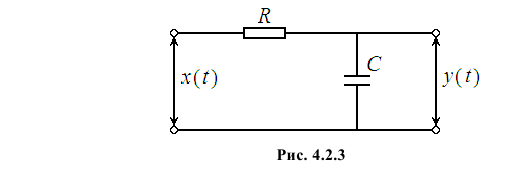

На RC – цепь, схема которой изображена на рис. 4.2.3, подается случайное напряжение X(t) с математическим ожиданием  и ковариационной функцией

и ковариационной функцией

Требуется найти математическое ожидание и дисперсию с напряжения Y(t) на выходе.

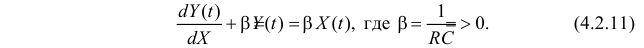

Решение. Дифференциальное уравнение, связывающее сигнал на выходе Y(t) с сигналом X(t) на входе имеет вид

Решение этого уравнения можно получить, например, методом вариации произвольной постоянной. Однородному уравнению  соответствует характеристическое уравнение

соответствует характеристическое уравнение  Поэтому решение соответствующего однородного уравнения имеет вид

Поэтому решение соответствующего однородного уравнения имеет вид  Вместо произвольной постоянной C подберем такую функцию C(t), чтобы

Вместо произвольной постоянной C подберем такую функцию C(t), чтобы  стало решением уравнения (4.2.11). Тогда при подстановке этого Y(t) в уравнение (4.2.11) получаем

стало решением уравнения (4.2.11). Тогда при подстановке этого Y(t) в уравнение (4.2.11) получаем

Откуда следует, что

Поэтому решение уравнения (4.2.11) имеет вид

Запись (4.2.12) означает, что Y(t) является результатом действия на X(t) линейного оператора:

В соответствии с (4.2.1)

По формуле (4.2.2) при

Аналогично при

Поэтому дисперсия

Ответ.

Процессы «гибели и рождения»

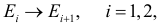

Пусть некоторый объект может в каждый момент времени может находиться в одном из состояний:  множество которых конечно или счетно. (Счетным называют множество, все элементы которого могут быть занумерованы с помощью натуральных чисел.) В случайные моменты времени возможны переходы из состояния в состояние. Особенность этих переходов состоит в том, что за бесконечно малый промежуток времени возможны переходы только в соседние состояния.

множество которых конечно или счетно. (Счетным называют множество, все элементы которого могут быть занумерованы с помощью натуральных чисел.) В случайные моменты времени возможны переходы из состояния в состояние. Особенность этих переходов состоит в том, что за бесконечно малый промежуток времени возможны переходы только в соседние состояния.

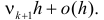

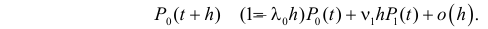

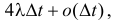

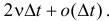

Формально это означает следующее. Если в момент времени t объект находится в состоянии  то за малый промежуток времени h объект из состояния

то за малый промежуток времени h объект из состояния  может перейти в состояние

может перейти в состояние  с вероятностью

с вероятностью  а вероятность перехода в состояние

а вероятность перехода в состояние  равна

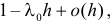

равна  Напомним, что

Напомним, что  означает величину бесконечно малую более высокого порядка малости по сравнению с h. Вероятность перехода из

означает величину бесконечно малую более высокого порядка малости по сравнению с h. Вероятность перехода из  в другие состояния за бесконечно малый промежуток времени h пренебрежимо мала

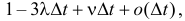

в другие состояния за бесконечно малый промежуток времени h пренебрежимо мала  Отсюда следует, что вероятность за время h сохранить состояние

Отсюда следует, что вероятность за время h сохранить состояние  равна

равна

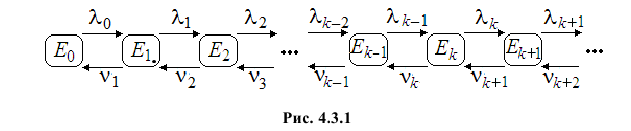

Пусть постоянные  и

и  не зависят от времени t и от способа прихода объекта в состояние

не зависят от времени t и от способа прихода объекта в состояние  . Эти предположения позволяют нарисовать следующую схему возможных переходов (см. рис. 4.3.1).

. Эти предположения позволяют нарисовать следующую схему возможных переходов (см. рис. 4.3.1).

Процесс изменения состояний объекта по приведенной схеме называется процессом гибели и рождения.

Эти процессы могут служить математической моделью для популяции живых организмов. В этом случае под состоянием  понимается наличие в популяции n особей, переход из

понимается наличие в популяции n особей, переход из  в состояние

в состояние  означает рождение нового члена популяции, а переход из

означает рождение нового члена популяции, а переход из  в состояние

в состояние  соответствует гибели одного из ее членов.

соответствует гибели одного из ее членов.

В терминах процессов гибели и размножения можно обсуждать многие технические задачи. Например, для математической модели транспортного предприятия под состоянием можно понимать число автомобилей, которые пригодны для эксплуатации. Тогда выход из стоя автомобиля означает переход в состояние с номером на единицу меньше (т.е. «гибель»), а восстановление машины после ремонта – переход в состояние с номером на единицу больше («рождение»).

Обозначим через  вероятность того, что в момент времени t объект находится в состоянии

вероятность того, что в момент времени t объект находится в состоянии  и выведем уравнения для этих вероятностей. Сначала выведем уравнение при

и выведем уравнения для этих вероятностей. Сначала выведем уравнение при  Для этого рассмотрим отрезок времени

Для этого рассмотрим отрезок времени  и учтем возможные изменения состояния объекта за малый промежуток времени h. Объект в момент времени

и учтем возможные изменения состояния объекта за малый промежуток времени h. Объект в момент времени  будет находиться в состоянии

будет находиться в состоянии  , вероятность чего равна

, вероятность чего равна  если в момент t он находился в состоянии

если в момент t он находился в состоянии  вероятность чего равна

вероятность чего равна  и за время h произошел переход в состояние

и за время h произошел переход в состояние  , вероятность чего равна

, вероятность чего равна  или в момент t он находился в состоянии

или в момент t он находился в состоянии  , вероятность чего равна

, вероятность чего равна  и за время h переходов не было, вероятность чего равна

и за время h переходов не было, вероятность чего равна  или в момент t он находился в состоянии

или в момент t он находился в состоянии  вероятность чего равна

вероятность чего равна  и за время h произошел переход в состояние

и за время h произошел переход в состояние  , вероятность чего равна

, вероятность чего равна

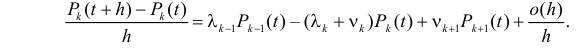

Символическая запись этой фразы имеет вид

Перенесем из правой части в левую  и разделим каждое слагаемое в равенстве на h:

и разделим каждое слагаемое в равенстве на h:

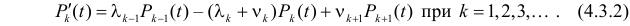

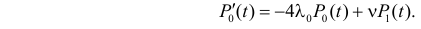

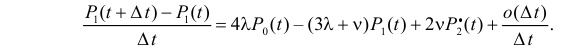

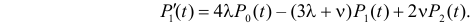

При  получаем дифференциальное уравнение

получаем дифференциальное уравнение

Уравнение для k=0 получается из следующих рассуждений. Объект в момент времени  будет находиться в состоянии Е0, вероятность чего равна

будет находиться в состоянии Е0, вероятность чего равна  если в момент t он находился в состоянии Е0, вероятность чего равна

если в момент t он находился в состоянии Е0, вероятность чего равна  и за время h переходов не было, вероятность чего равна

и за время h переходов не было, вероятность чего равна  или в момент t он находился в состоянии Е1, вероятность чего равна

или в момент t он находился в состоянии Е1, вероятность чего равна  и за время h произошел переход в состояние Е0, вероятность чего равна

и за время h произошел переход в состояние Е0, вероятность чего равна  Символически эта фраза может быть записана в виде

Символически эта фраза может быть записана в виде

Перенос слагаемого  в левую часть, деление правой и левой частей равенства на h, предельный переход при

в левую часть, деление правой и левой частей равенства на h, предельный переход при приводят к дифференциальному уравнению

приводят к дифференциальному уравнению

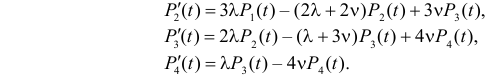

Уравнения (4.3.2) и (4.3.3) называют системой уравнений гибели и рождения. В общем виде решение этой системы получить сложно, но в отдельных частных случаях это вполне обозримая работа.

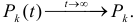

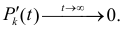

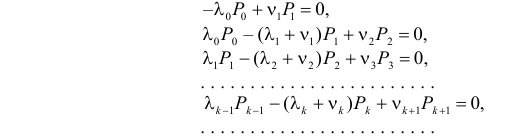

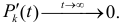

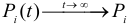

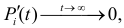

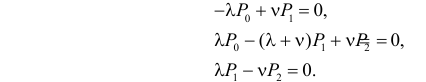

Обычно с течением времени влияние начального состояния иссякает и процесс входит в стационарный режим, при котором переходы из состояния в состояние продолжаются, но сами вероятности состояний стабилизируются и перестают зависеть от времени (от начального состояния), т.е.  Но при этом

Но при этом  В результате система дифференциальных уравнений (4.3.2) и (4.3.3) превращается в систему однородных линейных алгебраических уравнений

В результате система дифференциальных уравнений (4.3.2) и (4.3.3) превращается в систему однородных линейных алгебраических уравнений

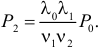

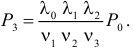

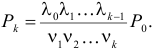

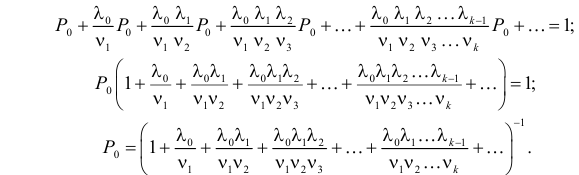

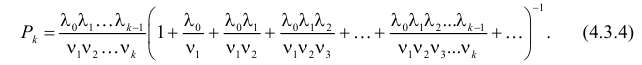

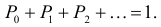

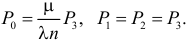

Выбрать единственное решение системы позволяет условие нормировки  Для этого выразим все вероятности, например, через

Для этого выразим все вероятности, например, через  Из первого уравнения

Из первого уравнения  С учетом этого, из второго уравнения получаем

С учетом этого, из второго уравнения получаем

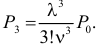

Третье уравнение дает равенство  Продолжая подобные действия, найдем, что

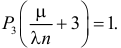

Продолжая подобные действия, найдем, что  Тогда по условию нормировки

Тогда по условию нормировки  .

.

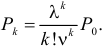

В итоге получаем, что

Замечание. Если ряд в знаменателе (4.3.4) расходится, то все  Это означает «взрыв» численности, т.е. за конечное время произойдем бесконечно много рождений. Сходимость ряда

Это означает «взрыв» численности, т.е. за конечное время произойдем бесконечно много рождений. Сходимость ряда  является достаточным условием существования ненулевых вероятностей

является достаточным условием существования ненулевых вероятностей  Для сходимости ряда по признаку Даламбера требуется, чтобы

Для сходимости ряда по признаку Даламбера требуется, чтобы

т.е. начиная с некоторого номера n интенсивность гибели должна превосходить интенсивность рождений.

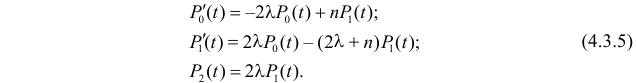

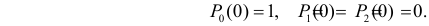

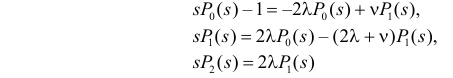

Пример 4.23.

Система состоит из основного блока, одного блока в «горячем» резерве (т.е. работающего одновременно с основным) и одного блока в «холодном» резерве (т.е. этот резервный блок не работает). Длительность безотказной работы работающего блока распределена по показательному закону с параметром  Вышедший из строя блок практически мгновенно заменяется блоком из холодного резерва, а вышедший из строя блок незамедлительно начинают ремонтировать. Время ремонта распределено по показательному закону с параметром n. Система прекращает свою работу, как только остается всего один работоспособный элемент. Требуется найти вероятность того, что система выйдет из строя до момента времени t.

Вышедший из строя блок практически мгновенно заменяется блоком из холодного резерва, а вышедший из строя блок незамедлительно начинают ремонтировать. Время ремонта распределено по показательному закону с параметром n. Система прекращает свою работу, как только остается всего один работоспособный элемент. Требуется найти вероятность того, что система выйдет из строя до момента времени t.

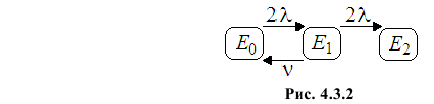

Решение. 1. Состояния системы будем различать по числу вышедших из строя блоков. Обозначим через  – состояние, в котором

– состояние, в котором  блоков вышли из строя. Тогда граф состояний системы имеет вид, изображенный на рис. 4.3.2.

блоков вышли из строя. Тогда граф состояний системы имеет вид, изображенный на рис. 4.3.2.

Происходит переход  если один из двух работающих блоков выходит из строя. Интенсивность таких переходов равна

если один из двух работающих блоков выходит из строя. Интенсивность таких переходов равна  При окончании ремонта происходит переход

При окончании ремонта происходит переход  с интенсивностью n. Состояние E2 является «поглощающим» – если система попала в него, то она это состояние не покинет.

с интенсивностью n. Состояние E2 является «поглощающим» – если система попала в него, то она это состояние не покинет.

2. Обозначим через  вероятность того, что в момент времени t система будет находиться в состоянии

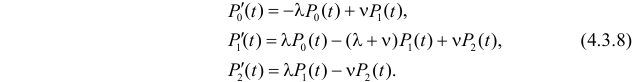

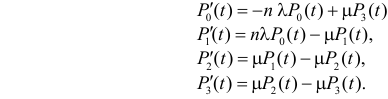

вероятность того, что в момент времени t система будет находиться в состоянии  . Нас интересует – вероятность того, что в момент времени t система уже вышла из строя. Выход из строя можно считать «рождением» неполадки, а ее устранение – «гибелью». Система уравнений гибели и размножения (4.3.2) и (4.3.3) в нашем случае имеет вид:

. Нас интересует – вероятность того, что в момент времени t система уже вышла из строя. Выход из строя можно считать «рождением» неполадки, а ее устранение – «гибелью». Система уравнений гибели и размножения (4.3.2) и (4.3.3) в нашем случае имеет вид:

Любое из уравнений системы можно заменить условием нормировки

Пусть система начинает свою работу из состояния E1, т.е. имеет начальные условия:

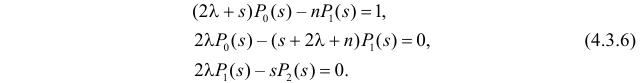

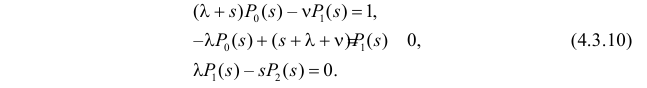

3. Перейдем в системе (4.3.5) к преобразованиям Лапласа:

или

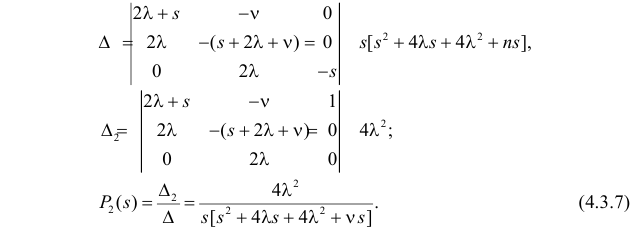

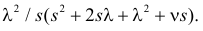

Решение системы (4.3.6), например, по формулам Крамера дает:

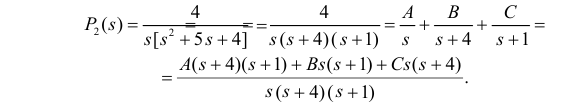

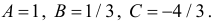

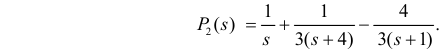

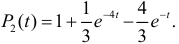

Остается найти обратное преобразование от  Например, при

Например, при  и

и  выражение (4.3.7) принимает вид

выражение (4.3.7) принимает вид

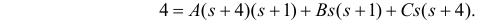

(Здесь мы пользуемся методом неопределенных коэффициентов для разложения на простые дроби). Имея две равные дроби с равными знаменателями, приравниваем числители этих дробей

Приравнивая в правой и левой частях равенства коэффициенты при равных степенях  получим

получим  В итоге имеем

В итоге имеем

Обращение преобразования Лапласа дает искомую вероятность

Ответ.

Пример 4.24.

На контактном многоканальном телефоне фирмы работает четыре оператора. Каждый свободный оператор независимо от других на интервале времени  может с вероятностью

может с вероятностью  начать отвечать на звонок. Оператор, отвечающий на звонок, с вероятностью

начать отвечать на звонок. Оператор, отвечающий на звонок, с вероятностью  на интервале времени

на интервале времени  может завершить ответ и освободиться. Требуется найти предельные вероятности того, что будут заняты k операторов.

может завершить ответ и освободиться. Требуется найти предельные вероятности того, что будут заняты k операторов.

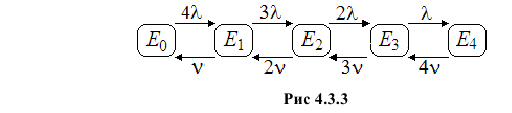

Решение. Состояния контактного телефона будем различать по числу занятых операторов. Пусть Ek – означает, что заняты k из них. Тогда граф состояний имеет вид, изображенный на рис. 4.3.3.

Составим уравнения для вероятностей  Сопоставим значения этих вероятностей в моменты времени

Сопоставим значения этих вероятностей в моменты времени

Перенос слагаемого  в левую часть, деление правой и левой частей равенства на

в левую часть, деление правой и левой частей равенства на  , предельный переход при

, предельный переход при  приводят к дифференциальному уравнению

приводят к дифференциальному уравнению

На контактном телефоне в момент времени  будет занят один оператор, вероятность чего равна

будет занят один оператор, вероятность чего равна  если в момент t все операторы были свободны, вероятность чего равна

если в момент t все операторы были свободны, вероятность чего равна  и за время

и за время  один из операторов включился в работу, вероятность чего равна

один из операторов включился в работу, вероятность чего равна  или в момент t был занят только один оператор, вероятность чего равна

или в момент t был занят только один оператор, вероятность чего равна  и за время

и за время  переходов не было, вероятность чего равна

переходов не было, вероятность чего равна  или в момент t были заняты два оператора, вероятность чего равна

или в момент t были заняты два оператора, вероятность чего равна  и за время

и за время  один из операторов освободился

один из операторов освободился

Символическая запись этой фразы имеет вид

Перенесем из правой части в левую  и разделим каждое слагаемое в равенстве на

и разделим каждое слагаемое в равенстве на  :

:

При  получаем дифференциальное уравнение

получаем дифференциальное уравнение

Аналогично выводятся уравнения

С течением времени вероятности состояний стабилизируются и перестают зависеть от времени (от начального состояния), т.е.

Но при этом  В результате система дифференциальных уравнений превращается в систему однородных линейных алгебраических уравнений

В результате система дифференциальных уравнений превращается в систему однородных линейных алгебраических уравнений

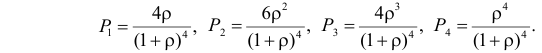

Выбрать единственное решение системы позволяет условие нормировки  Для этого выразим все вероятности, например, через Р0. Из первого уравнения

Для этого выразим все вероятности, например, через Р0. Из первого уравнения  С учетом этого, из второго уравнения получаем

С учетом этого, из второго уравнения получаем

Третье уравнение дает равенство  Продолжая подобные действия, найдем, что

Продолжая подобные действия, найдем, что  Тогда по условию нормировки

Тогда по условию нормировки

Обозначим  через

через  Тогда

Тогда

Откуда

Ответ.

Пример 4.25.

Система массового обслуживания состоит из двух обслуживающих устройств. В систему поступает простейший поток требований на обслуживание интенсивности  Времена обслуживания требований независимы и имеют показательный закон распределения с параметром

Времена обслуживания требований независимы и имеют показательный закон распределения с параметром  (

( – интенсивность обслуживания). Требование, заставшее все устройства занятыми, может встать в очередь или покинуть систему. Вероятность присоединения к очереди пропорциональна числу обслуживающих устройств и обратно пропорциональна числу требований в системе плюс один. Это означает, что интенсивность перехода

– интенсивность обслуживания). Требование, заставшее все устройства занятыми, может встать в очередь или покинуть систему. Вероятность присоединения к очереди пропорциональна числу обслуживающих устройств и обратно пропорциональна числу требований в системе плюс один. Это означает, что интенсивность перехода  равна

равна  Требуется найти стационарные вероятности числа требований в системе.

Требуется найти стационарные вероятности числа требований в системе.

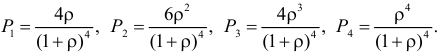

Решение. Обозначим через Ek – состояние системы, когда в ней находятся k требований. Если в системе находится  требований (два требования обслуживаются и

требований (два требования обслуживаются и  ожидают в очереди), то вероятность присоединения к очереди по условию задачи равна

ожидают в очереди), то вероятность присоединения к очереди по условию задачи равна  Это означает, что интенсивность перехода

Это означает, что интенсивность перехода  равна

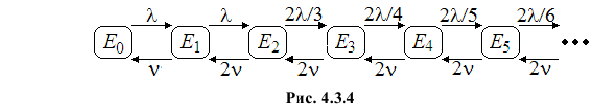

равна  Граф состояний системы изображен на рис. 4.3.4

Граф состояний системы изображен на рис. 4.3.4

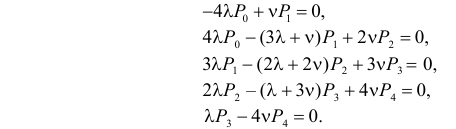

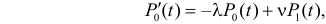

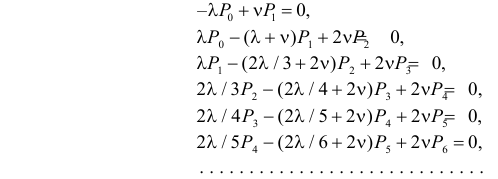

Составим систему уравнений гибели и размножения

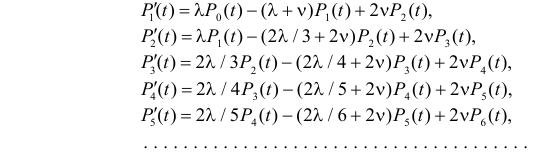

Для стационарного режима  получаем систему однородных линейных алгебраических уравнений

получаем систему однородных линейных алгебраических уравнений

Эту систему естественно дополнить условием нормировки  Из первого уравнения получаем, что

Из первого уравнения получаем, что  Подставляя этот результат во второе уравнение, находим

Подставляя этот результат во второе уравнение, находим  Из третьего уравнения, с учетом полученных для P1 и Р2 выражений, имеем

Из третьего уравнения, с учетом полученных для P1 и Р2 выражений, имеем  Продолжая действовать подобным образом, получим

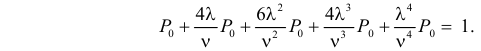

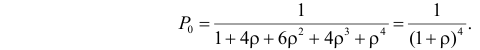

Продолжая действовать подобным образом, получим  Обозначим

Обозначим  через

через  Воспользуемся условием нормировки:

Воспользуемся условием нормировки:

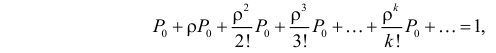

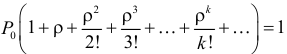

откуда  или

или  В итоге

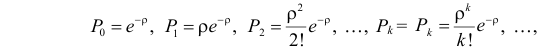

В итоге

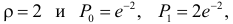

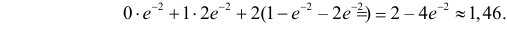

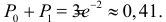

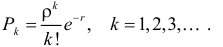

где  т.е. стационарное распределение оказалось распределением Пуассона. Используя найденные стационарные вероятности можно вычислить разные характеристики системы. Например, при

т.е. стационарное распределение оказалось распределением Пуассона. Используя найденные стационарные вероятности можно вычислить разные характеристики системы. Например, при  и

и  вычислим среднее число занятых обслуживающих устройств. Поскольку

вычислим среднее число занятых обслуживающих устройств. Поскольку  то математическое ожидание числа занятых приборов равно

то математическое ожидание числа занятых приборов равно

Вероятность того, что требование поступит на обслуживание без ожидания в очереди, равна  Вероятность наличия очереди в системе равна

Вероятность наличия очереди в системе равна

Ответ.

Пример 4.26.

Система массового обслуживания состоит из одного обслуживающего прибора и одного прибора в холодном резерве. Интенсивность выхода из строя работающего прибора равна  При выходе из строя работающего прибора его практически мгновенно заменяют резервным, а вышедший из строя прибор начинают ремонтировать. Вышедшие из строя приборы ремонтируются с интенсивностью n в порядке очереди. После отказа устройства ремонт продолжается с прежней интенсивностью. При наличии в системе годного к работе прибора система возобновляет свою работу.

При выходе из строя работающего прибора его практически мгновенно заменяют резервным, а вышедший из строя прибор начинают ремонтировать. Вышедшие из строя приборы ремонтируются с интенсивностью n в порядке очереди. После отказа устройства ремонт продолжается с прежней интенсивностью. При наличии в системе годного к работе прибора система возобновляет свою работу.

Требуется найти долю времени простоя системы из-за выхода из строя приборов. Найти наработку на отказ, т.е. среднее время работы системы между пребываниями в отказных состояниях.

Решение. Состояния системы будем различать по числу вышедших из строя приборов. Обозначим через  состояние системы, в котором

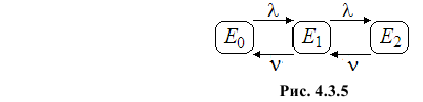

состояние системы, в котором  элементов системы находятся в нерабочем состоянии. Тогда состояние E2 можно назвать отказным состоянием, поскольку оба элемента вышли из строя. Граф состояний системы изображен на рис. 4.3.5.

элементов системы находятся в нерабочем состоянии. Тогда состояние E2 можно назвать отказным состоянием, поскольку оба элемента вышли из строя. Граф состояний системы изображен на рис. 4.3.5.

Если считать выход из строя прибора рождением неполадки, а завершение ремонта ее гибелью, то система уравнений гибели и размножения по формулам (4.3.2), (4.3.3) для нашего случая принимает вид

Это система линейных однородных дифференциальных уравнений с постоянными коэффициентами. Любое уравнение системы можно заменить условием нормировки:

С учетом того, что  и при этом

и при этом  для стационарных вероятностей состояний получаем систему однородных линейных алгебраических уравнений

для стационарных вероятностей состояний получаем систему однородных линейных алгебраических уравнений

Эта система имеет бесконечно много решений. Для выбора приемлемого для нас решения одно из уравнений, например, второе заменим условием нормировки

Из первого уравнения имеем  а из третьего уравнения

а из третьего уравнения  Тогда по условию нормировки

Тогда по условию нормировки  откуда

откуда

где  Тогда

Тогда

Стационарную вероятность P2 можно понимать как долю времени, в течение которой система находится в нерабочем состоянии (оба прибора вышли из строя).

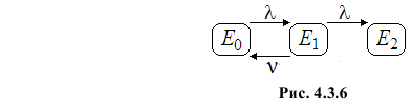

Для вычисления наработки на отказ сделаем состояние E2 поглощающим, т.е. исключим переход  Тогда граф состояний будет иметь вид, изображенный на рис. 4.3.6.

Тогда граф состояний будет иметь вид, изображенный на рис. 4.3.6.

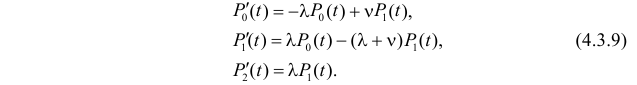

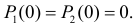

Этому графу состояний соответствует система уравнений

Зададим начальное состояние. Пусть, например,

Обозначим через

Обозначим через  преобразование Лапласа от

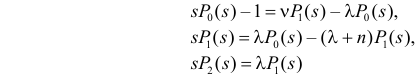

преобразование Лапласа от  и запишем систему (4.3.9) в преобразованиях Лапласа:

и запишем систему (4.3.9) в преобразованиях Лапласа:

или

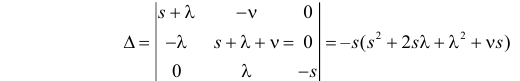

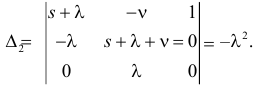

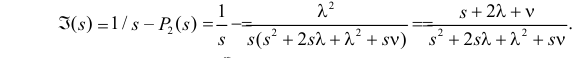

Найдем  например, по правилу Крамера. Вычислим определитель системы (4.3.10):

например, по правилу Крамера. Вычислим определитель системы (4.3.10):

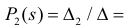

и  Поэтому

Поэтому

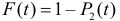

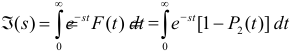

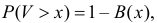

Обозначим через  – вероятность безотказной работы системы до момента t, а через

– вероятность безотказной работы системы до момента t, а через  – ее преобразование Лапласа. Тогда

– ее преобразование Лапласа. Тогда

Заметим, что  где T – время достижения отказного состояния, т.е. время безотказной работы системы.

где T – время достижения отказного состояния, т.е. время безотказной работы системы.

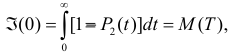

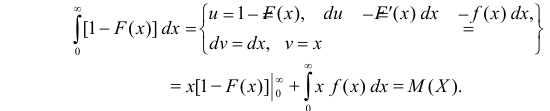

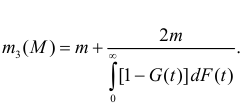

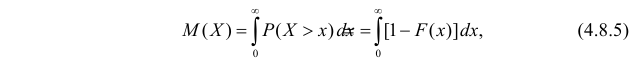

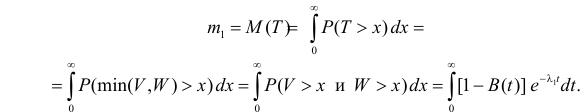

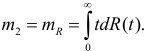

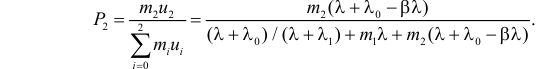

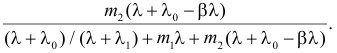

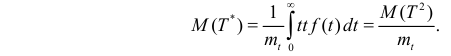

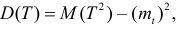

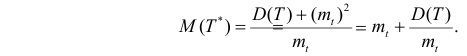

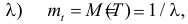

Последний вывод основан на следующих соображениях. Пусть X – неотрицательная случайная величина с функцией распределения  Интегрируя по частям, вычислим

Интегрируя по частям, вычислим

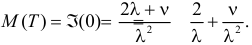

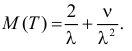

В нашем случае  Первое слагаемое равно наработке на отказ за счет холодного резервирования, второе слагаемое возникло за счет ремонта.

Первое слагаемое равно наработке на отказ за счет холодного резервирования, второе слагаемое возникло за счет ремонта.

Ответ.

Рассмотрим систему массового обслуживания, в которую поступает простейший поток требований интенсивности  Время обслуживания распределено показательно с параметром

Время обслуживания распределено показательно с параметром  Каждое требование при поступлении в систему начинает обслуживаться немедленно, если есть хотя бы один свободный прибор. Если требование застает все n приборов обслуживания занятыми, то оно получает отказ и теряется. Такую систему называют системой с потерями. Примером такой системы может служить телефонный узел.

Каждое требование при поступлении в систему начинает обслуживаться немедленно, если есть хотя бы один свободный прибор. Если требование застает все n приборов обслуживания занятыми, то оно получает отказ и теряется. Такую систему называют системой с потерями. Примером такой системы может служить телефонный узел.

Замечание. Пусть время обслуживания имеет показательное распределение с функцией распределения  и пусть обслуживание уже продолжалось время

и пусть обслуживание уже продолжалось время  Из характеристического свойства показательного распределения следует, что оставшаяся часть времени обслуживания имеет то же самое распределение. Поэтому вероятность того, что обслуживание завершится за последующее время

Из характеристического свойства показательного распределения следует, что оставшаяся часть времени обслуживания имеет то же самое распределение. Поэтому вероятность того, что обслуживание завершится за последующее время  равна

равна

Под состоянием  можно полагать то состояние системы, при котором в ней находится (обслуживается) k требований. Тогда система может находиться только в состояниях

можно полагать то состояние системы, при котором в ней находится (обслуживается) k требований. Тогда система может находиться только в состояниях  Вероятность перехода из состояния

Вероятность перехода из состояния  в состояние

в состояние  при

при  равна

равна  Если в системе находится k требований, то интенсивность обслуживания равна kn и вероятность перехода из

Если в системе находится k требований, то интенсивность обслуживания равна kn и вероятность перехода из  в

в  за малое время

за малое время  равна

равна  Мы имеем дело с процессом гибели и размножения, для которого

Мы имеем дело с процессом гибели и размножения, для которого  при

при  и

и  при

при  при

при  и

и  при

при  Если ввести обозначение

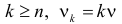

Если ввести обозначение  то формула (4.3.4) дает вероятности состояний системы при

то формула (4.3.4) дает вероятности состояний системы при

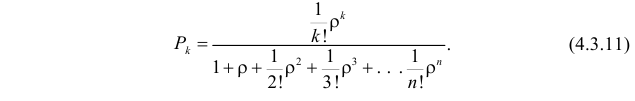

Формулы (4.3.11) называют формулами Эрланга, который их впервые вывел в 1917 г. В последующем оказалось, что для систем с потерями формулы Эрланга сохраняют свою структуру при любом распределении длительности обслуживания, лишь бы среднее время обслуживания равнялось

При  формула (4.3.11) дает вероятность того, что все приборы заняты обслуживанием и, следовательно, поступившее в такой момент требование получит отказ. Поэтому вероятность потери требования равна

формула (4.3.11) дает вероятность того, что все приборы заняты обслуживанием и, следовательно, поступившее в такой момент требование получит отказ. Поэтому вероятность потери требования равна

Пример 4.27.

В систему массового обслуживания, состоящую из четырех каналов обслуживания, поступает простейший поток требований интенсивности  Времена обслуживания требований независимы и каждое имеет распределение с функцией плотности вероятности

Времена обслуживания требований независимы и каждое имеет распределение с функцией плотности вероятности

Требование, заставшее все каналы обслуживания занятыми, теряется. Необходимо найти вероятность потери требования и среднее число занятых обслуживанием каналов.

Решение. Пусть V – время обслуживания требования. Вычислим среднее время обслуживания

В формулах Эрланга  . Заменяя

. Заменяя  на

на  получаем

получаем  По формуле (4.3.11) имеем:

По формуле (4.3.11) имеем:

и

и  . Вероятность застать все каналы занятыми равна

. Вероятность застать все каналы занятыми равна  Это и есть вероятность потери требования.

Это и есть вероятность потери требования.

Среднее число занятых каналов равно

Ответ.

Пример 4.28.

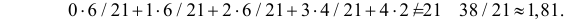

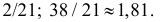

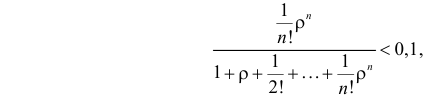

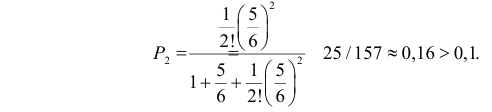

На многоканальный контактный телефон фирмы поступает простейший поток звонков интенсивности пять звонков в час. Время разговора с каждым клиентом в среднем занимает 10 минут. Звонки, заставшие все каналы занятыми, теряются. Сколько должно быть каналов для того, чтобы терялось не более 10% звонков?

Решение. Формулы Эрланга сохраняют свою структуру при любом распределении времени обслуживания и зависят только от среднего значения длительности обслуживания. В нашем случае  среднее время обслуживания равно 1/6 ч. Поэтому

среднее время обслуживания равно 1/6 ч. Поэтому  Явно решить неравенство

Явно решить неравенство

даже при известном значении  , едва ли возможно. Поэтому естественно найти n простым перебором его значений. Начнем с n=2. По формуле (4.3.12) при n=2

, едва ли возможно. Поэтому естественно найти n простым перебором его значений. Начнем с n=2. По формуле (4.3.12) при n=2

По той же формуле при n=3

Вычисления показали, что при двух каналах теряется около 16% звонков, а уже при трех каналах потери составят около 5% звонков.

Ответ. Достаточно трех каналов.

Метод фаз Эрланга

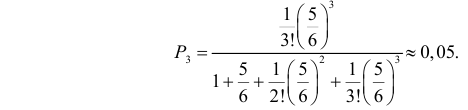

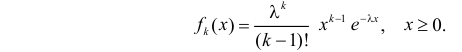

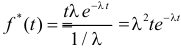

Случайная величина X имеет распределение Эрланга порядка k с параметром  , если ее функция плотности вероятности имеет вид

, если ее функция плотности вероятности имеет вид

На рис. 4.4.1 приведены графики распределения Эрланга при значении параметра  и разных значениях k.

и разных значениях k.

При k=1 получается плотность показательного распределения.

Метод фаз Эрланга применяется тогда, когда наряду с показательными распределениями в стохастической системе встречаются распределения Эрланга.

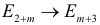

Математическое описание такой системы возможно с помощью Марковского процесса. Эта возможность основана на том, что случайную величину, имеющую распределение Эрланга порядка k с параметром  , можно представить в виде суммы k независимых показательно распределенных случайных величин с параметром

, можно представить в виде суммы k независимых показательно распределенных случайных величин с параметром  . Например, длительность обслуживания, имеющую распределение Эрланга порядка k, можно считать состоящей из k независимых «фаз», каждая из которых имеет одно и то же показательное распределение.

. Например, длительность обслуживания, имеющую распределение Эрланга порядка k, можно считать состоящей из k независимых «фаз», каждая из которых имеет одно и то же показательное распределение.

Оказывается, что многие функции распределения допускают хорошую аппроксимацию с помощью линейной комбинации функций распределения Эрланга.

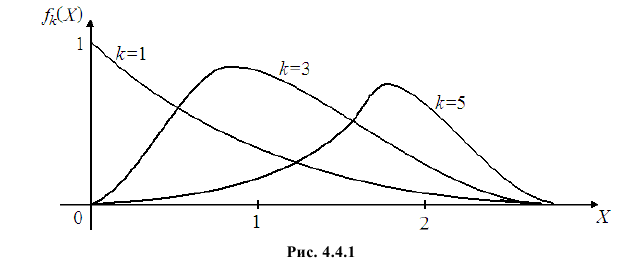

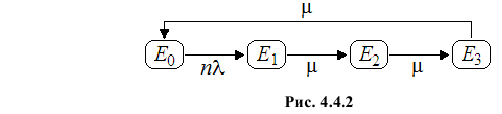

Пример 4.29 (система Энгсета с потерями)

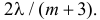

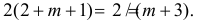

Система обслуживания состоит из одного прибора. Из n независимых источников поступают требования. Время обслуживания любого требования имеет распределение Эрланга 3-го порядка с параметром  Из каждого источника поступает на обслуживание простейший поток заявок, интенсивности

Из каждого источника поступает на обслуживание простейший поток заявок, интенсивности  . Интервалы между приходами требований из данного источника назовем паузами. Если требование застает прибор свободным, то начинает сразу обслуживаться. Пока происходит это обслуживание, из данного источника новых требований не поступает. После завершения обслуживания начинается отсчет новой паузы на данном источнике. Требуется найти долю времени, в течение которой прибор будет занят.

. Интервалы между приходами требований из данного источника назовем паузами. Если требование застает прибор свободным, то начинает сразу обслуживаться. Пока происходит это обслуживание, из данного источника новых требований не поступает. После завершения обслуживания начинается отсчет новой паузы на данном источнике. Требуется найти долю времени, в течение которой прибор будет занят.

Решение. Выделим состояния системы:  – прибор свободен;

– прибор свободен;  – прибор занят

– прибор занят  -й фазой обслуживания. Граф состояний системы изображен на рис. 4.4.2.

-й фазой обслуживания. Граф состояний системы изображен на рис. 4.4.2.

Для вероятностей состояний системы в момент времени t можно составить систему уравнений:

Тогда для стационарных вероятностей  получаем систему

получаем систему

из которой  Из условия нормировки

Из условия нормировки  Поэтому

Поэтому  Вероятность того, что система занята равна

Вероятность того, что система занята равна

Ответ.

Марковские процессы с дискретным множеством состояний

Цепи Маркова:

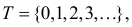

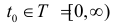

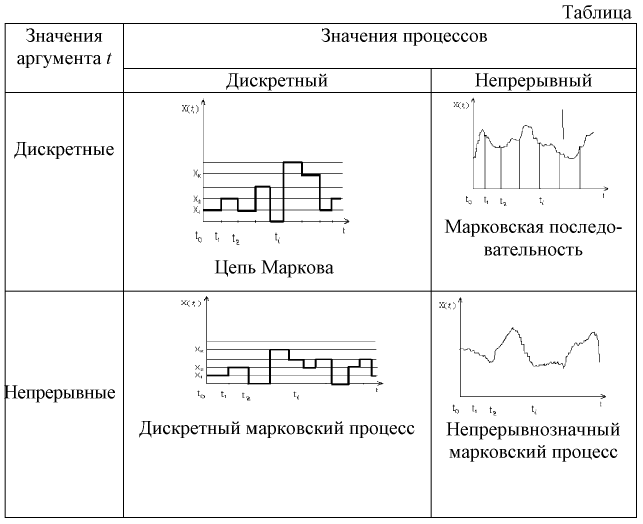

Случайным процессом  называется семейство случайных величин X(t), зависящих от параметра t, который пробегает некоторое множество значений T. Предполагается, что все эти случайные величины определены на одном и том же вероятностном пространстве

называется семейство случайных величин X(t), зависящих от параметра t, который пробегает некоторое множество значений T. Предполагается, что все эти случайные величины определены на одном и том же вероятностном пространстве  и принимают действительные значения. Множество значений будем называть пространством состояний, а под параметром t будем понимать время. Так что величина X(t) указывает состояние системы в момент времени t. Множество значений t может быть дискретным

и принимают действительные значения. Множество значений будем называть пространством состояний, а под параметром t будем понимать время. Так что величина X(t) указывает состояние системы в момент времени t. Множество значений t может быть дискретным  или непрерывным

или непрерывным  Иногда вместо X(t) будем использовать обозначение Xt .

Иногда вместо X(t) будем использовать обозначение Xt .

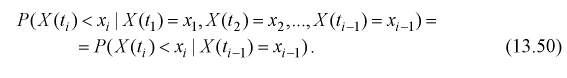

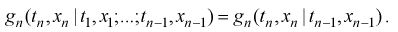

Определение. Случайный процесс Xt называется марковским, если для любого момента времени  развитие процесса в последующие моменты времени (при

развитие процесса в последующие моменты времени (при  ) зависит только от состояния процесса в момент времени t0 и не зависит от того, когда и как процесс пришел в это состояние.

) зависит только от состояния процесса в момент времени t0 и не зависит от того, когда и как процесс пришел в это состояние.

Пусть некоторый физический объект в каждый момент времени может находиться в одном из своих возможных состояний, число которых конечно или счетное. В этом случае иногда говорят о дискретном множестве состояний. Состояния могут быть качественными и описываться словами, или количественными и характеризоваться некоторыми числами. Представление о множестве состояний и о структуре переходов из состояния в состояние дает схема, которая называется графом состояний. Будем стрелками обозначать возможные переходы, а через  – возможные состояния.

– возможные состояния.

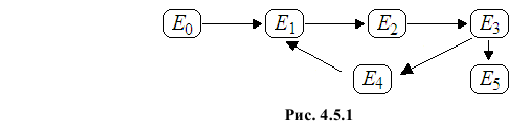

Например, в графе состояний (рис. 4.5.1) E0 означает, что устройство новое и не включено в работу, E1 – устройство работает, E2 – устройство неисправно, E3 – происходит поиск причин неисправности, E4 – производится ремонт, E5 – устройство признано не подлежащим ремонту и утилизировано. Если ремонт удался, то происходит переход в состояние E1.

Взаимное расположение состояний в графе позволяет их классифицировать следующим образом:

- Состояние называется источником, если объект может выйти их него, но попасть вновь в него не может (в приведенном примере состояние E0).

- Состояние называется поглощающим (или концевым), если в него можно войти, но из него выйти нельзя (в приведенном примере состояние E5).

- Состояние Ei называется соседним к состоянию Ej , если возможен непосредственный переход из состояния Ej в состояние Ei . В приведенном примере E3 соседнее состояние по отношению к E2, но E2 не соседнее состояние по отношению к E3.

- Подмножество состояний называется эргодическим (или связным), если из каждого состояния этого подмножества можно попасть в любое другое состояние этого подмножества.

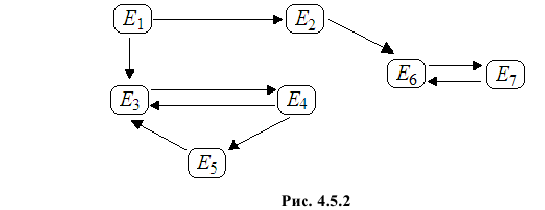

Например, в графе (см. рис. 4.5.2)два эргодических подмножества состояний:  и

и

Случайный процесс изменения состояний объекта можно понимать как процесс блуждания по множеству состояний графа.

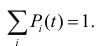

С точки зрения описания объекта первостепенный интерес представляют вероятности состояний этого объекта. Обозначим через  – вероятность того, что в момент времени t объект находится в состоянии Ei . Очевидно, что

– вероятность того, что в момент времени t объект находится в состоянии Ei . Очевидно, что

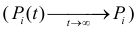

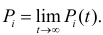

Часто интерес представляет лишь установившийся режим работы (или стационарный режим), в который объект входит после достаточно долгого времени работы. При стационарном режиме процесс перехода из состояния в состояние продолжается, но вероятности состояний не изменяются. Обозначим эти вероятности через Pi . Так что

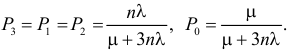

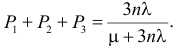

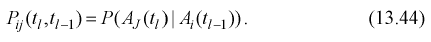

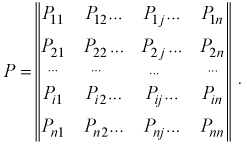

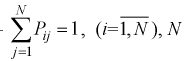

Величину Pi можно понимать как среднюю долю времени, в течение которой объект находится в состоянии Ei. В общем случае  зависят от всей предыстории переходов из состояния в состояние до момента времени t. Это чрезвычайно усложняет математическую модель такого процесса. В математическом плане наиболее просты марковские процессы, не обладающие «памятью» о прошлом.