Наличие технических ошибок на сайте может негативно сказаться на его ранжировании, что в свою очередь приведет к снижению поискового трафика и позиций в поисковых системах. Чтобы выявить технические ошибки, необходимо провести комплексный технический SEO-аудит сайта. Одним из основных помощников в этой сложной и трудозатратной задаче для нас выступает десктопная программа Screaming Frog.

О Screaming Frog

Screaming Frog – это софт для сканирования сайта, ключевыми функциями которого являются:

-

поиск битых ссылок;

-

поиск ссылок с редиректом;

-

поиск дублей страниц;

-

анализ изображений;

-

поиск страниц, где отсутствуют мета-теги или основной заголовок h1;

-

извлечение элементов со страниц сайта;

-

поиск пустых страниц или неинформативных страниц, где крайне мало контента.

С помощью данной программы можно проанализировать страницы, которые закрыты в файле robots.txt, проверить наличие и корректность заполнения тегов alt у изображений, а также наличие атрибута Canonical и многое другое.

Screaming Frog может просканировать весь сайт полностью, либо же определенный каталог, либо заданный вручную список страниц. Чтобы не создавать сильную нагрузку на сервер, можно в любой момент остановить сканирование.

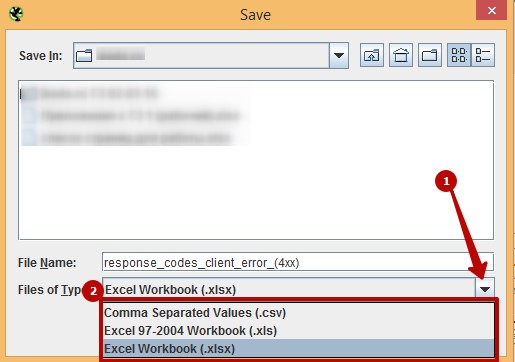

Важным плюсом является то, что результат сканирования можно выгрузить в формате csv или xlsx. Но есть и некоторые минусы:

-

сложный и интуитивно непонятный интерфейс для новых пользователей;

-

данные хранятся в оперативной памяти вашего ПК, в связи чем довольно проблематично полностью сканировать объемный сайт. А также при работе с софтом работа ПК может замедлиться;

-

программа платная (но есть бесплатная версия с ограничениями).

А теперь подробнее.

Поиск битых ссылок

Мы намеренно перескочили через тему «Настройка Screaming Frog», так как в сети присутствует большое количество мануалов по настройке программы, описаний интерфейса и вводной информации о том, как работать с программой и сканировать сайт. Переходим сразу к техническому анализу сайта.

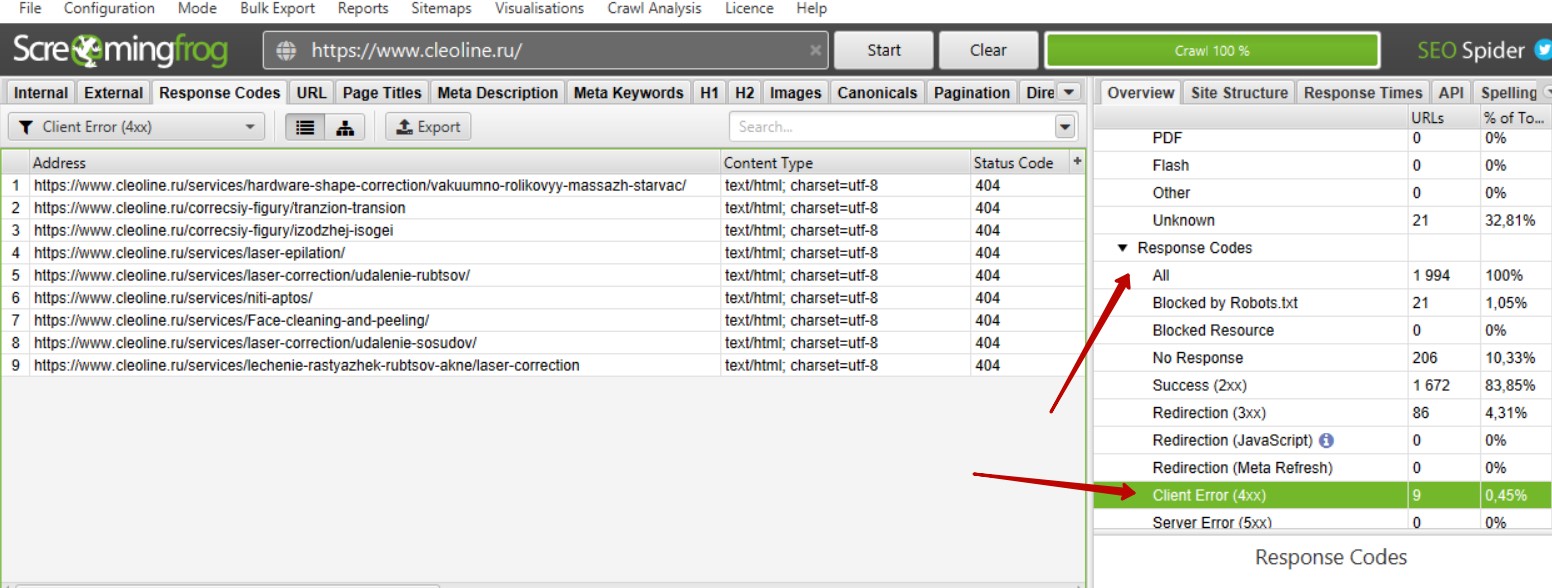

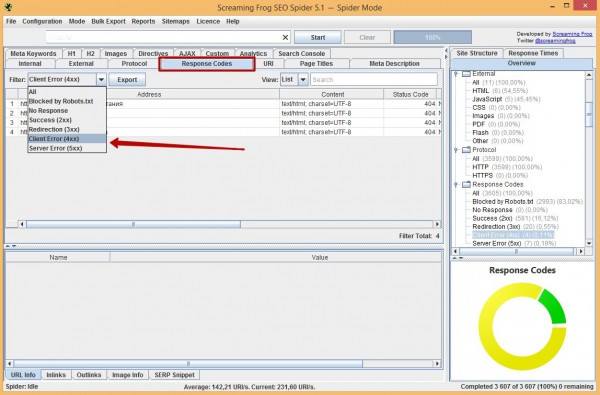

Итак, мы просканировали сайт. Для поиска битых ссылок необходимо справа найти вкладку «Response Code» — «Client Error (4xx)». Теперь мы видим список битых ссылок при их наличии на сайте.

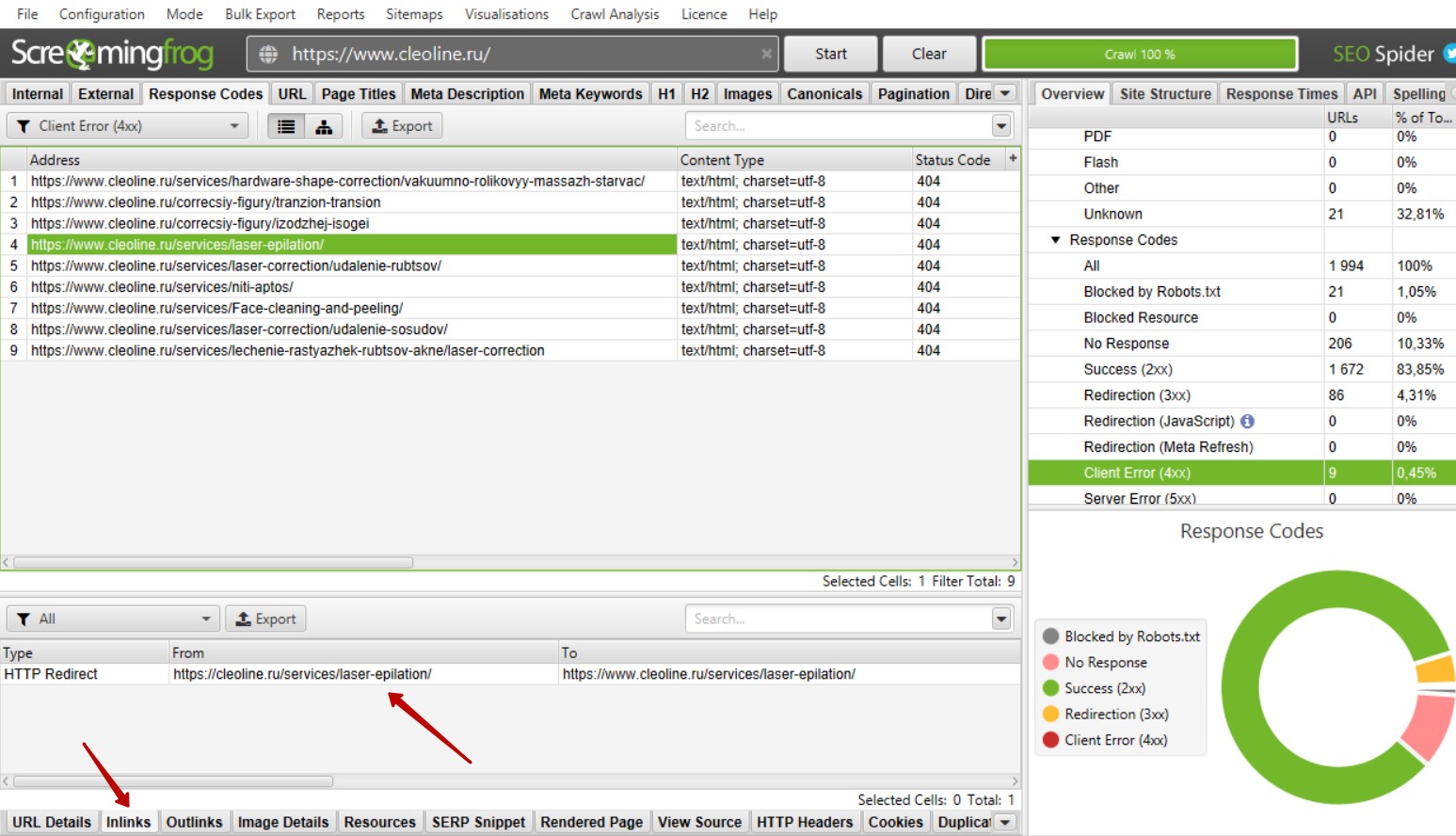

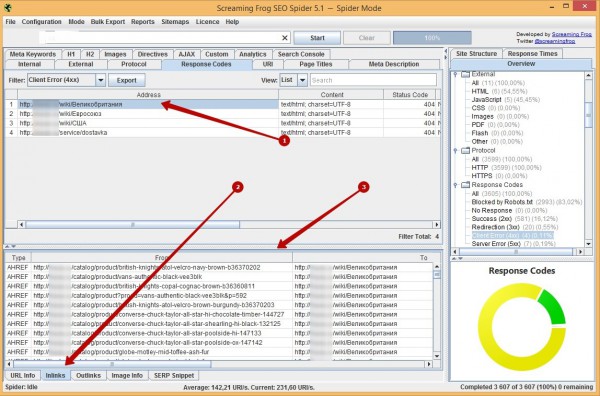

Как определить на каких страницах находятся битые ссылки?

Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылка или список ссылок.

Такие ссылки рекомендуется убирать, так как большое количество битых ссылок может негативно сказаться на ранжировании сайта.

Как найти битые ссылки на странице сайта?

Если при осмотре страницы битая ссылка не бросается в глаза, необходимо открыть код сайта «ctrl + shift + i», далее открыть форму поиска в коде «ctrl + а» и вбить адрес битой ссылки.

Битые ссылки могут быть размещены в текстах страниц. В таком случае необходимо убирать ссылки вручную. В некоторых случаях ссылка может быть размещена сразу на нескольких страницах. Это говорит о том, что ссылка размещена в меню, в футере или в каком-либо другом сквозном блоке. В таком случае не нужно заходить на каждую страницу отдельно, а можно просто удалить или заменить ссылку.

Почему битые ссылки – это плохо?

Битые ссылки не оказывают прямого влияния на ранжирование сайта, и каких-либо санкций за битые ссылки со стороны поисковых систем нет. Однако они могут потратить часть краулингового бюджета поисковых роботов, понизить показатель качества сайта, увеличить количество отказов. Кроме того, битые ссылки не передают вес другим страницам, а если на неё стоят ссылки с внешних ресурсов, вес такой ссылки не учитывается. Поэтому битые ссылки необходимо удалять с сайта либо заменять их на действующие.

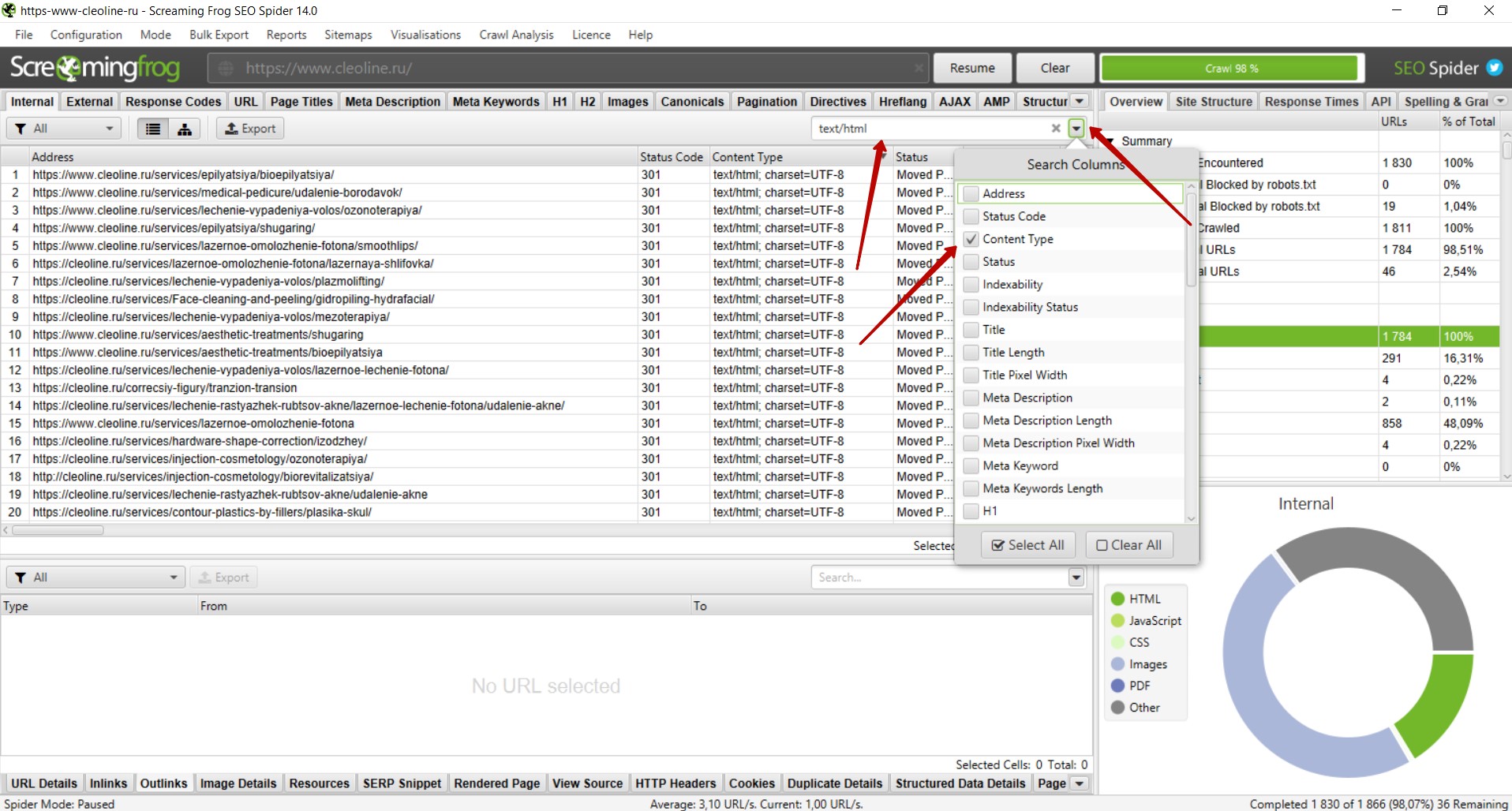

Поиск ссылок с 301 редиректом

301 редирект – перенаправление со старого адреса на новый, если изменился адрес страницы, а контент не менялся. Это делается как раз для того, чтобы не появлялись битые ссылки. Но лучше сразу ставить ссылку с 200 кодом ответа на существующую страницу. Если нет возможности менять ссылки, тогда настраивают 301 редирект. Обычно мы от таких ссылок избавляемся.

Поиск ссылок с 301 редиректом производится аналогичным поиску битых ссылок образом. Необходимо справа найти вкладку «Response Code» — «Redirection (3xx)». Теперь мы видим список ссылок с 301 редиректом и другими редиректами с 3xx кодом при их наличии на сайте.

Как определить на каких страницах находятся ссылки с 301 редиректом?

Поиск таких ссылок осуществляется так же, как и поиск битых ссылок. Необходимо выбрать ссылку или выделить несколько ссылок и внизу слева выбрать вкладку «Inlinks». В нижней части появится список страниц, где размещена выбранная ссылки или список ссылок, как и в случае с битыми ссылками.

Рядом присутствует вкладка Outlinks, где указаны страницы, куда приходит редирект.

Почему желательно избавляться от таких ссылок?

Небольшое количество таких ссылок никак не отразится на ранжировании сайта. Однако, если ссылок с редиректами много или такие ссылки размещены на всех страницах в меню, футере или других сквозных блоках, рекомендуется заменить данные ссылки на существующие страницы, на которые настроен редирект. Такие ссылки не несут в себе информацию о том, почему происходит перенаправление на другой адрес, что усложняет поисковым системам обработку данного редиректа.

Поиск дублей страниц

Наличие дублей страниц негативно сказывается на ранжировании сайта, так как из двух страниц поисковые системы вероятнее всего будут индексировать только одну наиболее релевантную, на их взгляд, страницу. Дублями страниц могут восприниматься страницы с разным контентом, но одинаковыми тегами title. Бывает, что у страниц услуг и статей идентичные теги title, и такие страницы признаются дублями. При этом интент запросов совсем разный: у первой – информационный, у второй – коммерческий. Для избежания возникновения дублей следует в первую очередь проверять сайт на наличие дубликатов title и при наличии дублей корректировать мета-теги.

Как искать дубликаты title?

Выбираем справа вкладку «Page Titles» — «Duplicate» и получаем список страниц на которых дублируются мета-теги.

В случае, когда на страницах разный контент и одинаковые теги title, необходимо скорректировать мета-теги.

Если страницы идентичны и по тегами, и по контенту, следует удалить одну страницу и настроить 301 редирект с адреса удаленной страницы на существующую страницу. Это поможет, если ссылки на удаленные страницы размещены на других сайтах или находится в индексе. 301 редирект здесь нужен, чтобы пользователи попадали не на удаленную, а на нужную страницу.

Но на самом сайте такие ссылки нужно удалить. Поэтому рекомендуем сразу проверить, есть ли на сайте ссылки на удаленную страницу (см. инструкции выше) и заменить их на существующую страницу.

Анализ заголовков h1

На каждой странице должен присутствовать основной заголовок в тегах <h1>, который максимально подробно и при этом кратко отражает содержание страницы. Это позволяет поисковым система более точно определить, что за информация размещена на странице. При проведении SEO-аудита необходимо проверить наличие основного заголовка на всех страницах сайта. Кроме того, тегами <h1> должен быть размечен только один основной заголовок.

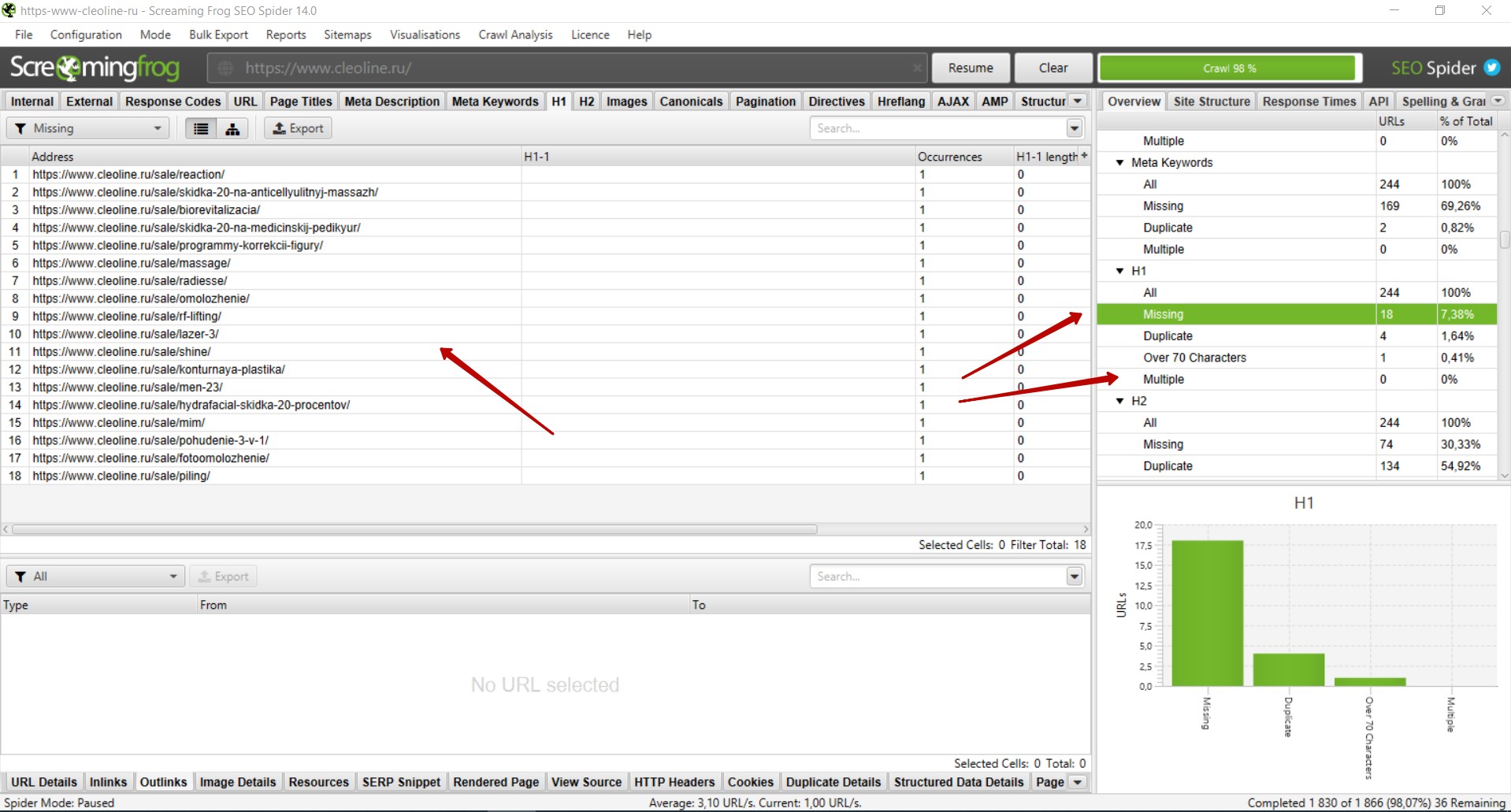

Как найти страницы, где отсутствует основной заголовок h1?

Необходимо справа выбрать вкладку «H1» — «Missing>. Вы увидите список страниц, где отсутствует заголовок h1. Следует добавить данный заголовок на все страницы сайта.

В том же блоке справа во вкладке «Multiple» будут страницы, где присутствует несколько заголовков h1. В таком случае необходимо удалить второй заголовок, если он дублирует первый либо в нём нет необходимости, или разметить заголовок тегами <h2> — <h6> в соответствии с его иерархией.

Рекомендуем также проверить вкладку «Duplicate» на наличие дублей заголовков h1. В целом, дубли h1 не являются проблемой. Однако при наличии большого количества дублей рекомендуем корректировать заголовки, в особенности на страницах товаров / услуг / статей и в случаях, когда на сайте настроена автоматическая генерация мета-тегов.

Проверка наличия и корректности Canonical

Для избежания возникновения дублей страниц рекомендуется на всех страницах размещать атрибут Canonical с указанием канонической (основной) страницы. Атрибут rel=canonical тега <link> указывает поисковым системам, что некоторые страницы могут быть одинаковыми, несмотря на разные URL-адреса (например, страницы пагинации).

Наличие данного атрибута не является фактором ранжирования, но в некоторых случаях может положительно сказаться на индексации сайта и избежать возникновения дублей страниц, например когда в URL добавляются GET-параметры (рекламные метки, сортировка и т.п.).

Для того, чтобы проверить на каких страницах размещен данный атрибут и корректно ли указаны ссылки, необходимо справа выбрать вкладку «Canonicals» — «All». Во вкладке «Missing» можно посмотреть список страниц, где данный атрибут отсутствует.

Поиск пустых или малоинформативных страниц

Наличие пустых или малоинформативных страниц может негативно сказаться на ранжировании сайта. Чаще всего такие страницы исключаются из индекса поисковых систем. Такие страницы рекомендуется удалять или дорабатывать таким образом, чтобы страница полностью отвечала на вопросы пользователя.

Для поиска пустых или малоинформативных страниц необходимо справа выбрать вкладку «Crawl Dara» — «Internal» — «All».

Через форму поиска следует отфильтровать страницы с контентом.

Далее необходимо в поле со списком страниц найти столбец «Word Count», отсортировать список страниц по убыванию количества слов и уже вручную проверить страницы с низким количеством слов в тексте страниц.

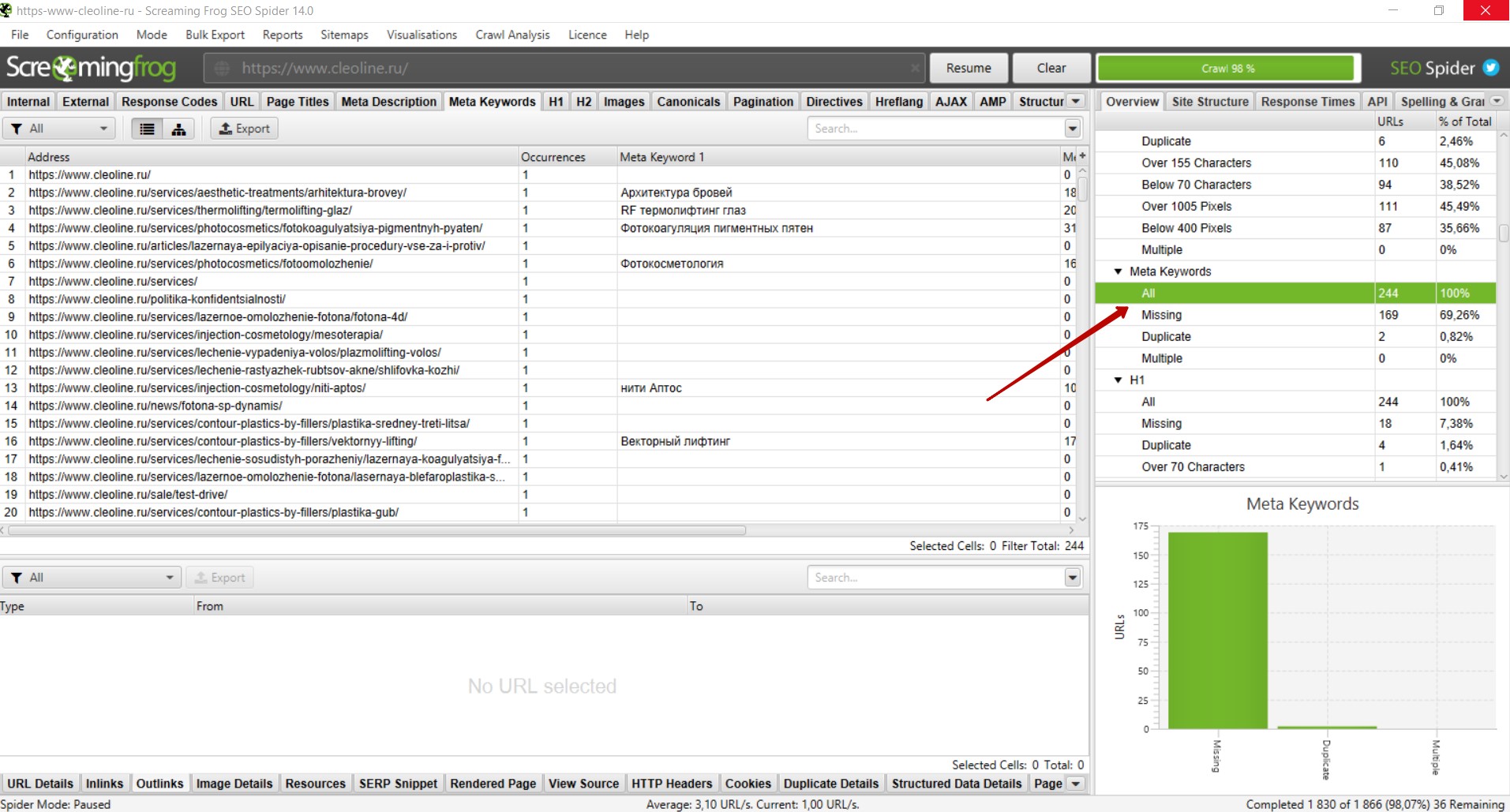

Спамный тег Keywords

Тег Keywords давно не учитывается поисковыми системами как фактор ранжирования и не оказывает положительного влияния. Однако при наличии на сайте спамных текстов и мета-тегов данный тег может стать одним из сигналов, что страница продвигается неестественными способами.

Для избежания таких ситуаций, мы рекомендуем удалять теги Keywords со всех страниц сайта.

Чтобы найти страницы, где размещен данный тег, необходимо справа выбрать вкладку «Meta Keywords» — «Missing», и вы увидите список страниц, где присутствует данный тег.

Анализ изображений

Изображения на сайте очень важны для продвижения и правильная оптимизация изображений может положительно сказаться на ранжировании сайтов и принести дополнительный трафик, например с поиска по картинкам.

Чтобы приступить к анализу изображений, следует перейти справа во вкладку «Crawl Data» — «Internal» — «Images». Вы увидите список ссылок на изображения. Необходимо проверить код ответа сервера в столбце «Status Code» — все ссылки должны отдавать 200 код ответа. Битые изображения следует удалить либо заменить на существующие. Если закрыты служебные папки, изображения рекомендуем открывать в файле robots.txt , чтобы они индексировались поисковыми системами.

Следует также проверить вес изображений в столбце «Size». Изображения с весом более 3 мб рекомендуем сжимать, чтобы они не замедляли скорость загрузки страниц.

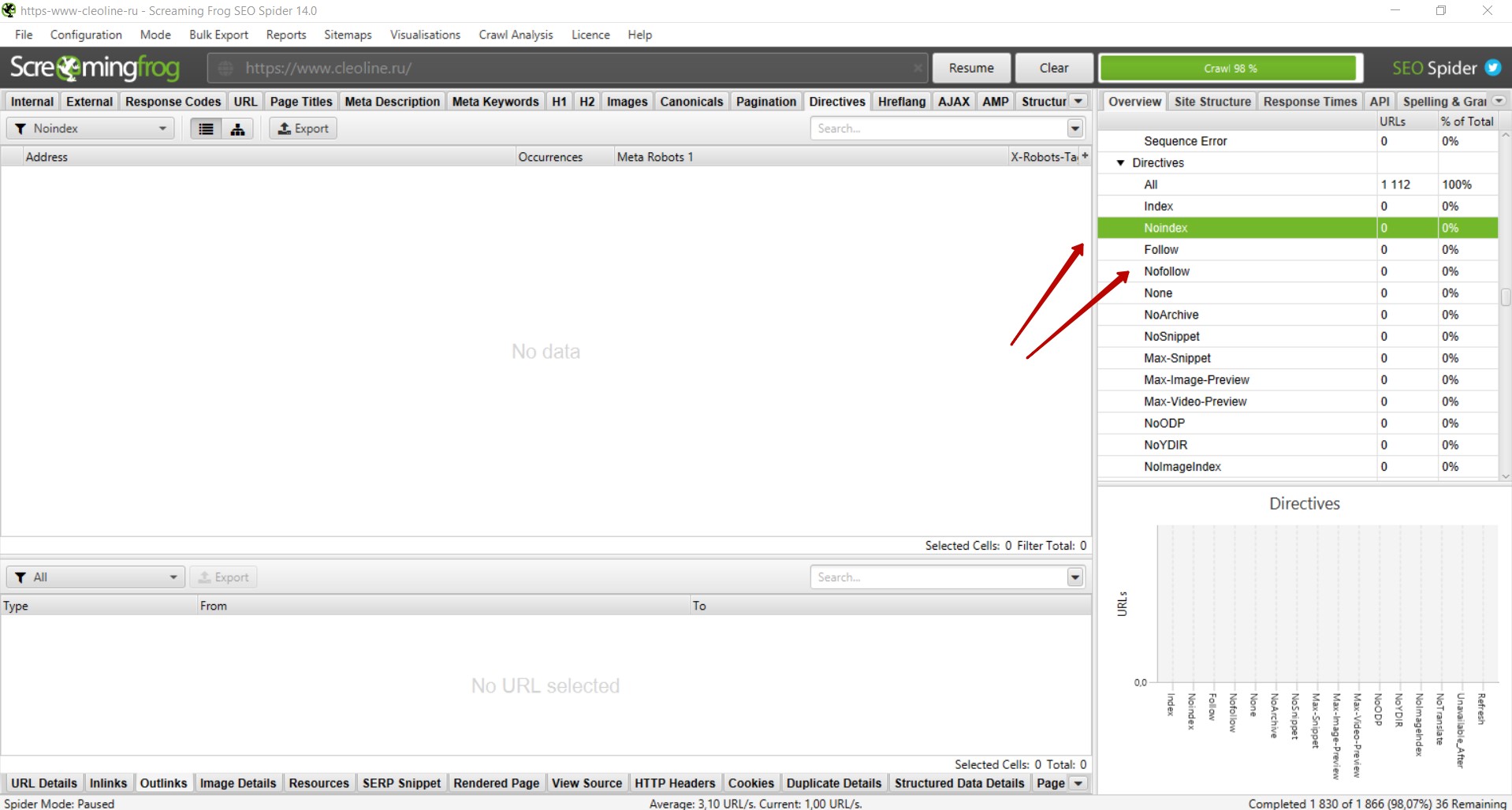

Анализ тегов Noindex и Nofollow

На некоторых страницах могут быть размещены теги «noindex», «nofollow». Чаще всего с помощью таких тегов намеренно закрывают страницы, которые не должны индексироваться. Однако некоторые теги могут быть размещены на страницах сайта ошибочно, в результате чего нужные страницы не попадут в индекс и не будут приносить трафик.

Поэтому рекомендуем проверять наличие данных тегов на страницах сайта. Для этого необходимо справа выбрать вкладку «Directives» — «noindex» и «nofollow» и проверить, не размещены ли данные теги на нужных для продвижения страницах. При наличии таких тегов на важных страницах рекомендуем убрать их из кода, чтобы страницы индексировались поисковыми системами.

Извлечение элементов со страниц сайта

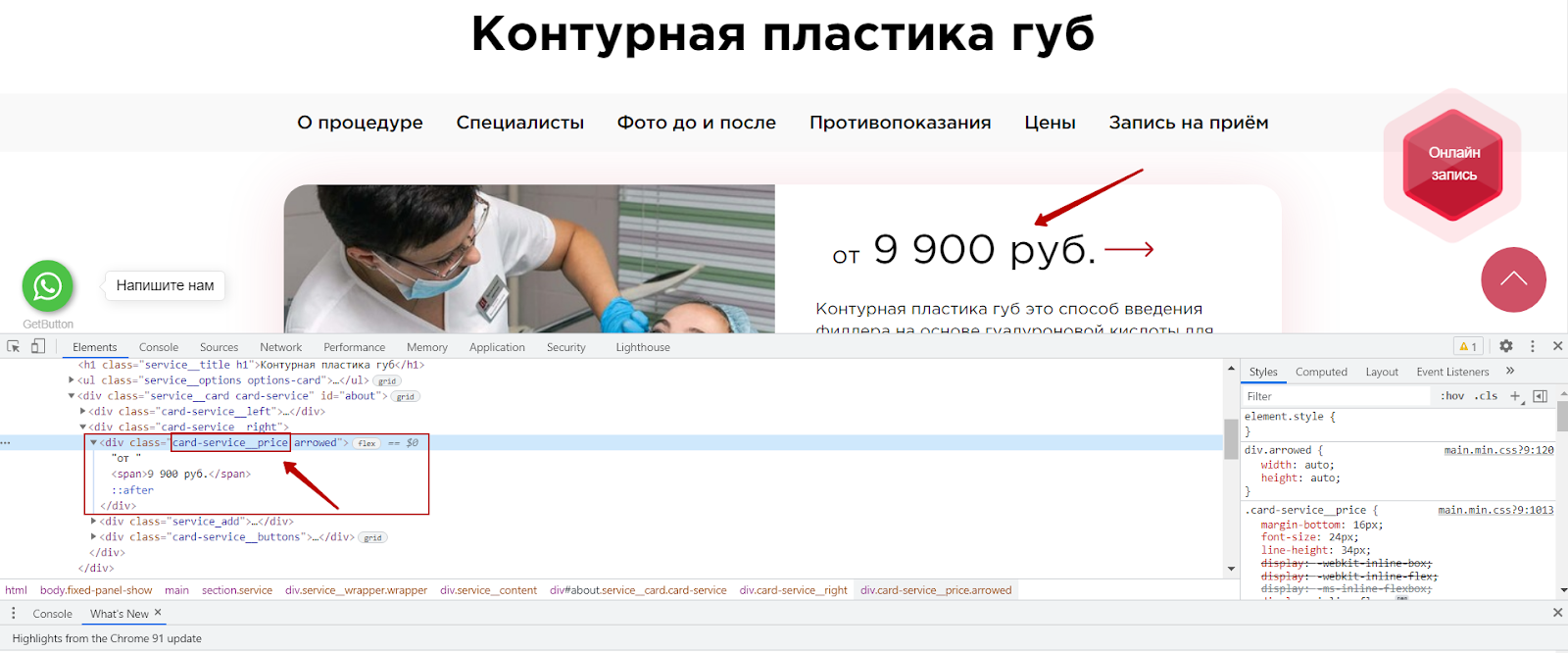

Иногда возникает потребность извлечь какой либо элемент со страниц сайта. Например, подзаголовки, цены, названия каких-то определенных блоков и т.д.

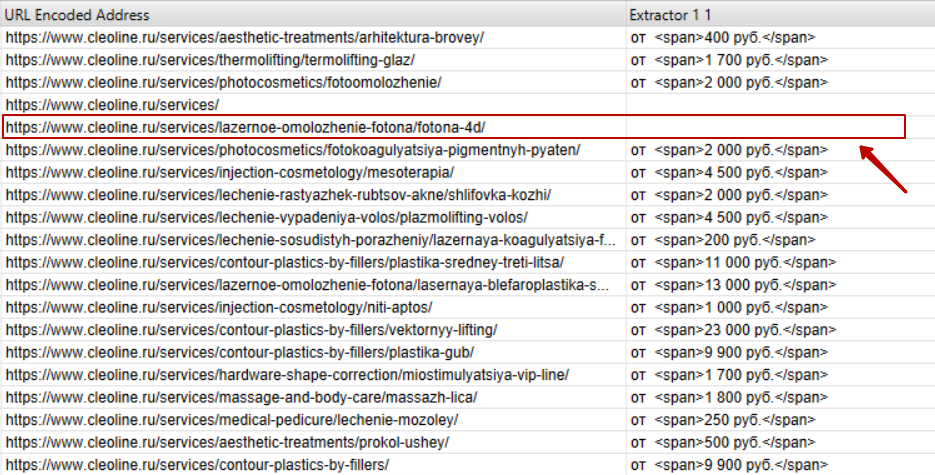

В случае с нашим клиентом мы обнаружили, что на некоторых страницах отсутствуют цены. Наличие цены на коммерческих страницах является одним из факторов ранжирования, в связи с чем мы подготовили рекомендацию о необходимости разместить цену на всех страницах сайта. Чтобы подготовить список страниц, где отсутствует цена, мы воспользовались функцией Custom Extraction.

Как это сделать?

Для начала необходимо определить, где находится нужный элемент на странице сайта, и скопировать стиль данного элемента.

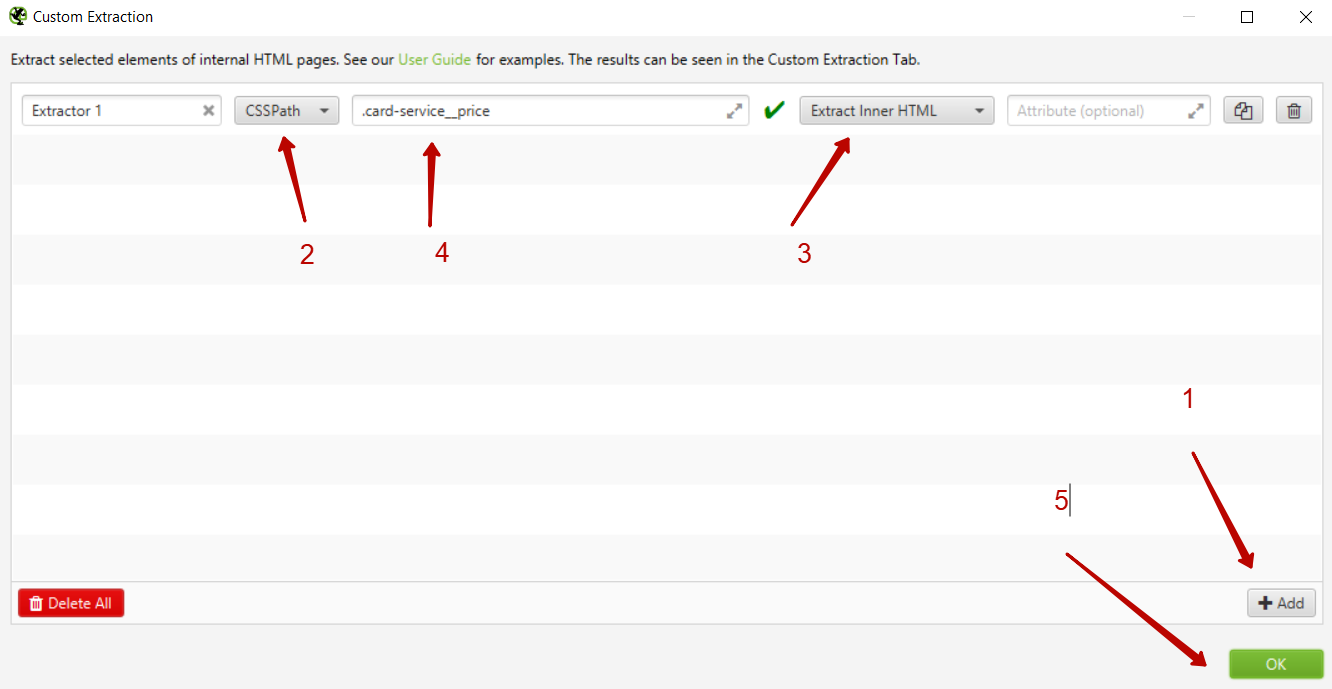

В интерфейсе Screaming Frog необходимо выбрать вкладку Configuration — Custom — Extraction.

Далее необходимо добавить новый элемент, нажав на кнопку add, и выбрать способ извлечения — CSSPath и что извлекаем — Extract Inner HTML. Далее указываем CSS стиль элемента, который ранее мы скопировали из кода сайта и ставим перед названием стиля точку.

После этого запускаем парсинг.

Нас интересуют только страницы услуг, поэтому необходимо отфильтровать только страницы раздела /services/, где размещены ссылки на страницы услуг. И мы получаем список извлеченных страниц и элементов и можем найти страницы, где отсутствует цена.

Функционал Custom Extraction довольно сложен, мы привели лишь небольшой пример, как с его помощью можно извлечь элементы страницы. Если вам будет интересно, мы можем рассказать о возможностях этой функции более подробно в следующей статье.

Выводы

Мы рассмотрели основные моменты, которые необходимо всегда проверять при проведении технического SEO-аудита в программе Screaming Frog. Многие технические проблемы / недочеты могут не оказывать прямого влияния на ранжирование сайта, однако в совокупности большое количество технических ошибок может значительно затруднить поисковое продвижение.

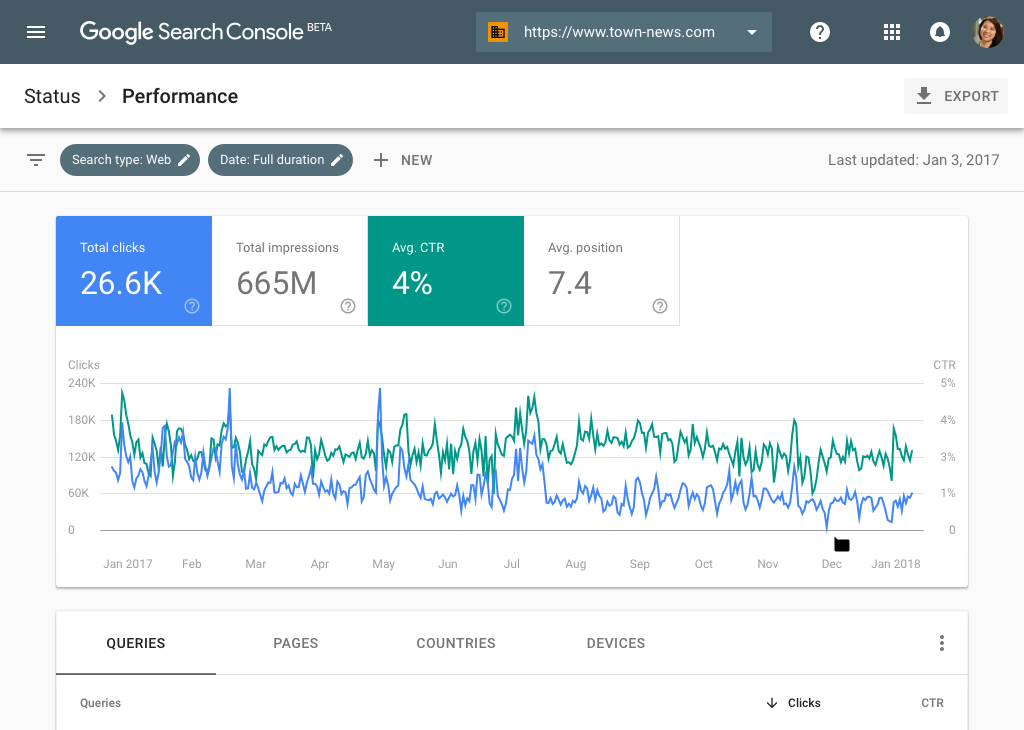

Обращаем внимание, что технический анализ должен проводиться не только через Screaming Frog, но и с помощью других инструментов, например Яндекс.Вебмастер и Google Search Console.

Мы рекомендуем не останавливаться на одной технической проверке и проводить такой анализ раз в 1-3 месяца, в зависимости от обновления страниц сайта.

Стоит учитывать, что устранение технических недочетов не гарантирует улучшение позиций и рост поискового трафика. Для увеличения видимости сайта в поисковых системах необходима комплексная доработка технической составляющей сайта, коммерческих факторов, работа с текстами и мета-тегами, структурой сайта, ссылочным окружением и другими факторами.

Если у вас остались какие-либо вопросы, — готовы ответить на них в комментариях.

А если вопросов будет много, подробнее раскроем их уже в следующих статьях.

У вас может быть очень крутой сайт. Качественный, с интересным контентом, с полезными товарами. Дизайном шикарным и удобным меню. Но если на нем есть битые ссылки (особенно если их много), это автоматически делает его подозрительным в глазах поисковых роботов и создает дурное впечатление о ресурсе со стороны посетителей. Такого допускать нельзя. Ваш прекрасный сайт должен быть прекрасным во всем. И мы этого добьемся.

Что такое битая ссылка?

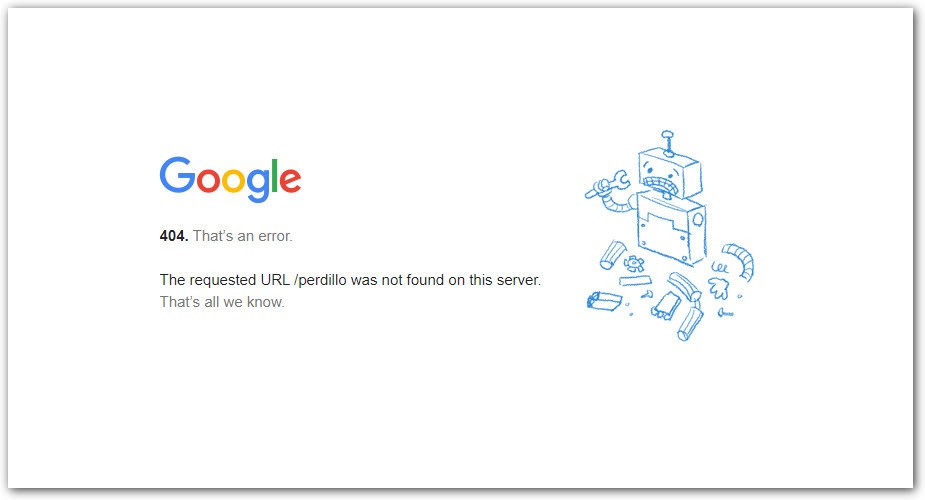

Битая ссылка — это страница на сайте, которую нельзя открыть. Ее не существует. Когда потенциальный посетитель пытается на нее попасть, то получает в ответ ошибку. Это может быть ошибка 404 Not Found или 400 Bad Request. Или без кода вовсе: Timeout, Empty, Reset. Зависит от настроек конкретного ресурса. Оболочка разная, а смысл один и тот же. Сервер говорит, что искомой страницы здесь нет.

Такие ссылки еще изредка называют «мертвыми». Они возникают по нескольким распространенным причинам:

- В адресе страницы допущена ошибка. Неправильно написано слово или не хватает какого-то символа. Или не настроены алиасы.

- Структуру сайта недавно кардинально поменяли, не настроив при этом перенаправление со старых ссылок.

- Ссылки на сторонний контент на странице удалили или каким-либо образом «сломали».

- В коде сайта затесались ошибки. В HTML или в JavaScript. Может быть, это сбой в CMS.

Комьюнити теперь в Телеграм

Подпишитесь и будьте в курсе последних IT-новостей

Подписаться

Чем опасны битые ссылки?

Есть две неподтвержденные теории и один солидный факт, подтверждающие серьезную угрозу со стороны битых ссылок.

Первая теория такая. Считается, что поисковые роботы Google и Яндекс не любят битые ссылки. Заприметив оные, поисковики решат, что сайт уже давно бросили или сделали так криво, что и стыдно его людям показывать. В связи с этим, позиции ресурса в Google и Яндекс заметно «просядут». Но никто еще не доказал, что это так.

Вторая теория. Якобы битые ссылки расходуют краулинговый бюджет — объем страниц, который поисковики сканируют за определенный период времени. Здесь вмешался представитель Google и сказал, что появление 404 ошибки никак не повлияет на краулинговый бюджет.

А вот что реально важно, так это отношение посетителей к сайту с битыми ссылками. На таких долго не задерживаются. Обычно 404 Not Found говорит о том, что надо бы перейти на главную страницу и воспользоваться поиском. Но всем плевать. Человек просто вернется в Google и будет искать ресурс с рабочими ссылками. Все. Вы потеряли своего посетителя.

Из-за этого вырастет доля отказов. А это не только упущенная аудитория, но и проблемы с ранжированием. Поисковик простит вам битую ссылку, но не простит визитер, который провел на сайте всего секунду и неожиданно убежал.

Читайте также

Как разыскать все битые ссылки на сайте?

Никто не будет сидеть и тыкать во все ссылки на сайте, чтобы найти битые. Тем более, если такие есть на чужих ресурсах. Поиском мертвых страниц занимаются специальные веб-сервисы и приложения. Кому что удобнее.

Я бы советовал не останавливать выбор на чем-то одном. Бывает так, что один сервис отображает неполную информацию. Это как с антивирусами. В тандеме находят больше угроз, чем по одиночке.

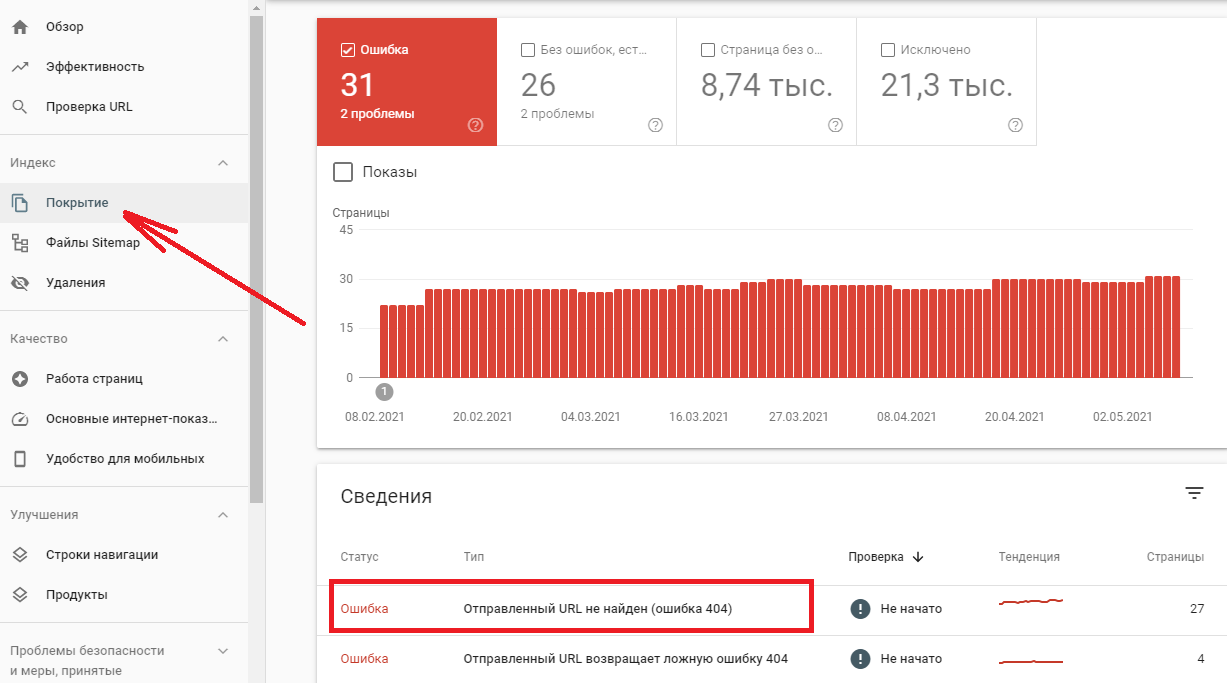

Google Search Console

Официальная панель управления Google отлично справляется с поиском битых ссылок. Так что можно отлавливать 404-е с помощью нее. Надо только подтвердить свои права на домен, а потом открыть пункт меню «Покрытие».

Яндекс.Вебмастер

Аналогичная функция есть в Яндексе. В их Вебмастере есть раздел «Ссылки», где можно взглянуть на все поломанные. Только вот здесь есть сложности с экспортом отчета. Раньше не было удобного способа вытащить все данные об ошибках, чтобы потом их устранить. Сейчас можно скачать TSV-файл с 10 000 битых ссылок. Кому-то даже этого будет мало.

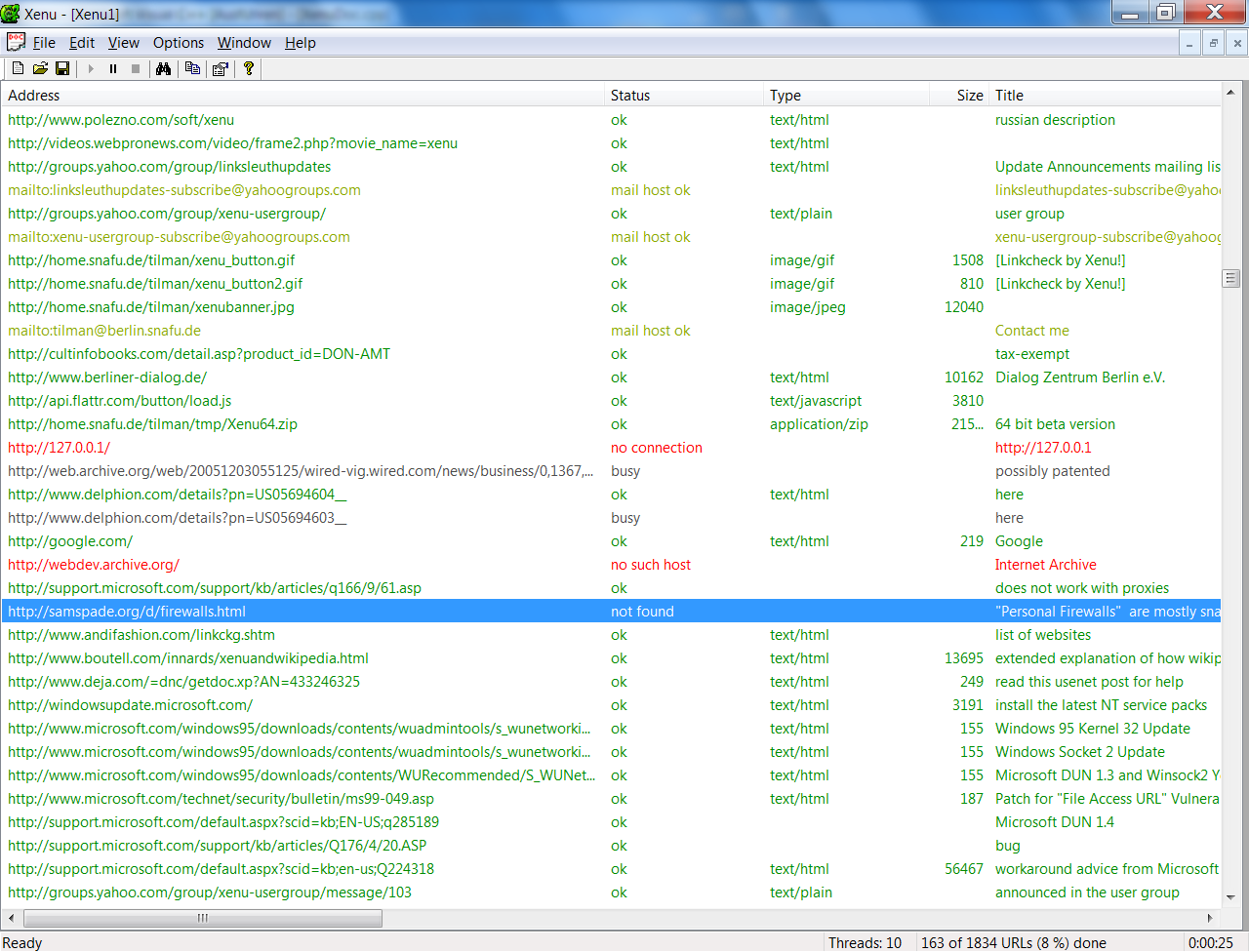

Xenu

Это старая программа, но отчеты из нее многие до сих пор считают эталонными. Xenu предоставляет информацию бесплатно, поэтому можно попробовать самостоятельно и без финансовых потерь.

- Поддерживает страницы с шифрованием.

- Работает быстрее большинства аналогов.

- Может обнаружить перенаправления.

- Позволяет делать повторные проверки.

Broken Link Checker

Это даже не отдельная программа, а плагин для WordPress. Дико популярный и полезный. Из плюсов можно выделить то, что он бесплатный и встраивается в WordPress. А из минусов — то, что он не всегда работает корректно и сложно настраивается. Часто приходится запускать модуль по несколько раз, чтобы был какой-то прок. Но другие дополнения к WordPress подобного рода оказываются еще хуже.

Netpeak Spider

Это дорогой и сложный инструмент для скрупулезного SEO-аудита. Он справляется с поиском сломанных страниц, но создавался для решения более широкого круга задач. Скорее всего, его покупка себя полностью не оправдает. Но функциональность хвалят, да.

Dead Link Checker

Платный онлайн-сервис для поиска ошибок 404 на ресурсе. Работает по подписке. То есть платите 10$ в месяц и получаете возможность отсканировать до 50 000 ссылок. Когда есть бесплатные альтернативы, кажется, что это не самый лучший выбор. Но я его не тестировал. Возможно, он творит какие-то чудеса и находит то, что не способны найти конкуренты.

Есть еще с десяток подобных приложений и сайтов, но они так себе. Либо работают чересчур медленно, либо стоят неадекватно дорого.

Нашел все битые ссылки, что дальше?

То, что нашли, уже хорошо. Только теперь надо их исправить. Будем действовать по следующей схеме действий:

- Разберем все ссылки.

- Категоризируем их.

- И исправим все ошибки.

Анализируем ссылки

Сначала надо организовать данные, полученные из сервисов по поиску битых ссылок. Надо понять, почему те или иные ссылки поломаны. Например, если дело в опечатке, то проще всего исправить эту самую опечатку в коде сайта. Если страницы больше не существует, то надо удалить ссылку и добавить заглушку с соответствующим сообщением. Мол, «410 Gone, ребята, странички не будет». А если вы недавно переехали на другой домен, то самым адекватным решением будет — настроить массовый редирект.

Поэтому для начала можно создать такую простенькую табличку:

| Мертвая ссылка | Количество посещений | Редирект сюда |

| kakaya-to-statya.net | 17 | kakaya-to-statya.blog.net |

| sayt-s-opechatkay.ru | 12 | – |

| sayt-s-opecahtloy-2.ru | 1 | – |

На ней сразу будет видно ссылки, которым нужен редирект, ссылки, для которых стоит заморочиться с исправлением опечаток, и те, о которых можно забыть.

Но это, конечно, исключительно пример. Вы можете организовать полученную информацию, как вздумается.

Исправляем опечатки

Опечатки бывают двух типов. Те, что допустили вы как владелец сайта. И те, что допускают посетители, надумавшие зайти к вам вручную, указав адрес страницы (страшные люди). Какие опечатки стоит исправлять и так понятно. Те, что допустили сами.

Но есть еще один момент. Если по ссылке с опечаткой пытаются пройти регулярно, то имеет смысл настроить перенаправление на правильную страницу. Или сделать вариант с опечаткой рабочей альтернативой для самых настойчивых.

Настраиваем редирект

Теперь займемся ссылками, которые по-вашему мнению нуждаются в перенаправлении.

Тут и пригодится таблица, которую я описал выше. Наглядно показано, что и куда должно переехать.

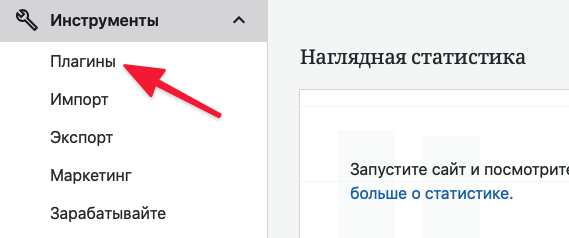

Расскажу, как можно сделать 301 редирект в CMS WordPress и с помощью файла .htaccess

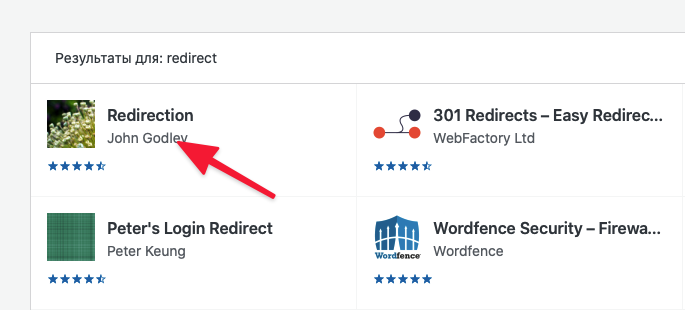

WordPress

- Открываем вкладку «Инструменты»

- Переходим в подпункт «Плагины».

- Кликаем по поисковому полю.

- Ищем плагин Redirection и устанавливаем его.

В поисковике будут и другие плагины, с помощью которых можно настроить редирект. Можете попробовать их. Это уже дело вкуса.

- Потом снова открываем вкладку «Инструменты».

- Переходим к настройкам плагина «Перенаправления».

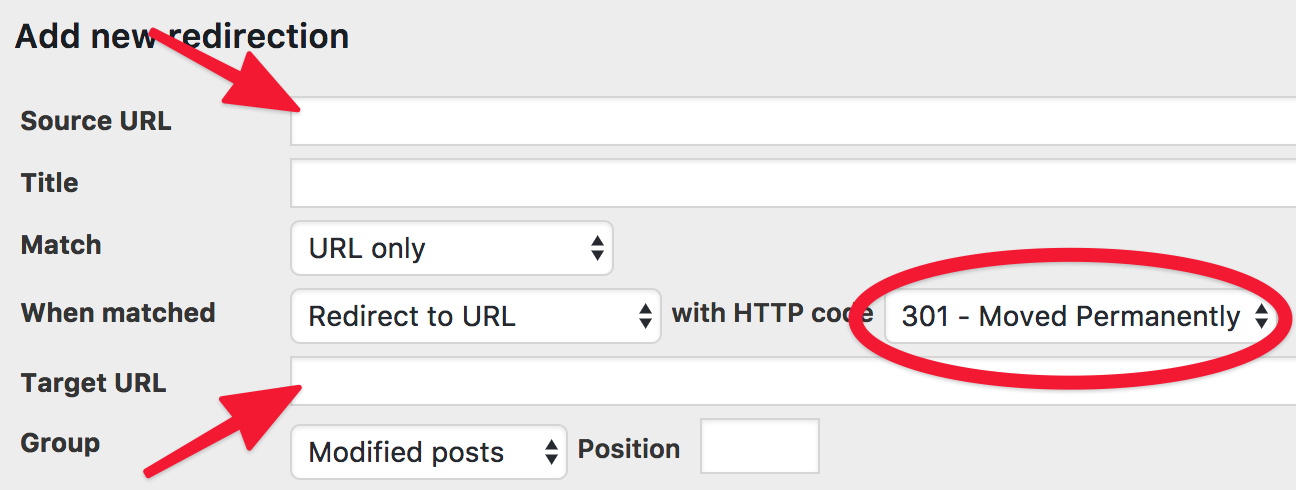

- Нажимаем на Add new redirection.

- Указываем Source URL (ссылку, с которой надо перенаправить).

- А потом Target URL (куда надо перенаправить).

- И сохраняем заданные параметры.

Ну и так придется повторять до тех пор, пока все ссылки, нуждающиеся в перенаправлении, не получат его. Эти задачи нередко достаются верстальщикам на аутсорсе или «разнорабочим» с UpWork и других бирж.

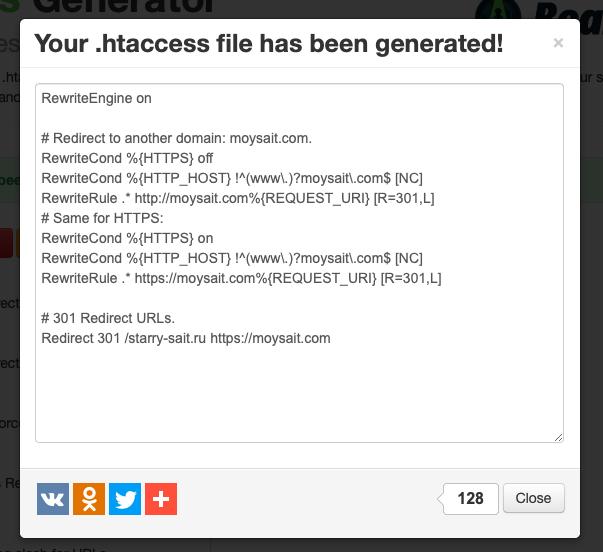

Как сделать массовый редирект

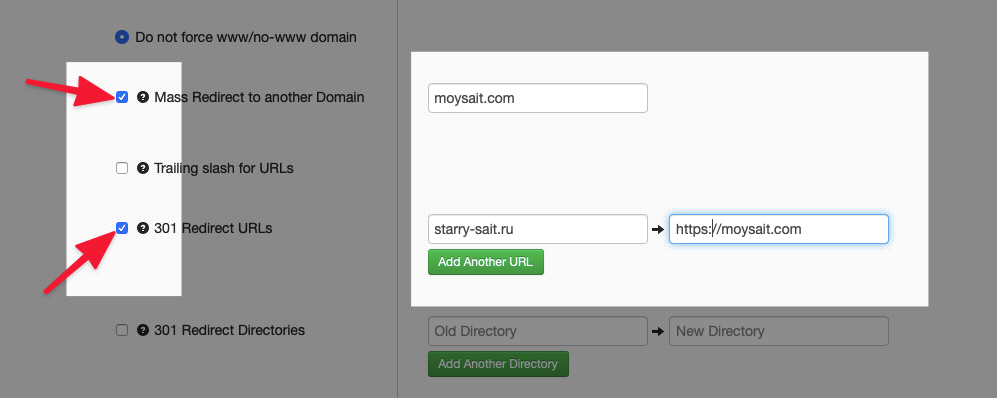

При переезде на новый домен вручную делать редирект всех битых ссылок — это нерациональный адский труд. Поэтому проще воспользоваться массовым редиректом. Делаем следующее:

- Открываем сайт для генерации файла .htaccess с настроенным перенаправлением.

- Ставим галочки напротив пунктов Mass Redirect to another Domain и 301 Redirect URLs.

- Напротив первого вписываем название сайта.

- Напротив второго домен, с которого нужно перенаправить пользователей, и домен, на которой надо перенаправить.

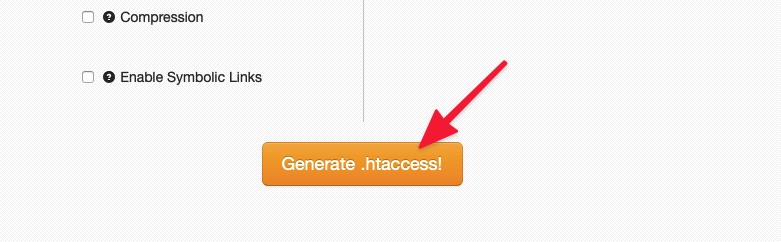

- Нажимаем на кнопку Generate .htaccess в нижней части страницы.

- Потом копируем сгенерированный код и вставляем его в файл .htaccess на сервере.

Впрочем, так можно сгенерировать код для любого типа перенаправлений.

Что делать с битыми ссылками на чужих сайтах?

Теперь вы знаете, что делать со страницами, которые убили сами и к которым у нас есть доступ. Проблематичнее дела обстоят с чужими сайтами, где есть ссылки на ваш ресурс. Они тоже подвержены опечаткам и переезду. Тоже будeт ошибка. Но дело поправимое.

Попросим владельца сайта поменять ссылку

Это, наверное, до боли очевидное решение. Просто постучите владельцам сайта, на котором лежит битая ссылка на ваш ресурс. Попросите их исправить опечатку или указать в материале обновленный адрес. Если удастся с ними связаться, то больше ничего делать и не придется. Все поправят за вас. Но шансы, что вас проигнорируют ощутимо выше.

Настроим редирект с битой ссылки на рабочую

Работает так же, как и в случае со своими ссылками. Просто настройте редирект, чтобы пользователь оказался в нужном месте. Для этого не надо ни с кем связываться и ждать ответа. Настраиваем перенаправление удобным способом и радуемся.

Заново создаем пропавшую страницу

Если уже успели удалить страницу, на которую ведет битая ссылка, то можно создать ее заново. Добавьте туда аналогичный контент. Или тот же, что был раньше. Это может пригодиться, если с чужой страницы приходит большое число посетителей.

Настроим редирект на похожую страницу

Может, контент на уже несуществующей странице устарел? Подумайте, возможно, у вас есть страничка с похожей информацией. Будет хорошей идеей настроить редирект на нее. Тогда и вы ничего не теряете, и посетитель получит то, чего ждет.

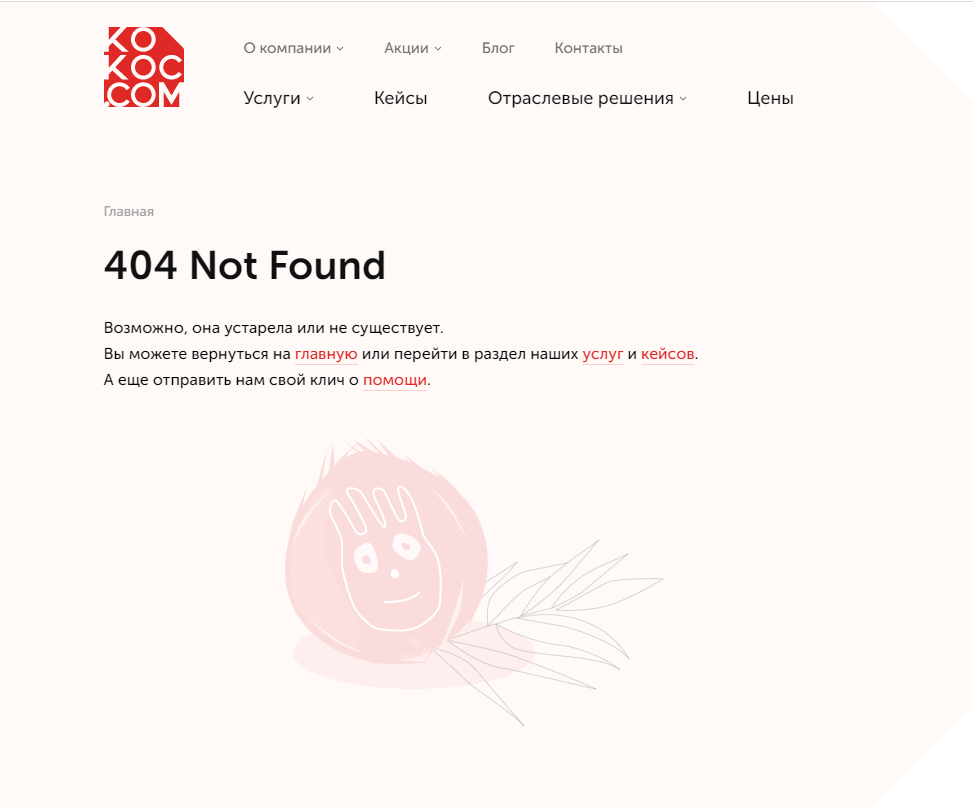

И бонусом делаем кастомную страничку 404

Тоже хороший вариант. Сделайте страницу с ошибкой 404 более привлекательной. Оригинальной, что ли. Добавьте картинку, анимацию. Не плоскую шутку. А самое главное, ссылку на главную страницу или на встроенный поисковик. Так вы в десятки раз повысите вероятность, что пользователь останется на вашем сайте, а не ретируется, заметив страшные черные буквы — Not Found.

Можно испробовать все описанные способы в том же порядке. Не ответил владелец чужого сайта? Пилите редирект. Не подходит вариант с редиректом? Так хотя бы сделайте нормальную страничку с ошибкой. Это уже что-то.

Выводы

Итак, еще раз:

- Битые ссылки — поломанные страницы, отзывающиеся ошибками 400 и 404.

- Они портят жизнь посетителям вашего сайта. Так что придется принимать какие-то меры.

- Их несложно найти с помощью бесконечного количества сайтов и программ, заточенных под эту задачу.

- И есть ворох путей исправления ситуации, независимо от того, почему появились проклятые битые ссылки.

Думаю, на этом и закончим. Спасибо.

Поисковые системы совершенствуют алгоритмы ранжирования и стараются выводить в результатах поиска наиболее качественные ресурсы, отвечающие запросам пользователей. Соответственно, владельцы сайтов вкладывают много сил, чтобы именно их ресурсы занимали наивысшие позиции. Давайте представим, что вы ищете беговые кроссовки из последней коллекции известного бренда. Вы кликаете по нужной ссылке в результатах поиска и попадаете не на страницу магазина с желаемым товаром, а на экран с печальной надписью «404 Not Found», «Страница не найдена», «Нет такой страницы» и все в таком духе.

Страница 404 на примере Google

Такая ситуация может случиться и при переходе по внутренним ссылкам сайта. Давайте разберемся, почему так происходит и как с этим бороться.

Что такое битые ссылки

Битая ссылка – это гиперссылка на страницу, адрес которой был изменен или она была удалена с сайта. Иными словами, по данному адресу страницы больше нет, и при запросе к серверу он возвращает код ответа 4xx Client Error: чаще всего «404 Not Found» и в редких случаях – «410 Not Found» (окончательное удаление адреса из индекса поисковых систем).

На несуществующие страницы могут вести ссылки на самом сайте (внутренние битые ссылки) или размещенные на сторонних ресурсах (внешние битые ссылки). Одна из базовых задач по оптимизации веб-ресурса заключается в регулярной проверке на наличие битых ссылок и их устранение.

Как появляются битые ссылки

Причинами появления ссылок на несуществующие адреса являются:

-

удаление контента из-за его неактуальности;

-

изменение URL-адреса;

-

ошибки в настройке веб-сервера;

-

технические ошибки на сайте;

-

специальный/случайный ввод в адресную строку браузера несуществующих адресов.

Рассмотрим их подробнее.

Удаление неактуального контента

Часто возникают ситуации, когда какие-то товары, услуги, а иногда и целые разделы сайта становятся неактуальными: например, в случае обновления ассортимента. Многие владельцы сайтов просто удаляют такие страницы. При этом они забывают, что на них могут вести внутренние или внешние ссылки. После удаления страниц они автоматически станут нерабочими, притом что часть этих страниц могла бы ранжироваться в поисковых системах на хороших позициях.

В итоге пользователь перейдет по такой гиперссылке и увидит экран с ошибкой:

Хорошо, когда страница 404 содержит дополнительное пояснение о том, что страница была перемещена или удалена

Поэтому важно следить, чтобы внутри сайта не оставалось нерабочих ссылок. А при удалении по возможности заранее настраивать 301-й редирект на актуальную или максимально близкую по содержанию страницу.

301 Редирект — это способ постоянного перенаправления поисковых систем и посетителей сайта на адрес, который отличается от изначально запрашиваемого.

Изменение адреса/структуры

Контент-менеджеры сайтов часто не имеют технических навыков. Из-за этого возникают ситуации, когда они пытаются изменить заголовок страницы или название ссылки на страницу из меню. Из-за особенностей движка сайта или случайной ошибки меняется URL-адрес страницы. Это означает, что по старому адресу страница стала недоступной и все ссылки на нее автоматически будут отдавать 404-ю ошибку.

Например, была страница с адресом https://site.ru/novosti/novost-1/, а после правок заголовка контенщиком адрес изменился на https://site.ru/novosti/samaya-svezhaya-novost-1/.

Другая ситуация – изменение адреса из-за смены родительского раздела. Она происходит, когда вы меняете структуру, переносите страницу из одного раздела в другой. Например, на сайте в разделе «Обувь» изначально было деление по типу обуви: ботинки, кроссовки, туфли и т. д., а потом уже на мужские, женские, детские. Соответственно, товар имеет привязку:

https://site.ru/obuv/krossovki/muzhskie/tovar1/

Вы решили сделать сначала деление по полу, а потом уже по типу обуви. Следовательно, адрес товара в разделе приобретет вид https://site.ru/obuv/muzhskaya/krossovki/tovar1/

Или же решили добавить дополнительные подкатегории по сезону: https://site.ru/obuv/krossovki/muzhskie/zimnie/tovar1/

Во всех этих случаях происходит одно и то же: по изначальному адресу страница перестает существовать, все ссылки на нее становятся битыми.

При изменении структуры сайта или исправлении адреса страницы не забывайте обязательно настраивать 301 редирект со старого адреса на новый, а внутренние ссылки сайта заменять на актуальные.

Технические ошибки на стороне сервера

К появлению 404-х ошибок на сайте могут приводить и некорректные настройки веб-сервера. Например, когда движок сайта использует ЧПУ (человекоподобный URL), а сервер не настроен на переадресацию входящих запросов. Или когда при переходе сайта на защищенный протокол не было настроено перенаправление с http на https. Также причиной ошибок может служить кэширование страниц на стороне сервера перед выдачей клиенту.

Случайные ошибки и человеческий фактор

Никто не застрахован от ошибок. Достаточно опечатки в одну букву, чтобы получить нерабочую гиперссылку. Поэтому каждый раз после обновления контента важно проверять работоспособность перелинковки.

Программы для проверки битых ссылок на сайте

Как часто нужно проводить поиск битых ссылок и с помощью чего это делать? Мы рекомендуем регулярные проверки, не реже 1 раза в месяц. Если контент вашего ресурса обновляется часто, проверки можно проводить более регулярно: например, для новостных сайтов раз в неделю.

Рассмотрим наиболее популярные программы для поиска битых ссылок:

-

Screaming Frog SEO Spider Tool. Программа имеет широкий спектр настроек и анализирует много параметров, в том числе показывает, на каких страницах и какие ссылки битые. Подходит для анализа не очень больших сайтов, т.к. даже платная версия имеет ограничение по количеству сканируемых URL-адресов. В бесплатном варианте вы сможете проверить лишь 500 УРЛов.

-

Netpeak Spider. Также очень удобная платная программа с большим набором параметров для анализа.

-

Xenu’s Link Sleuth. Программа предназначена только для операционной системы Windows и имеет свои недостатки, но является бесплатной.

-

Majento SiteAnalyzer. Также бесплатная программа для анализа вашего сайта.

Онлайн сервисы проверки битых ссылок на сайте

Онлайн-сервисы – их достаточно много, но не все хорошо справляются со своей задачей. Отмечу несколько достойных вариантов:

-

Online Broken Link Checker. Имеет бесплатную версию для проверки до 3000 URL, но с ограничениями и без возможности экспорта результатов. Коммерческая версия обладает более широкими возможностями, плюс есть возможность персональной настройки.

-

Deadlinkchecker. Сервис дает проверить бесплатно до 2001-й ссылки.

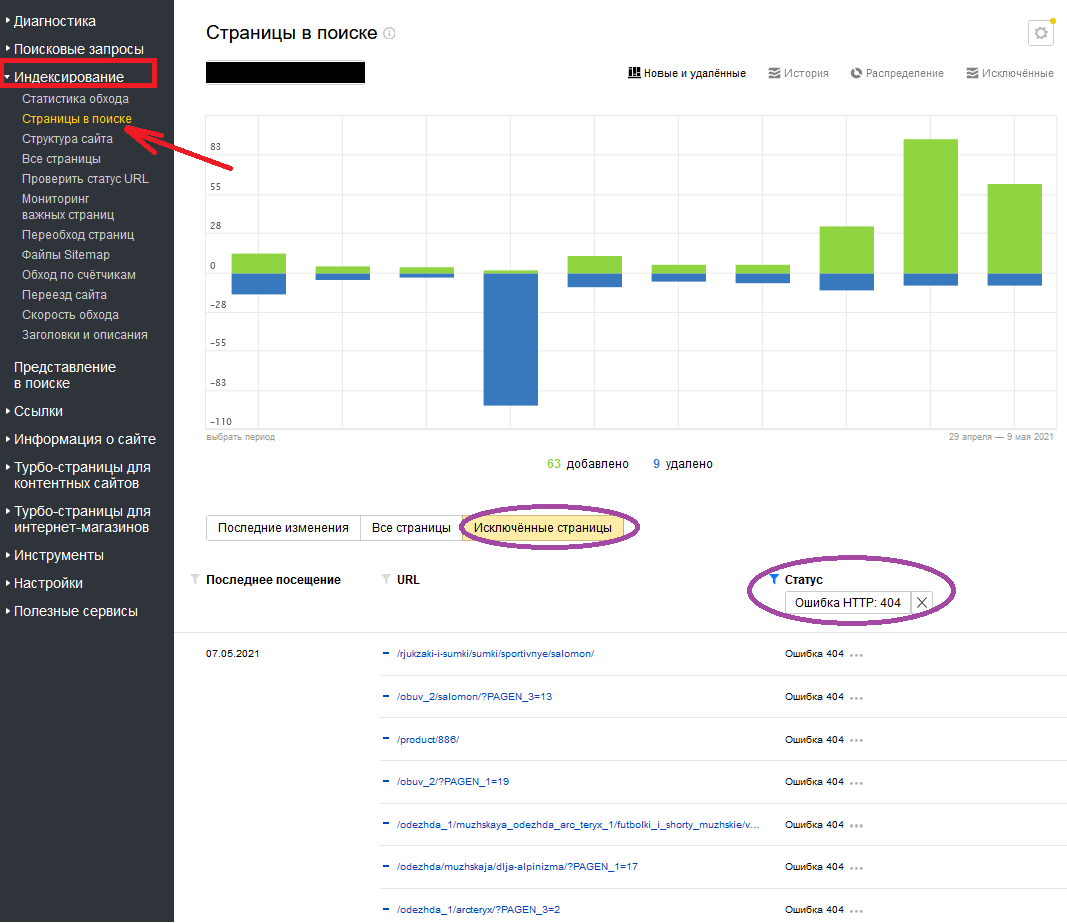

Проверка битых ссылок в «Яндекс.Вебмастере» и «Google Search Console»

Нельзя не сказать про отслеживание внутренних и внешних битых ссылок на сайте с помощью сервисов «Яндекс» и Google для вебмастеров. В панелях «Яндекс.Вебмастер» и Google Search Console вы сможете увидеть страницы с 404-й ошибкой, которые были исключены из индекса, проанализировать, что явилось причиной их появления и принять решение о необходимости их исправления.

Так это выглядит в «Яндекс.Вебмастере»:

Проверяем 404-е страницы в разделе «Страницы в поиске» меню «Индексирование»

А вот так в Google Search Console:

Проверяем 404-е страницы в разделе «Покрытие» меню «Индекс»

Как исправить битые ссылки

Для исправления битых ссылок рекомендуется следующее:

-

Обязательная замена внутренних ссылок на работающие или их удаление.

-

Настройка 301-го редиректа с несуществующего адреса на актуальную страницу или максимально близкую по содержанию. Этот вариант рекомендован, если удаленная/перенесенная страница находилась в продвижении, приносила трафик или на нее идет ссылочный вес, который вы хотели бы сохранить и перенаправить на другой адрес.

При настройке 301 редиректа, последовательные переадресации не должны иметь более 3 переадресаций — это снижает передаваемый вес и замедляет скорость загрузки страниц.

Не забывайте проводить регулярные проверки на работоспособность внутренних ссылок, это повышает доверие к ресурсу ваших посетителей и поисковых систем.

Опасны ли битые ссылки и нужно ли с ними бороться?

Влияют ли битые ссылки на ранжирование интернет-ресурса? Напрямую – нет, потому что не существует такого фактора ранжирования, когда за подобные ссылки вы однозначно получите понижение позиций. Однако это не значит, что битые ссылки на сайте никак не скажутся на результатах вашего продвижения.

Битые ссылки можно сравнить с дверью, за которой пользователь натыкается на кирпичную стену. Это явно не добавляет ему расположения к сайту. А что если таких ссылок достаточно много и посетитель за одно посещение сталкивается с несколькими из них или ваша страница 404 ничего об это не говорит, а представлена в стандартном варианте?

Для рядового пользователя написанное будет ничем не лучше иероглифов по понятности

После такого большинство посетителей просто закроет вкладку и покинет сайт раз и навсегда, так как вы не открыли перед ним другие «двери». Упущенный клиент, упущенная выгода, прерванная сессия повлекут за собой ухудшение поведенческих факторов. А поведенческие факторы, в свою очередь, имеют весомое значение для ранжирования интернет-ресурса в поисковых системах.

Оформление страницы 404-ой ошибки в стиле сайта (с наличием меню, выводом дополнительных блоков или ссылок для привлечения и удержания) поможет не потерять потенциального клиента.

Страница 404 сайта kokoc.com: визуальная и текстовая часть максимально дружелюбно сообщают пользователю о том, случилось и как решить проблемы

Периодически сайт нужно проверять на наличие битых ссылок. Как найти битые ссылки на сайте, используя Screaming Frog SEO Spider Tool, Netpeak Spider, Xenu’s Link Sleuth, Siteliner, читайте в их обзоре.

Битые ссылки – один из факторов, негативно влияющих на качество сайта, а позиции сайта, в свою очередь, зависят от его качества в целом. И что же получается? Битые ссылки косвенно влияют на ранжирование, а соответственно, и на трафик сайта.

Если сегодня их нет, это не означает, что через некоторое время они не появятся. Поэтому рекомендуем – периодически проверяйте свой сайт на битые ссылки. Частота проверки зависит от типа вашего сайта (интернет-магазин, новостной сайт, статейный сайт и т.д.) и объёма трафика.

Все найденные битые ссылки необходимо устранять, и чем раньше – тем лучше.

В статье мы рассмотрим несколько инструментов, с помощью которых можно найти битые ссылки на сайте.

- Screaming Frog SEO Spider Tool

- Netpeak Spider

- Xenu’s Link Sleuth

- Siteliner

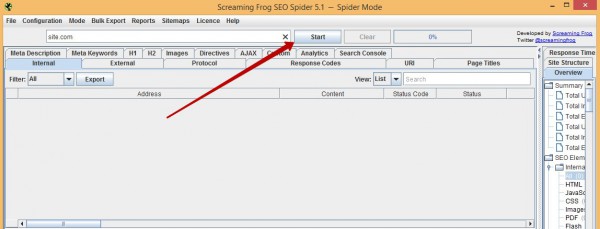

1. Screaming Frog SEO Spider Tool

Есть платная и бесплатная версии программы. В бесплатной версии есть ряд ограничений в настройках, она сканирует не более 500 URL-адресов, но вполне подойдет для небольших сайтов.

Для начала нужно скачать и установить программу, так как это десктоп-приложение (доступны клиенты для Windows, Mac OS и Ubuntu).

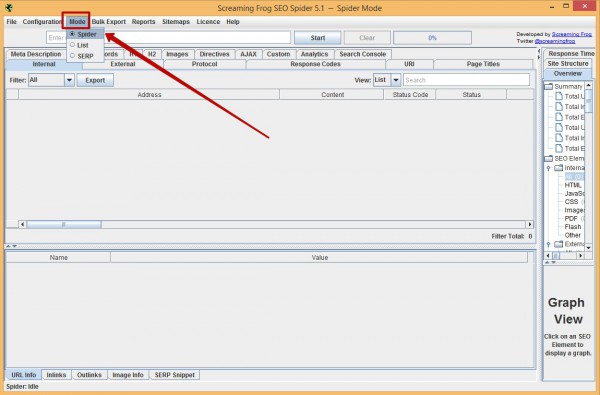

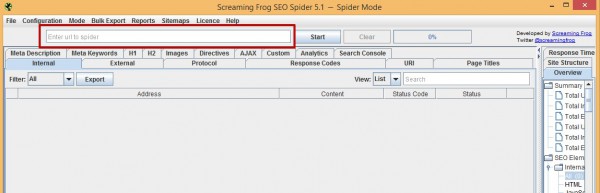

Как пользоваться?

1. После запуска программы выбираем тип поиска страниц. Так как на наличие битых ссылок нам необходимо проверить весь сайт, выбираем режим «Spider»:

2. В строку вводим адрес сайта, который необходимо проанализировать:

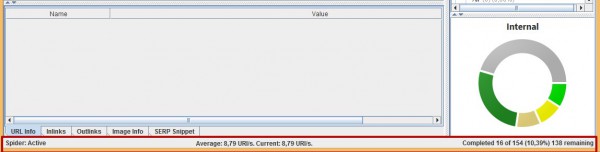

3. Нажимаем кнопку «Start» и ждем, пока Screaming Frog просканирует весь сайт. Время сканирования преимущественно зависит от объёма сайта.

После того как Screaming Frog завершит сканирование сайта, приступаем к следующему шагу поиска битых ссылок.

4. Переходим на вкладку «Response Code» и в фильтре слева выбираем, какие ошибки нас интересуют:

- 4хх

- 5хх

Обратите внимание, есть нюанс: мы не можем одновременно посмотреть страницы с ошибками 4xx и 5xx, только отдельно. Поэтому сначала смотрим группу одних ошибок и выгружаем их, а затем в фильтре выбираем другую группу ошибок и также выгружаем их при необходимости.

Если Screaming Frog нашел битые ссылки на вашем сайте, смотрим, на каких страницах они расположены.

Чтобы увидеть, на каких страницах есть битые ссылки, необходимо:

1. Выбрать одну из битых ссылок.

2. В нижнем рабочем окне выбрать вкладку «Inlinks».

3. В нижнем окне появится список всех страниц, где были найдены битые ссылки.

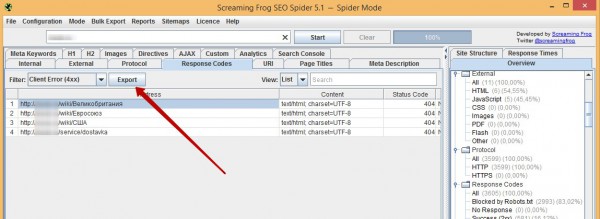

Экспорт битых ссылок

Списки битых ссылок можно экспортировать в форматах csv, xls и xlsx.

1. Нажимаем кнопку «Export»:

2. В появившемся диалоговом окне выбираем необходимый формат экспорта и место, куда сохранять файл со списком нерабочих ссылок.

Вот таким несложным способом можно проверить сайт на наличие битых ссылок с помощью программы Screaming Frog SEO Spider.

Плюсы Screaming Frog SEO Spider:

- Скорость работы (сайт с 4000 URL-адресов (страницы, изображения и т.д.) просканировал менее чем за минуту)

- Большой набор настроек и ручных фильтров

- Экспорт битых и сопутствующих ссылок в один из трех форматов: xls, xlsx, csv

- Есть клиенты для операционных систем Windows, Mac OS и Ubuntu

Минусы Screaming Frog SEO Spider:

- Цена лицензии

2. Netpeak Spider

Netpeak Spider – десктопное приложение для Windows, предназначенное для сканирования и анализа сайта.

Как пользоваться?

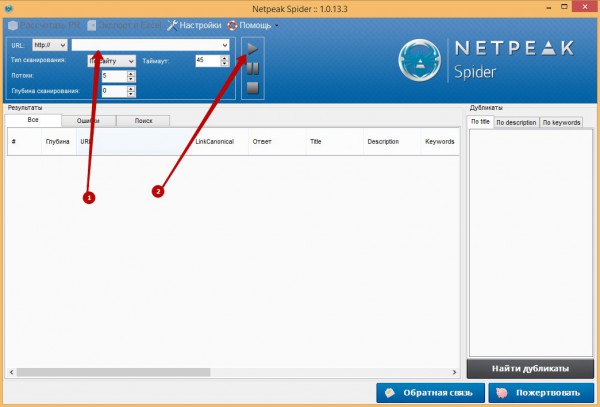

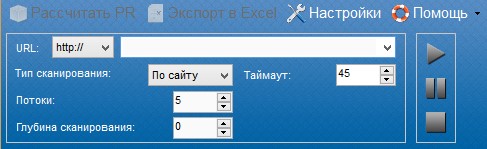

1. После установки запускаем программу, в поле (1) вписываем адрес сайта и нажимаем кнопку старта (2).

Чтобы просканировать весь сайт, рекомендуем выставить следующие настройки:

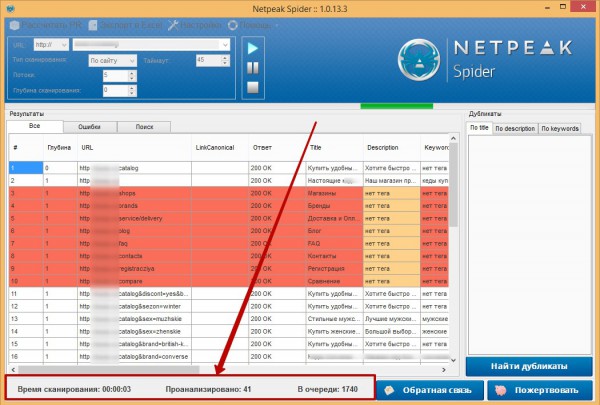

2. Процесс сканирования можно наблюдать внизу рабочего окна программы:

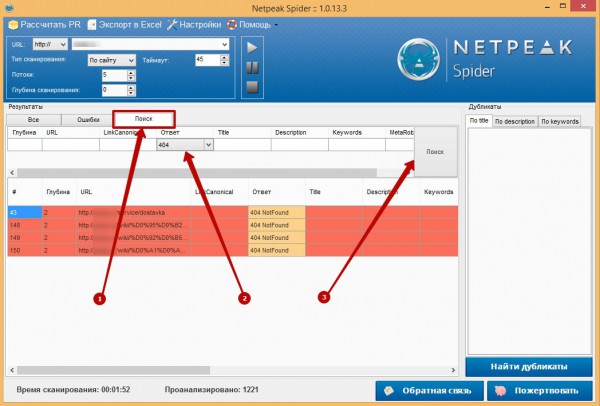

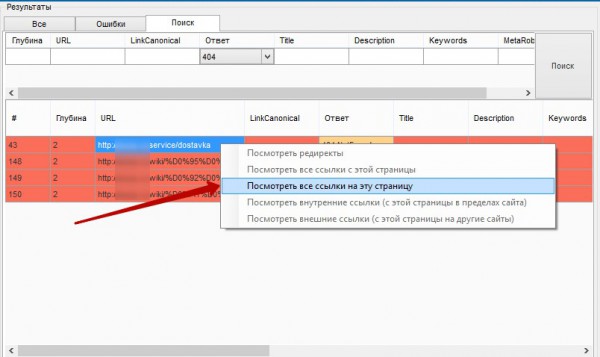

3. После того как Netpeak Spider проанализирует весь сайт, в программе будет большой список страниц. Чтобы быстро найти битые ссылки, переходим во вкладку «Поиск» (1), в фильтре «Ответ» выбираем «404» (2) и жмем кнопку «Поиск» (3).Теперь программа отобразит все URL-адреса с ошибкой 404:

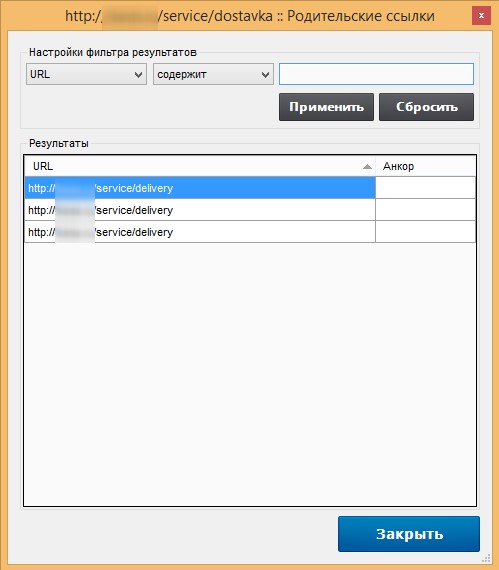

4. Чтобы узнать, на каких страницах расположены ссылки, которые ссылаются на любой из URL-адресов, нажмите левой кнопкой мыши на интересующую ссылку, а затем правой кнопкой вызовите контекстное меню и нажмите «Посмотреть все ссылки на эту страницу»:

5. В новом окне вы увидите все страницы, которые ссылаются на выбранный URL-адрес.

Преимущества:

- Бесплатная

- Простой интерфейс, который разработан для обычного пользователя

Недостатки:

- При больших объёмах сканирования программа может «тормозить»

- Работает только на Windows

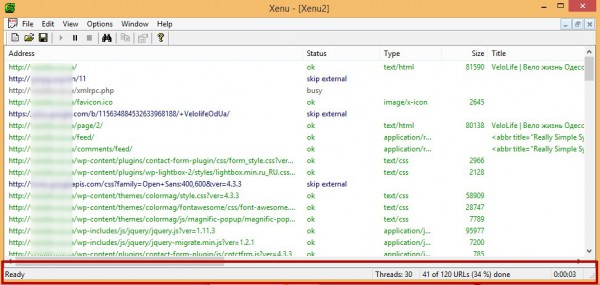

3. Xenu

Изначально поиск битых ссылок на сайте был основным предназначением этой программы, но со временем она расширилась и теперь, кроме поиска битых ссылок, может выполнять и другие функции.

Программа бесплатная, написана только для ОС Windows. Правда, разработчики на официальном сайте говорят, что для того чтобы запустить Xenu на других ОС, можно использовать «прокладки» (wine для crossover и др.).

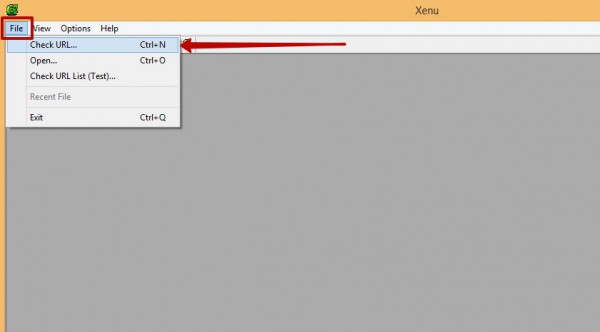

Как пользоваться?

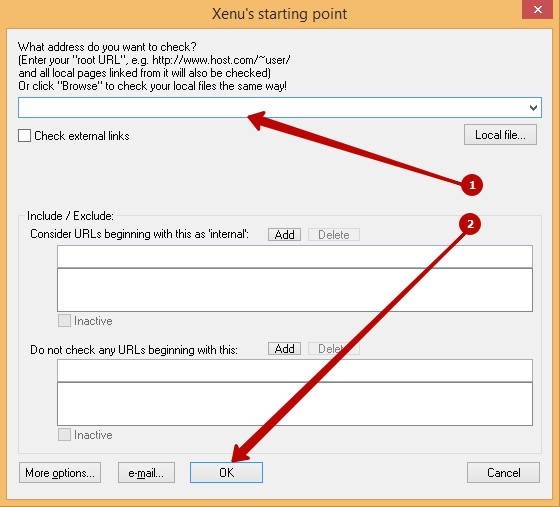

1. После установки и запуска в верхнем меню программы Xenu нажимаем «File» и в выпадающем списке выбираем «Check URL…»:

2. В появившемся окне вписываем адрес сайта, который необходимо проверить, и жмем кнопку «OK»:

Ждем, пока Xenu проверит сайт. Статус работы программы отображается в нижней части окна:

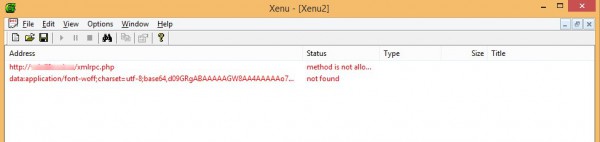

3. После анализа мы видим много разных ссылок с разными значениями. Чтобы выделить только битые ссылки, в верхнем меню нажимаем «View» и в выпадающем списке выбираем «Show brokens links only» или комбинацию клавиш Ctrl+B. Теперь отображаются только битые ссылки, которые мы и искали.

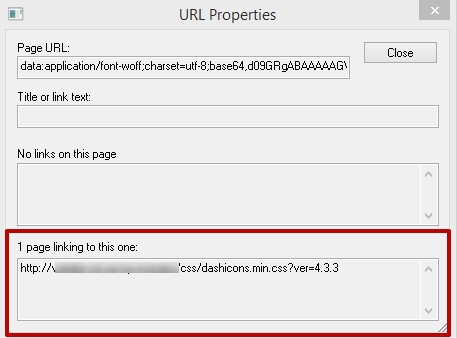

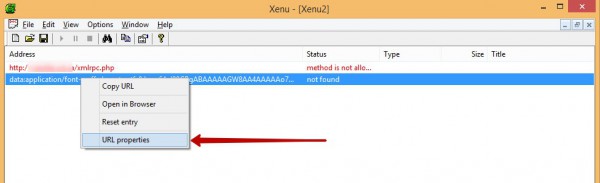

Чтобы посмотреть, где находится битая ссылка, вызовите контекстное меню правой кнопкой мыши на одной из ссылок и нажмите «URL properties»:

Возможно, это не самый удачный пример, так как тут битая ссылка находится в файле стиля, зачастую они находятся на простых страницах сайта, но суть остаётся та же. Тем более, все битые ссылки необходимо устранять, где бы они ни находились.

Нужно отметить, что Xenu проверяет сайт более детально, чем две предыдущие программы, и поэтому проверка занимает больше времени.

Преимущества:

- Глубокий анализ сайта

Недостатки:

- Анализ большого сайта может занять немало времени

- Работает только под Windows (на других ОС через «прокладку»)

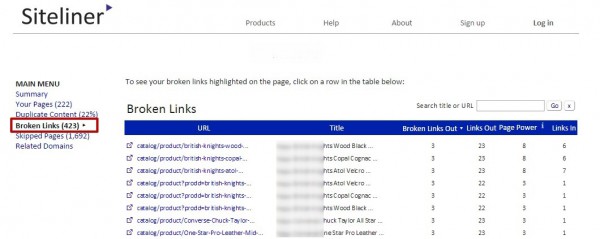

4. Онлайн-сервис Siteliner

Онлайн-сервис условно бесплатный. Бесплатно он проверяет 250 самых популярных страниц сайта, которые определяются на основе внутренней структуры ссылок. Для премиум-аккаунта есть единственное ограничение – это количество страниц сайта, которое может проверить сервис, – 25 000 страниц.

Как пользоваться?

Он простой в использовании – чтобы найти битые ссылки на сайте с помощью Siteliner, нужно:

1. Перейти на страницу сервиса.

2. Ввести адрес сайта в поле на странице и нажать кнопку «Go».

3. После того как Siteliner просканирует ваш сайт полностью, на странице появится отчет. Нам нужна страница «Broken Links».

На странице «Broken Links» выводятся все страницы сайта, на которых находится хотя бы одна битая ссылка. Количество битых ссылок на странице отображается в столбце «Broken Links Out».

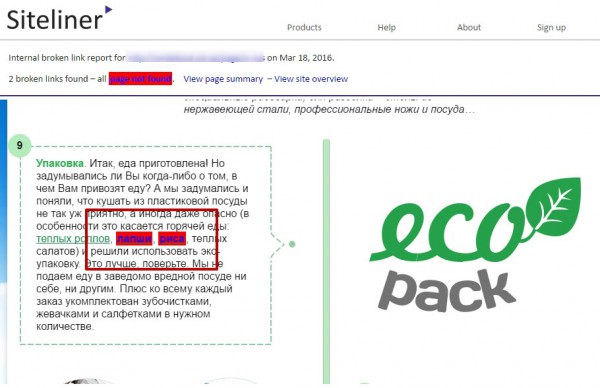

Если мы нажмем на одну из ссылок столбца «URL», то попадем на страницу анализируемого сайта, на которой битые ссылки будут выделены. Пример на скриншоте:

Преимущества:

- Web-сервис

- Скорость проверки выше, чем у десктоп-приложений

- Наглядно отображает битую ссылку на странице

Недостатки:

- Не выводит список битых ссылок, а выводит URL-адреса, где были найдены битые ссылки

Мы рассмотрели 4 сервиса, которые помогут найти битые ссылки. Я при поиске битых ссылок на сайте отдаю предпочтение Screaming Frog SEO Spider Tool и Siteliner.

- Screaming Frog SEO – простота, скорость, удобство

- Siteliner – скорость работы и «наглядность»

Первый сервис отображает все битые ссылки и списки страниц, которые ссылаются. Второй – выводит список страниц, на которых присутствуют битые ссылки, и наглядно выделяет их на странице.

Повторюсь, битые ссылки – не самый главный фактор, который влияет на ранжирование сайта в поисковых системах, но обращать внимание на битые ссылки стоит – исправлять ошибки и стараться не допускать их в дальнейшем. Но так как эта задача не всегда реализуема, рекомендую периодически проверять сайт на битые ссылки.

А что используете в работе вы? Делитесь своими предпочтениями в комментариях!

Наверх

Еще по теме:

- Word Keeper vs Key Collector

- 9 бесплатных SEO-инструментов при работе с сайтом

- 20 возможностей Google Sheets, которые сэкономят время SEO-оптимизатору: функции, плагины, макросы

- 7 бесплатных SEO-сервисов для аудита сайта

- Автоматизированный парсинг сайтов

Скорость сбора фраз Количество фраз Скорость сбора частот Точность Гибкость настроек Цена Итог Для большинства SEO-специалистов Key Collector является основным инструментом по сбору семантики. Отличную…

Бесплатные инструменты для технического анализа Парсинг Website auditor от SEO Powersuite Перелинковка PageWeight Lite Free Version Скорость gtmetrix.com batchspeed.com Бесплатные инструменты для анализа структуры сайта…

Сегодня Google Spreadsheets является достойной заменой столь необходимой для каждого оптимизатора программы – Microsoft Excel. Конечно, многий функционал урезан и там, где в Excel было…

В процессе продвижения и аудита сайтов SEO-специалистам часто приходится использовать различные сервисы и инструменты, которые облегчают сбор, группировку, анализ данных. Большинство популярных сервисов, как известно,…

1. Что такое парсинг сайтов2. Зачем и когда используют парсинг3. Как парсить данные с помощью различных сервисов и инструментов Google Spreadsheet Функция importHTML Функция importXML…

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

Мифы о страницах 404, инструменты и сервисы для поиска битых ссылок и методы работы с ними.

В статье:

-

Чем вредны битые ссылки на сайте

-

Как искать битые ссылки

-

Что делать с битыми ссылками

Представим, что веб-мастер написал статью и поставил ссылку на Википедию. Страницу удалили, веб-мастер об этом не знает, ссылка на его сайте все еще стоит, но теперь ведет на страницу 404. Или представим веб-мастера, который переместил товар в новую категорию или настроил ЧПУ, но забыл сделать редиректы со старых URL. Теперь старые ссылки на товары ведут на несуществующие страницы.

Такие ссылки, ведущие в никуда, называют битыми. Они могут быть внутренними — ведущими на страницы своего сайта, или внешними — на страницы стороннего проекта.

Битые ссылки — это гиперссылки, которые ведут на несуществующие файлы или страницы ресурса.

Страницы отдают серверу код ответа 404 Not Found — он означает, что сам сервер найден, но документа по такому адресу не существует, имя файла в коде и на сервере не совпадает. К примеру, файл на сервере удалили или переместили, и теперь он доступен по новому адресу.

Если таких ссылок на сайте много, становится интересно, может ли это негативно повлиять на SEO и позиции сайта. Разберемся, что об этом говорят представители ПС.

Чем вредны битые ссылки на сайте

Битые ссылки вредят SEO: уводят посетителей, ухудшают поведенческие факторы и увеличивают отказы. Пользователь надеялся получить дополнительную информацию, а по ссылке ошибка — ожидания не оправдались. Если он перешел на страницу, где 404, он может совсем закрыть вкладку с сайтом и пойти к конкурентам.

Такие ссылки участвуют во внутренней перелинковке и нарушают распределение ссылочного веса, перетягивая на себя часть авторитетности донора.

Битым ссылкам часто приписывают лишний негатив. В статьях про краулинг встречается информация, что битые ссылки отрицательно влияют на краулинговый бюджет — ресурсы, которые ПС выделяет на сканирование сайта. Пишут, что краулер потратит лимиты на бесполезный обход битых ссылок и из-за этого проигнорирует важные страницы.

По словам Джона Мюллера, сотрудника Google, это не так: 4хх ошибки не приводят к снижению краулингового бюджета. Бот повторно сканирует эти страницы, чтобы убедиться, что они закрыты, но делает это не в ущерб остальным страницам.

Еще Джон Мюллер отмечает, что неважно, сколько страниц с ошибками 404 есть на сайте, фактом своего наличия они не могут снизить рейтинг остальных страниц.

4хх ошибки не крадут бюджет краулера.

Но это касается не всех страниц 4хх. В блоге Google перечисляют страницы, которые негативно влияют на распределение бюджета, и среди них есть «мягкие страницы ошибок», то есть 404 SOFT.

404 SOFT возникают, если для несуществующей страницы сервер должен ответить кодом 404 или 410, а вместо этого отвечает HTTP-кодом ответа 200 OK. В таком случае краулер воспринимает страницу как обычно, сканирует ее и тратит краулинговый бюджет вместо обхода действительно важных страниц.

Ошибки 404 SOFT тратят краулинговый бюджет.

Большое количество страниц 404 точно не принесет никакого положительно эффекта, а навредить может, поэтому лучше их исправить. Найти страницы 404 помогут специальные сервисы и инструменты.

Как искать битые ссылки

Для совсем небольших сайтов можно обойтись ручным способом — пролистать все страницы и посмотреть все ссылки на сайте или посмотреть ссылки из выдачи ПС по запросу «site: вашсайт.ру»

Сервисы могут показывать неточные результаты, так что комбинируйте несколько инструментов, чтобы найти как можно больше страниц с ошибками.

Google Search Console

Страницы с ошибками консоль отображает в разделе «Сканирование» — «Ошибки сканирования».

В консоли перечислены ссылки на момент последнего обхода сайта краулером, поэтому в режиме реального времени отследить ссылки не получится.

Удобно отслеживать 404 ошибки можно с помощью Google Tag Manager. Как это сделать — в руководстве.

Яндекс.Вебмастер

Сервис отображает битые ссылки в разделе «Внутренние ссылки» — «Неработающие внутренние ссылки на сайте». Он покажет примеры внутренних неработающих ссылок по данным последнего обхода сайта ботом Яндекса.

Online Broken Link Checker

Англоязычный онлайн-инструмент для проверки битых ссылок. Бесплатно проверяет до 3000 страниц, смотрит только HTML-документы, то есть ссылок на изображения, видео и другое мультимедиа не будет.

Если вам нужно просканировать больше страниц, проверить подпапки (URL-адреса с /) или отдельные страницы, экспортировать результаты в MS Excel, авторы инструменты предлагают связаться с ними.

Netpeak Spider

Русскоязычная программа для анализа ссылок на сайте. Есть бесплатная версия со всеми функциями, но без возможности копировать, экспортировать и сохранять отчёты.

(Пример анализа сайта программой: netpeak spider ru screen.jpg)

Спайдер анализирует неограниченное количество URL на предмет битых ссылок, картинок, редиректов, а также имеет дополнительные возможности — формирование интерактивных отчётов, интеграции с GA, GSC и Яндекс.Метрика, мульти-доменное сканирование, проверка AMP и разметки и многое другое. Стоит 374,40 долларов в год.

Xenu’s Link Sleuth

Бесплатная англоязычная программа для анализа ссылок на сайте. Инструмент захватывает корневую страницу и проверяет ее, переходя на отдельные ссылки для поиска ошибок. Есть настройка работы программы с фильтрами и количеством одновременных потоков проверки.

После завершения проверки Xenu’s Link Sleuth генерирует HTML-отчет с результатами.

Работает бесплатно, но проверка больших ресурсов занимает довольно много времени.

Screaming Frog

Англоязычная программа для анализа ссылок на сайте. Есть бесплатная версия с проверкой 500 страниц.

Платный тариф открывает неограниченное количество страниц для анализа и дополнительные возможности — формирование отчетов, интеграцию с GA, сканирование и проверка AMP и разметки и другие. Стоит 149 евро в год.

Broken Link Checker, плагин для WordPress

Плагин отслеживает ссылки на страницах сайта — в блоге, комментариях и меню — и оповещает веб-мастера через панель инструментов или по электронной почте о том, что ссылка стала битой. Настройки позволяют работать с этими ссылками — запрещать поисковым ботам переходить по ним, менять и исправлять ссылки внутри плагина, не редактируя сам пост.

Доступен бесплатно, есть русификация.

Расширение Check My Links для Google Chrome

Оно подходит для проверки конкретных страниц, позволяет наглядно увидеть местоположение ссылок и их вид.

После установки расширения в браузере в правом верхнем углу появится иконка. Перейдите на нужную страницу, где будете анализировать ссылки, и кликните на иконку. Расширение проверит ссылки, выведет счетчик и подкрасит ссылки цветами. Ссылки, ведущие на страницы 404, будут красными.

Расширение работает бесплатно, но подходит для небольших сайтов или работы с конкретными страницами.

Как проверить код ответа сервера на странице

Узнать, какой код ответа возвращается по URL, к примеру, можно с помощью инструмента проверки URL в консоли веб-мастера.

На странице может быть 404, потому что на ней слишком мало контента, ссылки на ней ведут на недоступные ресурсы, запрещенные к доступу в robots.txt. Или ресурсов наоборот слишком много, они много весят и слишком долго обрабатываются.

Проверить внешние ссылки на сайт можно с помощью сервиса Анализ сайта. Он посчитает их количество, оценит доли SEO- и естественных ссылок, а новые ссылки соберет в список и покажет анкоры.

Попробовать сервис

Что делать с битыми ссылками и несуществующими страницами

Итак, с помощью сервисов вы нашли ссылки, которые ведут на недоступные страницы. Варианты дальнейших действий зависят от самой ссылки.

Внешняя битая ссылка

Ссылка с вашего сайта ведет на сайт партнера, но конечная страница не работает. Найдите такие ссылки и удалите, если содержание не пострадает, или замените на актуальные. Если это коммерческая ссылка, которую нельзя удалить и заменить, свяжитесь с партнером и скажите о проблеме с его ресурсом.

На поиске ссылок на страницы 404 на чужих сайтах базируется один из методов получения обратных ссылок. Веб-мастеры отслеживают трафиковые статьи по своей теме, находят в материале ссылки, которые ведут на 404, и пишут свои посты на эту тему. Потом они пишут автору блога и предлагают заменить битую ссылку на их материал. Выигрывают обе стороны: веб-мастер получает ссылку на свой сайт, а автор блога закрывает битую ссылку хорошим материалом и не отправляет пользователей читать несуществующую страницу.

Внутренняя битая ссылка

Что делать с битыми ссылками внутри своего сайта, варианты:

- Если страницу по ссылке удалили случайно, восстановите ее.

- Замените битую ссылку в тексте актуальным линком на страницу.

- Если существует страница с аналогичным контентом по новому адресу, к примеру, если вы переместили товар в другую категорию с изменением URL, настройте 301 редирект.

- Если замены для такой страницы нет, удалите ссылку.

Почитать по теме:

Как удалить устаревший контент из поисковых систем Яндекс и Google

Что делать с недоступными страницами

Даже если вы удалите все ссылки на несуществующие страницы, они все равно будут появляться — пользователь ошибется в адресе, произойдет технический сбой или что-то еще, поэтому рекомендуем сделать настройку.

Страница с ошибкой должна возвращать код ответа 404 (недоступно) или 410 (удалено), но не 220 ОК. Код 410 сервер посылает, если ресурс удален и недоступен, а расположение копии неизвестно. Если документ может быть восстановлен, то лучше передать 404.

Стандартная страница 404 побуждает закрыть вкладку. Настройте свою страницу 404, чтобы возвращать пользователей на сайт и направлять на целевые страницы. Разместите на ней навигацию к работающим разделам сайта, ссылку на главную или что-то смешное и интересное. Это позволит вернуть пользователей к работе с сайтом и оставить хорошее впечатление о компании.

Следующий шаг — разобраться со страницами, которых не существует. Ссылки на них все еще могут быть в индексе ПС, поэтому их нужно удалить.

Как удалить несуществующие страницы из индекса

Удалить страницы из индекса можно через панели веб-мастеров Яндекс и Google.

Чтобы страница удалилась из индекса, сервер при обращении к ней должен возвращать ошибку 404. Если страница существует, но не должна участвовать в поисковой выдаче, закройте ее от индексации правилами robots.txt или мета-тегом noindex.

При следующем обходе сайта роботом запросы на удаление будут выполнены, а страницы исчезнут из результатов поиска.