Анализ связи между двумя переменными

Хотя результаты одномерного

анализа данных часто имеют самостоятельное

значение, большинство исследователей

уделяют основное внимание анализу

связей между переменными. Самым простым

и типичным является случай анализа

взаимосвязи (сопряженности) двух

переменных. Используемые здесь методы

задают некоторый логический каркас,

остающийся почти неизменным и при

рассмотрении более сложных моделей,

включающих множество переменных.

Устойчивый интерес социологов к

двумерному и многомерному анализу

данных объясняется вполне понятным

желанием проверить гипотезы о причинной

зависимости двух и более переменных.

Ведь утверждения о причинных взаимосвязях

составляют фундамент не только социальной

теории, но и социальной политики (по

крайней мере, так принято считать). Так

как возможности социологов проверять

причинные гипотезы с помощью эксперимента,

как уже говорилось, ограниченны, основной

альтернативой является статистический

анализ неэкспериментальных данных. В

общем случае для демонстрации

причинно-следственного отношения между

двумя переменными, скажем, X

и Y,

необходимо выполнить следующие

требования:

1) показать, что существует эмпирическая

взаимосвязь между переменными;

2) исключить возможность

обратного влияния Y

на X;

3) убедиться, что взаимосвязь между

переменными не может быть объяснена

зависимостью этих переменных от какой-то

дополнительной переменной (или

переменных).

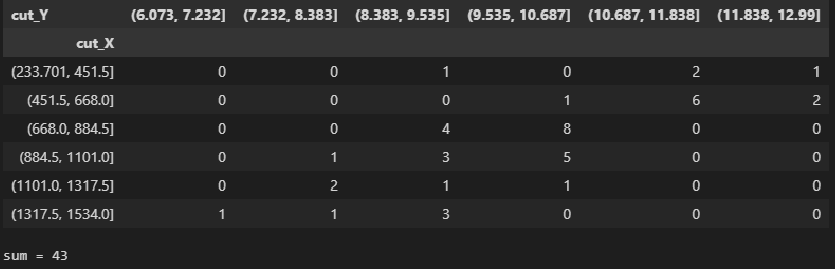

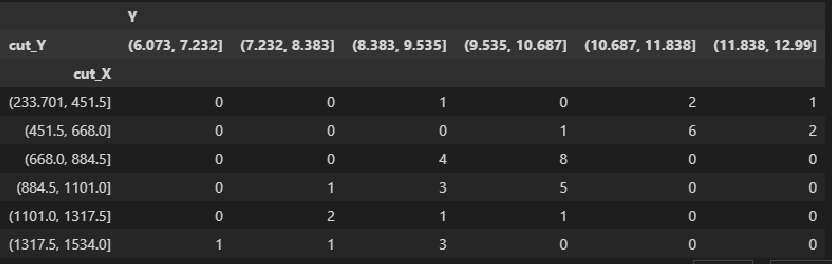

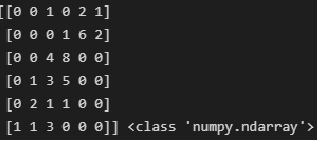

Первым шагом к анализу

взаимоотношений двух переменных является

их перекрестная

классификация, или

построение таблицы

сопряженности. Речь

идет о таблице, содержащей информацию

о совместном распределении переменных.

Допустим, в результате одномерного

анализа данных мы установили, что люди

сильно различаются по уровню заботы о

своем здоровье: некоторые люди регулярно

делают физические упражнения, другие

– полностью пренебрегают зарядкой. Мы

можем предположить, что причина этих

различий – какая-то другая переменная,

например, пол, образование, род занятий,

доход и т. п.

Пусть мы располагаем

совокупностью данных о занятиях

физзарядкой и образовании для выборки

горожан. Для простоты мы предположим,

что обе переменные имеют лишь два уровня:

высокий и низкий. Так как данные об

образовании исходно разбиты на большее

количество категорий, нам придется их

перегруппировать, разбив весь диапазон

значений на два класса. Предположим, мы

выберем в качестве граничного значения

10 лет обучения, так что люди, получившие

неполное среднее и среднее образование,

попадут в «низкую» градацию, а остальные

– в «высокую». (Это, конечно, большое

огрубление, но мы используем его из

соображений простоты.) Для занятий

физическим^ упражнениями мы соответственно

воспользуемся двумя категориями –

«делают физзарядку» и «не делают

физзарядку». Таблица

8.3 показывает, как могло

бы выглядеть совместное распределение

этих двух переменных.

Таблица 8.3 Взаимосвязь

между уровнем образования и занятиями

физкультурой

-

Уровень

образованияВсего

Высокий

Низкий

Делают

зарядку50

200

250

Не делают

зарядку205

45

250

Всего

255

245

500

В таблице 8.3

два столбца (для образования) и две

строки (для занятий физкультурой),

следовательно, размерность этой таблицы

2х2. Кроме того, имеются дополнительные

крайний столбец и крайняя строка

(маргиналы таблицы), указывающие общее

количество наблюдений в данной строке

или в столбце. В правом нижнем углу

указана общая сумма, т. е. общее число

наблюдений в выборке. Не давшие ответа

уже исключены (для реальных данных их

число также стоит указать, но не в

таблице, а в подтабличной сноске). Заметим

здесь, что многие исследователи при

построении таких таблиц пользуются

неписаным правилом: для той переменной,

которую полагают независимой, отводится

верхняя строка (горизонталь), а зависимую

располагают «сбоку», по вертикали

(разумеется, соблюдение этого правила

не является обязательным и ничего с

точки зрения анализа не меняет).

Обычно характер взаимоотношений

между переменными в небольшой таблице

можно определить даже «на глазок»,

сравнивая числа в столбцах или строках.

Еще легче это сделать, если вместо

абсолютных значений стоят проценты.

Чтобы перевести абсолютные частоты,

указанные в клетках таблицы, в проценты,

нужно разделить их на маргинальные

частоты и умножить на 100. Если делить на

маргинал столбца, мы получим процент

по столбцу. Например,

50/255х100 = 19,6%, т. е. 19,6% имеющих

низкий уровень образования делают

зарядку (но не наоборот!). Если делить

на маргинал строки, то мы получим другую

величину –процент по

строке. В частности,

можно заметить, что 80% делающих зарядку,

составляют люди с высоким уровнем

образования(200/250х100). Деление на общую

численность выборки дает общий процент.

Так, всего в выборке 50% людей, делающих

зарядку.

Так как вывод о наличии

взаимосвязи между переменными требует

демонстрации различий между подгруппами

по уровню зависимой

переменной, при анализе

таблицы сопряженности можно

руководствоваться простыми правилами.

Во-первых, нужно определить независимую

переменную и, в соответствии с принятым

определением, пересчитать абсолютные

частоты в проценты. Если независимая

переменная расположена по горизонтали

таблицы, мы считаем проценты по столбцу;

если независимая переменная расположена

по вертикали, проценты берутся от сумм

по строке. Далее сравниваются процентные

показатели, полученные для подгрупп с

разным уровнем независимой переменной,

каждый раз внутри

одной категории зависимой переменной

(например, внутри категории делающих

зарядку). Обнаруженные различия

свидетельствуют о существовании

взаимосвязи между двумя переменными.

(В качестве упражнения примените

описанную процедуру к таблице

8.3, чтобы убедиться в

наличии связи между уровнем образования

и занятиями физкультурой.)

Отметим специально, что

элементарная таблица сопряженности

размерности 2х2 – это минимально необходимое

условие для вывода о наличии взаимосвязи

двух переменных. Знания о распределении

зависимой переменной недостаточно.

Нельзя, например, утверждать, будто из

того, что 75% детей-первенцев имеют

интеллект выше среднего, а 25% – средний

и более низкий, следует зависимость

между порядком рождения и интеллектом.

Необходимо проанализировать и

распределение показателей интеллекта

для детей-непервенцев. Варьировать

должна не только зависимая, но и

независимая переменная.

Таблица 8.4 Oбщая

форма таблицы сопряженности размерности

2х2

-

Переменная

ХВсего

0

1

Переменная

У0

а

б

А+б

1

с

д

С+д

Всего

А+с

Б+д

n

довольно ясно показывает, что всякое

приращение в размерах партийной кассы

(сдвиг вправо по оси Х)влечет за

собой увеличение парламентского

представительства (сдвиг вверх по

оси ординат). Между переменнымиХиYсуществуетлинейное отношение:если одна переменная возрастает по

величине, то это же происходит и с другой.

Помимо указания на природу отношения

двух переменных, диаграмма нарисунке

21позволяет также сделать некоторые

предположения обинтенсивности,силе этого отношения. Очевидно, что чем

более компактно, «скученно»

располагаются точки-наблюдения вокруг

пунктирной прямой линии (описывающейидеальное линейное отношение Х иY), тем сильнее зависимость. Нарисунке

22приведены еще три диаграммы

рассеивания.

Очевидно, что на рисунке 22акакая-либо

связь между x

и

y попросту

отсутствует. Нарисунке

22бвоображаемая прямая линия

(отмечена пунктиром) пересекла бы

диаграмму сверху вниз, из левого верхнего

в правый нижний угол. Иными словами,

линейная связь в этом случае имеет

обратное направление:

чем больше X,тем меньше зависимая переменная У.

Заметим также, что «кучность»

расположения точек вдоль воображаемой

прямойна рисунке 226не очень велика, а значит и связь

(корреляция) между переменными не только

обратная, отрицательная, но еще и не

очень сильная, умеренная. Наконец,на

рисунке 22в зависимую и независимую

переменную связывает явно нелинейное

отношение: воображаемый график

нисколько не похож на прямую линию и

напоминает скорее параболу12.

Отметим, что методы анализа, о которых

сейчас пойдет речь, не годятся для этого

нелинейного случая, так как обычная

формула для подсчета коэффициента

корреляции даст нулевое значение, хотя

связь между переменными существует.

Существует обобщенный показатель,

позволяющий оценить, насколько связь

между переменными приближается к

линейному функциональному отношению,

которое на диаграмме рассеивания

выглядит как прямая линия. Это коэффициент

корреляции,измеряющий тесноту связи

между переменными, т. е. их тен-денцию

изменяться совместно. Как и в рассмотренных

выше мерах связи каче-ственных признаков,

коэффициент корреляции позволяет

оценить возможность предсказания

значений зависимой переменной по

значениям независимой. Общая формула

для вычислениякоэффициента корреляции

Пирсонавключает в себя величинуковариациизначенийXиY.

Эта величина (sxy)характеризует совместное изменение

значений двух переменных. Она задается

как сумма произ-

12

Именно так обычно выглядит зависимость

между благожелательностью установки

по отношению к некоторому объекту

(X)

и интенсивностью установки (Y):

люди, занимающие крайне благожелательную

или крайне неблагожелательную позицию

в каком-то вопросе, обычно оценивают

свои убеждения как более выраженные и

интенсивные, чем те люди, чьи установки

лежат в области середины, «нейтральных»

значений шкалы.ведений отклонений

наблюдаемых значений Х

и У от средних X

и Y

соответственно, т. е. Ei=1n

(Xi

– Х )(Yi

–

Y

),

деленная на количество наблюдений.

Чтобы понять «физический смысл»

ковариации, достаточно обратить внимание

на следующее ее свойство: если для

какого-то объекта

i

в выборке оба значения

—X,

и

Y,—

окажутся высокими, то и произведение

(Хi

– Х)

на (Yi

– Y)

будет большим и положительным. Если

оба значения (по Х

и по Y)

низки, то произведение двух отклонений,

т. е. двух отрицательных чисел, также

будет положительным. Таким образом,

если линейная связь Х

и Y

положительна и велика, сумма таких

произведений для всех наблюдений также

будет положительна. Если связь между Х

и У обратная,

томногимположительным

отклонениям по Х

будут

соответствовать отрицательные

отклонения по Y,

т. е. сумма отрицательных произведений

отклонений будет отрицательной.

Наконец, при

отсутствии систематической связи

произведения будут иногда положительными,

иногда отрицательными, а их сумма (и,

следовательно, ковариация Х

и Y)

будет, в пределе, равна нулю. Таким

образом, ко вариация показывает

величину и направление связи, совместного

изменения Х

и У. Если разделить ковариацию

sxy

на стандартные отклонения

sx

и sy

(чтобы избавиться от влияния масштаба

шкал, в которых измеряются X

и Y),

то мы получим искомую формулу коэффициента

корреляции Пирсона

(rxy):

![]()

Более удобная для практических вычислений

расчетная формула выглядит так:

Несмотря на несколько устрашающий вид,

расчетная формула очень проста. Для

«ручного» вычисления rxy,вам понадобятся лишь пять величин: суммы

значений поXиY(Ei=1nХiиEi=1nYi),

суммы квадратов значений поХ и

Y (Ei=1nХ2иEi=1nY2),

суммы произведенийХ иYпо всем

объектам-«случаям» (Ei=1n

XiYi).

В таблице 8.11приведены данные о максимальных дневных

и ночных температурах, зарегистрированных

в 10городах13.

Просуммировав значения в столбцах, мы

получим E10 i=1Хi

=258иE10 i=1 Yi=156.

Возведя каждое из значений Х и

Yв квадрат и просуммировав, мы

найдем, чтоE10 i=1Хi2

= 7180иE10 i=1

Yi2

= 2962.Сумма попарных произведенийХiиYi(E10

i=1 XiYi)

составит 4359.Вы можете

самостоятельно убедиться в том, что

подстановка всех значений в расчетную

формулу даст (надеюсь) величинуrxy=0,91.

Иными словами, корреляция между дневными

и ночными температурами воздуха очень

высока, но все же отлична от

1,0(коэффициент корреляции может

меняться в пределах от-1,0 до

+1,0).Это отличие, вероятно, объясняется

влиянием других факторов (продолжительность

дня и ночи, облачность, географическое

положение и т. п.). Судя по полученной

величине корреляции, знание дневных

температур позволяетпредсказыватьночные температуры с очень высокой

точностью, но не безошибочно.

13Погода (Гидрометцентр

РФ) //Сегодня.

1994. 23авг.

|

Таблица 8.11 |

||

|

Город |

Дневная температура воздуха |

Ночная температура воздуха |

|

Лондон |

16 |

11 |

|

Париж |

21 |

12 |

|

Стокгольм |

20 |

12 |

|

Варшава |

25 |

14 |

|

Бонн |

25 |

16 |

|

Рим |

36 |

23 |

|

Тель-Авив |

31 |

23 |

|

Анкара |

32 |

15 |

|

Каир |

36 |

22 |

|

Москва |

16 |

8 |

|

N=10 |

Величина, которая равна квадрату

коэффициента корреляции Пирсона, т. е.

г, имеет ряд интересных статистических

свойств. Отметим сейчас, что r2является ПУО-мерой связи, подобной

обсуждавшимся выше (см. с.

176—179).Можно показать, что она

характеризует ту долю дисперсии значенийY, которая объясняется наличием

корреляции междуХ и Y.(Естественно, величинаr2будет

всегда положительной и не может

превзойти по абсолютной величине

коэффициент корреляции.)14Та

часть разброса в значенияхY, которая

не может быть предсказана по значениям

X,—этодисперсия

ошибки нашего прогноза,т. е.

1 –r2.Необъясненный

разброс в значенияхУприсутствует

в том случае, когда при равных уровнях

Х (ср., например, дневные температуры

в Варшаве и Бонне изтаблицы

8.11) сохраняются различия в

значенияхY.

Коэффициент корреляции позволяет

оценить степень связи между переменными.

Однако этого недостаточно для того,

чтобы непосредственно преобразовывать

информацию, относящуюся к одной

переменной, в оценки другой переменной.

Допустим, мы выяснили, что коэффициент

корреляции между переменными «величина

партийного бюджета» и «число мест в

парламенте» равен 0,8.Можем ли мы теперь предсказать, сколько

мест в парламенте получит партия,

годовой бюджет которой равен

100млн рублей? Похоже, что знание

величины коэффициента корреляции нам

здесь не поможет. Однако мы можем

вспомнить, что коэффициент корреляции

—это еще и оценка соответствия

разброса наших наблюдений той

идеальной модели линейного функционального

отношения, которое на рассмотренных

выше диаграммах рассеивания (см.рис.

21—22)представлено пунктирными

прямыми. Эти линии называютлиниями

регрессии.

Если бы все наблюдения аккуратно

«укладывались» на линию регрессии, то

для предсказания значения зависимой

переменной достаточно было бы восстано

вить перпендикуляр к оси

Y из той точки прямой, которая

соответствует известному значению

X.

14Подробный анализ

можно найти в большинстве руководств

по прикладной статистике. Здесь

мы ограничимся обсуждением общей логикиоценки объясненной дисперсии.

На рисунке 23показано, как можно было бы графически

определить ожидаемые значенияYдля гипотетического примера с партийной

кассой и местами в парламенте. (Разумеется,

найти искомое значение У можно и без

линейки, с помощью вычислений, если

известен угол наклона регрессионной

прямой и точка пересечения с осью

ординат.)

Как говорилось выше, линия регрессии

не обязательно должна быть прямой, но

мы ограничимся рассмотрением самого

простого случая линейной зависимости(нелинейные связи во многих случаях

также могут быть приближенно описаны

линейными отношениями).

Существуют специальные статистические

процедуры, которые позволяют найти

регрессионную прямую, максимально

соответствующую реальным данным.

Регрессионный анализ, таким образом,

дает возможность предсказывать

значенияYпо значениям Х с

минимальным количеством ошибок.В

общем виде уравнение, описывающее прямую

линию регрессии Y

no X,выглядит

так:

Y=ayx

+byx

X,

где Y—то предсказываемое значение по переменнойY(в только что рассмотренном

примере —количество

мест в парламенте),а —это точка, в которой прямая пересекает

осьY(т. е. значение Y для случая,

когдаX=0), и b—коэффициент

регрессии, т. е. наклон прямой. Часто

удобно измерять обе переменные не в

«сырых» шкалах, а в единицах отклонения

от среднего. Процедурастандартизации,т. е. перевода исходной шкалы в стандартные

Z-оценки,вам уже известна (см. с.

169).Преимущество использования

стандартизированных переменных в

регрессионном анализе заключается в

том, что линия регрессии в этом случае

проходит через начало координат.

Стандартизованный коэффициент

регрессии (наклон прямой) обозначают

обычно греческой буквой b(либо лат. b*).Правда, в отличие от b-коэффициента,

bне позволяет

прямо заключить, на какое количество

исходных единиц возрастет У при увеличенииХна одну единицу (например, насколько

увеличится число депутатских мандатов

при увеличении бюджета на 1млн рублей или насколько увеличивается

заработная плата при увеличении

стажа работы на один год). С другой

стороны, bпозволяет сопоставить

влияние на независимую переменную

контрольных переменных, измеренных в

разных шкалах.

Социологи обычно осуществляют

регрессионный анализ, используя

возможности распространенных

прикладных пакетов компьютерных программ

(например, SPSS).В этом

случае для нахождения линии регрессии,

лучше всего соответствующей данной

выборке наблюдений, которая представлена

точками на диаграмме рассеивания,

используют метод минимизации взвешенной

суммы квадратов расстояний между этими

точками и искомой прямой15.

Хотя здесь не место для обсуждения

статистических деталей, мы все же

сделаем несколько замечаний,

относящихся к осмысленному (или

бессмысленному) использованию техники

линейной регрессии.

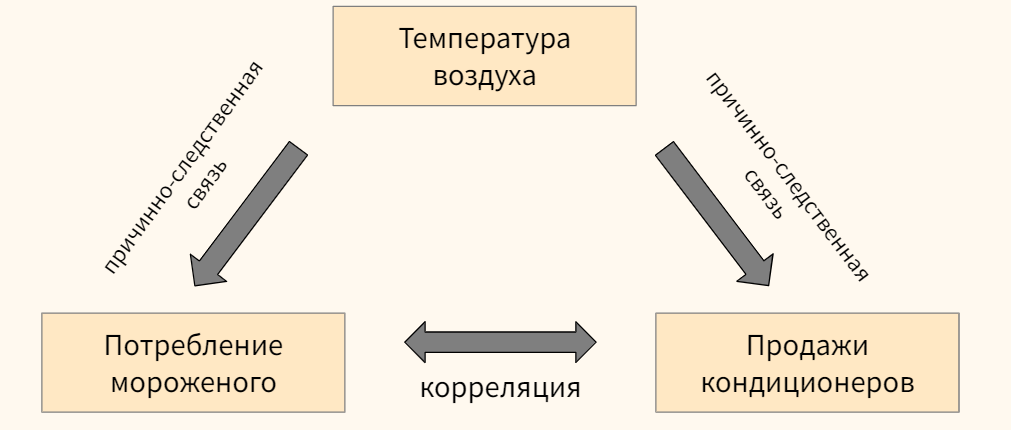

Во-первых, как и в ранее обсуждавшихся

примерах анализа связи, наличие

координации, согласованности в

изменениях двух переменных еще не

доказывает, что обнаруженное отношение

носит собственно каузальный характер.

Проверка альтернативных причинных

моделей, иначе объясняющих эмпирическую

сопряженность переменных-признаков,

может основываться только на содержательных

теоретических представлениях.

Далее, нужно помнить о том, что регрессионные

коэффициенты в общем случае

асимметричны.Если мы решим, что это

У, а неХявляется независимой

переменной, то вполне можем рассчитать

другую по величине пару коэффициентов

—аxуиbxу.(Заметьте, что порядок букв в подстрочном

индексе значим: первой всегда идет

предсказываемая переменная, а второй

—предсказывающая.) Разумеется,

при выборе кандидатов в зависимые и

независимые переменные также важны

не статистические, а содержательные

соображения.

Если вернуться к затронутой выше

взаимосвязи между линейной регрессией

и корреляцией,то здесь мы можем

сделать следующие дополнения. Пусть

все точки-наблюдения аккуратно

размещены на регрессионной прямой.

Перед нами почти невероятный случай

абсолютной линейной зависимости. Зная,

например, что коэффициентb(нестандартизованный) равен

313,мы можем утверждать, что именно

такова величина воздействия переменнойXна зависимую переменнуюY.

Кроме того, мы можем точно сказать, что

единичная прибавка в величинеXвызовет увеличениеYна ту же величину,

313(если, допустим,Х—стаж работы, а У —зарплата,

то с увеличением стажа на год зарплата

растет на313рублей). В

этом случае коэффициент корреляции

будет равен в точности 1,0, что

свидетельствует о сильном, «абсолютном»,

характере связи переменных. Различие

между предсказанными и наблюдаемыми

значениями в этом случае отсутствует.

Корреляция как мера точности прогноза

показывает, что ошибок предсказания

просто нет.

15Более детальные

сведения можно найти в статистической

литературе. Очень доступно проблема

излагается, в частности, в кн.:Гласе

Дж., Стенли Дж.Указ. соч. С.

123—141.Для тех же, кто захочет

осуществить «ручную» регрессию для

какого-либо из использованных примеров,

просто приведем формулы для вычисления

нестандартизированных коэффициентов

(обозначения те же, что и выше):

В действительности, однако, из-за влияния

других переменных и случайной выборочной

ошибки точки-наблюдения обычно лежат

выше или ниже прямой, которая, как

говорилось, является лишь наилучшим

приближением реальных данных. Коэффициент

корреляции Пирсона rи величинаr2по-прежнему служат оценкой точности

прогноза, основанного на линии регрессии.

Вполне возможны ситуации, когда

коэффициент регрессии очень велик,

воздействиеXнаYпросто громадно, но корреляция низка

и, следовательно, точность прогноза

невелика. Нет ничего необычного и в

обратной ситуации: воздействиеХ на

Y относительно мало, а коэффициент

корреляции и объясненная дисперсия

очень велики. Посмотрев на приведенные

выше диаграммы рассеивания, можно легко

уяснить себесмысл отношения между

корреляцией и регрессией:первая

имеет прямое отношение к «разбросанности»

точек наблюдения (чем выше «разбросанность»,

тем нижеr2и ненадежнее

прогноз), тогда как коэффициент регрессии

описывает наклон, «крутизну» линии.

Однако существующее здесь различие

не стоит и преувеличивать: регрессионный

коэффициент (наклон прямой) для

стандартизованных данных в точности

равен коэффициенту корреляции Пирсонаr16. 16

Легко понять, что при измерении в единицах

стандартного отклонения максимальная

связь (Р=

1,0)

соответствует ситуации, когда сдвигу

от начала координат в

1 ед.

стандартного отклонения по Х

соответствует увеличение У также на

1 ед.

стандартного отклонения. Важно

заметить, что в случае стандартизированных

переменных (и только в этом случае)

коэффициенты регрессии

Y

no

X и

X noY

будут совпадать.

Предположим, что исследователь изучает

зависимость между образованием матери

(X)и образованием

детей (Y). Обе переменные измерены

как количество лет, затраченных на

получение образования. Найдя достаточно

высокую корреляцию междуХи У—скажем, равную 0,71, —он

также находит коэффициенты регрессииаиbи устанавливает, чтоr2(называемый также коэффициентом

детерминации) в данном случае приближенно

равен 0,5.Это значит, что

доля вариации в значениях переменнойY(образование детей), объясненная

воздействием переменной-предиктораХ(материнское образование), составляет

около 50%общей дисперсии

предсказываемой переменной. Коэффициент

корреляции между переменными достаточно

велик и статистически значим даже для

не очень большой выборки. Следовательно,

обнаруженная взаимосвязь переменных

не может быть объяснена случайными

погрешностями выборки. В пользу

предложенной исследователем причинной

гипотезы говорит и то обстоятельство,

что альтернативная гипотеза

—образование детей влияет на

образовательный статус родителей

—крайне неправдоподобна и может

быть отвергнута на основании

содержательных представлений о временной

упорядоченности событий. Однако все

еще не исключены те возможности, которые

мы обсуждали в параграфе, посвященном

методу уточнения. Иными словами, нам

следует считаться с вероятностью того,

что какая-то другая переменная (или

несколько переменных) определяют и

образование родителей и образование

детей (например, финансовые возможности

либо интеллект). Чтобы проверить такую

конкурирующую гипотезу, следует

рассчитать так называемуючастную

корреляцию.Логика расчета частной

корреляции совпадает с логикой построения

частных таблиц сопряженности при

использовании метода уточнения.

Построить частные таблицы сопряженности

для различных уровней контрольной

переменной в случае, когда переменные

измерены на интервальном уровне,—

это практически неразрешимая задача.

Чтобы убедиться в этом, достаточно

подсчитать, каким должно быть количество

таблиц уже при десяти-двенадцати

категориях каждой переменной. Расчет

коэффициента частной корреляции—

это простейшее средство уточнения

исходной причинной модели при введении

дополнительной переменной. Интерпретация

коэффициента частной корреляции не

отличается от интерпретации частных

таблиц сопряженности:частной

корреляцией называют корреляцию между

двумя переменными, когда статистически

контролируется, или «поддерживается

на постоянном уровне», третья

переменная (набор переменных).

Если, предположим, при изучении корреляции

между образованием и доходом нам

понадобится «вычесть» из полученной

величины эффект интеллекта, предположительно

влияющего и на образование, и на доход,

достаточно воспользоваться процедурой

вычисления частной корреляции. Полученная

величина будет свидетельствовать о

чистом влиянии образования на доход,

из которого «вычтена» линейная

зависимость образования от интеллекта.

Мюллер и соавторы 17приводят

интересный пример использования

коэффициента частной корреляции. В

исследовании П. Риттербэнда и Р.

Силберстайна изучались студенческие

беспорядки 1968—1969гг. Одна

из гипотез заключалась в том, что

число нарушений дисциплины и демонстраций

протеста в старших классах учебных

заведений связано с различиями показателей

академической успеваемости учащихся.

Корреляция между частотой «политических»

беспорядков и средней успеваемостью

оказалась отрицательной (хуже успеваемость

—больше беспорядков) и статистически

значимой(r = -0,36).Однако

еще более высокой была корреляция между

частотой беспорядков и долей чернокожих

учащихся (r=0,54). Исследователи решили

проверить, сохранится ли связь между

беспорядками и успеваемостью, если

статистически проконтролировать

влияние расового состава учащихся.

Коэффициент частной корреляции частоты

беспорядков и успеваемостипри контролерасового состава учащихся оказался

равным нулю. Исходная корреляция между

беспорядками и успеваемостью в данном

случае может быть описана причинной

моделью«ложной взаимосвязи» (см. рис.

19):наблюдаемые значения этих двух

переменных скор-релированы лишь потому,

что обе они зависят от третьей переменной

—доли чернокожих в общем количестве

учащихся. Чернокожие студенты, как

заметили исследователи, оказались

восприимчивее к предложенным самыми

активными «политиканами» образцам

участия в политических беспорядках.

Кроме того, их успеваемость, помимо

всяких политических событий, была

устойчиво ниже, чем средняя успеваемость

белых.

Коэффициент частной корреляции между

переменными Х и. Y

при контроле дополнительной переменной

Z(т. е. при поддержании Z«на постоянном уровне») обозначают

какrxy.z.Для его

вычисления достаточно знать, величины

наблюдаемых попарных корреляций

между переменнымиX, Yи Z

(т. е.простых корреляций —rxy, ryz, rxz):

Как всякая выборочная статистика,

коэффициент корреляции подвержен

выборочному разбросу. Существует

некоторая вероятность того, что для

данной вы-

17 Mueller

J., Schuessler К., Costner

H. Statistical Reasoning in Sociology.

3rd ed. Boston:

Haighton Mifflin Co,

1977. P. 279—281.

борки будет получено ненулевое значение

коэффициента корреляции, тогда как

истинное его значение для генеральной

совокупности равно нулю. Иными словами,

существует задача оценки значимостиполученных значений корреляций и

коэффициентов регрессии, относящаяся

к области теории статистического вывода.

Описание соответствующих статистических

методов выходит за рамки этой книги,

поэтому мы рассмотрим лишь самые общие

принципы, позволяющие решать описанную

задачу в простых случаях и интерпретировать

соответствующие показатели при

использовании стандартных компьютерных

программ.

Прежде всего вероятностная оценка

коэффициента корреляции подразумевает

оценку отношения к его случайной ошибке.

Удобная, хотя и не вполне надежная

формула для вычисления ошибки коэффициента

корреляции (тr),выглядит

так18:

![]()

Всегда полезно вычислить отношение

полученной величины rк его ошибке

(т. е.r/тi).В использовавшемся

нами примере данных о погоде коэффициент

корреляции оказался равен

0,91,а его выборочная ошибка составляет:

![]()

Отношение rк mrобозначаемое как t,составит (0,91/0,573)= 15,88.Разумеется, коэффициент, превосходящий

свою случайную ошибку почти в

16раз, может быть признан значимым

даже без построения доверительных

интервалов.

Когда значение г не столь близко к

единице и выборка невелика, нужно все

же проверить статистическую гипотезу

о равенстве rнулю в генеральной

совокупности. Для этого нужно

определить tпо формуле:

где t —это величина так называемого

t-критерияСтьюдента (см. также главу

4),г —выборочный

коэффициент корреляции,п

—объем выборки. Для установления

значимости вычисленной величины

t-критерияпользуются таблицами

t-распределениядля (n – 2)степеней свободы (см.табл.

4.1).Во многих пособиях по статистике

можно найти и готовые таблицы критических

значений коэффициента корреляцииrдля данного уровня значимостиа. В

этом случае отпадает необходимость

в каких-либо вычислениях t:достаточно сравнить полученную величину

коэффициента корреляции с табличным

значением19. (Например, величина

коэффициента корреляцииr

= 0,55будет существенной на уровне

значимостир = 0,01даже

для выборки объемом 105,так как критическое значение составляет

0,254.)

18См.:Дружинин Н.

К.Логика оценки статистических

гипотез. М.: Статистика, 1973.

С. 112—114.

“См., в частности:Ликеш

И., Ляга И.Основные таблицы математической

статистики. М.: Финансы и статистика,

1985.(Табл. 14.)

Множественная регрессия

и путевой анализ

Выше описывалась модель линейной

регрессии для двух переменных. В

действительности социолог довольно

редко сталкивается со столь простыми

моделями данных. Влияние одного

фактора обычно может объяснить лишь

часть разброса наблюдаемых значений

независимой переменной. Метод частной

корреляции позволяет нам проконтролировать

эффекты воздействия любых других

контрольных переменных, которые мы в

состоянии измерить. (Стоит снова

подчеркнуть здесь, что статистические

методы изучения причинных взаимосвязей,

в отличие от экспериментальных,позволяют нам контролировать лишь те

источники вариации, которые мы способны

концептуализировать и измерить.) Однако

еще более интересной задачей является

контроль одновременного воздействиянесколькихнезависимых наоднузависимую переменную, а также сравнение

эффекта воздействия разных независимых

переменных и предсказание «отклика»

независимой переменной. Именно эти

задачи решают методы анализа, о

которых пойдет речь в данном параграфе.

Наше изложение будет неполным, так

как более детальное обсуждение требует

дополнительной математической

подготовки. Мы будем ориентироваться

на сравнительно скромные цели понимания

общей логики и интерпретации результатов

соответствующих статистических

процедур.

Уравнение множественной регрессии

—это определенная модельпорождения

данных.Важные допущения, принимаемые

в этой модели, касаются уже известного

вам требованиялинейности,а такжеаддитивностисуммарного эффекта

независимых переменных. Последнее

означает, что воздействия разных

независимых переменных просто

суммируются, а не, скажем, перемножаются

(мультипликативный эффект, в отличие

от аддитивного, имеет место тогда, когда

величина воздействия одной независимой

переменной на зависимую, в свою очередь,

находится под влиянием другой независимой

переменной, т. е. независимые переменные

взаимодействуют друг с другом).

Множественная регрессия во многом

аналогична простой (бивариантной)

регрессии. Отличие состоит в том, что

регрессия осуществляется по двум и

более независимым переменным одновременно,причем каждая из них входит в регрессионное

уравнение с коэффициентом, позволяющим

предсказать значения зависимой переменной

с минимальным количеством ошибок

(критерием здесь снова является метод

наименьших квадратов). Частные коэффициенты

в уравнении множественной регрессии

показывают, какой будет величина

воздействия соответствующей независимой

переменной на зависимуюпри контролевлияния других независимых переменных.

Если воспользоваться простейшей

системой обозначений, то уравнение

множественной регрессии для трех

независимых переменных можно записать

как:

![]()

где Y—это предсказываемое

значение зависимой переменной,X1

… Х3,—независимые переменные, аb,

…b3,

—частные коэффициенты регрессии

для каждой из зависимых переменных.

Коэффициенты bмогут быть

интерпретированы как показатели влияния

каждой из независимых переменных на

зависимую при контроле всех других

независимых переменных в уравнении.

В отличие от коэффициентов частной

корреляции коэффициенты регрессии

обладают размерностью. Они показывают,на

сколько единиц изменится зависимая

переменная при увеличении независимой

на одну единицу (при контроле всех

остальных переменных модели). Пусть,

например, мы построили уравнение

множественной регрессии, описывающее

зависимость дохода от интеллекта(Х1)и стажа работы(Х2).Если величинаb1оказалась

равной 100,это означает,

что каждый дополнительный балл по шкале

интеллекта увеличивает доход на

100рублей. Значениеb2=

950 говорит нам, что год стажа прибавляет

950рублей. Однако «сырые» оценки

интеллекта и стажа измерены в разных

единицах. Для определениясравнительной

значимостинезависимых переменных,

входящих в уравнение множественной

регрессии, мы должны подвергнуть все

переменныестандартизации(т. е.

перевести их в Z-оценки,см. выше). Стандартизованные коэффициенты

множественной регрессии, которые удобнее

всего обозначать какb*(либо греч.

«бета» — B),меняются в пределах от -1,0до +1,0.Они сохраняют свою

величину при изменении масштаба шкалы:

переход от измерения возраста в годах

к измерению в днях не изменит

соответствующийb*.

Стандартизованные коэффициенты позволяют

оценить «вклад» каждой из

переменных-предикторов в предсказание

значений независимой переменной.

Если в примере с влиянием интеллекта и

стажа работы на доход окажется, что

b1*= 0,25,

a b2*=0,30,то можно заключить, что сравнительная

значимость «веса» интеллекта и стажа

в предсказании дохода различаются

незначительно. Если же для одной

переменнойb1*

=0,80,тогда какb2*

=0,40, мы можем сказать, что эффект

воздействия второй переменной в два

раза меньше эффекта первой.

Чтобы определить ожидаемые значения

зависимой переменной для отдельных

индивидов, достаточно подставить в

уравнение множественной регрессии

соответствующие значения

переменных-предикторов и вычисленных

коэффициентов Ь.Пусть, например,

мы хотим рассчитать прогнозное значение

величины дохода для человека, чей

коэффициент интеллекта равен

110,а стаж работы — 20годам. Еслиb1,

как в вышеприведенном примере,

составляет 100,

b2

= 950, а слагаемое а

= 50000,то мы получим:

ожидаемый доход = 50000 +100х 110 + 950х 20 =

80000руб.

Множественную регрессию можно использовать

и для предсказания средних групповых

значений,например среднего дохода

мужчин-врачей. Единственное различие

в данном случае заключается в использованиисредних значений независимых

переменныхдля подстановки в уравнение

множественной регрессии. В качестве

независимой переменной множественной

регрессии могут использоваться и

дихотомические переменные, которым

приписывают значения 0и

1 (например, пол). Для того чтобы

включить в уравнение номинальную

переменную с более чем двумя

категориями, нужно создать соответствующее

число новых,«фиктивных» переменных,каждая из которых будет кодироваться

как О или 1в зависимости

от наличия или отсутствия категории-признака.

Скажем, состоящую из трех категорий

переменную «цвет глаз» можно представить

с помощью трех переменных:Х1

—«голубые глаза»,Х2

—«карие глаза»,Х3,

— «зеленые глаза». (Человек с

голубыми глазами получит 1поХ1и 0по

двум другим переменным.)

|

Таблица 8.12 Множественный |

|||

|

Независимая переменная |

Коэффициент b |

Коэффициент b* |

p< |

|

Индекс совокупного тиража порнографических |

6,99 |

0,52 |

0,001 |

|

Показатель числа убийств и непредумышленных |

1,70 |

0,55 |

0,001 |

|

Показатель числа публичных оскорблений |

0,04 |

0,32 |

0,001 |

|

Индекс положения женщин |

0,43 |

0,27 |

0,014 |

|

Число грабежей |

-0,03 |

-0,25 |

0,052 |

|

Процент черного населения |

-0,41 |

-0,38 |

0,001 |

|

Процент живущих ниже федерального |

1,11 |

0,29 |

0,011 |

Метод множественной регрессии очень

популярен среди социологов. Вот,

например, как выглядели результаты

его применения в исследовании Л. Бэрона

и М. Строса, изучавших факторы, влияющие

на статистику изнасилований20.

Использованная в планировании этого

исследования матрица данных включала

в себя в качестве объектов («случаев»)

различные штаты США. Признаками, по

которым описывались штаты, служили

около десятка независимых и собственно

контрольных переменных, предположительно

воздействующих на зависимую

переменную,—количество

зарегистрированных полицией изнасилований

на 100000населения в год

для данного штата (по данным ежегодных

статистических отчетов ФБР). Предполагалось,

что существующие различия между штатами

в уровне изнасилований можно будет

объяснить различиями в уровнях независимых

переменных. Нужно отметить, что разброс

«случаев» по зависимой переменной был

весьма велик —от

71,9на Аляске до 8,2в

Северной Дакоте (1979).Из десятка переменных, включенных в

уравнение множественной регрессии,

девять оказались статистически значимы.

Основные результаты регрессионного

анализа для семи переменных представлены

втаблице 8.12.

Из таблицы видно, что индекс совокупного

тиража порнографических журналов

(интегральный показатель, учитывающий

уровни продаж восьми популярных

изданий) имеет коэффициент регрессии

6,99.Это означает, что рост индекса

на единицу в среднем увеличивает

количество изнасилований почти на7случаев (в расчете на 100000населения). Весьма значительно и влияние

числа убийств, что особенно заметно

при сравнении стандартизованных

коэффициентов (b*), не зависящих

от шкалы измерения признака. Фактически

количество убийств вносит самый

значительный «вклад» в предсказание

значений зависимой переменной (b*

= 0,55).Интересно отметить, что одна

из независимых переменных в описываемом

исследовании —индекс

положения женщин, рассчитанный на

основании 22-х политических, экономических

и социальных индикаторов,—при

анализе простых взаимосвязей

продемонстрировала практически

нулевую корреляцию с количеством

изнасилований (г = 0,17),причем

20 Baron

L., Strauss M. A. Sexual

Stratification, Pornography, and Rape in the United States //

Malamuth

N.. Donnerstein E. (eds.)

Pornography and Sexual Aggression. Orlando etal.:

Academic Press, 1984.

P. 185—209.

21Таблица приводится

в сокращении по источнику:

Baron L, Strauss V. A.

Sexual Stratification, Pornography, and Rape…

результаты анализа диаграммы рассеивания

также не дали никаких свидетельств в

пользу гипотезы о нелинейной связи.

Множественная регрессия позволила

уточнить первоначальные выводы: при

контроле прочих переменных модели, чем

вышестатус женщин, темвышеуровень изнасилований (результат,

которому довольно трудно найти

теоретическое объяснение). Использование

девяти независимых переменных позволило

объяснить 83%дисперсии в

показателях количества изнасилований

(квадрат коэффициента множественной

корреляцииr2составил

0,83).

При интерпретации результатов

множественной регрессии стандартизованные

коэффициенты, как уже говорилось,

используют в качестве показателей

значимости, «вклада» соответствующих

переменных. Эта трактовка верна лишь в

определенных пределах. При нарушении

некоторых условий сравнение абсолютных

величин стандартизованных коэффициентов

может вести к неверным выводам. Дело в

том, что коэффициенты регрессии подвержены

влиянию случайных ошибок измерения(см. с. 116).Использованиененадежных индикаторов«сдвигает»

регрессионные коэффициенты к нулю22.

Иными. словами,более надежныеиндикаторы даютболее высокиеоценки

коэффициентов. Пусть, например, для

предсказания риска сердечно-сосудистых

заболеваний использовались две

независимые переменные индивидуального

уровня—«ориентация на

достижения» и «склонность подавлять

агрессию»,—причем

шкала для измерения первой обладалаболее высокимкоэффициентом

надежности. Если стандартизованный

коэффициент регрессии для достиженческой

мотивации окажетсявыше,чем для

подавления агрессии, это может

рассматриваться как следствие таких

содержательных различий между

переменными, которые важны с точки

зрения теории психосоциальных

факторов заболеваемости. Но нельзя

исключить и альтернативное объяснение,

связывающее более высокий регрессионный

коэффициент первой переменной с побочными

эффектами методов измерения: влияние

ориентации на достижения не превосходит

влияния, оказываемого на риск инфаркта

склонностью подавлять агрессию, а

наблюдаемые различия регрессионных

коэффициентов связаны лишь с ненадежностью

использованных индикаторов склонности

к подавлению.

Другая проблема, требующая некоторой

осторожности в интерпретации коэффициентов

регрессии, возникает вследствие того,

что модель множественной регрессии

не обязывает нас ни к каким строгим

предположениям о причинных связях

между независимыми переменными.Регрессионное уравнение, образно

говоря, не делает никаких различий между

собственно независимыми, т. е. теоретически

специфицированными, переменными и

дополнительными—контрольными,

опосредующими и т. п.—факторами,

вводимыми в модель с целью уточнения.

В тех случаях, когда теоретическая

гипотеза, проверяемая в ходе исследования,

допускает: 1)существование

взаимосвязей между независимыми

переменными, 2)наличие

прямых и косвенных (опосредованных)

влияний, а также 3)использование нескольких индикаторов

для каждого латентного фактора, могут

понадобиться более совершенные

статистические методы. Одна из возможностей

здесь—это использованиепутевого анализа.

22Это явление

называютаттенюацией.Существуют

специальные методы внесения поправок

на аттенюацию, но здесь они обсуждаться

не будут.

Путевой анализ —

один из основных способов построения

и проверки причинных моделей в

социологии.Многие более продвинутые

статистические техники основаны на

сходной исследовательской методологии.

Важным достоинством путевого анализа

является то, что он позволяет оценить

параметры каузальных моделей, причем

в расчет принимаются не только прямые,но инепрямые (опосредованные)влияния. Если, например, в результате

корреляционного или регрессионного

анализа мы обнаружили, что интеллект

(измеренный как IQ)лишь

умеренно влияет на доход, нам не следует

торопиться с общими выводами. Мы

оставили неучтенной возможность того,

что интеллект может иметь существенное

влияние на образование, которое, в свою

очередь, воздействует на последующий

доход. Таким образом, нам нужно принять

во внимание то, что интеллект

—помимо прямого эффекта

—может иметь еще и опосредованное,

непрямое влияние на доход посредством

влияния на образование. Методы,

рассматривавшиеся нами до сих пор,

описывали только прямые эффекты.

Путевой анализ включает в себя технику

представления прямых и косвенных

причинных влияний при помощи специальных

диаграмм (потоковых графов). Эти диаграммы

часто называют просто причинными

(структурными) моделями.

Последовательно «считывая» такую

модель, можно легко определить все пути

влияния одной переменной на другую и

соответственно оценить величину чистого

эффекта. Во многих разделах этой книги

причинные модели уже использовались

для представления сравнительно сложных

причинных гипотез (см., например, с.

122),поэтому общая логика их построения

не требует детального обсуждения.

Порядок представления переменных на

диаграмме отражает предполагаемое

направление причинной связи, а диапазон

включенных в диаграмму переменных

и отношения между ними зависят от

принятых исследователем теоретических

гипотез. Так называемыепутевые

коэффициенты,описывающие связи

между переменными (связям соответствуют

стрелочки на диаграмме),равны

стандартизованным коэффициентам

множественной регрессии (b*)23.

Обычно путевую диаграмму рисуют слева

направо —от самых «ранних»

по порядку следования независимых

переменных до зависимой. Путевые

коэффициенты часто обозначают

латинскими«р»с подстрочными

индексами(р21

— это путевой коэффициент для

связи между переменнымиX1

—>Х2).Нарисунке

24в качестве примера

изображена путевая диаграмма, отражающая

гипотетические отношения между

интеллектом(Х1),образованием(Х2),социально-экономическим статусом(Х3),доходом(Х4)и размерами сбережений(Х5).

Специальные правила позволяют перевести

отношения, изображенные на диаграмме,

в совокупность структурных уравнений,описывающих механизмы прямого и

опосредованного воздействия одних

переменных на другие. Нарисунке

24,в частности, видно, что не

существует пути дляпрямого воздействия

интеллекта на размеры сбережений,

однако общий эффект воздействия

интеллекта будет включать в себясовокупность непрямых эффектов:

X1воздействует наX5 и

через образование(Х2),и через достигнутый статус(Х3),и через доход(Х4).Иными

словами, хотя и нельзя утверждать, что

склонность откладывать деньги «в

кубышку» зависит от умственных

способностей, последние влияют

23В оценивании также

используется метод наименьших квадратов.

и на возможность получения образования,

и на статус, и на доход. В свою очередь,

люди с определенным социальным и

экономическим статусом обнаруживают

склонность иметь сбережения.

В общем случае, полный эффект влияния

переменной равен сумме ее непосредственного

эффекта и всех косвенных эффектов

влияния.Величины возмущений (е2

— e4)

Haрисунке позволяют оценить, насколько

хорошо работает модель, показывая,

какая часть дисперсии соответствующей

переменной осталась необъясненной. В

результате путевой анализ позволяет

пересматривать и уточнять исходную

теоретическую модель, сравнивать

«эффективность» нескольких

конкурирующих теорий для объяснения

существующей совокупности эмпирических

наблюдений. Существуют даже компьютерные

программы, осуществляющие автоматический

поиск наилучшей структурной модели, т.

е. процедуру, сходную с отбором из

нескольких существующих теорий такой,

которая максимально соответствовала

бы полученным в исследовании данным24.

Важно, однако, осознавать, что сами по

себе результаты применения регрессионных

методов и причинных моделей (регрессионные

коэфициенты, линии регрессии, путевые

диаграммы) решают прежде всего задачуобобщенного описанияуже полученных

эмпирических данных. Они могут служить

надежной основой для интерполяции,

оценки положения гипотетических «точек»

в пределах ряда наблюдавшихся значений,

однако их использование в целяхэкстраполяции и прогнозаможет

вести к существенным ошибкам в тех

случаях, когда такой прогноз не

подкреплен более широкой теорией, не

сводимой к отдельной модели для конечной

совокупности данных. (Достаточно указать

в качестве примера на многочисленные

ошибочные прогнозы в экономике

—на уке, где количество эмпирических

данных и описывающих их структурных

моделей многократно превзошло количество

существующих теорий.)

24Подробнее см.:И.

Ф. Девятко.Диагностическая процедура

в социологии: очерк истории и теории.

М.: Наука, 1993.С.121—136.

Путевой анализ, как и множественная

регрессия, сегодня является частью

большинства стандартных статистических

программ для компьютера. Не стоит,

однако, забывать о том, что при любом

уровне прогресса в компьютерном

обеспечении задать причинную модель,

т. е. совокупность содержательных

гипотез, подлежащих статистическому

оцениванию,может только сам

исследователь.

Дополнительная литература

Вайнберг Дж., Шумекер Дж..Статистика. М.: Финансы и статистика,

1979.

Гласе Дж., Стэнли Дж.Статистические

методы в педагогике и психологии.

М.: Прогресс, 1976.

Интерпретация и анализ данныхв

социологическом исследовании. М.: Наука,

1987.

Татарова Г. Г.Типологический анализ

в социологии. М.: Наука,

1993.

Типология и классификацияв

социологических исследованиях. М.:

Наука, 1982.

Толстова Ю. Н.Логика математического

анализа социологических

данных. М.: Наука, 1991.

Хейс Д.Причинный анализ в статистических

исследованиях. М.:

Финансы и статистика, 1981.

Флейс Дж.Статистические методы для

изучения таблиц долей и пропорций. М.:

Финансы и статистика, 1989.

Ядов В. А.Социологическое исследование:

методология, программа, методы. 2-е

изд. М.: Наука, 1987.Гл.

5.

Исследуем отношение между переменными¶

В этой главе исследуются отношения между переменными.

-

Мы будем визуализировать отношения с помощью диаграмм рассеяния (scatter plots), диаграмм размаха (box plots) и скрипичных диаграмм (violin plots),

-

И мы будем количественно определять отношения, используя корреляцию (correlation) и простую регрессию (simple regression).

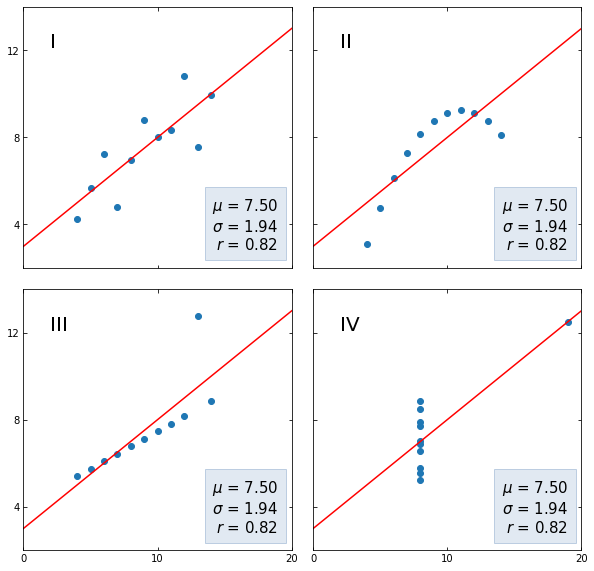

Самый важный урок этой главы заключается в том, что вы всегда должны визуализировать взаимосвязь между переменными, прежде чем пытаться ее количественно оценить; в противном случае вас могут ввести в заблуждение.

In [1]:

from os.path import basename, exists def download(url): filename = basename(url) if not exists(filename): from urllib.request import urlretrieve local, _ = urlretrieve(url, filename) print('Downloaded ' + local) download('https://github.com/AllenDowney/' + 'ElementsOfDataScience/raw/master/brfss.hdf5')

Изучение отношений¶

В качестве первого примера мы рассмотрим взаимосвязь между ростом и весом.

Мы будем использовать данные из Системы наблюдения за поведенческими факторами риска (BRFSS), которая находится в ведении Центров по контролю за заболеваниями по адресу https://www.cdc.gov/brfss.

В опросе приняли участие более 400 000 респондентов, но, чтобы произвести анализ, я выбрал случайную подвыборку из 100 000 человек.

In [2]:

import pandas as pd brfss = pd.read_hdf('brfss.hdf5', 'brfss') brfss.shape

Out[3]:

| SEX | HTM4 | WTKG3 | INCOME2 | _LLCPWT | _AGEG5YR | _VEGESU1 | _HTMG10 | AGE | |

|---|---|---|---|---|---|---|---|---|---|

| 96230 | 2.0 | 160.0 | 60.33 | 8.0 | 1398.525290 | 6.0 | 2.14 | 150.0 | 47.0 |

| 244920 | 2.0 | 163.0 | 58.97 | 5.0 | 84.057503 | 13.0 | 3.14 | 160.0 | 89.5 |

| 57312 | 2.0 | 163.0 | 72.57 | 8.0 | 390.248599 | 5.0 | 2.64 | 160.0 | 42.0 |

| 32573 | 2.0 | 165.0 | 74.84 | 1.0 | 11566.705300 | 3.0 | 1.46 | 160.0 | 32.0 |

| 355929 | 2.0 | 170.0 | 108.86 | 3.0 | 844.485450 | 3.0 | 1.81 | 160.0 | 32.0 |

BRFSS включает сотни переменных. Для примеров в этой главе я выбрал всего девять.

Мы начнем с HTM4, который записывает рост каждого респондента в см, и WTKG3, который записывает вес в кг.

In [4]:

height = brfss['HTM4'] weight = brfss['WTKG3']

Чтобы визуализировать взаимосвязь между этими переменными, мы построим диаграмму рассеяния (scatter plot).

Диаграммы рассеяния широко распространены и понятны, но их на удивление сложно правильно построить.

В качестве первой попытки мы будем использовать функцию plot с аргументом o, который строит круг для каждой точки.

см. документацию по plot

In [5]:

import matplotlib.pyplot as plt %matplotlib inline plt.plot(height, weight, 'o') plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height');

Похоже, что высокие люди тяжелее, но в этом графике есть несколько моментов, которые затрудняют интерпретацию.

Первый из них – перекрытие (overplotted), то есть точки данных накладываются друг на друга, поэтому вы не можете сказать, где много точек, а где только одна.

Когда это происходит, результаты могут вводить в заблуждение.

Один из способов улучшить график – использовать прозрачность (transparency), что мы можем сделать с помощью ключевого аргумента alpha. Чем ниже значение alpha, тем прозрачнее каждая точка данных.

Вот как это выглядит с alpha=0.02.

In [6]:

plt.plot(height, weight, 'o', alpha=0.02) plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height');

Уже лучше, но на графике так много точек данных, что диаграмма рассеяния все еще перекрывается. Следующим шагом будет уменьшение размеров маркеров.

При markersize=1 и низком значении alpha диаграмма рассеяния будет менее насыщенной.

Вот как это выглядит.

In [7]:

plt.plot(height, weight, 'o', alpha=0.02, markersize=1) plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height');

Уже лучше, но теперь мы видим, что точки строятся отдельными столбцами. Это потому, что большая часть высоты была указана в дюймах и преобразована в сантиметры.

Мы можем разбить столбцы, добавив к значениям некоторый случайный шум; по сути, мы заполняем округленные значения.

Такое добавление случайного шума называется дрожанием (jittering).

Дрожание – это добавление случайного шума к данным для предотвращения перекрытия статистических графиков. Если непрерывное измерение округлено до некоторой удобной единицы, может произойти перекрытие. Это приводит к превращению непрерывной переменной в дискретную порядковую переменную. Например, возраст измеряется в годах, а масса тела – в фунтах или килограммах. Если вы построите диаграмму разброса веса в зависимости от возраста для достаточно большой выборки людей, там может быть много людей, записанных, скажем, с 29 годами и 70 кг, и, следовательно, в этой точке будет нанесено много маркеров (29, 70).

Чтобы уменьшить перекрытие, вы можете добавить к данным небольшой случайный шум. Размер шума часто выбирается равным ширине единицы измерения. Например, к значению 70 кг вы можете добавить количество u , где u – равномерная случайная величина в интервале [-0,5, 0,5]. Вы можете обосновать дрожание, предположив, что истинный вес человека весом 70 кг с равной вероятностью находится в любом месте интервала [69,5, 70,5].

Контекст данных важен при принятии решения о дрожании. Например, возраст обычно округляется в меньшую сторону: 29-летний человек может праздновать свой 29-й день рождения сегодня или, возможно, ему исполнится 30 завтра, но ей все равно 29 лет. Следовательно, вы можете изменить возраст, добавив величину v , где v – равномерная случайная величина в интервале [0,1]. (Мы игнорируем статистически значимый случай женщин, которым остается 29 лет в течение многих лет!)

Источник: Jittering to prevent overplotting in statistical graphics

Мы можем использовать NumPy для добавления шума из нормального распределения со средним 0 и стандартным отклонением 2.

см. документацию NumPy

In [8]:

import numpy as np noise = np.random.normal(0, 2, size=len(brfss)) height_jitter = height + noise

Вот как выглядит график с дрожащими (jittered) высотами.

In [9]:

plt.plot(height_jitter, weight, 'o', alpha=0.02, markersize=1) plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height');

Столбцы исчезли, но теперь мы видим, что есть строки, в которых люди округляют свой вес. Мы также можем исправить это с помощью дрожания веса.

In [10]:

noise = np.random.normal(0, 2, size=len(brfss)) weight_jitter = weight + noise

In [11]:

plt.plot(height_jitter, weight_jitter, 'o', alpha=0.02, markersize=1) plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height');

Наконец, давайте увеличим масштаб области, где находится большинство точек данных.

Функции xlim и ylim устанавливают нижнюю и верхнюю границы для осей $x$ и $y$; в данном случае мы наносим рост от 140 до 200 сантиметров и вес до 160 килограмм.

Вот как это выглядит.

In [12]:

plt.plot(height_jitter, weight_jitter, 'o', alpha=0.02, markersize=1) plt.xlim([140, 200]) plt.ylim([0, 160]) plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height');

Теперь у нас есть достоверная картина взаимосвязи между ростом и весом.

Ниже вы можете увидеть вводящий в заблуждение график, с которого мы начали, и более надежный, которым мы закончили. Они явно разные, и они предлагают разные истории о взаимосвязи между этими переменными.

In [13]:

# Set the figure size plt.figure(figsize=(8, 3)) # Create subplots with 2 rows, 1 column, and start plot 1 plt.subplot(1, 2, 1) plt.plot(height, weight, 'o') plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height') # Adjust the layout so the two plots don't overlap plt.tight_layout() # Start plot 2 plt.subplot(1, 2, 2) plt.plot(height_jitter, weight_jitter, 'o', alpha=0.02, markersize=1) plt.xlim([140, 200]) plt.ylim([0, 160]) plt.xlabel('Height in cm') plt.ylabel('Weight in kg') plt.title('Scatter plot of weight versus height') plt.tight_layout()

Смысл этого примера в том, что для создания эффективного графика разброса требуются некоторые усилия.

Упражнение: Набирают ли люди вес с возрастом? Мы можем ответить на этот вопрос, визуализировав взаимосвязь между весом и возрастом.

Но прежде чем строить диаграмму рассеяния, рекомендуется визуализировать распределения по одной переменной за раз. Итак, давайте посмотрим на возрастное распределение.

Набор данных BRFSS включает столбец AGE, который представляет возраст каждого респондента в годах. Чтобы защитить конфиденциальность респондентов, возраст округляется до пятилетних интервалов. AGE содержит середину интервалов (bins).

-

Извлеките переменную

'AGE'из фрейма данныхbrfssи присвойте ееage. -

Постройте функцию вероятности (Probability mass function, PMF) для

ageв виде гистограммы, используяPmfизempiricaldist.

empiricaldist– библиотека Python, представляющая эмпирические функции распределения.

In [14]:

try: import empiricaldist except ImportError: !pip install empiricaldist

In [15]:

from empiricaldist import Pmf

Упражнение: Теперь давайте посмотрим на распределение веса.

Столбец, содержащий вес в килограммах, – это WTKG3. Поскольку этот столбец содержит много уникальных значений, отображение его как функции вероятности (PMF) работает плохо.

In [17]:

Pmf.from_seq(weight).bar() plt.xlabel('Weight in kg') plt.ylabel('PMF') plt.title('Distribution of weight');

Чтобы получить лучшее представление об этом распределении, попробуйте построить график функции распределения (Cumulative distribution function, CDF).

Вычислите функцию распределения (CDF) нормального распределения с тем же средним значением и стандартным отклонением и сравните его с распределением веса.

Подходит ли нормальное распределение для этих данных? А как насчет логарифмического преобразования весов?

Упражнение: Теперь давайте построим диаграмму разброса (scatter plot) для weight и age.

Отрегулируйте alpha и markersize, чтобы избежать наложения (overplotting). Используйте ylim, чтобы ограничить ось y от 0 до 200 килограммов.

Упражнение: В предыдущем упражнении возрасты указаны в столбцах, потому что они были округлены до 5-летних интервалов (bins). Если мы добавим дрожание (jitter), диаграмма рассеяния покажет взаимосвязь более четко.

- Добавьте случайный шум к

ageсо средним значением0и стандартным отклонением2.5. - Создайте диаграмму рассеяния и снова отрегулируйте

alphaиmarkersize.

Визуализация отношений¶

В предыдущем разделе мы использовали диаграммы разброса для визуализации взаимосвязей между переменными, а в упражнениях вы исследовали взаимосвязь между возрастом и весом. В этом разделе мы увидим другие способы визуализации этих отношений, в том числе диаграммы размаха и скрипичные диаграммы.

Я начну с диаграммы разброса веса в зависимости от возраста.

In [23]:

age = brfss['AGE'] noise = np.random.normal(0, 1.0, size=len(brfss)) age_jitter = age + noise plt.plot(age_jitter, weight_jitter, 'o', alpha=0.01, markersize=1) plt.xlabel('Age in years') plt.ylabel('Weight in kg') plt.ylim([0, 200]) plt.title('Weight versus age');

В этой версии диаграммы разброса я скорректировал дрожание весов, чтобы между столбцами оставалось пространство.

Это позволяет увидеть форму распределения в каждой возрастной группе и различия между группами.

С этой точки зрения кажется, что вес увеличивается до 40-50 лет, а затем начинает уменьшаться.

Если мы пойдем дальше, то сможем использовать ядерную оценку плотности (Kernel Density Estimation, KDE) для оценки функции плотности в каждом столбце и построения графика. И для этого есть название – скрипичная диаграмма (violin plot).

Библиотека Seaborn предоставляет функцию, которая создает скрипичную диаграмму, но прежде чем мы сможем ее использовать, мы должны избавиться от любых строк с пропущенными данными.

Вот так:

In [24]:

data = brfss.dropna(subset=['AGE', 'WTKG3']) data.shape

dropna() создает новый фрейм данных, который удаляет строки из brfss, где AGE или WTKG3 равны NaN.

Теперь мы можем вызвать функцию violinplot.

см. документацию по violinplot

In [25]:

import seaborn as sns sns.violinplot(x='AGE', y='WTKG3', data=data, inner=None) plt.xlabel('Age in years') plt.ylabel('Weight in kg') plt.title('Weight versus age');

Аргументы x и y означают, что нам нужно AGE на оси x и WTKG3 на оси y.

data – это только что созданный фрейм данных, который содержит переменные для отображения.

Аргумент inner=None немного упрощает график.

На рисунке каждая фигура представляет собой распределение веса в одной возрастной группе. Ширина этих форм пропорциональна предполагаемой плотности, так что это похоже на две вертикальные ядерные оценки плотности (KDE), построенные вплотную друг к другу (и залитые красивыми цветами).

Другой, связанный с этим способ просмотра данных, называется диаграмма размаха (ящик с усами, box plot).

Код для создания диаграммы размаха очень похож.

см. документацию по boxplot

In [26]:

sns.boxplot(x='AGE', y='WTKG3', data=data, whis=10) plt.xlabel('Age in years') plt.ylabel('Weight in kg') plt.title('Weight versus age');

Я включил аргумент whis=10, чтобы отключить функцию, которая нам не нужна.

Каждый прямоугольник представляет распределение веса в возрастной группе. Высота каждого прямоугольника представляет собой диапазон от 25-го до 75-го процентиля. Линия в середине каждого прямоугольника – это медиана. Шипы, торчащие сверху и снизу, показывают минимальное и максимальное значения.

На мой взгляд, этот график дает лучшее представление о взаимосвязи между весом и возрастом.

-

Глядя на медианы, кажется, что люди в возрасте от 40 лет являются самыми тяжелыми; люди младшего и старшего возраста легче.

-

Глядя на размеры ящиков, кажется, что люди в возрасте от 40 также имеют наибольший разброс в весе.

-

Эти графики также показывают, насколько искажено распределение веса; то есть самые тяжелые люди намного дальше от медианы, чем самые легкие.

Для данных, которые склоняются к более высоким значениям, иногда полезно рассматривать их в логарифмической шкале.

Мы можем сделать это с помощью Pyplot-функции yscale.

In [27]:

sns.boxplot(x='AGE', y='WTKG3', data=data, whis=10) plt.yscale('log') plt.xlabel('Age in years') plt.ylabel('Weight in kg (log scale)') plt.title('Weight versus age');

Чтобы наиболее четко показать взаимосвязь между возрастом и весом, я бы использовал этот рисунок.

В следующих упражнениях у вас будет возможность создать скрипичную диаграмму и диаграмму размаха.

Упражнение: Ранее мы рассмотрели диаграмму рассеяния (scatter plot) по росту и весу и увидели, что более высокие люди, как правило, тяжелее. Теперь давайте более подробно рассмотрим диаграмму размаха (box plot).

Фрейм данных brfss содержит столбец с именем _HTMG10, который представляет высоту в сантиметрах, разбитую на группы по 10 см.

-

Составьте диаграмму размаха, показывающую распределение веса в каждой группе роста.

-

Постройте ось Y в логарифмическом масштабе.

Предложение: если метки на оси x сталкиваются, вы можете повернуть их следующим образом:

plt.xticks(rotation='45')Упражнение: В качестве второго примера давайте посмотрим на взаимосвязь между доходом (income) и ростом.

В BRFSS доход представлен как категориальная переменная; то есть респондентов относят к одной из 8 категорий доходов. Имя столбца – INCOME2.

Прежде чем связывать доход с чем-либо еще, давайте посмотрим на распределение, вычислив функцию вероятности (PMF).

-

Извлеките

INCOME2изbrfssи присвойте егоincome. -

Постройте функцию вероятности (PMF) для

incomeв виде гистограммы (bar chart).

Примечание: вы увидите, что около трети респондентов относятся к группе с самым высоким доходом; лучше, если бы было больше лидирующих групп, но мы будем работать с тем, что у нас есть.

Упражнение: Создайте скрипичную диаграмму (violin plot), которая показывает распределение роста в каждой группе дохода.

Вы видите взаимосвязь между этими переменными?

Корреляция¶

В предыдущем разделе мы визуализировали отношения между парами переменных. Теперь мы узнаем о коэффициенте корреляции, который количественно определяет силу этих взаимосвязей.

Когда люди говорят “корреляция”, они имеют в виду любую связь между двумя переменными. В статистике обычно это означает коэффициент корреляции Пирсона, который представляет собой число от -1 до 1, которое количественно определяет силу линейной связи между переменными.

Для демонстрации я выберу три столбца из набора данных BRFSS:

In [31]:

columns = ['HTM4', 'WTKG3', 'AGE'] subset = brfss[columns]

Результатом является фрейм данных только с этими столбцами.

С этим подмножеством данных мы можем использовать метод corr, например:

Out[32]:

| HTM4 | WTKG3 | AGE | |

|---|---|---|---|

| HTM4 | 1.000000 | 0.474203 | -0.093684 |

| WTKG3 | 0.474203 | 1.000000 | 0.021641 |

| AGE | -0.093684 | 0.021641 | 1.000000 |

Результатом является корреляционная матрица. В первой строке корреляция HTM4 с самим собой равна 1. Это ожидаемо; корреляция чего-либо с самим собой равна 1.

Следующая запись более интересна; соотношение роста и веса составляет около 0.47. Коэффициент положительный, это означает, что более высокие люди тяжелее, и он умеренный по силе, что означает, что он имеет некоторую прогностическую ценность. Если вы знаете чей-то рост, вы можете лучше предположить его вес, и наоборот.

Корреляция между ростом и возрастом составляет примерно -0.09. Коэффициент отрицательный, это означает, что пожилые люди, как правило, ниже ростом, но он слабый, а это означает, что знание чьего-либо возраста не поможет, если вы попытаетесь угадать их рост.

Корреляция между возрастом и весом еще меньше. Напрашивается вывод, что нет никакой связи между возрастом и весом, но мы уже видели, что она есть. Так почему же корреляция такая низкая?

Помните, что зависимость между весом и возрастом выглядит так.

In [33]:

data = brfss.dropna(subset=['AGE', 'WTKG3']) sns.boxplot(x='AGE', y='WTKG3', data=data, whis=10) plt.xlabel('Age in years') plt.ylabel('Weight in kg') plt.title('Weight versus age');

Люди за сорок – самые тяжелые; люди младшего и старшего возраста легче. Итак, эта связь нелинейна.

Но корреляция измеряет только линейные отношения. Если связь нелинейная, корреляция обычно недооценивает ее силу.

Чтобы продемонстрировать, я сгенерирую несколько поддельных данных: xs содержит точки с равным интервалом между -1 и 1.

ys – это квадрат xs плюс некоторый случайный шум.

In [34]:

xs = np.linspace(-1, 1) ys = xs**2 + np.random.normal(0, 0.05, len(xs))

Вот диаграмма рассеяния для xs и ys.

In [35]:

plt.plot(xs, ys, 'o', alpha=0.5) plt.xlabel('x') plt.ylabel('y') plt.title('Scatter plot of a fake dataset');

Понятно, что это сильная связь; если вам дано x, вы можете гораздо лучше догадаться о y.

Но вот корреляционная матрица:

Out[36]:

array([[1. , 0.01135475],

[0.01135475, 1. ]])

Несмотря на то, что существует сильная нелинейная зависимость, вычисленная корреляция близка к 0.

В общем, если корреляция высока, то есть близка к

1или-1, вы можете сделать вывод, что существует сильная линейная зависимость.

Но если корреляция близка к0, это не означает, что связи нет; может быть связь нелинейная.

Это одна из причин, по которой я считаю, что корреляция не является хорошей статистикой.

В частности, корреляция ничего не говорит о наклоне. Если мы говорим, что две переменные коррелируют, это означает, что мы можем использовать одну для предсказания другой. Но, возможно, это не то, о чем мы заботимся.

Например, предположим, что нас беспокоит влияние увеличения веса на здоровье, поэтому мы строим график зависимости веса от возраста от 20 до 50 лет.

Я создам два поддельных набора данных, чтобы продемонстрировать суть дела. В каждом наборе данных xs представляет возраст, а ys – вес.

Я использую np.random.seed для инициализации генератора случайных чисел, поэтому мы получаем одни и те же результаты при каждом запуске.

In [37]:

np.random.seed(18) xs1 = np.linspace(20, 50) ys1 = 75 + 0.02 * xs1 + np.random.normal(0, 0.15, len(xs1)) plt.plot(xs1, ys1, 'o', alpha=0.5) plt.xlabel('Age in years') plt.ylabel('Weight in kg') plt.title('Fake dataset #1');

А вот и второй набор данных:

In [38]:

np.random.seed(18) xs2 = np.linspace(20, 50) ys2 = 65 + 0.2 * xs2 + np.random.normal(0, 3, len(xs2)) plt.plot(xs2, ys2, 'o', alpha=0.5) plt.xlabel('Age in years') plt.ylabel('Weight in kg') plt.title('Fake dataset #2');

Я построил эти примеры так, чтобы они выглядели одинаково, но имели существенно разные корреляции:

In [39]:

rho1 = np.corrcoef(xs1, ys1)[0][1] rho1

In [40]:

rho2 = np.corrcoef(xs2, ys2)[0][1] rho2

В первом примере сильная корреляция, близкая к 0.75. Во втором примере корреляция умеренная, близкая к 0.5. Поэтому мы можем подумать, что первые отношения более важны. Но посмотрите внимательнее на ось y на обоих рисунках.

В первом примере средняя прибавка в весе за 30 лет составляет менее 1 килограмма; во втором больше 5 килограммов!

Если нас беспокоит влияние увеличения веса на здоровье, второе соотношение, вероятно, более важно, даже если корреляция ниже.

Статистика, которая нас действительно волнует, – это наклон линии, а не коэффициент корреляции.

В следующем разделе мы увидим, как оценить этот наклон. Но сначала давайте попрактикуемся с корреляцией.

Упражнения: Цель BRFSS – изучить факторы риска для здоровья, поэтому в него включены вопросы о диете.

Столбец _VEGESU1 представляет количество порций овощей, которые респонденты ели в день.

Посмотрим, как эта переменная связана с возрастом и доходом.

- Во фрейме данных

brfssвыберите столбцы'AGE',INCOME2и_VEGESU1. - Вычислите корреляционную матрицу для этих переменных.

Упражнение: В предыдущем упражнении корреляция между доходом и потреблением овощей составляет около 0.12. Корреляция между возрастом и потреблением овощей составляет примерно -0.01.

Что из следующего является правильной интерпретацией этих результатов?

- A: люди в этом наборе данных с более высоким доходом едят больше овощей.

- B: Связь между доходом и потреблением овощей линейна.

- C: Пожилые люди едят больше овощей.

- D: Между возрастом и потреблением овощей может быть сильная нелинейная зависимость.

Упражнение: В общем, рекомендуется визуализировать взаимосвязь между переменными перед вычислением корреляции. В предыдущем примере мы этого не делали, но еще не поздно.

Создайте визуализацию взаимосвязи между возрастом и овощами. Как бы вы описали отношения, если они есть?

Простая регрессия¶

В предыдущем разделе мы видели, что корреляция не всегда измеряет то, что мы действительно хотим знать. В этом разделе мы рассмотрим альтернативу: простую линейную регрессию.

Давайте еще раз посмотрим на взаимосвязь между весом и возрастом. В предыдущем разделе я создал два фальшивых набора данных, чтобы доказать свою точку зрения:

In [44]: