Часто вопрос стоит следующим образом. Есть экспериментальные данные, и хочется понять, можно ли описывать как случайную величину с некоторым типом распределения (чаще всего нормальным). Как в такой ситуации поступать?

Есть очевидный путь — построить гистограмму распределения и сравнить ее с кривой нормального распределения. Какая возникает при этом проблема? Мы пытаемся подобрать адекватную модель для описания процесса. Отличие от подобных ситуаций с моделями другого типа состоит в том, что модель — случайная. Мы заведомо принимаем, что она может давать разные результаты при одних и тех же входных параметрах.

Если мы работаем с физическим объектом, мы говорим о том, что у него есть физические свойства и параметры — масса, теплоемкость и т.п. Эти параметры мы можем чаще всего напрямую измерить. Теперь же мы отказываемся от описания объекта как физического объекта. Мы говорим, что да, то, что происходит, определяется физическими процессами. То же образование трещин, например — физический процесс. Но процесс настолько сложный, что описание его как физического, становится нецелесообразным. Например, из-за того, что слишком много параметров определяют его ход, и мы не можем их контролировать. Эти рассуждения могут показаться банальными, когда мы говорим о погрешности, но иногда этот переход дается тяжело. Можно вспомнить наш разговор о моделировании погодных явлений — люди долго шли к тому, чтобы встроить в модели случайность и начать говорить о результатах расчета на языке теории вероятностей.

Модель случайной величины — это тоже модель, у нее есть свои законы: они описываются в теории вероятностей. У нее есть свои параметры — тип распределения, математическое ожидание, дисперсия. Но эти параметры мы не можем измерить напрямую, ведь при одних и тех же входных параметрах мы получаем разные результаты. А для работы с моделью эти параметры нужны.

Рассмотрим, например, нормальное распределение. Случайная величина, описывающаяся данным типом распределения, может принимать любые значения — от минус бесконечности до плюс бесконечности вне зависимости от того, каковы параметры распределения. Как же в такой ситуации измерить эти параметры? Идея следующая. Мы выдвигаем гипотезу — берем фиксированные тип распределения, математическое ожидание и дисперсию и пытаемся понять, насколько результаты измерений адекватны нашей гипотезе. Весь вопрос в том, как на количественный язык перевести понятие адекватности.

Рис. 1. Мы выдвинули гипотезу о том, что процесс можно описать как случайную величину с µ=10 и σ2=1. Результат B явно более адекватен гипотезе, чем результат A, но как охарактеризовать эту «адекватность» количественно?

Посмотрим на рис. 1 – здесь мы выдвинули гипотезу о нормальном распределении с мат. Ожиданием µ=10 и дисперсией σ2=1. Показаны два результата измерений: A=9 и B=6. Интуитивно мы понимаем, что для результата A гипотеза выглядит более-менее правдоподобной, а вот для результата B – нет. Результат B находится далеко от основной части колокола. Как количественно описать эту разницу?

Какие вообще количественные ответы дает модель случайной величины? Вероятности тех или иных событий. Возможно, стоит оценить вероятность событий «мы получили результат A» и «мы получили результат B» P({X=A}) и P({X=B}). К сожалению, различий мы не получим – вероятность получить любое конкретное значение равна нулю, поскольку мы имеем дело с непрерывной случайной величиной.

Тогда мы делаем следующий ход. Вместо события «мы получили результат A» мы рассмотрим событие «мы получили результат, отклоняющийся от мат.ождания не меньше, чем A». На языке математики это можно записать так: мы перейдем от P({X=A}) к P({|X-µ|>|A-µ|}), где X – случайная величина. Соответственно, эту вероятность мы будем сравнивать с P({|X-µ|>|B-µ|}). Эти вероятности уже конечны, и сильно отличаются: P({|X-µ|>|B-µ|}) > P({|X-µ|>|A-µ|}) (рис. 2).

Рис. 2. Мы будем сравнивать вероятности событий «мы получили результат, отклоняющийся от математического ожидания не меньше, чем A» и «мы получили результат, отклоняющийся от математического ожидания не меньше, чем B».

Если стоит задача оценить правдоподобность гипотезы для конкретного результата измерений A, можно сравнить вероятность события P({|X-µ|>|A-µ|}) (будем называть далее ее просто «тестовой вероятностью») с некоторым пороговым уровнем вероятности P0 (его называют «уровнем значимости»). Часто берут P0=0.05.

Следует иметь в виду, что часто рассматривают вероятность противоположного события P({|X-µ|<|A-µ|}). Тогда проверяют условие P({|X-µ|<|A-µ|}) < P1, а характерное используемое значение P1=1-P0 (например, P1=0.95).

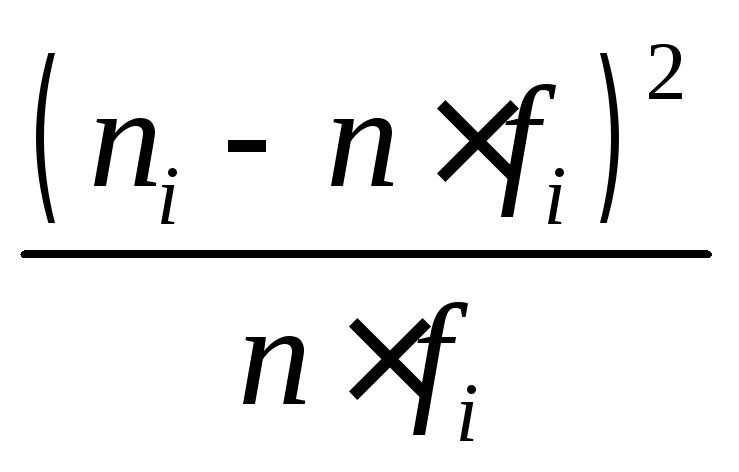

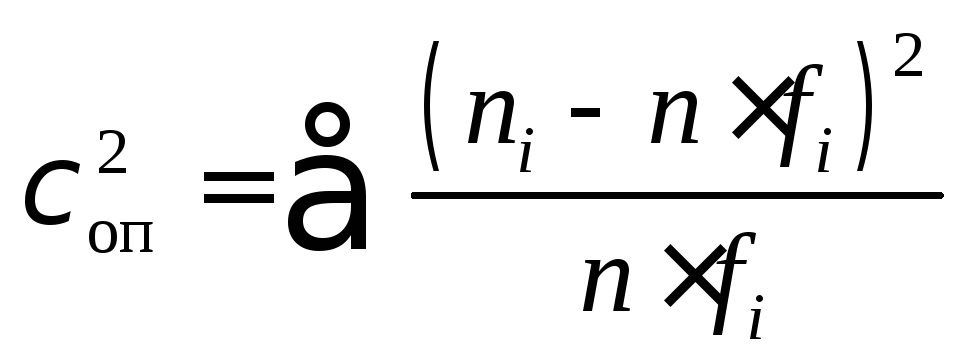

На практике обычно мы имеем дело с ситуацией, когда есть не одно измерение, а набор [A1, A2, … , An]. Та же идея распространяется и на этот случай. Диапазон, в который попали измерения, делится на m частей, затем строится гистограмма [G1,…,Gm], где Gj – число измерений, в который результат попал в j-й диапазон, деленное на число измерений n и на величину j-го диапазона (деление необходимо, чтобы получить плотность вероятности). Далее мы определяем степень отклонения гистограммы от гипотетической кривой T(x), соответствующей предполагаемому распределению (рис. 3):

В результате для набора измерений мы получили скалярную величину W – количественную характеристику отклонения от предполагаемого распределения. Далее вычисляется вероятность получить такое или большее отклонение.

Рис. 3. Гистограмма, построенная по выборке данных и ее сравнение с кривой нормального распределения.

На этом этапе возникает ряд вопросов к деталям алгоритма, в частности — как выбрать дискретные диапазоны, на базе которых строится гистограмма. Подходы к решению этих вопросов описаны в литературе — например, по теме «t-критерия Стьюдента». Здесь мы ограничимся описанием идеи метода. В Matlab он реализован в функции chi2gof.

Из приведенного описания ясно, что при проверке гипотезы нет цели получить вероятность, близкую к 100%. Однако слишком малые значения «тестовой вероятности» будут сигнализировать о том, что скорее всего, гипотеза неадекватна. Если мы получили «тестовую вероятность», например, 0.1%, это можно трактовать следующим образом – «приняв рассматриваемую статистическую гипотезу, в принципе, такой результат измерений можно было получить, однако настолько отклоняющиеся от наиболее ожидаемых результаты попадаются только в одном опыте из 1000».

Этот аспект важно понимать, поскольку часто люди интерпретируют вычисляемую при тесте «тестовую вероятность» как вероятность правильности гипотезы.

— Но ведь для построения гипотезы нам нужны некие исходные данные. С другой стороны, если мы используем все исходные данные, мы построим гипотезу, которая очень хорошо согласуется с известными данными, но вряд ли будет работать дальше. Получается, нам надо для построения гипотезы выбрать некую часть данных, а потом тестировать ее на остальных?

— Да, это один из вариантов. Он требует большого объема данных. Так логично действовать, если стоит задача построить функцию распределения вероятности. Есть другой вариант — выдвинуть гипотезу, исходя из физических соображений, и проверить ее на данных. В этом случае можно использовать для проверки все данные. Наиболее часто в этом случае в качестве гипотезы берут предположение о том, что распределение нормальное. Чем это обосновано? Предположением о том, что эксперимент хорошо поставлен, и источник отклонения будет описываться нормальным распределением.

— А если все-таки нужно определить функцию распределения, как действовать?

— Во-первых, важно определить цели, поскольку подобная задача потребует большого объема измерений. Следует помнить о том, что центральная предельная теорема гарантирует, что ты можешь определить математическое ожидание и дисперсию вне зависимости от формы распределения случайной величины, проведя измерение большое число раз. А для решения ряда задач кроме математического ожидания и дисперсии ничего не требуется (см. неравенство Чебышева). В таком случае усилия можно сэкономить. Если все же требуется определить функцию распределения — можно взять часть измерений, построить гистограмму, аппроксимировать ее некоей гладкой функцией и проверить эту гипотезу на других данных измерения. Проверка проводится по аналогии с описанным методом — вычисляется отклонение гистограммы от функции распределения, вычисляется вероятность получить такое или большее отклонение. В Matlab, например, есть функции, позволяющие реализовать такой тест для любого типа распределения, не только для нормального.

Хотя подобные тесты можно производить над очень небольшими выборками, результаты в такой ситуации может быть обманчивы.

Проведем следующий численный эксперимент. Возьмем генератор нормального распределения и генератор однородного распределения (уж оно-то сильно непохоже на нормальное, и их легко будет различить!). Заставим каждый из генераторов выдать последовательность из N чисел и проведем на этой парой последовательностей описанный выше тест на нормальность распределения. В качестве алгоритма используется функция Matlab

chi2gof с настройками по умолчанию (в частности, уровень доверия здесь P0 = 0.05). На графике на рис. 4 показана зависимость доли положительных ответов теста в зависимости от длины последовательности N. Как видно, генератор нормального распределения проходит тест примерно в 95% случаев вне зависимости от N, как и можно было ожидать. Здесь следует отметить — в 5% случаев генератор случайной величины подчинялся нормальному распределению, однако тест на нормальность он не прошел, и такая доля «ложных несрабатываний» — неотъемлимое свойство теста. Снижая уровень доверия, мы уменьшим долю «ложных несрабатываний», однако одновременно повысится доля «ложных срабатываний» — положительных результатов теста в случае, если распределение не было нормальным.

Рис. 4. Результаты применения «Хи-квадрат» проверки нормальности распределения случайной величины. Тестируемые выборки сформированы генератором случайного распределения в Matlab. Синяя кривая получена при помощи генератором нормального распределения, красная — однородного распределения.

А вот результаты для генератора однородного распределения более интересны — при малой величине выборки он проходит тест на нормальное распределение! При длине последовательности N=50 генератор однородного распределения проходит тест на нормальность в 80% случаев! Чтобы при помощи этого теста надежно отличить нормальное распределение от однородного требуется порядка 300 измерений. Если же отличия между функциями распределения меньше, потребуются еще большие выборки.

Почему так происходит? Дело в том, что такого типа тесты помогает ответить на вопрос «могли ли данные результаты измерений быть получены при нормальном распределении?», а не на вопрос «было ли распределение случайной величины нормальным?»

Получается, что отличие от нормального распределения может ощущаться только при большом числе измерения. Отсюда следует, что часто даже если реальное распределение отличается от нормального, нет практической необходимости это учитывать — это очень трудоемко, а выигрыш невелик. И нормальное распределение применяется как хорошая и разработанная модель, позволяющая получить удовлетворительные по точности результаты.

— Я посчитала хи-квадрат тест руками, и у меня получилось, что распределение могло быть нормальным, а применение функции chi2gof в матлабе дало обратный результат.

— Такое возможно, поскольку подобные тесты сильно зависят от правил построения гистограммы и, разумеется, уровня доверия, с которым сравнивается условная вероятность. В

chi2gof по умолчанию зашиты конкретные правила — например, если в столбец попало меньше 5 значений, он объединяется с соседним. Если изменить это число — результат изменится. Поэтому результаты теста несколько субъективны. Есть рекомендуемые значения числа столбцов в зависимости от величины выборки, позволяющие получить наиболее значимые результаты.

Текущая версия страницы пока не проверялась опытными участниками и может значительно отличаться от версии, проверенной 15 марта 2021 года; проверки требуют 33 правки.

Распределение вероятностей — это закон, описывающий область значений случайной величины и соответствующие вероятности появления этих значений.

Определение[править | править код]

Пусть задано вероятностное пространство

Мера

Иными словами,

Классификация распределений[править | править код]

Функция ![F_{X}(x)=mathbb {P} ^{X}((-infty ,x])=mathbb {P} (Xleqslant x)](https://wikimedia.org/api/rest_v1/media/math/render/svg/844cf2f49070bd19a33ad6869f293429715dccec)

Функция распределения

— функция неубывающая;

;

непрерывна справа.

Из того факта, что борелевская сигма-алгебра на вещественной прямой порождается семейством интервалов вида ![{(-infty ,x]}_{xin mathbb {R} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9ba60c8f657abc7bdf060c91144b07bcb512646)

Любая функция

Для вероятностных распределений, обладающих определенными свойствами, существуют более удобные способы их задания. В то же время распределения (и случайные величины) принято классифицировать по характеру функций распределения[1].

Дискретные распределения[править | править код]

Случайная величина

Распределение простой случайной величины тогда по определению задаётся:

Набор вероятностей

Для иллюстрации сказанного выше, рассмотрим следующий пример.

Пусть функция

задана таким образом, что

и

. Эта функция задаёт распределение случайной величины

, для которой

(см. распределение Бернулли, где случайная величина принимает значения

). Случайная величина

является моделью подбрасывания уравновешенной монеты.

Другими примерами дискретных случайных величин являются распределение Пуассона, биномиальное распределение, геометрическое распределение.

Дискретное распределение обладает следующими свойствами:

,

, если множество значений – конечное — из свойств вероятности,

- Функция распределения

имеет конечное или счётное множество точек разрыва первого рода,

- Если

– точка непрерывности

, то существует

.

Решётчатые распределения[править | править код]

Решётчатым называется распределение с дискретной функцией распределения и точки разрыва функции распределения образуют подмножество точек вида

Теорема. Для того, чтобы функция распределения

Абсолютно непрерывные распределения[править | править код]

Распределение случайной величины

Примерами абсолютно непрерывных распределений являются нормальное распределение, равномерное распределение, экспоненциальное распределение, распределение Коши.

Пример. Пусть

![(a,b)subset [0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/24d36dd131385c5f4e29f0828318555527897406)

Для любой плотности распределения

;

.

Верно и обратное — если функция

;

,

то существует распределение

Применение формулы Ньютона-Лейбница приводит к следующим соотношениям между функцией и плотностью абсолютно непрерывного распределения:

Теорема. Если

.

При построении распределения по эмпирическим (опытным) данным следует избегать ошибок округления.

Сингулярные распределения[править | править код]

Кроме дискретных и непрерывных случайных величин существуют величины, не являющиеся ни на одном интервале ни дискретными, ни непрерывными. К таким случайным величинам относятся, например, те, функции распределения которых непрерывные, но возрастают только на множестве лебеговой меры нуль[4].

Сингулярными называют распределения, сосредоточенные на множестве нулевой меры (обычно меры Лебега).

Таблица основных распределений[править | править код]

| Название | Обозначение | Параметр | Носитель | Плотность (последовательность вероятностей) | Матем. ожидание | Дисперсия | Характеристическая функция |

|---|---|---|---|---|---|---|---|

| Дискретное равномерное |  |

|

|

|

|

|

|

| Бернулли |  |

|

|

|

|

|

|

| Биномиальное |  |

|

|

|

|

|

|

| Пуассоновское |  |

|

|

|

|

|

|

| Геометрическое |  |

![{displaystyle pin (0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc11ca62a414431ebe4c2411bc5931fa9dfbf66e) |

|

|

|

|

|

| Название | Обозначение | Параметр | Носитель | Плотность вероятности  |

Функция распределения F(х) | Характеристическая функция | Математическое ожидание | Медиана | Мода | Дисперсия | Коэффициент асимметрии | Коэффициент эксцесса | Дифференциальная энтропия | Производящая функция моментов |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

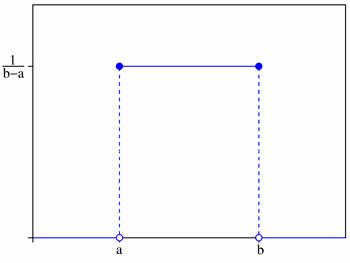

| Равномерное непрерывное |  |

, ,  — коэффициент сдвига, — коэффициент сдвига,  — коэффициент масштаба — коэффициент масштаба |

![{displaystyle [a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935) |

![{displaystyle {dfrac {1}{b-a}}I{xin [a,b]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2f5cf3af1781a097132a99a0faa824b63e0150ff) |

![{displaystyle {dfrac {x-a}{b-a}}I{xin [a,b]}+I{x>b}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5b34ee204339a66241f331f91f2c1bf882fd2b8a) |

|

|

|

любое число из отрезка ![[a,b]](https://wikimedia.org/api/rest_v1/media/math/render/svg/9c4b788fc5c637e26ee98b45f89a5c08c85f7935) |

|

|

|

|

|

| Нормальное (гауссовское) |  |

— коэффициент сдвига, — коэффициент сдвига,  — коэффициент масштаба — коэффициент масштаба |

|

|

|

|

|

|

|

|

|

|

|

|

| Логнормальное |  |

|

|

|

![{frac {1}{2}}+{frac {1}{2}}{mathrm {Erf}}left[{frac {ln(x)-mu }{sigma {sqrt {2}}}}right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/1a9d6e18da5576e1e9e9ebfb992655a16fd71de4) |

|

|

|

|

|

|

|

|

|

| Гамма-распределение |  |

|

|

|

|

|

|

при при  |

|

|

|

|

при при

|

|

| Экспоненциальное |  |

|

|

|

|

|

|

|

|

|

|

|

|

|

| Лапласа |  |

— коэффициент масштаба, — коэффициент масштаба,  — коэффициент сдвига — коэффициент сдвига |

|

|

|

|

|

|

|

|

|

|

|

|

| Коши |  |

— коэффициент сдвига, — коэффициент сдвига,  — коэффициент масштаба — коэффициент масштаба |

|

|

|

|

нет |  |

|

|

нет | нет |  |

нет |

| Бета-распределение |  |

|

![{displaystyle [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d) |

|

|

|

|

![{displaystyle I_{frac {1}{2}}^{[-1]}(alpha ,beta )approx {frac {alpha -{tfrac {1}{3}}}{alpha +beta -{tfrac {2}{3}}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/acc904cfdb07eeda7e157e6dbf3f12f9ac70e611) для для  |

для для  |

|

|

|

|

|

| хи-квадрат |  |

— число степеней свободы — число степеней свободы |

|

|

|

|

|

примерно  |

если если  |

|

|

|

![{frac {k}{2}}!+!ln left[2Gamma left({k over 2}right)right]!+!left(1!-!{frac {k}{2}}right)psi left({frac {k}{2}}right)](https://wikimedia.org/api/rest_v1/media/math/render/svg/68f01393e5f33aee251e935c9fdb24c42d85af2a) |

, если , если

|

| Стьюдента |  |

— число степеней свободы — число степеней свободы |

|

|

|

для для  |

, если , если  |

|

|

, если , если  |

, если , если  |

, если , если  |

![{begin{matrix}{frac {n+1}{2}}left[psi ({frac {1+n}{2}})-psi ({frac {n}{2}})right]\[0.5em]+log {left[{sqrt {n}}B({frac {n}{2}},{frac {1}{2}})right]}end{matrix}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1cd3fdc61973f68042141bd52ef3b36cd233e8a0) |

Нет |

| Фишера |  |

– числа степеней свободы – числа степеней свободы |

|

|

|

|

, если , если  |

, если , если  |

если если  |

если  |

|

|

||

| Рэлея |  |

|

|

|

|

|

|

|

|

|

|

|

|

|

| Вейбулла |  |

– коэффициент масштаба, – коэффициент масштаба,  – коэффициент формы – коэффициент формы |

|

|

|

|

|

|

для для  |

|

|

|

|

|

| Логистическое |  |

, ,  |

|

|

|

для для  |

|

|

|

|

|

|

|

для

|

| Вигнера |  |

– радиус – радиус |

![{displaystyle [-R;+R]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1220f1c83fabcfbacecc48e24894de39f2457a44) |

|

для для  |

|

|

|

|

|

|

|

|

|

| Парето |  |

— коэффициент масштаба, — коэффициент масштаба,  |

|

|

|

![{displaystyle k{big (}Gamma (-k){big [}x_{text{m}}^{k}(-it)^{k}-(-ix_{text{m}}t)^{k}{big ]}+E_{text{k+1}}(-ix_{text{m}}t){big )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/82b2a7e6f9af7758fd69d56b96a670713e8e1473) |

, если , если  |

![{displaystyle x_{text{m}}{sqrt[{k}]{2}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b4e35961fe9242e183d968bd97508d7871d93464) |

|

при при  |

при при  |

при при  |

|

нет |

где

| Название | Обозначение | Параметр | Носитель | Плотность (последовательность вероятностей) | Матем. ожидание | Дисперсия | Характеристическая функция |

|---|---|---|---|---|---|---|---|

| Гауссовское |  |

– симм. и неотр. опр. – симм. и неотр. опр. |

|

|

|

|

|

Примечания[править | править код]

- ↑ Маталыцкий, Хацкевич. Теория вероятностей, математическая статистика и случайные процессы, 2012. – С.69

- ↑ Маталыцкий, Хацкевич. Теория вероятностей, математическая статистика и случайные процессы, 2012. – С.68

- ↑ 1 2 Рамачандран, 1975, с. 38.

- ↑ Маталыцкий, Хацкевич. Теория вероятностей, математическая статистика и случайные процессы, 2012. — С.76

Литература[править | править код]

- Распределение вероятностей // Большая российская энциклопедия : [в 35 т.] / гл. ред. Ю. С. Осипов. — М. : Большая российская энциклопедия, 2004—2017.

- Лагутин М.Б. Наглядная математическая статистика. — М.: Бином, 2009. — 472 с.

- Жуковский М.Е., Родионов И.В. Основы теории вероятностей. — М.: МФТИ, 2015. — 82 с.

- Жуковский М.Е., Родионов И.В., Шабанов Д.А. Введение в математическую статистику. — М.: МФТИ, 2017. — 109 с.

- Рамачандран Б. Теория характеристических функций. — М.: Наука, 1975. — 224 с.

- Королюк В.С., Портенко Н.И., Скороход А.В., Турбин А.Ф. Справочник по теории вероятностей и математической статистике. — М.: Наука, 1985. — 640 с.

- Губарев В.В. Вероятностные модели: Справочник в 2-х частях. — Новосибирск.: Новосибир. электротехн. ин-т, 1992. — 422 с.

См. также[править | править код]

- Маргинальное распределение

Формулы: законы распределения случайных величин

В данном разделе вы найдете формулы по теории вероятностей, описывающие законы распределения дискретных и непрерывных случайных величин: биномиальный, Пуассона, экспоненциальный, равномерный, нормальный.

Каталог формул по теории вероятности онлайн

Законы распределения на этой странице

|

|

Понравилось? Добавьте в закладки

Дискретные случайные величины

Биномиальное распределение ДСВ

Пусть дискретная случайная величина $X$ – количество “успехов” в последовательности из $n$ независимых случайных экспериментов, таких что вероятность “успеха” в каждом из них равна $p$ (“неуспеха” – $q=1-p$).

Закон распределения $X$ имеет вид:

| $x_k$ | 0 | 1 | … | k | … | n |

| $p_k$ | $q^n$ | $ncdot p cdot q^{n-1}$ | $C_n^k cdot p^k cdot q^{n-k}$ | $p^n$ |

Здесь вероятности находятся по формуле Бернулли:

$$

P(X=k) = C_n^k cdot p^k cdot (1-p)^{n-k} = C_n^k cdot p^k cdot q^{n-k}, k=0,1,2,…,n.

$$

Числовые характеристики биномиального распределения:

$$M(X)=np, quad D(X)=npq, sigma(X)=sqrt{npq}.$$

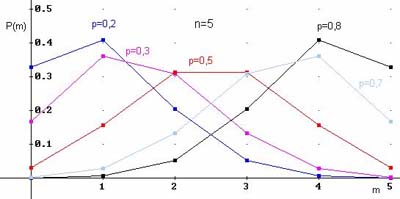

Примеры многоугольников распределения для $n=5$ и различных вероятностей:

Примеры решенных задач на биномиальный закон ДСВ

Пуассоновское распределение ДСВ

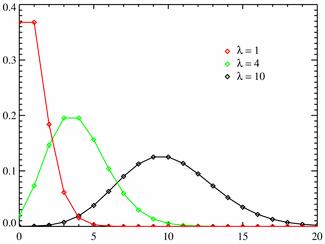

Распределение Пуассона моделирует случайную величину, представляющую собой число событий, произошедших за фиксированное время, при условии, что данные события происходят с некоторой фиксированной средней интенсивностью и независимо друг от друга.

При условии $pto 0$, $n to infty$, $np to lambda = const$ закон распределения Пуассона является предельным случаем биномиального закона. Так как при этом вероятность $p$ события $A$ в каждом испытании мала, то закон распределения Пуассона называют часто законом редких явлений.

Ряд распределения по закону Пуассона имеет вид:

| $x_k$ | 0 | 1 | … | k | … |

| $p_k$ | $e^{-lambda}$ | $lambda e^{-lambda}$ | … | $frac{lambda^k}{k!}cdot e^{-lambda}$ | … |

Вероятности вычисляются по формуле Пуассона:

$$

P(X=k)=frac{lambda^k}{k!}cdot e^{-lambda}, k=0,1,2,…

$$

Числовые характеристики для распределения Пуассона:

$$M(X)=lambda, quad D(X)=lambda, sigma(X)=sqrt{lambda}.$$

Разные многоугольники распределения при $lambda = 1; 4; 10$.

Примеры решенных задач на закон Пуассона

Геометрическое распределение ДСВ

Пусть происходит серия независимых испытаний, в каждом из которых событие может появится с одной и той же вероятностью $p$. Тогда случайная величина $X$ – количество испытаний до первого появления события, имеет геометрическое распределение вероятностей.

Формула для вероятностей:

$$

P(X=k) = q^k cdot p, k=0,1,2,…,n,…

$$

Ряд распределения геометрического закона:

| $x_k$ | 0 | 1 | 2 | … | k | … |

| $p_k$ | $p$ | $qcdot p$ | $q^2 cdot p$ | … | $q^k cdot p$ | … |

Числовые характеристики:

$$M(X)=frac{q}{p}, quad D(X)=frac{q}{p^2}.$$

Примеры решенных задач на геометрическое распределение

Гипергеометрическое распределение ДСВ

Из урны, в которой находятся $N$ шаров ($K$ белых и $N-K$ чёрных шаров), наудачу и без возвращения вынимают $n$ шаров ($n le N$). Найти закон распределения случайной величины $X$ – равной числу белых шаров среди выбранных.

Случайная величина $X$ может принимать целые значения от $0$ до $K$ (если $n lt K$, то до $n$). Вероятности вычисляются по формуле:

$$

P(X=k)=frac{C_K^k cdot C_{N-K}^{n-k}}{C_N^n}, quad 0le k le K.

$$

Числовые характеристики:

$$M(X)=frac{K}{N}cdot n, quad D(X)=frac{K}{N}cdot n cdot frac{N-n}{N} cdot frac{N-K}{N-1}.$$

Примеры задач на гипергеометрическое распределение

Решаем теорию вероятностей на отлично. Закажите сейчас!

Непрерывные случайные величины

Показательное распределение НСВ

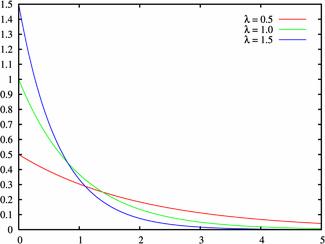

Экспоненциальное или показательное распределение — абсолютно непрерывное распределение, моделирующее время между двумя последовательными свершениями одного и того же события.

Плотность распределения величины $X$(везде $ lambda gt 0)$:

$$

f(x)=

left{

begin{array}{l}

0, x lt 0\

lambda e^{-lambda x}, xge 0 \

end{array}

right.

$$

Функция распределения величины $X$:

$$

F(x)=

left{

begin{array}{l}

0, x lt 0\

1- e^{-lambda x}, xge 0 \

end{array}

right.

$$

Числовые характеристики можно найти по формулам:

$$M(X)=frac{1}{lambda}, quad D(X)=frac{1}{lambda^2}, quad sigma= frac{1}{lambda}.$$

Плотность распределения при различных значениях $lambda gt 0$:

Примеры решенных задач на показательное распределение

Равномерное распределение НСВ

Равномерный закон распределения используется при анализе ошибок округления при проведении числовых расчётов (например, ошибка округления числа до целого распределена равномерно на отрезке), в ряде задач массового обслуживания, при статистическом моделировании наблюдений, подчинённых заданному распределению.

Плотность распределения на отрезке $(a;b)$:

$$

f(x)=

left{

begin{array}{l}

0, x le a\

frac {1}{b-a}, a lt x le b, \

0, x gt b, \

end{array}

right.

$$

Функция распределения:

$$

F(x)=

left{

begin{array}{l}

0, x le a\

frac {x-a}{b-a}, a lt x le b, \

1, x gt b, \

end{array}

right.

$$

Числовые характеристики равномерно распределенной случайной величины:

$$M(X)=frac{a+b}{2}, quad D(X)=frac{(b-a)^2}{12}, quad sigma=frac{b-a}{2sqrt{3}}.$$

График плотности вероятностей:

Примеры решенных задач на равномерное распределение

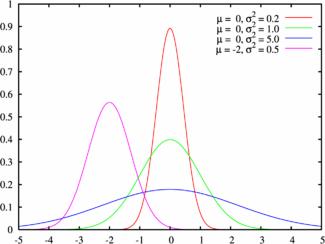

Нормальное распределение или распределение Гаусса НСВ

Нормальное распределение, также называемое распределением Гаусса, – распределение вероятностей, которое играет важнейшую роль во многих областях знаний, особенно в физике.

Физическая величина подчиняется нормальному распределению, когда она подвержена влиянию огромного числа случайных помех. Ясно, что такая ситуация крайне распространена, поэтому можно сказать, что из всех распределений в природе чаще всего встречается именно нормальное распределение — отсюда и произошло одно из его названий.

Плотность распределения нормальной случайной величины $X$ имеет вид:

$$f(x)= frac{1}{sigmasqrt{2pi}} expleft({-frac{(x-a)^2}{2sigma^2}}right). $$

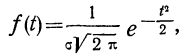

При $a=0$ и $sigma=1$ эта функция принимает вид:

$$varphi(x)= frac{1}{sqrt{2pi}} e^{-x^2/2}.$$

Скачать таблицу для функции $varphi(x)$

Числовые характеристики для нормального распределения:

$$M(X)=a, quad D(X)=sigma^2.$$

Пример графика плотности распределения для различных значений среднего и СКО:

Нормальный закон распределения случайной величины с параметрами $a=0$ и $sigma=1$ называется стандартным или нормированным, а соответствующая нормальная кривая – стандартной или нормированной.

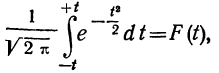

Функция Лапласа определяется как:

$$Phi(x)= frac{1}{sqrt{2pi}}int_0^x e^{-t^2/2} dt$$

Скачать таблицу для функции Лапласа

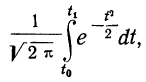

Вероятность попадания нормально распределенной случайной величины $X$ в заданный интервал $(alpha, beta)$:

$$

P(alpha lt X lt beta) = Phileft( frac{beta-a}{sigma} right) – Phileft( frac{alpha-a}{sigma} right).

$$

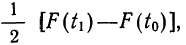

Вероятность отклонения нормально распределенной случайной величины $X$ на величину $delta$ от математического ожидания (по модулю).

$$

P(|X -a|lt delta) = 2 Phileft( frac{delta}{sigma} right).

$$

Примеры решенных задач на нормальное распределение

Полезная страница? Сохрани или расскажи друзьям

Решенные задачи по теории вероятностей

Ищете готовые задачи по теории вероятностей? Посмотрите в решебнике:

Подробно решим теорию вероятностей. Закажите сейчас!

Полезные ссылки

|

|

Содержание:

Законы распределения:

Распределение случайных переменных: Каждая из случайных переменных имеет ряд возможных значений, могущих возникнуть с определенной вероятностью.

Случайные переменные величины могут носить прерывный (дискретный) и непрерывный характер. Возможные значения прерывной случайной переменной отделены друг от друга конечными интервалами. Возможные значения непрерывной случайной переменной не могут быть заранее перечислены и непрерывно заполняют некоторый промежуток.

Примерами прерывных случайных переменных могут служить:

- число попаданий при п выстрелах, если известна вероятность попадания при 1 выстреле. Число попаданий может быть 0, 1, 2….. n;

- число появлений герба при n бросаниях монеты.

Примеры непрерывных случайных переменных:

- ошибка измерения;

- дальность полета снаряда.

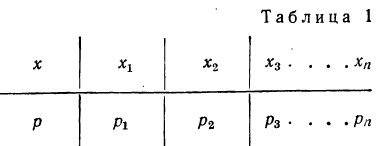

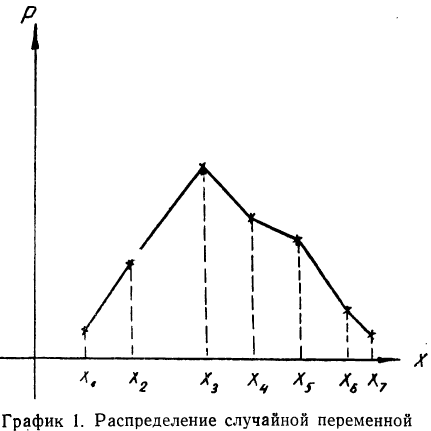

Если перечислить все возможные значения случайной переменной и указать вероятности этих значений, то получится распределение случайной переменной. Распределение случайной переменной указывает на соотношение между отдельными значениями случайной величины и их вероятностями.

Распределение случайной переменной будет задано законом распределения, если точно указать, какой вероятностью обладает каждое значение случайной переменной.

Закон распределения имеет чаще всего табличную -форму изложения. В этом случае перечисляются все возможные значения случайной переменной и соответствующие им вероятности:

Такая таблица называется также рядом распределения случайной переменной.

Для наглядности ряд распределения изображают графически, откладывая на прямоугольной системе координат по оси абсцисс возможные значения случайной переменной, а по оси ординат — их вероятности. В результате графического изображения получается многоугольник или полигон распределения (график 1). Многоугольник распределения является одной из форм закона распределения.

Функция распределения

Ряд распределения является исчерпывающей характеристикой прерывной случайной перемен-

Вероятность того, что Х<х, зависит от текущей переменной х и является функцией от х. Эта функция носит название функции распределения случайной переменной X.

F(x) = P(X

Функция распределения является одной из форм выражения закона распределения. Она является универсальной характеристикой случайной переменной и может существовать для прерывных и непрерывных случайных переменных.

Функция распределения F(x) называется также интегральной функцией распределения, или интегральным законом распределения.

Основные свойства функции распределения могут быть сформулированы так:

- F(x) всегда неотрицательная функция, т. е.

- Так как вероятность не может быть больше единицы, то

- Ввиду того что F(x) является неубывающей функцией, то при

- Предельное значение функции распределения при х=

равно нулю, а при х=

равно нулю, а при х= равно единице.

равно единице.

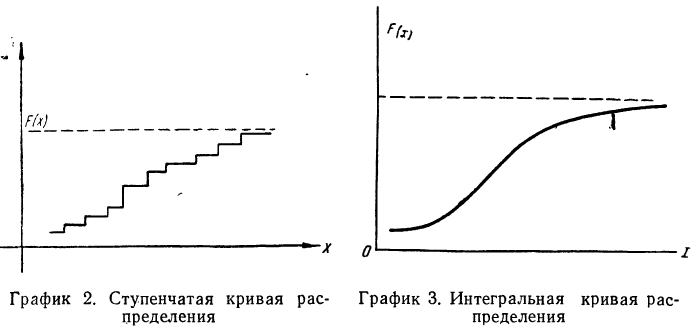

Если случайная переменная X дискретна и задана рядом распределения, то для нахождения F(x) для каждого х необходимо найти сумму вероятностей значений X, которые лежат до точки х.

Графическое изображение функции распределения представляет собой некоторую неубывающую кривую, значения которой начинаются с 0 и доходят до 1.

В случае дискретной случайной переменной величины вероятность F(x) увеличивается скачками всякий раз, когда х при своем изменении проходит через одно из возможных значений  величины X. Между двумя соседними значениями функция F(x) постоянна. Поэтому графически функция F(x) в этом случае будет изображена в виде ступенчатой кривой (см. график 2).

величины X. Между двумя соседними значениями функция F(x) постоянна. Поэтому графически функция F(x) в этом случае будет изображена в виде ступенчатой кривой (см. график 2).

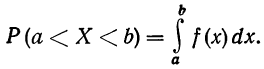

В случае непрерывной случайной переменной величины функция F(x) при графическом изображении дает плавную, монотонно возрастающую кривую следующего вида (см. график 3).

Обычно функция распределения непрерывной случайной переменной представляет собой функцию, непрерывную во всех точках. Эта функция является также дифференцируемой функцией. График функции распределения такой случайной переменной является плавной кривой и имеет касательную в любой ее точке.

Плотность распределения

Если для непрерывной случайной переменной X с функцией распределения F(x) вычислять вероятность попадания ее на участок от х до х+  х, т. е.

х, т. е.  то оказывается, что эта вероятность равна приращению функции распределения на этом участке, т. е.

то оказывается, что эта вероятность равна приращению функции распределения на этом участке, т. е.

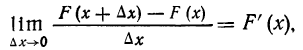

Если величину  полагать бесконечно малой величиной и находить отношение вероятности попадания на участок к длине участка, то величину отношения в пределе можно выразить так:

полагать бесконечно малой величиной и находить отношение вероятности попадания на участок к длине участка, то величину отношения в пределе можно выразить так:

т. е. производной от функции распределения, которая характеризует плотность, с которой распределяются значения случайной переменной в данной точке. Эта функция называется плотностью распределения и часто обозначается f(x). Ее называют также дифференциальной функцией распределения, или дифференциальным законом распределения.

Таким образом, функция плотности распределения f(x) является производной интегральной функции распределения F(x).

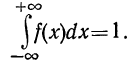

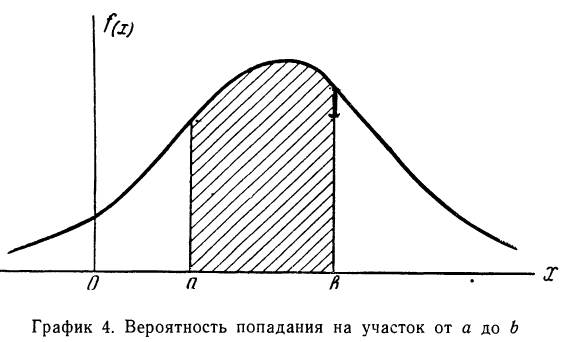

Вероятность того, что случайная переменная X примет значение, лежащее в границах от а до 6, равна определенному интегралу в тех же пределах от плотности вероятности, или:

Кривая, изображающая плотность распределения случайной переменной, называется кривой распределения (дифференциальной).

Построим кривую некоторой заданной функции плотности вероятности и найдем участок, ограниченный абсциссами а и b. Площадь, ограниченная соответствующими ординатами кривой распределения самой кривой и осью абсцисс, и отобразит вероятность того, что случайная переменная будет находиться в данных пределах (см. график 4).

Плотность распределения является одной из форм закона распределения, но существует только для непрерывных случайных величин.

Основные свойства плотности распределения могут быть сформулированы так:

1. Плотность распределения есть функция, не могущая принимать отрицательных значений, т. е.

Отсюда в геометрическом изображении плотности распределения (в кривой распределения) не может быть точек, лежащих ниже оси абсцисс.

2. Следовательно, вся площадь, ограниченная кривой распределения и осью абсцисс, равна единице.

Следовательно, вся площадь, ограниченная кривой распределения и осью абсцисс, равна единице.

Среди законов распределения большое значение имеют биномиальное распределение, распределение Пуассона и нормальное распределение.

Биномиальное распределение

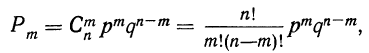

Если производится n независимых испытаний, в каждом из которых вероятность появления данного события А есть величина постоянная, равная р, и, следовательно, вероятность непоявления события А также постоянна и равна q=1—р, то число появлений события А во всех n испытаниях представляет собой случайную переменную. Вероятность того, что событие А появится в n испытаниях m раз, равна:

т. е. m+1, члену разложения бинома  Здесь q+p=1 и, следовательно,

Здесь q+p=1 и, следовательно,

—число сочетаний из n элементов по m. Теорема верна для любых m, в том числе и для m = 0 и m=n. Вероятность

—число сочетаний из n элементов по m. Теорема верна для любых m, в том числе и для m = 0 и m=n. Вероятность  появления события А образует распределение вероятностей случайной переменной m.

появления события А образует распределение вероятностей случайной переменной m.

Ввиду того что вероятности  связаны с разложением бинома

связаны с разложением бинома  распределение случайной переменной m называется биномиальным распределением. Биномиальное распределение является распределением дискретной случайной переменной, поскольку величины m могут принимать только вполне определенные целые значения.

распределение случайной переменной m называется биномиальным распределением. Биномиальное распределение является распределением дискретной случайной переменной, поскольку величины m могут принимать только вполне определенные целые значения.

График биномиального распределения, на котором по оси абсцисс откладываются числа наступлений события, а по оси ординат — вероятности этих чисел, представляет собой ломаную линию. Форма графика зависит от значений р, q и n.

Если р и q одинаковы, то график распределения симметричен. Если же р и q неодинаковы, то график распределения будет скошенным.

Одна из частот на графике имеет максимальное значение. Это наиболее вероятная частота. Ее значение можно определить приближенно, аналитически как произведение nр.

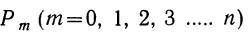

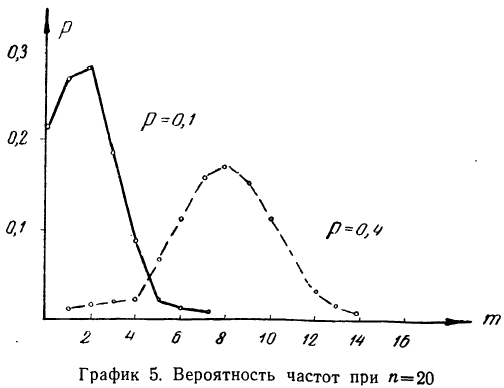

Найдем вероятности числа наступления события А при 20 испытаниях при p = 0,1 и р = 0,4 и построим график их распределений (см. график 5). Найдем вероятности частот при n = 20 для p = 0,1 и р=0,4.

График показывает, что приближение р к 0,5 вносит в распределение большую симметрию. Оказывается также, что при увеличении n распределение становится симметричным и для

Биномиальное распределение имеет широкое распространение в практической деятельности людей. Например, продолжительное наблюдение за качеством выпускаемой заводом продукции показало, что p-я часть ее является браком. Иначе говоря, мы выражаем через р вероятность для любого изделия оказаться бракованным. Биномиальное распределение показывает вероятность того, что в партии, содержащей n изделий, окажется m бракованных, где m = 0, 1, 2, 3 … n.

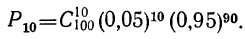

Предположим, имеется 100 изделий из партии изделий, в ко торой доля брака равна 0,05. Вероятность того, что из этих из делий окажется 10 бракованных, равна:

Закон биномиального распределения называется также схемой Бернулли. .

Нормальное распределение

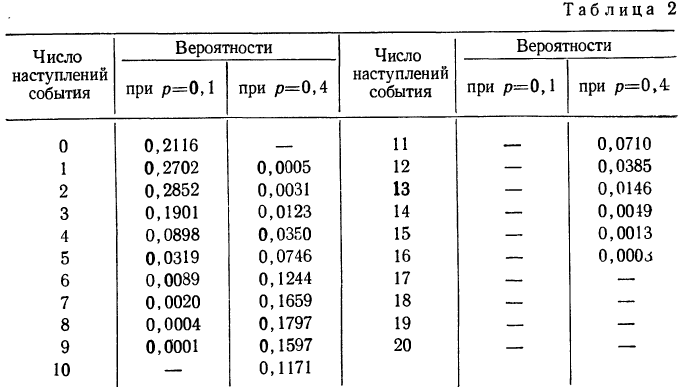

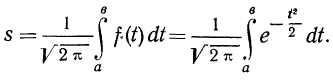

Расчет вероятностей по формуле биномиального распределения при больших n очень громоздок. При этом значении m прерывны, и нет возможности аналитически отыскать их сумму в некоторых границах. Лаплас нашел закон распределения, являющийся предельным законом при неограниченном возрастании числа испытаний n и называемый законом нормального распределения.

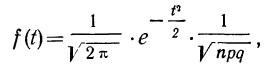

Плотность вероятности нормального распределения выражается при этом формулой:

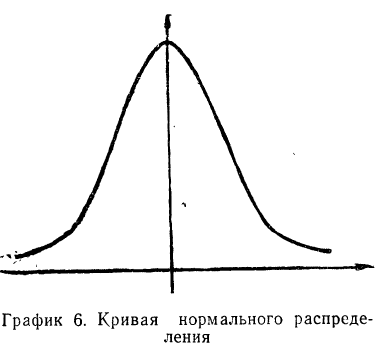

где t представляет собой нормированное отклонение частоты т от наиболее вероятной частоты nр, т. е.  — среднее квадратическое отклонение случайной переменной m. Графическое изображение плотности распределения f(t) дает кривую нормального распределения (см. график 6).

— среднее квадратическое отклонение случайной переменной m. Графическое изображение плотности распределения f(t) дает кривую нормального распределения (см. график 6).

Максимальная ордината кривой соответствует точке m=nр, т. е. математическому ожиданию случайной переменной m; величина этой ординаты равна  .

.

Для практического нахождения вероятностей используют таблицу значений f(t).

Эмпирические и теоретические распределения

В примерах распределений, приведенных в разделе I, мы пользовались данными, почерпнутыми из наблюдений.

Поэтому всякий наблюденный ряд распределения назовем эмпирическим, а график, изображающий распределение

частот этого ряда, — эмпирической кривой распределения. Эмпирические кривые распределения могут быть представлены полигоном и гистограммой. При этом изображение в виде полигона применяется для рядов с прерывными значениями признака, а гистограмма— для рядов с непрерывными значениями признака.

Наблюдая многочисленные ряды распределения, математики стремятся описать эти распределения путем анализа образования величины признака, пытаются построить теоретическое распределение, исходя из данных об эмпирическом распределении.

Мы уже видели на примере распределения случайной переменной, что распределение ее задается законом распределения. Закон распределения, заданный в виде функции распределения, позволяет математически описать ряды распределения некоторых совокупностей.

Теоретическим законом распределения многих совокупностей, наблюдаемых на практике, является нормальное распределение. Иначе говоря, многие эмпирические подчинены закону нормального распределения, функция плотности вероятности которого приведена в предыдущем параграфе.

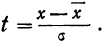

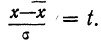

Чтобы эту формулу применять для нахождения теоретических данных по некоторому эмпирическому ряду, необходимо вероятностные характеристики заменить данными эмпирического ряда. При этой замене величина стандартизованного отклонения t будет представлять собой  где х— текущие значения случайной переменной X, а

где х— текущие значения случайной переменной X, а  и

и  — соответствующие характеристики эмпирического распределения, а именно средняя арифметическая и среднее квадратическое отклонение.

— соответствующие характеристики эмпирического распределения, а именно средняя арифметическая и среднее квадратическое отклонение.

Следовательно, нормальное распределение ряда распределения зависит от величин средней арифметической и его среднего квадратического отклонения.

Свойства кривой нормального распределения

Дифференциальный закон нормального распределения, заданный функцией:

имеет ряд свойств. Полагая  =1, тем самым будем иметь измерение варьирующего признака в единицах среднего квадратического отклонения. Тогда функция нормального распределения упростится и примет вид:

=1, тем самым будем иметь измерение варьирующего признака в единицах среднего квадратического отклонения. Тогда функция нормального распределения упростится и примет вид:

Рассмотрим ее свойства.

- Кривая нормального распределения имеет ветви, удаленные в бесконечность, причем кривая асимптотически приближается к оси Ot.

- Функция является четной: t(—t) = f(t). Следовательно, кривая нормального распределения симметрична относительно оси Оу.

- Функция имеет максимум при t = 0. Величина этого максимума равна

Следовательно, модального значения кривая

достигает при t = 0, а так как  то при

то при

Наибольшую частоту кривая будет иметь при значении х, равном среднему арифметическому из отдельных вариантов. Средняя арифметическая является центром группирования частот ряда.

4. При t=±1 функция имеет точки перегиба. Это означает, что кривая имеет точки перегиба при отклонениях от центра

группирования  равных среднему квадратическому отклонению.

равных среднему квадратическому отклонению.

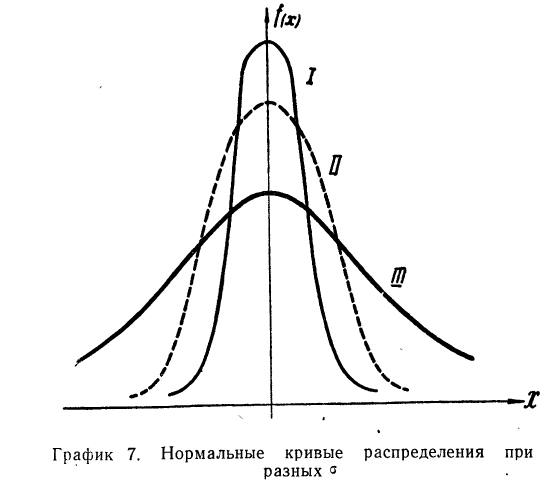

5. Сумма частостей, лежащих в пределах от а до b, равна определенному интегралу в тех же пределах от функции f(t), т. е.

Если учесть действительную величину среднего квадратического отклонения, то окажется, что при больших величинах о значение f(t) мало, при малых, наоборот, велико. Отсюда изменяется и форма кривой распределения. При больших  кривая нормального распределения становится плоской, растягиваясь вдоль оси абсцисс. При уменьшении

кривая нормального распределения становится плоской, растягиваясь вдоль оси абсцисс. При уменьшении  кривая распределения вытягивается вверх и сжимается с боков.

кривая распределения вытягивается вверх и сжимается с боков.

На графике 7 показаны 3 кривые нормального распределения (I, II, III) при  из них кривая I соответствует самому большому, а кривая III—самому малому значению

из них кривая I соответствует самому большому, а кривая III—самому малому значению

Зная общие свойства кривой нормального распределения, рассмотрим те условия, которые приводят к образованию кривых данного типа.

Формирование нормального распределения

Закон нормального распределения является наиболее распространенным законом не только потому, что он наиболее часто встречается, но и потому, что он является предельным законом распределения, к которому приближается ряд других законов распределения.

Нормальное распределение образуется в том случае, когда действует большое число независимых (или слабо зависимых), случайных причин. Подчиненность закону нормального распределения проявляется тем точнее, чем больше случайных величин действует вместе. Основное условие формирования нормального распределения состоит в том, чтобы все случайные величины, действующие вместе, играли в общей сумме примерно одинаковую роль. Если одна из случайных ошибок окажется по своему влиянию резко превалирующей над другими, то закон распределения будет обусловлен действием этой величины.

Если есть основания рассматривать изучаемую величину как сумму многих независимых слагаемых, то при соблюдении указанного выше условия ее распределение будет нормальным, независимо от характера распределения слагаемых.

Нормальное распределение встречается часто в биологических явлениях, отклонениях размеров изделий от их среднего размера, погрешностях измерения и т. д.

Если взять распределение людей по номеру носимой ими обуви, то это распределение будет нормальным. Но это правило применимо только в том случае, когда численность совокупности велика и сама совокупность однородна.

Из того факта, что нормальное распределение встречается нередко в разных областях, не следует, что всякий признак распределяется нормально. Наряду с нормальным распределением существуют другие различные распределения.

Но все же умение выявить нормальное распределение в некоторой эмпирической совокупности является важным условием для ряда практических расчетов и действий. Зная, что эмпирическое распределение является нормальным, можно определить оптимальные размеры предприятий, размеры резервов и т. д.

Важным условием определения характера данной эмпирической кривой является построение на основе эмпирических данных теоретического нормального распределения.

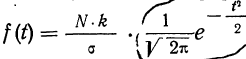

Построение кривой нормального распределения

Первый способ. Для того чтобы построить кривую нормального распределения, пользуются следующей егo формулой:

где N — число проведенных испытаний, равное сумме частот эмпирического распределения

k — величина интервала дробления эмпирического ряда распределения;

— среднее квадратическое отклонение ряда;

— среднее квадратическое отклонение ряда;

t—нормированное отклонение, т. е.

Величина  табулирована и может быть найдена по таблице (см. приложение II).

табулирована и может быть найдена по таблице (см. приложение II).

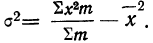

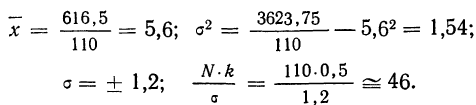

Для нахождения значений теоретических частот (см. пример 1) сначала необходимо найти среднюю арифметическую эмпирического ряда распределения, т. е.  для чего находим произведения хm. Затем находим дисперсию ряда, вос-пользовавшись формулой

для чего находим произведения хm. Затем находим дисперсию ряда, вос-пользовавшись формулой  Поскольку средняя уже найдена, остается найти

Поскольку средняя уже найдена, остается найти  для чего по каждой строке находим

для чего по каждой строке находим  (графы 4 и 5). Затем определяем величину t, последовательно записывая для каждой строки

(графы 4 и 5). Затем определяем величину t, последовательно записывая для каждой строки  и

и  (графы 6 и 7). Графа 7 дает величину t по строкам. Из таблицы значений f(t) (см. приложение II) для данных в графе 7 найдем соответствующие величины (графа 8). Осталось найденные величины умножить на общий для всех строк множитель

(графы 6 и 7). Графа 7 дает величину t по строкам. Из таблицы значений f(t) (см. приложение II) для данных в графе 7 найдем соответствующие величины (графа 8). Осталось найденные величины умножить на общий для всех строк множитель

Найденная при умножении величина и составляет теоретическую частоту каждого варианта, записанного в строке (графа 9). Ввиду того что частоты могут быть только целыми числами, округляем их до целых и получим теоретические частоты, которые будем обозначать  (графа 10).

(графа 10).

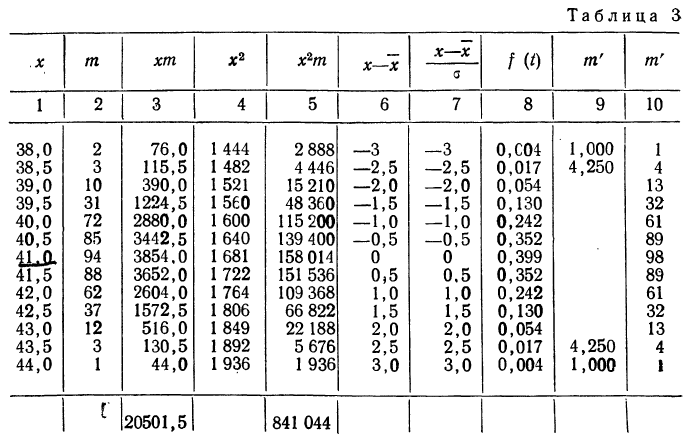

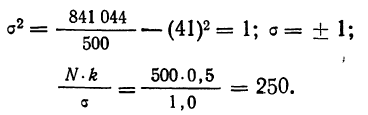

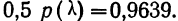

Пример 1.

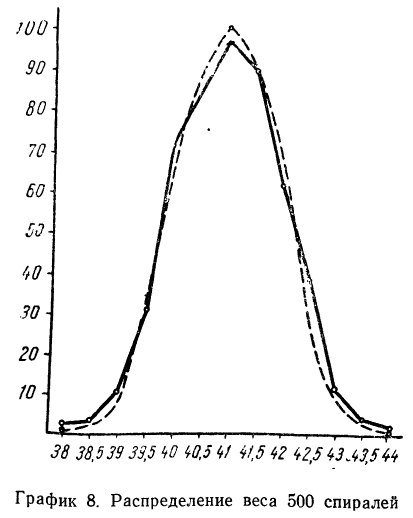

В таблице 3 приведено эмпирическое распределение веса 500 спиралей и расчет частот нормального распределения. (Вес спиралей х дан в миллиграммах.)

Из таблицы находим:

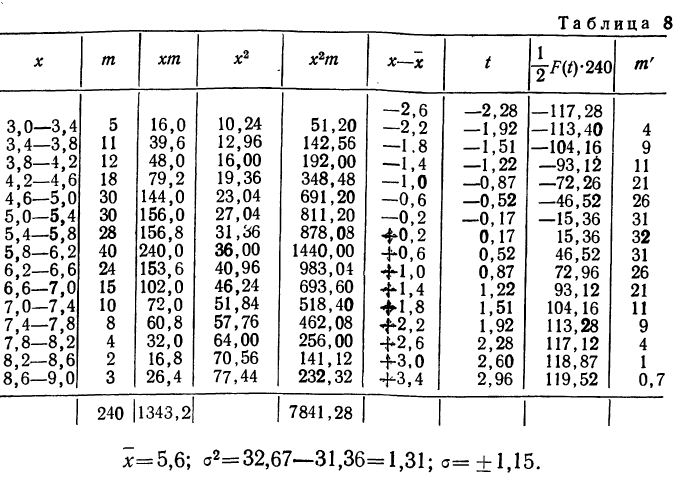

Строим график эмпирических и теоретических данных. На графике 8 сплошной линией дано изображение эмпирического распределения, а пунктирной — построенного на его основе теоретического распределения.

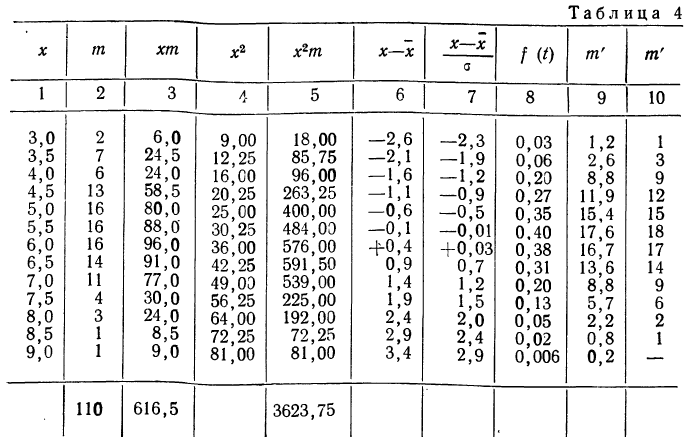

Пример 2.

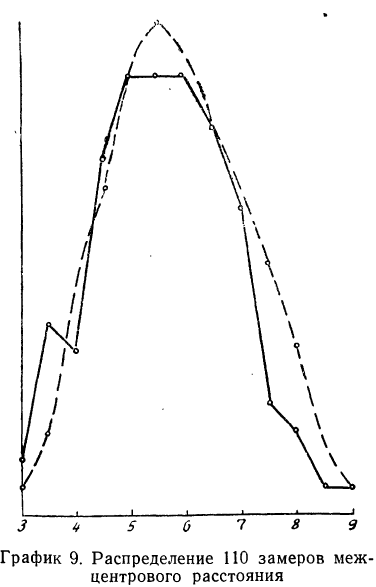

В таблице 4 дается эмпирическое распределение ПО замеров межцентрового расстояния при шевинговании зубцов динамомашины 110412 и расчет теоретических частот.

Исчислим:

Построим графики эмпирического и теоретического распределений (см. график 9).

Оба эмпирических распределения хорошо воспроизводятся теоретическим нормальным распределением.

Второй способ построения кривой нормального распределения основан на применении функции стандартизованного нормального распределения, в котором  = 1, т. е. величина наибольшей ординаты принимается за единицу.

= 1, т. е. величина наибольшей ординаты принимается за единицу.

За начало отсчета признака при этом способе построения берется его средняя арифметическая. Ей соответствует наибольшая ордината.

Вычисление ординат производится по формуле:

где N — число наблюдений;

k — величина интервала эмпирического распределения.

Так как значение наибольшей ординаты получается при

t = 0, когда  то величина наибольшей ординаты будет:

то величина наибольшей ординаты будет:

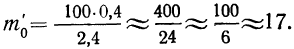

Придавая t последовательно значения 0,5; 1,0; 1,5; 2,0, т. е. сначала меньшие, а потом увеличивающиеся, находим в таблице стандартизованного нормального распределения для данных t соответствующие  и, умножив полученную величину на значение наибольшей ординаты, будем иметь ординаты для этих значений t.

и, умножив полученную величину на значение наибольшей ординаты, будем иметь ординаты для этих значений t.

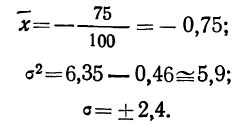

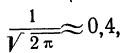

Например, при t = 0,5 величина стандартизованного нормального распределения = 0,8825. Так как величина наибольшей ординаты

= 0,8825. Так как величина наибольшей ординаты  то величина ординаты в точке t = 0,5 будет равна:

то величина ординаты в точке t = 0,5 будет равна:

Пример 3.

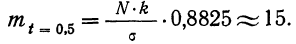

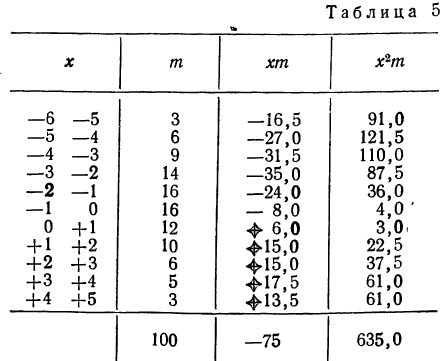

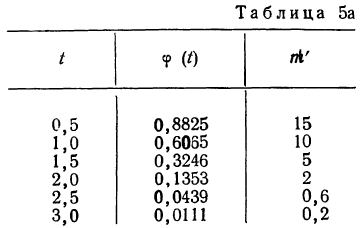

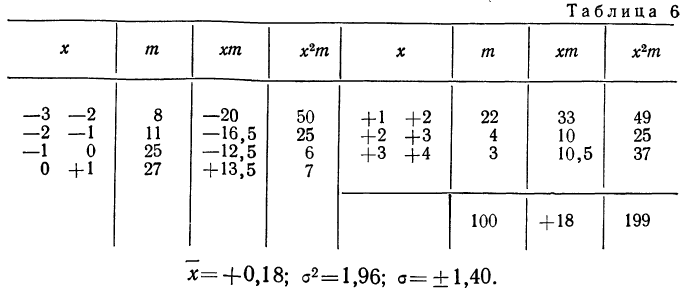

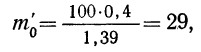

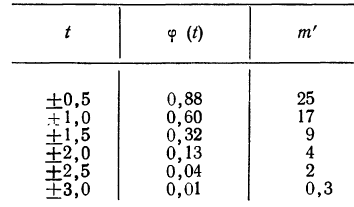

Взяты результаты измерения 100 отклонений шага резьбы х от всей длины резьбы. Получен следующий ряд распределения, для которого по общим правилам производится расчет средней и дисперсии.

Отсюда;

Рассчитаем наибольшую ординату:

так как величина  то:

то:

Взяв значение t = 0,5 по таблице стандартизованного нормального распределения, находим  При t = 0,5 оно равно 0,88251. Это и есть коэффициент, который при умножении на значение наибольшей ординаты дает величину ординаты в этой точке. Потом аналогично находим ординаты для t = ± 1 и т. д.

При t = 0,5 оно равно 0,88251. Это и есть коэффициент, который при умножении на значение наибольшей ординаты дает величину ординаты в этой точке. Потом аналогично находим ординаты для t = ± 1 и т. д.

Для данного примера будем иметь:

Полученный результат наносим на график, а для сравнения наносим на график и результаты непосредственных измерений отклонений (см. график 10).

Как видно из графика, теоретическая кривая довольно близко воспроизводит полигон эмпирического распределения.

Пример 4.

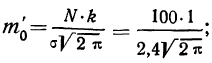

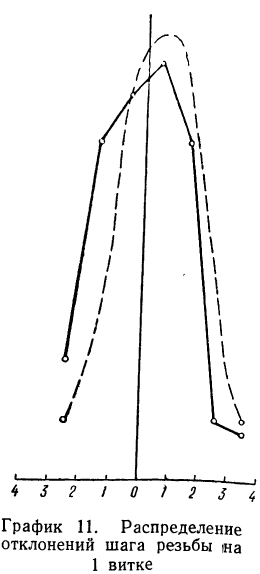

Даны результаты измерений отклонений шага резьбы (х) в микронах на 1 витке от среднего значения. Приводятся эти данные с соответствующими расчетами:

Теоретические частоты (ординаты) рассчитываются так же, как и в предыдущем примере. Сначала находится величина наибольшей частоты:

затем другие частоты:

Эмпирические и теоретические частоты наносим на график (см. график 11) и убеждаемся, что эмпирическое распределение довольно близко воспроизводится теоретическим распределением.

Третий способ построения кривой нормального распределения (или вычисления теоретических частот) по имеющимся эмпирическим данным основан на применении функции:

которая дает площадь нормальной кривой, заключенной между —t и +t.

Вообще говоря, можно находить площадь нормальной кривой, заключенную между любыми точками  как

как

применяя функцию F(t). Искомая площадь будет представлять собой  причем для отрицательных t надо брать F(t) со знаком минус.

причем для отрицательных t надо брать F(t) со знаком минус.

Пример 5.

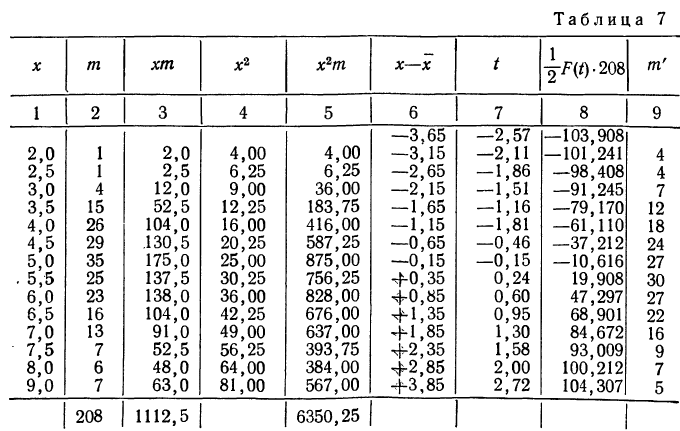

Получены результаты 208 измерений межцентровых расстояний при шевинговании зубцов шестерни динамо-машины (см. табл. 7). Вычислим нужные параметры и теоретические частоты и построим графики эмпирического и теоретического распределений.

Колонки 1, 2, 3, 4 и 5 необходимы для расчетов  и

и  в колонке 6 рассчитаны отклонения концов интервалов от средней, в колонке 7 — величина стандартизованного отклонения

в колонке 6 рассчитаны отклонения концов интервалов от средней, в колонке 7 — величина стандартизованного отклонения  Колонка 8 содержит значения F(t), взятые из приложения III, умноженные на

Колонка 8 содержит значения F(t), взятые из приложения III, умноженные на  т. е. на 104. В верхней строке приведено и значение t для конца интервала, предшествующего первому, т. е.

т. е. на 104. В верхней строке приведено и значение t для конца интервала, предшествующего первому, т. е.

Чтобы получить теоретическую частоту для каждого интервала, достаточно из верхней строки (в 8-й колонке) вычесть число той же колонки, стоящее строкой ниже.

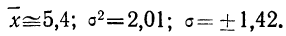

На графике 12 показано, что теоретическое распределение достаточно точно отражает эмпирически полученный материал, только наблюдается некоторое смещение теоретической кривой вправо, что, очевидно, вызвано большим удельным весом правого конца эмпирического распределения.

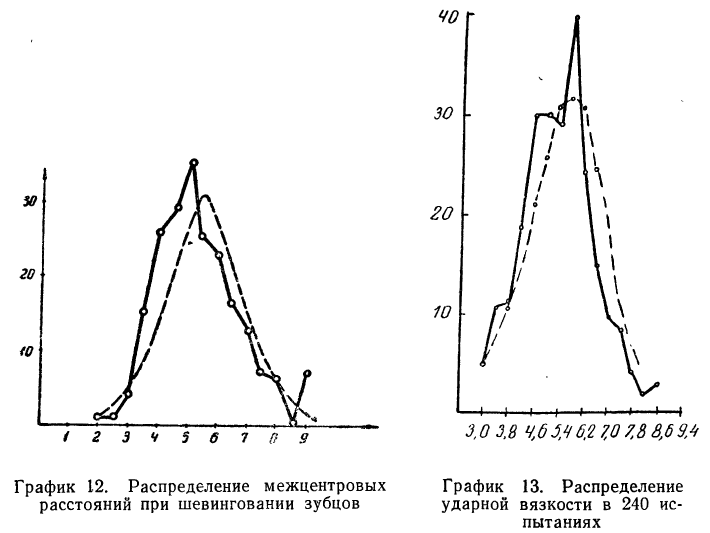

Пример 6.

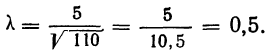

Дается ряд распределения ударной вязкости в 240 испытаниях. Приведем этот ряд распределения и построим для него теоретическое распределение (см. график 13).

Критерии согласия

Определение близости эмпирических распределений к теоретическому нормальному распределению по графику может быть недостаточно точным, субъективным и по-разному оценивать расхождения между ними. Поэтому математики выработали ряд объективных оценок для того, чтобы определить, является ли данное эмпирическое распределение нормальным. Такие оценки называются критериями согласия. Критерии согласия были предложены разными учеными, занимавшимися этим вопросом. Рассмотрим критерии согласия Пирсона, Романовского, Колмогорова и Ястремского.

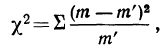

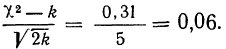

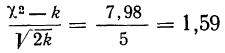

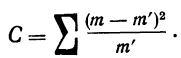

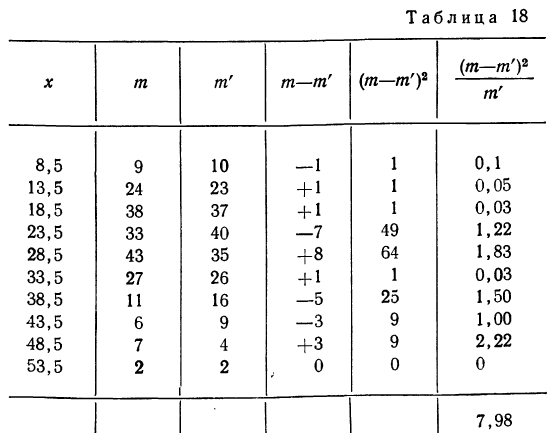

Критерий согласия Пирсона основан на определении величины  которая вычисляется как сумма квадратов разностей эмпирических и теоретических частот, отнесенных к теоретическим частотам, т. е.

которая вычисляется как сумма квадратов разностей эмпирических и теоретических частот, отнесенных к теоретическим частотам, т. е.

где m — эмпирические частоты;

m’ — теоретические частоты.

Для оценки того, насколько данное эмпирическое распределение воспроизводится нормальным распределением, исчисляют по распределению Пирсона вероятности достижения  данного значения

данного значения

Значения  вычислены для разных

вычислены для разных  табулированы и приводятся в приложении VI, в котором дается комбинационная таблица, где одним из аргументов (данные по строкам) являются значения

табулированы и приводятся в приложении VI, в котором дается комбинационная таблица, где одним из аргументов (данные по строкам) являются значения  а по другим (по столбцам) —значения k — число степеней свободы варьирования эмпирического распределения. Число степеней свободы вариации определяется для данного ряда распределения и равно числу групп в нем минус число исчисленных статистических характеристик (средняя, дисперсия, моменты распределения и т. д.), использованных при вычислении теоретического распределения.

а по другим (по столбцам) —значения k — число степеней свободы варьирования эмпирического распределения. Число степеней свободы вариации определяется для данного ряда распределения и равно числу групп в нем минус число исчисленных статистических характеристик (средняя, дисперсия, моменты распределения и т. д.), использованных при вычислении теоретического распределения.

Пересечение данного столбца с соответствующей строкой дает искомую вероятность

При вероятностях, значительно отличающихся от нуля, расхождение между теоретическими и эмпирическими частотами можно считать случайным.

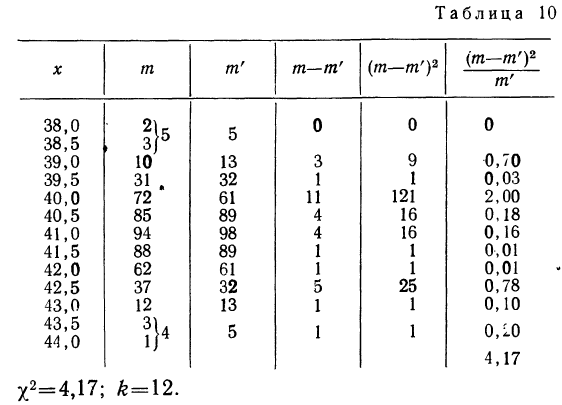

Проф. В. И. Романовский предложил более простой метод оценки близости эмпирического распределения к нормальному, используя величину

Он предложил вычислять отношение:

где k — число степеней свободы.

Если указанное отношение имеет абсолютное значение, меньшее трех, то предлагается расхождение между теоретическим и эмпирическим распределениями считать несущественным; если же это отношение больше трех, то расхождение существенно. Несущественность расхождения (когда величина отношения Романовского меньше трех) говорит о возможности принять за закон данного эмпирического распределения нормальное распределение.

По данным примера 2 рассчитаем величину

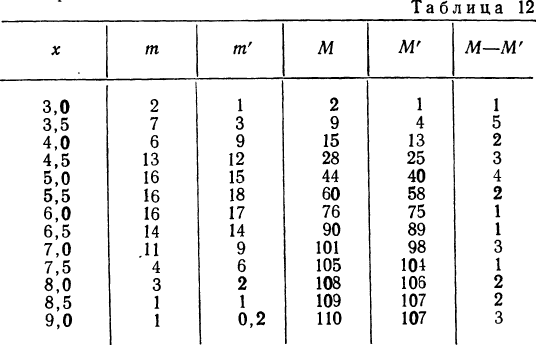

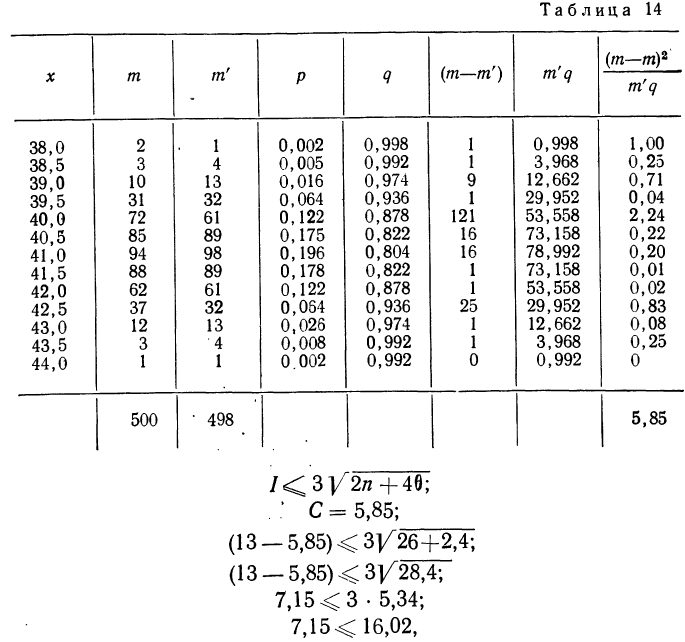

Пример 7.

Вычисление  Для распределения межцентрового расстояния в НО наблюдениях:

Для распределения межцентрового расстояния в НО наблюдениях:

Из таблицы  (приложение VI) для

(приложение VI) для  = 12 и k = 12 находим вероятность

= 12 и k = 12 находим вероятность  =0,4457; она достаточно велика, значит расхождение между теоретическими и эмпирическими частотами можно считать случайными, а распределение — подчиняющимся закону нормального распределения.

=0,4457; она достаточно велика, значит расхождение между теоретическими и эмпирическими частотами можно считать случайными, а распределение — подчиняющимся закону нормального распределения.

Находим отношение Романовского:

Это отношение значительно меньше трех, поэтому расхождение между теоретическими и эмпирическими частотами можно считать несущественными, и, таким образом, теоретическое распределение достаточно хорошо воспроизводит эмпирическое.

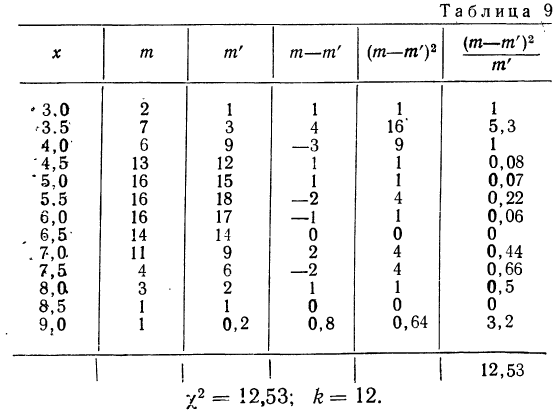

Пример 8.

Вычислим критерий  Для распределения веса 500 спиралей.

Для распределения веса 500 спиралей.

По таблице находим вероятность  = 0,9834, которая близка к достоверности, и поэтому расхождение между теоретическим и эмпирическим распределением может быть случайным.

= 0,9834, которая близка к достоверности, и поэтому расхождение между теоретическим и эмпирическим распределением может быть случайным.

Отношение Романовского

также значительно меньше трех, поэтому теоретическое воспро* изведение эмпирического ряда достаточно удовлетворительное.

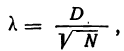

Критерий  Колмогорова. Критерий

Колмогорова. Критерий  , предложенный А. Н. Колмогоровым, устанавливает близость теоретических и эмпирических распределений путем сравнения их интегральных распределений.

, предложенный А. Н. Колмогоровым, устанавливает близость теоретических и эмпирических распределений путем сравнения их интегральных распределений.  исчисляется исходя из D — максимального верхнего предела абсолютного значения разности их накопленных частот, отнесенного к квадратному корню из числа наблюдений N:

исчисляется исходя из D — максимального верхнего предела абсолютного значения разности их накопленных частот, отнесенного к квадратному корню из числа наблюдений N:

где D — максимальная граница разности:  — накопленных теоретических частот и М— накопленных эмпирических частот.

— накопленных теоретических частот и М— накопленных эмпирических частот.

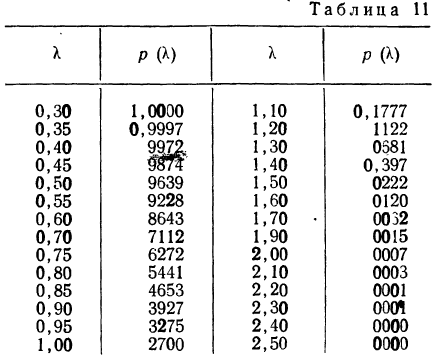

Приведем таблицу значений  —вероятности того, что

—вероятности того, что  достигнет данной величины.

достигнет данной величины.

Если найденному значению  соответствует очень малая вероятность

соответствует очень малая вероятность  то расхождение между эмпирическим и теоретическим распределением нельзя считать случайным и, таким образом, первое мало отражает второе. Наоборот, если

то расхождение между эмпирическим и теоретическим распределением нельзя считать случайным и, таким образом, первое мало отражает второе. Наоборот, если  — величина значительная (больше 0,05), то расхождение между частотами может быть случайным и распределения хорошо соответствуют одно другому.

— величина значительная (больше 0,05), то расхождение между частотами может быть случайным и распределения хорошо соответствуют одно другому.

Рассмотрим применение этого критерия на двух примерах.

Пример 9.

В таблице вероятностей  находим для

находим для

Эта большая вероятность указывает на то, что расхождение между наблюдением и теоретическим распределением вполне могло быть случайным.

Пример 10.

Величина вероятности  показывает несущественность расхождений между теоретическим и эмпирическим распределением.

показывает несущественность расхождений между теоретическим и эмпирическим распределением.

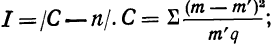

Критерий Б. С. Ястремского. В общем виде критерий Ястремского можно записать следующим неравенством:

где

— эмпирические частоты;

— эмпирические частоты; — теоретические частоты;

— теоретические частоты; — число групп.

— число групп.

Для числа групп, меньших 20,  = 0,6; q = 1 — р.

= 0,6; q = 1 — р.

Значение I, меньшее  в критерии Ястремского показывает несущественность расхождения между эмпирическими и теоретическими частотами в данном распределении.

в критерии Ястремского показывает несущественность расхождения между эмпирическими и теоретическими частотами в данном распределении.

При значениях I, больших  расхождение между теоретическим и эмпирическим распределением существенно.

расхождение между теоретическим и эмпирическим распределением существенно.

Пример 11.

Определим величину I и оценим эмпирическое распределение 500 спиралей (m) по сравнению с соответствующим нормальным (m’).

что говорит о нормальном распределении исследуемой совокупности.

Элементарные приемы определения «нормальности» распределения. Для определения элементарными способами близости данного опытного распределения к нормальному прибегают к числам Вестергарда и к сравнению средней арифметической, моды и медианы.

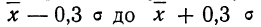

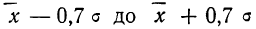

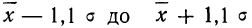

Числами Вестергарда являются: 0,3; 0,7; 1,1; 3. Для пользования ими определяют сначала основные характеристики — среднюю арифметическую  и среднее квадратическое отклонение

и среднее квадратическое отклонение

Для того чтобы данное эмпирическое распределение было подчинено закону нормального распределения, необходимо, чтобы распределение удовлетворяло следующим условиям:

- в промежутке от

была расположена

была расположена  часть всей совокупности;

часть всей совокупности; - в промежутке от

была расположена

была расположена  часть всей совокупности;

часть всей совокупности; - в промежутке от

было расположено

было расположено  всей совокупности;

всей совокупности; - в промежутках от —3 до +3 было расположено 0,998 всей совокупности.

Для приводимого распределения 500 спиралей по весу (пример 1) все эти условия соблюдаются, что говорит о подчинении данного распределения закону нормального распределения.

К элементарным приемам определения «нормальности» следует отнести применение графического метода, особенно удобное с помощью полулогарифмической сетки Турбина. На сетке накопленные эмпирические частоты при нормальном их распределении дают прямую линию. Всякое отклонение от прямой свидетельствует об отклонении эмпирического распределения от «нормального».

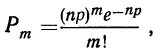

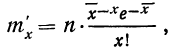

Распределение Пуассона

Вероятности частот событий, редко встречающихся при некотором числе испытаний, находят по формуле:

где m — частота данного события;

n — число испытаний;

р — вероятность события при одном испытании;

е= 2,71828.

Это выражение носит название закона распределения Пуассона.

Подставим вместо nр среднее число фактически наблюдавшихся случаев в эмпирическом материале. Теоретические ординаты кривой распределения по закону Пуассона m’ найдем по формуле:

где х — переменное значение числа раз;

— среднее число раз в эмпирическом распределении;

— среднее число раз в эмпирическом распределении;

n — число наблюдений.

При

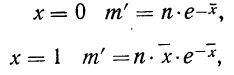

Пример 12.

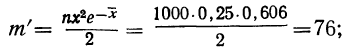

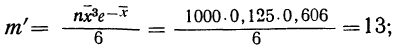

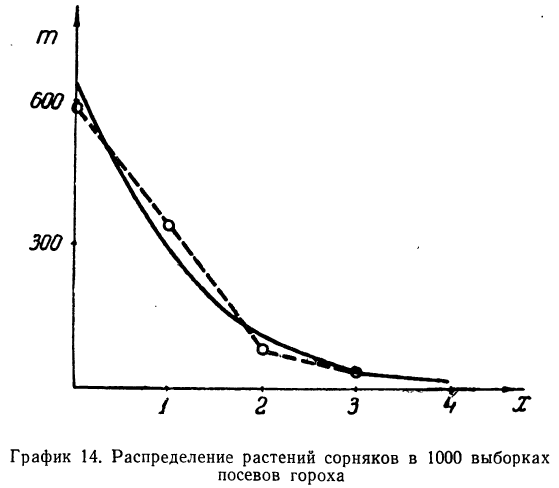

Наблюдалось следующее распределение растений сорняков в 1000 выборках посевов гороха. Результаты эксперимента записаны в следующей таблице:

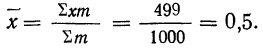

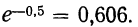

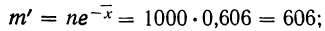

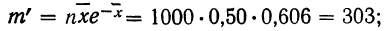

Определим по закону Пуассона теоретические частоты разного числа растений сорняков. Для этого предварительно исчислим среднее число растений сорняков в одной выборке:

Из таблицы находим

Определим теоретическое число выборок, в которых число растений сорняков будет равно 0:

то же:

для числа растений сорняков, равного 1:

для числа растений сорняков, равного 2:

для числа растений сорняков, равного 3:

для числа растений сорняков более 3:

Графическое сопоставление обоих распределений говорит о соответствии между эмпирическим и теоретическим распределениями.

Распределение Максвелла

В технике часто встречается распределение по закону Максвелла. Это — распределение существенно положительных величин. Например, эмпирическое распределение эксцентриситетов биений теоретически воспроизводится распределением Максвелла.

Дифференциальный закон распределения Максвелла выражается следующей формулой:

где  — параметр распределения, равный

— параметр распределения, равный

Интегральный закон распределения выразится тогда:

Пример 13.

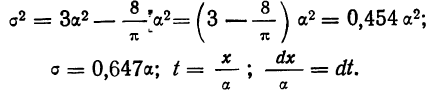

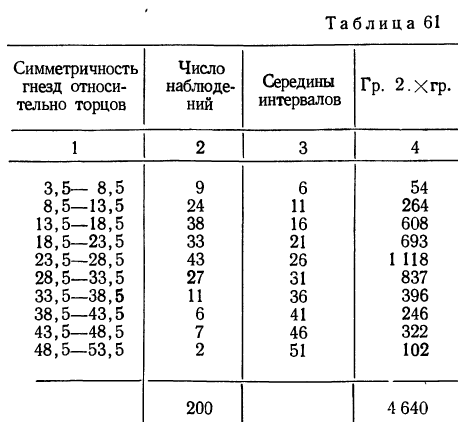

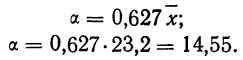

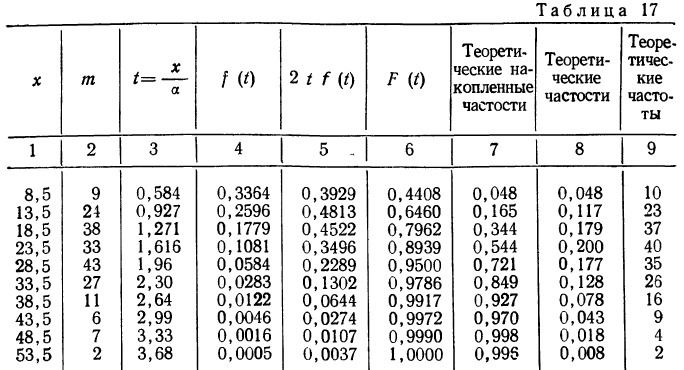

Заимствуем из книги А. М. Длина таблицу распределения симметричности гнезд относительно торцов в круглых плашках (в 0,01 мм) и проведем дополнительные расчеты.

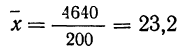

Из этой таблицы легко определим среднюю симметричность:

и параметр рассеяния:

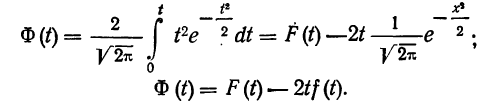

Формула интегрального распределения по закону Максвелла позволяет найти накопленные, а затем теоретические частости и частоты.

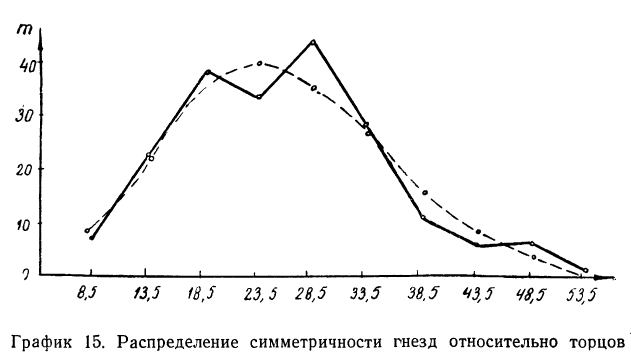

Изобразим на графике 15 данные эмпирического и теоретического рядов распределения.

Определим близость их по критерию согласия Ястремского. Для этого приведем в табл. 18 расчет величины С:

По критерию Ястремского находим

Величина I значительно меньше 3. Следовательно, данное эм лирическое распределение хорошо согласуется с законом распределения Максвелла.

- Дисперсионный анализ

- Математическая обработка динамических рядов

- Корреляция – определение и вычисление

- Элементы теории ошибок

- Статистические оценки

- Теория статистической проверки гипотез

- Линейный регрессионный анализ

- Вариационный ряд

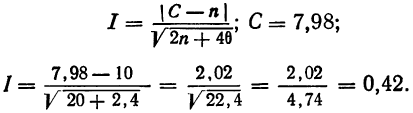

Вернемся к исходной таблице рассматриваемого

примера, добавив еще одну строку в

которой проставим частость одинаковых

ответов

|

Размер, |

39 |

40 |

41 |

42 |

43 |

44 |

45 |

|

|

Количество, |

1 |

3 |

4 |

5 |

4 |

2 |

1 |

20 |

|

Частость, |

0,05 |

0,15 |

0,2 |

0,25 |

0,2 |

0,1 |

0,05 |

1,00 |

П редставим

редставим

имеющиеся данные в виде графика. Как

видно из графика: – численные значения

изменяются не беспредельно; – чем больше

отклонение от среднего значения, тем

меньше частость ее появления и наоборот.

Следовательно, имеют место элементы,

присущие нормальному закону.

Выдвигаем гипотезу (Высказываем

предположение): случайные величины

распределены по нормальному закону. Но

нормальный закон характерен для

генеральной совокупности, а у нас выборка

ограниченного объема. Насколько приемлема

наша гипотеза?

Вполне очевидно, что при нормальном

законе распределения частости будут

иные. Если они отличаются от опытных

данных несущественно, то можно согласиться

с выдвинутой гипотезой, если отличия

существенные, то придется опровергнуть

гипотезу. Но что значит «несущественно»?

Видимо придется установить какой-либо

критерий. Существуют различные способы

установления критерия, который принято

называть «Критерий согласия». К числу

наиболее распространенных способов

относятся: критерий согласия Пирсона

![]() (

(

хи – квадрат); Романовского; Колмагорова

и Ястремского.

Сущность всех способов одинакова и

сводится к определению опытного значения

критерия согласия и сравнению его с

некоторым теоретическим значением.

Если опытное значение критерия согласия

превосходит теоретическое его значение,

то гипотеза отвергается, если не

превосходит, то принимается. Наиболее

распространенным является критерий

согласия Пирсона

![]() (

(

хи – квадрат). Рассмотрим порядок

проведения расчетов при использовании

этого способа.

Формулируем основную гипотезу: опытное

распределение соответствуют теоретическому

распределению, что записывается в виде

![]() .

.

Тогда конкурирующая гипотеза![]() .

.

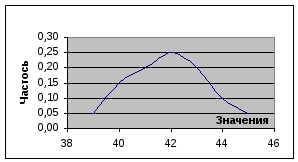

Опытное значение критерия согласия

рассчитывают по формуле

,

,

|

где |

n |

– общее число опытов; |

|

|

– число значений, |

|

|

|

– теоретическая |

|

|

|

– число значений в |

По физическому смыслу критерий согласия

Пирсона![]() –

–

это мера отклонений опытных данных от

теоретических.

Для того чтобы найти теоретическую

частость

![]() попадания вi–ый

попадания вi–ый

интервал, необходимо сначала вычислить

отклонения от среднего значения и это

отклонение выразить в среднем

квадратическом отклонении для генеральной

совокупности, т.е.![]() .

.

Например,![]() .

.

Результаты аналогичных расчетов сведем

в таблицу

|

Размер, |

39 |

40 |

41 |

42 |

43 |

44 |

45 |

|

|

-1,86 |

-1,22 |

-0,58 |

0,06 |

0,71 |

1,35 |

1,99 |

Затем, используя таблицу функции

распределения нормального закона

![]() найти соответствующие значения

найти соответствующие значения![]() .

.

Например, первому столбцу должно

соответствовать значение

f(39)=F(-1,86)–F(-1,22),

второму столбцу f(40)=F(-0,58)-F(-1,22)

и т.д.

Примечание.При отсутствии таблицы

можно воспользоваться компьютером. Для

этого вExcelв какой-либо

столбец ввести значения![]() .Выделить

.Выделить

ячейку рядом с первым числом, вызвать

Статистические функции, НОРМСТРАСП и

в появившемся подменю указать первое

числох = –1,86. Ок. В ячейке появится

0,031, соответствующее

F(-1,86). Аналогично дляF(-1,22)= 0,111.

Вычитая, имеем

f(39)=F(-1,26)–F(-1,52)=

0,111-0,031=0,080.

Аналогичные и последующие расчеты

заносим в таблицу

|

Размер, |

39 |

40 |

41 |

42 |

43 |

44 |

45 |

|

|

-1,86 |

-1,22 |

-0,58 |

0,06 |

0,71 |

1,35 |

1,99 |

|

|

0,031 |

0,111 |

0,281 |

0,524 |

0,761 |

0,911 |

0,977 |

|

|

0.080 |

0.170 |

0.243 |

0.237 |

0.150 |

0.065 |

0.019 |

|

|

1 |

3 |

4 |

5 |

4 |

2 |

1 |

|

|

0,222 |

0,046 |

0,152 |

0,014 |

0,328 |

0,371 |

1,008 |

Суммируя последнюю строку, получим

=2,142.

=2,142.

Необходимо сравнить опытное значение

с теоретическим значением. Теоретическое

значение![]() находят по специальным таблицам, Входом

находят по специальным таблицам, Входом

в таблицу является гарантированная

вероятность и число степеней свободы.

Число степеней свободы находят по

формуле![]() ,

,

гдеk– число разрядов

в таблице (в нашем случае число столбцовk=7);s–

число наложенных связей. Одна связь

присутствует всегда. Действительно,

если сумма вероятностей равна единице,

тоn-1 значений могут

быть любыми, а одна всегда равна![]() .

.

Если потребуем равенства![]() ,

,

то это еще одна связь. Если потребуем

равенства дисперсий, то это еще одна

связь. Итого три. Следовательно, число

степеней свободы![]() .

.

По таблице, для уровня значимости![]() ,

,

при![]() ,

,

находим![]() .

.

Вывод. Так как

![]() ,

,

то с вероятностью 90% можно утверждать,

что нет оснований для того, чтобы

отвергнуть гипотезу. Вероятность того,

что мы ошибаемся равна![]() .

.

Примечание. При отсутствии таблицы

можно воспользоваться компьютером. Для

этого вExcel вызвать

Статистические функции, ХИ2ОБР и в

появившемся подменю указать Вероятность

0,1, Степеней свободы 4. Ок. Прочитать

ответ 7,77944.

Пример 1. 2.В казино поступила жалоба,

что игральная кость с неравномерным

выпадением очков. Необходимо проверить

следуют ли экспериментальные данные

закону равной вероятности. Для решения

этой задачи проведен эксперимент, в

котором произведено 600 бросаний.

Используем критерий χ2. Основная

гипотезаНо:![]() ,

,

конкурирующая гипотеза![]() .

.

Результаты эксперимента и промежуточные

расчеты отражены в таблице.

|

Число |

Их число в |

Теоретическое значение |

|

Примечание |

|

1 |

101 |

100 |

0.01 |

|

|

2 |

86 |

100 |

1.96 |

|

|

3 |

107 |

100 |

0.49 |

|

|

4 |

94 |

100 |

0.36 |

|

|

5 |

97 |

100 |

0.09 |

|

|

6 |

115 |

100 |

2.25 |

|

|

Всего |

600 |

600 |

5,16 |

Суммируя, находим

![]()

Число степеней свободы:

![]() ;k=6 – число строк;s=3.

;k=6 – число строк;s=3.

Следовательно, r

=6-3=3.

![]() .

.

Так как![]() ,

,

то нет оснований для того, чтобы отвергнуть

гипотезу о равномерном выпадении очков.

Отклонения–следствие случайности.

Вероятность того, что мы ошибаемся

составляет 5%.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #