Статистическое изучение взаимосвязей

1. Виды взаимосвязей и понятие

корреляционной зависимости

2. Методы выявления корреляционной

связи

3. Однофакторный корреляционно-регрессионный

анализ

4. Многофакторный корреляционно-регрессионный

анализ

5. Непараметрические показатели связи

1. Виды взаимосвязей и понятие

корреляционной зависимости

Все статистические показатели находятся

между собой в определённых связях и

соотношениях.

Задача статистического исследования

состоит в том, чтобы определить характер

данной взаимосвязи.

Существуют следующие виды взаимосвязей:

1. Факторные. В этом случае связи

проявляются в согласованной вариации

различных признаков у одной и той же

совокупности. При этом один из признаков

выступает как фактор, а другой – как

следствие. Изучение этих связей

производится методом группировок, а

также теорией корреляции.

2. Компонентные. К данному виду

относятся такие взаимосвязи, при которых

изменение какого-то сложного явления

целиком определяется изменением

компонентов, входящих в это сложное

явление как множители (X=x·f). Для

этого применяется индексный метод.

Например, с помощью системы взаимосвязанных

индексов узнают, как изменился товарооборот

за счёт изменения количества проданных

товаров и цен.

3. Балансовые. Применяются при анализе

связей и пропорций в образовании ресурсов

и их распределении. Баланс

представляет систему показателей,

которая состоит их двух сумм абсолютных

величин, связанных между собой знаком

равенства,

а + б = в + г.

Например, баланс материальных ресурсов:

остаток + поступление = расход

+ остаток

начальный конечный

Признаки (показатели) при изучении

взаимосвязей делятся на 2 вида:

Признаки, обуславливающие изменение

других, называютфакторными, или

простофакторами.

Признаки, изменяющиеся под действием

факторных признаков, являютсярезультативными.

Различают 2 вида взаимосвязей:

функциональныеистохастические.

Функциональнойназывают такую

связь, при которой определенному значению

факторного признака соответствует

только одно значение результативного

признака.

Если причинная зависимость проявляется

не в каждом случае, а в общем, среднем

при большом числе наблюдений, то такая

связь называется стохастической.

Частным случаем стохастической связи

является корреляционная связь, при

которой изменение среднего значения

результативного признака обусловлено

изменением факторного.

Особенности стохастических

(корреляционных) связей:

– обнаруживаются не в единичных случаях,

а в общем и среднем при большом числе

наблюдений;

–

неполные, они учитывают не все действующие

факторы, а только существенные;

– необратимы. Например, функциональную

связь можно превратить в

другую функциональную связь

. Если мы говорим, что урожайность

сельхозпродукции зависит от количества

внесенных удобрений, то обратное

утверждение лишено смысла.

По направлению выделяют связьпрямуюиобратную. Припрямой связи с

увеличением факторного признака

происходит увеличение результативного.

В случаеобратной связи с увеличением

факторного признака происходит уменьшение

результативного.

По аналитическому выражению выделяют

связилинейные (прямолинейные)инелинейные (криволинейные). Если

связь между явлениями выражена уравнением

прямой линии, то оналинейная. Если

связь выражена уравнением кривой линии

(параболы, гиперболы, степенной,

показательной и т.п.), то онанелинейная.

По количеству факторов, действующих

на результативный признак, различают

связиоднофакторныеимногофакторные.

Если один признак-фактор и результативный

признак, то связь – однофакторная

(парная регрессия). Если признаков-факторов

2 и более, то связь многофакторная

(множественная регрессия).

Связи различают еще по степени тесноты

связи (см. таблицу Чэддока).

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

Содержание:

Корреляционный анализ:

Связи между различными явлениями в природе сложны и многообразны, однако их можно определённым образом классифицировать. В технике и естествознании часто речь идёт о функциональной зависимости между переменными x и у, когда каждому возможному значению х поставлено в однозначное соответствие определённое значение у. Это может быть, например, зависимость между давлением и объёмом газа (закон Бойля—Мариотта).

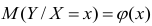

В реальном мире многие явления природы происходят в обстановке действия многочисленных факторов, влияния каждого из которых ничтожно, а число их велико. В этом случае связь теряет свою однозначность и изучаемая физическая система переходит не в определённое состояние, а в одно из возможных для неё состояний. Здесь речь может идти лишь о так называемой статистической связи. Статистическая связь состоит в том, что одна случайная переменная реагирует на изменение другой изменением своего закона распределения. Следовательно, для изучения статистической зависимости нужно знать аналитический вид двумерного распределения. Однако нахождение аналитического вида двумерного распределения по выборке ограниченного объёма, во-первых, громоздко, во-вторых, может привести к значительным ошибкам. Поэтому на практике при исследовании зависимостей между случайными переменными X и У обычно ограничиваются изучением зависимости между одной из них и условным математическим ожиданием другой, т.е.

Вопрос о том, что принять за зависимую переменную, а что — за независимую, следует решать применительно к каждому конкретному случаю.

Знание статистической зависимости между случайными переменными имеет большое практическое значение: с её помощью можно прогнозировать значение зависимой случайной переменной в предположении, что независимая переменная примет определенное значение. Однако, поскольку понятие статистической зависимости относится к осредненным условиям, прогнозы не могут быть безошибочными. Применяя некоторые вероятностные методы, как будет показано далее, можно вычислить вероятность того, что ошибка прогноза не выйдет за определенные границы.

Введение в корреляционный анализ

Связь, которая существует между случайными величинами разной природы, например, между величиной X и величиной Y, не обязательно является следствием прямой зависимости одной величины от другой (так называемая функциональная связь).

В некоторых случаях обе величины зависят от целой совокупности разных факторов, общих для обеих величин, в результате чего и формируется связанные друг с другом закономерности. Когда связь между случайными величинами обнаружена с помощью статистики, мы не можем утверждать, что обнаружили причину происходящего изменения параметров, скорее мы лишь увидели два взаимосвязанных следствия.

Например, дети, которые чаще смотрят по телевизору американские боевики, меньше читают. Дети, которые больше читают, лучше учатся. Не так-то просто решить, где тут причины, а где следствия, но это и не является задачей статистики.

Статистика может лишь, выдвинув гипотезу о наличии связи, подкрепить ее цифрами. Если связь действительно имеется, говорят, что между двумя случайными величинами есть корреляция. Если увеличение одной случайной величины связано с увеличением второй случайной величины, корреляция называется прямой.

Например, количество прочитанных страниц за год и средний балл (успеваемость). Если, напротив рост одной величины связано с уменьшением другой, говорят об обратной корреляции. Например, количество боевиков и количество прочитанных страниц. Взаимная связь двух случайных величин называется корреляцией, корреляционный анализ позволяет определить наличие такой связи, оценить, насколько тесна и существенна эта связь. Все это выражается количественно.

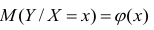

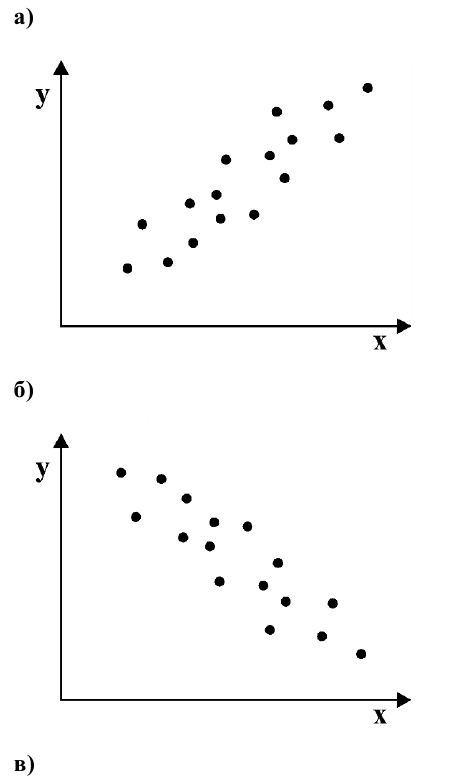

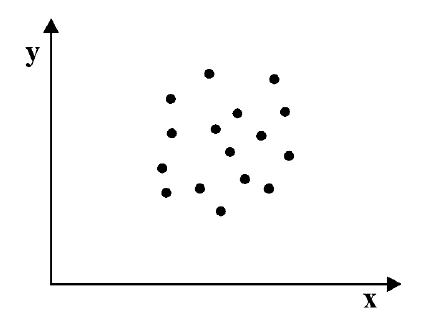

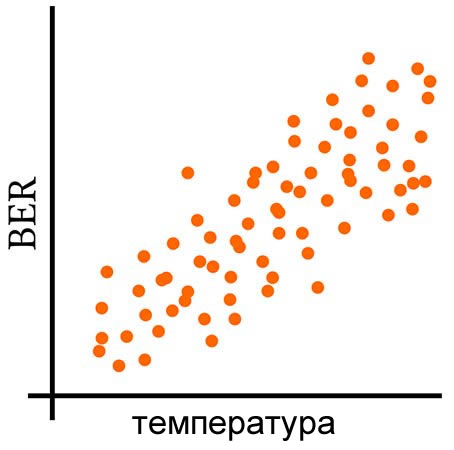

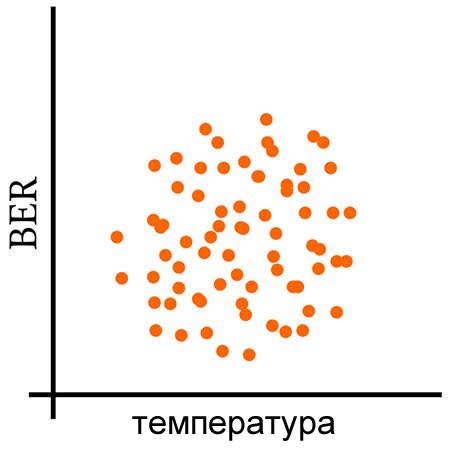

Как определить, есть ли корреляция между величинами? В большинстве случаев, это можно увидеть на обычном графике. Например, по каждому ребенку из нашей выборки можно определить величину

Если график имеет вид а), то это говорит о наличии прямой корреляции, в случае, если он имеет вид б) – корреляция обратная. Отсутствие корреляции тоже можно приблизительно определить по виду графика – это случай в).

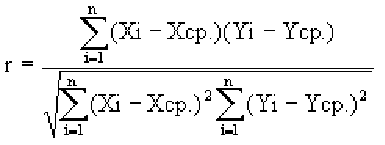

С помощью коэффициента корреляции можно посчитать насколько тесная связь существует между величинами.

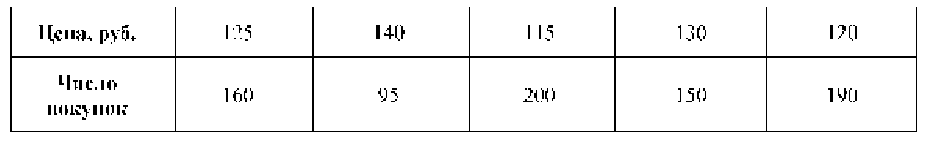

Пусть, существует корреляция между ценой и спросом на товар. Количество купленных единиц товара в зависимости от цены у разных продавцов показано в таблице:

Коэффициент r мы считаем в Excel, с помощью функции

Надо отметить, что чем ближе к 0 коэффициент корреляции, тем слабее связь между величинами. Наиболее тесная связь при прямой корреляции соответствует коэффициенту r, близкому к +1. В нашем случае, корреляция обратная, но тоже очень тесная, и коэффициент близок к -1.

Что можно сказать о случайных величинах, у которых коэффициент имеет промежуточное значение? Например, если бы мы получили r = 0,65. В этом случае, статистика позволяет сказать, что две случайные величины частично связаны друг с другом. Скажем на 65% влияние на количество покупок оказывала цена, а на 35% – другие обстоятельства. И еще одно важное обстоятельство надо упомянуть.

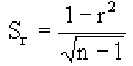

Поскольку мы говорим о случайных величинах, всегда существует вероятность, что замеченная нами связь – случайное обстоятельство. Причем вероятность найти связь там, где ее нет, особенно велика тогда, когда точек в выборке мало, а при оценке Вы не построили график, а просто посчитали значение коэффициента корреляции на компьютере. Так, если мы оставим всего две разные точки в любой произвольной выборке, коэффициент корреляции будет равен или +1 или -1. Из школьного курса геометрии мы знаем, что через две точки можно всегда провести прямую линию. Для оценки статистической достоверности факта обнаруженной Вами связи полезно использовать так называемую корреляционную поправку:

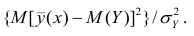

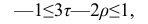

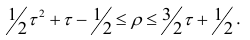

Связь нельзя считать случайной, если:

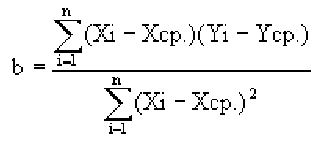

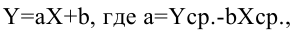

В то время как задача корреляционного анализа – установить, являются ли данные случайные величины взаимосвязанными, цель регрессионного анализа – описать эту связь аналитической зависимостью, т.е. с помощью уравнения. Мы рассмотрим самый несложный случай, когда связь между точками на графике может быть представлена прямой линией. Уравнение этой прямой линии

Зная уравнение прямой, мы можем находить значение функции по значению аргумента в тех точках, где значение X известно, a Y – нет. Эти оценки бывают очень нужны, но они должны использоваться осторожно, особенно, если связь между величинами не слишком тесная. Отметим также, что из сопоставления формул для b и r видно, что коэффициент не дает значение наклона прямой, а лишь показывает сам факт наличия связи.

Определение формы связи. Понятие регрессии

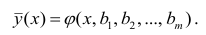

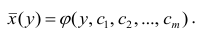

Определить форму связи — значит выявить механизм получения зависимой случайной переменной. При изучении статистических зависимостей форму связи можно характеризовать функцией регрессии (линейной, квадратной, показательной и т.д.).

Условное математическое ожидание

функцией регрессии случайной переменной Y относительно X (или функцией регрессии Y по X). Точно так же условное математическое ожидание

На примере, дискретного распределения найдём функцию регрессии.

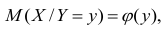

Функция регрессии имеет важное значение при статистическом анализе зависимостей между переменными и может быть использована для прогнозирования одной из случайных переменных, если известно значение другой случайной переменной. Точность такого прогноза определяется дисперсией условного распределения.

Несмотря на важность понятия функции регрессии, возможности её практического применения весьма ограничены. Для оценки функции регрессии необходимо знать аналитический вид двумерного распределения (X, Y). Только в этом случае можно точно определить вид функции регрессии, а затем оценить параметры двумерного распределения. Однако для подобной оценки мы чаще всего располагаем лишь выборкой ограниченного объема, по которой нужно найти вид двумерного распределения (X, Y), а затем вид функции регрессии. Это может привести к значительным ошибкам, так как одну и ту же совокупность точек

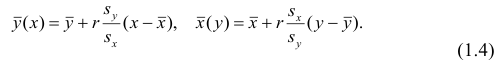

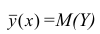

Кривой регрессии Y по X (или Y на А) называют условное среднее значение случайной переменной У, рассматриваемое как функция определенного класса, параметры которой находят методом наименьших квадратов по наблюдённым значениям двумерной случайной величины (х, у), т.е.

Аналогично определяется кривая регрессии X по Y (X на Y):

Кривую регрессии называют также эмпирическим уравнением регрессии или просто уравнением регрессии. Уравнение регрессии является оценкой соответствующей функции регрессии.

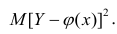

Возникает вопрос: почему для определения кривой регрессии

используют именно условное среднее

Если рассеивание вычисляется относительно

Основные положения корреляционного анализа

Статистические связи между переменными можно изучать методом корреляционного и регрессионного анализа. С помощью этих методов решают разные задачи; требования, предъявляемые к исследуемым переменным, в каждом методе различны.

Основная задача корреляционного анализа — выявление связи между случайными переменными путём точечной и интервальной оценки парных коэффициентов корреляции, вычисления и проверки значимости множественных коэффициентов корреляции и детерминации, оценки частных коэффициентов корреляции. Корреляционный анализ позволяет также оценить функцию регрессии одной случайной переменной на другую.

Предпосылки корреляционного анализа следующие:

- 1) переменные величины должны быть случайными;

- 2) случайные величины должны иметь совместное нормальное распределение.

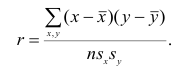

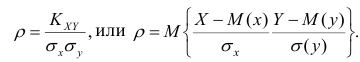

Рассмотрим простейший случай корреляционного анализа — двумерную модель. Введём основные понятия и опишем принцип проведения корреляционного анализа. Пусть X и Y — случайные переменные, имеющие совместное нормальное распределение. В этом случае связь между X и Y можно описать коэффициентом корреляции p;. Этот коэффициент определяется как ковариация между X и Y, отнесённая к их среднеквадратическим отклонениям:

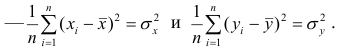

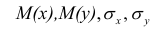

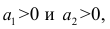

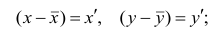

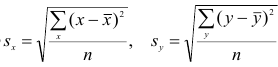

Оценкой коэффициента корреляции является выборочный коэффициент корреляции r. Для его нахождения необходимо знать оценки следующих параметров:

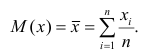

математического ожидания является среднее арифметическое, т.е.

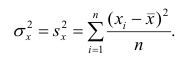

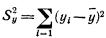

Оценкой дисперсии служит выборочная дисперсия, т.е.

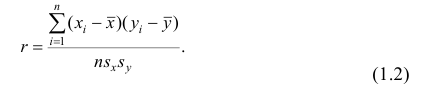

Тогда выборочный коэффициент корреляции

Коэффициент р называют также парным коэффициентом корреляции, а r— выборочным парным коэффициентом корреляции.

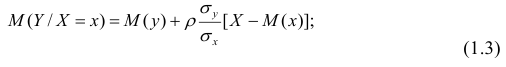

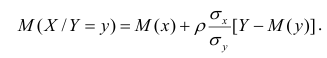

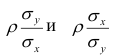

При совместном нормальном законе распределения случайных величин X и Y, используя рассмотренные выше параметры распределения и коэффициент корреляции, можно получить выражение для условного математического ожидания, т. е, записать выражение для функции регрессии одной случайной величины на другую. Так, функция регрессии Y на X имеет вид:

функция регрессии X на Y — следующий вид:

Выражения

Подставив в (1.3) соответствующие оценки параметров, получим уравнения регрессии, график которых — прямая линия, проходящая через точку

Таким образом, в корреляционном анализе на основе оценок параметров двумерной нормальной совокупности получаем оценки тесноты связи между случайными переменными и можем оценить регрессию одной переменной на другую. Особенностью корреляционного анализа является строго линейная зависимость между переменными. Это обусловливается исходными предпосылками. На практике корреляционный анализ можно применять для обработки наблюдений, сделанных на предприятиях при нормальных условиях работы, если случайные изменения свойства сырья или других факторов вызывают случайные изменения свойств продукции.

Свойства коэффициента корреляции

Коэффициент корреляции является одним из самых распространенных способов измерения связи между случайными переменными. Рассмотрим некоторые свойства этого коэффициента.

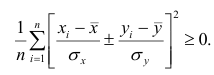

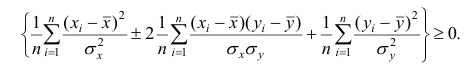

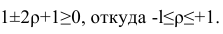

Теорема 1. Коэффициент корреляции принимает значения на интервале (-1, +1).

Доказательство. Докажем справедливость утверждения для случая дискретных переменных. Запишем явно неотрицательное выражение:

Возведём выражение под знаком суммы в квадрат:

Первое и третье из слагаемых равны единице, поскольку из определения дисперсии следует, что

Таким образом, окончательно получаем

Если коэффициент корреляции положителен, то связь между переменными также положительна и значения переменных увеличиваются или уменьшаются одновременно. Если коэффициент корреляции имеет отрицательное значение, то при увеличении одной переменной уменьшается другая.

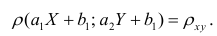

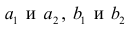

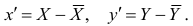

Приведём следующее важное свойство коэффициента корреляции: коэффициент корреляции не зависит от выбора начала отсчёта и единицы измерения, т. е. от любых постоянных

Таким образом, переменные X и У можно уменьшать или увеличивать в а раз, а также вычитать или прибавлять к значениям X и У одно и то же число b. В результате величина коэффициента корреляции не изменится.

Если коэффициент корреляции

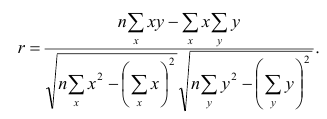

Выборочный коэффициент корреляции вычисляют по формуле (1.2). Имеется несколько модификаций этой формулы, которые удобно использовать при той или иной форме представления исходной информации. Так, при малом числе наблюдений выборочный коэффициент корреляции удобно вычислять по формуле

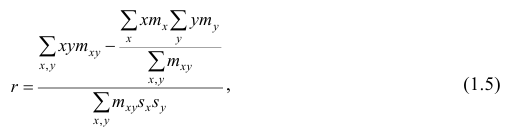

Если информация имеет вид корреляционной таблицы (см. п 1.5), то удобно пользоваться формулой

где

Из формулы (1.2) очевидно, что

Поле корреляции. Вычисление оценок параметров двумерной модели

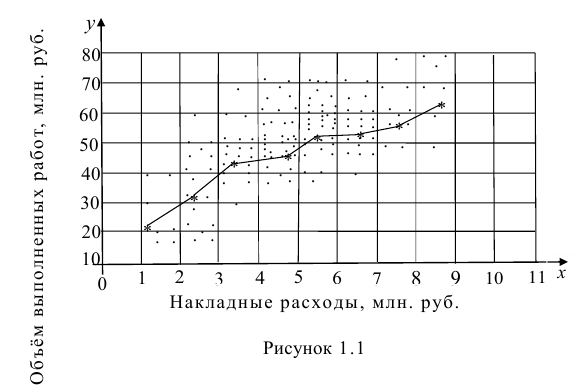

На практике для вычисления оценок параметров двумерной модели удобно использовать корреляционную таблицу и поле корреляции. Пусть, например, изучается зависимость между объёмом выполненных работ (у) и накладными расходами (x). Имеем выборку из генеральной совокупности, состоящую из 150 пар переменных

Пару случайных чисел

По осям координат откладывают или дискретные значения переменных, или интервалы их изменения. Для интервального ряда наносят координатную сетку. Каждую пару переменных из данной выборки изображают в виде точки с соответствующими координатами для дискретного ряда или в виде точки в соответствующей клетке для интервального ряда. Такое изображение корреляционной зависимости называют полем корреляции. На рис. 1.1 изображено поле корреляции для выборки, состоящей из 150 пар переменных (ряд интервальный).

Если вычислить средние значения у в каждом интервале изменения х [обозначим их

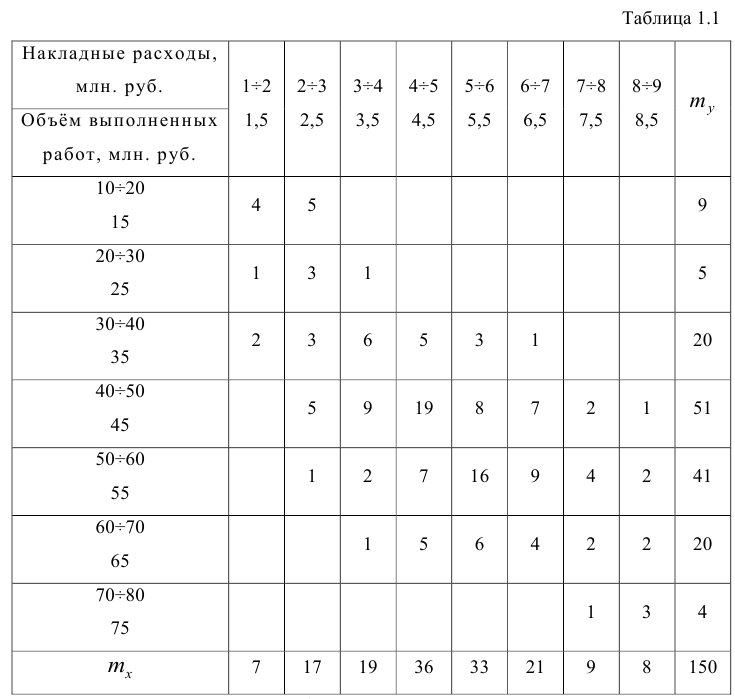

Корреляционную таблицу, как и поле корреляции, строят по

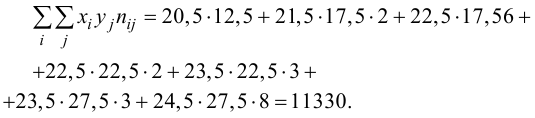

сгруппированному ряду (дискретному или интервальному). Табл. 1.1 построена на основе интервального ряда. В первой строке и первом столбце таблицы помещают интервалы изменения х и у и значения середин интервалов. Так, например, 1,5 — середина интервала изменения *=1-2,15— середина интервала изменения у= 10-20. В ячейки, образованные пересечением строк и столбцов, заносят частоты попадания пар значений (л у) в соответствующие интервалы по х и у. Например, частота 4 означает, что в интервал изменения у от 10 до 20 попало 4 пары наблюдавшихся значений. Эти частоты обозначают

Как будет показано в дальнейшем, корреляционно таблицей удобно пользоваться при вычислении коэффициентов корреляций и параметров уравнений регрессии.

Корреляционная таблица построена на основе интервального ряда, поэтому для оценок параметров воспользуемся формулами гл. 1 для вычисления средней арифметической и дисперсии. Имеем:

Проверка гипотезы о значимости коэффициента корреляции

На практике коэффициент корреляции р обычно неизвестен. По результатам выборки может быть найдена его точечная оценка — выборочный коэффициент корреляции r.

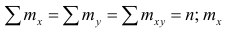

Равенство нулю выборочного коэффициента корреляции ещё не свидетельствует о равенстве нулю самого коэффициента корреляции, а следовательно, о некоррелированности случайных величин X и Y. Чтобы выяснить, находятся ли случайные величины в корреляционной зависимости, нужно проверить значимость выборочного коэффициента корреляции г, т.е. установить, достаточна ли его величина для обоснованного вывода о наличии корреляционной связи. Для этого проверяют нулевую гипотезу

которая имеет распределение Стьюдента с k=n-2

степенями свободы. Для проверки нулевой гипотезы по уровню значимости а и числу степеней свободы к находят по таблицам распределения Стьюдента (t-распределение; см. табл. 1 приложения) критическое значение

В случае значимого выборочного коэффициента, корреляции есть смысл построить доверительный интервал для коэффициента корреляций р. Однако для этого нужно знать закон распределения выборочного коэффициента корреляции r.

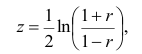

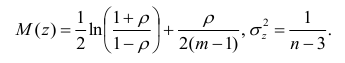

Плотность вероятности выборочного коэффициента корреляции имеет сложный вид, поэтому прибегают к специально подобранным функциям от выборочного коэффициента корреляции, которые сводятся к хорошо изученным распределениям, например нормальному или Стьюдента. Чаще всего для подбора функции применяют преобразование Фишера. Вычисляют статистику:

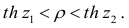

где r=thz — гиперболический тангенс от z.

Распределение статистики z хорошо аппроксимируется нормальным распределением с параметрами

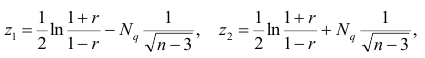

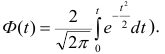

В этом, случае доверительный интервал для римеетвид

где

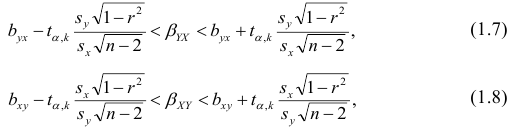

Если коэффициент корреляции значим, то коэффициенты регрессии также значимо отличаются от нуля, а интервальные оценки для них можно получить по следующим формулам:

где

Корреляционное отношение

На практике часто предпосылки корреляционного анализа нарушаются: один из признаков оказывается величиной не случайной, или признаки не имеют совместного нормального распределения. Однако статистическая зависимость между ними существует. Для изучения связи между признаками в этом случае существует общий показатель зависимости признаков, основанный на показателе изменчивости — общей (или полной) дисперсии.

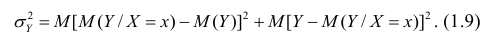

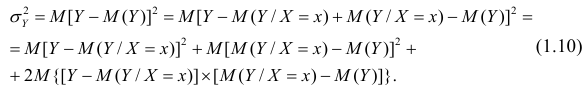

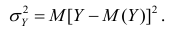

Полной называется дисперсия признака относительно его математического ожидания. Так, для признака Y это

Очевидно, чем меньше влияние прочих факторов, тем теснее связь, тем более приближается она к функциональной. Представим

Первое слагаемое обозначим

Покажем, что

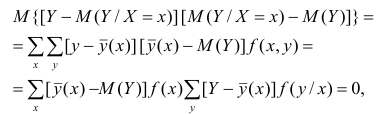

Для простоты полагаем распределение дискретным. Имеем

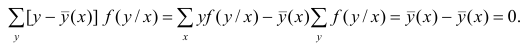

так как при любом х справедливо равенство

Третье слагаемое в равенстве (1.10) равно нулю, поэтому равенство (1.9) справедливо. Поскольку второе слагаемое в равенстве (1.9) оценивает влияние признака X на Y, то его можно использовать для оценки тесноты связи между X и Y. Тесноту связи удобно оценивать в единицах общей дисперсии

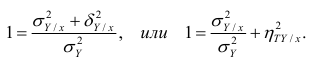

Разделив обе части равенства (1.9) на

Из последней формулы имеем

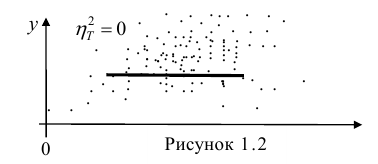

Поскольку

Все сделанные выводы справедливы и для

следует, что

Далее, из равенства (1.12) следует, что

Аналогичными свойствами обладает

Часто используют величину

Считают, что она не может быть отрицательной. Значения величины

Значения

Разность

При вычислении

Понятие о многомерном корреляционном анализе

Частный коэффициент корреляции. Основные понятия корреляционного анализа, введенные для двумерной модели, можно распространить на многомерный случай. Задачи и предпосылки корреляционного анализа были сформулированы в п. 1.3. Однако если при изучении взаимосвязи переменных по двумерной модели мы ограничивались рассмотрением парных коэффициентов корреляции, то для многомерной модели этого недостаточно. Многообразие связей между переменными находит отражение в частных и множественных коэффициентах корреляции.

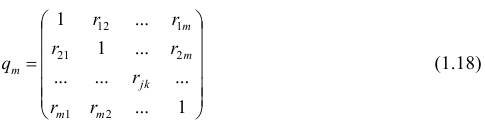

Пусть имеется многомерная нормальная совокупность с m признаками

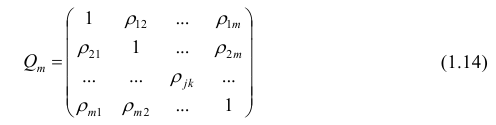

можно описать корреляционной матрицей. Под корреляционной матрицей будем понимать, матрицу, составленную из парных коэффициентов корреляции (вычисляются по формуле (1,1)):

где

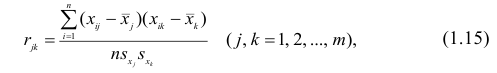

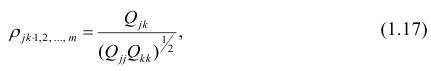

Оценкой парного коэффициента корреляции является выборочный парный коэффициент корреляции, определяемый по формуле (1.2), однако для m признаков формула (9.2) принимает вид

где

Как и в двумерном случае, для оценки коэффициента корреляции необходимо оценить математические ожидания и дисперсии. В многомерном корреляционном анализе имеем т математических ожиданий и m дисперсий, а также m(m—1)/2 парных коэффициентов корреляции. Таким образом, нужно произвести оценку 2m+m(m—1)/2 параметров.

В случае многомерной корреляции зависимости между признаками более многообразны и сложны, чем в двумерном случае. Одной корреляционной матрицей нельзя полностью описать зависимости между признаками. Введём понятие частного коэффициента корреляции l-го порядка.

Пусть исходная совокупность состоит из т признаков. Можно изучать зависимости между двумя из них при фиксированном значении l признаков из m-2 оставшихся. Рассмотрим, например, систему из 5 признаков. Изучим зависимости между

Рассмотрим более подробно структуру частных коэффициентов корреляции на примере системы из трёх признаков

корреляции и имеет вид

Частный коэффициент корреляции, так же как и парный коэффициент корреляции, изменяется от —1 до +1, В общем виде, когда система состоит из m признаков, частный коэффициент корреляции l-го порядка может быть найден из корреляционной матрицы. Если 1=m—2, то рассматривается матрица порядка m, при

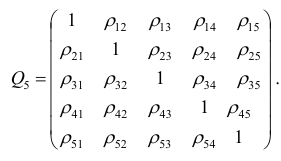

корреляции. Например, корреляционная матрица системы из пяти признаков имеет вид

Для определения частного коэффициента корреляции второго порядка, например

вычеркнув из исходной матрицы

В общем виде формулу частного коэффициента корреляции l-го порядка (1=m—2) можно записать в виде

где

матрицы

Очевидно, что выражение (1.16) является частым случаем выражения (1.17), в чём легко убедиться, рассмотрев корреляционную матрицу

Оценкой частного коэффициента корреляции l-го порядка является выборочный частный коэффициент корреляции l-го порядка. Он вычисляется на основе корреляционной матрицы, составленной из выборочных парных коэффициентов корреляции:

Формула выборочного частного коэффициента корреляции имеет вид

где

Частный коэффициент корреляции l-го порядка, вызволенный на основе п наблюдений над признаками, имеет такое же распределение, что и парный коэффициент корреляции, вычисленный

Множественный коэффициент корреляции

Часто представляет интерес оценить связь одного из признаков со всеми остальными. Это можно сделать с помощью множественного, или совокупного, коэффициента корреляции

где

дополнение к элементу

Квадрат коэффициента множественной корреляции

множественным коэффициентом детерминации. Коэффициенты множественной корреляции и детерминации — величины положительные, принимающие значения в интервале

коэффициентов являются выборочные множественные коэффициенты корреляции и детерминации, которые обозначают соответственно

где

Многомерный корреляционный анализ позволяет получить оценку функции регрессии — уравнение регрессии. Коэффициенты в уравнении регрессии можно найти непосредственно через выборочные парные коэффициенты корреляции или воспользоваться методом многомерной регрессии, который мы рассмотрим в вопросе 2.7. В этом случае все предпосылки регрессионного анализа оказываются выполненными и, кроме того, связь между переменными строго линейна.

Ранговая корреляция

В некоторых случаях встречаются признаки, не поддающиеся количественной оценке (назовём такие признаки объектами). Попытаемся, например, оценить соотношение между математическими и музыкальными способностями группы учащихся. «Уровень способностей» является переменной величиной в том смысле; что он варьирует от одного индивидуума к другому. Его можно измерить, если выставлять каждому индивидууму отметки. Однако этот способ лишен объективности, так как разные экзаменаторы могут выставить одному и тому же учащемуся разные отметки. Элемент субъективизма можно исключить, если учащиеся будут ранжированы. Расположим учащихся по порядку, в соответствии со степенью способностей и присвоим каждому из них порядковый номер, который назовем рангом. Корреляция между рангами более точно отражает соотношение между способностями учащихся, чем корреляция между отметками.

Тесноту связи между рангами измеряют так же, как и между признаками. Рассмотрим уже известную формулу коэффициента корреляции

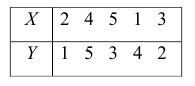

Пусть

что

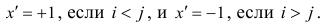

В зависимости от того, что принять за меру различия между величинами

Введём следующую меру различия между объектами: будем считать

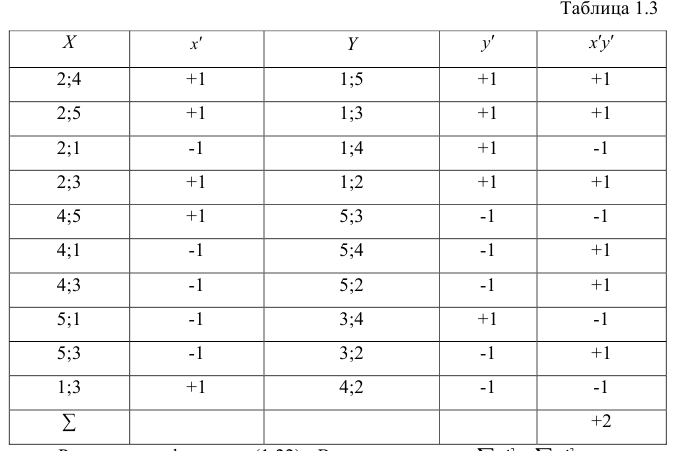

Рассмотрим отдельно каждую из них. В последовательности X первой паре элементов —2; 4 припишем значение +1, так как

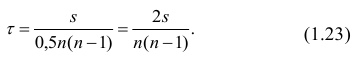

Рассмотрим формулу ( 1 .22). В нашем случае

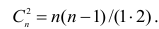

количеству пар, участвовавших в переборе. Каждая пара встречается только один раз, поэтому их общее количество равно числу сочетаний из n по 2, т.е.

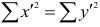

Теперь рассмотрим другую меру различия между объектами. Если обозначить через

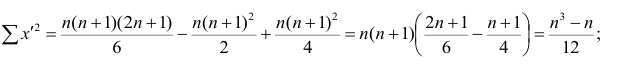

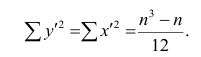

Тогда

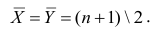

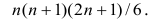

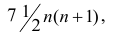

чисел натурального ряда равна

Тогда

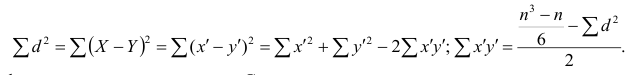

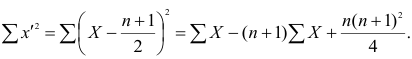

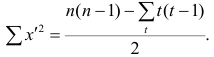

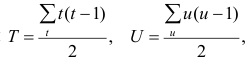

Введём новую величину d, равную разности между рангами: d=X—Y, и определим через неё величину

Коэффициент корреляции рангов Спирмэна

У коэффициентов

При вычислении коэффициента корреляций рангов Кэнделла для подсчёта s можно использовать следующий приём: одну из последовательностей упорядочивают так, чтобы её элементы были числами натурального ряда; соответственно изменяют и другую последовательность. Тогда сумму

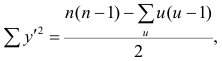

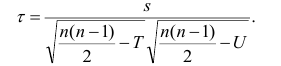

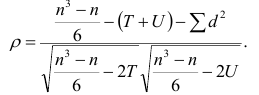

Если нельзя установить ранговое различие нескольких объектов, говорят, что такие объекты являются связанными. В этом случае объектам приписывается средний ранг. Например, если связанными являются объекты 4 и 5, то им приписывают ранг 4.5; если связанными являются объекты 1, 2, 3, 4 и 5, то их средний ранг (1+2+3+4+5)/5=3. Сумма рангов связанных объектов должна быть равна сумме рангов при ранжировании без связей. Формулы коэффициентов корреляции для

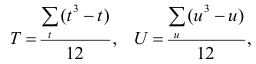

где t и u—число связанных пар в последовательностях.

Обозначая

Аналогично находим выражение для р. Только в этом случае

последовательностях, а

Если имеется несколько последовательностей, то возникает необходимость определить общую меру согласованности между ними. Такой мерой является коэффициент копкордации.

Пусть ь — число последовательностей, т — количество рангов в каждой последовательности. Тогда коэффициент конкордации

где d — фактически встречающееся отклонение от среднего значения суммы рангов одного объекта.

Коэффициент корреляции рангов может быть использован для быстрого оценивания взаимосвязи между признаками, не имеющими нормального распределения, и полезен в тех случаях, когда признаки поддаются ранжированию, но не могут быть точно измерены.

Пример:

Для данных табл. 13 найти выборочный коэффициент корреляции, проверить его значимость на уровне

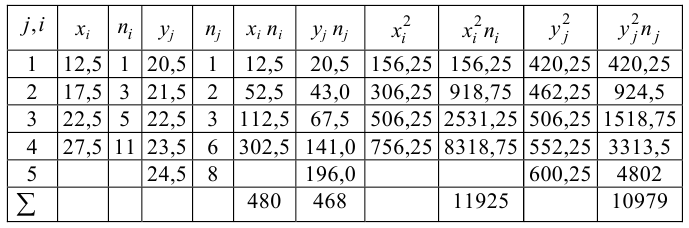

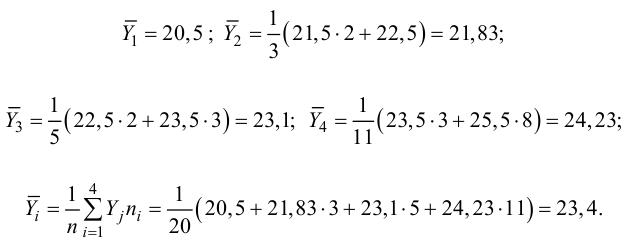

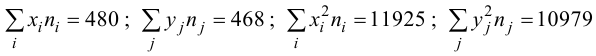

Решение. Для вычислений составим таблицу. Находим суммы

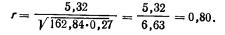

Подставляя полученные значения сумм в (8), найдем выборочный коэффициент корреляции

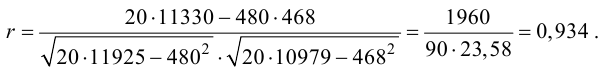

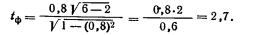

Проверим значимость

По таблице распределения П6 Стьюдента

Пример:

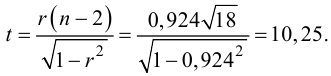

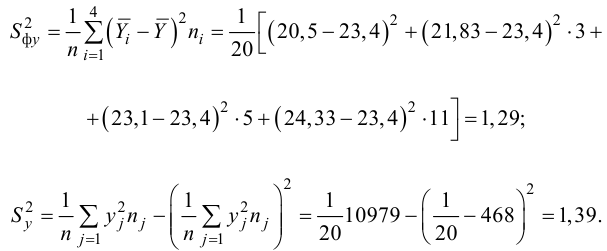

Для данных табл. 13 найти корреляционное отношение

Для вычисления эмпирического корреляционного отношения найдем групповые средние

Тогда

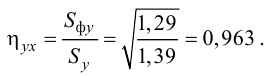

Вычисляем корреляционное отношение

- Статистические решающие функции

- Случайные процессы

- Выборочный метод

- Статистическая проверка гипотез

- Доверительный интервал для математического ожидания

- Доверительный интервал для дисперсии

- Проверка статистических гипотез

- Регрессионный анализ

Поиск статистических взаимосвязей: корреляция, причинно-следственная связь и ковариация

Добавлено 22 сентября 2020 в 22:54

В данной статье объясняется статистическая мера, которая помогает нам делать выводы о том, как одна переменная влияет на другую.

В этой серии статей, посвященной статистике в электротехнике, приводятся высокоуровневые определения и примеры статистических концепций, которые можно применять в процессе проектирования. Ознакомиться со статьями серии вы можете в меню с оглавлением выше, над статьей.

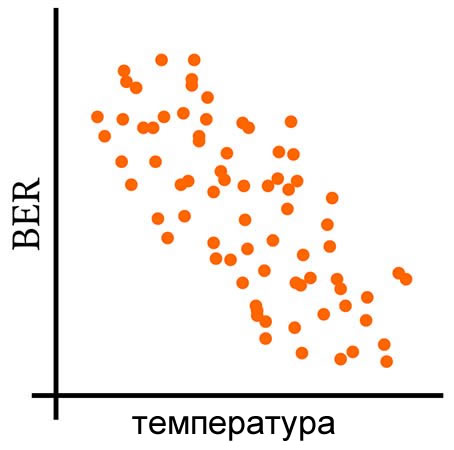

Корреляция и причинно-следственная связь

Допустим, у нас есть система беспроводной связи, которая доставляет нам проблемы. Частота битовых ошибок (BER) резко меняется от одного полевого теста к другому, и очевидной причины такого нестабильного поведения нет. Что еще хуже, полевые испытания даже не близки к контролируемым экспериментам, и существует довольно много факторов (тепловые и атмосферные условия, вибрация, радиочастотные помехи, электромагнитные помехи от ближайшего оборудования, ориентация, относительная скорость), которые могут влиять на производительность системы.

Один из способов справиться с этой ситуацией – выбрать факторы, которые с наибольшей вероятностью будут сильно влиять на BER, собрать данные и найти причинно-следственные связи. Поскольку доказать причинно-следственную связь часто очень сложно, наш анализ на самом деле даст количественную оценку корреляции, а затем мы можем либо предположить, что корреляция указывает на причинную связь (что рискованно), либо попытаться продемонстрировать причинность путем сбора новых данных из тщательно спланированного эксперимента.

Таким образом, поиск причинно-следственной связи начинается с поиска корреляции, а корреляция начинается с ковариации.

Переменные, которые изменяются вместе

Описательная статистическая мера, называемая дисперсией, обсуждалась в одной из предыдущих статей, которая также охватывает стандартное отклонение. Дисперсия (обозначается σ2) – это усредненная мощность (выраженная в единицах мощности) случайных отклонений в наборе данных. Мы рассчитываем дисперсию следующим образом:

[sigma^2=frac{1}{N-1}sum_{i=1}^{N}(X_i-mu)^2]

где N – количество значений в наборе данных (т.е. размер выборки), а μ – среднее значение.

Допустим, мы начинаем наше исследование с того, что отправим систему на несколько полевых испытаний и сохраним множество упорядоченных пар, состоящих из значений температуры окружающей среды и BER. Например, мы могли бы вычислить средний BER за пять минут работы, а затем связать эти данные со средней температурой за тот же интервал. Затем мы повторяем процедуру измерения в течение следующего пятиминутного интервала, следующего пятиминутного интервала и так далее.

Данные температуры и BER будут иметь свои собственные отдельные дисперсии, то есть склонность значений в заданном наборе данных отклоняться от среднего значения того же набора данных. Но мы также можем вычислить ковариацию, которая отражает склонность значений в двух наборах данных к линейному изменению вместе (или, более кратко, к линейному совместному изменению, англ. «co-vary» – отсюда и название «ковариация»).

Следующие три графика дают визуальное объяснение того, что означает совместное изменение переменных.

Расчет ковариации

Следующее математическое соотношение определяется как ковариация двух переменных X и Y:

[operatorname {cov} (X,Y)=operatorname {E} {{big [}(X-operatorname {E} [X])(Y-operatorname {E} [Y]){big ]}}]

Для дискретных данных с размером выборки N это соотношение будет следующим:

[operatorname {cov} (X,Y)=frac{1}{N-1}sum_{i=1}^{N}(X_i-operatorname {E}[X])(Y_i-operatorname {E}[Y])]

Возможно, вы не знакомы с обозначением E[X]. «E» означает «ожидаемое значение», которое равно среднему арифметическому. (Существует тонкое концептуальное различие между ожидаемым значением и средним значением, но это тема для другой статьи.) Я хотел ввести это обозначение, потому что концепция ожидаемого значения дает нам другой способ думать о среднем значении набора данных – это значение, которое мы ожидаем от следующего измерения, в том смысле, что это ожидаемое значение имеет наибольшую вероятность появления.

Формула ковариации станет интуитивно понятна, если вы поразмыслите над ней на минуту или две:

- Отклонения (как по величине, так и по полярности) в наборе данных X умножаются на отклонения в наборе данных Y.

- Соответствующие отклонения в двух наборах данных, которые являются как положительными, так и отрицательными, внесут положительный вклад в суммирование.

- Если одно отклонение положительное, а соответствующее отклонение другого набора данных отрицательное, вклад будет отрицательным.

- Когда мы делим результат суммирования на N–1, мы усредняем все эти вклады и тем самым генерируем значение, которое указывает

- склонность значений в двух наборах данных отклоняться в одном направлении (т.е.положительная ковариация),

- склонность к отклонениям в противоположные стороны (отрицательная ковариация),

- или отсутствие склонности к совместному отклонению (нулевая ковариация).

Заключение

Ковариация количественно определяет линейную корреляцию двух случайных величин. Однако значения ковариации несколько сложно интерпретировать, и в следующей статье мы обсудим две модифицированные версии ковариации, которые сделают корреляционный анализ более удобным.

Теги

BERКовариацияКорреляцияОписательная статистикаПричинность / причинно-следственная связьСтандартное отклонениеСтатистикаСтатистическая связь

Общие понятия об изучении связей

Анализ взаимосвязей, присущих изучаемым процессам и явлениям, является важнейшей задачей исторических, как впрочем и многих других, исследований. В тех случаях, когда речь идет о явлениях и процессах, обладающих сложной структурой и многообразием свойственных им связей, такой анализ представляет собой сложную задачу. Прежде всего необходимо установить наличие взаимосвязей и их характер. Вслед за этим возникает вопрос о тесноте взаимосвязей и степени воздействия различных факторов (причин) на интересующий исследователя результат. Если черты и свойства изучаемых объектов могут быть измерены и выражены количественно, то анализ взаимосвязей может вестись на основе применения математических методов. Использование этих методов позволяет проверить гипотезу о наличии или отсутствии взаимосвязей между теми или иными признаками, выдвигаемую на основе содержательного анализа. Далее, лишь посредством математических методов можно установить тесноту и характер взаимосвязей или выявить силу (степень) воздействия различных факторов на результат.

Наиболее разработанными в математической статистике методами анализа взаимосвязей являются корреляционный и регрессионный анализ. Но прежде чем переходить к их характеристике, остановимся на вопросе о характере и форме тех взаимосвязей, которые присущи объективным явлениям природы и общества.

Функциональные зависимости. Функциональная зависимость двух количественных признаков или переменных состоит в том, что каждому значению одной переменной всегда соответствует одно определенное значение другой переменной. Например, при строительстве железных дорог на километр пути приходится вполне определенное количество уложенных рельсов. Поэтому рассматривая статистические данные по таким количественным признакам: у— длина уложенного железнодорожного пути (в км), х—количество истраченного на строительстве рельсового проката (в тоннах), мы будем иметь дело с функциональной зависимостью определенного вида. Рассмотрим эту зависимость подробнее на условном примере:

Соотношение между признаками, отображенное в таблице, удобно представить в наглядной графической форме, рассматривая числовые данные как координаты точек в прямоугольной системе координат (рис. 8).

Графическим изображением анализируемой зависимости (полученным путем соединения непрерывной линией точек, соответствующих данным таблицы) служит прямая линия. Такая зависимость называется прямой пропорциональной зависимостью. Ее аналитическим выражением является уравнение y=kx, где k — коэффициент пропорциональности (в нашем случае &=100). Прямая пропорциональная зависимость представляет собой частный случай линейной зависимости, которая характеризуется уравнением

y=kx+b

Графическим изображением линейной зависимости также служит прямая линия (рис. 9).

Линейная зависимость является наиболее простой и в определенном смысле универсальной формой связи многих явлений. Ее универсальность состоит в том, что более сложные зависимости часто можно рассматривать «в первом приближении» как линейные. Здесь мы подходим к выяснению роли функциональных зависимостей в анализе стати стических связей. Непосредственно функциональные зависимости в чистом виде редко встречаются в общественных явлениях. Связи обычно носят гораздо более сложный характер. Однако их описание во всей сложности часто затруднительно, да и нецелесообразно. Поэтому их рассматривают как соответствующие тем или иным видам функциональной зависимости. Простейшей формой функциональной связи является линейная зависимость, которая широко используется в регрессионном и особенно в корреляционном анализе. Гипотеза о линейной связи между исследуемыми признаками получила широкое распространение в анализе взаимосвязей. Лишь в том случае, если результаты применения гипотезы о линейной зависимости оказываются неудачными или имеются веские основания против линейной связи, используют более сложные функциональные зависимости.

Отметим наиболее употребительные формы функциональной зависимости, применяемые в статистическом анализе.

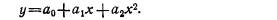

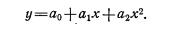

В случае если прямая линия не соответствует характеру используемых данных, можно использовать параболу (рис. 10). Аналитическое выражение ее имеет вид:

Наличие в этом уравнении члена a2x2 является простейшей формой учета нелинейности.

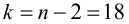

В том случае, когда мы имеем дело с затуханием роста или падения, удобно использовать гиперболические либо логарифмические зависимости (рис. 11 и 12). Математические выражения для гиперболической и логарифмической зависимостей выглядят так:

y=k/x; y=a lgx

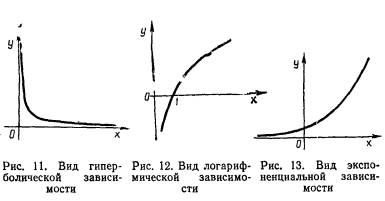

Процессы демографического и экономического роста описываются экспоненциальными зависимостями вида:

y=keλx.

Графическое изображение этой зависимости (k>0, λ>0) иллюстрируется рис. 13.

Подбор подходящей функциональной зависимости на основе графического и логического анализа является важным этапом исследования взаимосвязей, особенно в тех случаях, когда линейная связь оказалась неприемлемой.

В отличие от функциональной зависимости, когда каждому значению одного признака всегда соответствует определенное значение другого, при статистической зависимости одному и тому же значению одного признака могут соответствовать различные значения другого. Это происходит в силу того, что при статистической зависимости связь устанавливается между признаками (двумя, тремя и т. д.), которые изменяются не только в силу взаимодействия между собой, но и под воздействием множества различных неучтенных факторов. В результате множественного воздействия взаимно переплетающихся факторов связь между признаками существует и проявляется не в каждом отдельном случае, как при функциональной связи, а только в тенденции, «в среднем». Поэтому здесь установить наличие взаимосвязи и определить ее количественную меру можно не на основе единичных наблюдений, а лишь применительно к определенной совокупности объектов, т. е. в среднем по отношению к тем или иным массовым объектам или явлениям. Характеризующие эти объекты количественные показатели в источниковедении и в статистике называются массовыми данными.

Задачи анализа статистических связей. Анализ статистической, или корреляционной, связи предполагает выявление формы связи, а также оценку тесноты связи. Первая задача решается методами регрессионного анализа, вторая — методами корреляционного анализа. Регрессионный анализ сводится к описанию статистической связи с помощью подходящей функциональной зависимости. Корреляционный анализ позволяет оценивать тесноту связи посредством специальных показателей, причем выбор их зависит от вида функциональной зависимости, пригодной для адекватного описания рассматриваемой статистической взаимосвязи. Как указывалось, наиболее распространенной в изучении связей является гипотеза о линейной зависимости. Соответствующие ей методы корреляционного и регрессионного анализа наиболее полно разработаны в математической статистике. Прежде чем перейти к изложению этих методов, остановимся на двух общих вопросах, относящихся к корреляционному и регрессионному анализу.

Один из важных вопросов, возникающих в изучении связей,— установление «направления» зависимости. Пусть для простоты рассматривается связь между двумя признаками y и х. Какой из этих признаков следует считать подверженным влиянию, или результативным (зависимой переменной), какой — оказывающим влияние, или факторным (независимой переменной)?

Первостепенное значение в решении этого вопроса имеет содержательный анализ. Положим, мы рассматриваем связь между производительностью труда рабочих и стажем их работы. По-видимому, результативным признаком следует признать производительность труда, а факторным — стаж рабочего. Не всегда «направление» связи проявляется столь очевидно. Тогда при решении вопроса о выборе результативного признака на первый план выступает постановка содержательной проблемы, для исследования которой используется изучение взаимосвязей. Например, устанавливая «направление» связи между такими признаками, как доходность предприятий и их энерговооруженность, мы должны исходить из того, что же мы хотим установить в действительности: влияние внедрения новой техники и технологии на доходность предприятий или же потенциальные возможности предприятий в овладении передовой техникой и технологией. В первом случае результативным признаком естественно считать доходность, во втором — энерговооруженность.

Далее, корреляционный и регрессионный анализ могут применяться и дают вполне корректные результаты при соблюдении определенных условий. Это однородность исходных данных, независимость отдельных значений признака друг от друга и нормальность распределения изучаемых признаков. Некоторые способы проверки однородности, случайности и нормальности распределении данных указаны в гл. 9.

Условия применения корреляционного и регрессионного анализа, а также возникающие на практике нарушения условий и следствия этих нарушений рассмотрены в § 2 и 3 данной главы.

Линейная корреляция

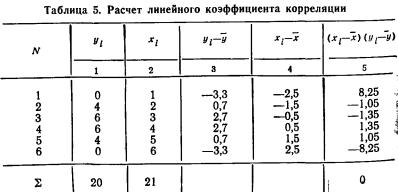

Одной из основных мер связи в корреляционном анализе является линейный коэффициент корреляции.

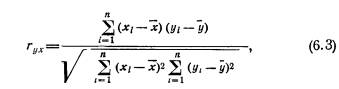

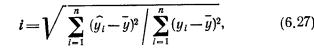

Парный линейный коэффициент корреляции. С помощью парного линейного коэффициента корреляции измеряется теснота связи между двумя признаками. Линейный коэффициент корреляции чаще всего рассчитывается по формуле

где xi и yi — значения признаков х и у соответственно для i-ro объекта, i=1, .., n; n — число объектов;

Линейный коэффициент корреляции изменяется в пределах от —1 до +1. Равенство коэффициента нулю свидетельствует об отсутствии линейной связи. Равенство коэффициента —1 или +1 показывает наличие функциональной связи. Знак «+» указывает на связь прямую (увеличение или уменьшение одного признака сопровождается аналогичным изменением другого признака), знак «—» — на связь обратную (увеличение или уменьшение одного признака сопровождается противоположным по направлению изменением другого признака).

Пример 1. Используя данные табл. 1, рассчитаем коэффициент корреляции между доходом крестьянского хозяйства и стоимостью имеющегося в этом хозяйстве скота

Воспользуемся формулой (6.3), а промежуточные расчеты сделаем с помощью рабочей табл. 1, в которую введем необходимые для вычислений графы:

Как оценить полученное значение коэффициента корреляции? Велико оно или мало? О наличии или об отсутствии связи свидетельствует? Для ответа на эти вопросы проводят проверку значимости коэффициента.

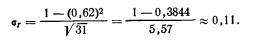

Проверка значимости парного линейного коэффициента корреляции. Коэффициенты корреляции, как правило, рассчитываются для выборочных данных. Чтобы распространить полученные частные результаты на генеральную совокупность, приходится допустить некоторую ошибку, которую можно оценить с помощью средней квадратической ошибки. Средняя квадратическая ошибка для парного линейного коэффициента корреляции достаточно большой выборки вычисляется по формуле

где ρ — коэффициент корреляции генеральной совокупности; n — объем выборки.

В математической статистике доказано, что если признаки х и y распределены по нормальному закону, то в достаточно больших выборках коэффициенты корреляции можно считать распределенными нормально со средним значением ρ и средним квадратическим отклонением σr (нормальное распределение рассмотрено в гл. 4). Этот факт используется для построения доверительных интервалов коэффициента корреляции в генеральной совокупности, а также для проверки значимости выборочных коэффициентов корреляции, т. е. для проверки того, могло ли данное значение r получиться в выборке из некоррелированной генеральной совокупности (ρ=0) в силу простой случайности.

Очевидно, чем больше отклонение r от ρ, тем менее вероятно, что оно случайно. Так, для нормального распределения вероятность того, что выборочное значение r отличается от ρ больше чем на 3σr, меньше 0,01, т. е. величина нормированного отклонения

Если

Пример 2. Выясним, является ли значимым коэффициент корреляция между доходов крестьянского хозяйства и стоимостью скота в хозяйстве.

В нашем примере, задавшись степенью достоверности Р, равной 0,99 и найдя соответствующее ей в таблице 1 приложения значение tкр=2.58, проводим сравнение. Поскольку tф=0.62/0,18=3,44 заметно превосходит табличное значение 2,58 и вероятность того, что это случайность, мала (0,01), связь между доходом крестьянского хозяйства и стоимостью имеющегося в нем скота следует признать значимой.

Поскольку вычисленный в примере 1 линейный коэффициент корреляции имеет положительный знак, то взаимосвязь между признаками прямая: чем больше скота в хозяйстве, тем больше доход, и чем меньше скота, тем доход меньше.

Заметим, что линейный коэффициент корреляции является показателем взаимной связи между признаками и не дает представления о том, какой из признаков является факторным, а какой — результативным (в формуле (6.3) признаки х и у совершенно равноправны).

Установив существенность взаимной связи между двумя признаками, можно поставить вопрос о тесноте связи. Напомним, что теснота линейной связи измеряется линейным коэффициентом корреляции, но такая оценка верна только для случая, когда расчеты проведены для генеральной совокупности. Для выборочных данных, что обычно имеет место в практике использования корреляционного анализа, необходимо выявить те границы, в пределах которых находится значение коэффициента корреляции генеральной совокупности, т. е. определить для него доверительные интервалы.

Доверительные интервалы для парного линейного коэффициента корреляции. После расчета выборочного коэффициента корреляции (r) и его средней квадратической ошибки (σr) устанавливается уровень достоверности выводов или доверительная вероятность. Для больших выборок соответственно выбранной вероятности Р по таблице нормального распределения определяется параметр t. Верхняя граница интервала получается прибавлением к выборочному коэффициенту корреляции tσr, нижняя граница—вычитанием tσr. Формула средней квадратической ошибки (6.4) содержит неизвестный на практике генеральный коэффициент корреляции. Обычно в расчетах его заменяют выборочным коэффициентом корреляции.

Пример 3. Определим доверительные интервалы для коэффициента, вычисленного в примере 1.

Полагая доверительную вероятность Р, т. е. вероятность, с которой гарантируются результаты, равной 0,98, находим в табл. 1 приложения соответствующее ей значение t, равное 2,33. Воспользовавшись формулой (6.4), где вместо ρ возьмем выборочный коэффициент корреляции r, равный 0,62, получим значение для средней квадратической ошибки

Поскольку tσr=2.33*0.11=0.26, верхняя и нижняя границы равны соответственно 0,88 и 0,36. Другими словами, с вероятностью 0,98 линейный коэффициент корреляции генеральной совокупности находится в пределах от 0,36 до 0,88.

Важнейшей предпосылкой использования корреляционного анализа является нормальность распределения признаков в генеральной совокупности. Нормальность распределения или, по крайней мере, близость распределения к нормальному необходима для корректного проведения проверки значимости связи и вычисления доверительных интервалов. Методы проверки нормальности распределения см. в гл. 9.

Проверка значимости парного линейного коэффициента корреляции для случая малой выборки. При пользовании формулами (6,4) — (6.5) необходимо учитывать два ограничения. Во-первых, они верны для коэффициента корреляции генеральной совокупности и замена последнего выборочным коэффициентом корреляции является искусственным приемом. Риск заменить генеральный коэффициент корреляции существенно отличным от него выборочным коэффициентом увеличивается с уменьшением объема выборки п. Во-вторых, при выборках небольшого объема распределение выборочного коэффициента корреляции может значительно отличаться от нормального, а нормальность распределения является важнейшим условием корректного использования доверительных интервалов и проверки значимости коэффициентов.

Таким образом, при малых объемах выборок (практически при n<50) изложенная выше методика определения доверительных интервалов и проверки значимости коэффициентов корреляции неприменима (поэтому примеры 2—3 являются в какой-то мере условными). Особенно возрастают требования к объему выборки при высоких, близких к 1, значениях показателя связи генеральной совокупности.

и сравнивается с табличной или критической величиной tкр, зависящей от числа k=n—2, где n—объем выборки, и от выбранной степени достоверности Р. Если , то приходят к выводу о наличии связи; если tф<tкр, то гипотеза об отсутствии связи не отклоняется.

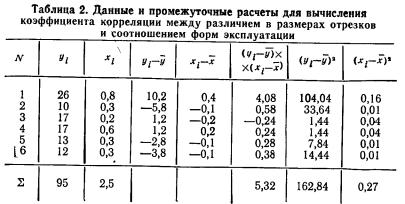

Пример 4. В трех первых столбцах табл. 2 приведены данные, позволяющие анализировать зависимость различий в размерах отрезков, установленных реформой 1861 г. и соотношением форм эксплуатации по шести губерниям Черноземного центра. Вычислим линейный коэффициент корреляции между этими признаками и проверим его значимость (у — % отрезков, х — отношение числа оброчных крестьян к числу барщинных).

Рассчитав средние значения признаков (

Для проверки значимости коэффициента воспользуемся формулой (6.6):

Табличное значение tкр(k) находим в табл. 2 приложения. Оно расположено на пересечении строки с номером k=n—2 и столбца с удовлетворяющей исследователя степенью достоверности результата. Для нашего примера число степеней свободы k=6—2=4. Положив степень достоверности результата Р равной 0,80, на пересечении 4-й строки и соответствующего 0,90 столбца находим tкр( k)=2,13.

Поскольку tф==2,7>t( k)==2,13, с риском ошибиться в 10 случаях из 100 отбрасываем гипотезу об отсутствии линейной связи, т. е. считаем, что связь между размером отрезков и формой эксплуатации крестьян существует.

Понятие о частной и множественной корреляции. С помощью парного линейного коэффициента корреляции выявляется связь между двумя признаками, один из которых можно рассматривать как результативный, другой — как факторный. Но в действительности на результат воздействуют несколько факторов. В связи с этим возникают два типа задач: задачи измерения комплексного влияния на результативную переменную нескольких переменных и задачи определения тесноты связи между двумя переменными при фиксированных значениях остальных переменных. Задачи первого типа решаются с помощью множественных коэффициентов корреляции, задачи второго типа — с помощью частных коэффициентов корреляции.

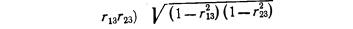

Частный, или чистый, коэффициент корреляции между двумя признаками при исключении влияния третьего признака (обозначим его символом r12.3) рассчитывается по формуле (Существует алгоритм, позволяющий вычислить частные коэффициенты корреляции при исключенном влиянии двух, трех и т. д. факторов. Этот рекуррентный алгоритм используется в машинном варианте (есть стандартные программы для ЭВМ).)

где индексы при r показывают номера признаков, связь между которыми оценивается.

Частный коэффициент корреляции первого и второго признаков при исключении влияния третьего оценивает тесноту линейной корреляционной связи между первым и вторым признаками при фиксированном значении третьего признака. Другими словами, он оценивает влияние на результативный (первый) признак изменения лишь второго признака.

Оценка влияния на результативный признак изменений третьего признака при постоянных значениях второго признака определяется по формуле

Значения частных коэффициентов корреляции заключаются в тех же пределах от —1 до +1, что и значения парных коэффициентов корреляции, и так же интерпретируются.

Пример 5. На основе данных табл. 1 оценить, какое из направлений хозяйства — скотоводческое или земледельческое — определяет доход в зажиточной группе крестьян.

Для решения этого вопроса в дополнение к рассчитанному в примере 1 коэффициенту r12, показывающему тесноту взаимосвязи между доходом хозяйства и стоимостью скота в нем, вычислим еще два парных коэффициента корреляции: r13—коэффициент связи между доходом, крестьянского хозяйства и уровнем землепользования в нем, r23 — коэффициент связи между землепользованием крестьянского двора и стоимостью всего скота.

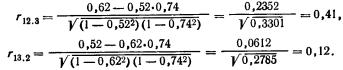

Получим r12=0,62, r13=0,52, r23=0,74. Парные коэффициенты корреляции, показывающие тесноту связи между доходом и уровнем землепользования, между доходом и стоимостью скота, почти равны по величине. Отсюда можно сделать вывод о том, что ни та, ни другая формы хозяйствования не имеет преимущественного влияния на доход. Однако взаимосвязь между самими факторными признаками, т. е. между землепользованием и стоимостью скота (r23), оказалась довольно тесной. Наличие же связи между факторными признаками может искажать действительную тесноту связи между результативным и факторными признаками. Расчет частных коэффициентов корреляции позволяет избавляться от этих искажений. Воспользовавшись формулами (6.7) и (6.8), вычислим коэффициенты r12.3 и r13.2.

Частный коэффициент корреляции между доходом крестьянского двора и стоимостью скота при постоянном показателе землепользования меньше, чем соответствующий парный коэффициент корреляции (0,41 против 0,62). По-видимому, взаимная зависимость между величиной дохода и стоимостью скота частично опосредствовалась через воздействие уровня землепользования.

Частная корреляция между доходом и землепользованием совсем мала (0,12) при довольно большом значении парного коэффициента (0,52). Это можно объяснить тем, что взаимная зависимость дохода и землепользования в значительной степени были усилена влиянием исключенного здесь фактора — стоимости скота.

Таким образом, частные коэффициенты корреляции позволяют установить тесноту взаимосвязи между двумя признаками при исключении влияния других переменных, но для окончательных выводов необходима проверка уровня значимости частных коэффициентов корреляции.

Значимость частных коэффициентов корреляции зависит не только от величины выборочного коэффициента и объема выборки, но также и от числа введенных в исследование переменных.

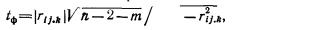

Для проверки значимости частных коэффициентов корреляции вычисляют величину по формуле

где rij.k — коэффициент корреляции между i и j признаками при исключенном влиянии k-го признака; m—количество исключенных признаков, и сравнивают ее с табличным или критическим значением, соответствующим принятому уровню значимости.

Наличие связи подтверждается, если вычисленное значение tф превосходит значение tкр.

Пример 5 (продолжение). Проверить значимость частных коэффициентов корреляции, рассчитанных выше.

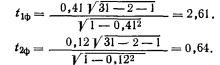

Воспользовавшись формулой (6.9), вычислим величины t1ф для r12.3 и t2ф для r13.2:

Для того чтобы найти табличные значения tкр, нужно задаться степенью достоверности выводов и учесть число n—2—m, фигурирующее в формуле (6.9).

Табличное значение tкр находится по табл. 2 приложения на пересечении строки с номером (n —2—m) и столбца, соответствующего заданной степени достоверности выводов.

В нашем примере в каждом коэффициенте число признаков, от которых мы абстрагируемся, равно 1 и, следовательно, n —2—m=31—2—1==28. Задавшись степенью достоверности, равной 0,90, по табл. 2 приложения находим значение tкр, равное 1,7.

Поскольку t1ф>tкр, подтверждается наличие взаимосвязи между доходом и стоимостью скота. Для второго из рассматриваемых коэффициентов t2ф<tкр, что свидетельствует, по-видимому, об отсутствии непосредственной связи между доходом и землепользованием.

Множественный, или совокупный, коэффициент корреляции для случая трех признаков, один из которых — результативный (с номером 1) и два—факторных (с порядковыми номерами 2 и 3) рассчитывается по формуле (Для расчетов используется такая формула

пригодная для случаев, когда число признаков, совокупное влияние которых исследуется, превосходит два. Существуют стандартные программы, вычисляющие R1(23…P))

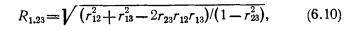

где подстрочные индексы при r показывают номера признаков, связь между которыми оценивается этим коэффициентом корреляции.

Множественный коэффициент корреляции является показателем тесноты линейной связи между результативным признаком и совокупностью факторных признаков.

Множественный коэффициент корреляции изменяется в пределах от 0 до 1. Равенство его нулю говорит об отсутствии линейной связи, равенство единице—о функциональной связи. Указаний на то, является ли связь прямой или обратной, коэффициент не дает.

Пример 6. Рассчитать множественный коэффициент корреляции между величиной дохода крестьянского хозяйства и совокупным влиянием на него уровня землепользования и стоимости скота в хозяйстве.

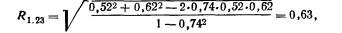

Воспользуемся результатами предыдущих примеров: r12=0.62; r13=0.52; r23=0.74. По формуле (6.10);

т. е. степень тесноты связи между доходом крестьянского хозяйства и совокупностью двух факторных признаков составляет 0,63.

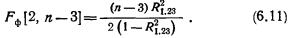

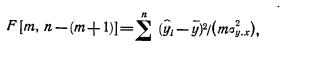

Вопрос о значимости множественного коэффициента корреляции решается с помощью так называемого F-критерия. Величина Fф, рассчитанная по специальной формуле, сравнивается с табличным (критическим) значением Fкр — распределения Фишера, соответствующим выбранной степени достоверности Р (или уровню значимости α=1—Р). Если Fф>Fкр, то коэффициент признается значимым на уровне а, так как вероятность того, что Fф для выборки случайно получилось больше Fкр, мала (меньше α). Для случая двух факторных признаков величина вычисляется по формуле (Формула расчетной величины F для общего случая m факторных признаков имеет вид

где R1.23…m+1—множественный коэффициент корреляции; n—число объектов, для которых приводятся значения признаков; m — число факторных признаков. Этот же критерий используется для проверки значимости регрессии, см. (6.20).)

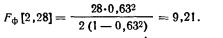

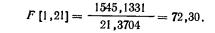

Пример 6 (продолжение). Проверить значимость вычисленного в примере 6 множественного коэффициента корреляции для уровня значимости α=0,05 (P=0,95).

Воспользуемся формулой (6.11):

В табл. 4А приложения (соответствующей α=0,05) во 2-м столбце и 28-й строке (номер столбца определяется по первому числу в квадратной скобке при F, а номер строки—по второму числу) находим критическое значение –распределения. Поскольку при достоверности вывода, равной 0,95, Fкр=3,34, т. е. Fф>Fкр, совместное влияние на величину дохода уровня землепользования и стоимости скота имеет место.

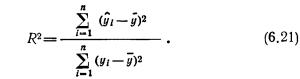

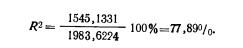

Коэффициент детерминации. Линейный коэффициент корреляции оценивает тесноту взаимосвязи между признаками и показывает, является ли связь прямой или обратной. Но понятие тесноты взаимосвязи часто может быть недостаточным при содержательном анализе взаимосвязей. В частности, коэффициент корреляции не показывает степень воздействия факторного признака на результативный. Таким показателем является коэффициент детерминации (обозначим его D), для случая линейной связи представляющий собой квадрат парного линейного коэффициента корреляции (D=r2) или квадрат множественного коэффициента корреляции. Его значение определяет долю (в процентах) изменений, обусловленных влиянием факторного признака, в общей изменчивости результативного признака.

Пример 7. Рассчитать по данным примера 4 (табл. 2) коэффициент детерминации.

Коэффициент корреляции равен 0,80. Коэффициент детерминации составляет: D=0,802•100%=64%.

Таким образом, различия в размерах отрезков в губерниях Черноземного центра на 64% определялись различиями в соотношении форм эксплуатации.

Корреляционная таблица. В предыдущем изложении каждый признак был представлен рядом значений. В некоторых случаях удобна другая форма записи исходных данных, в виде корреляционной таблицы.

Корреляционная таблица имеет такое устройство: по строкам располагаются значения одного признака, по столбцам — другого признака. Число, стоящее в клетке на пересечении i-й строки и j-го столбца, показывает, как часто i-e значение первого признака встречается совместно с j-м значением второго признака.

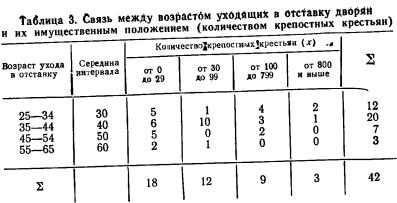

В табл. 3 представлены сведения об уходящих в отставку дворянах (60-е годы XVIII в.). В строках дан возраст ухода в отставку, в столбцах — имущественное обложение уходящих в отставку, характеризуемое числом принадлежащих им крестьян. В клетках представлены числа, показывающие, как часто встречаются соответствующие сочетания количественных значений этих двух признаков.

Корреляционная таблица является удобной формой представления данных. Уже беглое знакомство с ней нередко позволяет судить о тесноте связи (не обязательно линейной) между признаками. Если большие значения одного признака в основном сочетаются с большими значениями другого признака, а малые—с малыми, т. е. числа концентрируются вдоль диагонали таблицы, то можно говорить о наличии прямой связи. Если малые значения одного признака в большинстве случаев встречаются совместно с большими значениями другого признака, т. е. числа сосредоточены вдоль другой диагонали, то имеется обратная связь. При этом, чем больше концентрация частот вдоль одной из диагоналей, тем теснее связь.

Корреляционное отношение. Когда изучаемая совокупность (в виде корреляционной таблицы) разбивается на группы по одному (факторному) признаку х, то для каждой из этих групп можно вычислить соответствующие групповые средние результативного признака

или остаточной (S2ост). Поэтому отношение

является мерой степени влияния факторного признака на результативный. Значение квадратного корня из этого отношения измеряет «направленную связь» (x→y) в общем виде и носит название корреляционного отношения (ηy/x).

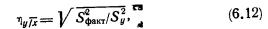

Величины Sфакт2 и Sy2 вычисляются по формулам:

где

Рассмотрим вычисление корреляционного отношения, воспользовавшись данными табл. 3.

Пример 8. В источнике, содержащем данные об уходящих в отставку дворянах, имеются сведения о. причинах ухода в отставку. Как правило, в качестве причины указывалась болезнь. Являлась ли эта причина единственной? Есть основания предположить, что возраст ухода в отставку зависел также от имущественного положения находящихся на военной службе дворян: чем более они были обеспечены, тем с большей легкостью могли оставить службу. Для проверки этого предположения измерим тесноту связи между возрастом уходящих в отставку дворян и их имущественным положением по данным табл. 3.

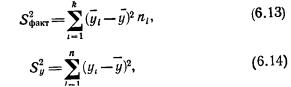

По признаку имущественного положения совокупность разбита на 4 группы. Рассчитаем средний возраст ухода в отставку для каждой группы

Аналогично вычислим

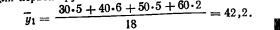

Наконец, вычислим общую среднюю арифметическую (средний возраст ухода в отставку по всем данным табл. 3). Для расчета этой средней в качестве весов возьмем числа, стоящие в последнем суммарном столбце таблицы;

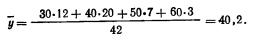

Далее, воспользовавшись последовательно формулами (6.13), (6.14) и (6 12), рассчитаем корреляционное отношение:

S2факт=(42,2-40,2)2+(40,8-40,2)2*12+37,7-40,2)2*9+(33,3-40,2)2*3=294,

S2y=(30-40.2)2*12+(40-40.2)2*20+(50-40.2)2*7+(60-40.2)2*3=3098,

Величена корреляционного отношения изменяется в пределах от 0 до 1. Близость ее к нулю говорит об отсутствии связи, близость к единице—о тесной связи.

Корреляционное отношение в отличие от линейного коэффициента корреляции не указывает, является ли связь прямой или обратной. Однако нередко уже по виду исходной таблицы можно решить этот вопрос. Промежуточные расчеты также помогают определить, является связь прямой или обратной: если с ростом факторного группировочного признака растут групповые средние результативного признака, то связь—прямая, если же с увеличением факторного признака значения групповых средних уменьшаются, то связь—обратная.

Как показатель тесноты связи корреляционное отношение имеет более универсальный характер, чем линейный коэффициент корреляции, поскольку его использование не ограничивается случаями линейной связи, а факторный признак может быть не количественным, а ранговым и даже номинальным.

Квадрат корреляционного отношения, выраженный в процентах, и коэффициент детерминации, как он определен выше, имеют одинаковый смысл, только при расчете коэффициента детерминации используется предположение о линейной связи между факторным и результативным признаками, тогда как при вычислении корреляционного отношения вопрос о форме связи не ставится.

Возвращаясь к примеру 8, оценим полученные в нем результаты. Корреляционное отношение, выражающее степень тесноты связи, оказалось равным 0,31, а квадрат корреляционного отношения в процентах (коэффициент детерминации) —9,9%.

Таким образом, возраст ухода в отставку зависит от имущественного положения, но в целом в небольшой степени: колебания имущественного положения только на 9,9% объясняют колебания возраста ухода в отставку. Причем, поскольку с увеличением количества крестьян у владельцев средний возраст ухода в отставку уменьшается, то связь между этими признаками — обратная (Вопрос оценки значимости корреляционного отношения в выборке рассмотрен в § 4 гл. 9.).

Линейный коэффициент корреляции, как уже отмечалось, является показателем взаимной связи между признаками, но не указывает, какой из них результативный, а какой — факторный. В этом отношении от него выгодно отличается корреляционное отношение, которое позволяет выявить это соотношение. Для этого вычисляются два корреляционных отношения, сравнение которых и помогает определить правильное распределение «ролей» между признаками.

Коэффициент корреляции и корреляционное отношение являются эффективным средством выявления связи между различными количественными признаками и определения ее тесноты. Коэффициент детерминации дает представление и о степени воздействия одних факторов на другие. Однако решение вопроса о тесноте связи нередко упирается в вопрос о форме связи. Кроме того, знание формы связи дает развернутое представление о влиянии различных факторов на результативный признак, а также возможность прогнозирования изменений результата при тех или иных комбинациях значений факторов.

Выявление формы связи осуществляется с помощью методов регрессионного анализа.

§ 3. Линейная регрессия

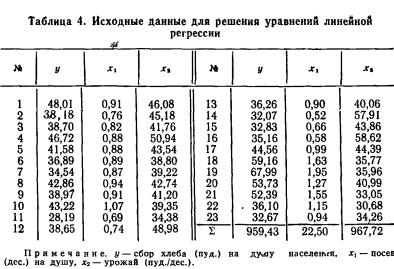

Суть метода наименьших квадратов. Рассмотрим содержание метода на конкретном примере. Пусть имеются данные о сборе хлеба на душу населения по совокупности черноземных губерний. От каких факторов зависит величина этого сбора? Вероятно, определяющее влияние на величину сбора хлеба оказывает величина посева и уровень урожайности. Рассмотрим сначала зависимость величины сбора хлеба на душу населения от размера посева на душу (столбцы 1 и 2 табл .4) Попытаемся представить интересующую нас зависимость с помощью прямой линии. Разумеется, такая линия может дать только приближенное представление о форме реальной статистической связи. Постараемся сделать это приближение наилучшим. Оно будет тем лучше, чем меньше исходные данные будут отличаться от соответствующих точек, лежащих на линии. Степень близости может быть выражена величиной суммы квадратов отклонении, реальных значений от, расположенных на прямой. Использование именно квадратов отклонений (не просто отклонений) позволяет суммировать отклонения различных знаков без их взаимного погашения и дополнительно обеспечивает сравнительно большее внимание, уделяемое большим отклонениям. Именно этот критерий (минимизация суммы квадратов отклонений) положен в основу метода наименьших квадратов.

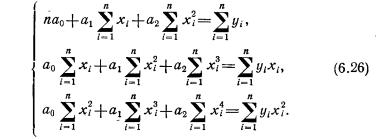

В вычислительном аспекте метод наименьших квадратов сводится к составлению и решению системы так называемых нормальных уравнений. Исходным этапом для этого является подбор вида функции, отображающей статистическую связь.

Тип функции в каждом конкретном случае можно подобрать путем прикидки на графике исходных данных подходящей, т. е. достаточно хорошо приближающей эти данные, линии. В нашем случае связь между сбором хлеба на душу и величиной посева на душу может быть изображена с помощью прямой линии (рис. 14) и записана в виде

где у—величина сбора хлеба на душу (результативный признак или зависимая переменная); x—величина посева на душу (факторный признак или независимая переменная); ao и a1 — параметры уравнения, которые могут быть найдены методом наименьших квадратов.

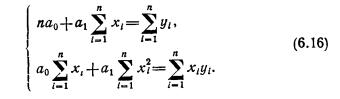

Для нахождения искомых параметров нужно составить систему уравнений, которая в данном случае будет иметь вид

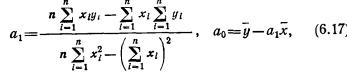

Полученная система может быть решена известным из школьного курса методом Гаусса. Искомые параметры системы из двух нормальных уравнений можно вычислить и непосредственно с помощью последовательного использования нижеприведенных формул:

где yi — i-e значение результативного признака; xi — i-e значение факторного признака;

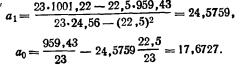

Пример 9. Найдем уравнение линейной связи между величиной сбора хлеба (у) и размером посева (х) по данным табл. 4. Проделав необходимые вычисления, получим из (6.17):

принято говорить, уравнение регрессии, выглядит следующим образом:

у = 17,6727+24,5759x.

Интерпретация коэффициента регрессии. Уравнение регрессии не только определяет форму анализируемой связи, но и показывает, в какой степени изменение одного признака сопровождается изменением другого признака.

Коэффициент при х, называемый коэффициентом регрессии, показывает, на какую величину в среднем изменяется результативный признак у при изменении факторного признака х на единицу.

В примере 9 коэффициент регрессии получился равным 24,58. Следовательно, с увеличением посева, приходящегося на душу, на одну десятину сбор хлеба на душу населения в среднем увеличивается на 24,58 пуда.

Средняя и предельная ошибки коэффициента регрессии. Поскольку уравнения регрессии рассчитываются, как правило, для выборочных данных, обязательно встают вопросы точности и надежности полученных результатов. Вычисленный коэффициент регрессии, будучи выборочным, с некоторой точностью оценивает соответствующий коэффициент регрессии генеральной совокупности. Представление об этой точности дает средняя ошибка коэффициента регрессии (

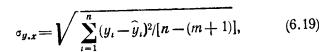

где

уi, — i-e значение результативного признака; ŷi — i-e выравненное значение, полученное из уравнения (6.15); xi—i-e значение факторного признака; σx—среднее квадратическое отклонение х; n — число значений х или, что то же самое, значений у; m—число факгорных признаков (независимых переменных).

В формуле (6.18), в частности, формализовано очевидное положение: чем больше фактические значения отклоняются от выравненных, тем большую ошибку следует ожидать; чем меньше число наблюдений, на основе которых строится уравнение, тем больше будет ошибка.

Средняя ошибка коэффициента регрессии является основой для расчета предельной ошибки. Последняя показывает, в каких пределах находится истинное значение коэффициента регрессии при заданной надежности результатов. Предельная ошибка коэффициента регрессии вычисляется аналогично предельной ошибке средней арифметической (см. гл. 5), т. е. как t

Пример 10. Найти среднюю и предельную ошибки коэффициента регрессии, полученного в примере 9.

Для расчета

ŷi = 17,6681 +24,5762*0,91 = 40,04 и т. д.

Затем вычислим отклонения фактических значений уi, от выравненных и их квадраты

Далее, подсчитав средний по черноземным губерниям посев на душу ( =0,98), отклонения фактических значений xi от этой средней, квадраты отклонений и среднее квадратическое отклонение

Задавшись уровнем надежности, равным 0,95, найдем по табл. 1 приложения соответствующее ему значение t=1,96, рассчитаем предельную ошибку 1,96*2,89=5,66 и пределы коэффициента регрессии для принятого уровня надежности (В случае малых выборок величина t находится из табл. 2 приложения.). Нижняя граница коэффициента регрессии равна 24,58-5,66=18,92, а верхняя граница 24,58+5,66=30,24

Средняя квадратическая ошибка линии регрессии. Уравнение регрессии представляет собой функциональную связь, при которой по любому значению х можно однозначно определить значение у. Функциональная связь лишь приближенно отражает связь реальную, причем степень этого приближения может быть различной и зависит она как от свойств исходных данных, так и от выбора вида функции, по которой производится выравнивание.

На рис. 15 представлены два различных случая взаимоотношения между двумя признаками. В обоих случаях предполагаемая связь описывается одним и тем же уравнением, но во втором случае соотношение между признаками х и у достаточно четко выражено и уравнение, по-видимому, довольно хорошо описывает это соотношение, тогда как в первом случае сомнительно само наличие сколько-нибудь закономерного соотношения между признаками. И в том, и в другом случаях, несмотря на их существенное различие, метод наименьших квадратов дает одинаковое уравнение, поскольку этот метод нечувствителен к потенциальным возможностям исходного материала вписаться в ту или иную схему. Кроме того, метод наименьших квадратов применяется для расчета неизвестных параметров заранее выбранного вида функции, и вопрос о выборе наиболее подходящего для конкретных данных вида функции в рамках этого метода не ставится и не решается. Таким образом, при пользовании методом наименьших квадратов открытыми остаются два важных вопроса, а именно: существует ли связь и верен ли выбор вида функции, с помощью которой делается попытка описать форму связи.

Чтобы оценить, насколько точно уравнение регрессии описывает реальные соотношения между переменными, нужно ввести меру рассеяния фактических значений относительно вычисленных с помощью уравнения. Такой мерой служит средняя квадратическая ошибка регрессионного уравнения, вычисляемая по приведенной выше формуле (6.19).

Пример 11. Определить среднюю квадратическую ошибку уравнения, полученного в примере 9.

Промежуточные расчеты примера 10 дают нам среднюю квадратическую ошибку уравнения. Она равна 4,6 пуда.

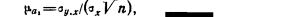

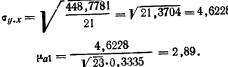

Этот показатель аналогичен среднему квадратическому отклонению для средней. Подобно тому, как по величине среднего квадратического отклонения можно судить о представительности средней арифметической (см. гл. 5), по величине средней квадратической ошибки регрессионного уравнения можно сделать вывод о том, насколько показательна для соотношения между признаками та связь, которая выявлена уравнением. В каждом конкретном случае фактическая ошибка может оказаться либо больше, либо меньше средней. Средняя квадратическая ошибка уравнения показывает, насколько в среднем мы ошибемся, если будем пользоваться уравнением, и тем самым дает представление о точности уравнения. Чем меньше σy.x, тем точнее предсказание линии регрессии, тем лучше уравнение регрессии описывает существующую связь. Показатель σy.x позволяет различать случаи, представленные на рис. 15. В случае б) он окажется значительно меньше, чем в случае а). Величина σy.x зависит как от выбора функции, так и от степени описываемой связи.