Пусть дана матрица

3-го порядка. Надо найти жорданову форму

и жорданов базис.

-

Пусть

характеристический многочлен матрицыимеет вид

![]()

,

где

![]()

![]()

.

Тогда

жорданова форма матрицы имеет вид

.

-

Пусть

характеристический многочлен матрицыимеет вид

![]()

,

где

.

Возможны два случая:

а)

![]()

,

поэтому

![]()

и, следовательно,

![]()

,

поэтому жорданова форма содержит две

жордановы клетки с собственным значением

![]()

:

;

б)

![]()

,

поэтому

![]()

и, следовательно, жорданова форма

содержит одну жорданову клетку с

собственным значением

:

.

-

Пусть

характеристический многочлен матрицыимеет вид

![]()

.

Возможны два

случая:

а)

,

поэтому

и, следовательно, жорданова форма

содержит две жордановы клетки с

собственным значением

:

;

б)

,

поэтому

и, следовательно, жорданова форма

содержит одну жорданову клетку с

собственным значением

:

.

Задача.

Дана матрица

.

Найти

![]()

.

Р е ш е

н и е.

Найдем характеристический многочлен

матрицы:

![]()

.

Жорданова

форма матрицы

имеет вид

.

Найдем

.

Для

нахождения

воспользуемся формулой

![]()

,

где

![]()

– матрица перехода от базиса

![]()

к базису

![]()

.

Очевидно, что

![]()

,

поэтому

![]()

.

Пример

1. Найти жорданову форму и жорданов

базис матрицы оператора

.

Р е ш е

н и е.

Вычислим

,

следовательно,

собственное значение

![]()

,

![]()

.

Найдем

геометрическую кратность собственного

значения

.

Для этого посчитаем ранг матрицы

.

Следовательно,

![]()

,

поэтому

жорданова форма имеет вид

или

.

Найдем собственный вектор

,

соответствующий собственному значению

.

Так как он удовлетворяет условию

![]()

,

то

решим систему

.

Следовательно,

координаты собственного вектора

![]()

удовлетворяют уравнению

![]()

.

Заметим, что коэффициент при

![]()

равен 0, поэтому

может принимать любые значения.

Отбрасывать

нельзя !!!

Для

нахождения ФСР построим таблицу

.

Векторы

![]()

,

![]()

образуют фундаментальную систему

решений в собственном подпространстве

![]()

,

поэтому любой собственный вектор,

отвечающий собственному значению

![]()

,

линейно через них выражается и,

следовательно, имеет вид

![]()

.

Так как

![]()

,

,

то должен быть один присоединенный

вектор, который будет являться решением

системы

![]()

.

Подберем коэффициенты

![]()

и

![]()

таким образом, чтобы система

была совместна. Так как

,

то для

совместности системы необходимо, чтобы

выполнялось условие

![]()

.

Возьмем

![]()

,

тогда

![]()

,

и координаты присоединенного вектора

являются решением системы

,

то есть

удовлетворяют уравнению

![]()

или

![]()

.

Возьмем

![]()

.

Таким образом, у нас есть собственный

вектор

![]()

,

присоединенный к нему

![]()

и нужен еще один собственный вектор,

отвечающий собственному значению

.

Можно взять или вектор

![]()

,

или

![]()

,

или любой другой, отличный от

,

отвечающий собственному значению

.

Эти три вектора и будут образовывать

жорданов базис.

Пример 2. Найти жорданову

форму и жорданов базис матрицы оператора

.

Р е ш е

н и е.

Вычислим

,

следовательно,

собственное значение

![]()

,

.

Найдем

геометрическую кратность собственного

значения

.

Для этого посчитаем ранг матрицы

.

Следовательно,

![]()

,

поэтому

жорданова форма имеет вид

или

.

Найдем собственный вектор

,

соответствующий собственному значению

.

Так как он удовлетворяет условию

![]()

,

то

решим систему

.

Очевидно,

что координаты собственного вектора

удовлетворяют уравнению

![]()

или

![]()

.

Для

нахождения ФСР построим таблицу

.

Векторы

![]()

,

![]()

образуют фундаментальную систему

решений в собственном подпространстве

![]()

,

поэтому любой собственный вектор,

отвечающий собственному значению

![]()

,

линейно через них выражается

и, следовательно, имеет вид

![]()

.

Так как

,

,

то должен быть один присоединенный

вектор, который будет являться решением

системы

![]()

.

Подберем коэффициенты

и

таким образом, чтобы система

была совместна. Так как

,

то для

совместности системы необходимо, чтобы

выполнялось условие

.

Возьмем

,

тогда

![]()

и координаты присоединенного вектора

являются решением системы

,

то есть

удовлетворяют уравнению

![]()

или

![]()

.

Возьмем

![]()

.

Таким образом, у нас есть собственный

вектор

,

присоединенный к нему

и нужен еще один собственный вектор,

отвечающий собственному значению

.

Можно взять или вектор

,

или

,

или любой другой, отличный от

,

отвечающий собственному значению

.

Эти три вектора и будут образовывать

жорданов базис.

Пример 3. Найти жорданову

форму и жорданов базис матрицы оператора

.

Р е ш е

н и е.

Вычислим

.

Таким образом, получили три собственных

значения

![]()

,

![]()

,

![]()

.

Так как алгебраическая кратность каждого

из них равна 1, то жорданова форма имеет

следующий вид

.

Найдем собственный вектор

![]()

,

соответствующий собственному значению

.

Очевидно, что он является решением

уравнения

![]()

и, следовательно, его координаты

удовлетворяют системе

![]()

![]()

,

то есть

![]()

,

поэтому можем взять

![]()

.

Вычислим собственный вектор

![]()

,

соответствующий собственному значению

.

Очевидно, что он удовлетворяет уравнению

,

а его координаты – системе

,

откуда

следует, что

![]()

,

поэтому можем взять

![]()

.

Найдем собственный вектор

![]()

,

соответствующий собственному значению

![]()

.

Так как он является решением уравнения

![]()

,

то его координаты удовлетворяют системе

![]()

,

и,

следовательно,

,

поэтому можем взять

![]()

.

Векторы

![]()

образуют жорданов базис матрицы.

Пример 4. Найти жорданову

форму и жорданов базис матрицы оператора

.

Р е ш е

н и е.

Вычислим

.

Таким образом, получили два собственных

значения

,

![]()

.

Так как алгебраическая кратность

равна 2, нужно вычислить геометрическую

кратность

![]()

собственного значения

.

Для этого посчитаем ранг матрицы

.

Очевидно, что

![]()

,

поэтому

![]()

и, следовательно, жорданова форма имеет

следующий вид

.

Найдем собственные векторы

,

,

соответствующие собственному значению

.

Очевидно, что они являются решением

уравнения

,

а их координаты

![]()

– решением системы

,

и,

следовательно, удовлетворяют уравнению

![]()

или

![]()

.

Для

нахождения ФСР построим таблицу

.

Векторы

![]()

,

![]()

образуют фундаментальную систему

решений в собственном подпространстве

![]()

,

поэтому любой собственный вектор,

отвечающий собственному значению

![]()

,

линейно через них выражается и,

следовательно, имеет вид

![]()

.

Так

как

,

то нужно выбрать любые два линейно

независимых вектора из этой линейной

комбинации. Возьмем

![]()

,

![]()

.

Найдем собственный вектор

,

соответствующий собственному значению

.

Очевидно, что он удовлетворяет уравнению

,

а его координаты

– системе

,

то есть

,

поэтому можем взять

![]()

.

Векторы

образуют жорданов базис матрицы.

Соседние файлы в предмете [НЕСОРТИРОВАННОЕ]

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

- #

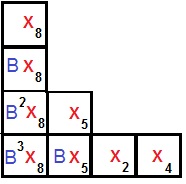

Example of a matrix in Jordan normal form. All matrix entries not shown are zero. The outlined squares are known as “Jordan blocks”. Each Jordan block contains one number lambda on its main diagonal, and ones above the main diagonal. The lambdas are the eigenvalues of the matrix; they need not be distinct.

In linear algebra, a Jordan normal form, also known as a Jordan canonical form (JCF),[1][2]

is an upper triangular matrix of a particular form called a Jordan matrix representing a linear operator on a finite-dimensional vector space with respect to some basis. Such a matrix has each non-zero off-diagonal entry equal to 1, immediately above the main diagonal (on the superdiagonal), and with identical diagonal entries to the left and below them.

Let V be a vector space over a field K. Then a basis with respect to which the matrix has the required form exists if and only if all eigenvalues of the matrix lie in K, or equivalently if the characteristic polynomial of the operator splits into linear factors over K. This condition is always satisfied if K is algebraically closed (for instance, if it is the field of complex numbers). The diagonal entries of the normal form are the eigenvalues (of the operator), and the number of times each eigenvalue occurs is called the algebraic multiplicity of the eigenvalue.[3][4][5]

If the operator is originally given by a square matrix M, then its Jordan normal form is also called the Jordan normal form of M. Any square matrix has a Jordan normal form if the field of coefficients is extended to one containing all the eigenvalues of the matrix. In spite of its name, the normal form for a given M is not entirely unique, as it is a block diagonal matrix formed of Jordan blocks, the order of which is not fixed; it is conventional to group blocks for the same eigenvalue together, but no ordering is imposed among the eigenvalues, nor among the blocks for a given eigenvalue, although the latter could for instance be ordered by weakly decreasing size.[3][4][5]

The Jordan–Chevalley decomposition is particularly simple with respect to a basis for which the operator takes its Jordan normal form. The diagonal form for diagonalizable matrices, for instance normal matrices, is a special case of the Jordan normal form.[6][7][8]

The Jordan normal form is named after Camille Jordan, who first stated the Jordan decomposition theorem in 1870.[9]

Overview[edit]

Notation[edit]

Some textbooks have the ones on the subdiagonal; that is, immediately below the main diagonal instead of on the superdiagonal. The eigenvalues are still on the main diagonal.[10][11]

Motivation[edit]

An n × n matrix A is diagonalizable if and only if the sum of the dimensions of the eigenspaces is n. Or, equivalently, if and only if A has n linearly independent eigenvectors. Not all matrices are diagonalizable; matrices that are not diagonalizable are called defective matrices. Consider the following matrix:

Including multiplicity, the eigenvalues of A are λ = 1, 2, 4, 4. The dimension of the eigenspace corresponding to the eigenvalue 4 is 1 (and not 2), so A is not diagonalizable. However, there is an invertible matrix P such that J = P−1AP, where

The matrix

Complex matrices[edit]

In general, a square complex matrix A is similar to a block diagonal matrix

where each block Ji is a square matrix of the form

So there exists an invertible matrix P such that P−1AP = J is such that the only non-zero entries of J are on the diagonal and the superdiagonal. J is called the Jordan normal form of A. Each Ji is called a Jordan block of A. In a given Jordan block, every entry on the superdiagonal is 1.

Assuming this result, we can deduce the following properties:

- Counting multiplicities, the eigenvalues of J, and therefore of A, are the diagonal entries.

- Given an eigenvalue λi, its geometric multiplicity is the dimension of ker(A − λi I), where I is the identity matrix, and it is the number of Jordan blocks corresponding to λi.[12]

- The sum of the sizes of all Jordan blocks corresponding to an eigenvalue λi is its algebraic multiplicity.[12]

- A is diagonalizable if and only if, for every eigenvalue λ of A, its geometric and algebraic multiplicities coincide. In particular, the Jordan blocks in this case are 1 × 1 matrices; that is, scalars.

- The Jordan block corresponding to λ is of the form λI + N, where N is a nilpotent matrix defined as Nij = δi,j−1 (where δ is the Kronecker delta). The nilpotency of N can be exploited when calculating f(A) where f is a complex analytic function. For example, in principle the Jordan form could give a closed-form expression for the exponential exp(A).

- The number of Jordan blocks corresponding to λ of size at least j is dim ker(A − λI)j − dim ker(A − λI)j−1. Thus, the number of Jordan blocks of size j is

- Given an eigenvalue λi, its multiplicity in the minimal polynomial is the size of its largest Jordan block.

Example[edit]

Consider the matrix

that is,

Let

We see that

For

But

Thus,

Vectors such as

Example: Obtaining the normal form[edit]

This example shows how to calculate the Jordan normal form of a given matrix.

Consider the matrix

which is mentioned in the beginning of the article.

The characteristic polynomial of A is

This shows that the eigenvalues are 1, 2, 4 and 4, according to algebraic multiplicity. The eigenspace corresponding to the eigenvalue 1 can be found by solving the equation Av = λv. It is spanned by the column vector v = (−1, 1, 0, 0)T. Similarly, the eigenspace corresponding to the eigenvalue 2 is spanned by w = (1, −1, 0, 1)T. Finally, the eigenspace corresponding to the eigenvalue 4 is also one-dimensional (even though this is a double eigenvalue) and is spanned by x = (1, 0, −1, 1)T. So, the geometric multiplicity (that is, the dimension of the eigenspace of the given eigenvalue) of each of the three eigenvalues is one. Therefore, the two eigenvalues equal to 4 correspond to a single Jordan block, and the Jordan normal form of the matrix A is the direct sum

There are three Jordan chains. Two have length one: {v} and {w}, corresponding to the eigenvalues 1 and 2, respectively. There is one chain of length two corresponding to the eigenvalue 4. To find this chain, calculate

where I is the 4 × 4 identity matrix. Pick a vector in the above span that is not in the kernel of A − 4I; for example, y = (1,0,0,0)T. Now, (A − 4I)y = x and (A − 4I)x = 0, so {y, x} is a chain of length two corresponding to the eigenvalue 4.

The transition matrix P such that P−1AP = J is formed by putting these vectors next to each other as follows

A computation shows that the equation P−1AP = J indeed holds.

If we had interchanged the order in which the chain vectors appeared, that is, changing the order of v, w and {x, y} together, the Jordan blocks would be interchanged. However, the Jordan forms are equivalent Jordan forms.

Generalized eigenvectors[edit]

Given an eigenvalue λ, every corresponding Jordan block gives rise to a Jordan chain of linearly independent vectors pi, i = 1, …, b, where b is the size of the Jordan block. The generator, or lead vector, pb of the chain is a generalized eigenvector such that (A − λI)bpb = 0. The vector p1 = (A − λI)b−1pb is an ordinary eigenvector corresponding to λ. In general, pi is a preimage of pi−1 under A − λI. So the lead vector generates the chain via multiplication by A − λI.[13][2] Therefore the statement that every square matrix A can be put in Jordan normal form is equivalent to the claim that the underlying vector space has a basis composed of Jordan chains.

A proof[edit]

We give a proof by induction that any complex-valued square matrix A may be put in Jordan normal form. Since the underlying vector space can be shown[14] to be the direct sum of invariant subspaces associated with the eigenvalues, A can be assumed to have just one eigenvalue λ. The 1 × 1 case is trivial. Let A be an n × n matrix. The range of A − λI, denoted by Ran(A − λI), is an invariant subspace of A. Also, since λ is an eigenvalue of A, the dimension of Ran(A − λI), r, is strictly less than n, so, by the inductive hypothesis, Ran(A − λI) has a basis {p1, …, pr} composed of Jordan chains.

Next consider the kernel, that is, the subspace ker(A − λI). If

the desired result follows immediately from the rank–nullity theorem. (This would be the case, for example, if A were Hermitian.)

Otherwise, if

let the dimension of Q be s ≤ r. Each vector in Q is an eigenvector, so Ran(A − λI) must contain s Jordan chains corresponding to s linearly independent eigenvectors. Therefore the basis {p1, …, pr} must contain s vectors, say {pr−s+1, …, pr}, that are lead vectors of these Jordan chains. We can “extend the chains” by taking the preimages of these lead vectors. (This is the key step.) Let qi be such that

The set {qi}, being preimages of the linearly independent set {pi} under A − λ I, is also linearly independent. Clearly no non-trivial linear combination of the qi can lie in ker(A − λI), for {pi}i=r−s+1, …, r is linearly independent. Furthermore, no non-trivial linear combination of the qi can belong to Ran(A − λ I) because it would then be a linear combination of the basic vectors p1, …, pr, and this linear combination would have a contribution of basic vectors not in ker(A − λI) because otherwise it would belong to ker(A − λI). The action of A − λI on both linear combinations would then produce an equality of a non-trivial linear combination of lead vectors and such a linear combination of non-lead vectors, which would contradict the linear independence of (p1, …, pr).

Finally, we can pick any linearly independent set {z1, …, zt} whose projection spans

Each zi forms a Jordan chain of length 1. By construction, the union of the three sets {p1, …, pr}, {qr−s +1, …, qr}, and {z1, …, zt} is linearly independent, and its members combine to form Jordan chains. Finally, by the rank–nullity theorem, the cardinality of the union is n. In other words, we have found a basis composed of Jordan chains, and this shows A can be put in Jordan normal form.

Uniqueness[edit]

It can be shown that the Jordan normal form of a given matrix A is unique up to the order of the Jordan blocks.

Knowing the algebraic and geometric multiplicities of the eigenvalues is not sufficient to determine the Jordan normal form of A. Assuming the algebraic multiplicity m(λ) of an eigenvalue λ is known, the structure of the Jordan form can be ascertained by analyzing the ranks of the powers (A − λI)m(λ). To see this, suppose an n × n matrix A has only one eigenvalue λ. So m(λ) = n. The smallest integer k1 such that

is the size of the largest Jordan block in the Jordan form of A. (This number k1 is also called the index of λ. See discussion in a following section.) The rank of

is the number of Jordan blocks of size k1. Similarly, the rank of

is twice the number of Jordan blocks of size k1 plus the number of Jordan blocks of size k1 − 1. The general case is similar.

This can be used to show the uniqueness of the Jordan form. Let J1 and J2 be two Jordan normal forms of A. Then J1 and J2 are similar and have the same spectrum, including algebraic multiplicities of the eigenvalues. The procedure outlined in the previous paragraph can be used to determine the structure of these matrices. Since the rank of a matrix is preserved by similarity transformation, there is a bijection between the Jordan blocks of J1 and J2. This proves the uniqueness part of the statement.

Real matrices[edit]

If A is a real matrix, its Jordan form can still be non-real. Instead of representing it with complex eigenvalues and ones on the superdiagonal, as discussed above, there exists a real invertible matrix P such that P−1AP = J is a real block diagonal matrix with each block being a real Jordan block.[15] A real Jordan block is either identical to a complex Jordan block (if the corresponding eigenvalue

and describe multiplication by

This real Jordan form is a consequence of the complex Jordan form. For a real matrix the nonreal eigenvectors and generalized eigenvectors can always be chosen to form complex conjugate pairs. Taking the real and imaginary part (linear combination of the vector and its conjugate), the matrix has this form with respect to the new basis.

Matrices with entries in a field[edit]

Jordan reduction can be extended to any square matrix M whose entries lie in a field K. The result states that any M can be written as a sum D + N where D is semisimple, N is nilpotent, and DN = ND. This is called the Jordan–Chevalley decomposition. Whenever K contains the eigenvalues of M, in particular when K is algebraically closed, the normal form can be expressed explicitly as the direct sum of Jordan blocks.

Similar to the case when K is the complex numbers, knowing the dimensions of the kernels of (M − λI)k for 1 ≤ k ≤ m, where m is the algebraic multiplicity of the eigenvalue λ, allows one to determine the Jordan form of M. We may view the underlying vector space V as a K[x]-module by regarding the action of x on V as application of M and extending by K-linearity. Then the polynomials (x − λ)k are the elementary divisors of M, and the Jordan normal form is concerned with representing M in terms of blocks associated to the elementary divisors.

The proof of the Jordan normal form is usually carried out as an application to the ring K[x] of the structure theorem for finitely generated modules over a principal ideal domain, of which it is a corollary.

Consequences[edit]

One can see that the Jordan normal form is essentially a classification result for square matrices, and as such several important results from linear algebra can be viewed as its consequences.

Spectral mapping theorem[edit]

Using the Jordan normal form, direct calculation gives a spectral mapping theorem for the polynomial functional calculus: Let A be an n × n matrix with eigenvalues λ1, …, λn, then for any polynomial p, p(A) has eigenvalues p(λ1), …, p(λn).

Characteristic polynomial[edit]

The characteristic polynomial of A is

Therefore,

where

Cayley–Hamilton theorem[edit]

The Cayley–Hamilton theorem asserts that every matrix A satisfies its characteristic equation: if p is the characteristic polynomial of A, then

then its Jordan block

As the diagonal blocks do not affect each other, the ith diagonal block of

The Jordan form can be assumed to exist over a field extending the base field of the matrix, for instance over the splitting field of p; this field extension does not change the matrix p(A) in any way.

Minimal polynomial[edit]

The minimal polynomial P of a square matrix A is the unique monic polynomial of least degree, m, such that P(A) = 0. Alternatively, the set of polynomials that annihilate a given A form an ideal I in C[x], the principal ideal domain of polynomials with complex coefficients. The monic element that generates I is precisely P.

Let λ1, …, λq be the distinct eigenvalues of A, and si be the size of the largest Jordan block corresponding to λi. It is clear from the Jordan normal form that the minimal polynomial of A has degree Σsi.

While the Jordan normal form determines the minimal polynomial, the converse is not true. This leads to the notion of elementary divisors. The elementary divisors of a square matrix A are the characteristic polynomials of its Jordan blocks. The factors of the minimal polynomial m are the elementary divisors of the largest degree corresponding to distinct eigenvalues.

The degree of an elementary divisor is the size of the corresponding Jordan block, therefore the dimension of the corresponding invariant subspace. If all elementary divisors are linear, A is diagonalizable.

Invariant subspace decompositions[edit]

The Jordan form of a n × n matrix A is block diagonal, and therefore gives a decomposition of the n dimensional Euclidean space into invariant subspaces of A. Every Jordan block Ji corresponds to an invariant subspace Xi. Symbolically, we put

where each Xi is the span of the corresponding Jordan chain, and k is the number of Jordan chains.

One can also obtain a slightly different decomposition via the Jordan form. Given an eigenvalue λi, the size of its largest corresponding Jordan block si is called the index of λi and denoted by v(λi). (Therefore, the degree of the minimal polynomial is the sum of all indices.) Define a subspace Yi by

This gives the decomposition

where l is the number of distinct eigenvalues of A. Intuitively, we glob together the Jordan block invariant subspaces corresponding to the same eigenvalue. In the extreme case where A is a multiple of the identity matrix we have k = n and l = 1.

The projection onto Yi and along all the other Yj ( j ≠ i ) is called the spectral projection of A at vi and is usually denoted by P(λi ; A). Spectral projections are mutually orthogonal in the sense that P(λi ; A) P(vj ; A) = 0 if i ≠ j. Also they commute with A and their sum is the identity matrix. Replacing every vi in the Jordan matrix J by one and zeroing all other entries gives P(vi ; J), moreover if U J U−1 is the similarity transformation such that A = U J U−1 then P(λi ; A) = U P(λi ; J) U−1. They are not confined to finite dimensions. See below for their application to compact operators, and in holomorphic functional calculus for a more general discussion.

Comparing the two decompositions, notice that, in general, l ≤ k. When A is normal, the subspaces Xi‘s in the first decomposition are one-dimensional and mutually orthogonal. This is the spectral theorem for normal operators. The second decomposition generalizes more easily for general compact operators on Banach spaces.

It might be of interest here to note some properties of the index, ν(λ). More generally, for a complex number λ, its index can be defined as the least non-negative integer ν(λ) such that

So ν(v) > 0 if and only if λ is an eigenvalue of A. In the finite-dimensional case, ν(v) ≤ the algebraic multiplicity of v.

Plane (flat) normal form[edit]

The Jordan form is used to find a normal form of matrices up to conjugacy such that normal matrices make up an algebraic variety of a low fixed degree in the ambient matrix space.

Sets of representatives of matrix conjugacy classes for Jordan normal form or rational canonical forms in general do not constitute linear or

affine subspaces in the ambient matrix spaces.

Vladimir Arnold posed[16] a problem:

Find a canonical form of matrices over a field for which the set of representatives of matrix conjugacy classes is a union of affine linear subspaces (flats). In other words, map the set of matrix conjugacy classes injectively back into the initial set of matrices so that the image of this embedding—the set of all normal matrices, has the lowest possible degree—it is a union of shifted linear subspaces.

It was solved for algebraically closed fields by Peteris Daugulis.[17]

The construction of a uniquely defined plane normal form of a matrix starts by considering its Jordan normal form.

Matrix functions[edit]

Iteration of the Jordan chain motivates various extensions to more abstract settings. For finite matrices, one gets matrix functions; this can be extended to compact operators and the holomorphic functional calculus, as described further below.

The Jordan normal form is the most convenient for computation of the matrix functions (though it may be not the best choice for computer computations). Let f(z) be an analytical function of a complex argument. Applying the function on a n×n Jordan block J with eigenvalue λ results in an upper triangular matrix:

so that the elements of the k-th superdiagonal of the resulting matrix are

The following example shows the application to the power function f(z) = zn:

where the binomial coefficients are defined as

of the coefficients. For negative n the identity

Compact operators[edit]

A result analogous to the Jordan normal form holds for compact operators on a Banach space. One restricts to compact operators because every point x in the spectrum of a compact operator T is an eigenvalue; The only exception is when x is the limit point of the spectrum. This is not true for bounded operators in general. To give some idea of this generalization, we first reformulate the Jordan decomposition in the language of functional analysis.

Holomorphic functional calculus[edit]

Let X be a Banach space, L(X) be the bounded operators on X, and σ(T) denote the spectrum of T ∈ L(X). The holomorphic functional calculus is defined as follows:

Fix a bounded operator T. Consider the family Hol(T) of complex functions that is holomorphic on some open set G containing σ(T). Let Γ = {γi} be a finite collection of Jordan curves such that σ(T) lies in the inside of Γ, we define f(T) by

The open set G could vary with f and need not be connected. The integral is defined as the limit of the Riemann sums, as in the scalar case. Although the integral makes sense for continuous f, we restrict to holomorphic functions to apply the machinery from classical function theory (for example, the Cauchy integral formula). The assumption that σ(T) lie in the inside of Γ ensures f(T) is well defined; it does not depend on the choice of Γ. The functional calculus is the mapping Φ from Hol(T) to L(X) given by

We will require the following properties of this functional calculus:

- Φ extends the polynomial functional calculus.

- The spectral mapping theorem holds: σ(f(T)) = f(σ(T)).

- Φ is an algebra homomorphism.

The finite-dimensional case[edit]

In the finite-dimensional case, σ(T) = {λi} is a finite discrete set in the complex plane. Let ei be the function that is 1 in some open neighborhood of λi and 0 elsewhere. By property 3 of the functional calculus, the operator

is a projection. Moreover, let νi be the index of λi and

The spectral mapping theorem tells us

has spectrum {0}. By property 1, f(T) can be directly computed in the Jordan form, and by inspection, we see that the operator f(T)ei(T) is the zero matrix.

By property 3, f(T) ei(T) = ei(T) f(T). So ei(T) is precisely the projection onto the subspace

The relation

implies

where the index i runs through the distinct eigenvalues of T. This is the invariant subspace decomposition

given in a previous section. Each ei(T) is the projection onto the subspace spanned by the Jordan chains corresponding to λi and along the subspaces spanned by the Jordan chains corresponding to vj for j ≠ i. In other words, ei(T) = P(λi;T). This explicit identification of the operators ei(T) in turn gives an explicit form of holomorphic functional calculus for matrices:

- For all f ∈ Hol(T),

Notice that the expression of f(T) is a finite sum because, on each neighborhood of vi, we have chosen the Taylor series expansion of f centered at vi.

Poles of an operator[edit]

Let T be a bounded operator λ be an isolated point of σ(T). (As stated above, when T is compact, every point in its spectrum is an isolated point, except possibly the limit point 0.)

The point λ is called a pole of operator T with order ν if the resolvent function RT defined by

has a pole of order ν at λ.

We will show that, in the finite-dimensional case, the order of an eigenvalue coincides with its index. The result also holds for compact operators.

Consider the annular region A centered at the eigenvalue λ with sufficiently small radius ε such that the intersection of the open disc Bε(λ) and σ(T) is {λ}. The resolvent function RT is holomorphic on A.

Extending a result from classical function theory, RT has a Laurent series representation on A:

where

and C is a small circle centered at λ.

By the previous discussion on the functional calculus,

where

is 1 on

and 0 elsewhere.

But we have shown that the smallest positive integer m such that

and

is precisely the index of λ, ν(λ). In other words, the function RT has a pole of order ν(λ) at λ.

Numerical analysis[edit]

If the matrix A has multiple eigenvalues, or is close to a matrix with multiple eigenvalues, then its Jordan normal form is very sensitive to perturbations. Consider for instance the matrix

If ε = 0, then the Jordan normal form is simply

However, for ε ≠ 0, the Jordan normal form is

This ill conditioning makes it very hard to develop a robust numerical algorithm for the Jordan normal form, as the result depends critically on whether two eigenvalues are deemed to be equal. For this reason, the Jordan normal form is usually avoided in numerical analysis; the stable Schur decomposition[18] or pseudospectra[19] are better alternatives.

See also[edit]

- Canonical basis

- Canonical form

- Frobenius normal form

- Jordan matrix

- Jordan–Chevalley decomposition

- Matrix decomposition

- Modal matrix

- Weyr canonical form

Notes[edit]

- ^

Shilov defines the term Jordan canonical form and in a footnote says that Jordan normal form is synonymous.

These terms are sometimes shortened to Jordan form. (Shilov)

The term Classical canonical form is also sometimes used in the sense of this article. (James & James, 1976) - ^ a b Holt & Rumynin (2009, p. 9)

- ^ a b Beauregard & Fraleigh (1973, pp. 310–316)

- ^ a b Golub & Van Loan (1996, p. 355)

- ^ a b Nering (1970, pp. 118–127)

- ^ Beauregard & Fraleigh (1973, pp. 270–274)

- ^ Golub & Van Loan (1996, p. 353)

- ^ Nering (1970, pp. 113–118)

- ^ Brechenmacher, “Histoire du théorème de Jordan de la décomposition matricielle (1870-1930). Formes de représentation et méthodes de décomposition”, Thesis, 2007

- ^ Cullen (1966, p. 114)

- ^ Franklin (1968, p. 122)

- ^ a b Horn & Johnson (1985, §3.2.1)

- ^ Bronson (1970, pp. 189, 194)

- ^ Roe Goodman and Nolan R. Wallach, Representations and Invariants of Classical Groups, Cambridge UP 1998, Appendix B.1.

- ^ Horn & Johnson (1985, Theorem 3.4.5)

- ^ Arnold, Vladimir I, ed. (2004). Arnold’s problems. Springer-Verlag Berlin Heidelberg. p. 127. doi:10.1007/b138219. ISBN 978-3-540-20748-1.

- ^ Peteris Daugulis (2012). “A parametrization of matrix conjugacy orbit sets as unions of affine planes”. Linear Algebra and Its Applications. 436 (3): 709–721. arXiv:1110.0907. doi:10.1016/j.laa.2011.07.032. S2CID 119649768.

- ^ See Golub & Van Loan (2014), §7.6.5; or Golub & Wilkinson (1976) for details.

- ^ See Golub & Van Loan (2014), §7.9

References[edit]

- Beauregard, Raymond A.; Fraleigh, John B. (1973), A First Course In Linear Algebra: with Optional Introduction to Groups, Rings, and Fields, Boston: Houghton Mifflin Co., ISBN 0-395-14017-X

- Bronson, Richard (1970), Matrix Methods: An Introduction, New York: Academic Press, LCCN 70097490

- Cullen, Charles G. (1966), Matrices and Linear Transformations, Reading: Addison-Wesley, LCCN 66021267

- Dunford, N.; Schwartz, J. T. (1958), Linear Operators, Part I: General Theory, Interscience

- Finkbeiner II, Daniel T. (1978), Introduction to Matrices and Linear Transformations (3rd ed.), W. H. Freeman and Company

- Franklin, Joel N. (1968), Matrix Theory, Englewood Cliffs: Prentice-Hall, LCCN 68016345

- Golub, Gene H.; Van Loan, Charles F. (1996), Matrix Computations (3rd ed.), Baltimore: Johns Hopkins University Press, ISBN 0-8018-5414-8

- Golub, Gene H.; Wilkinson, J. H. (1976). “Ill-conditioned eigensystems and the computation of the Jordan normal form”. SIAM Review. 18 (4): 578–619. doi:10.1137/1018113.

- Holt, Derek; Rumynin, Dmitriy (2009), Algebra I – Advanced Linear Algebra (MA251) Lecture Notes (PDF)

- Horn, Roger A.; Johnson, Charles R. (1985), Matrix Analysis, Cambridge University Press, ISBN 978-0-521-38632-6

- James, Glenn; James, Robert C. (1976), Mathematics Dictionary (2nd ed.), Van Nostrand Reinhold

- MacLane, Saunders; Birkhoff, Garrett (1967), Algebra, Macmillan Publishers

- Michel, Anthony N.; Herget, Charles J. (1993), Applied Algebra and Functional Analysis, Dover Publications

- Nering, Evar D. (1970), Linear Algebra and Matrix Theory (2nd ed.), New York: Wiley, LCCN 76091646

- Shafarevich, I. R.; Remizov, A. O. (2012), Linear Algebra and Geometry, Springer, ISBN 978-3-642-30993-9

- Shilov, Georgi E. (1977), Linear Algebra, Dover Publications

- Jordan Canonical Form article at mathworld.wolfram.com

Жорданова матрица — квадратная блочно-диагональная матрица над полем

Каждый блок

Согласно теореме о жордановой нормальной форме, для произвольной квадратной матрицы

является жордановой матрицей. При этом

И наоборот, в силу эквивалентного соотношения

матрица

Жорданова форма матрицы определена не однозначно, а с точностью до порядка жордановых клеток. Точнее, две жордановы матрицы подобны над

случае, когда они составлены из одних и тех же жордановых клеток и отличаются друг от друга лишь расположением этих клеток на главной диагонали.

Свойства[править | править код]

- где

— единичная матрица того же порядка что и

, символ

обозначает ранг матрицы, а

, по определению, равен порядку

. Вышеприведённая формула следует из равенства

-

История[править | править код]

Одним из первых такую форму матрицы рассматривал Жордан.

Вариации и обобщения[править | править код]

- Помимо жордановой нормальной формы, рассматривают ряд других типов нормальных форм матрицы (например, фробениусова нормальная форма). К их рассмотрению прибегают, в частности, когда основное поле не содержит всех корней характеристического многочлена данной матрицы.

См. также[править | править код]

- Каноническая форма Вейра

Примечания[править | править код]

- ↑ Фаддеев Д. К. Лекции по алгебре. М.: Наука, 1984.

- ↑ Хорн Р. (Roger A. Horn), Джонсон Ч. (Charles C. Johnson) Матричный анализ. — М.: Мир, 1989 (ISBN 5-03-001042-4).

Литература[править | править код]

- Халмош П. Конечномерные векторные пространства. — М.: Физматгиз, 1963. — 264 с.

- Гантмахер Ф. Р. Теория матриц. — М.: Наука, 1966. — 576 с.

- Хорн Р. (Roger A. Horn), Джонсон Ч. (Charles C. Johnson). Матричный анализ. — М.: Мир, 1989, 655 с., ил. (ISBN 5-03-001042-4).

- Гельфанд И. М. Лекции по линейной алгебре М.: Наука, 1971.

- Фаддеев Д. К. Лекции по алгебре. М.: Наука, 1984.

- Шафаревич И. Р., Ремизов А. О. Линейная алгебра и геометрия, — Физматлит, Москва, 2009.

- Ким, Г. Д. Линейная алгебра и аналитическая геометрия, Москва, 2005.

- В. В. Колыбасова, Н. Ч. Крутицкая, А. В. Овчинников. Жорданова форма матрицы оператора

- P. Aluffi. Algebra: Chapter 0 (Graduate Studies in Mathematics). — American Mathematical Society, 2009 — ISBN 0-8218-4781-3.

Приведение матрицы к жордановой форме

Задача приведения матрицы к жордановой форме формулируется следующим образом. Требуется привести квадратную матрицу к жордановой форме

при помощи преобразования подобия:

, т.е.

найти жорданову форму квадратной матрицы

{первый этап);

найти преобразующую матрицу (второй этап), для которой

(7.39)

В некоторых прикладных и теоретических задачах достаточно определить только жорданову форму матрицы, т.е. ограничиться первым этапом. Однако чаще кроме жордановой формы матрицы

требуется также найти и преобразующую матрицу

, т.е. выполнить оба этапа.

Нахождение жордановой формы матрицы

Для нахождения жордановой формы квадратной матрицы

нужно выполнить следующие действия (см. лекцию жордановой форме).

1. Составить характеристическую матрицу .

2. Найти ее инвариантные множители (7.33) одним из способов, рассмотренных в предыдущей лекции.

3. По инвариантным множителям (7.33) составить таблицу (7.34) элементарных делителей.

4. По элементарным делителям составить жорданову форму .

Нахождение преобразующей матрицы

Рассмотрим два способа нахождения преобразующей матрицы.

Первый способ. Если жорданова форма матрицы

известна, то для нахождения преобразующей матрицы

нужно выполнить следующие действия.

1. Составить матричное уравнение относительно неизвестной матрицы

, которое равносильно однородной системе

линейных уравнении с

неизвестными элементами

матрицы

.

2. Найти такое частное решение этой системы уравнений, для которого .

Второй способ. Для нахождения преобразующей матрицы можно использовать следствие теоремы 7.7.

1. Составить блочную λ-матрицу , приписав к характеристической матрице

единичную матрицу того же порядка. При помощи элементарных преобразований, выполняемых над строками и столбцами блочной матрицы, привести ее левый блок к нормальному диагональному виду (7.9). При этом блочная матрица преобразуется к виду

, где

— матрица нормального диагонального вида, эквивалентная матрице

, a

— некоторая элементарная λ-матрица.

2. Составить блочную λ-матрицу , приписав к характеристической матрице

единичную матрицу того же порядка. При помощи элементарных преобразований, выполняемых над строками и столбцами блочной матрицы, привести ее левый блок к нормальному диагональному виду (7.9). При этом блочная матрица преобразуется к виду

, где

-такая же матрица, что и в пункте 1, а

— некоторая элементарная λ-матрица.

3. Найти λ-матрицу .

4. Вычислить левое значение при замене переменной

матрицей

.

5. Найти преобразующую матрицу , обращая матрицу

.

Действительно, при помощи элементарных преобразований характеристические матрицы и

приводятся к одному и тому же нормальному диагональному виду

Отсюда , то есть

где

Согласно следствию теоремы j? 7.6, преобразующая числовая матрица , т.е.

— это матрица, /Обратная к левому значению λ-матрицы

при подстановке вместо

матрицы

.

Замечания 7.7.

1. Несмотря на простоту, первый способ мало пригоден из-за большого Объема вычислений. Количество решаемых уравнений .

2.Второй способ позволяет полностью решить задачу приведения матрицы к жордановой форме. Выполняя пункт 1, находим нормальный диагональный вид характеристической матрицы

, и, как следствие, ее инвариантные множители

. Тогда выполняя пункты 3, 4 алгоритма нахождения жордановой формы, получим жорданову форму

матрицы

. Далее выполняем пункты 2, 3 второго способа и находим преобразующую матрицу.

3. В пунктах 1,2 второго способа λ-матрицы, стоящие в левых блоках матриц и

, приводятся к нормальному диагональному виду при помощи элементарных преобразований над строками и над столбцами. При этом правые блоки этих матриц “учитывают” только преобразования строк, в отличие от алгоритма, описанного в пункте 5 замечаний 7.4.

4. Преобразующая матрица в (7.39) определяется неоднозначно. В самом деле, если

— преобразующая матрица, а

— невырожденная матрица, перестановочная с

, то матрица

будет также преобразующей. Действительно, матрица

— обратимая и

Первый способ нахождения преобразующей матрицы, вообще говоря, позволяет найти все такие матрицы, перебирая в пункте 2 подходящие частные решения однородной системы. Второй способ позволяет найти одну преобразующую матрицу из этого множества. Как правило, на практике достаточно найти хотя бы одну преобразующую матрицу.

5. Задачу приведения матрицы к диагональному виду можно считать частным случаем задачи приведения матрицы к жордановой форме. Если квадратная матрица n-го порядка имеет

линейно независимых собственных векторов, то, как это следует из теоремы 7.5, ее жорданова форма

является диагональной матрицей (с собственными значениями на главной диагонали), а преобразующая матрица

может быть составлена из

линейно независимых собственных векторов матрицы

.

Пример 7.15. Привести к жордановой форме следующие матрицы:

Решение для матрицы A

Первый этап — нахождение жордановой формы матрицы .

1. Составляем характеристическую матрицу .

2. Инвариантные множители будем искать по формуле (7.11). Записываем миноры 1-го порядка:

. Находим наибольший общий делитель этих многочленов:

. Минор второго порядка равен определителю характеристической матрицы

. Следовательно,

. Таким образом, по формуле (7.11) получаем

3. По инвариантным множителям составляем таблицу (7.34) элемен тарных делителей. Так как собственное значение матрицы единственное , то таблица (7.34) состоит из одной строки (и одного столбца):

.

4. Единственному элементарному делителю соответствует од на жорданова клетка 2-го порядка, образующая жорданову форму матрицы

.

Второй этап — нахождение преобразующей матрицы. Воспользуемся первым способом.

1. Составляем матричное уравнение . Перемножая матрицы, получаем однородную систему уравнений относительно элементов искомой матрицы

2. Решаем эту систему. Расширенную матрицу системы приводим к ступенчатому, а затем к упрощенному виду:

где . Находим фундаментальную матрицу

и общее решение:

где

— произвольные постоянные.

Следовательно, любая преобразующая матрица имеет вид

где — произвольные постоянные, но

, так как матрица

невырожденная:

Например, при получаем

.

Используем второй способ нахождения преобразующей матрицы.

Составляем блочную матрицу: . При помощи элементарных преобразований, выполняемых над строками и над столбцами этой блочной матрицы, приводим левый блок к нормальному диагональному виду. Меняем местами строки и умножаем первую строку на (-l). Выбрав ведущий элемент, равный единице, делаем равными нулю остальные элементы в первом столбце и в первой строке левого блока:

Следовательно,

2. Составляем блочную матрицу и приводим левый блок этой матрицы к нормальному диагональному виду

Следовательно, .

3. Обращаем матрицу . Находим λ-матрицу, которая оказалась не зависящей от

4. Так как λ-матрица оказалась числовой, то

.

5. Находим преобразующую матрицу . Такой же результат, как частный случай, был получен первым способом.

Решение для матрицы B

Будем искать преобразующую матрицу вторым способом. При этом попутно найдем и жорданову форму

матрицы

(см. пункт 2 замечаний 7.7).

1. Составляем блочную матрицу:

Выполняя элементарные преобразования над строками и над столбцами этой блочной матрицы, приводим левый блок к нормальному диагональному виду. Меняем местами первую и третью строки и умножаем первую строку на (-1). Выбрав ведущий элемент, равный единице, делаем равными нулю остальные элементы в первом столбце и в первой строке левого блока:

Меняем местами второй и третий столбцы и умножаем вторую строку на (-1). Выбрав ведущий элемент, равный единице, делаем равными нулю остальные элементы во втором столбце и во второй строке левого блока:

Умножая третий столбец на (-1), получаем нормальную диагональную форму характеристической матрицы и матрицу

Находим жорданову форму матрицы

(см. пункт 2 замечаний 7.7). По инвариантным множителям

составляем таблицу элементарных делителей. Таблица состоит из одного делителя

, которому соответствует одна жорданова клетка 3-го порядка (для собственного значения

):

2. Составляем блочную матрицу

Приводим левый блок этой матрицы к нормальному диагональному виду. Меняем местами столбцы левого блока

Выбираем ведущий элемент, равный единице, в левом верхнем углу. Делаем в левом блоке равными нулю все элементы ведущей (первой) строки и ведущего (первого) столбца, за исключением ведущего элемента:

Выбираем ведущий элемент, равный единице, на пересечении второго столбца и второй строки. К третьей строке прибавляем вторую, умноженную на , а затем к третьему столбцу прибавляем второй, умноженный на

, и, наконец, умножаем третий столбец на (-1). В результате получим

Следовательно,

3. Обращаем матрицу .

Находим λ-матрицу

Представляем λ-матрицу в виде многочлена с матричными коэффициентами, ставя переменную

перед коэффициентами:

Подставляем вместо аргумента матрицу

5. Обращая полученную матрицу, находим преобразующую

Сделаем проверку, сравнивая левую и правую части равенства

Следовательно, равенство верное.

Решение для матрицы C

Применяем второй способ нахождения преобразующей матрицы, попутно определяя жорданову форму матрицы

(см. пункт 2 замечаний 7.7).

1. Составляем блочную матрицу:

Элементарными преобразованиями приводим левый ее блок к нормальному диагональному виду (см. пример 7.12). Меняем местами первый и третий столбцы, выбираем первую строку и первый столбец в качестве ведущих и делаем равными нулю все элементы выбранной строки (в пределах левого блока) и выбранного столбца, за исключением ведущего элемента:

Умножаем второй столбец на (-l), выбираем ведущими вторую строку и второй столбец, делаем равными нулю соответствующие элементы этой строки и столбца:

Умножим третий столбец на (-1), чтобы старший коэффициент многочлена был равен единице. Итак, получили матрицу и нормальный диагональный вид характеристической матрицы

. Составляем таблицу (7.33) инвариантных множителей:

Составляем таблицу (7.34) элементарных делителей: . Каждому из трех делителей соответствует жорданова клетка 1-го порядка (для собственных значений

), т.е. жорданова форма матрицы

— диагональная матрица:

2. Составляем блочную матрицу

Левый блок этой матрицы имеет диагональный вид, который не является нормальным, так как не делится на

. Прибавляем к первому столбцу третий, к третьей строке прибавляем первую, умноженную на (-1), меняем местами первую и третью строки:

Разделим первый столбец на 3, возьмем ведущий элемент, стоящий в левом верхнем углу, и сделаем равными нулю соответствующие элементы:

Умножив второй столбец на (-1), а третью строку на (-3), получим в левом блоке нормальный диагональный вид , а в правом блоке матрицу

3. Обращаем матрицу

Находим λ-матрицу S(lambda)=S_J^{-1}(lambda)cdot S_C(lambda):

4. Представляем λ-матрицу в виде многочлена с матричными коэффициентами, помещая переменную

перед коэффициентами:

Подставляем вместо аргумента матрицу

5. Обращая полученную матрицу, находим преобразующую

Сделаем проверку, вычислив матрицу

Заметим, что в примере 7.10 эта матрица была приведена к диагональному виду. Поэтому, согласно пункта 5 замечаний 7.7, ее жорданова форма является диагональной, а преобразующая матрица составляется из линейно независимых собственных векторов:

Эта матрица отличается от найденной вторым способом. Но она тоже является преобразующей (проверка равенства

была фактически выполнена в примере 7.10).

Решение для матрицы D

Применяем второй способ нахождения преобразующей матрицы , попутно определяя жорданову форму

матрицы

(см. пункт 2 замечаний 7.7).

1. Составляем блочную матрицу:

Элементарными преобразованиями приводим левый ее блок к нормальному диагональному виду. Взяв элемент, равный единице, в качестве ведущего, делаем равными нулю все элементы ведущего (первого) столбца и ведущей (третьей) строки (в пределах левого блока):

К первой строке прибавляем вторую, умноженную на , затем к третьему столбцу прибавляем второй, умноженный на

Ко второму столбцу прибавляем третий, умноженный на , а затем к первой строке прибавляем вторую, умноженную на

Меняем местами второй и третий столбцы, затем умножим первую строку на 9, второй столбец разделим на (-9):

Меняем местами первую и третью строки, после чего получим в левом блоке нормальный диагональный вид характеристической матрицы , a в правом блоке – матрицу

Составляем таблицу (7.33) инвариантных множителей:

Составляем таблицу (7.34) элементарных делителей:

Делителю соответствует жорданова клетка 2-го порядка, а делителю

– жорданова клетка 1-го порядка, т.е. жорданова форма матрицы

имеет вид:

2. Составляем блочную матрицу:

Приводим левый блок этой матрицы к нормальному диагональному виду. Выбираем единицу в качестве ведущего элемента и делаем равными нулю соответствующие элементы левого блока, а затем меняем местами первый и второй столбцы:

Полученный диагональный вид не является нормальным, так как не делится на

. Поэтому прибавляем ко второму столбцу третий, умноженный на

, а затем ко второй строке прибавляем третью, умноженную на

Разделив второй столбец на , получим элемент, равный единице, который принимаем за ведущий, и делаем равными нулю соответствующие элементы второй строки и второго столбца:

Умножив третью строку на , получим в левом блоке нормальный диагональный вид характеристической матрицы

, а в правом блоке – матрицу

3. Обращаем матрицу

Находим λ-матрицу

4. Представляем λ-матрицу в виде многочлена с матричными коэффициентами, помещая переменную

перед коэффициентами:

Подставляем вместо аргумента матрицу

. Учитывая, что

получаем

5. Обращая полученную матрицу, находим преобразующую

Сделаем проверку, вычислив матрицу

Получили заданную матрицу .

Математический форум (помощь с решением задач, обсуждение вопросов по математике).

Если заметили ошибку, опечатку или есть предложения, напишите в комментариях.

Содержание

Жорданова нормальная форма

Для понимания материалов настоящего раздела рекомендуется ознакомиться с разделом

ЛИНЕЙНЫЙ ОПЕРАТОР. Материал настоящего раздела традиционно считается сложным для понимания.

Задача. Найти базис пространства $ mathbb V_{} $, в котором матрица линейного оператора

$ mathcal A_{} $ имеет наиболее простой вид.

В дальнейшем под выражением оператор понимается исключительно линейный оператор (и линейное пространство $ mathbb V_{} $ предполагается конечномерным!).

Жорданова нормальная форма над полем комплексных чисел

В настоящем пункте пространство $ mathbb V_{} $ размерности $ dim mathbb V_{} = n $ предполагается комплексным.

Общая схема

В пункте ДИАГОНАЛИЗУЕМОСТЬ МАТРИЦЫ ОПЕРАТОРА было установлено, что если возможно найти базис пространства $ mathbb V_{} $,

состоящий из собственных векторов оператора, то в этом базисе матрица оператора будет диагональной. В частности, существование такого базиса всегда гарантировано в случае, когда характеристический полином оператора $ mathcal A_{} $ имеет только простые корни: в этом случае система из собственных векторов оператора, принадлежащих различным собственным числам, гарантировано линейно независима. Случай наличия кратных корней

$$

f(lambda)= det (mathcal A – lambda mathcal E) equiv (-1)^n(lambda – lambda_1)^{{mathfrak m}_1} times

dots times (lambda – lambda_{{mathfrak r}})^{ {mathfrak m}_{{mathfrak r}}} quad ;

$$

$$

{mathfrak m}_1+dots+{mathfrak m}_{{mathfrak r}}=n, lambda_k ne

lambda_{ell} npu k ne ell,

$$

при хотя бы одном $ {mathfrak m}_j>1 $ оказывается «пограничным»: оператор может оказаться как диагонализуемым, так и недиагонализуемым.

Стратегия действий: пространство $ mathbb V_{} $ удается разбить в прямую сумму подпространств

$$

mathbb V_{} =mathbb V_1 oplus dots oplus mathbb V_{mathfrak r} , quad dim mathbb V_j={mathfrak m}_j

$$

инвариантных относительно $ mathcal A_{} $: $ mathcal A(mathbb V_j) subset

mathbb V_j $. При этом $ mathbb V_j $ обязательно будет включать собственные векторы,

принадлежащие $ lambda_{j} $, но, помимо них — в случае когда алгебраическая кратность собственного числа превосходит его геометрическую кратность:

$$ {mathfrak m}_j > ell_j = operatorname{dfc} (mathcal A – lambda_j {mathcal E}) $$

— и другие: так называемые, корневые. На основании теоремы

из

☞

ПУНКТА в базисе $ mathbb V_{} $, составленном объединением базисов $ mathbb V_j $, матрица оператора будет иметь блочно-диагональный вид

$$

left(

begin{array}{cccc}

mathbf A_1 & mathbb O & dots & mathbb O \

mathbb O & mathbf A_2 & dots & mathbb O \

& & ddots & \

mathbb O & mathbb O & dots & mathbf A_{{mathfrak r}}

end{array}

right) quad , quad mbox{ здесь } mathbf A_j – mbox{ матрица порядка }

{mathfrak m}_jtimes {mathfrak m}_j .

$$

Каждый из базисов составляющих $ mathbb V_{} $ подпространств $ mathbb V_j $ удается подобрать

так, чтобы матрица $ mathbf A_j $ имела снова блочно-диагональный вид

$$

mathbf A_j=

left(

begin{array}{cccc}

{mathbf A}_{j1} & mathbb O & dots & mathbb O \

mathbb O & {mathbf A}_{j2} & dots & mathbb O \

& & ddots & \

mathbb O & mathbb O & dots & {mathbf A}_{j ell_j}

end{array}

right)

$$

где на диагонали стоят матрицы вида

$$

{mathfrak J}_k (lambda_j) =

left(

begin{array}{cccccc}

lambda_j & 0 & 0 & dots & 0 & 0 \

1 & lambda_j & 0 & dots & 0 & 0 \

0 & 1 & lambda_j & dots & 0 & 0 \

vdots & & ddots & ddots& & vdots \

0 & 0 & 0 & dots & 1 & lambda_j

end{array}

right)_{k times k}

$$

называемые (нижними) клетками Жордана1).

Указанный вид матрицы оператора $ mathcal A $ называется канонической формой Жордана2) или жордановой нормальной формой (ЖНФ), а соответствующий базис пространства — каноническим базисом. Жорданову нормальную форму оператора $ mathcal A $ будем обозначать $ mathbf A_{_{mathfrak J}} $.

§

Частным видом ЖНФ является диагональный:

$$ mathbf A_{_{mathfrak J}} =

A_{diag}=

left(

begin{array}{cccc}

lambda_1 & 0 & dots & 0 \

0 & lambda_2 & dots & 0 \

& & ddots & \

0 & 0 & dots & lambda_n

end{array}

right) ;

$$

в этом случае все клетки Жордана — первого порядка.

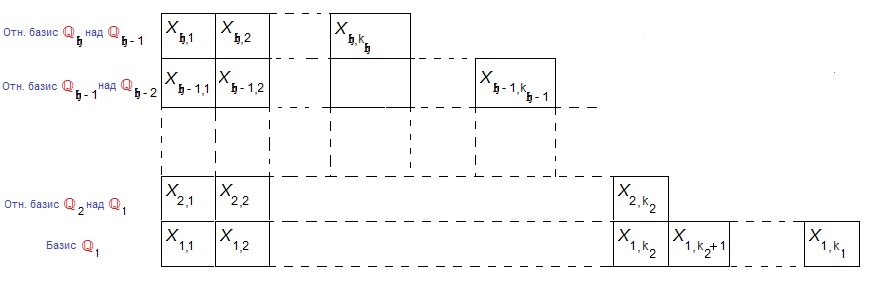

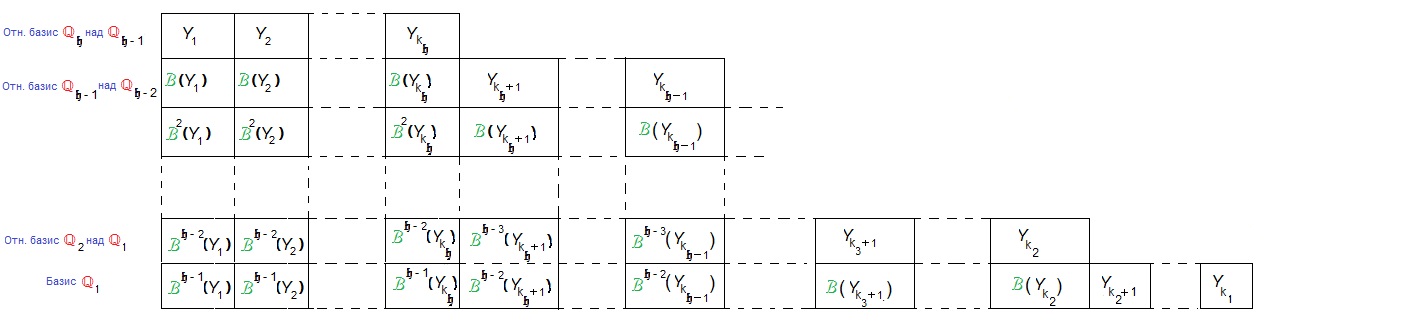

На языке матричного формализма задача построения ЖНФ и канонического базиса может быть переформулирована следующим образом: пусть имеется некоторый исходный базис $ {X_1,dots,X_n} $ пространства $ mathbb V_{} $, в котором матрица оператора равна $ mathbf A_{} $. Требуется найти

матрицу перехода $ C_{} $ от этого базиса к некоторому новому, обеспечивающую выполнение равенства

$$ C^{-1} mathbf A C = mathbf A_{_{mathfrak J}} . $$

Про матрицу $ mathbf A_{_{mathfrak J}} $ заранее известна лишь та информация, что все ее элементы — нулевые, за исключением разве лишь элементов двух ее диагоналей — главной и следующей за ней вниз.

Очень часто в приложениях ставится задача нахождения формы Жордана $ mathbf A_{_{mathfrak J}} $ и матрицы $ C_{} $, связанных с заданной матрицей $ mathbf A_{} $ последним равенством; при этом напрямую не ассоциируют исходную матрицу $ mathbf A_{} $ с каким-либо оператором — и вообще с каким-то пространством. С формальной точки зрения, нужно было бы формулировать задачу о каноническом базисе оператора $ X mapsto mathbf A cdot X $ при $ Xin mathbb C^n $ и исходном базисе пространства, состоящем из векторов

$$

{{mathfrak e}_j = big[underbrace{0,dots,0,1}_{j},0,dots,0big]^{top} }_{j=1}^n .

$$

Однако в примерах, рассмотренных ниже, я буду просто говорить на языке подобных матриц, ставя задачу

о приведении матрицы $ mathbf A_{} $ к ЖНФ.

Даже при формальном совпадении характеристических полиномов двух операторов $ mathcal A_1 $ и $ mathcal A_2 $ их жордановы нормальные формы могут быть различными. Однако для каждого оператора ЖНФ определяется единственным образом — с точностью до перестановки клеток Жордана на диагонали.

Аннулирующий полином

Пусть $ g(lambda),g_1(lambda),g_2(lambda) $ — произвольные полиномы над $ mathbb C_{} $.

Говорят, что операторный полином $ g(mathcal A) $ — аннулирующий для вектора $ Xin mathbb V_{} $ если $ g(mathcal A)(X)=mathbb O $.

Т

Теорема 1. Множество векторов $ X_{}in mathbb V $, аннулируемых $ g(mathcal A) $, образует линейное подпространство пространства $ mathbb V_{} $.

Доказательство. Действительно, это множество является ядром оператора $ g(mathcal A) $ и по теореме 1 из

☞

ПУНКТА, оно является линейным подпространством.

♦

Т

Теорема 2. Если полиномы $ g_1(lambda) $ и $ g_2(lambda) $ взаимно просты: $ operatorname{HOD} (g_1,g_2)=1 $, то подпространства векторов, аннулируемых $ g_1(mathcal A) $ и $ g_2(mathcal A) $, имеют тривиальное пересечение.

Доказательство. Если $ operatorname{HOD} (g_1,g_2)=1 $, то существуют полиномы $ { p_1(lambda),p_2(lambda)} subset mathbb C[lambda] $, обеспечивающие выполнение тождества Безу:

$$p_1(lambda)g_1(lambda)+p_2(lambda)g_2(lambda) equiv 1 . $$

Тогда при подстановке в это тождество оператора получим:

$$

p_1(mathcal A)g_1(mathcal A)+p_2(mathcal A)g_2(mathcal A) = mathcal E ,

$$

где $ mathcal E $ — тождественный оператор.

Если существует $ X in mathbb V_{} $ такой, что $ g_1(mathcal A)(X)=mathbb O $

и $ g_2(mathcal A)(X)=mathbb O $, то из последнего тождества следует, что

$$p_1(mathcal A)g_1(mathcal A)(X)+p_2(mathcal A)g_2(mathcal A)(X) = mathcal E(X) quad Longrightarrow

mathbb O=X . $$

♦

Т

Теорема 3. Если полиномы $ g_1(lambda) $ и $ g_2(lambda) $ взаимно просты и вектор $ Xne mathbb O $ аннулируется произведением

$ g_1(mathcal A)g_2(mathcal A) $, то этот вектор можно представить в виде суммы $ X=X_1+X_2 $,

где $ X_{j} $ аннулируется $ g_j(mathcal A) $.

Доказательство. Воспользуемся равенством из последней теоремы:

$$underbrace{p_1(mathcal A)g_1(mathcal A)(X)}_{= X_2}+

underbrace{p_2(mathcal A)g_2(mathcal A)(X)}_{= X_1} = mathcal E (X)=X .$$

Тогда $ g_2(mathcal A)(X_2)=p_1(mathcal A)g_1(mathcal A)g_2(mathcal A)(X)=p_1(mathcal A)(mathbb O)=mathbb O $, т.е.

$ X_2 $ аннулируется $ g_2(mathcal A) $. Аналогично доказывается, что

$ g_1(mathcal A)(X_1)=mathbb O $.

♦

=>

Если вектор $ X_{} $ аннулируется произведением

$$ g(mathcal A)=g_1(mathcal A)times dots times g_{{mathfrak r}}(mathcal A) , $$

где полиномы $ g_1(lambda),dots, g_{{mathfrak r}}(lambda) $ попарно взаимно просты, то его можно представить

в виде суммы

$$ X=X_1+dots+X_{{mathfrak r}} mbox{ где } X_j mbox{ аннулируется } g_j(mathcal A) . $$

Полином $ g(lambda) notequiv 0 $ называется аннулирующим полиномом оператора $ mathcal A_{} $, если $ g(mathcal A)= mathcal O $.

П

Пример. В пространстве $ mathbb P_3 $ полиномов с вещественными коэффициентами степеней $ le 3 $ оператор $ mathcal A_{} $ действует по правилу:

$$ mathcal A (F(x)) = F(x) (x^2-2) pmod{x^4-x^3-x^2+x} , $$

т.е. полином $ F_{}(x) $ отображается в остаток от деления произведения $ F(x) (x^2-2) $ на $ x^4-x^3-x^2+x $. Найти аннулирующий полином оператора.

Решение. Поскольку про аннулирующий полином $ g(lambda) $ нам заранее

не известна даже его степень, будем искать подбором как его степени (идя по возрастанию), так и его коэффициентов. Пусть

$$ g(lambda) = A_0 + A_1 lambda+ A_2 lambda^2+ dots . $$

Условие $ g(mathcal A)= mathcal O $ перепишем в виде

$$ A_0 mathcal E + A_1 mathcal A+ A_2 mathcal A^2+ dots = mathcal O . $$

В примере

☞

ПУНКТА степень оператора $ mathcal A^K $ вычислялась формулой

$$ mathcal A^k(F(x))=(x^2-2)^K F(x) pmod{x^4-x^3-x^2+x} . $$

Исходя из этого, аннулирующий полином должен обеспечивать выполнение условия

$$ ( A_0 + A_1 (x^2-2)+ A_2 (x^2-2)^2+ dots) F(x) equiv 0 pmod{x^4-x^3-x^2+x} ; $$

причем это тождество должно быть выполнено для любого полинома $ F_{}(x) $. Отсюда следует, что полином $ ( A_0 + A_1 (x^2-2)+ A_2 (x^2-2)^2+ dots) $ должен делиться нацело на $ x^4-x^3-x^2+x $. Для удовлетворения этого требования делаем теперь гипотезу о степени этого полинома и пробуем подобрать коэффициенты. Предположим, что $ deg g le 1 $, но такой полином может делиться на полином степени $ 4_{} $ только при условии выполнения равенств $ A_0=0,A_1=0 $; что нас совершенно не интересует. Пусть $ deg g=2 $, тогда если полином $ A_0 + A_1 (x^2-2)+ A_2 (x^2-2)^2 $ делится на полином степени $ 4_{} $, то должен отличаться от делителя только постоянным множителем:

$$ A_0 + A_1 (x^2-2)+ A_2 (x^2-2)^2 equiv C (x^4-x^3-x^2+x) quad npu quad C in mathbb C . $$

Легко проверить, что это возможно только в тривиальном случае: $ A_0=0,A_1=0,A_2=0 $. Случай $ deg g=3 $ требует уже более сложных расчетов: произведем деление с остатком

$$ A_0 + A_1 (x^2-2)+ A_2 (x^2-2)^2+ A_3 (x^2-2)^3 equiv $$

$$ equiv (A_2-4,A_3),x^3+(A_1-3,A_2+7,A_3),x^2+ $$

$$

+(-A_2+4,A_3),x+A_0-2,A_1+4,A_2-8,A_3 pmod{x^4-x^3-x^2+x} . $$

Остаток будет тождественно равен нулю тогда и только тогда, когда

$$ A_2=4,A_3, A_1=5, A_3, A_0=2, A_3 . $$

Эти условия — с точностью, до постоянного сомножителя — определяют аннулирующий полином .

Ответ. Аннулирующим полиномом минимально возможной степени является $ lambda^3+4, lambda^2+ 5, lambda+2 $.

Аннулирующий полином оператора $ mathcal A_{} $ минимально возможной степени называется минимальным аннулирующим полиномом.

Существование хотя бы одного аннулирующего полинома оператора гарантируется теоремой Гамильтона-Кэли:

если $ f(lambda) $ — характеристический полином оператора $ mathcal A_{} $, то $ f(mathcal A)={mathcal O} $. Таким образом, можно утверждать, что для минимального аннулирующего полинома выполняется условие $ deg g le dim mathbb V $. Предыдущий пример показывает, что это неравенство может оказаться и строгим. Обратим внимание, что

для оператора из этого примера характеристический полином равен $ (lambda+2)(lambda+1)^3 $ и полученный аннулирующий полином является его делителем: он равен $ (lambda+2)(lambda+1)^2 $.

Т

Теорема 4. Аннулирующий полином $ g(lambda_{}) $ оператора $ mathcal A_{} $ имеет те же корни, что и характеристический полином этого оператора.

Доказательство от противного. Пусть $ lambda_{ast} in mathbb C $ — корень характеристического полинома оператора $ mathcal A_{} $, но $ g(lambda_{}) $ не имеет

$ lambda_{ast} $ корнем. Числу $ lambda_{ast} $ принадлежит корневой вектор $ mathfrak X_{ast} $ высоты $ 1_{} $ (собственный вектор) оператора $ mathcal A_{} $:

$ (mathcal A- lambda_{ast} mathcal E)(mathfrak X_{ast})=mathbb O $. С другой стороны, поскольку $ operatorname{HOD}( g(lambda_{}), lambda- lambda_{ast})=1 $, то, по теореме 2, вектор $ mathfrak X_{ast} $ не должен аннулироваться оператором $ g(mathcal A) $. Однако это противоречит предположению о том, что $ g(mathcal A) $ — аннулирующий полином оператора.

♦

Т

Теорема 5. Минимальный аннулирующий полином оператора является делителем его характеристического полинома. Два минимальных аннулирующих полинома оператора различаются, разве лишь, постоянным множителем.

Доказательство. Предположим противное: пусть минимальный аннулирующий полином $ g(lambda) $ не является делителем $ f(lambda) $. Тогда при делении $ f(lambda) $ на

$ g(lambda) $ возникает нетривиальный остаток:

$$ f(lambda)equiv g(lambda) q(lambda) + r(lambda) quad npu quad deg r < deg g . $$

Поскольку $ f(lambda) $ и $ g(lambda) $ — аннулирующие для $ mathcal A $, то и $ r(lambda)= f(lambda) – g(lambda) q(lambda) $ является аннулирующим.

Но это противоречит тому, что, по предположению, $ g(lambda) $ — минимальный аннулирующий полином.

Если $ tilde g(lambda) $ — еще один минимальный аннулирующий полином оператора, то обязательно $ deg tilde g = deg g $. Если предположить, что у полиномов $ g(lambda) $ и $ tilde g(lambda) $ имеются различные сомножители, то полином $ operatorname{HOD}(g(lambda), tilde g(lambda)) $ будет иметь степень меньшую $ deg tilde g = deg g $. Для

$ operatorname{HOD}(g(lambda), tilde g(lambda)) $ имеет место линейное представление:

$$ operatorname{HOD}(g(lambda), tilde g(lambda)) equiv p_1(lambda) g(lambda) + p_2(lambda) tilde g(lambda) npu quad {p_1(lambda),p_2(lambda) } subset mathbb C[lambda] . $$

Тогда $ operatorname{HOD}(g(lambda), tilde g(lambda)) $ является аннулирующим полиномом оператора. Но тогда $ g(lambda) $ и $ tilde g(lambda) $ не могут быть минимальными аннулирующими.

♦

Следствиями теорем 4 и 5 является следующий результат.

=>

Минимальный аннулирующий полином оператора $ mathcal A_{} $ совпадает (с точностью до постоянного сомножителя) с характеристическим полиномом этого оператора при условии отсутствия у этого полинома кратных корней. В общем случае, пусть разложение характеристического полинома оператора имеет вид

$$ f(lambda)= det (mathcal A – lambda mathcal E) equiv (-1)^n(lambda – lambda_1)^{{mathfrak m}_1} times

dots times (lambda – lambda_{{mathfrak r}})^{ {mathfrak m}_{{mathfrak r}}} quad ; quad

{mathfrak m}_1+dots+{mathfrak m}_{{mathfrak r}}=n, lambda_k ne

lambda_{ell} npu k ne ell.

$$

Минимальный аннулирующий полином имеет вид

$$ g(lambda)=(lambda-lambda_1)^{mathfrak n_1}times dots times (lambda-lambda_{mathfrak r})^{mathfrak n_{mathfrak r}} , $$

где показатели

$ {mathfrak n_j }_{j=1}^{mathfrak r} $ могут принимать значения из множеств $ {{1,dots,mathfrak m_j }}_{j=1}^{mathfrak r} $.

Конструктивное построение минимального аннулирующего полинома произвольного оператора довольно громоздко; структура его линейных множителей

напрямую связана со структурой Жордановой нормальной формы. В литературе излагается [2] метод построения ЖНФ на основе информации о минимальном аннулирующем полиноме,

но я в дальнейшем не использую эту конструкцию.

Теорема Гамильтона-Кэли эквивалентна равенству

$$ (mathcal A- lambda_1 mathcal E)^{{mathfrak m}_1} times

dots times (mathcal A – lambda_{{mathfrak r}}mathcal E)^{ {mathfrak m}_{{mathfrak r}}} = mathcal O .

$$

Из следствия к теореме $ 3 $ тогда вытекает, что произвольный вектор $ X_{} in mathbb V $

может быть представлен в виде суммы

$$X=X_1+dots+X_{{mathfrak r}} , qquad mbox{ где } X_j quad

mbox{ аннулируется } left(mathcal A – lambda_j mathcal E right)^{{mathfrak m}_j} .

$$

и такое представление единственно, т.е. $ mathbb V_{} $ раскладывается в прямую сумму

$$ mathbb V= mathbb V_1oplus dots oplus mathbb V_{{mathfrak r}} , qquad mbox{ где }

mathbb V_{j}

mbox{ аннулируется } left(mathcal A – lambda_j mathcal E right)^{{mathfrak m}_j } . $$

Т

Теорема 6. Линейное подпространство векторов, аннулируемых

$ left(mathcal A – lambda_j mathcal E right)^{{mathfrak m}_j} $, инвариантно относительно $ mathcal A_{} $.

Доказательство. Действительно, если

$$ left(mathcal A – lambda_j mathcal E right)^{{mathfrak m}_j}(X)=mathbb O , ,$$

то и

$$ left(mathcal A – lambda_j mathcal E right)^{{mathfrak m}_j}(mathcal A(X))=mathcal A(left(mathcal A – lambda_j mathcal E right)^{{mathfrak m}_j}(X))= mathbb O , .

$$

♦

=>

На основании теоремы

из

☞

ПУНКТА в базисе $ mathbb V_{} $, составленном объединением базисов $ mathbb V_j $, матрица оператора будет иметь блочно-диагональный вид

$$

left(

begin{array}{cccc}

mathbf A_1 & mathbb O & dots & mathbb O \

mathbb O & mathbf A_2 & dots & mathbb O \

& & ddots & \

mathbb O & mathbb O & dots & mathbf A_{{mathfrak r}}

end{array}

right) .

$$

Итак, мы следуем изложенной в начале раздела схеме; остается только подобрать хорошие базисы для самих подпространств $ mathbb V_j $.

Корневое подпространство

Задача. Построить такой базис подпространства $ mathbb V_j $, в котором соответствующий блок $ {mathbf A}_j $ матрицы оператора $ mathcal A_{} $ будет состоять из клеток Жордана.

Ненулевой вектор $ X_{}in mathbb V $ называется корневым вектором оператора $ mathcal A_{} $, принадлежащим собственному числу $ lambda_{j}^{} $ если он аннулируется оператором $ (mathcal A – lambda_{j} mathcal E)^k $

при некотором $ k_{}in mathbb N $:

$ (mathcal A – lambda_{j} mathcal E)^k(X)=mathbb O $. Наименьший из показателей $ k_{} $ с

таким свойством называется высотой корневого вектора $ X_{} $:

$$ . mbox{ Высота } (X) = h iff (mathcal A – lambda_{j} mathcal E)^h(X)=mathbb O,

(mathcal A – lambda_{j} mathcal E)^{h-1}(X)ne mathbb O .$$

П

Пример 1. Любой собственный вектор оператора $ mathcal A_{} $ будет его корневым

высоты $ 1 $.

Рассмотрим теперь пример, разобранный в

☞

ПУНКТЕ.

П

Пример 2. В пространстве $ mathbb P_3 $ полиномов с вещественными коэффициентами степеней $ le 3 $ оператор $ mathcal A_{} $ действует по правилу

$$ mathcal A (f(x)) = F(x) (x^2-2) pmod{x^4-x^3-x^2+x} , $$

т.е. полином $ F_{}(x) $ отображается в остаток от деления произведения $ F(x) (x^2-2) $ на $ x^4-x^3-x^2+x $. Найти корневые векторы этого оператора.

Решение. Оператор имеет два собственных числа $ lambda_1=-2 $ и $ lambda_2=-1 $, причем последнее — кратности $ 3_{} $. Корневыми векторами высоты $ 1_{} $ являются собственные векторы, принадлежащие этим собственным числам, т.е.

$$ { t(x+1)(x-1)^2 mid tne 0 } quad mbox{ и } quad { (t_1x+t_2)x(x-1) mid (t_1,t_2) ne (0,0) } $$

соответственно.

Далее, ищем корневые векторы высоты $ 2_{} $, принадлежащие собственному числу $ lambda_1=-2 $.

$$ (mathcal A +2 , mathcal E)^2 (F(x))=x^4 F(x) pmod{x^4-x^3-x^2+x} $$

и наша задача состоит в нахождении полинома $ F_{}(x) $, для которого последнее выражение равно тождественно нулевому полиному. Очевидно, что множество всех таких полиномов

$$ { t(x^3-x^2-x+1) mid tne 0 } $$

совпадает с уже полученным выше множеством собственных векторов (полиномов). Понятно также, что дальнейшее увеличение степени оператора $ (mathcal A +2 , mathcal E) $ иных полиномов не даст. Следовательно, рассматриваемому собственному числу принадлежат только корневые векторы (полиномы) высоты $ 1_{} $.

Для собственного числа $ lambda_1=-1 $ сценарий оказывается несколько менее тривиальным:

$$ (mathcal A +mathcal E)^2 (F(x))=(x^2-1)^2 F(x) pmod{x^4-x^3-x^2+x} . $$

Полином $ (x^2-1)^2 F(x) $ делится нацело на $ x(x+1)(x-1)^2 $ при полиноме

$$ F_{}(x) in { (u_1x^2+u_2x+u_3)x mid (u_1,u_2,u_3) in mathbb R^3 } . $$

Некоторое подмножество этого множества составляют собственные векторы (полиномы):

$$ { (t_1x+t_2)(x-1)x mid (t_1,t_2)

in mathbb R^2 } subset { (u_1x^2+u_2x+u_3)x mid (u_1,u_2,u_3) in mathbb R^3 } , $$

но появляются и корневые векторы (полиномы) высоты $ 2_{} $. Чтобы понять какие это векторы обратим внимание, что полиномы из левого множества все делятся на $ (x-1) $, т.е. имеют корнем $ 1_{} $. Следовательно высоту $ 2_{} $ будут иметь полиномы $ (u_1x^2+u_2x+u_3)x $, для которых $ 1_{} $ не является корнем, т.е. удовлетворяющие условию $ u_1+u_2+u_3 ne 0 $.

Если мы попытаемся найти полиномы высоты $ 3_{} $, то нас ожидает неудача — множество решений

$ (mathcal A +mathcal E)^3 (F(x)) $ совпадает с предыдущим.

♦

П

Пример 3. Найти корневые векторы матрицы

$$

mathbf A=left(

begin{array}{rrrrrrrr}

3 & 0 & 1 & 1 & 0 & 1 & -1 & 0 \

0 & 3 & -2 & -1 & -1 & -2 & 1 & -1 \

2& 3 & 0 & 0 & -2 & -2 & 0 & -2 \

-3 & -3 & 1 & 1 & 2 & 1 & 1 & 2 \

-1 & -1 & 0 & 0 & 2 & -1 & 1 & 0 \

-1 & -1 & 0 & -1 & 1 & 3 & 0 & 1 \

-1 & -1 & 0 & -1 & 1 & 1 & 2 & 1 \

0& 0& 0 & 0 & 0 & 0 & 0 & 2

end{array}

right) .

$$

Решение. $ det (mathbf A- lambda E) equiv ( lambda -2)^8 $. У матрицы имеется единственное собственное число $ lambda_1=2 $ алгебраической кратности $ 8_{} $.

Составим матрицу

$$

mathbf B=mathbf A- 2, E=

left(

begin{array}{rrrrrrrr}

1 & 0 & 1 & 1 & 0 & 1 & -1 & 0\

0 & 1 & -2 & -1 & -1 & -2 & 1 & -1\

2 & 3 & -2 & 0 & -2 & -2 & 0 & -2\

-3 & -3 & 1 & -1 & 2 & 1 & 1 & 2\

-1 & -1 & 0 & 0 & 0 & -1 & 1 & 0\

-1 & -1 & 0 & -1 & 1 & 1 & 0 & 1\

-1 & -1 & 0 & -1 & 1 & 1 & 0 & 1\

0 & 0 & 0 & 0 & 0 & 0 & 0 & 0

end{array}

right)

$$

и найдем корневые векторы высоты $ 1_{} $ как решения системы однородных уравнений $ mathbf B X = mathbb O $. Методом Гаусса сводим эту систему к

$$

left(

begin{array}{rrrrrrrr}

1 & 0 & 1 & 1 & 0 & 1 & -1 & 0\

0& 1 & -2 & -1 & -1 & -2 & 1 & -1 \

0 & 0 & 2 & 1 & 1 & 2 & -1 & 1\

0& 0 & 0 & 1 & -1 & -2 & 1 & -1

end{array}

right) X = mathbb O iff

$$

$$

iff quad

left{

begin{array}{rrrrrrrrr}

x_1 & & -x_3 & +x_4 & +x_5 & & & & =0,\

& x_2 & & & & & & & =0, \

& & x_3 & +x_4 & & & & & =0,\

& & & x_4 & -x_5 & -2,x_6 & +x_7 & -x_8 & = 0.

end{array}

right.

$$