Несмотря на широкую распространённость, понятие информации остаётся одним из самых дискуссионных в науке, а термин может иметь различные значения в разных отраслях человеческой деятельности.

Определений информации существует множество, причём академик Н. Н. Моисеев даже полагал, что в силу широты этого понятия нет и не может быть строгого и достаточно универсального определения информации. Тем не менее, в международных и российских стандартах существуют более или менее конкретные формулировки:

знания о предметах, фактах, идеях и т. д., которыми могут обмениваться люди в рамках конкретного контекста (ISO/IEC 10746-2:1996);

знания относительно фактов, событий, вещей, идей и понятий, которые в определённом контексте имеют конкретный смысл (ISO/IEC 2382:2015);

сведения, воспринимаемые человеком и (или) специальными устройствами как отражение фактов материального или духовного мира в процессе коммуникации (ГОСТ 7.0-99).

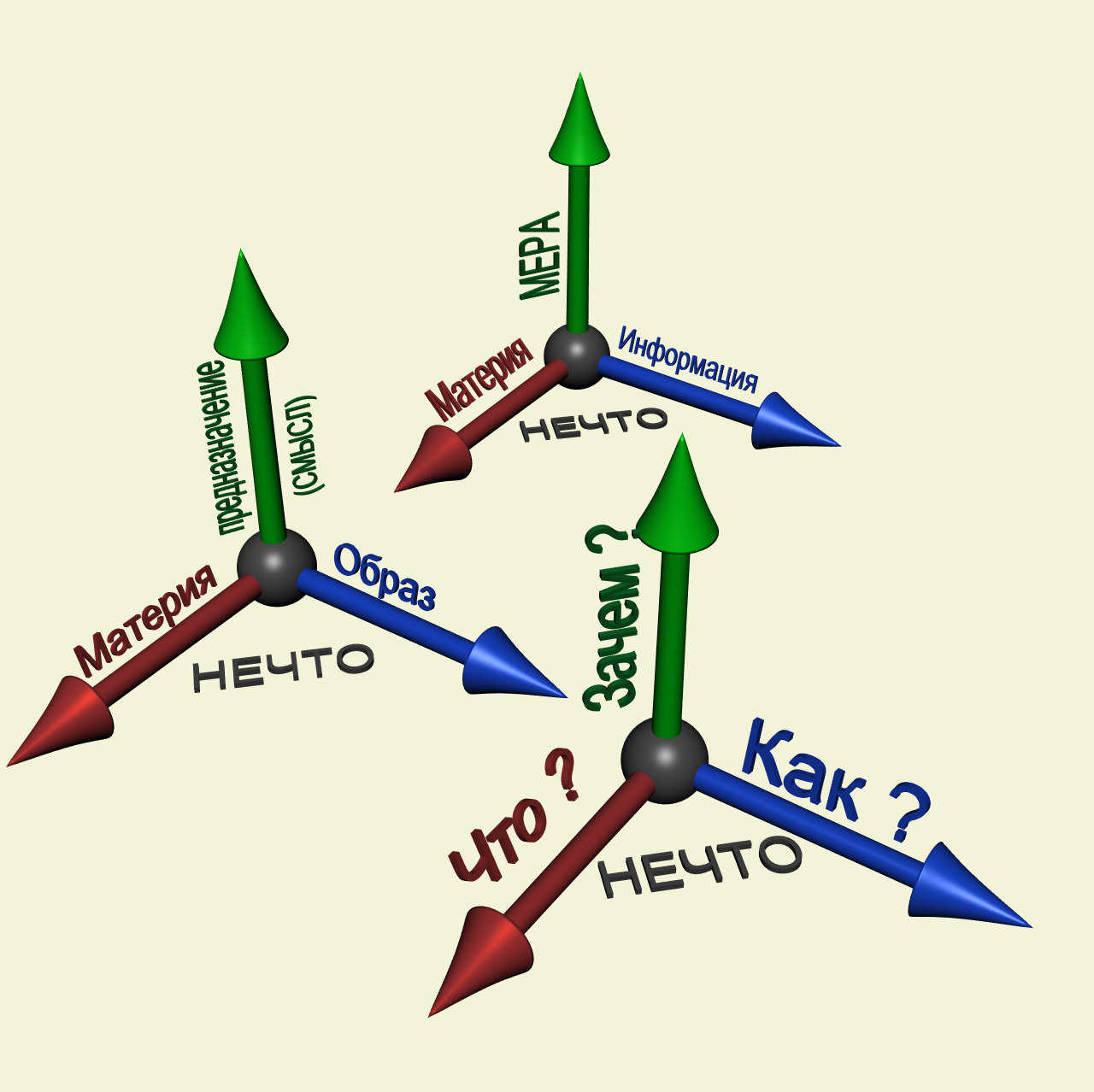

Хотя информация должна обрести некоторую форму представления (то есть превратиться в данные), чтобы ей можно было обмениваться, информация есть в первую очередь интерпретация (смысл) такого представления (ISO/IEC/IEEE 24765:2010). Поэтому в строгом смысле информация отличается от данных, хотя в неформальном контексте эти два термина очень часто используют как синонимы.

Первоначально «информация» — сведения, передаваемые людьми устным, письменным или другим способом (с помощью условных сигналов, технических средств и т. д.); с середины XX века термин «информация» превратился в общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире; передачу признаков от клетки к клетке, от организма к организму (например, генетическая информация); одно из основных понятий кибернетики.

Информа́ция (от лат. informātiō «разъяснение, представление, понятие о чём-либо» ← informare «придавать вид, форму, обучать; мыслить, воображать»[1]) — сведения (сообщения, данные) независимо от формы их представления[2][3].

Несмотря на широкую распространённость, понятие информации остаётся одним из самых дискуссионных в науке, а термин может иметь различные значения в разных отраслях человеческой деятельности[4].

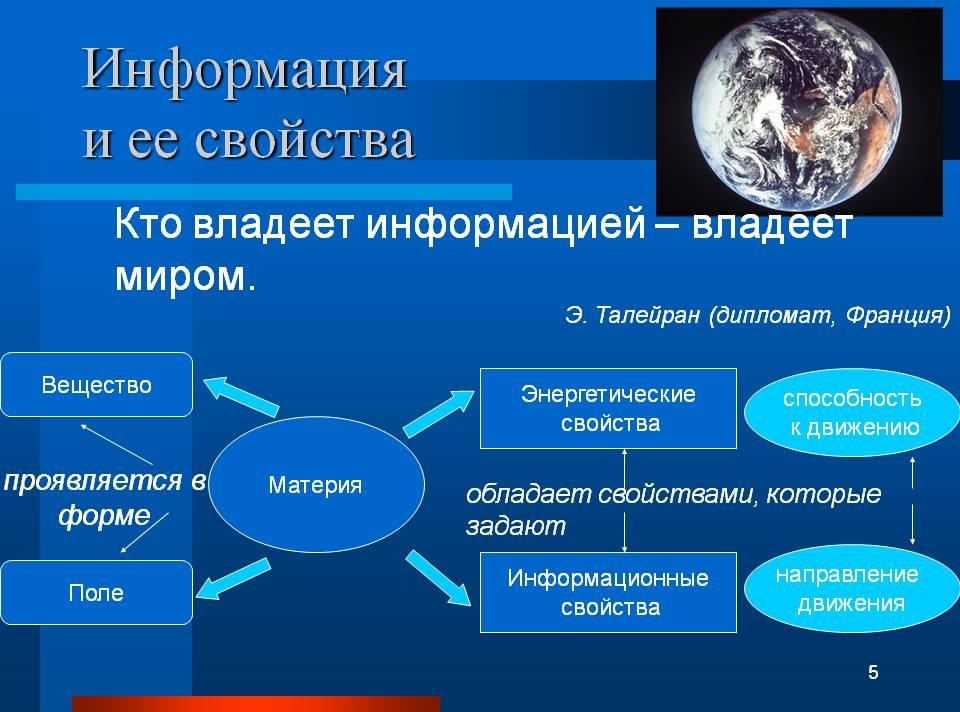

Информация — это не материя и не энергия, информация — это информация

Определений информации существует множество, причём академик Н. Н. Моисеев даже полагал, что в силу широты этого понятия нет и не может быть строгого и достаточно универсального определения информации[6].

В международных и российских стандартах даются следующие определения:

- знания о предметах, фактах, идеях и т. д., которыми могут обмениваться люди в рамках конкретного контекста (ISO/IEC 10746-2:1996)[7];

- знания относительно фактов, событий, вещей, идей и понятий, которые в определённом контексте имеют конкретный смысл (ISO/IEC 2382:2015)[8];

- сведения, воспринимаемые человеком и (или) специальными устройствами как отражение фактов материального или духовного мира в процессе коммуникации (ГОСТ 7.0-99)[9].

Хотя информация должна обрести некоторую форму представления (то есть превратиться в данные), чтобы ею можно было обмениваться, информация есть в первую очередь интерпретация (смысл) такого представления (ISO/IEC/IEEE 24765:2010)[10]. Поэтому в строгом смысле информация отличается от данных, хотя в неформальном контексте эти два термина очень часто используют как синонимы.

Первоначально «информация» — сведения, передаваемые людьми устным, письменным или каким-либо другим способом (с помощью условных сигналов, технических средств и т. д.); с середины XX века термин «информация» превратился в общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире; передачу признаков от клетки к клетке, от организма к организму (например, генетическая информация); одно из основных понятий кибернетики[11].

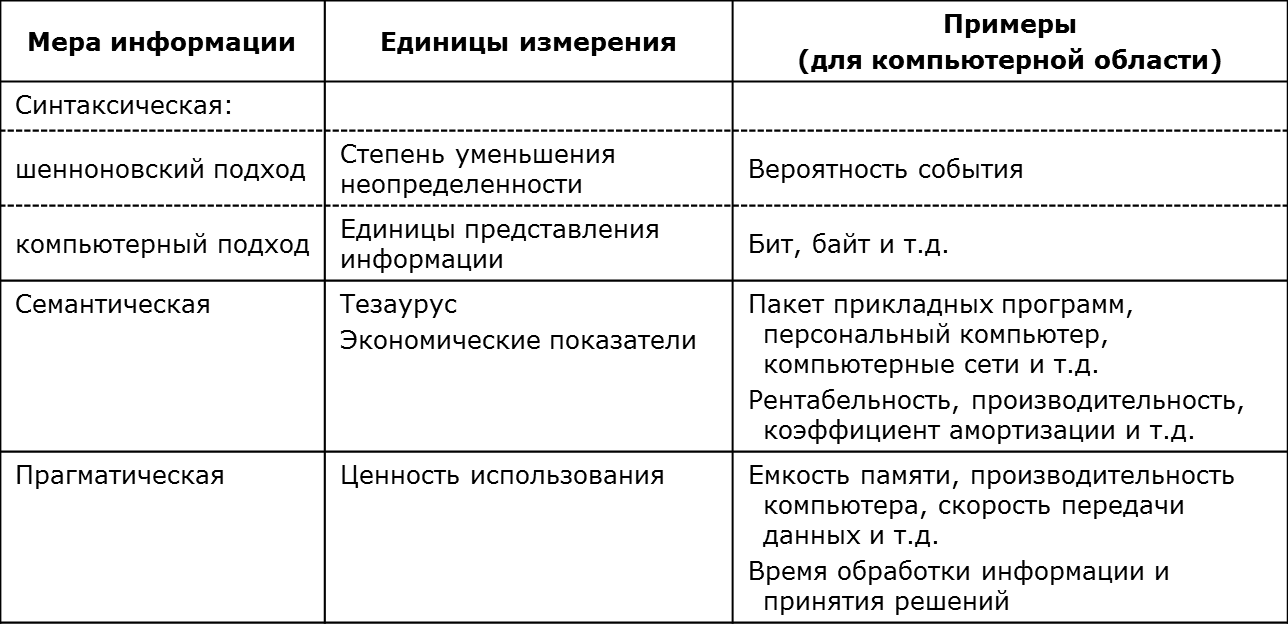

Измерение информации[править | править код]

| Измерения в байтах | ||||||||

|---|---|---|---|---|---|---|---|---|

| ГОСТ 8.417—2002 | Приставки СИ | Приставки МЭК | ||||||

| Название | Обозначение | Степень | Название | Степень | Название | Обозначение | Степень | |

| байт | Б | 100 | — | 100 | байт | B | Б | 20 |

| килобайт | Кбайт | 103 | кило- | 103 | кибибайт | KiB | КиБ | 210 |

| мегабайт | Мбайт | 106 | мега- | 106 | мебибайт | MiB | МиБ | 220 |

| гигабайт | Гбайт | 109 | гига- | 109 | гибибайт | GiB | ГиБ | 230 |

| терабайт | Тбайт | 1012 | тера- | 1012 | тебибайт | TiB | ТиБ | 240 |

| петабайт | Пбайт | 1015 | пета- | 1015 | пебибайт | PiB | ПиБ | 250 |

| эксабайт | Эбайт | 1018 | экса- | 1018 | эксбибайт | EiB | ЭиБ | 260 |

| зеттабайт | Збайт | 1021 | зетта- | 1021 | зебибайт | ZiB | ЗиБ | 270 |

| йоттабайт (иоттабайт) | Ибайт | 1024 | йотта- (иотта-) | 1024 | йобибайт | YiB | ЙиБ | 280 |

| роннабайт | – | 1027 | ронна- | 1027 | – | – | – | – |

| кветтабайт | – | 1030 | кветта- | 1030 | – | – | – | – |

Пионером в области информационной теории был Ральф Хартли. Он ввёл понятие «информации» (энтропии) как случайной переменной и был первым, кто попытался определить «меру информации».

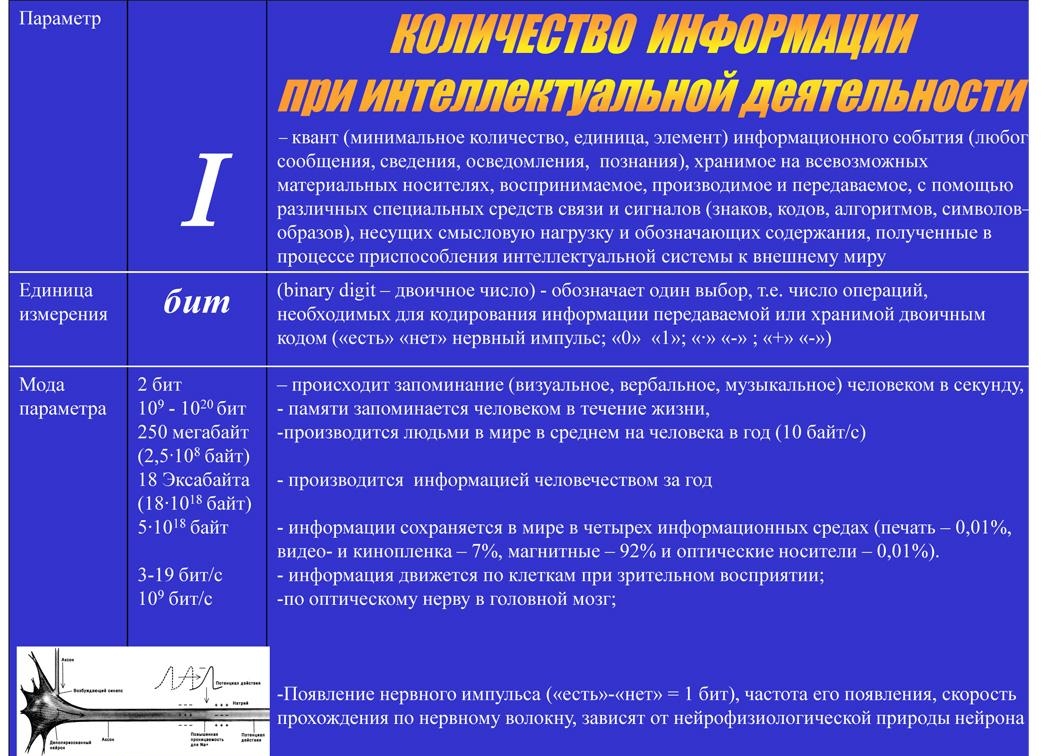

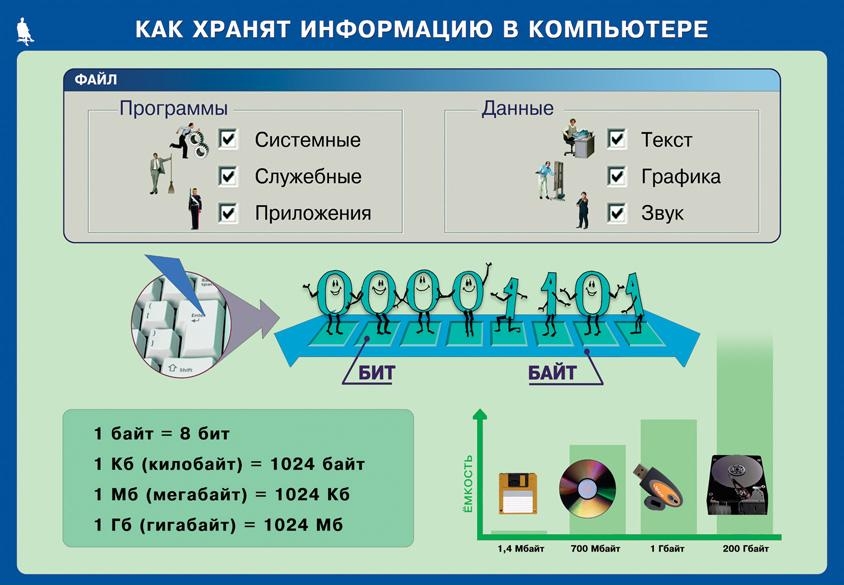

Простейшей единицей измерения информации является бит — единица измерения количества информации, принимающая 2 логических значения: да или нет, истина или ложь, включено или выключено; 1 или 0 в двоичной системе счисления.

В современных вычислительных системах одномоментно обрабатываются 8 бит информации, называемые байтом. Байт может принимать одно из 256 (28) различных значений (состояний, кодов). Производные от байта десятичные единицы измерения, соответственно, именуются килобайт (103 = 1000 байт), мегабайт (106 = 1 000 000 байт), гигабайт (109 = 1 000 000 000 байт) и т. д.[12]

Производные от байта двоичные (бинарные) единицы измерения именуются кибибайт (210 = 1024 байт), мебибайт (220 = 1 048 576 байт), гибибайт (230 = 1 073 741 824 байт) и так далее[12].

Также, информацию измеряют такими единицами как трит, Хартдит (децит) и Нат.

Суть и границы явления[править | править код]

Согласно современным представлениям, информация считается нематериальной, а то, что содержится в структуре объектов, принято называть данными (representation form — ISO/IEC/IEEE 24765:2010).

Для исследований самоорганизации динамических систем Генри Кастлер предложил следующее определение: «Информация есть запомненный выбор одного варианта из нескольких возможных и равноправных»[13]. Доктор философских наук И. В. Мелик-Гайказян дополняет его: «Запомнить — значит каким-либо образом фиксировать результат выбора, что обычно выражается в изменении упорядоченности системы»[14].

Н. М. Амосов считал, что «информация — это сведения о системе, о её структуре и функции, выраженные моделью», а «переработка информации заключается в превращении одних моделей в другие»[15].

История понятия[править | править код]

Слово «информация» происходит от лат. informatio, что в переводе обозначает сведение, разъяснение, ознакомление. Понятие информации рассматривалось ещё античными философами.

Латинские слова «de saxis informibus» из Вульгаты Иеронима (342—419) переводятся как «из камней цельных» (Втор. 27:6), а слова «informem adhuc me», которые переводятся как «Зародыш мой» (Пс. 138:16), можно перевести и как «бесформенного ещё меня», потому что именно как «ещё бесформенная» переводятся слова «adhuc informem» из Исповеди Августина (354—430).

Итальянским словом «informa» в Комедии Данте (1265—1321) обозначается уже не просто бесформенное, а процесс формирования, образования, творения (Ч. XVII 16-18, Ч. XXV 40-42, Р. VII 133—138).

В современном мире информация представляет собой один из важнейших ресурсов и, в то же время, одну из движущих сил развития человеческого общества. Информационные процессы, происходящие в материальном мире, живой природе и человеческом обществе, изучаются (или, по крайней мере, учитываются) всеми научными дисциплинами от философии до маркетинга.

Исторически сложилось так, что исследованием непосредственно информации занимаются две комплексные отрасли науки — кибернетика и информатика.

Информатика, сформировавшаяся как наука в середине XX века, отделилась от кибернетики и занимается исследованиями в области способов получения, хранения, передачи и обработки семантической информации.

Исследования смыслового содержания информации основываются на комплексе научных теорий под общим названием семиотика[источник не указан 2970 дней].

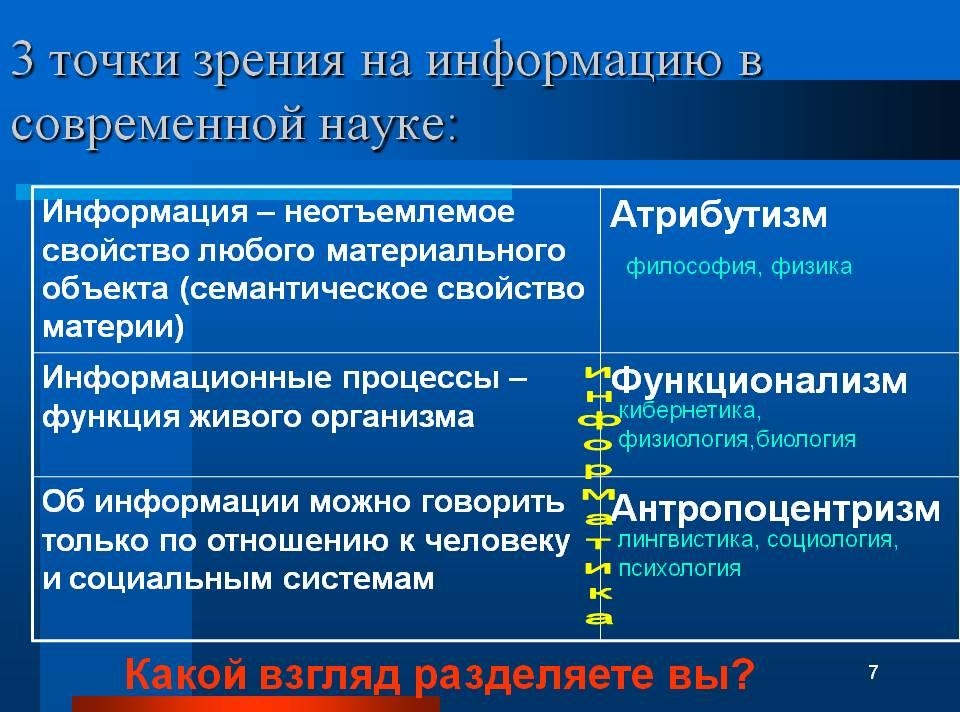

В России философская проблематика понятия «информация» разрабатывалась, начиная с 1960-х годов, когда вышла статья А. Д. Урсула «Природа информации». С тех пор, явно или неявно, рассматриваются в основном две концепции информации: атрибутивная, по которой информация свойственна всем физическим системам и процессам (А. Д. Урсул, И. Б. Новик, Л. Б. Баженов, Л. А. Петрушенко и другие), и функциональная — информация присуща лишь самоорганизующимся системам (П. В. Копнин, А. М. Коршунов, В. С. Тюхтин, Б. С. Украинцев и другие)[16].

Но если, например, провести даже неглубокий анализ содержания наиболее распространенных сегодня атрибутивной и функциональной концепций в отношении информации, то станет ясным, что обе эти концепции, в конечном счете, опираются на объективное свойство материи, установленное ещё в XIX веке и обозначаемое философской категорией «отражение». Однако в обеих концепциях не уделяется достаточного внимания изучению очевидной реальности, проявляющейся в том, что информация в тех формах, в которых она существует сегодня, есть продукт человеческого сознания, которое само есть продукт высшей формы (из известных нам форм) материи.

Другими словами, сторонники обеих концепций, игнорируя человека, игнорируя природу человеческого сознания, сразу относят информацию (продукт сознания) к свойству материи и тут же называют её «атрибутом материи». Вследствие этой ошибки обе концепции не могут представить нам строгое определение информации как понятия, поскольку человеческие понятия наполняются содержанием в результате общения человека с объективной реальностью, а не в результате оперирования, пусть и изощренного, внешне убедительного, правдоподобного в умозаключениях, другими понятиями. Попытки представить информацию в качестве категории также обречены на неудачу. Достаточно принять во внимание, что человеческая практика за последние десятилетия столь быстро изменяла формы и содержание понятий, а также свои представления и отношения к тому, что сегодня принято называть «информацией», что природа, сущность информации и, естественно, содержание этого понятия (если по-прежнему считать его понятием) существенно изменялись со временем[17].

Классификация информации[править | править код]

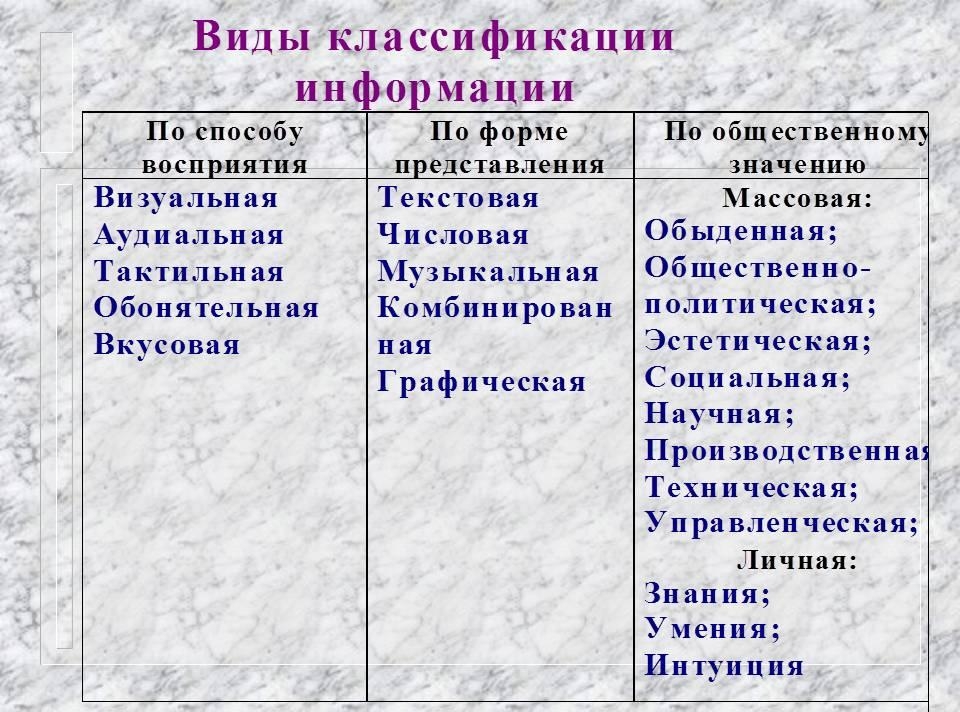

Информацию можно разделить на виды по различным критериям:

- По способу восприятия:

- Визуальная — воспринимаемая органами зрения.

- Звуковая — воспринимаемая органами слуха.

- Тактильная — воспринимаемая тактильными рецепторами.

- Обонятельная — воспринимаемая обонятельными рецепторами.

- Вкусовая — воспринимаемая вкусовыми рецепторами.

- По форме представления:

- Текстовая — передаваемая в виде символов, предназначенных обозначать лексемы языка.

- Числовая — в виде цифр и знаков (символов), обозначающих математические действия.

- Графическая — в виде изображений, предметов, графиков.

- Звуковая — устная или в виде записи и передачи лексем языка аудиальным путём.

- Видеоинформация — передаваемая в виде видеозаписи.

- По назначению:

- Массовая — содержит тривиальные сведения и оперирует набором понятий, понятным большей части социума.

- Специальная — содержит специфический набор понятий, при использовании происходит передача сведений, которые могут быть не понятны основной массе социума, но необходимы и понятны в рамках узкой социальной группы, где используется данная информация.

- Секретная — передаваемая узкому кругу лиц и по закрытым (защищённым и адаптивным) каналам.

- Личная (приватная) — набор сведений о какой-либо личности, определяющий социальное положение и типы социальных взаимодействий внутри популяции.

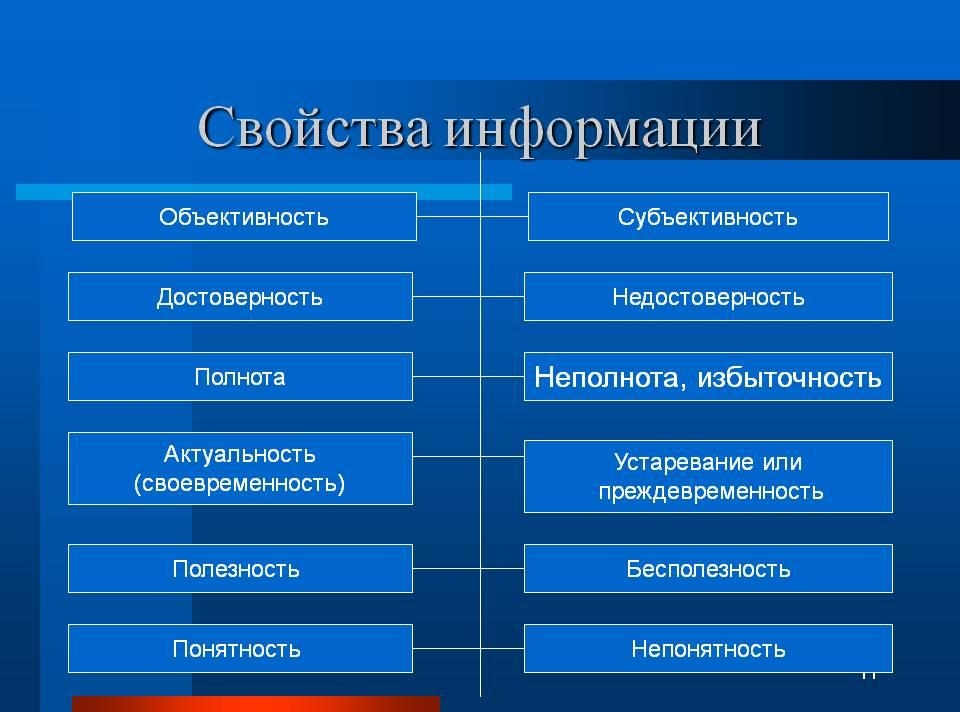

- По значению:

- Актуальная — информация, ценная в данный момент времени.

- Достоверная — информация, полученная без искажений с надежных источников.

- Понятная — информация, выраженная на языке, понятном тому, кому она предназначена.

- Полная — информация, достаточная для принятия правильного решения или понимания.

- Ценная — полезность информации определяется субъектом, получившим информацию в зависимости от объёма возможностей её использования.

- По истинности:

- Истинная.

- Ложная.

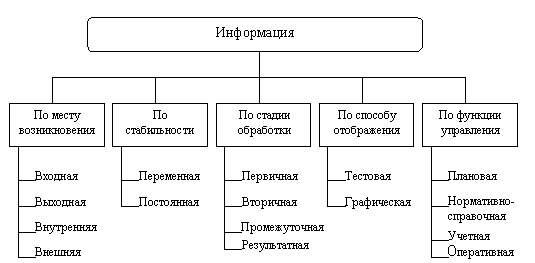

В основу классификации положено пять общих признаков:

- Место возникновения.

- Стадия обработки.

- Способ отображения.

- Стабильность.

- Функция управления.

Информация в различных областях деятельности[править | править код]

В математике[править | править код]

В математике информация — общее наименование фундаментальных понятий в информатике, теории информации, кибернетике, а также в математической статистике, в которых обобщённое интуитивное представление об информации относительно каких-либо величин или явлений конкретизируется и формализуется[18].

В информатике[править | править код]

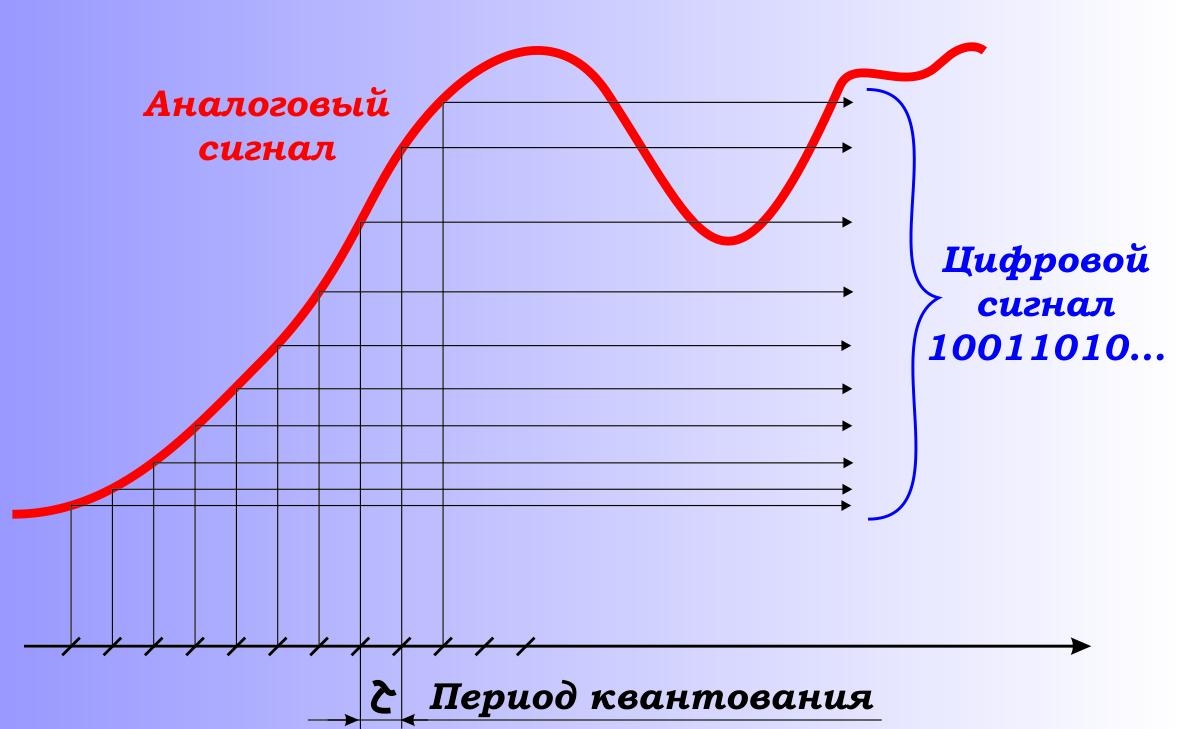

Предметом изучения информатики являются именно данные: методы их создания, хранения, обработки и передачи[19]. Данные представляют собой информацию в формализованном виде (в цифровой форме), позволяющем автоматизировать её сбор, хранение и дальнейшую обработку в ЭВМ. С этой точки зрения информация является абстрактным понятием, рассматриваемым безотносительно к её семантическому аспекту, а под количеством информации обычно понимается соответствующий объём данных. Однако одни и те же данные могут быть закодированы различным образом и иметь при этом различный объём, поэтому иногда рассматривается также понятие «ценность информации», которое связано с понятием информационной энтропии и является предметом изучения теории информации.

В теории информации[править | править код]

Теория информации (математическая теория связи) — изучает процессы хранения, преобразования и передачи информации. Она основана на научных методах измерения количества информации[20]. Теория информации развилась из потребностей теории связи. Основополагающими считаются «Передача информации[21]» Ральфа Хартли опубликованные в 1928 году и «Работы по теории информации и кибернетике[22]» Клода Шеннона, опубликованные в 1948 году. Теория информации изучает пределы возможностей систем передачи данных, а также основные принципы их проектирования и технической реализации[23].

С теорией информации связаны радиотехника (теория обработки сигналов) и информатика, относящиеся к измерению количества передаваемой информации, её свойства и устанавливающие предельные соотношения для систем. Основные разделы теории информации — кодирование источника (сжимающее кодирование) и канальное (помехоустойчивое) кодирование.

Информация не входит в число предметов исследования математики. Тем не менее, слово «информация» употребляется в математических терминах — собственная информация и взаимная информация, относящихся к абстрактной (математической) части теории информации. Однако, в математической теории понятие «информация» связано с исключительно абстрактными объектами — случайными величинами, в то время как в современной теории информации это понятие рассматривается значительно шире — как свойство материальных объектов[источник не указан 2988 дней].

Связь между этими двумя одинаковыми терминами несомненна. Именно математический аппарат случайных чисел использовал автор теории информации Клод Шеннон. Сам он подразумевает под термином «информация» нечто фундаментальное (нередуцируемое). В теории Шеннона интуитивно полагается, что информация имеет содержание. Информация уменьшает общую неопределённость и информационную энтропию. Количество информации доступно измерению. Однако он предостерегает исследователей от механического переноса понятий из его теории в другие области науки[источник не указан 2988 дней].

В теории управления (кибернетике)[править | править код]

Основоположник кибернетики Норберт Винер дал следующее определение информации: «Информация — это обозначение содержания, полученное нами из внешнего мира в процессе приспосабливания к нему нас и наших чувств»[5].

Кибернетика рассматривает машины и живые организмы как системы, воспринимающие, накапливающие и передающие информацию, а также перерабатывающие её в сигналы, определяющие их собственную деятельность[18].

Материальная система в кибернетике рассматривается как множество объектов, которые сами по себе могут находиться в различных состояниях, но состояние каждого из них определяется состояниями других объектов системы. В природе множество состояний системы представляет собой информацию, сами состояния представляют собой первичный код или код источника. Таким образом, каждая материальная система является источником информации.

Субъективную (семантическую) информацию кибернетика определяет как смысл или содержание сообщения. Информация — это характеристика объекта.

Алгоритмическая теория информации[править | править код]

Как область математики — алгоритмическая теория информации была создана А. Н. Колмогоровым[24]. Две основополагающие статьи по ней были опубликованы в журнале «Проблемы передачи информации» в 1965 и 1969 годах[25][26][27]. Центральным в этой теории является понятие алгоритмической (также называемой колмогоровской) сложности информационного объекта, то есть алгоритмического способа его описания (формирования); эта сложность определяется как минимальная длина алгоритма, формирующего такой объект. Теорема Колмогорова устанавливает, что среди алгоритмов, формирующий информационный объект существуют оптимальные, хотя такие алгоритмы не единственные и отличаются для разных способов представления алгоритмов, тем не менее для заданных двух оптимальных способов их длина (сложность) отличается не более чем на аддитивную константу. Задача вычисления алгоритмической сложности объекта является алгоритмически неразрешимой.

В семиотике[править | править код]

Семиотика — комплекс научных теорий, изучающих свойства знаковых систем. Наиболее существенные результаты достигнуты в разделе семиотики — семантике. Предметом исследований семантики является значение единиц языка, то есть информация, передаваемая посредством языка.

Знаковой системой считается система конкретных или абстрактных объектов (знаков, слов), с каждым из которых определённым образом сопоставлено некоторое значение. В теории доказано, что таких сопоставлений может быть два. Первый вид соответствия определяет непосредственно материальный объект, который обозначает это слово и называется денотат (или, в некоторых работах, — номинат). Второй вид соответствия определяет смысл знака (слова) и называется концепт. При этом исследуются такие свойства сопоставлений как «смысл», «истинность», «определимость», «следование», «интерпретация» и др. Для исследований используется аппарат математической логики и математической лингвистики.

Идеи семантики, намеченные ещё Г. В. Лейбницем и Ф. де Соссюром в XIX веке, сформулировали и развили Ч. Пирс (1839—1914), Ч. Моррис (1901—1979), Р. Карнап (1891—1970) и др.

Основным достижением теории является создание аппарата семантического анализа, позволяющего представить смысл текста на естественном языке в виде записи на некотором формализованном семантическом (смысловом) языке.

Семантический анализ является основой для создания устройств (программ) машинного перевода с одного естественного языка на другой.

В юриспруденции[править | править код]

Любые сведения, сообщения, данные, независимо от их оформления, являются информацией — материальным или нематериальным объектом, участвующим в любых отношениях. Развитие технологических возможностей переработки и передачи информации выделило её в самостоятельный предмет производственных, управленческих, идеологических и личных отношений. Информация стала товаром, продукцией, предметом труда и объектом услуг. В системе правовых отношений её рассматривает информационное право. Некоторые международные правовые акты и законодательства ряда стран (в том числе России) провозглашают право человека на свободный поиск, получение, передачу, производство и распространение информации любым способом, не нарушающим законы[3].

В физике[править | править код]

|

|

Этот раздел статьи ещё не написан. Здесь может располагаться отдельный раздел. Помогите Википедии, написав его. (31 января 2017) |

Квантовая теория информации рассматривает общие закономерности передачи, хранения и преобразования информации в системах, изменяющихся по законам квантовой механики[28].

Символ информации[править | править код]

Обычно[где?] информацию обозначают маленькой буквой i в кружочке

| Символ | Юникод | Название |

|---|---|---|

| ℹ | U+2139 | information source |

| ⓘ | U+24D8 | circled latin small letter i |

Хотя также она может обозначаться знаком вопроса в кружочке()

Дезинформация[править | править код]

Дезинформацией (также дезинформированием) называется один из способов манипулирования информацией, как то введение кого-либо в заблуждение путём предоставления неполной информации или полной, но уже не нужной информации, или полной, но не в нужной области, искажения контекста, искажения части информации.

Цель такого воздействия всегда одна — оппонент должен поступить так, как это необходимо манипулятору. Поступок объекта, против которого направлена дезинформация, может заключаться в принятии нужного манипулятору решения или в отказе от принятия невыгодного для манипулятора решения. Но в любом случае конечная цель — это действие, которое будет предпринято.

См. также[править | править код]

Примечания[править | править код]

- ↑ Большая Советская Энциклопедия

- ↑ Когаловский М. Р. и др. Глоссарий по информационному обществу Архивная копия от 31 марта 2020 на Wayback Machine / Под общ. ред. Ю. Е. Хохлова. — М.: Институт развития информационного общества, 2009. — 160 с.

- ↑ 1 2 Информация в праве / И. Л. Бачило // Излучение плазмы — Исламский фронт спасения. — М. : Большая российская энциклопедия, 2008. — С. 495. — (Большая российская энциклопедия : [в 35 т.] / гл. ред. Ю. С. Осипов ; 2004—2017, т. 11). — ISBN 978-5-85270-342-2.

- ↑ Информация // Казахстан. Национальная энциклопедия. — Алматы: Қазақ энциклопедиясы, 2005. — Т. II. — ISBN 9965-9746-3-2. (CC BY-SA 3.0)

- ↑ 1 2 Винер Н. Кибернетика, или управление и связь в животном и машине; или Кибернетика и общество/ 2-е издание. — М.: Наука; Главная редакция изданий для зарубежных стран, 1983.

— 344 с. - ↑ Хургин, 2007.

- ↑ ISO/IEC 10746-2:1996, Information technology — Open Distributed Processing — Reference Model: Foundations.3.2.5: knowledge that is exchangeable amongst users about things, facts, concepts, and so on, in a universe of discourse

- ↑ ISO/IEC 2382:2015 Information technology — Vocabulary Архивная копия от 17 июня 2016 на Wayback Machine: knowledge concerning objects, such as facts, events, things, processes, or ideas, including concepts, that within a certain context has a particular meaning

- ↑ ГОСТ 7.0-99 Архивная копия от 2 апреля 2015 на Wayback Machine Информационно-библиотечная деятельность, библиография. Термины и определения

- ↑ ISO/IEC/IEEE 24765:2010 Systems and software engineering — Vocabulary Архивная копия от 17 июня 2016 на Wayback Machine: Although information will necessarily have a representation form to make it communicable, it is the interpretation of this representation (the meaning) that is relevant in the first place

- ↑ Информация // Большой Энциклопедический словарь. — 2000. // Большой энциклопедический словарь / 2-е изд., перераб. и доп. — М.: Большая Российская энциклопедия, 2000. — 1434 с.

- ↑ 1 2 International Standard IEC 80000-13 Quantities and Units — Part 13: Information science and technology, International Electrotechnical Commission (2008).

- ↑ Кастлер Г. Возникновение биологической организации = The Emergence of Biological Organization. — М.: Мир, 1967.

- ↑ Информационный подход в междисциплинарной перспективе // «Вопросы философии».[1]

- ↑ Амосов Н. М. Моделирование сложных систем. — Киев: Наукова думка, 1968. — 88 с. — 20 000 экз.

- ↑ Материалы «круглого стола» Информационный подход в междисциплинарной перспективе Архивная копия от 9 октября 2015 на Wayback Machine//ред. В. В. Пирожков, Вопросы философии, 2010.

- ↑ Петриченко Е. А. ИНФОРМАЦИЯ И ФИЛОСОФСКИЕ КАТЕГОРИИ «ЯВЛЕНИЕ И СУЩНОСТЬ» // Современные проблемы науки и образования. – 2014. – № 1 : журнал. — 2014. — № 1. Архивировано 9 сентября 2017 года.

- ↑ 1 2 Информация в математике / Ю. В. Прохоров // Излучение плазмы — Исламский фронт спасения. — М. : Большая российская энциклопедия, 2008. — (Большая российская энциклопедия : [в 35 т.] / гл. ред. Ю. С. Осипов ; 2004—2017, т. 11). — ISBN 978-5-85270-342-2.

- ↑ Захаров В. П. Информационные системы (документальный поиск): Учебное пособие / В. П. Захаров. — СПб.: СПб.гос университет, 2002. — 188 с.

- ↑ Информации теория / Ю. В. Прохоров // Излучение плазмы — Исламский фронт спасения. — М. : Большая российская энциклопедия, 2008. — (Большая российская энциклопедия : [в 35 т.] / гл. ред. Ю. С. Осипов ; 2004—2017, т. 11). — ISBN 978-5-85270-342-2.

- ↑ Hartley, R.V.L., „Transmission of Information“ Архивная копия от 1 августа 2020 на Wayback Machine, Bell System Technical Journal, July 1928, pp. 535—563

- ↑ C. E. Shannon „A Mathematical Theory of Communication“ (Перевод в сборнике Шеннон К. „Работы по теории информации и кибернетике“. — М.: ИЛ, 1963. — 830 с., С. 243—322). Дата обращения: 24 марта 2015. Архивировано 13 мая 2015 года.

- ↑ Теория информации // «Энциклопедия Кругосвет».[2] Архивная копия от 23 марта 2009 на Wayback Machine

- ↑ Боголюбов Н. Н., Гнеденко Б. В., Соболев С. Л. Андрей Николаевич Колмогоров (К восьмидесятилетию со дня рождения) /Пред. к книге: Колмогоров А. Н. Теория информации и теория алгоритмов. — М.: Наука, 1987. — Стр. 16. — 304 с.

- ↑ Колмогоров А. Н. Три подхода к определению понятия «Количество информации». — Проблемы передачи информации, 1965, т. 1, с. 3-11.

- ↑ Колмогоров А. Н. К логическим основам теории информации и теории вероятности. — Проблемы передачи информации, 1969, т. 5, с. 3-7.

- ↑ Колмогоров А. Н. Теория информации и теория алгоритмов. — М.: Наука, 1987. — Стр. 213—223, 232—237. — 304 с.

- ↑ Квантовая теория информации / А. С. Холево // Канцелярия конфискации — Киргизы. — М. : Большая российская энциклопедия, 2009. — (Большая российская энциклопедия : [в 35 т.] / гл. ред. Ю. С. Осипов ; 2004—2017, т. 13). — ISBN 978-5-85270-344-6.

Литература[править | править код]

- Pieter Adriaans. Information. // Стэнфордская философская энциклопедия, 2012. (англ.)

- Adriaans, Pieter, van Benthem, Johan. Introduction: Information is what information does. // Dov M. Gabbay, Pieter Adriaans, Paul Thagard, Johan van Benthem, John Woods (ред.): Philosophy of Information. Amsterdam. С. 4. (англ.)

- Глик Д. Информация. История. Теория. Поток. — М. — 576 с. — ISBN 978-5-17-080465-8.

- Стратонович Р. Л. Теория информации М.: Сов. радио, 1975. — 424 с.

- Урсул А. Д. Природа информации. — М.: Политиздат, 1968. — 288 с.

- Урсул А. Д. Проблема информации в современной науке. — М.: Наука, 1975.

- Чернавский Д. С. Синергетика и информация (динамическая теория информации). — Едиториал УРСС, 2004. — ISBN 5-354-00241-9.

- Мелик-Гайказян И. В. Информационные процессы и реальность. — М.: Наука, Физматлит, 1997. — 192 с. — ISBN 5-02-015086-X.

- Хургин В. Об определении понятия «информация» // Информационные Ресурсы России. — 2007. — № 3.

- Информатика: Учебник / Под ред. проф. Н. В. Макаровой. — М.: Финансы и статистика. — 2006. — 768 с.

Ссылки[править | править код]

- Высказывания исследователей феномена информации.

лат. informatio — ознакомление, представление.

1) любые сведения, данные, сообщения, передаваемые посредством сигналов;

2) уменьшение неопределенности в результате передачи сведений, данных, сообщений — в этом качестве И. противопоставляется энтропии.

До сер. 20 в. понятие И. относилось только к сведениям и сообщениям, передаваемым человеком с помощью знаковых средств, способность к передаче И. рассматривалась как отличит. характеристика человека — разумного вида, однако с развитием науки и техники понятие И. стало применяться и для характеристики процессов обмена сигналами в живой природе (сигнальное поведение у животных и растений, генетич. передача данных в клетках и т.д.), а также в среде автоматизированных средств.

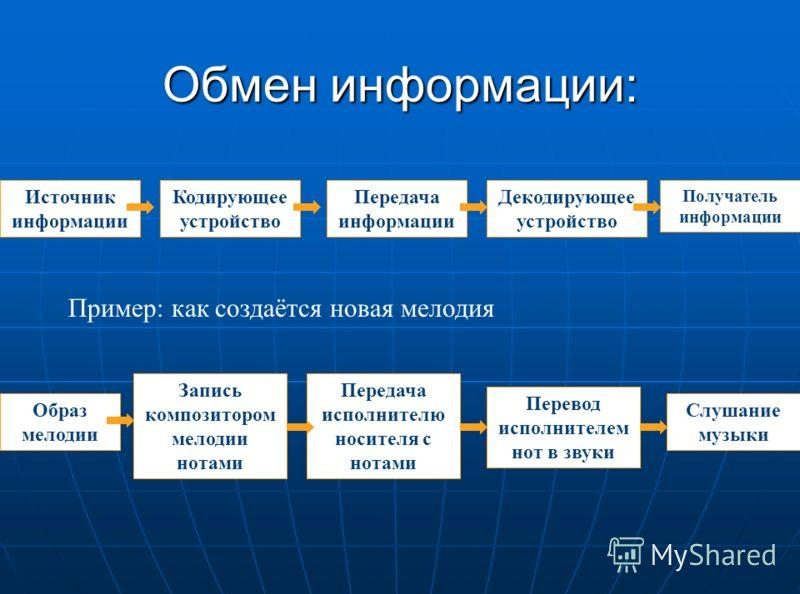

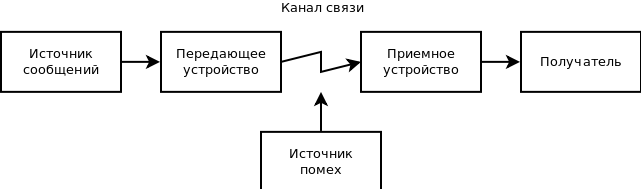

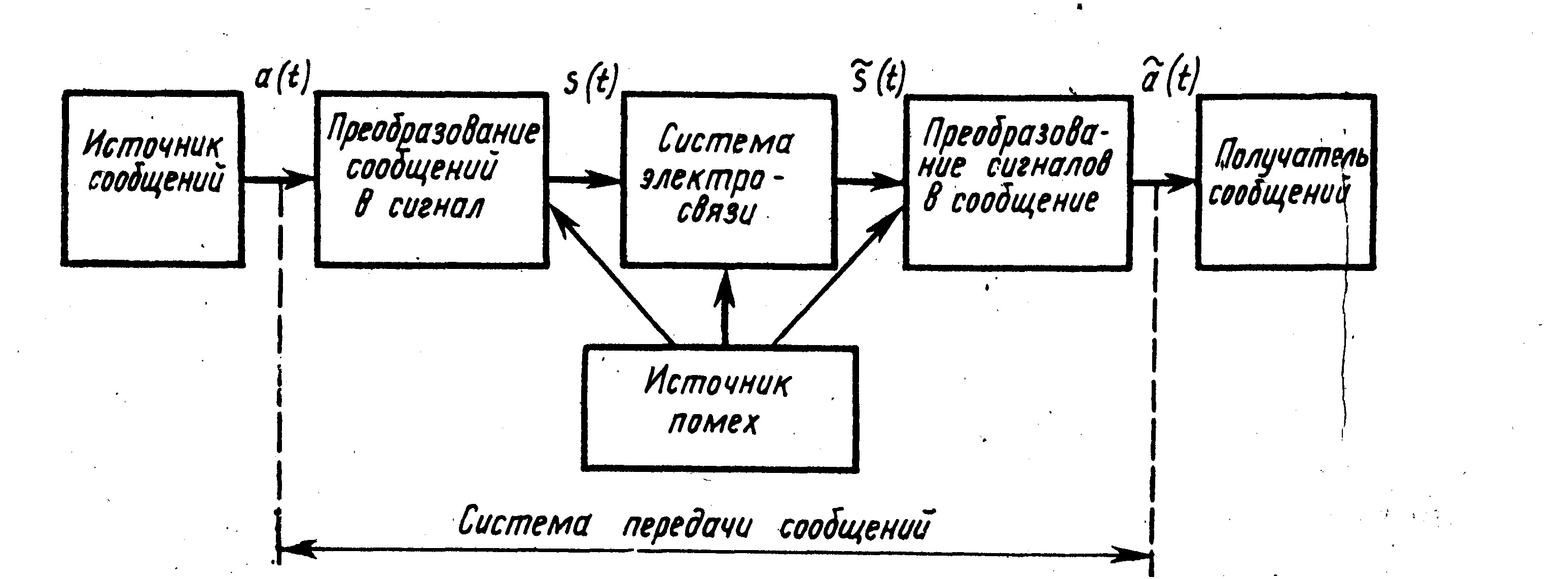

Интерес к изучению информ. процессов, к колич. и кач. оценке И., возникший в нач. 20 в., был обусловлен и развитием логико-математич., логико-семантич. и семиотич. исследований, привлекших внимание к проблемам представленности знаков и значений, и значит. увеличением объемов передаваемой И., и развитием техн. средств ее передачи (телеграф, телефон, радиосвязь, телевидение), происходившим в рамках модернизационных процессов. В пер. трети 20 в. исследования И. преследовали прежде всего цели уточнения процессов ее формализации (означения – см. Означение) и оптимизации условий ее передачи. Однако уже к сер. 20 в. появились первые теор. исследования, сформировавшие в дальнейшем ряд теорий И. — вероятностную, комбинаторную, алгоритмич. и др. Эти теории, разрабатывавшиеся средствами математики, позволили осуществить математич. моделирование процесса передачи И., выявить осн. элементы этого процесса (в классич. схеме, предложенной К. Шенноном, обмен И. включает шесть составляющих: источник — передатчик — канал передачи — приемник — адресат — источник помех), выявить принципы колич. оценки И. (пропускной способности) и степени ее искажения (помехоустойчивости).

Разработка этих теорий привела к появлению информатики как науки, предмет к-рой — И. и способы ее передачи. Однако решающее воздействие на развитие исследований в области И. оказало появление автоматизир. средств обработки И. (ЭВМ) и кибернетики — науки о связи, управлении и информ. обработке. Развитие машинной обработки И. стимулировало исследования в области формализации и алгоритмизации (сведения к операциям с элементарными высказываниями) И. и появление развернутых теорий алгоритмического синтаксиса, а также множества языков алгоритмизации и программирования. Попытки алгоритмизации семантич. процессов — означения и понимания — хотя и были далеко не столь успешны, однако оказали значит. влияние на развитие англ. лингвистич. философии и лингвистич. семантики, а также трансформационной грамматики в русле поиска универсального языка записи семантич. характеристик.

В кибернетике И. рассматривается в более узком понимании — не как любые сведения, а только как сведения, ведущие к уменьшению неопределенности (снижению количества возможных альтернативных вариантов) в ситуации общения, сведения, направленные на управление и согласование. В соответствии с таким подходом к И. в рамках общих теорий управления получили развитие исследования прагматич. аспектов И. — оценка И. с т.зр. ее актуальности (достаточная, избыточная, излишняя И.), ценности, полезности, адекватности и т.д. В рамках кибернетики стал возможен синтез математич. моделей и теорий И. с теориями социального взаимодействия и коммуникации, существенно обогативший научные представления о коммуникационных и трансляционных процессах в об-ве. На стыке информатики, кибернетики и антропологии получили также развитие нейроинформ. и нейролингвистич. исследования, рассматривавшие процессы передачи И. на уровне высшей нервной деятельности.

Применительно к социокультурному материалу математич. модели И. претерпели существ. трансформацию. Было установлено, что на информ. процессы в человеч. сооб-ве помимо шести осн. элементов существенно влияют также барьеры и фильтры: внутренние (индивидуальные психич. особенности участников информ. обмена, их опыт и компетентность), и внешние (социальные и культурные нормы, ценности, коллективные представления), значительно трансформирующие, искажающие И., и при этом они не всегда носят рац. характер. Колич. оценки этих искажающих влияний (помех) совершенно недостаточно, поскольку индивидуальный характер и сложность природы этих влияний делают принципиально необходимым их содержат. кач. анализ и определение механизмов их воздействия на И. Информ. процессы в человеч. сооб-ве далеко не всегда можно интерпретировать как ведущие к снижению неопределенности ситуации, и неактуальная информация (шум) имеет здесь не меньшее значение, чем актуальная. В соответствии с этим, помимо актуальности для социально и культурно значимой И. важны адекватность, достоверность, полнота, новизна, убедительность, выразительность, воспринимаемость и т.д. Понимание того, что информ. процессы являются важной составляющей любой культурной общности (истор. и современной), и применение к их изучению методов математич. моделирования (частично осуществленное структурализмом и европ. социальной антропологией) существенно обогатило теоретико-методол. багаж социокультурных наук. Функциональный подход к И. получил дальнейшее развитие в теории коммуникации. В рамках семиотики (см. Семиотика) изучение И. осуществляется в основном в ее семантич. аспектах (И. как пространство смыслов и значений).

В настоящее время изучение И. в социокультурных науках осуществляется по двум направлениям:

1) изучение информ. процессов (информ. культуры) разл. культурных общностей (гос-в, этносов, цивилизаций и т.д.);

2) исследования локальных информ. процессов в разл. видах деятельности (менеджмент, маркетинг, реклама, социальное участие, полит. деятельность и т.д.). Исследования такого рода, как правило, имеют прикладную направленность и наиболее широко привлекают достижения информатики и кибернетики. Такие исследования посвящены прежде всего совр. проблемам информ. обмена.

Прогрессирующая активизация и глобализация информ. процессов (средства массовой информации, массовая культура, глобальные информ. сети и т.д.) в культуре на протяжении всего 20 в. определили признание исключит. важности информ. процессов для развития совр. об-ва и сделали И. предметом не только научного, но и философского рассмотрения. И. интерпретировалась в культурфилософии, как правило, в рамках общих представлений того или иного направления (для неотомизма характерно представление И. как трансцендентального феномена; для экзистенциализма и феноменологии — ориентация на ее субъективистскую трактовку; для филос. герменевтики (см. Герменевтика) — стремление обусловить информ. процессы культурным опытом, для постпозитивизма — акцент на некогнитивные аспекты И.). Совр. ситуация нередко характеризуется культур-философией как “информ. взрыв”, “информ. бум”, обработка И. рассматривается как осн. вид деятельности в формирующемся “постиндустриальном об-ве”, предпринимаются попытки ее филос. истолкования и предсказания возможных путей развития “информ. цивилизации”.

Лит.: Шеннон К.Э. Работы по теории информации и кибернетики. М., 1963; Пирс Дж. Символы, сигналы, шумы. Закономерности и процессы передачи информации. М., 1967; Винер Н. Кибернетика или управление и связь в животном и машине. М., 1968; Гришкин И.И. Понятие информации. М., 1973; Афанасьев В.Г. Социальная информация и управление об-вом. М., 1975; Стратонович Р.Л. Теория информации. М., 1975; Дубровский Д.И. Информация, сознание, мозг. М., 1980; Страссман П.А. Информация в век электроники: Пробл. управления. М., 1987; Кин Дж. Средства массовой информации и демократия. М., 1994; Брой М. Информатика. Основополагающее введение. Ч. 1-3. М., 1996; Федотова Л.Н. Массовая информация: Стратегия производства и тактика потребления. М., 1996; Иванов А.М., Козлов В.И. Информация. Информатика. Компьютер. Самара,1996.

А. Г. Шейкин.

Культурология ХХ век. Энциклопедия. М.1996

Теорию информации вызвали к жизни потребности практики. Ее возникновение связывают с работой Клода Шеннона «Математическая теория связи», изданной в 1946г. Основы теории информации опираются на результаты, полученные многими учеными. Ко второй половине XX века земной шар гудел от передающейся информации, бегущей по телефонным и телеграфным кабелям и радиоканалам. Позже появились электронные вычислительные машины – переработчики информации. А для того времени основной задачей теории информации являлось, прежде всего, повышение эффективности функционирования систем связи. Сложность при проектировании и эксплуатации средств, систем и каналов связи в том, что конструктору и инженеру недостаточно решить задачу с физических и энергетических позиций. С этих точек зрения система может быть самой совершенной и экономичной. Но важно еще при создании передающих систем обратить внимание на то, какое количество информации пройдет через эту передающую систему. Ведь информацию можно измерить количественно, подсчитать. И поступают при подобных вычислениях самым обычным путем: абстрагируются от смысла сообщения, как отрешаются от конкретности в привычных всем нам арифметических действиях (как от сложения двух яблок и трех яблок переходят к сложению чисел вообще: 2+3).

Ученые заявили, что они «полностью игнорировали человеческую оценку информации». Последовательному ряду из 100 букв, например, они приписывают определенное значение информации, не обращая внимания, имеет ли эта информация смысл и имеет ли, в свою очередь, смысл практическое применение. Количественный подход – наиболее разработанная ветвь теории информации. В соответствии с этим определением совокупность 100 букв – фраза из 100 букв из газеты, пьесы Шекспира или теоремы Эйнштейна – имеет в точности одинаковое количество информации.

Такое определение количества информации является в высшей степени полезным и практичным. Оно в точности соответствует задаче инженера связи, который должен передать всю информацию, содержащуюся в поданной телеграмме, вне зависимости от ценности этой информации для адресата. Канал связи бездушен. Передающей системе важно одно: передать нужное количество информации за определенное время. Как же вычислить количество информации в конкретном сообщении?

Информация (Information) – это

Оценка количества информации основывается на законах теории вероятностей, точнее, определяется через вероятности событий. Это и понятно. Сообщение имеет ценность, несет информацию только тогда, когда мы узнаем из него об исходе события, имеющего случайный характер, когда оно в какой-то мере неожиданно. Ведь сообщение об уже известном никакой информации не содержит. Т.е. если вам, допустим, кто-то позвонит по телефонному аппарату и скажет: «Днем бывает светло, а ночью темно», то такое сообщение вас удивит лишь нелепостью высказывания очевидного и всем известного, а не новостью, которую оно содержит. Иное дело, например, результат забега на скачках. Кто придет первым? Исход здесь трудно предсказать.Чем больше интересующее нас событие имеет случайных исходов, тем ценнее сообщение о его результате, тем больше информации. Сообщение о событии, у которого только два одинаково возможных исхода, содержит одну единицу информации, называемую битом. Выбор единицы информации не случаен. Он связан с наиболее распространенным двоичным способом ее кодирования при передаче и обработке. Попытаемся хотя бы в самом упрощенном виде представить себе тот общий принцип количественной оценки информации, который является краеугольным камнем всей теории информации.

Мы уже знаем, что количество информации зависит от вероятностей тех или иных исходов события. Если событие, как говорят ученые, имеет два равновероятных исхода, это означает, что вероятность каждого исхода равна 1/2. Такова вероятность выпадения «орла» или «решки» при бросании монеты. Если событие имеет три равновероятных исхода, то вероятность каждого равна 1/3. Заметьте, сумма вероятностей всех исходов всегда равна единице: ведь какой-нибудь из всех возможных исходов обязательно наступит. Событие, как вы сами понимаете, может иметь и неравновероятные исходы. Так, при футбольном матче между сильной и слабой командами вероятность победы сильной команды велика – например, 4/5. Вероятность ничьей намного меньше, например 3/20. Вероятность же поражения совсем мала.

Выходит, что количество информации – это мера уменьшения неопределенности некоторой ситуации. Различные количества информации передаются по каналам связи, и количество проходящей через канал информации не может быть больше его пропускной способности. А ее определяют по тому, какое количество информации проходит здесь за единицу времени. Один из героев романа Жюля Верна «Таинственный остров», журналист Гедеон Спиллет, передавал по телефонному аппарату главу из Библии, чтобы его конкуренты не могли воспользоваться телефонной связью. В этом случае канал был загружен полностью, а количество информации было равно нулю, ибо абоненту передавались известные для него сведения. Значит, канал работал вхолостую, пропустив строго определенное количество импульсов, ничем их не нагрузив. А между тем, чем больше информации несет каждый из определенного числа импульсов, тем полнее используется пропускная способность канала. Поэтому нужно разумно кодировать информацию, найти экономный, скупой язык для передачи сообщений.

Информацию «просеивают» самым тщательным образом. В телеграфе часто встречающиеся буквы, сочетания букв, даже целые фразы изображают более коротким набором нулей и единиц, а те, что встречаются реже,- более длинным. В случае, когда уменьшают длину кодового слова для часто встречающихся символов и увеличивают для редко встречающихся, говорят об эффективном кодировании информации. Но на практике довольно часто случается, что код, возникший в результате самого тщательного «просеивания», код удобный и экономный, может исказить сообщение из-за помех, которые всегда, к сожалению, бывают в каналах связи: искажения звука в телефоне, атмосферные помехи в радио, искажение или затемнение изображения в телевидении, ошибки при передаче в телеграфе. Эти помехи, или, как их называют специалисты, шумы, обрушиваются на информацию. А от этого бывают самые невероятные и, естественно, неприятные неожиданности.

Поэтому для повышения надежности в передаче и обработке информации приходится вводить лишние символы – своеобразную защиту от искажений. Они – эти лишние символы – не несут действительного содержания в сообщении, они избыточны. С точки зрения теории информации все то, что делает язык красочным, гибким, богатым оттенками, многоплановым, многозначным, – избыточность. Как избыточно с таких позиций письмо Татьяны к Онегину! Сколько в нем информационных излишеств для краткого и всем понятного сообщения « Я вас люблю»! И как информационно точны рисованные обозначения, понятные всем и каждому, кто входит сегодня в метро, где вместо слов и фраз объявлений висят лаконичные символьные знаки, указывающие: «Вход», «Выход».

В этой связи полезно вспомнить анекдот, рассказанный в свое время знаменитым американским ученым Бенджаменом Франклином, о шляпочнике, пригласившем своих друзей для обсуждения проекта вывески.Предполагалось нарисовать на вывеске шляпу и написать: «Джон Томпсон, шляпочник, делает и продает шляпы за наличные деньги». Один из друзей заметил, что слова «за наличные деньги» являются излишними – такое напоминание будет оскорбительным для покупателя. Другой нашел также лишним слово «продает», так как само собой понятно, что шляпочник продает шляпы, а не раздает их даром. Третьему показалось, что слова «шляпочник» и «делает шляпы» представляют собой ненужную тавтологию, и последние слова были выкинуты. Четвертый предложил выкинуть и слово «шляпочник» – нарисованная шляпа ясно говорит, кто такой Джон Томпсон. Наконец, пятый уверял, что для покупателя совершенно безразлично, будет ли шляпочник называться Джоном Томпсоном или иначе, и предложил обойтись без этого указания.Таким образом, в конце концов на вывеске не осталось ничего, кроме шляпы. Конечно, если бы люди пользовались только такого рода кодами, без избыточности в сообщениях, то все «информационные формы» – книги, доклады, статьи – были бы предельно краткими. Но проиграли бы в доходчивости и красоте.

Классификация информации

Информацию можно разделить на виды по разным критериям: по истинности: истинная и ложная;

по способу восприятия:

– визуальная — воспринимается органами зрения;

– аудиальная — воспринимается органами слуха;

– тактильная — воспринимается тактильными рецепторами;

– обонятельная — воспринимается обонятельными рецепторами;

– вкусовая — воспринимаемая вкусовыми рецепторами.

по форме представления:

– текстовая — передаваемая в виде символов, предназначенных обозначать лексемы языка;

– числовая — в виде цифр и знаков, обозначающих математические действия;

– графическая — в виде изображений, предметов, графиков;

– звуковая — устная или в виде записи передача лексем языка аудиальным путём.

по назначению:

– массовая — содержит тривиальные сведения и оперирует набором понятий, понятным большей части социума;

– специальная — содержит специфический набор понятий, при использовании происходит передача сведений, которые могут быть не понятны основной массе социума, но необходимы и понятны в рамках узкой социальной группы, где используется данная информация;

– секретная — передаваемая узкому кругу лиц и по закрытым (защищённым) каналам;

– личная (приватная) — набор сведений о какой-либо личности, определяющий социальное положение и типы социальных взаимодействий внутри популяции.

по значению:

– актуальная – информация ценная в данный момент времени;

– достоверная – информация, полученная без искажений;

– понятная – информация, выраженная на языке понятном тому, кому она предназначена;

– полная – информация, достаточная для принятия правильного решения или понимания;

– полезная – полезность информации определяется субъектом, получившим информацию в зависимости от объёма возможностей её использования.

Австралия” src=”/pictures/investments/img778869_Informatsionnoe_okno_na_mostu_Avstraliya.jpg” style=”width: 800px; height: 583px;” title=” Информационное окно на мосту, Австралия” />

Значение информации в различных областях знаний

В теории информации в наше время разрабатывают много систем, методов, подходов, идей. Однако ученые считают, что к современным направлениям в теории информации добавятся новые, появятся новые идеи. В качестве доказательства правильности своих предположений они приводят «живой», развивающийся характер науки, указывают на то, что теория информации удивительно быстро и прочно внедряется в самые различные области человеческого знания. Теория информации проникла в физику, химию, биологию, медицину, философию, лингвистику, педагогику, экономику, логику, технические науки, эстетику. По признанию самих специалистов, учение об информации, возникшее в силу потребностей теории связи и кибернетики, перешагнуло их рамки. И теперь, пожалуй, мы вправе говорить об информации как научном понятии, дающем в руки исследователей теоретико – информационный метод, с помощью которого можно проникнуть во многие науки о живой и неживой природе, об обществе, что позволит не только взглянуть на все проблемы с новой стороны, но и увидеть еще неувиденное. Вот почему термин «информация» получил в наше время широкое распространение, став частью таких понятий, как информационная система, информационная культура, даже информационная этика.

Многие научные дисциплины используют теорию информации, чтобы подчеркнуть новое направление в старых науках. Так возникли, например, информационная география, информационная экономика, информационное право. Но чрезвычайно большое значение приобрел термин «информация» в связи с развитием новейшей компьютерной техники, автоматизацией умственного труда, развитием новых средств связи и обработки информации и особенно с возникновением информатики. Одной из важнейших задач теории информации является изучение природы и свойств информации, создание методов ее обработки, в частности преобразования самой различной современной информации в программы для ЭВМ, с помощью которых происходит автоматизация умственной работы-своеобразное усиление интеллекта, а значит, развитие интеллектуальных ресурсов общества.

Слово «информация» происходит от латинского слова informatio,что в переводе означает сведение, разъяснение, ознакомление. Понятие «информация» является базовым в курсе информатики, однако невозможно дать его определение через другие, более «простые» понятия.Понятие «информация» используется в различных науках, при этом в каждой науке понятие «информация»связано с различными системами понятий. Информация в биологии: Биология изучает живую природу и понятие «информация» связывается с целесообразным поведением живых организмов. В живых организмах информация передается и храниться с помощью объектов различной физической природы (состояние ДНК), которые рассматриваются как знаки биологических алфавитов. Генетическая информация передается по наследству и хранится во всех клетках живых организмов. Филосовский подход: информация – это взаимодействие, отражение, познание. Кибернетический подход: информация – это характеристики управляющего сигнала, передаваемого по линии связи.

Роль информации в философии

Традиционализм субъективного постоянно доминировал в ранних определениях информации, как категории, понятия, свойства материального мира. Информация существует вне нашего сознания, и может иметь отражение в нашем восприятии только как результат взаимодействия: отражения, чтения, получения в виде сигнала, стимула. Информация не материальна, как и все свойства материи. Информация стоит в ряду: материя, пространство, время, системность, функция, и др. что есть основополагающие понятия формализованного отражения объективной реальности в её распространении и изменчивости, разнообразии и проявлений. Информация — свойство материи и отражает её свойства (состояние или способность взаимодействия) и количество (мера) путём взаимодействия.

С материальной точки зрения информация — это порядок следования объектов материального мира. Например, порядок следования букв на листе бумаги по определенным правилам является письменной информацией. Порядок следования разноцветных точек на листе бумаги по определенным правилам является графической информацией. Порядок следования музыкальных нот является музыкальной информацией. Порядок следования генов в ДНК является наследственной информацией. Порядок следования битов в ЭВМ является компьютерной информацией и т.д. и т.п. Для осуществления информационного обмена требуется наличие необходимых и достаточных условий.

Информация (Information) – это

Необходимые условия:

– наличие не менее двух различных объектов материального или нематериального мира;

– наличие у объектов общего свойства, позволяющего идентифицировать объекты в качестве носителя информации;

– наличие у объектов специфического свойства, позволяющего различать объекты друг от друга;

– наличие свойства пространства, позволяющее определить порядок следования объектов. Например, расположение письменной информации на бумаге — это специфическое свойство бумаги, позволяющее располагать буквы слева направо и сверху вниз.

Достаточное условие одно: наличие субъекта, способного распознавать информацию. Это человек и человеческое общество, общества животных, роботов и т.д. Информационное сообщение строится путем выбора из базиса копий объектов и расположение этих объектов в пространстве в определенном порядке. Длина информационного сообщения определяется как количество копий объектов базиса и всегда выражается целым числом. Необходимо различать длину информационного сообщения, которое всегда измеряется целым числом, и количество знаний, содержащегося в информационном сообщении, которое измеряется в неизвестной единице измерения. С математической точки зрения информация — это последовательность целых чисел, которые записаны в вектор. Числа — это номер объекта в базисе информации. Вектор называется инвариантом информации, так как он не зависит от физической природы объектов базиса. Одно и то же информационное сообщение может быть выражено буквами, словами, предложениями, файлами, картинками, нотами, песнями, видеоклипами, любой комбинацией всех ранее названных.

Информация (Information) – это

Роль информации в физике

информация – это сведения об окружающем мире (объекте, процессе, явлении, событии), которые являются объектом преобразования (включая хранение, передачу и т.д.) и используются для выработки поведения, для принятия решения, для управления или для обучения.

Характерными чертами информации являются следующие:

– это наиболее важный ресурс современного производства: он снижает потребность в земле, труде, капитале, уменьшает затрата сырья и энергии. Так, например, обладая умением архивировать свои файлы (т.е. имея такую информацию), можно не тратиться на покупку новых дискет;

– Информация вызывает к жизни новые производства. Например, изобретение лазерного луча явилось причиной возникновения и развития производства лазерных (оптических) дисков;

– Информация является товаром, причем продавец информации ее не теряет после продажи. Так, если студент сообщит своему товарищу сведения о расписании занятий в течение семестра, он эти данные не потеряет для себя;

– Информация придает дополнительную ценность другим ресурсам, в частности, трудовым. Действительно, работник с высшим образованием ценится больше, чем со средним.

Как следует из определения, с информацией всегда связывают три понятия:

– источник информации – тот элемент окружающего мира (объект, процесс, явление, событие), сведения о котором являются объектом преобразования. Так, источником информации, которую в данный момент получает читатель настоящего учебного пособия, является информатика как сфера человеческой деятельности;

– Приобретатель информации – тот элемент окружающего мира, который использует информацию (для выработки поведения, для принятия решения, для управления или для обучения). Приобретатель настоящей информации – сам читатель;

– сигнал – материальный носитель, который фиксирует информацию для переноса ее от источника к приобретателю. В данном случае сигнал носит электронный характер. Если же студент возьмет данное пособие в библиотеке, то та же информация будет иметь бумажный носитель. Будучи прочитанной и запомненной студентом, информация приобретет еще один носитель – биологический, когда она “записывается” в память обучаемого.

Сигнал является важнейшим элементом в данной схеме. Формы его представления, а также количественные и качественные характеристики содержащейся в нем информации, важные для приобретателя информации, рассматриваются далее в данном разделе учебника. Основные характеристики компьютера как основного инструмента, выполняющего отображение источника информации в сигнал (связь 1 на рисунке) и “доведение” сигнала до приобретателя информации (связь 2 на рисунке), приводятся в части Компьютер. Структура процедур, реализующих связи 1 и 2 и составляющих информационный процесс, является предметом рассмотрения в части Информационный процесс.

Объекты материального мира находятся в состоянии непрерывного изменения, которое характеризуется обменом энергией объекта с окружающей средой. Изменение состояния одного объекта, всегда приводит к изменению состояния, некоторого другого объекта окружающей среды. Это явление, вне зависимости от того, как, какие именно состояния и каких именно объектов изменились, может рассматриваться, как передача сигнала от одного объекта, другому. Изменение состояния объекта при передаче ему сигнала, называется регистрацией сигнала.

Сигнал или последовательность сигналов образуют сообщение, которое может быть воспринято получателем в том или ином виде, а также в том или ином объёме. Информация в физике есть термин, качественно обобщающий понятия «сигнал» и «сообщение». Если сигналы и сообщения можно исчислять количественно, то можно сказать, что сигналы и сообщения являются единицами измерения объёма информации. Сообщение (сигнал) разными системами интерпретируется по-своему. Например, последовательно длинный и два коротких звуковых сигнала в терминологии азбуки Морзе — это буква де (или D), в терминологии БИОС от компании award — неисправность видеокарты.

Информация (Information) – это

Роль информации в математике

В математике теория информации (математическая теория связи) — раздел прикладной математики, определяющий понятие информации, её свойства и устанавливающий предельные соотношения для систем передачи данных. Основные разделы теории информации — кодирование источника (сжимающее кодирование) и канальное (помехоустойчивое) кодирование. Математика является больше чем научной дисциплиной. Она создает единый язык всей Науки.

Предметом исследований математики являются абстрактные объекты: число, функция, вектор, множество, и другие. При этом большинство из них вводится аксиоматически (аксиома), т.е. без всякой связи с другими понятиями и без какого-либо определения.

Информация (Information) – это

информация не входит в число предметов исследования математики. Тем не менее, слово «информация» употребляется в математических терминах – собственная информация и взаимная информация, относящихся к абстрактной (математической) части теории информации. Однако, в математической теории понятие «информация» связано с исключительно абстрактными объектами – случайными величинами, в то время как в современной теории информации это понятие рассматривается значительно шире – как свойство материальных объектов. Связь между этими двумя одинаковыми терминами несомненна. Именно математический аппарат случайных чисел использовал автор теории информации Клод Шеннон. Сам он подразумевает под термином «информация» нечто фундаментальное (нередуцируемое). В теории Шеннона интуитивно полагается, что информация имеет содержание. Информация уменьшает общую неопределённость и информационную энтропию. Количество информации доступно измерению. Однако он предостерегает исследователей от механического переноса понятий из его теории в другие области науки.

“Поиск путей применения теории информации в других областях науки не сводится к тривиальному переносу терминов из одной области науки в другую. Этот поиск осуществляется в длительном процессе выдвижения новых гипотез и их экспериментальной проверке.” К. Шеннон.

Информация (Information) – это

Роль информации в кибернетике

Основоположник кибернетики Нор берт Винер говорил об информации так:

информация — это не материя и не энергия, информация — это информация”. Но основное определение информации, которое он дал в нескольких своих книгах, следующее: информация — это обозначение содержания, полученное нами из внешнего мира, в процессе приспосабливания к нему нас и наших чувств.

Информация — это основное понятие кибернетики, точно так же экономическая И. — основное понятие экономической кибернетики.

Определений этого термина много, они сложны и противоречивы. Причина, очевидно, в том, что И. как явлением занимаются разные науки, и кибернетика лишь самая молодая из них. И. — предмет изучения таких наук, как наука об управлении, математическая статистика, генетика, теория средств массовой И. (печать, радио, телевидение), информатика, занимающаяся проблемами научно-технической И., и т. д. Наконец, последнее время большой интерес к проблемам И. проявляют философы: они склонны рассматривать И. как одно из основных универсальных свойств материи, связанное с понятием отражения. При всех трактовках понятия И. она предполагает существование двух объектов: источника И. и приобретателя (получателя) И. Передача И. от одного к другому происходит с помощью сигналов, которые, вообще говоря, могут не иметь никакой физической связи с ее смыслом: эта связь определяется соглашением. Напр., удар в вечевой колокол означал, что надо собираться на площадь, но тем, кто не знал об этом порядке, он не сообщал никакой И.

В ситуации с вечевым колоколом человек, участвующий в соглашении о смысле сигнала, знает, что в данный момент могут быть две альтернативы: вечевое собрание состоится или не состоится. Или, выражаясь языком теории И., неопределенное событие (вече) имеет два исхода. Принятый сигнал приводит к уменьшению неопределенности: человек теперь знает, что событие (вече) имеет только один исход — оно состоится. Однако, если заранее было известно, что вече состоится в таком-то часу, колокол ничего нового не сообщил. Отсюда вытекает, что чем менее вероятно (т. е. более неожиданно) сообщение, тем больше И. оно содержит, и наоборот, чем больше вероятность исхода до совершения события, тем меньше И. содержит сигнал. Примерно такие рассуждения привели в 40-х гг. XX в. к возникновению статистической, или “классической”, теории И., которая определяет понятие И. через меру уменьшения неопределенности знания о свершении какого-либо события (такая мера была названа энтропией). У истоков этой науки стояли Н. Винер, К. Шеннон и советские ученые А. Н. Колмогоров, В. А. Котельников и др. Им удалось вывести математические закономерности измерения количества И., а отсюда и такие понятия, как пропускная способность канала И., емкость запоминающих И. устройств и т. п., что послужило мощным стимулом к развитию кибернетики как науки и электронно-вычислительной техники как практического применения достижений кибернетики.

Что касается определения ценности, полезности И. для получателя, то здесь еще много нерешенного, неясного. Если исходить из потребностей экономического управления и, следовательно, экономической кибернетики, то И. можно определить как все те сведения, знания, сообщения, которые помогают решить ту или иную задачу управления (т. е. уменьшить неопределенность ее исходов). Тогда открываются и некоторые возможности для оценки И.: она тем полезнее, ценнее, чем скорее или с меньшими издержками приводит к решению задачи. Понятие И. близко понятию данные. Однако между ними есть различие: данные — это сигналы, из которых еще надо извлечь И. Обработка данных есть процесс приведения их к пригодному для этого виду.

Процесс их передачи от источника к приобретателю и восприятия в качестве И. может рассматриваться как прохождение трех фильтров:

– физического, или статистического (чисто количественное ограничение по пропускной способности канала, независимо от содержания данных, т. е. с точки зрения синтактики);

– семантического (отбор тех данных, которые могут быть поняты получателем, т. е. соответствуют тезаурусу его знаний);

– прагматического (отбор среди понятых сведений тех, которые полезны для решения данной задачи).

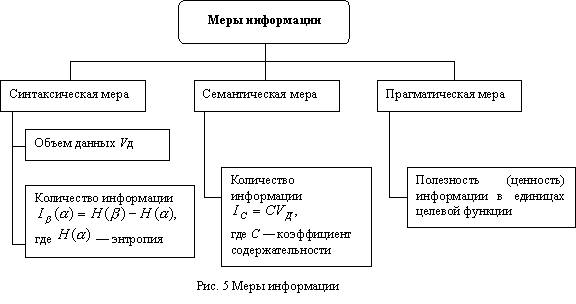

Это хорошо показано на схеме, взятой из книги Е. Г. Ясина об экономической информации. Соответственно выделяются три аспекта изучения проблем И. — синтаксический, семантический и прагматический.

По содержанию И. подразделяется на общественно-политическую, социально-экономическую (в том числе экономическую И.), научно-техническую и т. д. Вообще же классификаций И. много, они строятся по различным основаниям. Как правило, из-за близости понятий точно так же строятся и классификации данных. Напр., И. подразделяется на статическую (постоянную) и динамическую (переменную), и данные при этом — на постоянные и переменные. Другое деление — первичная, производная, выходная И. (так же классифицируются данные). Третье деление — И. управляющая и осведомляющая. Четвертое — избыточная, полезная и ложная. Пятое — полная (сплошная) и выборочная. Эта мысль Винера дает прямое указание на объективность информации, т.е. её существование в природе независимо от сознания (восприятия) человека.

Информация (Information) – это

Объективную информацию современная кибернетика определяет как объективное свойство материальных объектов и явлений порождать многообразие состояний, которые посредством фундаментальных взаимодействий материи передаются от одного объекта (процесса) другому, и запечатлеваются в его структуре. Материальная система в кибернетике рассматривается как множество объектов, которые сами по себе могут находиться в различных состояниях, но состояние каждого из них определяется состояниями других объектов системы.

Информация (Information) – это

В природе множество состояний системы представляет собой информацию, сами состояния представляют собой первичный код, или код источника. Таким образом, каждая материальная система является источником информации. Субъективную (семантическую) информацию кибернетика определяет как смысл или содержание сообщения.

Роль информации в информатике

Предметом изучения науки являются именно данные: методы их создания, хранения, обработки и передачи. Контент (также: «наполнение» (в контексте), «наполнение сайта») — термин, означающий все виды информации (как текстовой, так и мультимедийной — изображения, аудио, видео), составляющей наполнение (визуализированное, для посетителя, содержимое) веб-сайта. Применяется для отделения понятия информации, составляющей внутреннюю структуру страницы/сайта (код), от той, что будет в итоге выведена на экран.

Слово «информация» происходит от латинского слова informatio,что в переводе означает сведение, разъяснение, ознакомление. Понятие «информация» является базовым в курсе информатики, однако невозможно дать его определение через другие, более «простые» понятия.

Можно выделить следующие подходы к определению информации:

– традиционный (обыденный) – используется в информатике: информация – это сведения, знания, сообщения о положении дел, которые человек воспринимает из окружающего мира с помощью органов чувств (зрения, слуха, вкуса, обоняния, осязания).

– вероятностный – используется в теории об информации: информация – это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределённости и неполноты знаний.

Информация храниться, передается и обрабатывается в символьной (знаковой) форме. Одна и та же информация может быть представлена в различной форме:

– знаковой письменной, состоящей из различных знаков среди которых выделяют символьную в виде текста, чисел, спец. символов; графическую; табличную и тд.;

– виде жестов или сигналов;

– устной словесной форме (разговор).

Представление информации осуществляется с помощью языков, как знаковых систем, которые строятся на основе определенного алфавита и имеют правила для выполнения операций над знаками. Язык – определенная знаковая система представления информации. Существуют:

– естественные языки – разговорные языки в устной и письменной форме. В некоторых случаях разговорную речь могут заменить язык мимики и жестов, язык специальных знаков (например, дорожных);

– формальные языки – специальные языки для различных областей человеческой деятельности, которые характеризуются жестко зафиксированным алфавитом, более строгими правилами грамматики и синтаксиса. Это язык музыки (ноты), язык математики (цифры, математические знаки), системы счисления, языки программирования и т.д. В основе любого языка лежит алфавит – набор символов/знаков. Полное число символов алфавита принято называть мощностью алфавита.

Носители информации – среда или физическое тело для передачи, хранения и воспроизведения информации. (Это электрические, световые, тепловые, звуковые, радио сигналы, магнитные и лазерные диски, печатные издания, фотографии и тд.)

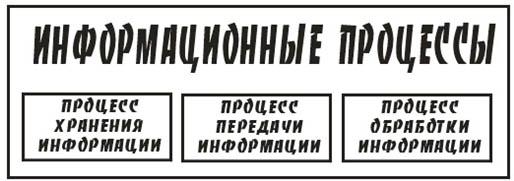

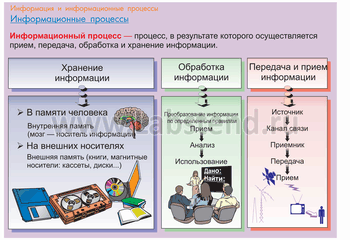

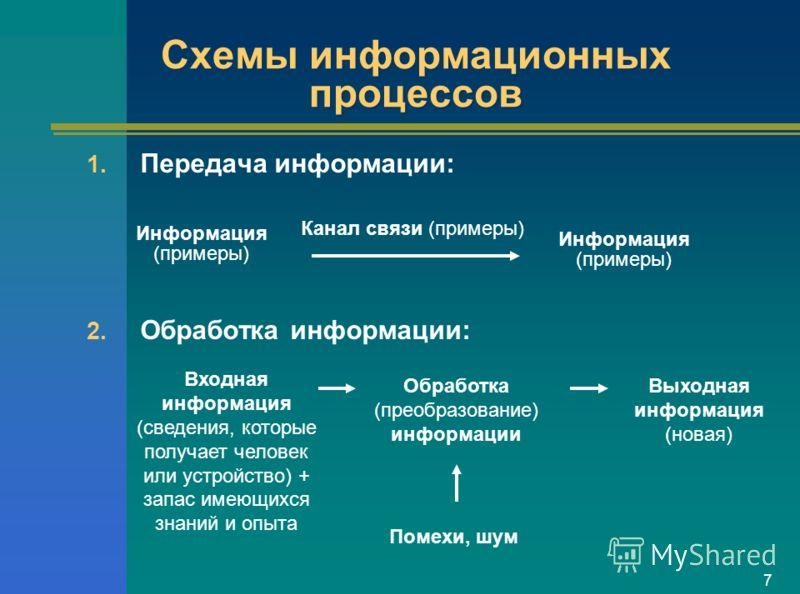

Информационные процессы – это процессы, связанные с получением, хранением, обработкой и передачей информации (т.е. действия, выполняемые с информацией). Т.е. это процессы, в ходе которых изменяется содержание информации или форма её представления.

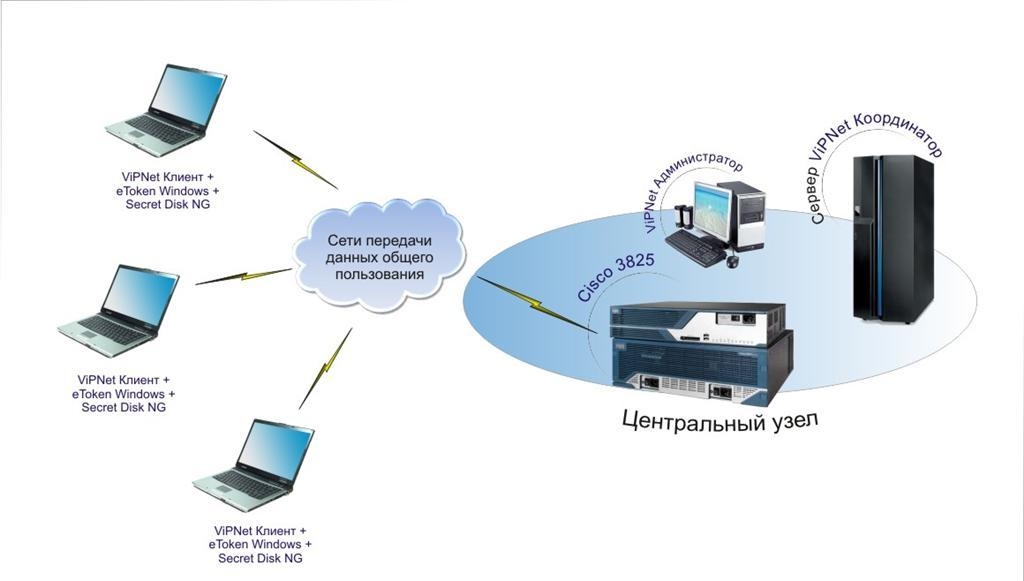

Для обеспечения информационного процесса необходим источник информации, канал связи и приобретатель информации. Источник передает (отправляет) информацию, а приемник её получает (воспринимает). Передаваемая информация добивается от источника до приемника с помощью сигнала (кода). Изменение сигнала позволяет получить информацию.

Свойства информации

Будучи объектом преобразования и использования, информация характеризуется следующими свойствами:

– синтаксис – свойство, определяющее способ представления информации на носителе (в сигнале). Так, данная информация представлена на электронном носителе с помощью определенного шрифта. Здесь же можно рассматривать такие параметры представления информации, как стиль и цвет шрифта, его размеры, междустрочный интервал и т.д. Выделение нужных параметров как синтаксических свойств, очевидно, определяется предполагаемым способом преобразования. Например, для плохо видящего человека существенным является размер и цвет шрифта. Если предполагается вводить данный текст в компьютер через сканер, важен формат бумаги;

– семантика – свойство, определяющее смысл информации как соответствие сигнала реальному миру. Так, семантика сигнала “информатика” заключается в данном ранее определении. Семантика может рассматриваться как некоторое соглашение, известное приобретателю информации, о том, что означает каждый сигнал (так называемое правило интерпретации). Например, именно семантику сигналов изучает начинающий автомобилист, штудирующий правила дорожного движения, познавая дорожные знаки (в этом случае сигналами выступают сами знаки). Семантику слов (сигналов) познаёт обучаемый какому-либо иностранному языку. Можно сказать, что смысл обучения информатике заключается в изучении семантики различных сигналов – суть ключевых понятий этой дисциплины;

– прагматика – свойство, определяющее влияние информации на поведение приобретателя. Так прагматика информации, получаемой читателем настоящего учебного пособия, заключается, по меньшей мере, в успешной сдаче экзамена по информатике. Хочется верить, что этим прагматика данного труда не ограничится, и он послужит для дальнейшего обучения и профессиональной деятельности читателя.

Информация (Information) – это

Следует отметить, что различные по синтаксису сигналы могут иметь одинаковую семантику. Например, сигналы “ЭВМ” и “компьютер” означают электронное устройство для преобразования информации. В этом случае обычно говорят о синонимии сигналов. С другой стороны, один сигнал (т.е., информация с одним синтаксическим свойством) может иметь разную прагматику для потребителей и разную семантику. Так, дорожный знак, известный под названием “кирпич” и имеющий вполне определенную семантику (“въезд запрещен”), означает для автомобилиста запрет на въезд, а на пешехода никак не влияет. В то же время, сигнал “ключ” может иметь разную семантику: скрипичный ключ, родниковый ключ, ключ для открытия замка, ключ, используемый в информатике для кодирования сигнала с целью его защиты от несанкционированного доступа (в этом случае говорят об омонимии сигнала). Есть сигналы – антонимы, имеющие противоположную семантику. Например, “холодный” и “горячий”, “быстрый” и “медленный” и т.д.

Предметом изучения науки информатика являются именно данные: методы их создания, хранения, обработки и передачи. А сама информация, зафиксированная в данных, её содержательный смысл интересны пользователям информационных систем, являющимся специалистами различных наук и областей деятельности: медика интересует медицинская информация, геолога — геологическая, бизнесмена — коммерческая и т.п. (в том числе специалиста по информатике интересует информация по вопросам работы с данными).

Семиотика – наука о информации

Информацию нельзя себе представить без ее получения, обработки, передачи и т.д., то есть вне рамок обмена информацией. Все акты информационного обмена осуществляются посредством символов или знаков, с помощью которых одна система воздействует на другую. Поэтому основной нayкой, изучающей информацию, является семиотика – наука о знаках и знаковых системах в природе и обществе (теория знаков). В каждом акте информационного обмена можно обнаружить три его «участника», три элемента: знак, объект, который он обозначает, и получателя (использователя) знака.

В зависимости от того, отношения между какими элементами рассматриваются, семиотику разделяют на три раздела: синтактику, семантику и прагматику. Синтактика изучает знаки и отношения между ними. При этом она абстрагируется от содержания знака и от его практического значения для получателя. Семантика изучает отношения между знаками и обозначаемыми ими объектами, отвлекаясь при этом от получателя знаков и ценности последних: для него. Понятно, что изучение закономерностей смыслового отображения объектов в знаках невозможно без учета и использования общих закономерностей построения любых знаковых систем, изучаемых синтактикой. Прагматика изучает отношения между знаками и их использователями. В рамках прагматики изучаются все факторы, отличающие один акт информационного обмена от другого, все вопросы практических результатов использования информации и ценности ее для получателя.

При этом неизбежно затрагиваются многие аспекты отношений знаков между собой и с объектами, ими обозначаемыми. Таким образом, три раздела семиотики соответствуют трем уровням абстрагирования (отвлечения) от особенностей конкретных актов обмена информацией. Изучение информации во всем ее многообразии соответствует прагматическому уровню. Отвлекаясь от получателя информации, исключая его из рассмотрения, мы переходим к изучению ее на семантическом уровне. С отвлечением от содержания знаков анализ информации переводится на уровень синтактики. Такое взаимопроникновение основных разделов семиотики, связанное с различными уровнями абстрагирования, можно представить с помощью схемы «Три раздела семиотики и их взаимосвязь». Измерение информации осуществляется соответственно так же в трех аспектах: синтактическом, семантическом и прагматическом. Потребность в таком различном измерении информации, как будет показано ниже, диктуется практикой проектирования и фирмы работы информационных систем. Рассмотрим типичную производственную ситуацию.

В конце смены планировщик участка подготавливает данные о выполнении графика производства. Эта данные поступают в информационно-вычислительный центр (ИВЦ) предприятия, где обрабатываются, и в виде сводок о состоянии производства на текущий момент выдаются руководителям. Начальник цеха на основании полученных данных принимает решение об изменении плана производства на следующий плановый период или принятии каких-либо других организационных мер. Очевидно, что для начальника, цеха количество информации, которое содержала сводка, зависит от величины экономического аффекта, полученного от ее использования при принятии решений, от того, насколько полезны были полученные сведения. Для планировщика участка количество информации в том же сообщении определяется точностью соответствия его фактическому положению дел на участке и степенью неожиданности сообщаемых фактов. Чем они неожиданней, тем быстрее нужно сообщить о них руководству, тем больше информации в данном сообщении. Для работников ИВЦ первостепенное значение будет иметь количество знаков, длина сообщения, несущего информацию, поскольку именно она определяет время загрузки вычислительной техники и каналов связи. При этом ни полезность информации, ни количественная мера смысловой ценности информации их практически не интересует.

Естественно, что организуя систему управления производством, строя модели выбора решения, мы в качестве меры информативности сообщений будем использовать полезность информации. При построении системы учета и отчетности, обеспечивающей руководство данными о ходе производственного процесса за меру количества информации следует принимать новизну полученных сведений. Компания же процедур механической переработки информации требует измерения объема сообщений в виде количества обрабатываемых знаков. Три таких существенно различных подхода к измерению информации не противоречат и не исключают друг друга. Наоборот, измеряя информацию в разных шкалах, они позволяют полнее и всестороннее оценить информативность каждого сообщения и эффективнее организовать систему управления производством. По меткому выражению проф. Н.Е. Кобринского, когда речь идет о рациональной компании потоков информации, количество, новизна, полезность информации оказываются между собой так же связанными, как количество, качество и стоимость продукции в производстве.

Информация в материальном мире

информация — одно из общих понятий, связанных с материей. Информация существует в любом материальном объекте в виде многообразия его состояний и передается от объекта к объекту в процессе их взаимодействия. Существование информации как объективного свойства материи логически вытекает из известных фундаментальных свойств материи — структурности, непрерывного изменения (движения) и взаимодействия материальных объектов.

Структурность материи проявляется как внутренняя расчленённость целостности, закономерный порядок связи элементов в составе целого. Иными словами, любой материальный объект, от субатомной частицы Мета вселенной (Большой взрыв) в целом, представляет собой систему взаимосвязанных подсистем. Вследствие непрерывного движения, понимаемого в широком смысле как перемещение в пространстве и развитие во времени, материальные объекты изменяют свои состояния. Состояния объектов изменяется и при взаимодействиях с другими объектами. Множество состояний материальной системы и всех её подсистем представляет информацию о системе.

Строго говоря, в силу неопределенности, бесконечности, свойства структурности, количество объективной информации в любом материальном объекте бесконечно. Эта информация называется полной. Однако можно выделять структурные уровни с конечными множествами состояний. Информация, существующая на структурном уровне с конечным числом состояний, называется частной. Для частной информации смысл понятие количества информации.

Из приведенного представления логично и просто вытекает выбор единицы измерения количества информации. Представим себе систему, которая может находиться всего в двух равновероятных состояниях. Присвоим одному из них код «1», а другому — «0». Это минимальное количество информации, которое может содержать система. Оно и является единицей измерения информации и называется бит. Существуют и другие, более сложно определяемые, способы и единицы измерения количества информации.