Содержание

§

Вспомогательная страница к разделам ОПРЕДЕЛИТЕЛЬ и

ЛИНЕЙНЫЕ ОТОБРАЖЕНИЯ

Матрица Якоби и якобиан

В настоящем разделе аргументы и значения рассматриваемых функций предполагаются вещественными.

Определение и основные свойства

Матрицей Якоби системы из $ m_{} $ функций

$ {f_1(x_1,dots,x_n),dots,f_m(x_{1},dots,x_n)} $ по переменным $ x_{1},dots,x_n $ называется матрица,

составленная из всевозможных частных производных:

$$

mathbf J = left[ frac{partial f_j}{partial x_k} right]_{j=1,dots,m, atop k=1,dots,n} =

left(

begin{array}{cccc}

{partial f_1}/{partial x_1} & {partial f_1}/{partial x_2} & dots & {partial f_1}/{partial x_n} \

{partial f_2}/{partial x_1} & {partial f_2}/{partial x_2} & dots & {partial f_2}/{partial x_n} \

dots & && dots \

{partial f_m}/{partial x_1} & {partial f_m}/{partial x_2} & dots & {partial f_m}/{partial x_n}

end{array}

right) , .

$$

В частном случае $ m_{}=1 $ матрица Якоби состоит из одной строки:

этот вектор в $ mathbb R_{}^{n} $ или $ mathbb C^{n} $ называется градиентом функции $ f_{} $ (в точке $ (x_1,dots,x_{n}) $):

$$

operatorname{grad} (f) = left( frac{partial f}{partial x_1},dots, frac{partial f}{partial x_n} right) .

$$

Можно сказать, что в общем случае системы функций их матрица Якоби состоит из строк, являющихся градиентами этих функций.

П

Пример. Для системы линейных функций

$$f_1=a_{11}x_1+dots+a_{1n}x_n – b_1,dots, f_m=a_{m1}x_1+dots+a_{mn}x_n – b_m $$

матрица Якоби будет матрицей коэффициентов при переменных:

$$

mathbf J =

left(begin{array}{cccc}

a_{11} & a_{12} & dots & a_{1n} \

dots & && dots \

a_{m1} & a_{m2} & dots & a_{mn}

end{array}

right) .

$$

Откуда возникает матрица Якоби? – Фактически оттуда же, откуда возникает обычная производная: из

необходимости исследовать поведение произвольной нелинейной функции. Что делают при исследовании

функции одной переменной $ y=f_{}(x) $? — Для нее выписывают формулу Тейлора и в этой формуле

$$ f(x) = f(x_0)+f'(x_0)(x-x_0)+dots $$

оставляют только два первых слагаемых, чтобы нелинейную функцию подменить линейной. Геометрически:

график произвольной функции заменяют на график его касательной, и считают, что эти два графика ведут себя

почти одинаково — по крайней мере, локально — в окрестности точки $ x_{0} $. То же самое делается

и при исследовании функций нескольких переменных. Пусть, например, задано отображение

$$ x=f_1(u,v), y=f_2(u,v), z=f_3(u,v) $$

некоторой области пространства $ mathbb{R}^{2} $ в пространство $ mathbb{R}^{3} $. Это отображение можно

геометрически интерпретировать, как задание некоторой поверхности в $ mathbb{R}^{3} $ параметрически

(задание параметров $ u_{} $ и $ v_{} $ однозначно определяет точку $ (x_{},y,z) $ поверхности). Если функции

$ f_{j} $ нелинейные, то исследовать поведение такого отображения начинают с его линейного приближения:

выписывают для этих функций формулы Тейлора

$$

f_j(u,v)=f_j(u_0,v_0) + frac{partial f}{partial u} (u-u_0) + frac{partial f}{partial v} (v-v_0)+dots

$$

(частные производные вычисляются в точке $ (u_{0},v_0) $) и отбрасывают нелинейные по $ u-u_0 $ и $ v-v_0 $ слагаемые.

Полученное отображение пространства $ mathbb{R}^{2} $ в пространство $ mathbb{R}^{3} $, по его виду, можно было бы назвать линейным, но в алгебре выражение линейное отображение закреплено за более узким классом отображений, а настоящее относится к классу аффинных:

$$ left(begin{array}{c} x \ y \ z end{array} right) =

left(begin{array}{c} x_0 \ y_0 \ z_0 end{array} right) +

left( begin{array}{cc}

partial f_1/ partial u & partial f_1/ partial v \

partial f_2/ partial u & partial f_2/ partial v \

partial f_3/ partial u & partial f_3/ partial v

end{array} right)

left(begin{array}{c} u-u_0 \ v-v_0 end{array} right)

$$

при

$$

left(begin{array}{c} x_0 \ y_0 \ z_0 end{array} right)=

left(begin{array}{c} f_1(u_0,v_0) \ f_2(u_0,v_0) \ f_3(u_0,v_0) end{array} right) .

$$

Геометрически: график параметрически заданной поверхности заменяют на график ее касательной плоскости и считают, что эти два

графика ведут себя почти одинаково — по крайней мере, локально,— в окрестности точки $ (x_0,y_0,z_0) $.

В частном случае $ m=n_{} $ матрица Якоби становится квадратной и тогда ее определитель называется якобианом

или определителем Якоби или функциональным определителем системы из $ n_{} $ функций

$ {f_1(x_1,dots,x_n),dots,f_{n}(x_1,dots,x_n)} $ по переменным $ x_{1},dots,x_n $:

$$

{mathfrak J}(x_1,dots,x_n)=frac{D(f_1,f_2,dots,f_n)}{D(x_1,x_2,dots,x_n)}=

$$

$$

=left|

begin{array}{cccc}

{partial f_1}/{partial x_1} & {partial f_1}/{partial x_2} & dots & {partial f_1}/{partial x_n} \

{partial f_2}/{partial x_1} & {partial f_2}/{partial x_2} & dots & {partial f_2}/{partial x_n} \

dots & && dots \

{partial f_n}/{partial x_1} & {partial f_n}/{partial x_2} & dots & {partial f_n}/{partial x_n}

end{array}

right|= det left[ frac{partial f_j}{partial x_k} right]_{j,k=1}^n .

$$

В этом же случае след матрицы Якоби называется дивергенцией вектора $ (f_1,f_2,dots,f_n) $:

$$ operatorname{div} (f_1,f_2,dots,f_n)= {partial f_1}/{partial x_1}+ {partial f_2}/{partial x_2}+dots+ {partial f_n}/{partial x_n} .

$$

В англоязычной литературе термин Jacobian часто относится и к матрице Якоби.

П

Пример. Якобиан системы двух функций $ {f_1(x,y), f_2(x,y) } $ равен

$$

mathfrak J(x,y)=frac{partial f_1}{ partial x} frac{partial f_2}{ partial y} –

frac{partial f_1}{ partial y} frac{partial f_2}{partial x} .

$$

Т

Теорема [Якоби]. Если $ A_{j1},dots,A_{jn} $ — алгебраические дополнения элементов $ j_{} $-й строки якобиана, то

$$

frac{partial A_{j1}}{partial x_1}+frac{partial A_{j2}}{partial x_2}+ dots+frac{partial A_{jn}}{partial x_n}

equiv 0 , .

$$

Предполагается, что производные, входящие в левую часть тождества, существуют.

Функциональная зависимость

Следующая теорема и ее следствия являются прямыми обобщениями соответствующих результатов из линейной алгебры.

Т

Теорема. Якобиан системы функций $ { f_{1},f_2,dots,f_n } $ тождественно равен нулю в некоторой области $ mathbb{S}_{} $:

$$

frac{D(f_1,f_2,dots,f_n)}{D(x_1,x_2,dots,x_n)} equiv 0 mbox{ } mbox{при} mbox{ } X in mathbb{S}

$$

тогда и только тогда, когда между этими функциями имеется функциональная зависимость

в $ mathbb{S} $, т.е. существует функция $ G(y_1,y_2,dots,y_n) notequiv 0 $ такая, что

$$

G(f_1(X),f_2(X),dots,f_n(X))equiv 0 mbox{ } mbox{при} mbox{ } X in mathbb{S} .

$$

В частном случае, когда в качестве $ G(y_1,y_2,dots,y_n) $ можно выбрать линейный однородный полином $ G(y_1,y_2,dots,y_n)=a_1y_1+a_2y_2+dots+a_n y_n $, говорят о линейной зависимости.

Приведем соображения, показывающие необходимость обращения якобиана в нуль для существования функциональной зависимости в системе функций $ { f_j } $. Дополнительно предположим, что у функции $ G $ существуют частные производные по ее аргументам. Продифференцируем тождество $ G(f_1(X),f_2(X),dots,f_n(X))equiv 0 $ по $ x_1,dots,x_n $. Получим систему тождеств

$$

left{begin{array}{cccc}

frac{partial G}{partial y_1} frac{partial f_1}{partial x_1}+ & frac{partial G}{partial y_2} frac{partial f_2}{partial x_1}+ &dots + frac{partial G}{partial y_n} frac{partial f_n}{partial x_1} & equiv 0, \

dots & & & dots \

frac{partial G}{partial y_1} frac{partial f_1}{partial x_n}+ & frac{partial G}{partial y_2} frac{partial f_2}{partial x_n}+ &dots + frac{partial G}{partial y_n} frac{partial f_n}{partial x_n} & equiv 0;

end{array}

right.

$$

здесь после вычисления производных $ {partial G / partial y_j } $ следует произвести подстановку $ y_1=f_1(X),dots,y_n=f_n(X) $. Получившуюся систему можно рассматривать как линейную однородную относительно этих последних выражений. Хотя бы одна из них не должна быть тождественно нулевой (в противном случае функция $ G $ не содержала бы ни одной функции $ f_j $). Но тогда для совместности системы необходимо, чтобы ее определитель был равен нулю. Этот определитель, с точностью до транспонирования, совпадает с якобианом.

П

Пример. Являются ли полиномы

$$ f_1=x_1+x_2+x_3-1,quad f_2=x_1x_2+x_1x_3+x_2x_3-2,quad f_3=x_1^2+x_2^2+x_3^2+3 $$

функционально зависимыми?

Решение.

$$

frac{D(f_1,f_2,f_3)}{D(x_1,x_2,x_3)}=

$$

$$

=

left|

begin{array}{ccc}

1 & 1 & 1 \

x_2+x_3 & x_1+x_3 & x_1+x_2 \

2x_1 & 2x_2 & 2x_3

end{array}

right| = 2 left|

begin{array}{ccc}

1 & 1 & 1 \

x_2+x_3 & x_1+x_3 & x_1+x_2 \

x_1 & x_2 & x_3

end{array}

right|=

$$

$$

=

left|

begin{array}{ccc}

1 & 1 & 1 \

x_1+x_2+x_3 & x_1+x_2+x_3 & x_1+x_2+x_3 \

x_1 & x_2 & x_3

end{array}

right|equiv 0

$$

(мы воспользовались здесь свойствами

4

и

5

определителя, выписанными

☞

ЗДЕСЬ ). Ответ оказывается положительным: рассматриваемые полиномы являются функционально зависимыми. В данном примере эта зависимость сравнительно просто «отлавливается» наметанным взглядом:

$$(f_1+1)^2-2(f_2+2)-(f_3-3) equiv 0 . $$

♦

В общем же случае установление конкретной «обнуляющей» формулы

$$ G(f_1(X),f_2(X),dots,f_n(X))equiv 0 $$

представляет собой отдельную и, как правило, непростую задачу.

=>

Если какие-то $ mathfrak r $ функций системы $ { f_{1}, dots, f_n } $ связаны в $ mathbb{S} $

функциональным соотношением

$$

H(f_{j_1}, dots, f_{j_{mathfrak r}}) equiv 0 ,

$$

то любой минор порядка $ mathfrak r $ якобиана, выбранный из соответствующих строк, будет тождественно равен нулю в

$ mathbb{S}_{} $.

=>

Пусть $ mathfrak r_{} $ обозначает ранг матрицы Якоби системы функций

$ {f_1,dots,f_{m} } $ по переменным $ x_{1},dots,x_n $. Если минор этой матрицы

$$

frac{D(f_1,dots,f_{mathfrak r})}{D(x_1,dots,x_mathfrak r)}

$$

отличен от нуля в $ mathbb{S}_{} $, то функции $ f_1,dots,f_{mathfrak r} $ функционально независимы в

$ mathbb{S} $, а все оставшиеся функции системы (при условии $ mathfrak r < m $) могут быть выражены в

виде (сложных) функций от этих независимых:

$$

f_{mathfrak r+1}(x_1,dots,x_n) equiv G_{mathfrak r+1}(f_1,dots,f_{mathfrak r}),dots,

f_{m}(x_1,dots,x_n) equiv G_m(f_1,dots,f_{mathfrak r}) .

$$

Сложная функция

Якобиан обладает свойствами, аналогичными свойствам обычной производной для функции одной переменной.

Так, следующий результат является аналогом правила дифференцирования сложной функции1).

$$

frac{d, F(f(x))}{d, x} equiv frac{d, F(y)}{d, y}Bigg|_{y=f(x)} frac{d, f(x)}{d, x} , .

$$

Т

Теорема. Якобиан системы сложных функций

$$ F_1(x_1,dots,x_n)=f_1(y_1(x_1,dots,x_n),dots,y_n(x_1,dots,x_n)),dots,$$

$$ F_n(x_1,dots,x_n)=f_n(y_1(x_1,dots,x_n),dots,y_n(x_1,dots,x_n)) $$

вычисляется по правилу умножения:

$$

frac{D(F_1,dots,F_n)}{D(x_1,dots,x_n)}=

frac{D(f_1,dots,f_n)}{D(y_1,dots,y_n)}cdot frac{D(y_1,dots,y_n)}{D(x_1,dots,x_n)} .

$$

где производные вычислены в соответствующих точках.

П

Пример [1]. Вычислить якобиан элементарных симметрических полиномов:

$$

f_1=sum_{1 le jle n} x_j = x_1+ dots+ x_n,

$$

$$

f_2=sum_{1le j_1<j_2le n} x_{j_1} x_{j_2}= x_1 x_2 +

x_1 x_3 +dots + x_2 x_3

+ dots+ x_{n-1}x_n,

$$

$$

f_3=sum_{1le j_1<j_2<j_3le n} x_{j_1} x_{j_2}x_{j_3}=

x_1 x_2 x_3+ x_1 x_2 x_4 + dots+

x_{n-2} x_{n-1} x_n,

$$

$$

dots

$$

$$

f_{n-1}=x_{1} x_{2}times dots times x_{n-1}

+ x_{1} x_{2} times dots times x_{n-2} x_n

+ dots + x_{2} x_{3}times dots times x_n,

$$

$$ f_n= x_{1} x_{2}times dots times x_{n} .$$

Решение. Воспользуемся следствием к теореме Варинга.

Составим набор новых симметрических полиномов:

$$ { s_1,dots,s_n } quad npu quad s_j=x_1^j+x_2^j+dots+x_n^j . $$

Из формул Варинга следует, что $ s_j $ выражаются через $ f_1,dots,f_j $ по формулам

$$ s_jequiv Psi(f_1,dots,f_{j-1}) + j f_j quad npu quad j in {1,dots,n } . $$

Воспользуемся теоремой:

$$

frac{D(s_1,dots,s_n)}{D(x_1,dots,x_n)} equiv frac{D(s_1,dots,s_n)}{D(f_1,dots,f_n)}cdot frac{D(f_1,dots,f_n)}{D(x_1,dots,x_n)} ;

$$

искомый якобиан определится из этой формулы если мы вычислим два других.

Определитель

$$

frac{D(s_1,dots,s_n)}{D(f_1,dots,f_n)}

$$

является определителем треугольной матрицы:

$$

frac{D(s_1,dots,s_n)}{D(f_1,dots,f_n)}=

left|

begin{array}{ccccc}

1 & 0 & 0 & dots & 0 \

ast & 2 & 0 & dots & 0 \

ast & ast & 3 & dots & 0 \

vdots & & & ddots & vdots \

ast & ast & ast & dots & n

end{array}

right| ,

$$

а определитель

$$

frac{D(s_1,dots,s_n)}{D(x_1,dots,x_n)}=

left|

begin{array}{cccc}

1 & 1 & dots & 1 \

2x_1 & 2x_2 & dots & 2x_n \

3x_1^2 & 3x_2^2 & dots & 3x_n^2 \

vdots & & & vdots \

nx_1^{n-1} & nx_2^{n-1} & dots & nx_n^{n-1}

end{array}

right|= n!

left|

begin{array}{cccc}

1 & 1 & dots & 1 \

x_1 & x_2 & dots & x_n \

x_1^2 & x_2^2 & dots & x_n^2 \

vdots & & & vdots \

x_1^{n-1} & x_2^{n-1} & dots & x_n^{n-1}

end{array}

right|

$$

вычисляется как определитель Вандермонда.

Ответ. $ displaystyle prod_{1le j < k le n} (x_k-x_j) $.

Замена переменных и обратное отображение

Условие существования функции, обратной к $ y=f(x) $, т.е. функции $ varphi $ такой, что $ varphi(f(x))equiv x $ (или, эквивалентно, $ f(varphi(y)) equiv y $),

формулируются в математическом анализе.

Т

Теорема. Пусть $ f(x) $ является непрерывно дифференцируемой функцией в некоторой окрестности точки $ x_0 $ и $ f^{prime} (x_0) ne 0 $. Тогда существует окрестность точки $ y_0=f(x_0) $, такая, что для любого значения $ y $ из этой окрестности существует единственное решение уравнения

$$ f(x)=y $$

относительно $ x $, лежащее в окрестности точки $ x_0 $. Иными словами: в упомянутой окрестности точки $ y_0 $

существует и однозначно определяется непрерывная функция $ varphi (y) $ такая, что

$$ f(varphi(y)) equiv y, varphi(y_0)=x_0 , . $$

В этой окрестности функция $ varphi $ является непрерывно дифференцируемой и выполняется равенство

$$ varphi^{prime} (y) = frac{1}{f^{prime} (x)} $$

для значений $ x $ и $ y $, связанных равенством $ y=f(x) $.

Конструктивных аналитических способов нахождения функции, обратной к заданной $ y=f(x) $ можно сказать, что и нет. Задача сводится к разрешению этого уравнения относительно $ x $. Однако уже для полиномиальных

$ f(x) $ решение такого уравнения в «хороших» функциях, т.е. в радикалах, возможно, в общем случае, только для $ deg f<5 $.

П

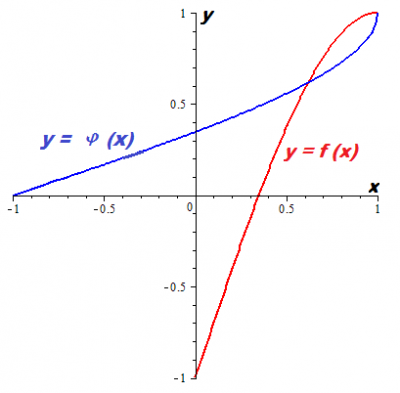

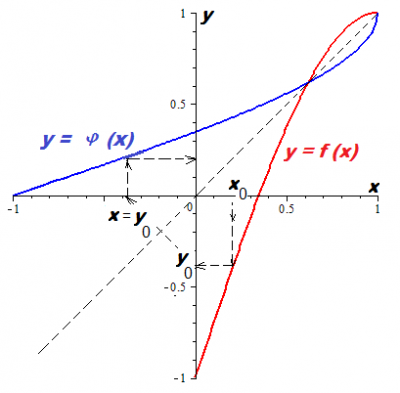

Пример. Найти функцию, обратную к функции $ y=-x^3+3,x-1 $, заданной на интервале $ [0,1] $.

Решение. Условие теоремы на указанном интервале выполнено: обратная функция $ x = varphi(y) $ существует на интервале $[-1,1] $. Решение кубического относительно $ x $ уравнения $x^3-3,x+(y+1)=0 $ произведем по формуле Кардано. Из трех корней, которые можно получить из этой формулы, мы выбираем

$$

varphi(y)=left(-frac{1}{2}-mathbf i frac{sqrt{3}}{2} right)u_1(y)+left(-frac{1}{2}+mathbf i frac{sqrt{3}}{2} right)frac{1}{u_1(y)} quad mbox{ при } u_1(y) =

sqrt[3]{-frac{1}{2}-frac{1}{2}y+frac{1}{2}sqrt{y^2+2,y-3}} , ,

$$

а $ mathbf i $ означает мнимую единицу. Очевидно невещественный ответ вызывает, мягко говоря, недоумение. На самом деле присутствие здесь мнимых чисел является иллюзией (т.е. они, в самом деле мнимые). Поясню. Так, при $ y=1 $ имеем $ u_1(1)=sqrt[3]{-1} $. Корень кубический от комплексной переменной является многозначной функцией, но мы условимся придавать ей значения по правилу

$$

sqrt[3]{cos theta + mathbf i sin theta }=cos frac{theta}3 + mathbf i sin frac{theta}3 quad mbox{ при }

thetain [0,2pi[ , .

$$

Тогда $ u_1(1)=-1 $ и $ varphi(1) = 1 $. При всех значениях $ y $ из интервала $ [-1,1[ $ выражение под квадратным радикалом, а именно $ y^2+2,y-3 $ отрицательно, т.е.

$$

sqrt{y^2+2,y-3}=pm mathbf i sqrt{|y^2+2,y-3|}

$$

(в правой части здесь стоит корень арифметический). Получаем еще одну неоднозначность в определении функции.

Разрешаем ее по тому же принципу, что и для корня кубического, полагая

$$

sqrt{cos theta + mathbf i sin theta }=cos frac{theta}2 + mathbf i sin frac{theta}2 quad mbox{ при }

thetain [0,2pi[ , .

$$

С учетом этих договоренностей получаем, к примеру, :

$$

u_1(0)= sqrt[3]{-frac{1}{2}+frac{1}{2}sqrt{-3}} = cos frac{2pi}9+ mathbf i sin frac{2pi}9 ,

$$

и

$$

varphi(0)= left( cos frac{4pi}3+ mathbf i sin frac{4pi}3 right) left( cos frac{2pi}9+ mathbf i sin frac{2pi}9 right)+left( cos frac{2pi}3+ mathbf i sin frac{2pi}3 right)

left( cos frac{2pi}9 – mathbf i sin frac{2pi}9 right)=

$$

$$

= 2cos frac{14 pi}9 = 2cos frac{5 pi}9 , .

$$

То есть получилось вещественное число.

Можно проверить (см.

ЗДЕСЬ)

, что оно действительно является корнем уравнения $x^3-3,x+1=0 $.

Это парадоксальное решение задачи — когда вещественный ответ выражается через мнимые числа — является следствием так называемого неприводимого случая в формуле Кардано. Любые попытки избавления ответа от присутствия мнимых чисел приводят к усложнению формул: вместо радикалов приходится привлекать тригонометрические функции (и обратные к ним).

Насколько сложным оказалось аналитическое представление обратной функции даже в сравнительно простом примере! И это при том, что графическое ее представление не составляет труда. Если изобразить график обратной функции, поменяв местами переменные, т.е. изобразив график $ y= varphi(x) $, то получим

кривую, зеркально симметричную кривой $ y=f(x) $ относительно прямой $ y = x $.

Мы легко можем найти сколь угодно много (но конечное число) точек на кривой: вычисление пар $ (x_j, f(x_j)) $ не представляет труда. А кстати: почему бы не воспользоваться этой возможностью? — Хотя бы для приближения, аппроксимации обратной функции.

У нас имеется прекрасный аппарат для этого: интерполяция.

$$

begin{array}{c|ccccccccc}

x & 0 & 0.1 & 0.2 & 0.3 & 0.4 & 0.5 & 0.6 & 0.7 & 0.8 & 0.9 \ hline

-x^3+3,x-1 & -1.000 & -0.701 & -0.408 & -0.127 & 0.136 & 0.375 & 0.584 & 0.757 & 0.888 & 0.971

end{array}

$$

Переворачиваем таблицу

$$

begin{array}{c|ccccccccc}

y & -1.000 & -0.701 & -0.408 & -0.127 & 0.136 & 0.375 & 0.584 & 0.757 & 0.888 & 0.971 \ hline

x & 0 & 0.1 & 0.2 & 0.3 & 0.4 & 0.5 & 0.6 & 0.7 & 0.8 & 0.9

end{array}

$$

и вычисляем интерполяционный полином (см. пункт ОБРАТНАЯ ИНТЕРПОЛЯЦИЯ):

$$

widetilde{varphi}(y)=

0.827y^9-0.337y^8-1.308y^7+0.654y^6+0.610y^5-0.283y^4-0.034 y^3+0.094 y^2+0.379y+0.347 , .

$$

Проверка:

$$ varphi(0) = 2cos (5 pi/9) approx 0.3472963546 , varphi^{prime}(0) = frac{1}{3left(1-4cos^2 5pi/9right)} approx 0.3790526807.$$

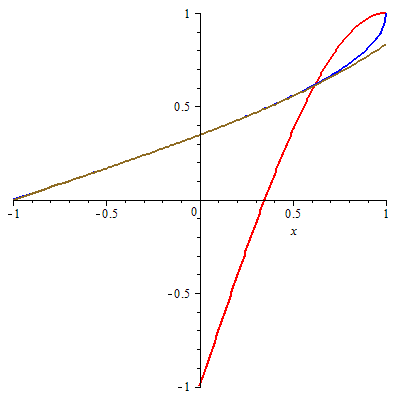

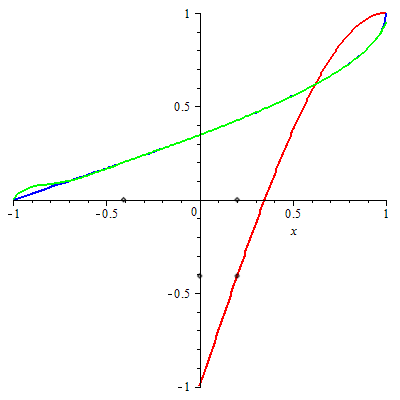

На графике внизу кривая $ y = widetilde{varphi}(x)$

изображена заленым цветом.

И только близко к точке $ x=-1 $ заметно расхождение с $ y= varphi(x) $.

♦

В альтернативу интерполяции, можно поставить задачу об аппроксимации обратной функции с помощью степенных рядов. Составим формальный ряд

$$

varphi(y)=B_0+B_1(y-y_0) + B_2(y-y_0)^2+ dots + B_k(y-y_0)^k+ dots

$$

Для значения $ y_0 $ из теоремы получаем два коэффициента этого ряда

$$ B_0=x_0, B_1= 1/f^{prime} (x_0) , . $$

Как получить следующий коэффициент $ B_2 $? Заметим, что если бы у обратной функции существовала бы вторая производная, то $ B_2 $ был бы следующим коэффициентом ряда Тейлора:

$$ B_2 = varphi^{prime prime}(y_0)/2 , . $$

Для получения выражения

$ varphi^{prime prime}(y_0) $ продифференцируем по $ y $ тождество $ f(varphi(y)) equiv y $. Тождество останется справедливым

$$ f^{prime}_x(varphi(y)) varphi^{prime}_y(y)equiv 1 , . $$

При подстановке сюда $ y=y_0 $ получаем уже известное нам равенство $ f^{prime}_x(x_0)varphi^{prime}_y(y_0)=1 $.

Но если продифференцировать еще раз, то получим

$$ f^{prime prime}_{x^2}(varphi(y)) left(varphi^{prime}_y(y)right)^2+f^{prime}_x(varphi(y)) varphi^{prime prime}_{y^2}(y)equiv 0 , . $$

При подстановке сюда $ y=y_0 $ получаем

$$ varphi^{prime prime}_{y^2}(y_0)=- frac{f^{prime prime}_{x^2}(x_0)}{[f^{prime}_x(x_0)]^3} $$

в дополнительном предположении, что вторая производная от $ f(x) $ существует. Вычисление остальных старших производных $ varphi(y) $ в точке $ y_0 $ производится аналогичным приемом — лишь бы только существовали эти производные для функции $ f(x) $.

$$ varphi^{prime prime prime}_{y^3}(y_0)=

frac{3,[f^{prime prime}_{x^2}(x_0)]^2- f^{prime}_x(x_0)f^{prime prime prime}_{x^3}(x_0) }{[f^{prime}_x(x_0)]^5} ,

$$

$$

varphi^{[4]}_{y^3}(y_0)=

$$

А для выведения общей формулы $ varphi^{[k]}_{y^k}(y_0) $ используется формула Фаа-ди-Бруно.

При полиномиальной $ f(x) $ ряд Тейлора для обратной функции всегда может быть построен.

П

Пример. Для функции $ y=-x^3+3,x-1 $ приведенного выше примера первые $ 8 $ членов разложение обратной функции в ряд Тейлора в точке $ y_0=-1 $ имеют вид

$$

widehat{varphi}(y)= frac{1}{3}(y+1)+frac{1}{81}(y+1)^3+frac{1}{729}(y+1)^5 +frac{4}{19683}(y+1)^7 , .

$$

На графике внизу кривая $ y = widehat{varphi}(x)$ изображена цветом охры.

И только близко к точке $ x=1 $ заметно расхождение с $ y= varphi(x) $.

♦

Фактически же задача свелась к задаче Коши для обыкновенного дифференциального уравнения. Так, для поиска

функции, обратной к $ f(x)= -x^3+3,x-1 $, рассматриваемой в окрестности точки $ x_0=0 $, мы должны проинтегрировать

дифференциальное уравнение

$$

frac{d varphi } {d, y} = frac{1}{-3 varphi^2+3}

$$

с начальным условием $ varphi(-1)=0 $. Поиск решения этого уравнения можно производить как в виде ряда (и мы только что это проделали), так и каким-нибудь численным методом. Хотя бы и Эйлера…

Теорема утверждает, что обратная функция будет определена в окрестности точки $ y_0 $, удовлетворяющей условию.

Насколько большой можно сделать эту окрестность? Ограничимся случаем полиномиальных $ f(x) $. При движении от точки $ y_0 $ вправо или влево по числовой оси значения $ varphi^{prime}(y) $ меняются непрерывным образом и стремятся к бесконечности только когда соответствующие значения $ x $ стремятся к корням полинома $ f^{prime}(x) $. Если этот полином имеет вещественные корни, и $ mu_1 < mu_2 $ — два соседних, то на интервале между точками $ f(mu_1) $ и $ f(mu_2) $ определена обратная функция $ varphi(y) $, отображающая этот интервал в $ ]mu_1, mu_2[ $. Эти границы существования обратной функции можно считать жесткими: если выполняются условия $ f^{prime prime}(mu_1) ne 0, f^{prime prime}(mu_2) ne 0 $ (а они, как правило, для случайно выбранного полинома выполняются), то расширение интервала существования невозможно.

Переход к случаю нескольких переменных начнем с линейного случая: равенства

$$

left{begin{array}{ccc}

y_1 &=&a_{11}x_1 +a_{12}x_2+ldots+a_{1n}x_n \

y_2 &=& a_{21}x_1 +a_{22}x_2+ldots+a_{2n}x_n \

ldots& & ldots \

y_n &=&a_{n1}x_1 +a_{n2}x_2+ldots+a_{nn}x_n

end{array}right.

$$

при фиксированных коэффициентах $ {a_{jk} } $ задают линейное отображение пространства $ mathbb R^n $ в пространство $ mathbb R^n $. Условие существования обратного отображения известно из линейной алгебры: система уравнений однозначно разрешима относительно $ x_1,dots,x_n $ тогда и только тогда, когда

$$

left|

begin{array}{rrrr}

a_{11} & a_{12} & dots & a_{1n} \

a_{21} & a_{22} & dots & a_{2n} \

dots &&& dots \

a_{n1} & a_{n2} & dots & a_{nn}

end{array}

right|

ne 0 .

$$

Обратное отображение задается матрицей, обратной матрице $ A=[a_{jk}]_{j,k=1}^n $:

$$

left(

begin{array}{l}

x_{1} \

x_{2} \

vdots \

x_{n}

end{array}

right) = A^{-1} left(

begin{array}{l}

y_{1} \

y_{2} \

vdots \

y_{n}

end{array}

right) , .

$$

Оба отображения — и прямое и обратное — определены во всем пространстве $ mathbb R^n $. Аналогичное утверждение справедливо и для обобщения линейных отображений — так называемых, аффинных отображений.

А вот с отображениями, которые задаются нелинейными функциями, дело обстоит значительно хуже.

Т

Теорема. Пусть функции $ f(x,y) $ и $ g(x,y) $ непрерывно дифференцируемы в некоторой окрестности точки $ (x_0,y_0) $ и якобиан

$$

frac{D(f,g)}{D(x,y)}=frac{partial f}{partial x}frac{partial g}{partial y}-frac{partial f}{partial y}frac{partial g}{partial x}

$$

отличен от нуля в точке $ (x_0,y_0) $. Тогда существует окрестность точки $(u_0,v_0)=(f(x_0,y_0),g(x_0,y_0)) $, в которой система уравнений

$$

left{ begin{array}{ll}

f(x,y)&=u, \

g(x,y)&=v ,

end{array}

right.

$$

рассматриваемая относительно $ x $ и $ y $, имеет единственное решение в окрестности точки $ (x_0,y_0) $. Иными словами: в упомянутой окрестности точки $(u_0,v_0) $

cуществуют и однозначно определяются непрерывные функции $ varphi(u,v) $ и $ psi(u,v) $ такие, что

$$ f(varphi(u,v),psi(u,v)) equiv u, g(varphi(u,v),psi(u,v)) equiv v, varphi(u_0,v_0)=x_0, psi(u_0,v_0)=x_0 , . $$

Функции $ varphi $ и $ psi $ непрерывно дифференцируемы в этой окрестности, и для их матрицы Якоби выполняется равенство

$$

left(begin{array}{cc}

partial varphi/ partial u & partial varphi/ partial v \

partial psi/ partial u & partial psi/ partial v

end{array}

right)=

left(begin{array}{cc}

partial f/ partial x & partial f/ partial y \

partial g/ partial x & partial g/ partial y

end{array}

right)^{-1} , .

$$

Левая часть этого матричного равенства вычисляется в точках $ (u,v) $, соответствующих точкам $(x,y) $, в которых вычисляется правая часть (т.е. эти пары подчиняются равенствам $ u=f(x,y),v=g(x,y) $).

Обоснование справедливости матричного равенства, связывающего матрицы Якоби прямого и обратного отображений, можно вывести дифференцированием тождеств $ f(varphi(u,v),psi(u,v)) equiv u, g(varphi(u,v),psi(u,v)) equiv v $ по $ u $ и $ v $:

$$

frac{partial f}{partial x}frac{partial varphi}{partial u }+frac{partial f}{partial y}frac{partial psi}{partial u } equiv 1, frac{partial f}{partial x}frac{partial varphi}{partial v }+frac{partial f}{partial y}frac{partial psi}{partial v } equiv 0,

$$

$$

frac{partial g}{partial x}frac{partial varphi}{partial u }+frac{partial g}{partial y}frac{partial psi}{partial u } equiv 0,

frac{partial g}{partial x}frac{partial varphi}{partial v }+frac{partial g}{partial y}frac{partial psi}{partial v } equiv 1 , .

$$

Отображение окрестности точки $ (u_0,v_0) $ в окрестность точки $ (x_0,y_0) $, заданное векторной функцией

$ (varphi(u,v), psi(u,v)) $ из теоремы, называется обратным отображением к отображению $ (f(x,y),g(x,y)) $.

=>

При выполнении условий теоремы, в соответствующих друг другу точках $ (u,v) $ и $ (x,y) $ выполняется равенство

$$

frac{D(varphi,psi)}{D(u,v)}=frac{1}{frac{D(f,g)}{D(x,y)}} , .

$$

П

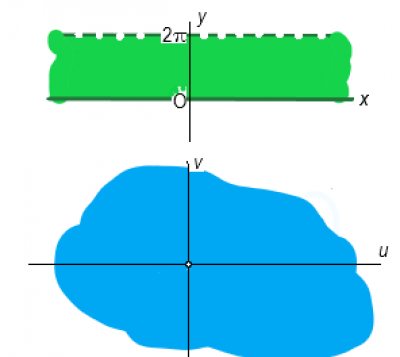

Пример. Отображение

$$ (e^x cos y, e^x sin y } $$

отображает $ (x,y) $-плоскость $ mathbb R^2 $ во множество $ mathbb R^2 setminus (0,0) $ на плоскости $ (u,v) $.

Якобиан

$$

frac{D(u,v)}{D(x,y)} equiv e^{2x}

$$

отличен от нуля во всей плоскости $ (x,y) $. Можно было бы ожидать, что обратное отображение однозначно определено во всей области $ mathbb R^2 setminus (0,0) $. Но очевидно, что это не так: бесконечное множество

$$ {(x,y)=(0,2pi k ) mid k in mathbb Z } $$

отображается в точку $ (u,v)=(1,0) $. Обратное отображение бесконечнозначно. Результат теоремы справедлив если мы рассмотрим отображение любой полосы шириной $ 2 pi $ плоскости $(x,y) $, параллельной оси $ O x $.

Например, полосы $ 0le y < 2 pi $ на область $ mathbb R^2setminus (0,0) $ плоскости $ (u,v) $:

В этом случае обратное отображение задается явным выражением для $ x $:

$$ x=frac{1}{2} ln (u^2+v^2), $$

и условиями

$$

cos y = frac{u}{sqrt{u^2+v^2}}, sin y = frac{v}{sqrt{u^2+v^2}}, yin [0,2pi)

$$

для $ y $. Теперь обратное отображение становится однозначным.

♦

Мы в дальнейшем ограничимся случаем полиномиальных функций. Для этого случая хотя бы можно ожидать, что якобиан будет из того же класса, что и сами функции, т.е. полиномом.

Ну и можно что-то конструктивное сказать о представлении обратных отображений — хотя они уже, как правило, не будут полиномиальными, но задачу их представления можно свести к одномерному случаю.

П

Пример. Найти обратное отображение к отображению

$$

left{ begin{array}{ll}

u=f(x,y):=&-2,x^2+5,xy-3,y^2-2,x+y+2,\

v=g(x,y):=& x^2-2,xy+y^2-x+y+1, .

end{array} right.

$$

Решение. Якобиан

$$

frac{D(f,g)}{D (x,y)}=left|

begin{array}{rr}

-4,x+5,y-2 & 5,x-6,y+1 \

2,x-2,y-1 & -2,x+2,y+1

end{array}

right|=-2,x^2+4,xy-2,y^2+3,x -3,y-1equiv

$$

$$

equiv (-2x+2y+1)(x-y-1) , .

$$

отличен от нуля во всех точках плоскости, за исключением лежащих на прямых $ y=x-1 $ и $ y=x-1/2 $. Согласно теореме, обратное отображение должно существовать, например, в окрестности точки $ (u,v)=(-5,7)=(f(-1,1),g(-1,1)) $.

Для разрешения системы алгебраических уравнений

$ u=f(x,y), v=g(x,y) $

относительно $ x $ и $ y $ применим теорию исключения. Результант системы по переменной $ y $

$$ mathcal X(x)=(1-v)x^2+(u+11,v-9)x+u^2-6,u-34,v+9,v^2+6,uv+21 $$

оказывается квадратным полиномом2) по $ x $. Корни уравнения $ mathcal X(x) =0$ следующие:

$$

frac{u+11v-9pm (u+3v-1)sqrt{4v-3}}{2(v-1)} , .

$$

Из них только соответствующий знаку минус в числителе, т.е.

$$ varphi(u,v):=frac{u+11v-9 – (u+3v-1)sqrt{4v-3}}{2(v-1)} $$

удовлетворяет условию $ varphi(-5,7)=-1 $. Аналогично находим выражение для $ y $:

$$ psi(u,v):=frac{u+10v-8 – (u+2v)sqrt{4v-3}}{2(v-1)} , . $$

Области определения обеих функций одинаковы:

$$ {(u,v) in mathbb R^2 mid vge 3/4, vne 1 } , . $$

Теперь проверим справедливость формулы, связывающей якобианы. Имеем (в окрестности точки $ (-5,7) $)

$$

frac{D(varphi,psi)}{D(u,v)}= frac{1}{2(1-v)sqrt{4v-3}}left[sqrt{4v-3}-1 right] , .

$$

Подстановка сюда $ u=f(x,y), v= g(x,y) $ дает (в окрестности точки $ (1,-1) $)

$$

frac{2(y-x)}{2(2y-2x+1)(y-x)(x-y-1)} equiv left( frac{D(f,g)}{D (x,y)} right)^{-1} , .

$$

♦

Сформулируем обобщение предыдущего результата в $ mathbb R^n $.

Т

Теорема. Если якобиан системы полиномов

$$ { f_1(X), dots , f_n(X) } subset mathbb R[X] $$

отличен от нуля в некоторой точке $ X_0 in mathbb R^n $, то существует окрестность этой точки, в которой система уравнений

$$

y_1=f_1(x_1,dots,x_n),dots,y_n=f_n(x_1,dots,x_n) ,

$$

рассматриваемая относительно переменных $ x_{1},dots,x_n $, имеет единственное решение, лежащее в окрестности точки

$$ Y_0=(f_1(X_0), dots , f_n(X_0)) , . $$

Иными словами: существует и однохначно определяется система непрерывных в окрестности точки $ Y_0 $ функций

$$ { varphi_1(Y),dots, varphi_n(Y)} , $$

таких, что

$$ f_1(varphi_1(Y),dots, varphi_n(Y))equiv y_1,dots, f_n(varphi_1(Y),dots, varphi_n(Y))equiv y_n $$

и

$$ (varphi_1(Y_0),dots, varphi_n(Y_0))=X_0 , .$$

Функции $ {varphi_j(Y) }_{j=1}^n $ непрерывно дифференцируемы в указанной окрестности.

Матрицы Якоби систем функций $ { f_j(X) }_{j=1}^n$ и $ { varphi_j (Y)}_{j=1}^n$ связаны равенством:

$$

left(

begin{array}{cccc}

{partial varphi_1}/{partial y_1} & {partial varphi_1}/{partial y_2} & dots & {partial varphi_1}/{partial y_n} \

dots & && dots \

{partial varphi_n}/{partial y_1} & {partial varphi_n}/{partial y_2} & dots & {partial varphi_n}/{partial y_n}

end{array}

right)=

left(

begin{array}{cccc}

{partial f_1}/{partial x_1} & {partial f_1}/{partial x_2} & dots & {partial f_1}/{partial x_n} \

dots & && dots \

{partial f_n}/{partial x_1} & {partial f_n}/{partial x_2} & dots & {partial f_n}/{partial x_n}

end{array}

right)^{-1} , .

$$

Здесь производные в левых и правых частях равенства вычислены в соответствующих точках.

=>

При выполнении условий теоремы, в соответствующих друг другу точках $ Y $ и $ X $ выполняется равенство

$$

frac{D(varphi_1,dots,varphi_n)}{D(y_1,dots,y_n)} = left(frac{D(f_1,dots,f_n)}{D(x_1,dots,x_n)} right)^{-1} .

$$

Якобиан как коэффициент растяжения

Еще одну важную сущность якобиана сформулируем в решении следующего примера.

П

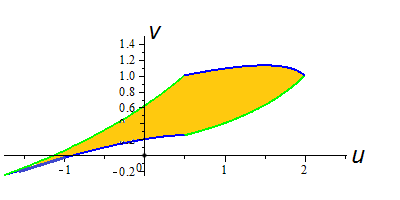

Пример. Отображение

$$

left{ begin{array}{ll}

u=f(x,y):=&-1/2,x^2-3/4,xy-y^2-x-1/2,y+2,\

v=g(x,y):=& 1/4,x^2-1/2,xy-1/2,y^2-x+1/2,y+1

end{array} right.

$$

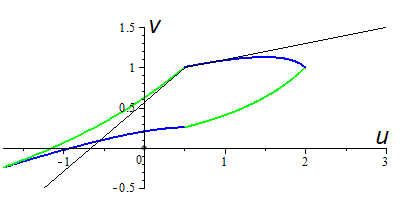

отображает окрестность точки $ (x_0,y_0)=(0,1) $ в окрестность точки $ (u_0,v_0)=(1/2,1) $. Квадрат $ 0 le x le 1, 0 le y le 1$ отображается в область плоскости $ (u,v) $, органиченную параметрически заданными кривыми

$$ {u=f(x,0),v=g(x,0) mid 0 le x le 1}, {u=f(x,1),v=g(x,1) mid 0 le x le 1} , $$

$$ {u=f(0,y),v=g(0,y) mid 0 le y le 1}, {u=f(1,y),v=g(1,y) mid 0 le y le 1} . $$

Как соотносятся между собой площади двух областей: исходного квадрата и его образа?

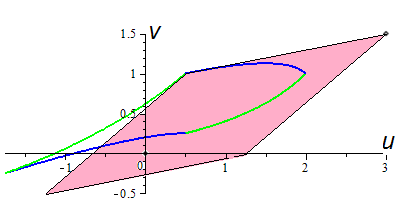

Решение. Для ответа на вопрос надо обладать возможностью вычислить точную площадь области, закрашенной оранжевым на рисунке. Я не уверен, что это можно сделать сведением к случаю «табличных» интегралов, но, по крайней мере, численными

методами можно найти приближение этой площади. Попробуем получить такое приближение, заменив границу области — криволинейную — на параллелограмм. С этой целью проведем в точке $ (u_0,v_0) $ касательные к ограничивающую область кривым:

$$

{ (u,v)= (u_0+ f^{prime}_x(x_0,y_0) t, v_0+ g^{prime}_x(x_0,y_0) t) mid t in mathbb R } mbox{ и }

{ (u,v)=(u_0+ f^{prime}_y(x_0,y_0) tau, v_0+ g^{prime}_y(x_0,y_0) tau )mid tau in mathbb R } , .

$$

и возьмем на них, помимо $ (u_0,v_0) $, точки, соответствующие значениям параметров $ t=1, tau=1 $.

Почему именно такие значения придаем параметрам? — Потому что $ 1 $ — это размер стороны квадрата, взятого на плоскости $ (x,y) $. Нелинейную функцию $ f(x,y_0) $ приближаем линейной функцией $ f(x_0,y_0)+f^{prime}_x (x_0,y_0)(x-x_0) $. Точка $ f(x_0+delta,y_0) $ аппроксимируется значением линейной функции при $ x=delta $.

Эта аппроксимация, в нашем конкретном случае, очевидно неудачная. Как следствие,

площадь получишегося параллелограмма визуально отличается от искомой площади.

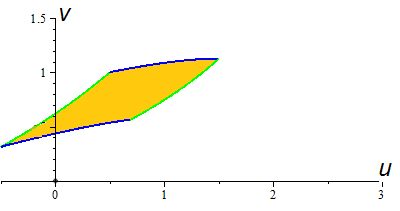

Однако если уменьшить размеры отображаемого квадрата на плоскости $ (x,y) $ до $ 0 le x le 1/2, 1/2le y le 1 $,

то его образ

становится более похожим на параллелограмм

построенный по приведенному выше образцу. В общем случае отображения квадрата размера $ delta times delta $ получаем приближение его образа в виде параллелограмма с вершинами

$$ (u_0,v_0), (u_0+f^{prime}_x delta,v_0 +g^{prime}_x delta), (u_0+f^{prime}_y delta,v_0 +g^{prime}_y delta) , , $$

$$

(u_0+f^{prime}_x delta++f^{prime}_y delta,v_0 +g^{prime}_x delta+g^{prime}_y delta) , .

$$

Здесь все производные вычислены в точке $ (x_0,y_0) $. Воспользовавшись формулой вычисления площади параллелограмма, получаем выражение в виде абсолютной величины (модуля) выражения

$$

left|begin{array}{cc}

f^{prime}_x & g^{prime}_x \

f^{prime}_y & g^{prime}_y

end{array}

right| delta^2 , .

$$

Чем меньше $ delta $ тем меньше отклонение этого приближения от образа квадрата при отображении. Если изображать образы точек под воздействием отображения на той же исходной плоскости, то можно сказать, что абсолютная величина якобиана представляет собой коэффициент сжатия (или растяжения) бесконечно малой области вокруг точки, в которой он вычисляется. В настоящем примере

$$

frac{D(f,g)}{D (x,y)} Bigg|_{(0,1)}= – frac{23}{8} ,

$$

т.е. малая окрестность точки $ (0,1) $ «резиновой» плоскости сдвинется к точке $ (1,-1) $ и растянется примерно в четыре раза.

♦

В частном случае линейного оператора в $ mathbb R^n $, результат становится точным и универсальным для любой точки пространства; см.

☞

ЗДЕСЬ.

Результат существенно используется в задачах замены переменных в кратных интегралах.

$$

int int F(x,y) dx dy leftrightarrow sum F(x_j, y_j) Delta x Delta y leftrightarrow

$$

$$

leftrightarrow sum F(varphi (u_j,v_j), psi(u_j,v_j) ) left| frac{D(varphi,psi)}{D (u,v)} right|_{(u_j,v_j)} Delta u Delta v leftrightarrow

$$

$$

leftrightarrow

int int F(varphi (u,v),psi(u,v)) left| frac{D(varphi,psi)}{D (u,v)} right| du dv , .

$$

Последний интеграл вычисляется по области, являющейся образом области, по которой вычисляется первый интеграл, при

отображении $ x=varphi (u,v), y=psi (u,v) $.

Неявная функция

Обобщением рассмотренного в предыдущем пункте случая, т.е. выражения вектора $ X=(x_1,dots,x_n) $ через вектор $ Y=(y_1,dots,y_n) $ при задании многомерного отображения формулами

$$ Y= (f_1(X),dots,f_n(X)) $$

является случай неявной функции.

В линейном случае, эта задача встречается при записи общего решения системы линейных уравнений. Если эта система

представлена в виде

$$

left{

begin{array}{llllllll}

a_{11}y_1 &+a_{12}y_2&+ ldots&+a_{1n}y_n &+a_{1,n+1}x_{1}&+ldots & +a_{1,n+m}x_{m} -b_1=0,\

a_{21}y_1 &+a_{22}y_2&+ ldots&+a_{2n}y_n &+a_{2,n+1}x_{1}&+ldots & +a_{2,n+m}x_{m} -b_2=0,\

dots & & & & dots & dots & & dots \

a_{n1}y_1 &+a_{n2}y_2&+ ldots&+a_{nn}y_n &+a_{n,n+1}x_{1}&+ldots & +a_{n,n+m}x_{m} -b_n=0

end{array} right.

$$

при $ mge 1 $, то при условии

$$

left|

begin{array}{rrrr}

a_{11} & a_{12} & dots & a_{1n} \

a_{21} & a_{22} & dots & a_{2n} \

dots &&& dots \

a_{n1} & a_{n2} & dots & a_{nn}

end{array}

right|

ne 0

$$

ее можно разрешить относительно переменных $ y_1,dots,y_n $ — например, по формулам Крамера или посредством обратной матрицы:

$$

left(

begin{array}{l}

y_{1} \

y_{2} \

vdots \

y_{n}

end{array}

right) =

–

left(

begin{array}{rrrr}

a_{11} & a_{12} & dots & a_{1n} \

a_{21} & a_{22} & dots & a_{2n} \

dots &&& dots \

a_{n1} & a_{n2} & dots & a_{nn}

end{array}

right)^{-1}

left(

begin{array}{rrr}

a_{1,n+1} & dots & a_{1,n+m} \

a_{2,n+1} & dots & a_{2,n+m} \

dots && dots \

a_{n,n+1} & dots & a_{n,n+m}

end{array}

right)

left(

begin{array}{l}

x_{1} \

\

vdots \

x_{m}

end{array}

right)+

$$

$$

+

left(

begin{array}{rrrr}

a_{11} & a_{12} & dots & a_{1n} \

a_{21} & a_{22} & dots & a_{2n} \

dots &&& dots \

a_{n1} & a_{n2} & dots & a_{nn}

end{array}

right)^{-1}

left(

begin{array}{l}

b_{1} \

\

vdots \

b_{m}

end{array}

right) , .

$$

В случае нелинейного уравнения

$$ f(x,y)=0 , $$

критерий существования неявной функции дается следующей теоремой

Т

Теорема 1 [о неявной функции]. Пусть функция $ f $ — непрерывно дифференцируема в окрестности точки $ (x_0,y_0) $ и

$$ f(x_0,y_0)=0 , partial f /partial y mid_{(x_0,y_0)}ne 0 , .$$

Тогда существует окрестность точки $ x_0 $, в которой уравнение

$ f(x,y)=0 $ имеет единственное вещественное решение относительно $ y $, лежащее в окрестности $ y_0 $. Иными словами:

существует вещественная непрерывная функция $ varphi(x) $, такая, что

$$ varphi(x_0)=y_0, f(x,varphi(x)) equiv 0 $$

(последнее тождество выполняется в заявленной окрестности $ x_0 $). При этом $ varphi(x) $ является непрерывно дифференцируемой функцией в той же окрестности и выполняется тождество

$$ varphi^{prime}(x)equiv-frac{partial f /partial x}{partial f /partial y} Bigg|_{_{(x,varphi(x))}} , . $$

Нахождение явного выражения для $ y=varphi(x) $ является задачей еще более сложной, чем задача предыдущего пункта о нахождении обратной функции. Усложнение проявляется уже в проблеме поиска хотя бы одной точки $ (x_0,y_0) in mathbb R^2 $, удовлетворяющей уравнению $ f(x,y)=0 $. Проблема существования вещественного решения этого уравнения даже для случая полиномиальной функции $ f $ нетривиальна: см. пункт

☞

АЛГЕБРАИЧЕСКИЕ УРАВНЕНИЯ.

Если вещественное решение удастся обнаружить, то нахождение неявной функции можно осуществить построением

ряда Тейлора (или, в общем случае, при нарушении условия теоремы, в виде ряда Пюизё), сходящегося в некоторой окрестности точки $ x_0 $.

Результат теоремы $ 1 $ очевидным образом обобщается на случай неявной функции нескольких переменных: уравнение

$$ f(x_1,dots,x_n, y) = 0 quad mbox{ при } n ge 2 $$

пытаются разрешить относительно $ y $.

Более общую задачу решения системы уравнений относительно нескольких переменных мы рассмотрим в частном случае уравнений алгебраических.

Т

Теорема 2. Пусть имеется система полиномов

$$ { f_1(X,Y), dots , f_m(X,Y) } subset mathbb R[X,Y], m ge 2 $$

от векторов переменных $ X=(x_1,dots,x_n) $ и $ Y=(y_1,dots,y_m) $. Пусть выполнены следующие условия:

-

существует точка $ (X_0,Y_0) in mathbb R^{n+m} $ такая, что

$$ f_1(X_0,Y_0)=0, dots , f_m(X_0,Y_0)=0 , . $$

-

якобиан

$$ frac{D(f_1,dots,f_m)}{D (y_1,dots,y_m)} $$

отличен от нуля в точке $ (X_0,Y_0) $.

Тогда существует окрестность точки $ X_0 $ и в ней система непрерывных функций

$$ {varphi_1 (X),dots, varphi_m(X) } $$

такая, что

$$ (varphi_1 (X_0),dots, varphi_m(X_0))=Y_0 $$

и

$$ f_1(X,varphi_1 (X),dots, varphi_m(X)) equiv 0, dots, f_m(X,varphi_1 (X),dots, varphi_m(X)) equiv 0 , . $$

Система функций $ {varphi_j (X)}_{j=1}^m $ с указанными свойствами единственна и для нее справедливо матричное равенство

$$

left(

begin{array}{cccc}

{partial varphi_1}/{partial x_1} & {partial varphi_1}/{partial x_2} & dots & {partial varphi_1}/{partial x_n} \

dots & & & dots \

{partial varphi_m}/{partial x_1} & {partial varphi_m}/{partial x_2} & dots & {partial varphi_m}/{partial x_n}

end{array}

right) equiv

$$

$$

equiv –

left(

begin{array}{cccc}

{partial f_1}/{partial y_1} & dots & {partial f_1}/{partial y_m} \

dots & & dots \

{partial f_m}/{partial y_1} & dots & {partial f_m}/{partial y_m}

end{array}

right)^{-1}

left(

begin{array}{cccc}

{partial f_1}/{partial x_1} & {partial f_1}/{partial x_2} & dots & {partial f_1}/{partial x_n} \

dots & && dots \

{partial f_m}/{partial x_1} & {partial f_m}/{partial x_2} & dots & {partial f_m}/{partial x_n}

end{array}

right) , .

$$

Рассмотрим сначала самый простой случай:

$$ f(x,y,z)=0, g(x,y,z)=0 , . $$

Будем предполагать, что каждое из уравнений задает некоторую поверхность в $ mathbb R^3 $.

Две неявно заданные алгебраические поверхности в $ mathbb R^3 $ могут не иметь вещественных точек пересечения.

Как установить существование точек пересечения, т.е. наличие вещественных решений системы уравнений? Для полиномимальных

$ f $ и $ g $ этот факт можно установить алгебраическими методами, которые проиллюстрирую на примере.

П

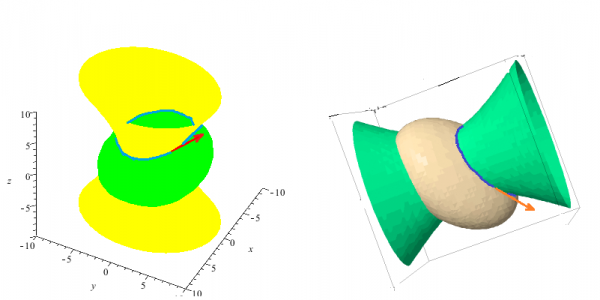

Пример. Пусть заданы две квадрики

$$ f(x,y,z):=frac{x^2}9+frac{y^2}{16}-frac{z^2}{25}-1=0, $$

$$ g(x,y,z):=

111376, x^2-14656, xy+72128, xz+45184, y^2-45184, yz+76096, z^2+

$$

$$

+92136, x-118608, y+205104, z-1913751=0

$$

Первая является однополостным гиперболоидом, а вторая — эллипсоидом. Эти поверхности пересекаются по двум замкнутым кривым $ mathbf K_1 $ и $ mathbf K_2 $. На одной из них выбираем произвольную точку, например

$$ (x_0,y_o,z_0) approx (1.959148, 3.864766, 3) , . $$

Отложив на несколько последующих абзацев ответ на вопрос, как эти координаты найдены, займемся

задачей нахождения касательной к кривой $ mathbf K_1 $ в указанной точке.

Докажем, что в окрестности точки кривую $ mathbf K_1 $ можно представить параметрически

$$ x=varphi_1 (z), y= varphi_2 (z), z= z , . $$

Действительно, матрица Якоби

$$

mathbf J=left(begin{array}{cc}

2/9 x & 1/6 y \

222752, x-14656, y+72128, z + 92136 & -14656, x+90368, y-45184, z-118608

end{array}

right)

$$

имеет ненулевой определитель в точке $ (x_0,y_o,z_0) $.

В соответствии с теоремой 2, параметрическое представление кривой существует в некоторой окрестности точки $ z_0 $.

Явное выражение для функций $ varphi_1, varphi_2 $ — отдельная нетривиальная проблема, но для поставленной конкретной задачи поиска касательной решение этой проблемы не требуется. Действительно, теорема 2 дает представление

$$ (varphi_1^{prime}(z_0), varphi_2^{prime}(z_0),1) approx (-1.052314,1.445142,1) $$

для направляющего вектора касательной в виде явного выражения через значения функций $ f $ и $ g $ (и их производных) в точке $ (x_0,y_0,z_0) $.

А теперь проверим полученный результат альтернативным алгоритмом, задействовав технологию исключения переменных (которую мы уже использовали в предыдущем ПУНКТЕ). Cоставив результант полиномов $ f $ и $ g $ по переменной $ y $, придем к уравнению

$$

F(x,z)=0

$$

при

$$

F(x,z):=mathcal R_y(f,g)=

$$

$$

=frac{425850289}{81}x^4+frac{240241528}{9}x^3z+frac{4457694952}{75}x^2z^2+frac{1396604256}{25},xz^3+frac{23733568656}{625}z^4+

$$

$$

+frac{139478087}{3} x^3+frac{528311126}{3} x^2 z+frac{4561868172}{25} x z^2+frac{3536887608}{25} z^3-

$$

$$

-frac{12342564733}{72}x^2-frac{1212320819}{2}xz-frac{9754043781}{10}z^2-frac{17191161915}{16}x-frac{20624138805}{8}z+frac{1192935588625}{256} , .

$$

Имеем: $ deg_x F=4 $, т.е. уравнение $ F(x,z)=0 $ разрешимо в радикалах относительно $ x $. По крайней мере, теоретически, функцию $ varphi_1(z) $ можно представить в виде конечной комбинации элементарных функций и корней второй и третьей степеней от коэффициентов полинома. Реальное же представление для $ varphi_1(z) $ крайне громоздко и, с точки зрения практического использования, неконструктивно.

Уравнение четвертой степени может иметь от нуля до четырех вещественных корней в зависимости от значений $ z $. При подстановке конкретного значения $z =z_0 in mathbb R $ получаем полином $ F(x,z_0) $ от одной переменной $ x $.

Мы можем однозначно и чисто алгебраическим алгоритмом установить число его вещественных корней. Так,

$$

F(x,3)equiv

$$

$$

equiv frac{425850289}{81}x^4+126573205 x^3+frac{1605258018107}{1800}x^2+frac{20614103217}{80}x-frac{793132431560159}{160000}

$$

имеет два вещественных корня $ approx -3.309237 $ и $ approx 1.959148 $. Второй из них мы и взяли выше в качестве $ x_0 $.

Таким образом, для $ varphi_1(z) $ мы получили представление в виде неявной функции $ F(x,z)=0 $ при заданном значении

$ varphi_1(z_0)=x_0 $. Но тогда для этой функции должна работать теорема 1, которая дает представление

$$ varphi_1^{prime}(z_0)= -frac{partial F /partial z}{partial F /partial x} Bigg|_{_{(x_0,z_0)}} , . $$

Результат совпадает с полученным выше.

Понятно, что для получения $ varphi_2(z) $ мы должны произвести процедуру исключения переменной $ x $ из системы

$ f=0,g=0 $, т.е. вычислить результант $ G(y,z):=mathcal R_x(f,g) $. Далее найти корень полинома $ G(y,z_0) $ (выбрав тот из них, что соответствует уже найденном у значению $ x_0 $) и т.д. Убеждаемся, что

$$ varphi_2^{prime}(z_0)= -frac{partial G /partial z}{partial G /partial y} Bigg|_{_{(y_0,z_0)}} , . $$

Вопроc: какая же связь между матрицей Якоби и результантами $ mathcal R_x(f,g), mathcal R_y(f,g) $ приводит — в результате применения двух различных алгоритмов — к совершенно разным представлениям для $ varphi_1^{prime}(z_0), varphi_2^{prime}(z_0) $, имеющим, тем не менее, одинаковые значения?

♦

=>

Если система полиномов

$${f_1(y_1,dots,y_n,x_1,dots,x_n),dots, f_n(y_1,dots,y_n,x_1,dots,x_n)} $$

удовлетворяет условиям теоремы в некоторой точке $ (X_0,Y_0) in mathbb R^{2n} $,

то существует окрестность точки $ X_0 $, в которой справедливо равенство

$$

frac{D(varphi_1,dots,varphi_n)}{D(x_1,dots,x_n)}=(-1)^n frac{D(f_1,dots,f_n)}{D(x_1,dots,x_n)} bigg/

frac{D(f_1,dots,f_n)}{D(y_1,dots,y_n)} , .

$$

Здесь производные вычислены в соответствующих точках.

Геометрические приложения

Т

Теорема. Пусть на плоскости заданы две кривые уравнениями

$$ f(x,y)=0 quad u quad g(x,y)=0 $$

и они пересекаются в точке $ (x_{0},y_0) $. Тогда величина угла $ gamma $,

под которым происходит это пересечение вычисляется по формуле

$$

operatorname{tg} (gamma) = pm frac{frac{partial f}{partial x} frac{partial g} {partial y} –

frac{partial f}{partial y} frac{partial g}{partial x}}{frac{partial f}{partial x} frac{partial g}{partial x} +

frac{partial f}{partial y}frac{partial g}{partial y}}

$$

где все производные в правой части вычислены в точке $ (x_{0},y_0) $.

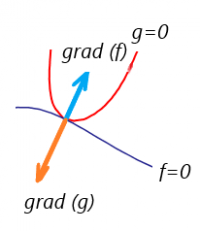

Утверждение следует из свойства градиента: вычисленный в точке кривой, он определяет направляющий вектор нормали к этой кривой.

=>

Если $ (x_{0},y_0) $ — точка пересечения кривых $ f(x,y)=0 $ и $ g(x,y)=0 $, то

-

кривые соприкасаются в этой точке, если в ней якобиан функций $ f_{} $ и $ g_{} $ обращается в нуль:

$$frac{partial f}{ partial x} frac{partial g}{ partial y} –

frac{partial f}{ partial y} frac{partial g}{partial x}= 0 $$

что, в общем-то, предсказуемо, поскольку строки якобиана

$$

left|begin{array}{cc}

partial f / partial x & partial f / partial y \

partial g / partial x & partial g / partial y

end{array}

right| , .

$$

— это координаты градиентов, и обращение якобиана в нуль означает коллинеарность этих градиентов;

-

кривые пересекаются в этой точке под прямым углом, если в ней

$$ frac{partial f}{partial x} frac{partial g}{ partial x} +

frac{partial f}{ partial y} frac{partial g}{ partial y} = 0 .

$$

?

Показать, что если функции $ u_{}(x,y) $ и $ v_{}(x,y) $ связаны соотношениями Коши-Римана

(Даламбера-Эйлера):

$$

frac{partial u}{ partial x} equiv frac{partial v}{ partial y} , frac{partial u}{ partial y}

equiv – frac{partial v}{ partial x}

$$

в некоторой области $ mathbb{S}_{} $, то в этой области их линии уровня, то есть кривые

$ u(x,y) = c_1 $ и $ v(x,y) = c_2 $ при $ {c_1,c_2} subset mathbb R $, могут пересекаться только под прямым углом.

Решение системы нелинейных уравнений

Рассмотрим систему двух вещественных алгебраических уравнений

$$

f(x,y)=0, g(x,y)=0 , .

$$

По аналогии с методом Ньютона решения уравнения от одной неизвестной, попробуем найти вещественное решение этой системы, сгенерировав итерационную последовательность в $ mathbb R^2 $, сходящуюся к этому решению. Допустим, что из каких-то соображений нам удалось установить, что вещественное решение системы существует, и что некоторая точка $ (x_0, y_0) $ достаточно близка к этому решению. Раскладываем полиномы по формуле Тейлора по степеням $ x-x_0, y-y_0 $ и оставляем в этих разложениях только первые слагаемые:

$$

f(x,y)equiv f(x_0,y_0)+ frac{partial f}{partial x}Bigg|_{(x_0,y_0)}(x-x_0)+frac{partial f}{partial y}Bigg|_{(x_0,y_0)}(y-y_0) + dots , ,

$$

$$

g(x,y)equiv g(x_0,y_0)+ frac{partial g}{partial x}Bigg|_{(x_0,y_0)}(x-x_0)+frac{partial g}{partial y}Bigg|_{(x_0,y_0)}(y-y_0) + dots , .

$$

Теперь вместо системы нелинейных уравнений рассматриваем систему

$$

left{

begin{array}{ccc}

f(x_0,y_0)&+ frac{partial f}{partial x}Bigg|_{(x_0,y_0)}(x-x_0)+frac{partial f}{partial y}Bigg|_{(x_0,y_0)}(y-y_0) &= 0,\

g(x_0,y_0)&+ frac{partial g}{partial x}Bigg|_{(x_0,y_0)}(x-x_0)+frac{partial g}{partial y}Bigg|_{(x_0,y_0)}(y-y_0) &= 0

end{array}

right.

$$

линейных уравнений. Она гарантировано имеет решение если матрица

$$

mathbf J=

left(

begin{array}{cc}

partial f /partial x & partial f /partial y \

partial g /partial x & partial g /partial y

end{array}

right)

$$

будет неособенной при $ x=x_0,y=y_0 $. При этом предположении решение системы единственно и может быть выражено в виде

$$

left(

begin{array}{c}

x_1 \

y_1

end{array}

right)=

left(

begin{array}{c}

x_0 \

y_0

end{array}

right) – mathbf J^{-1} left(

begin{array}{c}

f(x_0,y_0) \

g(x_0,y_0)

end{array}

right) , .

$$

Получаем полную аналогию с одномерным методом Ньютона; роль производной теперь выполняет матрица Якоби. Можно ожидать, что точка $ (x_1,y_1) $ будет лежать ближе к неизвестному нам решению исходной системы, нежели стартовая точка $ (x_0, y_0 ) $. Если это предположение выполняется, то можно попытаться организовать вычисление итерационной последовательности

$$

left{ left(

begin{array}{c}

x_j \

y_j

end{array}

right)=

left(

begin{array}{c}

x_{j-1} \

y_{j-1}

end{array}

right) – mathbf J^{-1} Bigg|_{_{(x_{j-1},y_{j-1})}} left(

begin{array}{c}

f(x_{j-1},y_{j-1}) \

g(x_{j-1},y_{j-1})

end{array}

right) right}_{j=1}^{infty}

$$

и потестировать ее на сходимость к решению. Одно ограничение для этого умозаключения довольно очевидно: матрица Якоби должна быть невырожденной на всех итерациях (а, желательно, и не очень близкой к вырожденным матрицам).

Метод известен как метод Ньютона, хотя эту атрибуцию надо будет проверить. Ссылок на исходную работу Ньютона я не нашел…

§

Подробнее о методе Ньютона решения систем нелинейных уравнений

☞

ЗДЕСЬ.

Условный экстремум

Задача. Для вещественных полиномов $ f(x,y) $ и $ g(x,y) $ найти

$$

max g(x,y) quad mbox{или} quad min g(x,y)

$$

при условии

$$

f(x,y)=0 , .

$$

Иными словами, требуется найти экстремумы одного полинома на алгебраической кривой $ f(x,y)=0 $.

Будем считать, что последнее уравнение имеет вещественное решение. Предположим, что точка $ (x_0,y_0) in mathbb R^2 $ лежит на кривой и в некоторой ее окрестности удовлетворяются условия теоремы 1. Существует функция $ varphi(x) $ такая, что $ varphi(x_0)=y_0 $ и $ f(x,varphi(x))=0 $. Тогда3)

$$

max_{y=varphi(x)} g(x,y) = max_{x} g(x,varphi(x)) , ,

$$

т.е. задачу удается свести к задаче обычной (безусловной) оптимизации. Стандартным способом ищем стационарные точки:

$$

frac{partial g}{partial x} + frac{partial g}{partial y} frac{d, varphi (x)}{d, x} =0 .

$$

Воспользуемся теоремой 1:

$$

frac{d, varphi (x)}{d, x} equiv – frac{partial f / partial x}{partial f / partial y} Bigg|_{y=varphi(x)} , .

$$

Таким образом, если точка $ (x_{ast},y_{ast}) $ — решение задачи условной оптимизации, то она должна удовлетворять системе уравнений

$$

f(x,y)=0 , frac{partial g}{partial x} frac{partial f}{partial y} – frac{partial g}{partial y} frac{partial f}{partial x} = 0

$$

при условии, что $ partial f / partial y mid_{_{(x_{ast},y_{ast})}} ne 0 $. Наблюдается магическое появление

якобиана

$$

frac{D(f,g)}{D(x,y)}

$$

в решении задачи.

К тому же заключению можно было прийти формальным применением метода множителей Лагранжа, но я не хочу здесь множить сущности.

Причину возникновения якобиана при решении задачи поясним на следующем примере.

П

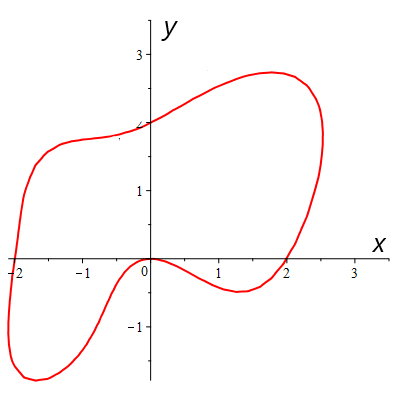

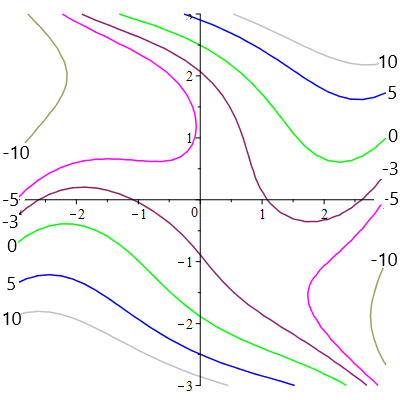

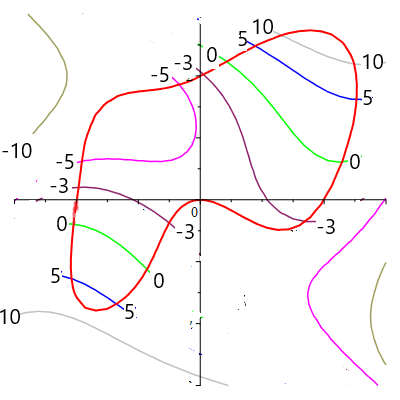

Пример. Найти $ min $ и $ max $ полинома

$$ g(x,y):=-frac{1}{8},x^4+frac{1}{6},y^4+2,xy+x^2-y-4 $$

на кривой

$$ f(x,y):=-x^4-frac{1}{2}y^4+4,x^2+3,xy+4,y = 0 , . $$

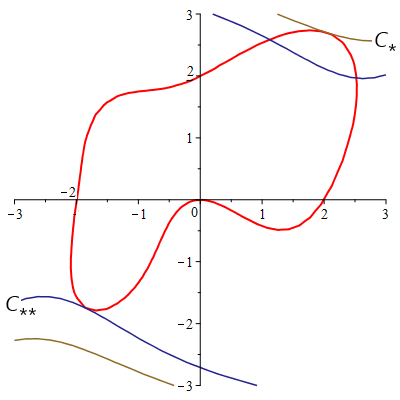

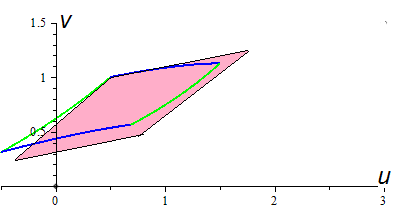

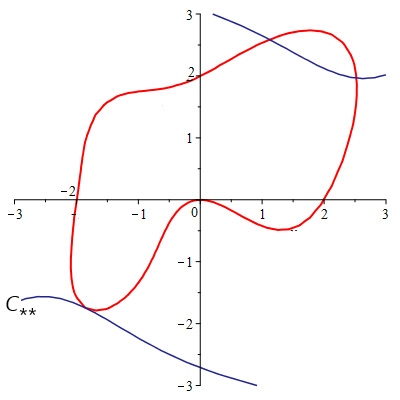

Решение. Уравнение $ f(x,y)=0 $ задает кривую, состоящую из одного замкнутого овала:

Полином $ g(x,y) $ достигает на этой кривой своего максимального и минимального значений. Построим топографическую систему для этого полинома, т.е. кривые $ g(x,y)=C $ при различных значениях константы $ C $:

Теперь наложим эту систему на кривую:

Наблюдаем, что при возрастании значения константы $ C $ точки пересечения кривой $ g(x,y)=C $ c $ f(x,y)=0 $ начинают стягиваться к двум предельным точкам — одна из них лежит в первой четверти плоскости $ Oxy $, а другая — в третьей.

Первая из точек — точка глобального максимума, визуально $ C_{ast}=max > 10 $, вторая же задает максимум локальный с $ 5 < C_{ast ast} =max < 10 $. В окрестности второй из этих точек кривые $ g(x,y)=C $ при $ C< C_{ast ast} $ имеют еще по две

точки пересечения с $ f(x,y)=0 $, но при $ Cto C_{ast ast} $ эти точки стремятся к слиянию. Иными словами, кривая

$ g(x,y)=C_{ast ast} $ должна касаться кривой $ f(x,y)=0 $.

Условие соприкасания двух неявно заданных кривых $ f(x,y)=0 $ и $ g(x,y)=C_{ast ast} $ указано в одном из предыдущих ПУНКТОВ: в точке касания градиенты функций $ f(x,y) $ и $ g(x,y)-C_{ast ast} $ должны быть коллинеарными:

$$frac{partial f}{ partial x} frac{partial g}{ partial y} –

frac{partial f}{ partial y} frac{partial g}{partial x}= 0 $$

Вот здесь и появляется якобиан. Рассуждения касательно $ min $ аналогичны.

Окончание решения, а именно установления величин $ max $ и $ min $ и координат точек кривой $ f(x,y)=0 $, в которых эти экстремумы достигаются,

☞

ЗДЕСЬ.

♦

В рассмотренном примере структура кривой $ f(x,y)=0 $ гарантировала нам существование конечных $ max $ и $ min $. В общем же случае задача усложнится необходимостью анализа поведения функции $ g $ и на ветвях кривой $ f=0 $ уходящих на бесконечность.

Решение задачи поиска

$$

max g(x,y,z) quad mbox{или} quad min g(x,y,z)

$$

при условиях

$$

f_1(x,y,z)=0 , , f_2(x,y,z)=0

$$

также приведет к системе уравнений, где третье уравнение представляет из себя

$$

frac{D(g,f_1,f_2)}{D(x,y,z)}=0 , .

$$

Задачи

Источники

[1]. Jacobi C.G.J. De Determinantibus functionalibus. J. reine angew. Math. Bd. 22, 1841, S. 319-359

[2]. Задача № 5256 из журнала American Mathematical Monthly, v. 73, N 1, 1966, cc. 93-94

[3]. Гурса Э. Курсъ математическаго анализа. Т.1. М. Издание торгового дома «В.И.Знаменский и Кº».1911

[4]. Зубов В.И. К вопросу существования и приближенного представления неявных функций Вестник Ленингр. ун-та. Сер. математика, механика и астрономия. № 19, вып. 4, 1956 , С.48-54

Материал из MachineLearning.

Перейти к: навигация, поиск

Содержание

- 1 Введение

- 1.1 Постановка математической задачи

- 1.1.1 Вычисление матрицы Якоби

- 1.1.2 Вычисление матрицы Гессе

- 1.1 Постановка математической задачи

- 2 Методы вычисления матрицы Якоби

- 2.1 Прямое вычисление частных производных

- 2.1.1 Оценка погрешности метода

- 2.2 Метод Бройдена

- 2.1 Прямое вычисление частных производных

- 3 Методы вычисления матрицы Гессе

- 4 Численный эксперимент

- 5 Рекомендации программисту

- 6 Заключение

- 7 Список литературы

Введение

Постановка математической задачи

Вычисление матрицы Якоби

Пусть задана система функций

от

переменных. Матрицей Якоби или якобианом данной системы функций называется

матрица, составленная из частных производных этих функций по всем переменным.

Если в некоторой точке очень сложно или невозможно вычислить частные производные,

, то для вычисления матрицы Якоби применяются методы численного дифференцирования.

Вычисление матрицы Гессе

Матрицей Гессе функции переменных

называется матрица, составленная из вторых производных функции

по всем переменным

Если в некоторой точке очень сложно или невозможно вычислить частные производные,

, то для вычисления матрицы Гессе применяются методы численного дифференцирования.

Методы вычисления матрицы Якоби

Прямое вычисление частных производных

Для вычисления матрицы Якоби в заданной необходимо найти частные производные всех функций системы по всем переменным. Для вычисления

производной применяются методы вычисления первой производной.

Формула для элемента якобиана при использовании правой разностной производной:

Формула для элемента якобиана при использовании центральной разностной производной:

Вычисление якобиана с использованием правой разностной производной требует вычислять значения функций в

точках. Если использовать центральную производную, то нужно находить значения функций в

точках. С другой, стороны погрешность правой производной имеет порядок

а центральной –

.

В большинстве случаев вычисление значения функции – это затратная по времени операция, поэтому используется правая разностная производная.

Оценка погрешности метода

Основная проблема при вычислении каждого элемента матрицы Якоби – как правильно выбрать шаг метода . Шаг выбирается независимо для каждого элемента матрицы.

Проанализируем зависимость погрешности метода от величины шага в случае использования правой разностной производной.

Для сокращения записи введём обозначения .

Остаточный член в соотношении имеет вид

.

Если , то

Если значения и

заданы с погрешностями

, то погрешность будет

содержать ещё одно слагаемое . Таким образом, оценка суммарной погрешности имеет вид

. Эта оценка достигает минимума при

. При этом

.

Оценка погрешности имеет один глобальный миниум. Поэтому выбор очень маленького шага не привидёт к росту точности. При величине шага, близкой к погрешность имеет порядок

.

Метод Бройдена

Чаще всего вычисление якобиана является одной из подзадач в различных методах оптимизации и решения систем нелинейных уравнений.

При решении систем нелинейных уравнений методом Ньютона требуется вычислять якобиан на каждой итерации.

Вычисление якобиана требует вычисления функций в точках. Это сложная и затратная по времени операция. Суть

метода Бройдена состоит в том, чтобы вычислить якобиан аналитически или с помощью метода конечных разностей на первой итерации,

а после этого на каждой итерации обновлять якобиан, не вычисляя значения функций и их производных.

Пусть задана система нелинейных уравнений , где

.

Тогда якобиан на -ой итерации выражается по формуле

После этого следующее приближение вычисляется по формуле

Методы вычисления матрицы Гессе

Как и матрица Якоби, матрица Гессе может быть вычислена с помощью разностной аппроксимации производных.

, где

– вектор переменных, а

и

– единичные вектора.

Эта формула требует вычисления значений функции в

точках.

Погрешность формулы имеет порядок .

Численный эксперимент

В качестве примера рассчитаем с помощью вышеизложенного метода матрицу Гессе функции в точке (1, 1)

| Величина шага | Численный результат | Истинное значение | Погрешность |

|---|---|---|---|

| 0.01 |

|

|

|

| 0.001 |

|

|

|

| 0.0001 |

|

|

|

| 0.00001 |

|

|

|

Рекомендации программисту

Вычисление матрицы Якоби требует большого числа операций. Поэтому при выборе метода её вычисления следует найти оптимальный баланс

между погрешностью метода и его скоростью.

Программа для вычисления якобиана, исходный код [1кб]

Программа для вычисления гессиана, исходный код [1кб]

Библиотека алгоритмов линейной алгебры [180кб]

Заключение

Список литературы

- Самарский А. А. , Гулин А. В. Численные методы. Москва «Наука», 1989.

- Бахвалов Н. С., Жидков Н. П., Кобельков Г. М. Численные методы. Лаборатория Базовых Знаний, 2003.

- Магнус Я. Р., Нейдеккер Х. Матричное дифференциальное исчисление с приложениями к статистике и эконометрике: Пер. с англ./ Под ред. С. А. Айвазяна. — М.:ФИЗМАТЛИТ, 2002. — 496 с.

- Хайкин С. Нейронные сети, полный курс. 2е издание, испр. — М: Вильямс. 2008. — 1103 с ISBN 978-5-8459-0890-2

- Bishop C. Exact calculation of the Hessian matrix for the multilayer perceptron / Neural Computation. Volume 4, Issue 4 (July 1992). Pp. 494—501. ISSN:0899-7667

- MacKay D. How do you evaluate the Hessian in the first place?

Не следует путать с Трёхдиагональная матрица.

|

|

Эту страницу предлагается объединить со страницей Якобиан. Пояснение причин и обсуждение — на странице Википедия:К объединению/7 мая 2020. |

Матрица Яко́би отображения

Содержание

- 1 Определение

- 2 Связанные определения

- 3 Свойства

- 4 См. также

Определение[править | править код]

Пусть задано отображение

Матрица

Иными словами, матрица Якоби является производной векторной функции от векторного аргумента.

Связанные определения[править | править код]

- Если

, то определитель

матрицы Якоби называется определителем Якоби или якобиа́ном системы функций

.

- Отображение называют невырожденным, если его матрица Якоби имеет максимально возможный ранг; то есть,

Свойства[править | править код]

- Если все

непрерывно дифференцируемы в окрестности

, то

- Пусть

— дифференцируемые отображения,

— их матрицы Якоби. Тогда матрица Якоби композиции отображений равна произведению их матриц Якоби (свойство функториальности):

См. также[править | править код]

- Якобиан

Дифференциальное исчисление |

|||||||

|---|---|---|---|---|---|---|---|

| Основное |

|

||||||

| Частные виды |

|

||||||

| Дифференциальные операторы (в различных координатах) |

|

||||||

| Связанные темы |

|

|

|

В статье не хватает ссылок на источники (см. рекомендации по поиску). Информация должна быть проверяема, иначе она может быть удалена. Вы можете отредактировать статью, добавив ссылки на авторитетные источники в виде сносок. (13 мая 2011) |

|

|

Это статья-заготовка по математике. Помогите Википедии, дополнив эту статью, как и любую другую. |

Время на прочтение

8 мин

Количество просмотров 58K

Содержание

- Что такое тензор и для чего он нужен?

- Векторные и тензорные операции. Ранги тензоров

- Криволинейные координаты

- Динамика точки в тензорном изложении

- Действия над тензорами и некоторые другие теоретические вопросы

- Кинематика свободного твердого тела. Природа угловой скорости

- Конечный поворот твердого тела. Свойства тензора поворота и способ его вычисления

- О свертках тензора Леви-Чивиты

- Вывод тензора угловой скорости через параметры конечного поворота. Применяем голову и Maxima

- Получаем вектор угловой скорости. Работаем над недочетами

- Ускорение точки тела при свободном движении. Угловое ускорение твердого тела

- Параметры Родрига-Гамильтона в кинематике твердого тела

- СКА Maxima в задачах преобразования тензорных выражений. Угловые скорость и ускорения в параметрах Родрига-Гамильтона

- Нестандартное введение в динамику твердого тела

- Движение несвободного твердого тела

- Свойства тензора инерции твердого тела

- Зарисовка о гайке Джанибекова

- Математическое моделирование эффекта Джанибекова

Введение

Читая отзывы к своим статьям, понял, что я излишне перегрузил читателя теоретическими вводными. Прошу за это прощения, признаться честно, я сам далек от формальной математики.

Однако, тензорное исчисление пестрит понятиями, многие из которых требуется вводить формально. Поэтому третья статься цикла тоже будет посвящена сухой теории. Тем не менее, я обещаю, что в следующей работе приступлю к тому, к чему сам давно хотел — к описанию практической ценности тензорного подхода. На примете имеется интересная задача, большая часть которой в моей голове уже разобрана. Тензорное исчисление для меня не праздный интерес, а способ обработать некоторые из своих теоретических и практических соображений в области механики. Так что практика по полной программе ещё предстоит.

А пока что рассмотрим некоторые теоретические основы. Добро пожаловать под кат.

1. Матрица Якоби и локальная метрика. «Жонглирование» индексами

Те системы координат, что мы рассматривали до сих пор были косоугольными. Но их оси были прямыми линиями. Однако, крайне часто приходится работать в пространстве, координатные линии которого — кривые. Такая система координат называется криволинейной.

Простейший жизненный пример криволинейной системы координат — географические координаты — широта, долгота и высота над уровнем моря, по которой определяется положение объектов вблизи поверхности Земли. Криволинейные координаты широко применяются в астрономии. В механике примером таких координат могут служить обобщенные координаты механической системы, однозначно определяющие её положение в пространстве с учетом геометрии наложенных на систему связей. На этом и строится аналитическая механика.

Рис. 1. Криволинейные координаты в трехмерном пространстве

Рассмотрим криволинейные координаты, заданные в трехмерном евклидовом пространстве (рисунок 1). Пусть положение точки задается в этих координатах вектором

и декартовы координаты точки связаны с (1) соотношением

или, в компонентной форме

Рассмотрим частную производную . Результат такого дифференцирования — это вектор, направленный по касательной к координатной линии

. Дифференцируя (2) по всем криволинейным координатам получим тройку векторов

Эти векторы задают базис так называемого касательного пространства. И в отличие от базиса в косоугольной системе координат, модуль и направление этих векторов будут изменятся при переходе от одной точки к другой. Мы получаем переменный базис, зависящий от положения в пространстве, заданного вектором (1). Такой базис называется локальным

Векторы (4) собирают в матрицу

которая называется матрицей Якоби, и по сути определяется как производная от одного вектора по другому вектору. В нашем случае

Легко догадаться, что если функция (2) линейна относительно компонент вектора , то её можно выразить матричным соотношением

то мы рассматриваем косоугольную систему координат, и матрица Якоби будет равна матрице преобразования от косоугольных координат к декартовым

Теперь, любой вектор, заданный в пространстве (тензор ранга (1, 0)) можно представить через его контравариантные компоненты в криволинейной системе координат

Однако, компоненты вектора, из-за переменного базиса, будут зависеть от положения в пространстве точки приложения вектора. Кроме того, для того чтобы представление (6) существовало, надо чтобы векторы, составляющие базис были не компланарны. Из курса векторной алгебры нам известно, что векторы некомпланарны, если их смешанное произведение отлично от нуля. Отсюда возникает условие, которому должен удовлетворять определитель матрицы Якоби

Данный определитель как раз определяет смешанное произведение векторов базиса.

Теперь вычислим ковариантные компоненты вектора . Для этого, в самой первой статье цикла, мы умножали вектор скалярно на соответствующий вектор базиса

В той же, первой статье, мы определили, что ковариантные компоненты вектора связаны с контравариантными через метрический тензор

Сравнивая два последних выражения мы получаем определение метрического тензора в криволинейных координатах

которое можно представить в матричной форме

Эту связь можно представить и в тензорной форме, но для этого придется ввести явно метрику для декартовых координат

Тогда, преобразование декартовой метрики в криволинейную будет выглядеть так

Выражение (8) вводит метрический тензор для криволинейных координат. Этот тензор зависит от положения точки в пространстве, поэтому говорят что он задан локально или определяет локальную метрику

Определившись с метрикой, мы можем записать правила преобразования контравариантных координат в ковариантные

и ковариантных координат в контравариантные

В тензорном исчислении операции опускания (9) и поднятия (10) индексов называют «жонглированием» индексами.

Выписав соотношения (9) и (10) мы подразумевали, что матрицы и

взаимно обратимы. Это возможно лишь в том случае, если

Данное условие выполняется для криволинейных координат, если матрица Якоби не вырождена, и это непосредственно следует из (8), так как

то есть условие (7) выполняемое для всех точек пространства — достаточное условие невырожденности локальной метрики.

Рассмотрение вырожденнных метрик, это отдельный и сложный вопрос, поэтому мы ограничимся метриками, в которых матрица метрического тензора обратима, то есть выполняется условие

где

- единичный тензор, называемый дельтой Кронекера. Видно, что его компоненты представлены единичной матрицей с размерностью, соответствующей размерности пространства.

2. Взаимный базис

Введем векторы , получаемые из векторов исходного базиса путем поднятия индекса

Теперь возьмем и умножим (11) скалярно на вектор

но, мы знаем, что — метрический тензор, поэтому, приходим к уравнению

Если мы возьмем, например, вектор , то в силу (12) он перпендикулярен векторам

и

(его скалярное произведение с ними равно нулю), а скалярное произведение этого вектора на

— равно единице

Дальше возьмем и умножим (11) скалярно на

и в силу (12) это дает контравариантный метрический тензор

Система векторов тоже образует базис, который называют взаимным или сопряженным с базисом

.

Снова рассмотрим вектор . Из соотношений (10) и (11) следует цепочка преобразований

Умножим (13) скалярно на

приходим к заключению, что любой вектор может быть разложен как по базису — тогда его компоненты будут контравариантные, так и по базису

— компоненты будут ковариантными

При этом, ковариантные компоненты — это скалярные произведение вектора на векторы базиса , а контравариантные компоненты — скалярные произведения вектора на векторы базиса

что ещё раз иллюстрирует взаимность этих базисов.

Тут надо отметить, что векторы базиса получаются естественным путем — они касательны соответствующим координатным линиям и им можно приписать геометрический смысл. Что касается базиса

, то его векторы не направлены по касательной координатным линиям, а перпендикулярны парам векторов касательного базиса. Такой базис иногда принято называть неголономным

3. Преобразование криволинейных координат. Формальное определение ковариантных и контравариантных компонент

Допустим, что мы работаем в криволинейной система координат, определенной вектором . Перейдем к другой системе координат, положение точек которой определяется вектором

, таким, что преобразование от старой системы координат к новой определяется уравнениями

Будем считать преобразование (16) обратимым, то есть допустим существование функции

Для этого требуется, чтобы определитель матрицы Якоби

был отличен от нуля

Тогда существует матрица , обратная матрице (18), такая, что

Матрица является матрицей Якоби для преобразования (17). Тогда можно вычислить векторы нового базиса

Получаем связь между старым базисом и новым

Разложим вектор в новом базисе

и используя соотношение (19), напишем

С учетом того, что векторы базиса линейно независимы, приравниваем коэффициенты при них в (21)

Теперь умножим обе части (21) на

Учтем, что

То есть, получаем формулу обратного преобразования контравариантных компонент

Из (22) и (19) можно заключить следующее

Контравариантные компоненты вектора преобразуются оператором, обратным оператору преобразования базиса

Действительно, чтобы получить векторы нового базиса, мы использовали матрицу по формуле (19). Чтобы получить контравариантные компоненты заданного в новом базисе вектора мы используем матрицу

А теперь посмотрим, как преобразуется вектор, заданный своими ковариантными компонентами

Из (23) видно, что

Ковариантные компоненты вектора преобразуются тем же оператором, которым осуществляется преобразование базиса

Формулы (19), (22) и (23) и сформулированные определения, вынесенные в цитатный блок дают формальное определение контравариантных и и ковариантных координат и иллюстрируют разницу между ними. Можно сформулировать утверждение

Тензор ранга (1,0) преобразуется оператором обратным, используемому при преобразовании базиса, а тензор ранга (0,1) преобразуется тем же самым оператором, что используется при преобразовании базиса.

4. Ковариантная производная. Символы Кристоффеля 2-го рода

Предположим, что мы хотим продифференцировать вектор, заданный произвольными координатам по какой-то из координат. Что мы должны сделать? Давайте попробуем выполнить эту операцию

На каком основании мы выписали производную от базисного вектора? А на том основании, что базис в криволинейных координатах зависит от них, а значит его производная от координаты отлична от нуля. Ну и ладно, эта производная тоже будет вектором, а значит её можно разложить по локальному базису, например вот так